使用辅助安装程序安装 OpenShift Container Platform

用户指南

摘要

前言

使开源包含更多

红帽承诺替换我们的代码、文档和网页属性中存在问题的语言。由于这项工作的艰巨性,这些变化正在尽可能地逐步更新。详情请查看 CTO Chris Wright 的信息。

对红帽文档提供反馈

您可以通过在 Jira 中提交 Create Issue 表单来提供反馈或报告错误。Jira 问题将在 Red Hat Hybrid Cloud Infrastructure Jira 项目中创建,您可以在其中跟踪您反馈的进度。

- 确保您已登录到 Jira。如果您没有 Jira 帐户,请创建一个帐户来提交反馈。

- 完成 Summary 和 Description 字段。在 Description 字段中,包含文档 URL、章节号以及问题的详细描述。不要修改表单中的任何其他字段。

- 点 Create。

我们感谢您对我们文档的反馈。

第 1 章 关于辅助安装程序

Red Hat OpenShift Container Platform 的辅助安装程序是一个用户友好的安装解决方案,在 Red Hat Hybrid Cloud Console 上提供。辅助安装程序支持各种专注于裸机、Nanix、vSphere 和 Oracle Cloud Infrastructure 的部署平台。

您可以在具有可选 HTTP/S 代理的连接的环境中为以下平台安装 OpenShift Container Platform:

- 高可用性 OpenShift Container Platform 或单节点 OpenShift 集群

- 在带有完整平台基础的裸机或 vSphere 上,或没有集成的其他虚拟平台上的 OpenShift Container Platform

- 可选,OpenShift Virtualization 和 Red Hat OpenShift Data Foundation

1.1. 功能

辅助安装程序提供安装功能作为服务。此软件即服务(SaaS)方法有以下特性:

- Web 界面

- 您可以使用 Hybrid Cloud Console 安装集群,而不是手动创建安装配置文件。

- 没有 bootstrap 节点

- 您不需要 bootstrap 节点,因为 bootstrap 进程运行在集群的一个节点上。

- 简化的安装工作流

- 您不需要深入了解 OpenShift Container Platform 来部署集群。辅助安装程序提供合理的默认配置。

- 您不需要在本地运行 OpenShift Container Platform 安装程序。

- 您可以访问最新测试的 z-stream 版本的最新辅助安装程序。

- 高级网络选项

- 辅助安装程序支持具有 SDN 和 OVN 的 IPv4 网络,只具有 OVN 的 IPv6 和双栈网络、基于 NMState 的静态 IP 寻址和 HTTP/S 代理。

- OVN 是 OpenShift Container Platform 4.12 及更新版本的默认 Container Network Interface (CNI)。

- SDN 最高支持 OpenShift Container Platform 4.14,并在 OpenShift Container Platform 4.15 中已弃用。

- 预安装验证

在安装前,辅助安装程序检查以下配置:

- 网络连接

- 网络带宽

- 连接到注册中心

- 域名的上游 DNS 解析

- 集群节点之间的时间同步

- 集群节点硬件

- 安装配置参数

- REST API

- 您可以使用辅助安装程序 REST API 自动化安装过程。

1.2. API 支持政策

在宣布弃用后,辅助安装程序 API 最少支持三个月。

第 2 章 准备使用辅助安装程序安装

在安装集群前,您必须确保集群节点和网络满足要求。

2.1. 先决条件

- 您可以参阅有关 OpenShift Container Platform 安装和更新流程的详细信息。

- 您可以阅读有关选择集群安装方法的文档,并为用户准备相关的环境。

- 如果使用防火墙,需要进行相关的配置,以便 Assisted Installer 可以访问它所需要的资源。

2.2. 支持的安装程序先决条件

Assisted Installer 验证以下先决条件以确保成功安装。

2.2.1. CPU 架构

在以下 CPU 构架上支持辅助安装程序:

- x86_64

- arm64

- ppc64le

- s390x

2.2.2. 硬件

对于单节点 OpenShift,辅助安装程序需要一个具有至少 8 个 CPU 核、16 GiB RAM 和 100 GB 磁盘大小的主机。

对于多节点集群,控制平面主机必须至少具有以下资源:

- 4 个 CPU 内核

- 16.00 GiB RAM

- 100 GB 存储

-

对于 etcd

wal_fsync_duration_seconds,10ms 写速度或更小

对于多节点集群,worker 主机必须至少具有以下资源:

- 2 个 CPU 内核

- 8.00 GiB RAM

- 100 GB 存储

对于 VMware 类型的主机,将 clusterSet disk.enableUUID 设置为 true,即使平台不是 vSphere。

2.2.3. 网络

网络必须满足以下要求:

- DHCP 服务器,除非使用静态 IP 地址。

基本域名。您必须确保满足以下要求:

-

没有通配符,如

*.<cluster_name>.<base_domain>,否则安装将无法进行。 -

api.<cluster_name>.<base_domain>的 DNS A/AAAA 记录。 -

*.apps.<cluster_name>.<base_domain>的带有 DNS A/AAAA 记录。

-

没有通配符,如

-

如果您打算通过

ocCLI 工具访问集群,则对 API URL 打开端口6443。 -

如果您打算允许防火墙外的用户访问控制台,则控制台打开端口

443。 - 在使用 User Managed Networking 时,集群中每个节点都需要一个 DNS A/AAAA 记录,否则安装将无法进行。在安装完成后,使用 Cluster Managed Networking 需要集群中每个节点都有 DNS A/AAAA 记录,以便可以连接到集群,但安装本身在使用 Cluster Managed Networking 时可以在没有 A/AAAA 记录的情况下进行。

- 在使用静态 IP 地址时,如需要使用预设置的主机名进行引导,则集群中每个节点都需要一个 DNS PTR 记录。否则,当使用静态 IP 地址时,辅助安装程序提供的自动重命名功能会将把节点重命名为其网络接口 MAC 地址。

- 顶级域注册器中的 DNS A/AAAA 记录设置可能需要大量时间更新。在安装前确保 A/AAAA 记录 DNS 设置可以正常工作,以防止安装延迟。

- 有关 DNS 记录示例,请参阅本章中的 DNS 配置示例。

OpenShift Container Platform 集群的网络还必须满足以下要求:

- 所有集群节点之间的连接

- 每个节点到互联网的连接

- 访问 NTP 服务器,以便在集群节点之间进行时间同步

2.2.4. DNS 配置示例

本节提供了 A 和 PTR 记录配置示例,它们满足使用辅助安装程序部署 OpenShift Container Platform 的 DNS 要求。示例不是为选择一个 DNS 解决方案而提供建议。

在这个示例中,集群名称为 ocp4,基域是 example.com。

2.2.4.1. DNS A 记录配置示例

以下示例是一个 BIND 区域文件,其显示了使用辅助安装程序安装的集群中名称解析的 A 记录示例。

DNS 区域数据库示例

$TTL 1W @ IN SOA ns1.example.com. root ( 2019070700 ; serial 3H ; refresh (3 hours) 30M ; retry (30 minutes) 2W ; expiry (2 weeks) 1W ) ; minimum (1 week) IN NS ns1.example.com. IN MX 10 smtp.example.com. ; ; ns1.example.com. IN A 192.168.1.1 smtp.example.com. IN A 192.168.1.5 ; helper.example.com. IN A 192.168.1.5 ; api.ocp4.example.com. IN A 192.168.1.5 1 api-int.ocp4.example.com. IN A 192.168.1.5 2 ; *.apps.ocp4.example.com. IN A 192.168.1.5 3 ; control-plane0.ocp4.example.com. IN A 192.168.1.97 4 control-plane1.ocp4.example.com. IN A 192.168.1.98 control-plane2.ocp4.example.com. IN A 192.168.1.99 ; worker0.ocp4.example.com. IN A 192.168.1.11 5 worker1.ocp4.example.com. IN A 192.168.1.7 ; ;EOF

- 1

- 为 Kubernetes API 提供名称解析。记录引用 API 负载均衡器的 IP 地址。

- 2

- 为 Kubernetes API 提供名称解析。记录引用 API 负载均衡器的 IP 地址,用于内部集群通信。

- 3

- 为通配符路由提供名称解析。记录引用应用程序入口负载均衡器的 IP 地址。应用程序入口负载均衡器以运行 Ingress Controller Pod 的机器为目标。默认情况下,入口控制器 pod 运行在 worker 机器上。注意

在这个示例中,将相同的负载均衡器用于 Kubernetes API 和应用入口流量。在生产环境中,您可以单独部署 API 和应用程序入口负载均衡器,以便可以隔离扩展每个负载均衡器基础架构。

- 4

- 为控制平面机器提供名称解析。

- 5

- 为 worker 机器提供名称解析。

2.2.4.2. DNS PTR 记录配置示例

以下示例是一个 BIND 区域文件,其显示了使用辅助安装程序安装的集群中反向名称解析的 PTR 记录示例。

反向记录的 DNS 区域数据库示例

$$TTL 1W @ IN SOA ns1.example.com. root ( 2019070700 ; serial 3H ; refresh (3 hours) 30M ; retry (30 minutes) 2W ; expiry (2 weeks) 1W ) ; minimum (1 week) IN NS ns1.example.com. ; 5.1.168.192.in-addr.arpa. IN PTR api.ocp4.example.com. 1 5.1.168.192.in-addr.arpa. IN PTR api-int.ocp4.example.com. 2 ; 97.1.168.192.in-addr.arpa. IN PTR control-plane0.ocp4.example.com. 3 98.1.168.192.in-addr.arpa. IN PTR control-plane1.ocp4.example.com. 99.1.168.192.in-addr.arpa. IN PTR control-plane2.ocp4.example.com. ; 11.1.168.192.in-addr.arpa. IN PTR worker0.ocp4.example.com. 4 7.1.168.192.in-addr.arpa. IN PTR worker1.ocp4.example.com. ; ;EOF

2.2.5. preflight 验证

Assisted Installer 确保集群在安装前满足先决条件,因为它消除了复杂的安装后故障排除,从而节省大量时间和工作时间。在节点上安装软件前,辅助安装程序执行以下验证:

- 确保网络连接

- 确保有足够的网络带宽

- 确保连接到 registry

- 确保任何上游 DNS 都可以解析所需的域名

- 确保集群节点之间的时间同步

- 验证集群节点是否满足最低硬件要求

- 验证安装配置参数

如果 Assisted Installer 没有成功验证忘记要求,安装将无法进行。

第 3 章 使用 Assisted Installer UI 安装

确保满足集群节点和网络要求后,您可以开始安装集群。

3.1. 预安装注意事项

在使用 Assisted Installer 安装 OpenShift Container Platform 前,您必须考虑以下配置选择:

- 要使用的基本域

- 要安装的 OpenShift Container Platform 产品版本

- 是否要安装完整集群还是单节点 OpenShift

- 是否使用 DHCP 服务器或静态网络配置

- 是否使用 IPv4 还是双栈网络

- 是否要安装 OpenShift Virtualization

- 是否要安装 Red Hat OpenShift Data Foundation

- 是否要安装多集群引擎(MCE)

- 在 vSphere 或 Nutanix 上安装时是否与平台集成

- 是否要安装混合集群架构

3.2. 设置集群详情

要使用 Assisted Installer Web 用户界面创建集群,请使用以下步骤。

流程

- 登录到 Red Hat Hybrid Cloud 控制台。

- 在 Red Hat OpenShift 标题中,点 Scale your application。

- 在菜单中,单击 Clusters。

- 点 Create cluster。

- 点 Datacenter 选项卡。

- 在 Assisted Installer 下,点 Create cluster。

- 在 Cluster name 字段中输入集群名称。

在 Base domain 字段中输入集群的基域。集群的所有子域将使用此基域。

注意基域必须是有效的 DNS 名称。不得为基域设置通配符域。

选择要安装的 OpenShift Container Platform 版本。

重要- 对于 IBM Power 和 IBM zSystems 平台,只支持 OpenShift Container Platform 4.13 及更新版本。

-

对于混合架构集群安装,请选择 OpenShift Container Platform 4.12 或更高版本,并使用

-multi选项。有关安装混合架构集群的说明,请参阅 其它资源。

可选: 如果您要在单一节点上安装 OpenShift Container Platform,请选择 Install single node Openshift (SNO)。

注意目前,IBM zSystems 和 IBM Power 平台还不支持 SNO。

- 可选: Assisted Installer 已关联有与您的帐户关联的 pull secret。如果要使用不同的 pull secret,请选择 Edit pull secret。

可选:如果您要在第三方平台上安装 OpenShift Container Platform,请从 Integrate with external parter platforms 列表中选择平台。有效值为

Nutanix、vSphere或Oracle Cloud Infrastructure。辅助安装程序默认没有平台集成。注意有关每个外部合作伙伴集成的详情,请参考 其它资源。

重要辅助安装程序支持 OpenShift Container Platform 4.14 及之后版本中的 Oracle Cloud Infrastructure (OCI)集成。对于 OpenShift Container Platform 4.14,OCI 集成只是一个技术预览功能。技术预览功能不受红帽产品服务等级协议(SLA)支持,且功能可能并不完整。红帽不推荐在生产环境中使用它们。这些技术预览功能可以使用户提早试用新的功能,并有机会在开发阶段提供反馈意见。

有关红帽技术预览功能支持范围的更多信息,请参阅 技术预览功能 - 支持范围。

可选: 辅助安装程序默认使用

x86_64CPU 架构。如果要在不同的架构上安装 OpenShift Container Platform,请选择要使用的架构。有效值为arm64,ppc64le, 和s390x。请记住,一些功能不适用于arm64,ppc64le, 和s390xCPU 架构。重要对于混合架构集群安装,请使用默认的

x86_64架构。有关安装混合架构集群的说明,请参阅 其它资源。可选:如果您至少有一个自定义清单要包括在安装中,请选择 Include custom manifests 。自定义清单包含目前在辅助安装程序种不支持的其它配置。选中复选框来向向导中添加 Custom manifests 页面,您可以在其中上传清单。

重要- 如果要在 Oracle Cloud Infrastructure (OCI)第三方平台上安装 OpenShift Container Platform,则需要强制添加 Oracle 提供的自定义清单。

- 如果您已经添加了自定义清单,取消选中 Include custom manifests 框会自动将它们全部删除。将要求您确认删除。

可选: 辅助安装程序默认为 DHCP 网络。如果集群节点需要使用静态 IP 配置、网桥或绑定,而不是使用 DHCP,请选择 Static IP、bridge 和 bond。

注意Oracle Cloud 基础设施上的 OpenShift Container Platform 安装不支持静态 IP 配置。

- 可选:如果要启用安装磁盘的加密,对单节点 OpenShift,在Enable encryption of installation disks 中选择 Control plane node, worker。对于多节点集群,您可以选择 Control plane 节点 来加密 control plane 节点安装磁盘,选择 Workers 来加密 worker 节点安装磁盘。

您不能在安装后更改基域、SNO 复选框、CPU 架构、主机的网络配置或磁盘加密。

3.3. 可选:配置静态网络

辅助安装程序支持最高到 OpenShift Container Platform 4.14 和 OVN 的带有 SDN 的 IPv4 网络,且只支持具有 OVN 的 IPv6 和双栈网络。Assisted Installer 支持使用 IP 地址/MAC 地址映射使用静态网络接口配置网络。Assisted Installer 还支持使用 NMState 库配置主机网络接口,即主机的声明网络管理器 API。您可以使用 NMState 部署带有静态 IP 寻址、绑定、VLAN 和其他高级网络功能的主机。首先,您必须设置网络范围内的配置。然后,您必须为每个主机创建特定于主机的配置。

对于 IBM Z 上使用 z/VM 的安装,请确保 z/VM 节点和 vSwitch 为静态网络和 NMState 进行了正确配置。另外,z/VM 节点必须分配有固定的 MAC 地址,因为池 MAC 地址可能会导致 NMState 有问题。

流程

- 选择互联网协议版本。有效选项为 IPv4 和 Dual stack。

- 如果集群主机位于共享 VLAN 上,请输入 VLAN ID。

输入网络范围内的 IP 地址。如果选择了 Dual stack 网络,则必须同时输入 IPv4 和 IPv6 地址。

- 以 CIDR 标记形式输入集群网络的 IP 地址范围。

- 输入默认网关 IP 地址。

- 输入 DNS 服务器 IP 地址。

输入特定于主机的配置。

- 如果您只设置使用单一网络接口的静态 IP 地址,请使用表单视图输入主机的 IP 地址和 MAC 地址。

- 如果您使用多个接口、绑定或其他高级网络功能,请使用 YAML 视图,并为使用 NMState 语法的每个主机输入所需的网络状态。然后,为在网络配置中使用的每个主机接口添加 MAC 地址和接口名称。

其他资源

3.4. 可选:安装 Operator

此步骤是可选的。

有关先决条件和配置选项,请查看产品文档:

如果需要高级选项,请在安装集群后安装 Operator。

流程

从以下选项中选择一个或多个:

- 安装 OpenShift Virtualization

- 安装多集群引擎

- 安装 OpenShift Data Foundation

- 安装逻辑卷管理器

- 点击 Next。

3.5. 在集群中添加主机

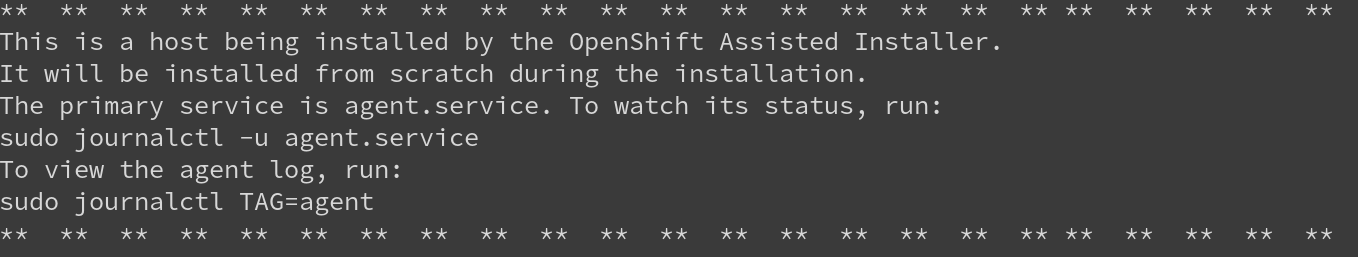

您必须将一个或多个主机添加到集群中。将主机添加到集群涉及生成发现 ISO。发现 ISO 使用代理运行 Red Hat Enterprise Linux CoreOS (RHCOS) 内存中。

对集群中的每个主机执行以下步骤。

流程

单击 Add hosts 按钮,并选择调配类型。

-

选择 Minimal image file: Provision with virtual media 以下载一个较小的镜像,该镜像会获取引导所需的数据。节点必须具有虚拟介质功能。这是

x86_64和arm64架构的推荐方法。 -

选择 Full image file: Provision with physical media 以下载更大的完整镜像。这是对

ppc64le架构和使用 RHEL KVM 安装时对s390x架构的推荐方法。 选择 iPXE: Provision from your network server,以使用 iPXE 引导主机。这是对具有 z/VM 节点的 IBM Z 的推荐方法。ISO 引导对 RHEL KVM 安装的推荐方法。

注意- 如果您在 RHEL KVM 上安装,在某些情况下,KVM 主机上的虚拟机没有在第一次引导时重启,需要手动重启。

- 如果在 Oracle Cloud Infrastructure 上安装 OpenShift Container Platform,请只选择 Minimal image file: Provision with virtual media。

-

选择 Minimal image file: Provision with virtual media 以下载一个较小的镜像,该镜像会获取引导所需的数据。节点必须具有虚拟介质功能。这是

- 可选: 如果集群主机位于需要使用代理的防火墙后面,请选择 Configure cluster-wide proxy settings。输入代理服务器的 HTTP 和 HTTPS URL 的用户名、密码、IP 地址和端口。

可选:添加一个 SSH 公钥,以便可以以

core用户身份连接到集群节点。通过登录到集群节点,您可以在安装过程中为您提供调试信息。重要不要在生产环境中跳过这个过程,在生产环境中需要灾难恢复和调试。

- 如果您在本地计算机上没有现有的 SSH 密钥对,请按照 为集群节点 SSH 访问生成密钥对 中的步骤操作。

-

在 SSH public key 字段中,单击 Browse 来上传包含 SSH 公钥的

id_rsa.pub文件。或者,将文件拖放到文件管理器的字段中。要查看文件管理器中的文件,请在菜单中选择 Show hidden files。

- 可选: 如果集群主机位于带有重新加密 man-in-the-middle (MITM)代理的网络中,或者集群需要信任证书用于容器镜像 registry,请选择 Configure cluster-wide trusted certificate。以 X.509 格式添加额外的证书。

- 如果需要,配置发现镜像。

- 可选:如果您要在一个平台上安装并希望与该平台集成,请选择 Integrate with your virtualization platform。您必须引导所有主机,并确保它们出现在主机清单中。所有主机必须位于同一平台上。

- 点 Generate Discovery ISO 或 Generate Script File。

- 下载发现 ISO 或 iPXE 脚本。

- 使用发现镜像或 iPXE 脚本引导主机。

其他资源

- 配置发现镜像了解更多详细信息。

- 使用发现镜像引导主机获取更多详细信息。

- Red Hat Enterprise Linux 9 - 配置和管理虚拟化了解更多详细信息。

- 如何配置 VIOS Media Repository/Virtual Media Library了解更多详情。

- 使用 UI 在 Nutanix 中添加主机

- 在 vSphere 中添加主机

3.6. 配置主机

使用发现 ISO 引导主机后,主机将显示在页面底部的表中。您可以选择为每个主机配置主机名和角色。如果需要,您还可以删除主机。

流程

在主机的 Options (⋮) 菜单中,选择 Change hostname。如有必要,为主机输入一个新名称,然后点更改。您必须确保每个主机具有有效且唯一的主机名。

或者,从 Actions 列表中选择 Change hostname 以重命名多个所选主机。在 Change Hostname 对话框中,输入新名称并包含

{{n}},使每个主机名都是唯一的。然后点 更改。注意在键入时,您可以看到在 Preview 窗格中显示的新名称。所有选定的主机的名称都几乎相同,唯一的不同是每个主机都带有一个一位的递增数字。

在 Options (⋮) 菜单中,您可以选择 Delete host 来删除一个主机。点 Delete 以确认删除。

或者,从 Actions 列表中选择 Delete 同时删除多个所选主机。然后点 Delete hosts。

注意在常规部署中,集群可以有三个或更多主机,其中三个主机必须是 control plane 主机。如果您删除一个也是 control plane 的主机,或者您只保留两个主机,则会出现一条信息表示系统未就绪。要恢复主机,您需要使用发现 ISO 重启它。

- 在主机的 Options (⋮) 菜单中,可以选择 View host events(可选)。列表中的事件按时间顺序显示。

对于多主机集群,在主机名旁边的 Role 列中,您可以点菜单来更改主机的角色。

如果您没有选择角色,则 Assisted Installer 会自动分配角色。control plane 节点的最低硬件要求超过 worker 节点。如果为主机分配角色,请确保为满足最低硬件要求的主机分配 control plane 角色。

- 点 Status 链接,以查看主机的硬件、网络和操作器验证。

- 点主机名左侧的箭头,以展开主机详细信息。

当所有集群主机都显示为 Ready 状态后,继续下一步。

3.7. 配置存储磁盘

主机发现期间检索到的每个主机可能有多个存储磁盘。在辅助安装程序向导的 Storage 页面中列出了主机的存储磁盘。

您可以选择修改每个磁盘的默认配置。

更改安装磁盘

辅助安装程序默认随机分配一个安装磁盘。如果主机有多个存储磁盘,您可以选择一个不同的磁盘作为安装磁盘。这会自动取消之前磁盘的分配。

流程

- 导航到向导的 Storage 页面。

- 扩展主机以显示关联的存储磁盘。

- 从 Role 列表中选择 Installation disk。

- 当所有存储磁盘都返回到 Ready 状态时,继续下一步。

禁用磁盘格式化

辅助安装程序在安装过程中默认将所有可引导磁盘标记为进行格式化,无论它们是否已被定义为安装磁盘。格式化会导致数据丢失。

您可以选择禁用特定磁盘的格式化。这应该谨慎执行,因为可引导磁盘可能会干扰安装过程,主要在引导顺序方面。

您无法禁用对安装磁盘的格式化。

流程

- 导航到向导的 Storage 页面。

- 扩展主机以显示关联的存储磁盘。

- 取消磁盘的 Format。

- 当所有存储磁盘都返回到 Ready 状态时,继续下一步。

其他资源

3.8. 配置网络

在安装 OpenShift Container Platform 之前,您必须配置集群网络。

流程

在 Networking 页面中,如果还没有为您选择,请选择以下之一:

Cluster-Managed Networking: 选择集群管理的联网意味着 Assisted Installer 将配置标准网络拓扑,包括

keepalived和 Virtual Router Redundancy Protocol (VRRP) 用于管理 API 和 Ingress VIP 地址。注意- 目前,OpenShift Container Platform 版本 4.13 中的 IBM zSystems 和 IBM Power 不支持集群管理的网络。

- Oracle Cloud Infrastructure (OCI)仅适用于带有用户管理的网络配置的 OpenShift Container Platform 4.14。

-

用户管理的联网 :选择用户管理的网络允许您使用非标准网络拓扑部署 OpenShift Container Platform。例如,如果要使用外部负载均衡器而不是

keepalived和 VRRP 部署,或者您想要在多个不同 L2 网络片段中部署集群节点。

对于集群管理的联网,请配置以下设置:

- 定义 Machine 网络。您可以使用默认网络或选择子网。

- 定义一个 API 虚拟 IP。API 虚拟 IP 为所有用户提供与平台交互的端点。

- 定义一个 Ingress 虚拟 IP。Ingress 虚拟 IP 为来自集群外部的应用程序流量提供端点。

对于用户管理的网络,请配置以下设置:

选择您的网络堆栈类型 :

- IPv4 :当您的主机只使用 IPv4 时,请选择此类型。

- Dual-stack:当主机将 IPv4 与 IPv6 一起使用时,您可以选择双栈。

- 定义 Machine 网络。您可以使用默认网络或选择子网。

- 定义一个 API 虚拟 IP。API 虚拟 IP 为所有用户提供与平台交互的端点。

- 定义一个 Ingress 虚拟 IP。Ingress 虚拟 IP 为来自集群外部的应用程序流量提供端点。

- 可选:您可以选择 Allocate IPs via DHCP server 来自动分配 API IP 和 Ingress IP 使用 DHCP 服务器。

可选: 选择 Use advanced networking 来配置以下高级网络属性:

- Cluster network CIDR :定义从中分配 Pod IP 地址的 IP 地址块。

- Cluster network host prefix :定义分配给每个节点的子网前缀长度。

- 服务网络 CIDR :定义用于服务 IP 地址的 IP 地址。

- Network type: 选择 Software-Defined Networking (SDN) 用于标准网络,或 Open Virtual Networking (OVN) 用于 IPv6, 双堆栈和电信功能。在 OpenShift Container Platform 4.12 及更新的版本中,OVN 是默认的 Container Network Interface (CNI)。在 OpenShift Container Platform 4.15 及更新版本中,不支持 软件定义的网络(SDN)。

其他资源

3.9. 添加自定义清单

自定义清单是一个 JSON 或 YAML 文件,其包含辅助安装程序用户界面目前不支持的高级配置。您可以创建一个自定义清单,或使用第三方提供的清单。

您可以将自定义清单从文件系统上传到 openshift 文件夹或 manifests 文件夹。对允许的自定义清单文件的数量没有限制。

一次只能上传一个文件。但是,每个上传的 YAML 文件可以包含多个自定义清单。上传多文档 YAML 清单比单独添加 YAML 文件要快。

对于包含一个自定义清单的文件,可接受的文件扩展名包括 .yaml、.yml 或 .json。

一个自定义清单示例

apiVersion: machineconfiguration.openshift.io/v1

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: master

name: 99-openshift-machineconfig-master-kargs

spec:

kernelArguments:

- loglevel=7

对于包含多个自定义清单的文件,可接受的文件类型包括 .yaml 或 .yml。

多个自定义清单示例

apiVersion: machineconfiguration.openshift.io/v1

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: master

name: 99-openshift-machineconfig-master-kargs

spec:

kernelArguments:

- loglevel=7

---

apiVersion: machineconfiguration.openshift.io/v2

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: worker

name: 98-openshift-machineconfig-worker-kargs

spec:

kernelArguments:

- loglevel=5

- 当在 Oracle Cloud Infrastructure (OCI)外部平台上安装 OpenShift Container Platform 时,您必须添加 Oracle 提供的自定义清单。对于其它外部合作伙伴集成,如 vSphere 或 Nutanix,此步骤是可选的。

- 有关自定义清单的更多信息,请参阅 其它资源。

在辅助安装程序用户界面中上传自定义清单

在上传自定义清单时,输入清单文件名,并选择目标文件夹。

先决条件

- 您至少有一个保存在文件系统中的自定义清单文件。

流程

- 在向导的 Cluster details 页面中,选择 Include custom manifests 复选框。

- 在 Custom manifest 页面中,在 folder 字段中选择您要保存自定义清单文件的辅助安装程序文件夹。选项包括 openshift 或 manifest。

- 在 Filename 字段中,输入清单文件的名称,包括扩展名。例如,manifest1.json 或 multiple1.yaml。

- 在 Content 下,点 Upload 图标或 Browse 按钮来上传文件。或者,将文件拖到您文件系统的 Content 字段中。

- 要上传另一个清单,请单击 Add another manifest,并重复此过程。这将保存之前上传的清单。

- 点 Next 保存所有清单,然后进入到 Review and create 页面。上传的自定义清单列在 Custom manifests 下。

在辅助安装程序用户界面中修改自定义清单

您可以更改上传的自定义清单的文件夹和文件名。您还可以复制现有清单的内容,或将其下载到 Chrome 下载设置中定义的文件夹中。

无法修改上传的清单的内容。但是,您可以覆盖该文件。

先决条件

- 您至少上传了一个自定义清单文件。

流程

- 要更改文件夹,请从 Folder 列表中为清单选择一个其他的文件夹。

- 要修改文件名,请在 File name 字段中输入清单的新名称。

- 要覆盖清单,请在同一文件夹中使用相同的文件名保存新清单。

- 要在文件系统中将清单保存为一个文件,请点 Download 图标。

- 要复制清单,请点击 Copy to clipboard 图标。

- 要应用更改,请单击 Add another manifest 或 Next。

在辅助安装程序用户界面中删除自定义清单

在安装前,您可以通过以下两种方式之一删除上传的自定义清单:

- 单独删除一个或多个清单。

- 一次删除所有清单。

删除清单后,您无法撤销操作。临时解决办法是再次上传清单。

删除单个清单

您可以一次删除一个清单。此选项不允许您删除最后剩余的清单。

先决条件

- 您已至少上传了两个自定义清单文件。

流程

- 进入到 Custom manifests 页面。

- 将鼠标悬停在清单名称上,以显示 Delete (-)图标。

- 单击该图标,然后在对话框中单击 Delete。

删除所有清单

您可以一次删除所有自定义清单。这也会隐藏 Custom manifest 页面。

先决条件

- 您至少上传了一个自定义清单文件。

流程

- 进入到向导的 Cluster details 页面。

- 清除 Include custom manifests 复选框。

- 在 Remove custom manifests 对话框中,点 Remove。

其他资源

3.10. 预安装验证

Assisted Installer 确保集群在安装前满足先决条件,因为它消除了复杂的安装后故障排除,从而节省大量时间和工作时间。在安装集群前,请确保集群和每个主机都通过了预安装验证。

其他资源

3.11. 安装集群

完成配置并且所有节点都为 Ready 后,您可以开始安装。安装过程需要花费相当长的时间,您可以从 Assisted Installer Web 控制台监控安装。节点将在安装过程中重新引导,它们将在安装后进行初始化。

流程

- 按 Begin Installation。

- 单击 Host Inventory 列表中 Status 列中的链接,以查看特定主机的安装状态。

3.12. 完成安装

安装和初始化集群后,Assisted Installer 表示安装已完成。Assisted Installer 提供控制台 URL、kubeadmin 用户名和密码以及 kubeconfig 文件。另外,辅助安装程序提供集群详情,包括 OpenShift Container Platform 版本、基础域、CPU 架构、API 和 Ingress IP 地址,以及集群和服务网络 IP 地址。

先决条件

-

已安装

ocCLI 工具。

流程

-

复制

kubeadmin用户名和密码。 下载

kubeconfig文件,并将其复制到工作目录中的auth目录中:$ mkdir -p <working_directory>/auth

$ cp kubeadmin <working_directory>/auth

注意kubeconfig文件可在完成安装后 24 小时下载。在您的环境中添加

kubeconfig文件:$ export KUBECONFIG=<your working directory>/auth/kubeconfig

使用

ocCLI 工具登录:$ oc login -u kubeadmin -p <password>

将

<password>替换为kubeadmin用户的密码。- 点 Web 控制台 URL 或点 Launch OpenShift Console 来打开控制台。

-

输入

kubeadmin用户名和密码。按照 OpenShift Container Platform 控制台中的说明来配置身份提供程序并配置警报接收器。 - 添加 OpenShift Container Platform 控制台的书签。

- 完成所有安装后平台集成步骤。

第 4 章 使用 Assisted Installer API 安装

确保满足集群节点和网络要求后,您可以使用 Assisted Installer API 开始安装集群。要使用 API,您必须执行以下步骤:

- 设置 API 身份验证。

- 配置 pull secret。

- 注册新的集群定义。

- 为集群创建基础架构环境。

执行这些步骤后,您可以修改集群定义,创建发现 ISO,在集群中添加主机,并安装集群。本文档并没有包括 Assisted Installer API 的每个端点,但您可以查看 API viewer 或 swagger.yaml 文件中的详细内容。

4.1. 生成离线令牌

从辅助安装程序 UI 下载离线令牌。您将使用离线令牌来设置 API 令牌。

先决条件

-

安装

jq。 - 以具有集群创建权限的用户身份登录 OpenShift Cluster Manager。

流程

- 在菜单中,单击 Downloads。

- 在 OpenShift Cluster Manager API Token 下的 Tokens 部分中,点 View API Token。

点 Load Token。

重要禁用弹出窗口阻塞。

- 在 API 令牌 部分中,复制离线令牌。

在终端中,将离线令牌设置为

OFFLINE_TOKEN变量:$ export OFFLINE_TOKEN=<copied_token>

提示要使离线令牌永久生效,请将其添加到您的配置集中。

(可选)确认

OFFLINE_TOKEN变量定义。$ echo ${OFFLINE_TOKEN}

4.2. 使用 REST API 进行身份验证

API 调用需要通过 API 令牌进行身份验证。假设您使用 API_TOKEN 作为变量名称,请将 -H "Authorization: Bearer ${API_TOKEN}" 添加到 API 调用中以与 REST API 进行身份验证。

API 令牌在 15 分钟后过期。

先决条件

-

您已生成了

OFFLINE_TOKEN变量。

流程

在命令行终端上,使用

OFFLINE_TOKEN设置API_TOKEN变量来验证用户。$ export API_TOKEN=$( \ curl \ --silent \ --header "Accept: application/json" \ --header "Content-Type: application/x-www-form-urlencoded" \ --data-urlencode "grant_type=refresh_token" \ --data-urlencode "client_id=cloud-services" \ --data-urlencode "refresh_token=${OFFLINE_TOKEN}" \ "https://sso.redhat.com/auth/realms/redhat-external/protocol/openid-connect/token" \ | jq --raw-output ".access_token" \ )

确认

API_TOKEN变量定义:$ echo ${API_TOKEN}在您的路径中为令牌生成方法创建一个脚本。例如:

$ vim ~/.local/bin/refresh-token

export API_TOKEN=$( \ curl \ --silent \ --header "Accept: application/json" \ --header "Content-Type: application/x-www-form-urlencoded" \ --data-urlencode "grant_type=refresh_token" \ --data-urlencode "client_id=cloud-services" \ --data-urlencode "refresh_token=${OFFLINE_TOKEN}" \ "https://sso.redhat.com/auth/realms/redhat-external/protocol/openid-connect/token" \ | jq --raw-output ".access_token" \ )然后保存文件。

更改文件模式使其可执行:

$ chmod +x ~/.local/bin/refresh-token

刷新 API 令牌:

$ source refresh-token

运行以下命令验证您可以访问 API:

$ curl -s https://api.openshift.com/api/assisted-install/v2/component-versions -H "Authorization: Bearer ${API_TOKEN}" | jq输出示例

{ "release_tag": "v2.11.3", "versions": { "assisted-installer": "registry.redhat.io/rhai-tech-preview/assisted-installer-rhel8:v1.0.0-211", "assisted-installer-controller": "registry.redhat.io/rhai-tech-preview/assisted-installer-reporter-rhel8:v1.0.0-266", "assisted-installer-service": "quay.io/app-sre/assisted-service:78d113a", "discovery-agent": "registry.redhat.io/rhai-tech-preview/assisted-installer-agent-rhel8:v1.0.0-195" } }

4.3. 配置 pull secret

许多 Assisted Installer API 调用都需要 pull secret。将 pull secret 下载到文件中,以便您可以在 API 调用中引用它。pull secret 是一个 JSON 对象,它将作为请求的 JSON 对象中的值包含在其中。必须格式化 pull secret JSON 来转义引号。例如:

之前

{"auths":{"cloud.openshift.com": ...

After

{\"auths\":{\"cloud.openshift.com\": ...

流程

- 在菜单中,点 OpenShift。

- 在子菜单中,点 Downloads。

- 在 Pull secret 下的 Tokens 部分中,点 Download。

要使用 shell 变量中的 pull secret,请执行以下命令:

$ export PULL_SECRET=$(cat ~/Downloads/pull-secret.txt | jq -R .)

要使用

jq分片 pull secret 文件,请在pull_secret变量中引用它,将值传送到tojson,以确保它被正确格式化为转义的 JSON。例如:$ curl https://api.openshift.com/api/assisted-install/v2/clusters \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' 1 { "name": "testcluster", "high_availability_mode": "None", "openshift_version": "4.11", "pull_secret": $pull_secret[0] | tojson, 2 "base_dns_domain": "example.com" } ')"确认

PULL_SECRET变量定义:$ echo ${PULL_SECRET}

4.4. 可选:生成 SSH 公钥

在 OpenShift Container Platform 安装过程中,您可以选择向安装程序提供 SSH 公钥。当排除安装错误时,这对于启动到远程节点的 SSH 连接很有用。

如果您在本地机器上没有一个用于身份验证的现有 SSH 密钥,请现在创建一个。

先决条件

-

生成

OFFLINE_TOKEN和API_TOKEN变量。

流程

从终端中的 root 用户获取 SSH 公钥:

$ cat /root/.ssh/id_rsa.pub

将 SSH 公钥设置为

CLUSTER_SSHKEY变量:$ CLUSTER_SSHKEY=<downloaded_ssh_key>

确认

CLUSTER_SSHKEY变量定义:$ echo ${CLUSTER_SSHKEY}

4.5. 注册新集群

要使用 API 注册新集群定义,请使用 /v2/clusters 端点。注册新集群需要以下设置:

-

name -

openshift-version -

pull_secret -

cpu_architecture

有关注册新集群时可设置的字段的详情,请参阅 API viewer 中的 cluster-create-params 模型。设置 olm_operators 字段时,请参阅 其它资源,以了解安装 Operator 的详情。

创建集群定义后,您可以修改集群定义并为附加设置提供值。

- 对于某些安装平台和 OpenShift Container Platform 版本,您还可以通过在同一集群上将两个不同的架构合并来创建一个混合架构集群。详情请查看 其它资源。

- 如果要在第三方平台上安装 OpenShift Container Platform,请参阅 其它资源 以了解相关说明。

先决条件

-

您已生成了一个有效的

API_TOKEN。令牌每 15 分钟过期一次。 - 您已下载了 pull secret。

-

可选: 您已将 pull secret 分配给

$PULL_SECRET变量。

流程

刷新 API 令牌:

$ source refresh-token

注册新集群。

可选: 您可以通过在请求中分片 pull secret 文件来注册新集群:

$ curl -s -X POST https://api.openshift.com/api/assisted-install/v2/clusters \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "name": "testcluster", "openshift_version": "4.11", "cpu_architecture" : "<architecture_name>", 1 "high_availability_mode": "<cluster_type>", 2 "base_dns_domain": "example.com", "pull_secret": $pull_secret[0] | tojson } ')" | jq '.id'可选: 您可以通过将配置写入 JSON 文件,然后在请求中引用它来注册新集群:

cat << EOF > cluster.json { "name": "testcluster", "openshift_version": "4.11", "high_availability_mode": "<cluster_type>", 1 "base_dns_domain": "example.com", "network_type": "examplenetwork", "cluster_network_cidr":"11.111.1.0/14" "cluster_network_host_prefix": 11, "service_network_cidr": "111.11.1.0/16", "api_vips":[{"ip": ""}], "ingress_vips": [{"ip": ""}], "vip_dhcp_allocation": false, "additional_ntp_source": "clock.redhat.com,clock2.redhat.com", "ssh_public_key": "$CLUSTER_SSHKEY", "pull_secret": $PULL_SECRET } EOF注意- 1

- 使用默认值

Full来表示一个多节点 OpenShift Container Platform 集群,或使用None来表示一个单节点 OpenShift 集群。Full在多个主节点上安装一个高可用性集群,并保证安装的集群的可用性。None在一个节点上安装一个完整的集群。

$ curl -s -X POST "https://api.openshift.com/api/assisted-install/v2/clusters" \ -d @./cluster.json \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.id'

将返回的

cluster_id分配给CLUSTER_ID变量,并导出它:$ export CLUSTER_ID=<cluster_id>

注意如果关闭终端会话,则需要在新的终端会话中再次导出

CLUSTER_ID变量。检查新集群的状态:

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq

注册新的集群定义后,为集群创建基础架构环境。

在创建基础架构环境前,您无法在 Assisted Installer 用户界面中看到集群配置设置。

4.5.1. 可选:安装 Operator

您可以在注册新集群时安装以下 Operator:

OpenShift Virtualization Operator

注意目前,IBM zSystems 和 IBM Power 不支持 OpenShift Virtualization。

- 多集群引擎 Operator

- OpenShift Data Foundation Operator

- LVM 存储 Operator

如果需要高级选项,请在安装集群后安装 Operator。

流程

运行以下命令:

$ curl -s -X POST https://api.openshift.com/api/assisted-install/v2/clusters \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "name": "testcluster", "openshift_version": "4.15", "cpu_architecture" : "x86_64", "base_dns_domain": "example.com", "olm_operators": [ { "name": "mce" } 1 , { "name": "odf" } 2 ] "pull_secret": $pull_secret[0] | tojson } ')" | jq '.id'

4.6. 修改集群

要使用 API 修改集群定义,请使用 /v2/clusters/{cluster_id} 端点。修改集群资源是添加设置(如更改网络类型或启用用户管理的网络)的常见操作。如需了解在修改集群定义时您可以设置的字段的详情,请参阅 API viewer 中的 v2-cluster-update-params 模型。

您可以从已注册的集群资源中添加或删除 Operator。

要在节点上创建分区,请参阅 OpenShift Container Platform 文档中的 在节点上配置存储。

先决条件

- 您已创建了新的集群资源。

流程

刷新 API 令牌:

$ source refresh-token

修改集群。例如,更改 SSH 密钥:

$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "ssh_public_key": "ssh-rsa AAAAB3NzaC1yc2EAAAADAQABAAABgQDZrD4LMkAEeoU2vShhF8VM+cCZtVRgB7tqtsMxms2q3TOJZAgfuqReKYWm+OLOZTD+DO3Hn1pah/mU3u7uJfTUg4wEX0Le8zBu9xJVym0BVmSFkzHfIJVTn6SfZ81NqcalisGWkpmkKXVCdnVAX6RsbHfpGKk9YPQarmRCn5KzkelJK4hrSWpBPjdzkFXaIpf64JBZtew9XVYA3QeXkIcFuq7NBuUH9BonroPEmIXNOa41PUP1IWq3mERNgzHZiuU8Ks/pFuU5HCMvv4qbTOIhiig7vidImHPpqYT/TCkuVi5w0ZZgkkBeLnxWxH0ldrfzgFBYAxnpTU8Ih/4VhG538Ix1hxPaM6cXds2ic71mBbtbSrk+zjtNPaeYk1O7UpcCw4jjHspU/rVV/DY51D5gSiiuaFPBMucnYPgUxy4FMBFfGrmGLIzTKiLzcz0DiSz1jBeTQOX++1nz+KDLBD8CPdi5k4dq7lLkapRk85qdEvgaG5RlHMSPSS3wDrQ51fD8= user@hostname" } ' | jq

4.6.1. 修改 Operator

您可以从之前作为安装的一部分的已注册的集群资源中添加或删除 Operator。这只有在启动 OpenShift Container Platform 安装前才有可能。

您可以为 /v2/clusters/{cluster_id} 端点使用 PATCH 方法来设置所需的 Operator 定义。

先决条件

- 您已刷新了 API 令牌。

-

您已将

CLUSTER_ID导出为一个环境变量。

流程

运行以下命令来修改 Operator:

$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "olm_operators": [{"name": "mce"}, {"name": "cnv"}], 1 } ' | jq '.id'- 1

- 为 OpenShift Virtualization 指定

cnv、为多集群引擎指定mce、为 Red Hat OpenShift Data Foundation 指定odf或为 Logical Volume Manager Storage 指定lvm。要删除之前安装的 Operator,请从值列表中排除它。要删除所有之前安装的 Operator,请指定一个空数组:"olm_operators": []。

输出示例

{ <various cluster properties>, "monitored_operators": [ { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "console", "operator_type": "builtin", "status_updated_at": "0001-01-01T00:00:00.000Z", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "cvo", "operator_type": "builtin", "status_updated_at": "0001-01-01T00:00:00.000Z", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "mce", "namespace": "multicluster-engine", "operator_type": "olm", "status_updated_at": "0001-01-01T00:00:00.000Z", "subscription_name": "multicluster-engine", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "cnv", "namespace": "openshift-cnv", "operator_type": "olm", "status_updated_at": "0001-01-01T00:00:00.000Z", "subscription_name": "hco-operatorhub", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "lvm", "namespace": "openshift-local-storage", "operator_type": "olm", "status_updated_at": "0001-01-01T00:00:00.000Z", "subscription_name": "local-storage-operator", "timeout_seconds": 4200 } ], <more cluster properties>注意输出是新集群状态的描述。输出中的

monitored_operators属性包含两种类型的 Operator:-

"operator_type": "builtin":此类型的 Operator 是 OpenShift Container Platform 不可分割的一部分。 -

"operator_type": "olm":此类型的 Operator 被用户手动或自动添加为一个依赖项。在本例中,LVM Storage Operator 被自动添加为 OpenShift Virtualization 的一个依赖项。

4.7. 注册新的基础架构环境

使用 Assisted Installer API 注册新集群定义后,使用 v2/infra-envs 端点创建一个基础架构环境。注册新的基础架构环境需要以下设置:

-

name -

pull_secret -

cpu_architecture

有关注册新基础架构环境时可以设置的字段的详情,请参阅 API viewer 中的 infra-env-create-params 模型。您可以在创建基础架构环境后修改基础架构环境。作为最佳实践,请考虑在创建新基础架构环境时包括 cluster_id。cluster_id 将基础架构环境与集群定义相关联。在创建新基础架构环境时,辅助安装程序也会生成发现 ISO。

先决条件

-

您已生成了一个有效的

API_TOKEN。令牌每 15 分钟过期一次。 - 您已下载了 pull secret。

-

可选: 注册一个新的集群定义并导出

cluster_id。

流程

刷新 API 令牌:

$ source refresh-token

注册新的基础架构环境。提供名称,最好包含集群名称。本例提供集群 ID,用于将基础架构环境与集群资源关联。以下示例指定了

image_type。您可以指定full-iso或minimal-iso。默认值为minimal-iso。可选: 您可以通过在请求中分片 pull secret 文件来注册新的基础架构环境:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt \ --arg cluster_id ${CLUSTER_ID} ' { "name": "testcluster-infra-env", "image_type":"full-iso", "cluster_id": $cluster_id, "cpu_architecture" : "<architecture_name>", 1 "pull_secret": $pull_secret[0] | tojson } ')" | jq '.id'注意- 1

- 表示有效的值。它们包括:

x86_64,arm64,ppc64le,s390x,multi

可选: 您可以通过将配置写入 JSON 文件并在请求中引用它来注册新的基础架构环境:

$ cat << EOF > infra-envs.json { "name": "testcluster", "pull_secret": $PULL_SECRET, "proxy": { "http_proxy": "", "https_proxy": "", "no_proxy": "" }, "ssh_authorized_key": "$CLUSTER_SSHKEY", "image_type": "full-iso", "cluster_id": "${CLUSTER_ID}", "openshift_version": "4.11" } EOF$ curl -s -X POST "https://api.openshift.com/api/assisted-install/v2/infra-envs" -d @./infra-envs.json -H "Content-Type: application/json" -H "Authorization: Bearer $API_TOKEN" | jq '.id'

为

INFRA_ENV_ID变量分配返回的id并导出它:$ export INFRA_ENV_ID=<id>

创建基础架构环境并通过 cluster_id 将其与集群定义相关联后,您可以在 Assisted Installer Web 用户界面中看到集群设置。如果您关闭终端会话,则需要在新终端会话中重新导出 id。

4.8. 修改基础架构环境

您可以使用 /v2/infra-envs/{infra_env_id} 端点修改基础架构环境。修改基础架构环境是添加设置(如网络、SSH 密钥或 ignition 配置覆盖)的常见操作。

如需了解在修改基础架构环境时您可以设置的字段的详情,请参阅 API viewer 中的 infra-env-update-params 模型。修改新的基础架构环境时,辅助安装程序也会重新生成发现 ISO。

先决条件

- 您已创建了新的基础架构环境。

流程

刷新 API 令牌:

$ source refresh-token

修改基础架构环境:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "image_type":"minimal-iso", "pull_secret": $pull_secret[0] | tojson } ')" | jq

4.8.1. 可选:添加内核参数

通过辅助安装程序为 Red Hat Enterprise Linux CoreOS (RHCOS)内核提供内核参数意味着在引导时向内核传递特定参数或选项,特别是在您无法自定义发现 ISO 的内核参数时。内核参数可控制内核行为的各个方面以及操作系统配置,影响硬件交互、系统性能和功能。内核参数用于自定义或告知节点的 RHCOS 内核有关硬件配置、调试首选项、系统服务以及其他低级设置。

RHCOS 安装程序 kargs modify 命令支持 append、delete 和 replace 选项。

您可以使用 /v2/infra-envs/{infra_env_id} 端点修改基础架构环境。修改新的基础架构环境时,辅助安装程序也会重新生成发现 ISO。

流程

刷新 API 令牌:

$ source refresh-token

修改内核参数:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "kernel_arguments": [{ "operation": "append", "value": "<karg>=<value>" }], 1 "image_type":"minimal-iso", "pull_secret": $pull_secret[0] | tojson } ')" | jq- 1

- 将

<karg>替换为内核参数,将<value>替换为内核参数值。例如:rd.net.timeout.carrier=60。您可以通过为每个内核参数添加 JSON 对象来指定多个内核参数。

4.9. 添加主机

配置集群资源和基础架构环境后,下载发现 ISO 镜像。您可以从两个镜像中选择:

-

完整 ISO 镜像 :在启动时使用完整的 ISO 镜像必须自我包含。该镜像包括引导和启动辅助安装程序代理所需的所有内容。ISO 镜像的大小大约为 1GB。这是使用 RHEL KVM 安装时对

s390x架构的推荐方法。 - 最小 ISO 镜像:当虚拟介质连接的带宽有限时,使用最小 ISO 镜像。这是默认设置。镜像仅包含使用联网引导主机所需的内容。在引导时会下载大多数内容。ISO 镜像大小为 100MB。

目前,对于具有 z/VM 的 IBM Z (s390x)上的安装不支持 ISO 镜像。详情请参阅 使用 iPXE 引导主机。

您可以使用三种方法,使用发现镜像引导主机。详情请参阅 使用发现镜像引导主机。

先决条件

- 您已创建了集群。

- 您已创建了基础架构环境。

- 您已完成配置。

- 如果集群主机位于需要使用代理的防火墙后面,您已为代理服务器的 HTTP 和 HTTPS URL 配置了用户名、密码、IP 地址和端口。

-

您已选择了镜像类型,或者使用默认的

minimal-iso。

流程

- 如果需要,配置发现镜像。详情请参阅 配置发现镜像。

刷新 API 令牌:

$ source refresh-token

获取下载 URL:

$ curl -H "Authorization: Bearer ${API_TOKEN}" \ https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/downloads/image-url输出示例

{ "expires_at": "2024-02-07T20:20:23.000Z", "url": "https://api.openshift.com/api/assisted-images/bytoken/<TOKEN>/<OCP_VERSION>/<CPU_ARCHITECTURE>/<FULL_OR_MINIMAL_IMAGE>.iso" }下载发现镜像:

$ wget -O discovery.iso <url>

将

<url>替换为上一步中的下载 URL。- 使用发现镜像引导主机。

- 为主机分配角色。

4.10. 修改主机

添加主机后,根据需要修改主机。最常见的修改是 host_name 和 host_role 参数。

您可以使用 /v2/infra-envs/{infra_env_id}/hosts/{host_id} 端点修改主机。如需了解在修改主机时您可以设置的字段的详情,请参阅 API viewer 中的 host-update-params 模型。

主机可以是两个角色中的一个:

-

master: 带有master角色的一个主机,作为控制平面(control plane)主机。 -

worker: 带有worker角色的主机,作为 worker 主机。

默认情况下,辅助安装程序将主机设置为 auto-assign,这意味着安装程序会自动确定主机是 master 角色还是 worker 角色。使用以下流程设置主机的角色:

先决条件

- 您已将主机添加到集群中。

流程

刷新 API 令牌:

$ source refresh-token

获取主机 ID:

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

修改主机:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "host_role":"worker" "host_name" : "worker-1" } ' | jq- 1

- 将

<host_id>替换为主机的 ID。

4.10.1. 修改存储磁盘配置

主机发现期间检索到的每个主机都可能有多个存储磁盘。您可以选择修改每个磁盘的默认配置。

先决条件

- 配置集群并发现主机。详情请查看 其它资源。

查看存储磁盘

您可以查看集群中的主机,以及每个主机上的磁盘。这可让您对特定磁盘执行操作。

流程

刷新 API 令牌:

$ source refresh-token

获取集群的主机 ID:

$ curl -s "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

输出示例

$ "1022623e-7689-8b2d-7fbd-e6f4d5bb28e5"

注意这是单个主机的 ID。多个主机 ID 用逗号分开。

获取特定主机的磁盘:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -H "Authorization: Bearer ${API_TOKEN}" \ | jq '.inventory | fromjson | .disks'- 1

- 将

<host_id>替换为相关主机的 ID。

输出示例

$ [ { "by_id": "/dev/disk/by-id/wwn-0x6c81f660f98afb002d3adc1a1460a506", "by_path": "/dev/disk/by-path/pci-0000:03:00.0-scsi-0:2:0:0", "drive_type": "HDD", "has_uuid": true, "hctl": "1:2:0:0", "id": "/dev/disk/by-id/wwn-0x6c81f660f98afb002d3adc1a1460a506", "installation_eligibility": { "eligible": true, "not_eligible_reasons": null }, "model": "PERC_H710P", "name": "sda", "path": "/dev/sda", "serial": "0006a560141adc3a2d00fb8af960f681", "size_bytes": 6595056500736, "vendor": "DELL", "wwn": "0x6c81f660f98afb002d3adc1a1460a506" } ]注意这是一个磁盘的输出。它包含磁盘的

disk_id和installation_eligibility属性。

更改安装磁盘

辅助安装程序默认随机分配一个安装磁盘。如果主机有多个存储磁盘,您可以选择一个不同的磁盘作为安装磁盘。这会自动取消之前磁盘的分配。

您可以选择任何其 installation_eligibility 属性为 eligible: true 的磁盘为安装磁盘。

流程

- 获取主机和存储磁盘 ID。详情请参阅 查看存储磁盘。

可选:识别当前安装磁盘:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -H "Authorization: Bearer ${API_TOKEN}" \ | jq '.installation_disk_id'- 1

- 将

<host_id>替换为相关主机的 ID。

分配一个新的安装磁盘:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -X PATCH \ -H "Content-Type: application/json" \ -H "Authorization: Bearer ${API_TOKEN}" \ { "disks_selected_config": [ { "id": "<disk_id>", 2 "role": "install" } ] }

禁用磁盘格式化

辅助安装程序在安装过程中默认将所有可引导磁盘标记为进行格式化,无论它们是否已被定义为安装磁盘。格式化会导致数据丢失。

您可以选择禁用特定磁盘的格式化。这应该谨慎执行,因为可引导磁盘可能会干扰安装过程,主要在引导顺序方面。

您无法禁用对安装磁盘的格式化。

流程

- 获取主机和存储磁盘 ID。详情请参阅 查看存储磁盘。

运行以下命令:

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -X PATCH \ -H "Content-Type: application/json" \ -H "Authorization: Bearer ${API_TOKEN}" \ { "disks_skip_formatting": [ { "disk_id": "<disk_id>", 2 "skip_formatting": true 3 } ] }

4.11. 添加自定义清单

自定义清单是一个 JSON 或 YAML 文件,其包含辅助安装程序用户界面目前不支持的高级配置。您可以创建一个自定义清单,或使用第三方提供的清单。要使用 API 创建一个自定义清单,请使用 /v2/clusters/$CLUSTER_ID/manifests 端点。

您可以使用辅助安装程序 API 将 base64 编码的自定义清单上传到 openshift 文件夹或 manifests 文件夹。对允许的自定义清单数量没有限制。

一次只能上传一个 base64 编码的 JSON 清单。但是,每个上传的 base64 编码的 YAML 文件可以包含多个自定义清单。上传多文档 YAML 清单比单独添加 YAML 文件要快。

对于包含一个自定义清单的文件,可接受的文件扩展名包括 .yaml、.yml 或 .json。

一个自定义清单示例

{

"apiVersion": "machineconfiguration.openshift.io/v1",

"kind": "MachineConfig",

"metadata": {

"labels": {

"machineconfiguration.openshift.io/role": "primary"

},

"name": "10_primary_storage_config"

},

"spec": {

"config": {

"ignition": {

"version": "3.2.0"

},

"storage": {

"disks": [

{

"device": "</dev/xxyN>",

"partitions": [

{

"label": "recovery",

"startMiB": 32768,

"sizeMiB": 16384

}

]

}

],

"filesystems": [

{

"device": "/dev/disk/by-partlabel/recovery",

"label": "recovery",

"format": "xfs"

}

]

}

}

}

}

对于包含多个自定义清单的文件,可接受的文件类型包括 .yaml 或 .yml。

多个自定义清单示例

apiVersion: machineconfiguration.openshift.io/v1

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: master

name: 99-openshift-machineconfig-master-kargs

spec:

kernelArguments:

- loglevel=7

---

apiVersion: machineconfiguration.openshift.io/v2

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: worker

name: 98-openshift-machineconfig-worker-kargs

spec:

kernelArguments:

- loglevel=5

- 当在 Oracle Cloud Infrastructure (OCI)外部平台上安装 OpenShift Container Platform 时,您必须添加 Oracle 提供的自定义清单。对于其它外部合作伙伴集成,如 vSphere 或 Nutanix,此步骤是可选的。

- 有关自定义清单的更多信息,请参阅 其它资源。

先决条件

-

您已生成了一个有效的

API_TOKEN。令牌每 15 分钟过期一次。 -

您已注册了一个新的集群定义,并将

cluster_id导出到$CLUSTER_IDBASH 变量。

流程

- 创建一个自定义清单文件。

- 使用合适的文件格式的扩展名保存自定义清单文件。

刷新 API 令牌:

$ source refresh-token

运行以下命令,将自定义清单添加到集群中:

$ curl -X POST "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/manifests" \ -H "Authorization: Bearer $API_TOKEN" \ -H "Content-Type: application/json" \ -d '{ "file_name":"manifest.json", "folder":"manifests", "content":"'"$(base64 -w 0 ~/manifest.json)"'" }' | jq将

manifest.json替换为清单文件的名称。manifest.json的第二个实例是文件的路径。确保路径正确。输出示例

{ "file_name": "manifest.json", "folder": "manifests" }注意base64 -w 0命令使用 base64 将清单编码为一个字符串,并省略回车。带回车的的编码将产生一个异常。验证辅助安装程序是否添加了清单:

curl -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/manifests/files?folder=manifests&file_name=manifest.json" -H "Authorization: Bearer $API_TOKEN"

将

manifest.json替换为清单文件的名称。

其他资源

4.12. 预安装验证

Assisted Installer 确保集群在安装前满足先决条件,因为它消除了复杂的安装后故障排除,从而节省大量时间和工作时间。在安装集群前,请确保集群和每个主机都通过了预安装验证。

其他资源

4.13. 安装集群

一旦集群主机经过验证,您就可以安装集群。

先决条件

- 您已创建了集群和基础架构环境。

- 您已将主机添加到基础架构环境中。

- 主机已通过验证。

流程

刷新 API 令牌:

$ source refresh-token

安装集群:

$ curl -H "Authorization: Bearer $API_TOKEN" \ -X POST \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/actions/install | jq

- 完成所有安装后平台集成步骤。

第 5 章 可选:启用磁盘加密

您可以使用 TPM v2 或 Tang 加密模式启用安装磁盘加密。

在某些情况下,当您在固件中为裸机主机启用 TPM 磁盘加密时,然后从您使用辅助安装程序生成的 ISO 引导它,集群部署可能会卡住。如果以前的安装在主机中保留了 TPM 加密密钥,则可能会出现这种情况。如需更多信息,请参阅 BZ#2011634。如果您遇到这个问题,请联系红帽支持。

5.1. 启用 TPM v2 加密

先决条件

-

检查每个主机上的 BIOS 是否启用了 TPM v2 加密。大多数 Dell 系统都需要这个设置。检查您的计算机手册。Assisted Installer 还验证固件中是否启用了 TPM。详情请查看 Assisted Installer API 中的

disk-encruption模式。

验证每个节点上是否安装了 TPM v2 加密芯片,并在固件中启用。

流程

- 可选: 使用 UI,在用户界面向导的 集群详情 步骤中,选择在 control plane 节点、worker 或这两个节点上启用 TPM v2 加密。

可选:使用 API,请遵循"修改主机"过程。将

disk_encryption.enable_on设置设置为all,masters, 或workers。将disk_encryption.mode设置设置为tpmv2。刷新 API 令牌:

$ source refresh-token

启用 TPM v2 加密:

$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "disk_encryption": { "enable_on": "none", "mode": "tpmv2" } } ' | jqenable_on的有效设置是all,master,worker, 或none。

5.2. 启用 Tang 加密

先决条件

- 您可以使用 Red Hat Enterprise Linux(RHEL)8 机器来生成 Tang Exchange 密钥的指纹。

流程

- 设置 Tang 服务器或访问现有服务器。具体步骤请查看 网络绑定磁盘加密。您可以设置多个 Tang 服务器,但 Assisted Installer 在安装过程中需要可以连接到所有 Tang 服务器。

在 Tang 服务器上,使用

tang-show-keys检索 Tang 服务器的 thumbprint:$ tang-show-keys <port>

可选:将

<port>替换为端口号。默认端口号为80。thumbprint 示例

1gYTN_LpU9ZMB35yn5IbADY5OQ0

可选:使用

jose获取 Tang 服务器的 thumbprint。确保在 Tang 服务器中安装了

jose:$ sudo dnf install jose

在 Tang 服务器上,使用

jose检索 thumbprint:$ sudo jose jwk thp -i /var/db/tang/<public_key>.jwk

将

<public_key>替换为 Tang 服务器的公共交换密钥。thumbprint 示例

1gYTN_LpU9ZMB35yn5IbADY5OQ0

- 可选:在用户界面向导的 Cluster details 步骤中,选择在 control plane 节点、worker 或这两个节点上启用 Tang 加密。您需要为 Tang 服务器输入 URL 和 thumbprints。

可选:使用 API,请遵循"修改主机"过程。

刷新 API 令牌:

$ source refresh-token

将

disk_encryption.enable_on设置设置为all,masters, 或workers。将disk_encryption.mode设置设置为tang。设置disk_encyrption.tang_servers,以提供一个或多个 Tang 服务器的 URL 和 thumbprint 详情:$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "disk_encryption": { "enable_on": "all", "mode": "tang", "tang_servers": "[{\"url\":\"http://tang.example.com:7500\",\"thumbprint\":\"PLjNyRdGw03zlRoGjQYMahSZGu9\"},{\"url\":\"http://tang2.example.com:7500\",\"thumbprint\":\"XYjNyRdGw03zlRoGjQYMahSZGu3\"}]" } } ' | jqenable_on的有效设置是all,master,worker, 或none。在tang_servers值中,注释掉对象中的引号。

5.3. 其他资源

第 6 章 配置发现镜像

Assisted Installer 使用初始镜像来运行在尝试安装 OpenShift Container Platform 前执行硬件和网络验证的代理。您可以使用 Ignition 自定义发现镜像。

对发现镜像的修改不会在系统中保留。

6.1. 创建 Ignition 配置文件

Ignition 是一个低级系统配置实用程序,它是 initramfs 临时初始根文件系统的一部分。当 Ignition 在第一次引导时运行时,它会在 Ignition 配置文件中找到配置数据,并在调用 switch_root 之前将其应用到主机,以 pivot 到主机的根文件系统。

Ignition 使用 JSON 配置规格文件来代表第一次引导时发生的一组更改。

不支持比 3.2 更新的 Ignition 版本,并引发一个错误。

流程

创建 Ignition 文件并指定配置规格版本:

$ vim ~/ignition.conf

{ "ignition": { "version": "3.1.0" } }将配置数据添加到 Ignition 文件。例如,为

core用户添加密码。生成密码哈希:

$ openssl passwd -6

在

core用户中添加生成的密码哈希:{ "ignition": { "version": "3.1.0" }, "passwd": { "users": [ { "name": "core", "passwordHash": "$6$spam$M5LGSMGyVD.9XOboxcwrsnwNdF4irpJdAWy.1Ry55syyUiUssIzIAHaOrUHr2zg6ruD8YNBPW9kW0H8EnKXyc1" } ] } }

保存 Ignition 文件并将其导出到

IGNITION_FILE变量:$ export IGNITION_FILE=~/ignition.conf

6.2. 使用 Ignition 修改发现镜像

创建 Ignition 配置文件后,您可以使用 Assisted Installer API 修补基础架构环境来修改发现镜像。

先决条件

- 如果您使用 UI 创建集群,则已设置 API 身份验证。

-

您有一个基础架构环境,并将基础架构环境

id导出至INFRA_ENV_ID变量。 -

您有一个有效的 Ignition 文件,并将文件名导出为

$IGNITION_FILE。

流程

创建

ignition_config_overrideJSON 对象并将其重定向到文件中:$ jq -n \ --arg IGNITION "$(jq -c . $IGNITION_FILE)" \ '{ignition_config_override: $IGNITION}' \ > discovery_ignition.json刷新 API 令牌:

$ source refresh-token

对基础架构环境进行补丁:

$ curl \ --header "Authorization: Bearer $API_TOKEN" \ --header "Content-Type: application/json" \ -XPATCH \ -d @discovery_ignition.json \ https://api.openshift.com/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID | jq

ignition_config_override对象引用 Ignition 文件。- 下载更新的发现镜像。

第 7 章 使用发现镜像引导主机

Assisted Installer 使用初始镜像来运行在尝试安装 OpenShift Container Platform 前执行硬件和网络验证的代理。您可以使用三种方法使用发现镜像引导主机:

- USB 驱动器

- RedFish 虚拟介质

- iPXE

7.1. 在 USB 驱动器中创建 ISO 镜像

您可以使用包含发现 ISO 镜像的 USB 驱动器安装 Assisted Installer 代理。使用 USB 驱动器启动主机为软件安装准备主机。

流程

- 在管理主机上,在 USB 端口中插入 USB 驱动器。

将 ISO 镜像复制到 USB 驱动器中,例如:

# dd if=<path_to_iso> of=<path_to_usb> status=progress

其中:

- <path_to_iso>

-

是下载的发现 ISO 文件的相对路径,如

discovery.iso。 - <path_to_usb>

是连接的 USB 驱动器的位置,例如

/dev/sdb。将 ISO 复制到 USB 驱动器后,您可以使用 USB 驱动器在集群主机上安装辅助安装程序代理。

7.2. 使用 USB 驱动器引导

要使用可引导 USB 驱动器将节点注册到 Assisted Installer,请使用以下步骤。

流程

- 将 RHCOS 发现 ISO USB 驱动器插入到目标主机中。

- 在服务器固件设置中配置启动驱动器顺序,以便从附加的发现 ISO 启动,然后重启服务器。

等待主机启动。

- 对于 UI 安装,在管理主机上返回浏览器。等待主机出现在已发现的主机列表中。

对于 API 安装,刷新令牌,检查启用的主机计数,并收集主机 ID:

$ source refresh-token

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.enabled_host_count'

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

输出示例

[ "1062663e-7989-8b2d-7fbb-e6f4d5bb28e5" ]

7.3. 使用 Redfish API 从 HTTP 托管 ISO 镜像引导

您可以使用 Redfish Baseboard Management Controller (BMC) API 安装的 ISO 来置备网络中的主机。

先决条件

- 下载安装 Red Hat Enterprise Linux CoreOS (RHCOS) ISO。

流程

- 将 ISO 文件复制到网络中的 HTTP 服务器。

从托管 ISO 文件引导主机,例如:

运行以下命令调用 redfish API,将托管的 ISO 设置为

VirtualMedia引导介质:$ curl -k -u <bmc_username>:<bmc_password> \ -d '{"Image":"<hosted_iso_file>", "Inserted": true}' \ -H "Content-Type: application/json" \ -X POST <host_bmc_address>/redfish/v1/Managers/iDRAC.Embedded.1/VirtualMedia/CD/Actions/VirtualMedia.InsertMedia其中:

- <bmc_username>:<bmc_password>

- 是目标主机 BMC 的用户名和密码。

- <hosted_iso_file>

-

是托管安装 ISO 的 URL ,例如:

https://example.com/rhcos-live-minimal.iso。ISO 必须从目标主机机器中访问。 - <host_bmc_address>

- 是目标主机计算机的 BMC IP 地址。

运行以下命令,将主机设置为从

VirtualMedia设备引导:$ curl -k -u <bmc_username>:<bmc_password> \ -X PATCH -H 'Content-Type: application/json' \ -d '{"Boot": {"BootSourceOverrideTarget": "Cd", "BootSourceOverrideMode": "UEFI", "BootSourceOverrideEnabled": "Once"}}' \ <host_bmc_address>/redfish/v1/Systems/System.Embedded.1重启主机:

$ curl -k -u <bmc_username>:<bmc_password> \ -d '{"ResetType": "ForceRestart"}' \ -H 'Content-type: application/json' \ -X POST <host_bmc_address>/redfish/v1/Systems/System.Embedded.1/Actions/ComputerSystem.Reset可选: 如果主机已关闭,您可以使用

{"ResetType": "On"}开关引导它。运行以下命令:$ curl -k -u <bmc_username>:<bmc_password> \ -d '{"ResetType": "On"}' -H 'Content-type: application/json' \ -X POST <host_bmc_address>/redfish/v1/Systems/System.Embedded.1/Actions/ComputerSystem.Reset

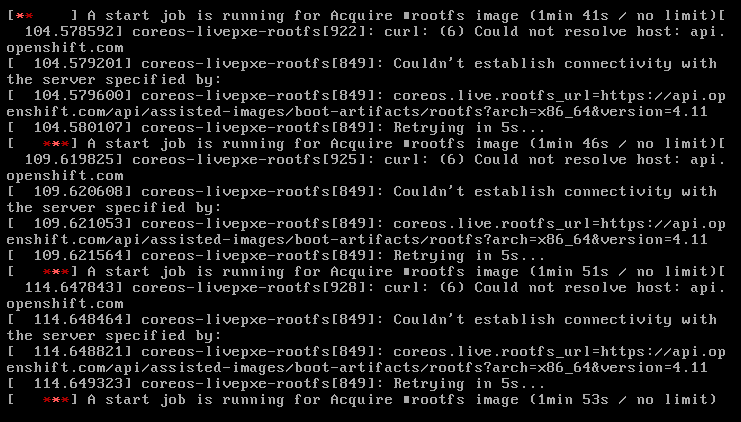

7.4. 使用 iPXE 引导主机

Assisted Installer 提供了一个 iPXE 脚本,包括为基础架构环境引导发现镜像所需的所有工件。由于 iPXE 的当前 HTTPS 实施的限制,建议是下载并公开 HTTP 服务器中所需的工件。目前,即使 iPXE 支持 HTTPS 协议,支持的算法也比较旧且不推荐。

支持的密码的完整列表位于 https://ipxe.org/crypto 中。

先决条件

- 您已使用 API 创建基础架构环境,或使用 UI 创建集群。

-

在 shell 中将您的基础架构环境 ID 导出为

$INFRA_ENV_ID。 -

您在访问 API 时具有凭证,并在 shell 中将令牌导出为

$API_TOKEN。 - 您有一个 HTTP 服务器来托管镜像。

通过 UI 配置时,$INFRA_ENV_ID 和 $API_TOKEN 变量会被提供。

IBM Power 只支持 PXE,这还需要: 您已在 /var/lib/tftpboot安装了 grub2。已安装了 DHCP 和 TFTP for PXE

流程

直接从 UI 下载 iPXE 脚本,或者从 Assisted Installer 获取 iPXE 脚本:

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID/downloads/files?file_name=ipxe-script > ipxe-script

Example

#!ipxe initrd --name initrd http://api.openshift.com/api/assisted-images/images/<infra_env_id>/pxe-initrd?arch=x86_64&image_token=<token_string>&version=4.10 kernel http://api.openshift.com/api/assisted-images/boot-artifacts/kernel?arch=x86_64&version=4.10 initrd=initrd coreos.live.rootfs_url=http://api.openshift.com/api/assisted-images/boot-artifacts/rootfs?arch=x86_64&version=4.10 random.trust_cpu=on rd.luks.options=discard ignition.firstboot ignition.platform.id=metal console=tty1 console=ttyS1,115200n8 coreos.inst.persistent-kargs="console=tty1 console=ttyS1,115200n8" boot

通过从

ipxe-script中提取 URL 下载所需的工件。下载初始 RAM 磁盘:

$ awk '/^initrd /{print $NF}' ipxe-script | curl -o initrd.img下载 linux 内核:

$ awk '/^kernel /{print $2}' ipxe-script | curl -o kernel下载根文件系统:

$ grep ^kernel ipxe-script | xargs -n1| grep ^coreos.live.rootfs_url | cut -d = -f 2- | curl -o rootfs.img

将 URL 更改为

ipxe-script'中不同的工件,以匹配本地 HTTP 服务器。例如:#!ipxe set webserver http://192.168.0.1 initrd --name initrd $webserver/initrd.img kernel $webserver/kernel initrd=initrd coreos.live.rootfs_url=$webserver/rootfs.img random.trust_cpu=on rd.luks.options=discard ignition.firstboot ignition.platform.id=metal console=tty1 console=ttyS1,115200n8 coreos.inst.persistent-kargs="console=tty1 console=ttyS1,115200n8" boot

可选:当在 IBM zSystems 上使用 RHEL KVM 安装时,您必须通过指定附加内核参数来引导主机

random.trust_cpu=on rd.luks.options=discard ignition.firstboot ignition.platform.id=metal console=tty1 console=ttyS1,115200n8 coreos.inst.persistent-kargs="console=tty1 console=ttyS1,115200n8

注意如果您在 RHEL KVM 上使用 iPXE 安装,在一些情况下,虚拟机主机上的虚拟机不会在第一次引导时重启,需要手动启动。

可选:在 IBM Power 上安装时,您必须下载 intramfs、kernel 和 root,如下所示:

- 将 initrd.img 和 kernel.img 复制到 PXE 目录 '/var/lib/tftpboot/rhcos '

- 将 rootfs.img 复制到 HTTPD 目录 '/var/www/html/install '

在 '/var/lib/tftpboot/boot/grub2/grub.cfg ' 中添加以下条目:

if [ ${net_default_mac} == fa:1d:67:35:13:20 ]; then default=0 fallback=1 timeout=1 menuentry "CoreOS (BIOS)" { echo "Loading kernel" linux "/rhcos/kernel.img" ip=dhcp rd.neednet=1 ignition.platform.id=metal ignition.firstboot coreos.live.rootfs_url=http://9.114.98.8:8000/install/rootfs.img echo "Loading initrd" initrd "/rhcos/initrd.img" } fi

第 8 章 为主机分配角色

您可以为发现的主机分配角色。这些角色定义集群中主机的功能。角色可以是标准 Kubernetes 类型之一: control plane (master) 或 worker。

主机必须满足您选择的角色的最低要求。您可以通过引用本文档的先决条件部分或使用 preflight 要求 API 来查找硬件要求。

如果您没有选择角色,系统会为您选择一个。您可以在安装启动前随时更改角色。

8.1. 使用 UI 选择角色

您可以在主机完成其发现后选择角色。

流程

- 进入 Host Discovery 选项卡,向下滚动到 Host Inventory 表。

- 选择所需主机的 Auto-assign 下拉菜单。

- 选择 Control plane 节点 来为这个主机分配一个 control plane 角色。

- 选择 Worker 为这个主机分配一个 worker 角色。

- 检查验证状态。

8.2. 使用 API 选择角色

您可以使用 /v2/infra-envs/{infra_env_id}/hosts/{host_id} 端点为主机选择一个角色。主机可以是两个角色之一:

-

master: 带有master角色的一个主机,作为控制平面(control plane)主机。 -

worker: 带有worker角色的主机,作为 worker 主机。

默认情况下,辅助安装程序将主机设置为 auto-assign,这意味着安装程序将确定主机是否是 master 角色还是 worker 角色。使用这个流程设置主机的角色。

先决条件

- 您已将主机添加到集群中。

流程

刷新 API 令牌:

$ source refresh-token

获取主机 ID:

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

输出示例

[ "1062663e-7989-8b2d-7fbb-e6f4d5bb28e5" ]

修改

host_role设置:$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "host_role":"worker" } ' | jq将

<host_id>替换为主机的 ID。

8.3. 自动分配角色

如果您没有自行分配角色,安装程序会自动为主机选择一个角色。角色选择机制决定主机的内存、CPU 和磁盘空间。它的目的是,为可以满足 control plane 节点的最低要求的 3 个弱主机分配 control plane 角色。所有其他主机默认为 worker 节点。目标是提供足够的资源来运行 control plane,并保留具有更多资源的主机用于运行实际工作负载。

您可以在安装前随时覆盖 auto-assign 决定。

这个验证可以确保,自动选择是一个有效的值。

8.4. 其他资源

第 9 章 预安装验证

9.1. 预安装验证的定义

Assisted Installer 旨在使集群安装尽可能简单、高效且无错误。Assisted Installer 在开始安装前对配置和收集的遥测执行验证检查。

Assisted Installer 将使用安装前提供的信息,如 control plane 拓扑、网络配置和主机名。它还将使用您要安装的主机的实时遥测。

当主机引导发现 ISO 时,代理将在主机上启动。代理会将主机状态的信息发送到 Assisted Installer。

辅助安装程序使用所有这些信息来计算实时安装验证。所有验证都可以是,阻止安装,或不阻塞安装。

9.2. 阻塞和非阻塞验证

阻塞验证将阻止安装的进度,这意味着您需要解决问题,并在继续操作前通过阻塞验证。

非阻塞验证是一个警告,并将告诉您可能引起问题的事情。

9.3. 验证类型

Assisted Installer 执行两种类型的验证:

主机

主机验证可确保给定主机的配置对安装有效。

Cluster

集群验证可确保整个集群的配置对安装有效。

9.4. 主机验证

9.4.1. 使用 REST API 获取主机验证

如果您使用基于 Web 的 UI,则其中许多验证不会按名称显示。要获取与标签一致的验证列表,请使用以下步骤。

先决条件

-

已安装

jq工具。 - 您已使用 API 创建基础架构环境,或使用 UI 创建集群。

- 您的主机使用发现 ISO 引导

-

在 shell 中以

CLUSTER_ID的形式导出集群 ID。 -

您在访问 API 时具有凭证,并在 shell 中导出令牌作为

API_TOKEN。

流程

刷新 API 令牌:

$ source refresh-token

获取所有主机的所有验证:

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/hosts \ | jq -r .[].validations_info \ | jq 'map(.[])'

获取所有主机的没有通过的验证:

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/hosts \ | jq -r .[].validations_info \ | jq 'map(.[]) | map(select(.status=="failure" or .status=="pending")) | select(length>0)'

9.4.2. 详细的主机验证

| 参数 | 验证类型 | 描述 |

|---|---|---|

|

| 非阻塞 | 检查主机最近与 Assisted Installer 进行通信。 |

|

| 非阻塞 | 检查 Assisted Installer 是否从主机收到清单。 |

|

| 非阻塞 | 检查 CPU 内核数是否满足最低要求。 |

|

| 非阻塞 | 检查内存量是否满足最低要求。 |

|

| 非阻塞 | 检查至少一个可用磁盘是否满足资格标准。 |

|

| 阻塞 | 检查内核数是否满足主机角色的最低要求。 |

|

| 阻塞 | 检查内存量是否满足主机角色的最低要求。 |

|

| 阻塞 | 对于第 2 天,检查主机是否可以从第 1 天集群中下载 ignition 配置。 |

|

| 阻塞 | 大多数组是集群中最大的 full-mesh 连接组,所有成员都可以与所有其他成员通信。此验证检查多节点中的第 1 天集群在大多数组中。 |

|

| 阻塞 | 检查平台是否对网络设置有效。 |

|

| 非阻塞 | 检查 NTP 服务器是否已成功用于同步主机上的时间。 |

|

| 非阻塞 | 检查容器镜像是否已成功从镜像 registry 中拉取。 |

|

| 阻塞 | 检查磁盘是否加快了之前安装的指标满足要求(如果存在)。 |

|

| 阻塞 | 检查集群中主机之间的平均网络延迟是否满足要求。 |

|

| 阻塞 | 检查集群中主机之间的网络数据包丢失是否满足要求。 |

|

| 阻塞 | 检查主机是否配置了默认路由。 |

|

| 阻塞 | 对于带有用户管理网络的多节点集群。检查主机是否可以解析集群的 API 域名。 |

|

| 阻塞 | 对于带有用户管理网络的多节点集群。检查主机是否可以解析集群的内部 API 域名。 |

|

| 阻塞 | 对于带有用户管理网络的多节点集群。检查主机是否可以解析集群的内部 apps 域名。 |

|

| 非阻塞 | 检查主机是否与集群平台兼容 |

|

| 阻塞 | 检查通配符 DNS *.<cluster_name>.<base_domain> 是否已配置,因为这会导致 OpenShift 的已知问题 |

|

| 非阻塞 | 检查配置的主机和磁盘加密的类型是否满足要求。 |

|

| 阻塞 | 检查此主机没有重叠的子网。 |

|

| 阻塞 | 检查主机名是否在集群中是唯一的。 |

|

| 阻塞 | 检查主机名的有效性,这意味着它与常规主机名格式匹配且没有被禁止。 |

|

| 阻塞 | 检查主机 IP 是否在机器 CIDR 的地址范围内。 |

|

| 阻塞 | 验证集群是否满足 Local Storage Operator 的要求。 |

|

| 阻塞 | 验证集群是否满足 Openshift Data Foundation Operator 的要求。

|

|

| 阻塞 | 验证集群是否满足容器原生虚拟化的要求。

|

|

| 阻塞 | 验证集群是否满足逻辑卷管理器 Operator 的要求。

|

|

| 非阻塞 | 验证每个有效磁盘是否将 disk.EnableUUID 设置为 true。在 VSphere 中,这将导致每个磁盘都有一个 UUID。 |

|

| 阻塞 | 检查发现代理版本是否与代理 docker 镜像版本兼容。 |

|

| 阻塞 | 检查安装磁盘是否没有跳过磁盘格式。 |

|

| 阻塞 | 检查标记为跳过格式的所有磁盘是否在清单中。磁盘 ID 可能会在重启后改变,此验证可防止出现此问题的问题。 |

|

| 阻塞 | 检查安装介质到主机的连接。 |

|

| 非阻塞 | 检查集群是否存在机器网络定义。 |

|

| 阻塞 | 检查平台是否与网络设置兼容。只有安装单节点 Openshift 或使用用户管理时,某些平台才被允许。 |

9.5. 集群验证

9.5.1. 使用 REST API 获取集群验证

如果您使用基于 Web 的 UI,则其中许多验证不会按名称显示。要获取与标签一致的验证列表,请按照以下流程操作。

先决条件

-

已安装

jq工具。 - 您已使用 API 创建基础架构环境,或使用 UI 创建集群。

-

在 shell 中以

CLUSTER_ID的形式导出集群 ID。 -

您在访问 API 时具有凭证,并在 shell 中导出令牌作为

API_TOKEN。

流程

刷新 API 令牌:

$ source refresh-token

获取所有集群验证:

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID \ | jq -r .validations_info \ | jq 'map(.[])'

获取没有通过的集群验证:

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID \ | jq -r .validations_info \ | jq '. | map(.[] | select(.status=="failure" or .status=="pending")) | select(length>0)'

9.5.2. 详细的集群验证

| 参数 | 验证类型 | 描述 |

|---|---|---|

|

| 非阻塞 | 检查集群是否存在机器网络定义。 |

|

| 非阻塞 | 检查集群是否存在集群网络定义。 |

|

| 非阻塞 | 检查集群是否存在服务网络定义。 |

|

| 阻塞 | 检查定义的网络没有重叠。 |

|

| 阻塞 | 检查定义的网络是否共享相同的地址系列 (有效地址系列为 IPv4、IPv6) |

|

| 阻塞 | 检查集群网络前缀,以确保其有效,并为所有主机有足够的地址空间。 |

|

| 阻塞 |

对于非用户管理的网络集群。检查 |

|

| 非阻塞 |

对于非用户管理的网络集群。检查 |

|

| 阻塞 |

对于非用户管理的网络集群。检查 |

|

| 阻塞 |

对于非用户管理的网络集群。检查 |

|

| 非阻塞 |

对于非用户管理的网络集群。检查 |

|

| 阻塞 | 检查集群中的所有主机是否处于 "ready to install" 状态。 |

|

| 阻塞 | 此验证只适用于多节点集群。

|

|

| 非阻塞 | 检查集群是否存在基本 DNS 域。 |

|

| 非阻塞 | 检查 pull secret 存在。不会检查 pull secret 是否有效或被授权。 |

|

| 阻塞 | 检查每个主机的时钟与其他主机的时钟没有进行同步的时间不超过 4 分钟。 |

|

| 阻塞 | 验证集群是否满足 Local Storage Operator 的要求。 |

|

| 阻塞 | 验证集群是否满足 Openshift Data Foundation Operator 的要求。

|

|

| 阻塞 | 验证集群是否满足容器原生虚拟化的要求。

|

|

| 阻塞 | 验证集群是否满足逻辑卷管理器 Operator 的要求。

|

|

| 阻塞 | 检查网络类型的有效性(如果存在)。

|

第 10 章 网络配置

这部分论述了使用 Assisted Installer 进行网络配置的基础知识。

10.1. 集群网络

OpenShift 使用各种网络类型和地址,并在下表中列出。

| 类型 | DNS | 描述 |

|---|---|---|

|

| 从中分配 Pod IP 地址的 IP 地址池。 | |

|

| 服务的 IP 地址池。 | |

|

| 组成集群的机器的 IP 地址块。 | |

|

|

| 用于 API 通信的 VIP。此设置必须在 DNS 中提供或预先配置,以便默认名称可以正确解析。如果要使用双栈网络部署,则必须是 IPv4 地址。 |

|

|

|

用于 API 通信的 VIP。此设置必须在 DNS 中提供或预先配置,以便默认名称可以正确解析。如果使用双栈网络,则第一个地址必须是 IPv4 地址,第二个地址必须是 IPv6 地址。您还必须设置 |

|

|

| 用于入口流量的 VIP。如果要使用双栈网络部署,则必须是 IPv4 地址。 |

|

|

|

用于入口流量的 VIP。如果您使用双栈网络部署,则第一个地址必须是 IPv4 地址,第二个地址必须是 IPv6 地址。您还必须设置 |

OpenShift Container Platform 4.12 引入了新的 apiVIPs 和 ingressVIPs 设置,用于接受双栈网络的多个 IP 地址。使用双栈网络时,第一个 IP 地址必须是 IPv4 地址,第二个 IP 地址必须是 IPv6 地址。新设置将替换 apiVIP 和 IngressVIP,但在使用 API 修改配置时,您必须同时设置新的和旧设置。

根据所需的网络堆栈,您可以选择不同的网络接口控制器。目前,辅助服务可以使用以下配置之一部署 OpenShift Container Platform 集群:

- IPv4

- IPv6

- 双栈 (IPv4 + IPv6)

支持的网络接口控制器取决于所选的堆栈,并在下表中总结。如需详细的 Container Network Interface (CNI)网络提供商功能比较,请参阅 OCP 网络文档。

| 堆栈 | SDN | OVN |

|---|---|---|

| IPv4 | 是 | 是 |

| IPv6 | 否 | 是 |

| dual-stack | 否 | 是 |

OVN 是 OpenShift Container Platform 4.12 及更新的版本中的默认 Container Network Interface (CNI)。SDN 最多支持 OpenShift Container Platform 4.14,但不支持 OpenShift Container Platform 4.15 及更新版本。

10.1.1. 限制

10.1.1.1. SDN

- 单节点 OpenShift (SNO)不支持 SDN 控制器。

- SDN 控制器不支持 IPv6。

- OpenShift Container Platform 4.15 及更新版本不支持 SDN 控制器。如需更多信息,请参阅 OpenShift Container Platform 发行注记中的 OpenShift SDN 网络插件。

10.1.1.2. OVN-Kubernetes

10.1.2. 集群网络

集群网络是一个网络,集群中部署的每个 Pod 都从中获取其 IP 地址。如果工作负载可以在组成集群的多个节点间存在,因此网络供应商可以根据 Pod 的 IP 地址轻松查找单个节点。为此,clusterNetwork.cidr 被进一步分成 clusterNetwork.hostPrefix 中定义的大小的子网。

主机前缀指定分配给集群中每个节点的子网的长度。集群如何为多节点集群分配地址的示例:

---

clusterNetwork:

- cidr: 10.128.0.0/14

hostPrefix: 23

---使用上述代码片段创建 3 节点集群可以创建以下网络拓扑:

-

在节点 #1 中调度的 Pod 从

10.128.0.0/23获取 IP -

在节点 #2 中调度的 Pod 从

10.128.2.0/23获取 IP -

在节点 #3 中调度的 Pod 从

10.128.4.0/23获取 IP

解释 OVN-K8s 超出了本文档的范围,但上述的模式提供了在不同节点之间路由 Pod 到Pod 流量的方法,而无需保留 Pod 和对应节点之间的大量映射列表。

10.1.3. 机器网络

机器网络是由组成集群用来相互通信的所有主机使用的网络。这也是必须包括 API 和 Ingress VIP 的子网。

10.1.4. 与多节点集群相比的 SNO

取决于您要部署单节点 OpenShift 还是多节点集群,需要使用不同的值。下表更详细地说明了这一点。

| 参数 | SNO | 使用 DHCP 模式的多节点集群 | 没有 DHCP 模式的多节点集群 |

|---|---|---|---|

|

| 必填 | 必填 | 必填 |

|

| 必填 | 必填 | 必填 |

|

| 可以自动分配 (*) | 可以自动分配 (*) | 可以自动分配 (*) |

|

| 禁止 | 禁止 | 必填 |

|

| 禁止 | 禁止 | 4.12 及更新的版本需要 |

|

| 禁止 | 禁止 | 必填 |

|

| 禁止 | 禁止 | 4.12 及更新的版本需要 |

如果只有一个主机网络,则机器网络 CIDR 的自动分配。否则,您需要明确指定它。

10.1.5. air-gapped 环境

在没有互联网访问的情况下部署集群的工作流有一些超出本文档范围的先决条件。您可以参阅 Zero Touch Provisioning the hard way Git repository 以了解更多信息。

10.2. VIP DHCP 分配

VIP DHCP 分配是允许用户跳过为 API 和 Ingress 手动提供虚拟 IP 和 Ingress 的要求,利用服务从 DHCP 服务器自动分配这些 IP 地址。

如果您启用这个功能,而不是使用来自集群配置的 api_vips 和 ingress_vips,服务会发送租期分配请求,并根据回复相应地使用 VIP。该服务将从 Machine Network 分配 IP 地址。

请注意,这不是 OpenShift Container Platform 功能,它已在辅助服务中实施,以简化配置。

VIP DHCP 分配目前仅限于 OpenShift Container Platform SDN 网络类型。OpenShift Container Platform 版本 4.15 及更新版本不支持 SDN。因此,对 VIP DHCP 分配的支持也会从 OpenShift Container Platform 4.15 及之后版本结束。

10.2.1. 启用自动分配的有效负载示例

---

{

"vip_dhcp_allocation": true,

"network_type": "OVNKubernetes",

"user_managed_networking": false,

"cluster_networks": [

{

"cidr": "10.128.0.0/14",

"host_prefix": 23

}

],

"service_networks": [

{

"cidr": "172.30.0.0/16"

}

],

"machine_networks": [

{

"cidr": "192.168.127.0/24"

}

]

}

---10.2.2. 禁用自动分配的有效负载示例

---

{

"api_vips": [

{

"ip": "192.168.127.100"

}

],

"ingress_vips": [

{

"ip": "192.168.127.101"

}

],

"vip_dhcp_allocation": false,

"network_type": "OVNKubernetes",

"user_managed_networking": false,

"cluster_networks": [

{

"cidr": "10.128.0.0/14",

"host_prefix": 23

}

],

"service_networks": [

{

"cidr": "172.30.0.0/16"

}

]

}

---10.3. 其他资源

- 裸机 IPI 文档 提供了对 VIP 地址的语法的额外解释。

10.4. 了解用户管理和集群管理的网络之间的区别

用户管理的网络是 Assisted Installer 中的一项功能,它允许具有非标准网络拓扑的客户部署 OpenShift Container Platform 集群。示例包括:

-

具有不需要使用

keepalived和 VRRP 处理 VIP 地址的外部负载均衡器的客户。 - 使用在许多不同 L2 网络片段间分布的集群节点部署。

10.4.1. 验证

在允许安装启动前,辅助安装程序中会发生各种网络验证。当您启用用户管理的网络时,以下验证更改:

- L3 连接检查 (ICMP) 被执行,而不是 L2 检查 (ARP)

10.5. 静态网络配置

您可以在生成或更新发现 ISO 时使用静态网络配置。

10.5.1. 先决条件

- 熟悉 NMState。

10.5.2. NMState 配置

YAML 格式的 NMState 文件指定主机所需的网络配置。它具有在发现时将替换为接口的实际名称的接口的逻辑名称。

10.5.2.1. NMState 配置示例

---

dns-resolver:

config:

server:

- 192.168.126.1

interfaces:

- ipv4:

address:

- ip: 192.168.126.30

prefix-length: 24

dhcp: false

enabled: true

name: eth0

state: up

type: ethernet

- ipv4:

address:

- ip: 192.168.141.30

prefix-length: 24

dhcp: false

enabled: true

name: eth1

state: up

type: ethernet

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.126.1

next-hop-interface: eth0

table-id: 254

---10.5.3. MAC 接口映射

MAC 接口映射是一个属性,它使用主机上的实际接口映射 NMState 配置中定义的逻辑接口。

映射应始终使用主机上的物理接口。例如,当 NMState 配置定义了绑定或 VLAN 时,映射应该只包含父接口的条目。

10.5.3.1. MAC 接口映射示例

---

mac_interface_map: [

{

mac_address: 02:00:00:2c:23:a5,

logical_nic_name: eth0

},

{

mac_address: 02:00:00:68:73:dc,

logical_nic_name: eth1

}

]

---10.5.4. 额外的 NMState 配置示例

以下示例仅用于显示部分配置。您不应该原样使用它们,而是根据您的具体环境对它们进行相应的调整。如果使用错误,可能会导致您的机器没有网络连接。

10.5.4.1. 标记的 VLAN

---

interfaces:

- ipv4:

address:

- ip: 192.168.143.15

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

name: eth0.404

state: up

type: vlan

vlan:

base-iface: eth0

id: 404

reorder-headers: true

---10.5.4.2. 网络绑定

---

interfaces:

- ipv4:

address:

- ip: 192.168.138.15

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

link-aggregation:

mode: active-backup

options:

all_slaves_active: delivered

miimon: "140"

slaves:

- eth0

- eth1

name: bond0

state: up

type: bond

---10.6. 使用 API 应用静态网络配置

您可以使用 Assisted Installer API 应用静态网络配置。

先决条件

- 您已使用 API 创建基础架构环境,或者已使用 UI 创建集群。

-

在 shell 中将您的基础架构环境 ID 导出为

$INFRA_ENV_ID。 -

您在访问 API 时具有凭证,并在 shell 中将令牌导出为

$API_TOKEN。 -

您有带有静态网络配置的 YAML 文件,作为

server-a.yaml和server-b.yaml。

流程

使用 API 请求创建一个临时文件

/tmp/request-body.txt:--- jq -n --arg NMSTATE_YAML1 "$(cat server-a.yaml)" --arg NMSTATE_YAML2 "$(cat server-b.yaml)" \ '{ "static_network_config": [ { "network_yaml": $NMSTATE_YAML1, "mac_interface_map": [{"mac_address": "02:00:00:2c:23:a5", "logical_nic_name": "eth0"}, {"mac_address": "02:00:00:68:73:dc", "logical_nic_name": "eth1"}] }, { "network_yaml": $NMSTATE_YAML2, "mac_interface_map": [{"mac_address": "02:00:00:9f:85:eb", "logical_nic_name": "eth1"}, {"mac_address": "02:00:00:c8:be:9b", "logical_nic_name": "eth0"}] } ] }' >> /tmp/request-body.txt ---刷新 API 令牌:

$ source refresh-token

将请求发送到 Assisted Service API 端点:

--- $ curl -H "Content-Type: application/json" \ -X PATCH -d @/tmp/request-body.txt \ -H "Authorization: Bearer ${API_TOKEN}" \ https://api.openshift.com/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID ---

10.7. 其他资源

10.8. 转换为双栈网络

双栈 IPv4/IPv6 配置允许部署驻留在 IPv4 和 IPv6 子网中的 pod 的集群。

10.8.1. 先决条件

- 您熟悉 OVN-K8s 文档

10.8.2. 单一节点 OpenShift 的有效负载示例

---

{

"network_type": "OVNKubernetes",

"user_managed_networking": false,

"cluster_networks": [

{

"cidr": "10.128.0.0/14",

"host_prefix": 23

},

{

"cidr": "fd01::/48",

"host_prefix": 64

}

],

"service_networks": [

{"cidr": "172.30.0.0/16"}, {"cidr": "fd02::/112"}

],

"machine_networks": [

{"cidr": "192.168.127.0/24"},{"cidr": "1001:db8::/120"}

]

}

---10.8.3. 由多个节点组成的 OpenShift Container Platform 集群的有效负载示例

---

{

"vip_dhcp_allocation": false,

"network_type": "OVNKubernetes",

"user_managed_networking": false,

"api_vips": [

{

"ip": "192.168.127.100"

},

{

"ip": "2001:0db8:85a3:0000:0000:8a2e:0370:7334"

}

],

"ingress_vips": [

{

"ip": "192.168.127.101"

},

{

"ip": "2001:0db8:85a3:0000:0000:8a2e:0370:7335"

}

],

"cluster_networks": [

{

"cidr": "10.128.0.0/14",

"host_prefix": 23

},

{

"cidr": "fd01::/48",

"host_prefix": 64

}

],

"service_networks": [

{"cidr": "172.30.0.0/16"}, {"cidr": "fd02::/112"}

],

"machine_networks": [

{"cidr": "192.168.127.0/24"},{"cidr": "1001:db8::/120"}

]

}

---10.8.4. 限制

在使用双栈网络时,api_vips IP 地址和 ingress_vips IP 地址设置必须是主 IP 地址系列的设置,其必须是 IPv4 地址。目前,红帽不支持将 IPv6 作为主要 IP 地址系列的双栈 VIP 或双栈网络。红帽支持双栈网络,并将 IPv4 作为主要 IP 地址系列,以及 IPv6 作为辅助 IP 地址系列。因此,在输入 IP 地址值时,您必须在 IPv6 条目前面放置 IPv4 条目。

10.9. 其他资源

第 11 章 扩展集群

您可以使用用户界面或 API 添加主机来扩展使用 Assisted Installer 安装的集群。

11.1. 先决条件

- 您必须有权访问辅助安装程序集群。

-

您必须安装 OpenShift CLI (

oc)。 - 确保将 worker 节点添加到集群中的集群需要的所有 DNS 记录。

-

如果要将 worker 节点添加到具有多个 CPU 架构的集群,您必须确保该架构被设置为

multi。 -

如果您要将

arm64、IBM Power或IBM zSystems计算节点添加到现有x86_64集群中,请使用支持混合架构的平台。详情请参阅 安装混合架构集群

11.2. 检查多个构架

将节点添加到具有多个架构的集群时,请确保将 architecture 设置设置为 multi。

流程

- 使用 CLI 登录集群。

检查

architecture设置:$ oc adm release info -o json | jq .metadata.metadata

确保

architecture设置设为 'multi'。{ "release.openshift.io/architecture": "multi" }

11.3. 使用 UI 添加主机

您可以将主机添加到使用 Assisted Installer 创建的集群。

只有在运行 OpenShift Container Platform 版本 4.11 及 up 的集群才支持将主机添加到 Assisted Installer 集群。

流程

- 登录 OpenShift Cluster Manager,再点您要扩展的集群。

- 点 Add hosts 并下载新主机的发现 ISO,添加 SSH 公钥并根据需要配置集群范围的代理设置。

- 可选:根据需要修改 ignition 文件。

- 使用发现 ISO 引导目标主机,并等待在控制台中发现主机。

-

选择主机角色。它可以是

worker或control plane主机。 - 开始安装。

当安装继续进行时,安装会为主机生成待处理的证书签名请求 (CSR)。出现提示时,批准待处理的 CSR 以完成安装。

主机成功安装后,它在集群 Web 控制台中列为主机。

新的主机将使用与原始集群相同的方法进行加密。

11.4. 使用 API 添加主机

您可以使用 Assisted Installer REST API 将主机添加到集群。

先决条件

-

安装 OpenShift Cluster Manager CLI (

ocm)。 - 以具有集群创建权限的用户身份登录 OpenShift Cluster Manager。

-

安装

jq。 - 确保您要扩展的集群存在所有必需的 DNS 记录。

流程

- 针对 Assisted Installer REST API 进行身份验证,并为会话生成 API 令牌。生成的令牌有效期仅为 15 分钟。

运行以下命令设置

$API_URL变量:$ export API_URL=<api_url> 1- 1

- 将

<api_url>替换为 Assisted Installer API URL,例如https://api.openshift.com

运行以下命令导入集群:

设置

$CLUSTER_ID变量。登录到集群并运行以下命令:$ export CLUSTER_ID=$(oc get clusterversion -o jsonpath='{.items[].spec.clusterID}')设置用于导入集群的

$CLUSTER_REQUEST变量:$ export CLUSTER_REQUEST=$(jq --null-input --arg openshift_cluster_id "$CLUSTER_ID" '{ "api_vip_dnsname": "<api_vip>", 1 "openshift_cluster_id": $CLUSTER_ID, "name": "<openshift_cluster_name>" 2 }')导入集群并设置

$CLUSTER_ID变量。运行以下命令:$ CLUSTER_ID=$(curl "$API_URL/api/assisted-install/v2/clusters/import" -H "Authorization: Bearer ${API_TOKEN}" -H 'accept: application/json' -H 'Content-Type: application/json' \ -d "$CLUSTER_REQUEST" | tee /dev/stderr | jq -r '.id')

运行以下命令,为集群生成

InfraEnv资源并设置$INFRA_ENV_ID变量:- 从位于 console.redhat.com 的 Red Hat OpenShift Cluster Manager 下载 pull secret 文件。

设置

$INFRA_ENV_REQUEST变量:export INFRA_ENV_REQUEST=$(jq --null-input \ --slurpfile pull_secret <path_to_pull_secret_file> \1 --arg ssh_pub_key "$(cat <path_to_ssh_pub_key>)" \2 --arg cluster_id "$CLUSTER_ID" '{ "name": "<infraenv_name>", 3 "pull_secret": $pull_secret[0] | tojson, "cluster_id": $cluster_id, "ssh_authorized_key": $ssh_pub_key, "image_type": "<iso_image_type>" 4 }')- 1

- 将

<path_to_pull_secret_file>替换为包含从位于 console.redhat.com 的 Red Hat OpenShift Cluster Manager 下载的 pull secret 的本地文件的路径。 - 2

- 将

<path_to_ssh_pub_key>替换为访问主机所需的公共 SSH 密钥的路径。如果没有设置这个值,则无法在发现模式下访问主机。 - 3

- 将

<infraenv_name>替换为InfraEnv资源的纯文本名称。 - 4

- 将

<iso_image_type>替换为 ISO 镜像类型,可以是full-iso或minimal-iso。

将

$INFRA_ENV_REQUEST发布到 /v2/infra-envs API,并设置$INFRA_ENV_ID变量:$ INFRA_ENV_ID=$(curl "$API_URL/api/assisted-install/v2/infra-envs" -H "Authorization: Bearer ${API_TOKEN}" -H 'accept: application/json' -H 'Content-Type: application/json' -d "$INFRA_ENV_REQUEST" | tee /dev/stderr | jq -r '.id')

运行以下命令,获取集群主机的发现 ISO 的 URL:

$ curl -s "$API_URL/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID" -H "Authorization: Bearer ${API_TOKEN}" | jq -r '.download_url'输出示例

https://api.openshift.com/api/assisted-images/images/41b91e72-c33e-42ee-b80f-b5c5bbf6431a?arch=x86_64&image_token=eyJhbGciOiJIUzI1NiIsInR5cCI6IkpXVCJ9.eyJleHAiOjE2NTYwMjYzNzEsInN1YiI6IjQxYjkxZTcyLWMzM2UtNDJlZS1iODBmLWI1YzViYmY2NDMxYSJ9.1EX_VGaMNejMhrAvVRBS7PDPIQtbOOc8LtG8OukE1a4&type=minimal-iso&version=4.12

下载 ISO:

$ curl -L -s '<iso_url>' --output rhcos-live-minimal.iso 1- 1

- 将

<iso_url>替换为上一步中的 ISO URL。

-

从下载的

rhcos-live-minimal.iso中引导新的 worker 主机。 获取没有安装的集群中的主机列表。继续运行以下命令,直到新主机显示:

$ curl -s "$API_URL/api/assisted-install/v2/clusters/$CLUSTER_ID" -H "Authorization: Bearer ${API_TOKEN}" | jq -r '.hosts[] | select(.status != "installed").id'输出示例

2294ba03-c264-4f11-ac08-2f1bb2f8c296

为新主机设置

$HOST_ID变量,例如:$ HOST_ID=<host_id> 1- 1

- 将

<host_id>替换为上一步中的主机 ID。

运行以下命令检查主机是否已就绪:

注意确保复制整个命令,包括完整的

jq表达式。$ curl -s $API_URL/api/assisted-install/v2/clusters/$CLUSTER_ID -H "Authorization: Bearer ${API_TOKEN}" | jq ' def host_name($host): if (.suggested_hostname // "") == "" then if (.inventory // "") == "" then "Unknown hostname, please wait" else .inventory | fromjson | .hostname end else .suggested_hostname end; def is_notable($validation): ["failure", "pending", "error"] | any(. == $validation.status); def notable_validations($validations_info): [ $validations_info // "{}" | fromjson | to_entries[].value[] | select(is_notable(.)) ]; { "Hosts validations": { "Hosts": [ .hosts[] | select(.status != "installed") | { "id": .id, "name": host_name(.), "status": .status, "notable_validations": notable_validations(.validations_info) } ] }, "Cluster validations info": { "notable_validations": notable_validations(.validations_info) } } ' -r输出示例

{ "Hosts validations": { "Hosts": [ { "id": "97ec378c-3568-460c-bc22-df54534ff08f", "name": "localhost.localdomain", "status": "insufficient", "notable_validations": [ { "id": "ntp-synced", "status": "failure", "message": "Host couldn't synchronize with any NTP server" }, { "id": "api-domain-name-resolved-correctly", "status": "error", "message": "Parse error for domain name resolutions result" }, { "id": "api-int-domain-name-resolved-correctly", "status": "error", "message": "Parse error for domain name resolutions result" }, { "id": "apps-domain-name-resolved-correctly", "status": "error", "message": "Parse error for domain name resolutions result" } ] } ] }, "Cluster validations info": { "notable_validations": [] } }当上一个命令显示主机就绪时,通过运行以下命令来使用 /v2/infra-envs/{infra_env_id}/hosts/{host_id}/actions/install API 开始安装:

$ curl -X POST -s "$API_URL/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID/hosts/$HOST_ID/actions/install" -H "Authorization: Bearer ${API_TOKEN}"当安装继续进行时,安装会为主机生成待处理的证书签名请求 (CSR)。

重要您必须批准 CSR 才能完成安装。

运行以下 API 调用以监控集群安装:

$ curl -s "$API_URL/api/assisted-install/v2/clusters/$CLUSTER_ID" -H "Authorization: Bearer ${API_TOKEN}" | jq '{ "Cluster day-2 hosts": [ .hosts[] | select(.status != "installed") | {id, requested_hostname, status, status_info, progress, status_updated_at, updated_at, infra_env_id, cluster_id, created_at} ] }'输出示例

{ "Cluster day-2 hosts": [ { "id": "a1c52dde-3432-4f59-b2ae-0a530c851480", "requested_hostname": "control-plane-1", "status": "added-to-existing-cluster", "status_info": "Host has rebooted and no further updates will be posted. Please check console for progress and to possibly approve pending CSRs", "progress": { "current_stage": "Done", "installation_percentage": 100, "stage_started_at": "2022-07-08T10:56:20.476Z", "stage_updated_at": "2022-07-08T10:56:20.476Z" }, "status_updated_at": "2022-07-08T10:56:20.476Z", "updated_at": "2022-07-08T10:57:15.306369Z", "infra_env_id": "b74ec0c3-d5b5-4717-a866-5b6854791bd3", "cluster_id": "8f721322-419d-4eed-aa5b-61b50ea586ae", "created_at": "2022-07-06T22:54:57.161614Z" } ] }可选: 运行以下命令以查看集群的所有事件:

$ curl -s "$API_URL/api/assisted-install/v2/events?cluster_id=$CLUSTER_ID" -H "Authorization: Bearer ${API_TOKEN}" | jq -c '.[] | {severity, message, event_time, host_id}'输出示例

{"severity":"info","message":"Host compute-0: updated status from insufficient to known (Host is ready to be installed)","event_time":"2022-07-08T11:21:46.346Z","host_id":"9d7b3b44-1125-4ad0-9b14-76550087b445"} {"severity":"info","message":"Host compute-0: updated status from known to installing (Installation is in progress)","event_time":"2022-07-08T11:28:28.647Z","host_id":"9d7b3b44-1125-4ad0-9b14-76550087b445"} {"severity":"info","message":"Host compute-0: updated status from installing to installing-in-progress (Starting installation)","event_time":"2022-07-08T11:28:52.068Z","host_id":"9d7b3b44-1125-4ad0-9b14-76550087b445"} {"severity":"info","message":"Uploaded logs for host compute-0 cluster 8f721322-419d-4eed-aa5b-61b50ea586ae","event_time":"2022-07-08T11:29:47.802Z","host_id":"9d7b3b44-1125-4ad0-9b14-76550087b445"} {"severity":"info","message":"Host compute-0: updated status from installing-in-progress to added-to-existing-cluster (Host has rebooted and no further updates will be posted. Please check console for progress and to possibly approve pending CSRs)","event_time":"2022-07-08T11:29:48.259Z","host_id":"9d7b3b44-1125-4ad0-9b14-76550087b445"} {"severity":"info","message":"Host: compute-0, reached installation stage Rebooting","event_time":"2022-07-08T11:29:48.261Z","host_id":"9d7b3b44-1125-4ad0-9b14-76550087b445"}- 登录到集群并批准待处理的 CSR 以完成安装。

验证

检查新主机是否已成功添加到集群中,状态为

Ready:$ oc get nodes

输出示例

NAME STATUS ROLES AGE VERSION control-plane-1.example.com Ready master,worker 56m v1.25.0 compute-1.example.com Ready worker 11m v1.25.0

11.5. 安装一个混合架构集群

在 OpenShift Container Platform 版本 4.12.0 及更新版本中,带有 x86_64 控制平面的集群支持两种不同 CPU 架构的混合架构 worker 节点。混合架构集群结合了每个架构的优势,并支持各种工作负载。

从 4.12.0 版本开始,您可以向带有 x86_64 控制平面的现有 OpenShift Container Platform 集群中添加 arm64 worker 节点。从版本 4.14.0 开始,您可以将 IBM Power 或 IBM zSystems worker 节点添加到现有的 x86_64 控制平面中。