지원 설치 관리자를 사용하여 OpenShift Container Platform 설치

사용자 가이드

초록

머리말

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 이러한 변경 사항은 가능한 한 점진적으로 업데이트되고 있습니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

Red Hat 문서에 관한 피드백 제공

Jira에서 문제 생성 양식을 제출하여 피드백을 제공하거나 오류를 보고할 수 있습니다. Jira 문제는 Red Hat Hybrid Cloud Infrastructure Jira 프로젝트에서 생성되어 피드백의 진행 상황을 추적할 수 있습니다.

- Jira에 로그인했는지 확인합니다. Jira 계정이 없는 경우 피드백을 제출할 계정을 생성합니다.

문제 생성을클릭합니다.

- 요약 및 설명 필드를 작성합니다. 설명 필드에 문서 URL, 장 또는 섹션 번호, 문제에 대한 자세한 설명을 포함합니다. 양식의 다른 필드를 수정하지 마십시오.

- 생성을 클릭합니다.

문서 개선을 위한 의견에 감사드립니다.

1장. 지원 설치 관리자 정보

Red Hat OpenShift Container Platform 지원 설치 프로그램은 Red Hat Hybrid Cloud Console 에서 제공되는 사용자 친화적인 설치 솔루션입니다. 지원 설치 관리자는 베어 메탈, Nutanix, vSphere 및 Oracle Cloud Infrastructure에 중점을 두고 다양한 배포 플랫폼을 지원합니다.

다음 플랫폼의 경우 선택적 HTTP/S 프록시를 사용하여 연결된 환경의 온프레미스에 OpenShift Container Platform을 설치할 수 있습니다.

- 고가용성 OpenShift Container Platform 또는 단일 노드 OpenShift 클러스터

- 완전한 플랫폼 통합 또는 통합이 없는 기타 가상화 플랫폼이 있는 베어 메탈 또는 vSphere의 OpenShift Container Platform

- 선택적으로 OpenShift Virtualization 및 Red Hat OpenShift Data Foundation

1.1. 기능

지원 설치 관리자는 설치 기능을 서비스로 제공합니다. SaaS(Software-as-a-Service) 접근 방식에는 다음과 같은 기능이 있습니다.

- 웹 인터페이스

- 설치 구성 파일을 수동으로 생성하는 대신 하이브리드 클라우드 콘솔 을 사용하여 클러스터를 설치할 수 있습니다.

- 부트스트랩 노드 없음

- 부트스트랩 프로세스가 클러스터 내의 노드에서 실행되므로 부트스트랩 노드가 필요하지 않습니다.

- 간소화된 설치 워크플로

- 클러스터를 배포하기 위해 OpenShift Container Platform에 대한 지식이 필요하지 않습니다. 지원 설치 프로그램은 적절한 기본 구성을 제공합니다.

- OpenShift Container Platform 설치 프로그램을 로컬에서 실행할 필요가 없습니다.

- 최신 테스트된 z-stream 릴리스의 최신 지원 설치 프로그램에 액세스할 수 있습니다.

- 고급 네트워킹 옵션

- 지원 설치 프로그램은 OVN만, NMState 기반 고정 IP 주소 지정 및 HTTP/S 프록시가 있는 SDN 및 OVN, IPv6 및 듀얼 스택 네트워킹을 사용하여 IPv4 네트워킹을 지원합니다.

- OVN은 OpenShift Container Platform 4.12 이상의 기본 CNI(Container Network Interface)입니다.

- SDN은 OpenShift Container Platform 4.14까지 지원되며 OpenShift Container Platform 4.15에서 더 이상 사용되지 않습니다.

- 사전 설치 검증

설치하기 전에 지원 설치 프로그램에서 다음 구성을 확인합니다.

- 네트워크 연결

- 네트워크 대역폭

- 레지스트리에 연결

- 도메인 이름의 업스트림 DNS 확인

- 클러스터 노드 간 시간 동기화

- 클러스터 노드 하드웨어

- 설치 구성 매개변수

- REST API

- 지원 설치 관리자 REST API를 사용하여 설치 프로세스를 자동화할 수 있습니다.

1.2. API 지원 정책

지원 설치 관리자 API는 사용 중단 발표 후 최소 3개월 동안 지원됩니다.

2장. 지원 설치 관리자를 사용하여 설치 준비

클러스터를 설치하기 전에 클러스터 노드와 네트워크가 요구 사항을 충족하는지 확인해야 합니다.

2.1. 사전 요구 사항

- OpenShift Container Platform 설치 및 업데이트 프로세스에 대한 세부 사항을 검토했습니다.

- 클러스터 설치 방법 선택 및 사용자를 위한 준비에 대한 문서를 읽습니다.

- 방화벽을 사용하는 경우 지원 설치 프로그램이 작동하는 데 필요한 리소스에 액세스할 수 있도록 방화벽을 구성해야 합니다.

2.2. 지원되는 설치 관리자 사전 요구 사항

지원 설치 프로그램은 설치에 성공했는지 확인하기 위해 다음 사전 요구 사항을 검증합니다.

2.2.1. CPU 아키텍처

지원 설치 프로그램은 다음 CPU 아키텍처에서 지원됩니다.

- x86_64

- arm64

- ppc64le

- s390x

2.2.2. 하드웨어

단일 노드 OpenShift의 경우 지원 설치 프로그램에는 CPU 코어가 8개, 16GiB RAM 및 100GB 디스크 크기가 있는 하나의 호스트가 필요합니다.

다중 노드 클러스터의 경우 컨트롤 플레인 호스트에는 다음과 같은 리소스가 있어야 합니다.

- 4 CPU 코어

- 16.00GiB RAM

- 100GB 스토리지

-

etcd

wal_fsync_duration_seconds의 경우 10ms 쓰기 속도 이하

다중 노드 클러스터의 경우 작업자 호스트에는 다음과 같은 리소스가 있어야 합니다.

- CPU 코어 2개

- 8.00GiB RAM

- 100GB 스토리지

VMware 유형의 호스트의 경우 platform이 vSphere가 아닌 경우에도 clusterSet disk.enableUUID 를 true 로 설정합니다.

2.2.3. 네트워킹

네트워크는 다음 요구 사항을 충족해야 합니다.

- 고정 IP 주소를 사용하지 않는 한 DHCP 서버.

기본 도메인 이름입니다. 다음 요구 사항이 충족되었는지 확인해야 합니다.

-

*.<cluster_name>.<base_domain>과 같은 와일드카드가 없거나 설치가 진행되지 않습니다. -

api.<cluster_name>.<base_domain> 의 DNS A/AAAA 레코드입니다. -

*.apps.<cluster_name>.<base_domain>에 대한 와일드카드가 있는 DNS A/AAAA 레코드입니다.

-

-

방화벽 외부의 사용자가

ocCLI 툴을 통해 클러스터에 액세스할 수 있도록 하려면 포트6443이 API URL에 열려 있습니다. -

방화벽 외부의 사용자가 콘솔에 액세스하도록 허용하려면 콘솔에 포트

443이 열려 있습니다. - 사용자 관리 네트워킹을 사용할 때 클러스터의 각 노드에 대한 DNS A/AAAA 레코드가 진행되지 않습니다. 클러스터에 연결하기 위해 설치 후 Cluster Managed Networking을 사용할 때 클러스터의 각 노드에 DNS A/AAAA 레코드가 필요하지만 Cluster Managed Networking을 사용할 때 A/AAAA 레코드 없이 설치를 진행할 수 있습니다.

- 고정 IP 주소를 사용할 때 사전 설정된 호스트 이름으로 부팅하려는 경우 클러스터의 각 노드의 DNS PTR 레코드입니다. 그렇지 않으면 노드의 이름을 네트워크 인터페이스 MAC 주소로 이름을 바꾸는 고정 IP 주소를 사용할 때 지원 설치 관리자의 자동 노드 이름 변경 기능이 있습니다.

- 최상위 도메인 등록 기관의 DNS A/AAAA 레코드 설정은 업데이트하는 데 상당한 시간이 걸릴 수 있습니다. 설치 지연을 방지하기 위해 설치 전에 A/AAAA 레코드 DNS 설정이 작동하는지 확인합니다.

- DNS 레코드 예제는 이 장의 DNS 구성 예제 를 참조하십시오.

OpenShift Container Platform 클러스터 네트워크는 다음 요구 사항을 충족해야 합니다.

- 모든 클러스터 노드 간 연결

- 인터넷에 각 노드에 대한 연결

- 클러스터 노드 간 시간 동기화를 위해 NTP 서버에 액세스

2.2.4. DNS 구성 예

이 섹션에서는 지원 설치 관리자를 사용하여 OpenShift Container Platform 배포를 위한 DNS 요구 사항을 충족하는 A 및 PTR 레코드 구성 예제를 제공합니다. 이 예제에서는 하나의 DNS 솔루션을 선택하기 위한 조언을 제공하기 위한 것이 아닙니다.

이 예제에서 클러스터 이름은 ocp4이고 기본 도메인은 example.com입니다.

2.2.4.1. DNS A 레코드 구성 예

다음 예제는 지원 설치 관리자를 사용하여 설치된 클러스터의 이름 확인을 위한 샘플 A 레코드를 보여주는 BIND 영역 파일입니다.

DNS 영역 데이터베이스 예

$TTL 1W @ IN SOA ns1.example.com. root ( 2019070700 ; serial 3H ; refresh (3 hours) 30M ; retry (30 minutes) 2W ; expiry (2 weeks) 1W ) ; minimum (1 week) IN NS ns1.example.com. IN MX 10 smtp.example.com. ; ; ns1.example.com. IN A 192.168.1.1 smtp.example.com. IN A 192.168.1.5 ; helper.example.com. IN A 192.168.1.5 ; api.ocp4.example.com. IN A 192.168.1.5 1 api-int.ocp4.example.com. IN A 192.168.1.5 2 ; *.apps.ocp4.example.com. IN A 192.168.1.5 3 ; control-plane0.ocp4.example.com. IN A 192.168.1.97 4 control-plane1.ocp4.example.com. IN A 192.168.1.98 control-plane2.ocp4.example.com. IN A 192.168.1.99 ; worker0.ocp4.example.com. IN A 192.168.1.11 5 worker1.ocp4.example.com. IN A 192.168.1.7 ; ;EOF

- 1

- Kubernetes API의 이름 확인을 제공합니다. 레코드는 API 로드 밸런서의 IP 주소를 나타냅니다.

- 2

- Kubernetes API의 이름 확인을 제공합니다. 레코드는 API 로드 밸런서의 IP 주소를 참조하며 내부 클러스터 통신에 사용됩니다.

- 3

- 와일드카드 경로의 이름 확인을 제공합니다. 레코드는 애플리케이션 인그레스 로드 밸런서의 IP 주소를 나타냅니다. 애플리케이션 인그레스 로드 밸런서는 Ingress 컨트롤러 Pod를 실행하는 머신을 대상으로 합니다. Ingress 컨트롤러 Pod는 기본적으로 작업자 머신에서 실행됩니다.참고

이 예제에서는 Kubernetes API 및 애플리케이션 인그레스 트래픽에 동일한 로드 밸런서를 사용합니다. 프로덕션 시나리오에서는 각각에 대해 개별적으로 로드 밸런서 인프라를 확장할 수 있도록 API 및 애플리케이션 인그레스 로드 밸런서를 별도로 배포할 수 있습니다.

- 4

- 컨트롤 플레인 시스템의 이름 확인을 제공합니다.

- 5

- 작업자 시스템의 이름 확인을 제공합니다.

2.2.4.2. DNS PTR 레코드 구성의 예

다음 예제는 지원 설치 관리자를 사용하여 설치된 클러스터의 역방향 이름 확인을 위한 샘플 PTR 레코드를 보여주는 BIND 영역 파일입니다.

역방향 레코드에 대한 DNS 영역 데이터베이스의 예

$$TTL 1W @ IN SOA ns1.example.com. root ( 2019070700 ; serial 3H ; refresh (3 hours) 30M ; retry (30 minutes) 2W ; expiry (2 weeks) 1W ) ; minimum (1 week) IN NS ns1.example.com. ; 5.1.168.192.in-addr.arpa. IN PTR api.ocp4.example.com. 1 5.1.168.192.in-addr.arpa. IN PTR api-int.ocp4.example.com. 2 ; 97.1.168.192.in-addr.arpa. IN PTR control-plane0.ocp4.example.com. 3 98.1.168.192.in-addr.arpa. IN PTR control-plane1.ocp4.example.com. 99.1.168.192.in-addr.arpa. IN PTR control-plane2.ocp4.example.com. ; 11.1.168.192.in-addr.arpa. IN PTR worker0.ocp4.example.com. 4 7.1.168.192.in-addr.arpa. IN PTR worker1.ocp4.example.com. ; ;EOF

2.2.5. preflight 검증

지원 설치 관리자는 복잡한 설치 후 문제 해결을 제거하므로 설치 전에 클러스터가 사전 요구 사항을 충족할 수 있도록 하여 상당한 시간과 노력을 절약할 수 있습니다. 노드에 소프트웨어를 설치하기 전에 지원 설치 프로그램은 다음과 같은 검증을 수행합니다.

- 네트워크 연결 확인

- 충분한 네트워크 대역폭을 보장합니다.

- 레지스트리에 대한 연결 확인

- 모든 업스트림 DNS가 필요한 도메인 이름을 확인할 수 있는지 확인합니다.

- 클러스터 노드 간 시간 동기화 확인

- 클러스터 노드가 최소 하드웨어 요구 사항을 충족하는지 확인합니다.

- 설치 구성 매개변수 검증

지원 설치 프로그램이 예상 요구 사항을 성공적으로 확인하지 않으면 설치가 진행되지 않습니다.

3장. 지원 설치 프로그램 UI로 설치

클러스터 노드 및 네트워크 요구 사항이 충족되었는지 확인한 후 클러스터 설치를 시작할 수 있습니다.

3.1. 사전 설치 고려 사항

지원 설치 관리자를 사용하여 OpenShift Container Platform을 설치하기 전에 다음 구성 옵션을 고려해야 합니다.

- 사용할 기본 도메인

- 설치할 OpenShift Container Platform 제품 버전

- 전체 클러스터 또는 단일 노드 OpenShift 설치 여부

- DHCP 서버 또는 정적 네트워크 구성 사용 여부

- IPv4 또는 듀얼 스택 네트워킹 사용 여부

- OpenShift Virtualization 설치 여부

- Red Hat OpenShift Data Foundation 설치 여부

- 다중 클러스터 엔진(MCE) 설치 여부

- vSphere 또는 Nutanix에 설치할 때 플랫폼과 통합할지 여부

- 혼합 클러스터 아키텍처 설치 여부

3.2. 클러스터 세부 정보 설정

지원 설치 프로그램 웹 사용자 인터페이스를 사용하여 클러스터를 생성하려면 다음 절차를 사용하십시오.

프로세스

- Red Hat Hybrid Cloud Console 에 로그인합니다.

- Red Hat OpenShift 타일에서 애플리케이션 스케일링을 클릭합니다.

- 메뉴에서 클러스터를 클릭합니다.

- 클러스터 생성을 클릭합니다.

- Datacenter 탭을 클릭합니다.

- 지원 설치 관리자에서 클러스터 생성을 클릭합니다.

- 클러스터 이름 필드에 클러스터 이름을 입력합니다.

Base domain 필드에 클러스터의 기본 도메인을 입력합니다. 클러스터의 모든 하위 도메인은 이 기본 도메인을 사용합니다.

참고기본 도메인은 유효한 DNS 이름이어야 합니다. 기본 도메인에 대한 와일드카드 도메인이 설정되어 있지 않아야 합니다.

설치할 OpenShift Container Platform 버전을 선택합니다.

중요- IBM Power 및 IBM zSystems 플랫폼의 경우 OpenShift Container Platform 4.13 이상만 지원됩니다.

-

혼합 아키텍처 클러스터 설치의 경우 OpenShift Container Platform 4.12 이상을 선택하고

-multi옵션을 사용합니다. 혼합 아키텍처 클러스터 설치에 대한 자세한 내용은 추가 리소스를 참조하십시오.

선택 사항: 단일 노드에 OpenShift Container Platform을 설치하려면 Install single node Openshift (SNO) 를 선택합니다.

참고현재 SNO는 IBM zSystems 및 IBM Power 플랫폼에서 지원되지 않습니다.

- 선택 사항: 지원 설치 프로그램에 이미 계정에 연결된 풀 시크릿이 있습니다. 다른 풀 시크릿을 사용하려면 풀 시크릿 편집을 선택합니다.

선택 사항: 타사 플랫폼에 OpenShift Container Platform을 설치하는 경우 외부 파트 플랫폼 목록과 통합 플랫폼을 선택합니다. 유효한 값은

Nutanix,vSphere또는Oracle Cloud Infrastructure입니다. 지원 설치 관리자의 기본값은 플랫폼 통합이 없습니다.참고각 외부 파트너 통합에 대한 자세한 내용은 추가 리소스 를 참조하십시오.

중요Supported Installer는 OpenShift Container Platform 4.14 이상에서 Oracle Cloud Infrastructure (OCI) 통합을 지원합니다. OpenShift Container Platform 4.14의 경우 OCI 통합은 기술 프리뷰 기능 전용입니다. 기술 프리뷰 기능은 Red Hat 프로덕션 서비스 수준 계약(SLA)에서 지원되지 않으며 기능적으로 완전하지 않을 수 있습니다. 따라서 프로덕션 환경에서 사용하는 것은 권장하지 않습니다. 이러한 기능을 사용하면 향후 제품 기능을 조기에 이용할 수 있어 개발 과정에서 고객이 기능을 테스트하고 피드백을 제공할 수 있습니다.

Red Hat 기술 프리뷰 기능의 지원 범위에 대한 자세한 내용은 기술 프리뷰 기능 - 지원 범위를 참조하십시오.

선택 사항: 지원 설치 관리자는 기본적으로

x86_64CPU 아키텍처를 사용합니다. 다른 아키텍처에 OpenShift Container Platform을 설치하는 경우 사용할 해당 아키텍처를 선택합니다. 유효한 값은arm64,ppc64le및s390x입니다. 일부 기능은arm64,ppc64le및s390xCPU 아키텍처에서는 사용할 수 없습니다.중요혼합 아키텍처 클러스터 설치의 경우 기본

x86_64아키텍처를 사용합니다. 혼합 아키텍처 클러스터 설치에 대한 자세한 내용은 추가 리소스를 참조하십시오.선택 사항: 설치에 포함할 사용자 정의 매니페스트 가 하나 이상 있는 경우 사용자 정의 매니페스트 포함을 선택합니다. 사용자 정의 매니페스트에는 현재 지원 설치 관리자에서 지원되지 않는 추가 구성이 포함되어 있습니다. 확인란을 선택하면 매니페스트를 업로드하는 마법사에 사용자 정의 매니페스트 페이지가 추가됩니다.

중요- Oracle Cloud Infrastructure(OCI) 타사 플랫폼에 OpenShift Container Platform을 설치하는 경우 Oracle에서 제공하는 사용자 정의 매니페스트를 추가해야 합니다.

- 사용자 정의 매니페스트를 이미 추가한 경우 사용자 정의 매니페스트 포함 상자를 선택 해제하면 모두 자동으로 삭제됩니다. 삭제를 확인하라는 메시지가 표시됩니다.

선택 사항: 지원 설치 프로그램은 기본적으로 DHCP 네트워킹으로 설정됩니다. DHCP 예약 대신 클러스터 노드에 고정 IP 구성, 브리지 또는 본딩을 사용하는 경우 고정 IP, 브리지 및 본딩 을 선택합니다.

참고Oracle Cloud Infrastructure의 OpenShift Container Platform 설치에는 고정 IP 구성이 지원되지 않습니다.

- 선택 사항: 설치 디스크의 암호화를 활성화하려면 설치 디스크의 암호화를 활성화하려면 설치 디스크의 암호화를 사용하려면 컨트롤 플레인 노드인 worker를 단일 노드 OpenShift로 선택할 수 있습니다. 다중 노드 클러스터의 경우 컨트롤 플레인 노드를 선택하여 컨트롤 플레인 노드 설치 디스크를 암호화하고 작업자를 선택하여 작업자 노드 설치 디스크를 암호화할 수 있습니다.

기본 도메인, SNO 확인란, CPU 아키텍처, 호스트의 네트워크 구성 또는 설치가 시작된 후에는 디스크 암호화를 변경할 수 없습니다.

3.3. 선택사항: 정적 네트워크 구성

지원 설치 프로그램은 OpenShift Container Platform 4.14 및 OVN까지 SDN으로 IPv4 네트워킹을 지원하며 OVN을 사용하여 IPv6 및 듀얼 스택 네트워킹만 지원합니다. 지원 설치 관리자는 IP 주소/MAC 주소 매핑으로 정적 네트워크 인터페이스를 사용하여 네트워크 구성을 지원합니다. 지원 설치 관리자는 또한 NMState 라이브러리를 사용하여 호스트 네트워크 인터페이스 구성을 지원합니다. 호스트의 선언적 네트워크 관리자 API입니다. NMState를 사용하여 고정 IP 주소 지정, 본딩, VLAN 및 기타 고급 네트워킹 기능이 있는 호스트를 배포할 수 있습니다. 먼저 네트워크 전체 구성을 설정해야 합니다. 그런 다음 각 호스트에 대한 호스트별 구성을 생성해야 합니다.

z/VM을 사용하여 IBM Z에 설치하는 경우 정적 네트워크 및 NMState에 대해 z/VM 노드 및 vSwitch가 올바르게 구성되었는지 확인합니다. 또한 z/VM 노드에는 MAC 주소 풀로 인해 NMState에 문제가 발생할 수 있으므로 고정된 MAC 주소가 할당되어 있어야 합니다.

프로세스

- 인터넷 프로토콜 버전을 선택합니다. 유효한 옵션은 IPv4 및 듀얼 스택 입니다.

- 클러스터 호스트가 공유 VLAN에 있는 경우 VLAN ID를 입력합니다.

네트워크 전체 IP 주소를 입력합니다. 듀얼 스택 네트워킹을 선택한 경우 IPv4 및 IPv6 주소를 모두 입력해야 합니다.

- CIDR 표기법에 클러스터 네트워크의 IP 주소 범위를 입력합니다.

- 기본 게이트웨이 IP 주소를 입력합니다.

- DNS 서버 IP 주소를 입력합니다.

호스트별 구성을 입력합니다.

- 단일 네트워크 인터페이스를 사용하는 고정 IP 주소만 설정하는 경우 양식 보기를 사용하여 각 호스트의 IP 주소와 MAC 주소를 입력합니다.

- 여러 인터페이스, 본딩 또는 기타 고급 네트워킹 기능을 사용하는 경우 YAML 보기를 사용하고 NMState 구문을 사용하는 각 호스트에 대해 원하는 네트워크 상태를 입력합니다. 그런 다음 네트워크 구성에 사용된 각 호스트 인터페이스의 MAC 주소 및 인터페이스 이름을 추가합니다.

추가 리소스

3.4. 선택사항: Operator 설치

이 단계는 선택 사항입니다.

사전 요구 사항 및 구성 옵션은 제품 설명서를 참조하십시오.

고급 옵션이 필요한 경우 클러스터를 설치한 후 Operator를 설치합니다.

프로세스

다음 옵션에서 하나 이상을 선택합니다.

- Install OpenShift Virtualization

- 다중 클러스터 엔진 설치

- Install OpenShift Data Foundation

- 논리 볼륨 관리자 설치

- 다음을 클릭합니다.

3.5. 클러스터에 호스트 추가

클러스터에 하나 이상의 호스트를 추가해야 합니다. 클러스터에 호스트를 추가하려면 검색 ISO를 생성해야 합니다. 검색 ISO는 에이전트와 함께 RHCOS(Red Hat Enterprise Linux CoreOS) in-memory를 실행합니다.

클러스터의 각 호스트에 대해 다음 절차를 수행합니다.

프로세스

호스트 추가 버튼을 클릭하고 프로비저닝 유형을 선택합니다.

-

최소 이미지 파일: 가상 미디어를 사용하여 프로비저닝 하여 부팅에 필요한 데이터를 가져올 작은 이미지를 다운로드합니다. 노드에는 가상 미디어 기능이 있어야 합니다. 이 방법은

x86_64및arm64아키텍처에 권장되는 방법입니다. -

Full image file: Provision with physical media 를 선택하여 더 큰 전체 이미지를 다운로드합니다. 이는 RHEL KVM을 사용하여 설치할 때

ppc64le아키텍처 및s390x아키텍처에 권장되는 방법입니다. iPXE를 사용하여 호스트를 부팅하려면 네트워크 서버에서 iPXE: Provision 을 선택합니다. 이는 z/VM 노드가 있는 IBM Z에 권장되는 방법입니다. ISO 부팅은 RHEL KVM 설치에 권장되는 방법입니다.

참고- RHEL KVM에 설치하는 경우 경우에 따라 KVM 호스트의 VM이 처음 부팅 시 재부팅되지 않으므로 수동으로 다시 시작해야 합니다.

- Oracle Cloud Infrastructure에 OpenShift Container Platform을 설치하는 경우 최소 이미지 파일: Provision with virtual media 를 선택합니다.

-

최소 이미지 파일: 가상 미디어를 사용하여 프로비저닝 하여 부팅에 필요한 데이터를 가져올 작은 이미지를 다운로드합니다. 노드에는 가상 미디어 기능이 있어야 합니다. 이 방법은

- 선택 사항: 클러스터 호스트가 프록시를 사용해야 하는 방화벽 뒤에 있는 경우 클러스터 전체 프록시 설정 구성 을 선택합니다. 프록시 서버의 HTTP 및 HTTPS URL에 대한 사용자 이름, 암호, IP 주소 및 포트를 입력합니다.

선택 사항:

core사용자로 클러스터 노드에 연결할 수 있도록 SSH 공개 키를 추가합니다. 클러스터 노드에 로그인하면 설치 중에 디버깅 정보를 제공할 수 있습니다.중요재해 복구 및 디버깅이 필요한 프로덕션 환경에서는이 단계를 생략하지 마십시오.

- 로컬 시스템에 기존 SSH 키 쌍이 없는 경우 클러스터 노드 SSH 액세스에 대한 키 쌍 생성 단계를 따르십시오.

-

SSH 공개 키 필드에서 찾아보기 를 클릭하여 SSH 공개 키가 포함된

id_rsa.pub파일을 업로드합니다. 또는 파일을 파일 관리자의 필드로 끌어다 놓습니다. 파일 관리자에서 파일을 보려면 메뉴에서 숨겨진 파일 표시를 선택합니다.

- 선택 사항: 클러스터 호스트가 MITTM(man-in-the-middle) 프록시를 다시 암호화한 네트워크에 있거나 클러스터가 컨테이너 이미지 레지스트리와 같은 다른 용도로 인증서를 신뢰해야 하는 경우 클러스터 전체에서 신뢰할 수 있는 인증서 구성 을 선택합니다. X.509 형식으로 인증서를 추가합니다.

- 필요한 경우 검색 이미지를 구성합니다.

- 선택 사항: 플랫폼에 설치하고 플랫폼과 통합 하려면 가상화 플랫폼과 통합을 선택합니다. 모든 호스트를 부팅하고 호스트 인벤토리에 표시되어야 합니다. 모든 호스트가 동일한 플랫폼에 있어야 합니다.

- Discovery ISO 생성 또는 스크립트 파일 생성을 클릭합니다.

- 검색 ISO 또는 iPXE 스크립트를 다운로드합니다.

- 검색 이미지 또는 iPXE 스크립트를 사용하여 호스트를 부팅합니다.

추가 리소스

3.6. 호스트 구성

검색 ISO를 사용하여 호스트를 부팅하면 페이지 하단의 테이블에 호스트가 표시됩니다. 선택적으로 각 호스트에 대한 호스트 이름과 역할을 구성할 수 있습니다. 필요한 경우 호스트를 삭제할 수도 있습니다.

프로세스

호스트의 옵션 ( Cryostat) 메뉴에서 호스트 이름 변경을 선택합니다. 필요한 경우 호스트의 새 이름을 입력하고 변경 을 클릭합니다. 각 호스트에 유효한 고유 호스트 이름이 있는지 확인해야 합니다.

또는 Actions 목록에서 호스트 이름 변경을 선택하여 선택한 여러 호스트의 이름을 바꿉니다. 호스트 이름 변경 대화 상자에서 새 이름을 입력하고

{{n}}을 포함하여 각 호스트 이름을 고유하게 만듭니다. 그런 다음 변경을 클릭합니다.참고입력 시 프리뷰 창에서 새 이름이 표시되는 것을 확인할 수 있습니다. 호스트당 한 자리 증분(호스트당 한 자리 증분)을 제외하고 선택한 모든 호스트에 대해 이름이 동일합니다.

Options ( Cryostat) 메뉴에서 Delete host 를 선택하여 호스트를 삭제할 수 있습니다. 삭제를 클릭하여 삭제를 확인합니다.

또는 작업 목록에서 삭제를 선택하여 선택한 여러 호스트를 동시에 삭제합니다. 그런 다음 Delete hosts 를 클릭합니다.

참고일반 배포에서 클러스터에 3개 이상의 호스트가 있을 수 있으며 이 중 세 개는 컨트롤 플레인 호스트여야 합니다. 컨트롤 플레인이라고도 하는 호스트를 삭제하거나 두 개의 호스트만 남아 있는 경우 시스템이 준비되지 않았음을 알리는 메시지가 표시됩니다. 호스트를 복원하려면 검색 ISO에서 재부팅해야 합니다.

- 호스트의 옵션 ( Cryostat) 메뉴에서 필요한 경우 호스트 이벤트 보기를 선택합니다. 목록의 이벤트는 순차적으로 표시됩니다.

멀티 호스트 클러스터의 경우 호스트 이름 옆에 있는 역할 열에서 메뉴를 클릭하여 호스트의 역할을 변경할 수 있습니다.

역할을 선택하지 않으면 지원 설치 프로그램이 역할을 자동으로 할당합니다. 컨트롤 플레인 노드의 최소 하드웨어 요구 사항은 작업자 노드를 초과합니다. 호스트에 역할을 할당하는 경우 최소 하드웨어 요구 사항을 충족하는 호스트에 컨트롤 플레인 역할을 할당해야 합니다.

- Status 링크를 클릭하여 호스트에 대한 하드웨어, 네트워크 및 operator 검증을 확인합니다.

- 호스트 이름 왼쪽에 있는 화살표를 클릭하여 호스트 세부 정보를 확장합니다.

모든 클러스터 호스트가 Ready 상태로 표시되면 다음 단계를 진행합니다.

3.7. 스토리지 디스크 구성

호스트 검색 중에 검색된 각 호스트에는 여러 스토리지 디스크가 있을 수 있습니다. 스토리지 디스크는 지원 설치 관리자 마법사의 스토리지 페이지에 있는 호스트에 대해 나열됩니다.

선택적으로 각 디스크의 기본 구성을 수정할 수 있습니다.

설치 디스크 변경

지원 설치 관리자는 기본적으로 설치 디스크를 무작위로 할당합니다. 호스트에 대한 스토리지 디스크가 여러 개 있는 경우 다른 디스크를 선택하여 설치 디스크가 될 수 있습니다. 이렇게 하면 이전 디스크가 자동으로 할당 해제됩니다.

프로세스

- 마법사의 스토리지 페이지로 이동합니다.

- 연결된 스토리지 디스크를 표시하도록 호스트를 확장합니다.

- Role 목록에서 Installation disk 를 선택합니다.

- 모든 스토리지 디스크가 Ready 상태로 돌아가면 다음 단계로 이동합니다.

디스크 형식 비활성화

지원 설치 프로그램은 설치 디스크로 정의되었는지 여부에 관계없이 설치 프로세스 중에 포맷할 수 있는 모든 부팅 가능한 디스크를 표시합니다. 포맷으로 인해 데이터가 손실됩니다.

특정 디스크의 포맷을 비활성화하도록 선택할 수 있습니다. 부팅 가능한 디스크가 부팅 순서 측면에서 설치 프로세스를 방해할 수 있으므로 이 작업은 주의해서 수행해야 합니다.

설치 디스크의 포맷을 비활성화할 수 없습니다.

프로세스

- 마법사의 스토리지 페이지로 이동합니다.

- 연결된 스토리지 디스크를 표시하도록 호스트를 확장합니다.

- 디스크에 대한 지우기 형식.

- 모든 스토리지 디스크가 Ready 상태로 돌아가면 다음 단계로 이동합니다.

추가 리소스

3.8. 네트워킹 구성

OpenShift Container Platform을 설치하기 전에 클러스터 네트워크를 구성해야 합니다.

프로세스

네트워킹 페이지에서 아직 선택되지 않은 경우 다음 중 하나를 선택합니다.

클러스터 관리형 네트워킹: 클러스터 관리 네트워킹을 선택하면 지원 관리자가 API 및 Ingress VIP 주소를 관리하기 위한

keepalived및 VRRP(Virtual Router Redundancy Protocol)를 포함한 표준 네트워크 토폴로지를 구성합니다.참고- 현재 Cluster-Managed Networking은 IBM zSystems 및 IBM Power in OpenShift Container Platform 버전 4.13에서 지원되지 않습니다.

- OCI(Oracle Cloud Infrastructure)는 사용자 관리 네트워킹 구성만 있는 OpenShift Container Platform 4.14에서 사용할 수 있습니다.

-

사용자 관리형 네트워킹: 사용자 관리 네트워킹을 선택하면 비표준 네트워크 토폴로지를 사용하여 OpenShift Container Platform을 배포할 수 있습니다. 예를 들어

keepalived및 VRRP 대신 외부 로드 밸런서를 사용하여 배포하려는 경우 또는 여러 별도의 L2 네트워크 세그먼트에 클러스터 노드를 배포하려는 경우입니다.

클러스터 관리 네트워킹의 경우 다음 설정을 구성합니다.

- 시스템 네트워크를 정의합니다. 기본 네트워크를 사용하거나 서브넷을 선택할 수 있습니다.

- API 가상 IP 를 정의합니다. API 가상 IP는 모든 사용자가 플랫폼과 상호 작용하고 구성할 수 있는 끝점을 제공합니다.

- 인그레스 가상 IP 를 정의합니다. Ingress 가상 IP는 클러스터 외부에서 이동하는 애플리케이션 트래픽에 대한 끝점을 제공합니다.

사용자 관리 네트워킹의 경우 다음 설정을 구성합니다.

네트워킹 스택 유형을 선택합니다.

- IPv4: 호스트가 IPv4만 사용하는 경우 이 유형을 선택합니다.

- 듀얼 스택: 호스트가 IPv6와 함께 IPv4를 사용하는 경우 듀얼 스택을 선택할 수 있습니다.

- 시스템 네트워크를 정의합니다. 기본 네트워크를 사용하거나 서브넷을 선택할 수 있습니다.

- API 가상 IP 를 정의합니다. API 가상 IP는 모든 사용자가 플랫폼과 상호 작용하고 구성할 수 있는 끝점을 제공합니다.

- 인그레스 가상 IP 를 정의합니다. Ingress 가상 IP는 클러스터 외부에서 이동하는 애플리케이션 트래픽에 대한 끝점을 제공합니다.

- 선택 사항: DHCP 서버 를 통해 IP 할당을 선택하여 DHCP 서버 를 사용하여 API IP 및 Ingress IP 를 자동으로 할당할 수 있습니다.

선택 사항: 고급 네트워킹 사용을 선택하여 다음과 같은 고급 네트워킹 속성을 구성합니다.

- 클러스터 네트워크 CIDR: Pod IP 주소가 할당되는 IP 주소 블록을 정의합니다.

- cluster network host prefix: 각 노드에 할당할 서브넷 접두사 길이를 정의합니다.

- service network CIDR : 서비스 IP 주소에 사용할 IP 주소를 정의합니다.

- 네트워크 유형: 표준 네트워킹의 경우 SDN(소프트웨어 정의 네트워킹) 또는 IPv6, 듀얼 스택 네트워킹 및 통신용 OVN(Open Virtual Networking) 을 선택합니다. OpenShift Container Platform 4.12 이상 릴리스에서 OVN은 기본 CNI(Container Network Interface)입니다. OpenShift Container Platform 4.15 이상 릴리스에서는 SDN(소프트웨어 정의 네트워킹) 이 지원되지 않습니다.

추가 리소스

3.9. 사용자 정의 매니페스트 추가

사용자 정의 매니페스트는 지원 설치 관리자 사용자 인터페이스에서 현재 지원되지 않는 고급 구성이 포함된 JSON 또는 YAML 파일입니다. 사용자 정의 매니페스트를 생성하거나 타사에서 제공하는 매니페스트를 사용할 수 있습니다.

파일 시스템에서 사용자 정의 매니페스트를 openshift 폴더 또는 매니페스트 폴더에 업로드할 수 있습니다. 허용된 사용자 정의 매니페스트 파일 수에는 제한이 없습니다.

한 번에 하나의 파일만 업로드할 수 있습니다. 그러나 업로드된 각 YAML 파일에는 여러 사용자 정의 매니페스트가 포함될 수 있습니다. 여러 문서 YAML 매니페스트를 업로드하는 것이 YAML 파일을 개별적으로 추가하는 것보다 빠릅니다.

단일 사용자 정의 매니페스트가 포함된 파일의 경우 허용되는 파일 확장자에는 .yaml,.yml 또는 .json 이 포함됩니다.

단일 사용자 정의 매니페스트 예

apiVersion: machineconfiguration.openshift.io/v1

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: master

name: 99-openshift-machineconfig-master-kargs

spec:

kernelArguments:

- loglevel=7

여러 사용자 지정 매니페스트가 포함된 파일의 경우 허용되는 파일 유형에는 .yaml 또는 .yml 이 포함됩니다.

여러 사용자 정의 매니페스트 예

apiVersion: machineconfiguration.openshift.io/v1

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: master

name: 99-openshift-machineconfig-master-kargs

spec:

kernelArguments:

- loglevel=7

---

apiVersion: machineconfiguration.openshift.io/v2

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: worker

name: 98-openshift-machineconfig-worker-kargs

spec:

kernelArguments:

- loglevel=5

- Oracle Cloud Infrastructure(OCI) 외부 플랫폼에 OpenShift Container Platform을 설치하는 경우 Oracle에서 제공하는 사용자 정의 매니페스트를 추가해야 합니다. vSphere 또는 Nutanix와 같은 추가 외부 파트너 통합의 경우 이 단계는 선택 사항입니다.

- 사용자 정의 매니페스트에 대한 자세한 내용은 추가 리소스 를 참조하십시오.

지원 설치 관리자 사용자 인터페이스에서 사용자 정의 매니페스트 업로드

사용자 정의 매니페스트를 업로드할 때 매니페스트 파일 이름을 입력하고 대상 폴더를 선택합니다.

사전 요구 사항

- 파일 시스템에 저장된 사용자 지정 매니페스트 파일이 하나 이상 있습니다.

프로세스

- 마법사의 클러스터 세부 정보 페이지에서 사용자 정의 매니페스트 포함 확인란을 선택합니다.

- 사용자 정의 매니페스트 페이지의 폴더 필드에서 사용자 정의 매니페스트 파일을 저장할 지원 설치 관리자 폴더를 선택합니다. 옵션에는 openshift 또는 manifest 가 포함됩니다.

- Filename 필드에 확장을 포함하여 매니페스트 파일의 이름을 입력합니다. 예를 들면 manifest1.json 또는 multiple1.yaml 입니다.

- Content 에서 Upload 아이콘 또는 찾아보기 를 클릭하여 파일을 업로드합니다. 또는 파일을 파일 시스템의 Content (콘텐츠) 필드로 드래그합니다.

- 다른 매니페스트를 업로드하려면 다른 매니페스트 추가 를 클릭하고 프로세스를 반복합니다. 이렇게 하면 이전에 업로드한 매니페스트가 저장됩니다.

- 다음을 클릭하여 모든 매니페스트를 저장하고 검토 및 생성 페이지로 이동합니다. 업로드된 사용자 정의 매니페스트는 사용자 정의 매니페스트 아래에 나열됩니다.

지원 설치 관리자 사용자 인터페이스에서 사용자 정의 매니페스트 수정

업로드된 사용자 정의 매니페스트의 폴더 및 파일 이름을 변경할 수 있습니다. 기존 매니페스트의 콘텐츠를 복사하거나 Chrome 다운로드 설정에 정의된 폴더에 다운로드할 수도 있습니다.

업로드된 매니페스트의 콘텐츠를 수정할 수 없습니다. 그러나 파일을 덮어쓸 수 있습니다.

사전 요구 사항

- 하나 이상의 사용자 정의 매니페스트 파일을 업로드했습니다.

프로세스

- 폴더를 변경하려면 폴더 목록에서 매니페스트의 다른 폴더 를 선택합니다.

- 파일 이름을 수정하려면 파일 이름 필드에 매니페스트의 새 이름을 입력합니다.

- 매니페스트를 덮어쓰려면 새 매니페스트를 동일한 폴더에 파일 이름으로 저장합니다.

- 매니페스트를 파일 시스템에 파일로 저장하려면 다운로드 아이콘을 클릭합니다.

- 매니페스트를 복사하려면 Copy to clipboard 아이콘을 클릭합니다.

- 변경 사항을 적용하려면 Add another manifest 또는 Next 를 클릭합니다.

지원 설치 관리자 사용자 인터페이스에서 사용자 정의 매니페스트 제거

다음 두 가지 방법 중 하나로 설치하기 전에 업로드된 사용자 정의 매니페스트를 제거할 수 있습니다.

- 하나 이상의 매니페스트를 개별적으로 제거합니다.

- 한 번에 모든 매니페스트를 제거합니다.

매니페스트를 제거한 후에는 작업을 취소할 수 없습니다. 해결방법은 매니페스트를 다시 업로드하는 것입니다.

단일 매니페스트 제거

한 번에 하나의 매니페스트를 삭제할 수 있습니다. 이 옵션은 마지막 남아 있는 매니페스트를 삭제할 수 없습니다.

사전 요구 사항

- 두 개 이상의 사용자 지정 매니페스트 파일을 업로드했습니다.

프로세스

- 사용자 정의 매니페스트 페이지로 이동합니다.

- 매니페스트 이름 위로 마우스를 가져가면 삭제 (minus) 아이콘이 표시됩니다.

- 아이콘을 클릭한 다음 대화 상자에서 삭제 를 클릭합니다.

모든 매니페스트 제거

모든 사용자 정의 매니페스트를 한 번에 제거할 수 있습니다. 또한 사용자 정의 매니페스트 페이지도 숨겨집니다.

사전 요구 사항

- 하나 이상의 사용자 정의 매니페스트 파일을 업로드했습니다.

프로세스

- 마법사의 클러스터 세부 정보 페이지로 이동합니다.

- 사용자 정의 매니페스트 포함 확인란을 지웁니다.

- 사용자 정의 매니페스트 제거 대화 상자에서 제거를 클릭합니다.

추가 리소스

3.10. 사전 설치 검증

지원 설치 관리자는 복잡한 설치 후 문제 해결을 제거하므로 설치 전에 클러스터가 사전 요구 사항을 충족할 수 있도록 하여 상당한 시간과 노력을 절약할 수 있습니다. 클러스터를 설치하기 전에 클러스터와 각 호스트가 사전 설치 검증을 통과했는지 확인합니다.

추가 리소스

3.11. 클러스터 설치

구성을 완료하고 모든 노드가 Ready 이면 설치를 시작할 수 있습니다. 설치 프로세스에는 상당한 시간이 소요되며 지원 관리자 웹 콘솔에서 설치를 모니터링할 수 있습니다. 설치 중에 노드가 재부팅되고 설치 후 노드가 초기화됩니다.

프로세스

- 설치 시작 을 누릅니다.

- Host Inventory 목록의 Status 열에 있는 링크를 클릭하여 특정 호스트의 설치 상태를 확인합니다.

3.12. 설치 완료

클러스터가 설치되고 초기화된 후 지원 설치 프로그램은 설치가 완료되었음을 나타냅니다. 지원 설치 프로그램은 콘솔 URL, kubeadmin 사용자 이름 및 암호, kubeconfig 파일을 제공합니다. 또한 지원 설치 프로그램은 OpenShift Container Platform 버전, 기본 도메인, CPU 아키텍처, API 및 Ingress IP 주소, 클러스터 및 서비스 네트워크 IP 주소를 포함한 클러스터 세부 정보를 제공합니다.

사전 요구 사항

-

ocCLI 툴을 설치했습니다.

프로세스

-

kubeadmin사용자 이름과 암호의 사본을 만듭니다. kubeconfig파일을 다운로드하여 작업 디렉터리의auth디렉터리에 복사합니다.$ mkdir -p <working_directory>/auth

$ cp kubeadmin <working_directory>/auth

참고kubeconfig파일은 설치를 완료한 후 24시간 동안 다운로드할 수 있습니다.환경에

kubeconfig파일을 추가합니다.$ export KUBECONFIG=<your working directory>/auth/kubeconfig

ocCLI 툴로 로그인합니다.$ oc login -u kubeadmin -p <password>

&

lt;password>를kubeadmin사용자의 암호로 바꿉니다.- 웹 콘솔 URL을 클릭하거나 OpenShift 콘솔 시작을 클릭하여 콘솔을 엽니다.

-

kubeadmin사용자 이름과 암호를 입력합니다. OpenShift Container Platform 콘솔의 지침에 따라 ID 공급자를 구성하고 경고 수신자를 구성합니다. - OpenShift Container Platform 콘솔의 북마크를 추가합니다.

- 설치 후 플랫폼 통합 단계를 완료합니다.

추가 리소스

4장. 지원 설치 관리자 API로 설치

클러스터 노드 및 네트워크 요구 사항이 충족되었는지 확인한 후 지원 설치 관리자 API를 사용하여 클러스터 설치를 시작할 수 있습니다. API를 사용하려면 다음 절차를 수행해야 합니다.

- API 인증을 설정합니다.

- 풀 시크릿을 구성합니다.

- 새 클러스터 정의를 등록합니다.

- 클러스터의 인프라 환경을 생성합니다.

이러한 단계를 수행한 후 클러스터 정의를 수정하고, 검색 ISO를 생성하고, 클러스터에 호스트를 추가하고, 클러스터를 설치할 수 있습니다. 이 문서에서는 지원 설치 프로그램 API의 모든 끝점을 다루지는 않지만 API 뷰어 또는 swagger.yaml 파일의 모든 끝점을 검토할 수 있습니다.

4.1. 오프라인 토큰 생성

지원 설치 프로그램 UI에서 오프라인 토큰을 다운로드합니다. 오프라인 토큰을 사용하여 API 토큰을 설정합니다.

사전 요구 사항

-

jq를 설치합니다. - 클러스터 생성 권한이 있는 사용자로 OpenShift Cluster Manager 에 로그인합니다.

프로세스

- 메뉴에서 다운로드를 클릭합니다.

- OpenShift Cluster Manager API 토큰 의 토큰 섹션에서 View API Token 을 클릭합니다.

로드 토큰 을 클릭합니다.

중요팝업 차단기를 비활성화합니다.

- API 토큰 섹션에서 오프라인 토큰을 복사합니다.

터미널에서 오프라인 토큰을

OFFLINE_TOKEN변수로 설정합니다.$ export OFFLINE_TOKEN=<copied_token>

작은 정보오프라인 토큰을 영구적으로 만들려면 프로필에 추가합니다.

(선택 사항)

OFFLINE_TOKEN변수 정의를 확인합니다.$ echo ${OFFLINE_TOKEN}

4.2. REST API로 인증

API 호출에는 API 토큰을 사용한 인증이 필요합니다. API_TOKEN 을 변수 이름으로 사용하는 경우 API 호출에 -H "Authorization: Bearer ${API_TOKEN}" 을 API 호출에 추가하여 REST API로 인증합니다.

API 토큰은 15분 후에 만료됩니다.

사전 요구 사항

-

OFFLINE_TOKEN변수를 생성했습니다.

프로세스

명령줄 터미널에서

OFFLINE_TOKEN을 사용하여API_TOKEN변수를 설정하여 사용자를 검증합니다.$ export API_TOKEN=$( \ curl \ --silent \ --header "Accept: application/json" \ --header "Content-Type: application/x-www-form-urlencoded" \ --data-urlencode "grant_type=refresh_token" \ --data-urlencode "client_id=cloud-services" \ --data-urlencode "refresh_token=${OFFLINE_TOKEN}" \ "https://sso.redhat.com/auth/realms/redhat-external/protocol/openid-connect/token" \ | jq --raw-output ".access_token" \ )

API_TOKEN변수 정의를 확인합니다.$ echo ${API_TOKEN}경로에서 생성하는 방법 중 하나에 스크립트를 생성합니다. 예를 들면 다음과 같습니다.

$ vim ~/.local/bin/refresh-token

export API_TOKEN=$( \ curl \ --silent \ --header "Accept: application/json" \ --header "Content-Type: application/x-www-form-urlencoded" \ --data-urlencode "grant_type=refresh_token" \ --data-urlencode "client_id=cloud-services" \ --data-urlencode "refresh_token=${OFFLINE_TOKEN}" \ "https://sso.redhat.com/auth/realms/redhat-external/protocol/openid-connect/token" \ | jq --raw-output ".access_token" \ )그런 다음 파일을 저장합니다.

파일 모드를 변경하여 실행 가능하게 만듭니다.

$ chmod +x ~/.local/bin/refresh-token

API 토큰을 새로 고칩니다.

$ source refresh-token

다음 명령을 실행하여 API에 액세스할 수 있는지 확인합니다.

$ curl -s https://api.openshift.com/api/assisted-install/v2/component-versions -H "Authorization: Bearer ${API_TOKEN}" | jq출력 예

{ "release_tag": "v2.11.3", "versions": { "assisted-installer": "registry.redhat.io/rhai-tech-preview/assisted-installer-rhel8:v1.0.0-211", "assisted-installer-controller": "registry.redhat.io/rhai-tech-preview/assisted-installer-reporter-rhel8:v1.0.0-266", "assisted-installer-service": "quay.io/app-sre/assisted-service:78d113a", "discovery-agent": "registry.redhat.io/rhai-tech-preview/assisted-installer-agent-rhel8:v1.0.0-195" } }

4.3. 풀 시크릿 구성

지원 설치 프로그램 API 호출의 대부분은 풀 시크릿이 필요합니다. API 호출에서 참조할 수 있도록 풀 시크릿을 파일에 다운로드합니다. 풀 시크릿은 요청의 JSON 오브젝트에 값으로 포함될 JSON 오브젝트입니다. 따옴표를 이스케이프하려면 풀 시크릿 JSON을 포맷해야 합니다. 예를 들면 다음과 같습니다.

이전

{"auths":{"cloud.openshift.com": ...

이후

{\"auths\":{\"cloud.openshift.com\": ...

프로세스

- 메뉴에서 OpenShift 를 클릭합니다.

- 하위 메뉴에서 다운로드를 클릭합니다.

- Pull secret 아래의 토큰 섹션에서 다운로드를 클릭합니다.

쉘 변수에서 풀 시크릿을 사용하려면 다음 명령을 실행합니다.

$ export PULL_SECRET=$(cat ~/Downloads/pull-secret.txt | jq -R .)

jq를 사용하여 풀 시크릿 파일을 슬퍼하려면pull_secret변수에서 해당 파일을 참조하고 값을tojson으로 파이핑하여 올바르게 이스케이프된 JSON으로 포맷되었는지 확인합니다. 예를 들면 다음과 같습니다.$ curl https://api.openshift.com/api/assisted-install/v2/clusters \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' 1 { "name": "testcluster", "high_availability_mode": "None", "openshift_version": "4.11", "pull_secret": $pull_secret[0] | tojson, 2 "base_dns_domain": "example.com" } ')"PULL_SECRET변수 정의를 확인합니다.$ echo ${PULL_SECRET}

4.4. 선택 사항: SSH 공개 키 생성

OpenShift Container Platform을 설치하는 동안 설치 프로그램에 SSH 공개 키를 선택적으로 제공할 수 있습니다. 이 기능은 설치 오류 발생 시 원격 노드에 대한 SSH 연결을 시작하는 데 유용합니다.

로컬 시스템에 인증에 사용할 기존 SSH 키 쌍이 없는 경우 지금 만듭니다.

사전 요구 사항

-

OFFLINE_TOKEN및API_TOKEN변수를 생성합니다.

프로세스

터미널의 root 사용자가 SSH 공개 키를 가져옵니다.

$ cat /root/.ssh/id_rsa.pub

SSH 공개 키를

CLUSTER_SSHKEY변수로 설정합니다.$ CLUSTER_SSHKEY=<downloaded_ssh_key>

CLUSTER_SSHKEY변수 정의를 확인합니다.$ echo ${CLUSTER_SSHKEY}

4.5. 새 클러스터 등록

API에 새 클러스터 정의를 등록하려면 /v2/clusters 끝점을 사용합니다. 새 클러스터를 등록하려면 다음 설정이 필요합니다.

-

name -

openshift-version -

pull_secret -

cpu_architecture

새 클러스터를 등록할 때 설정할 수 있는 필드에 대한 자세한 내용은 API 뷰어 의 cluster-create-params 모델을 참조하십시오. olm_operators 필드를 설정할 때 Operator 설치에 대한 자세한 내용은 추가 리소스 를 참조하십시오.

클러스터 정의를 생성한 후 클러스터 정의를 수정하고 추가 설정 값을 제공할 수 있습니다.

- 특정 설치 플랫폼 및 OpenShift Container Platform 버전의 경우 동일한 클러스터에서 두 개의 서로 다른 아키텍처를 결합하여 혼합 아키텍처 클러스터를 생성할 수도 있습니다. 자세한 내용은 추가 리소스 를 참조하십시오.

- 타사 플랫폼에 OpenShift Container Platform을 설치하는 경우 관련 지침은 추가 리소스 를 참조하십시오.

사전 요구 사항

-

유효한

API_TOKEN을 생성했습니다. 토큰은 15분마다 만료됩니다. - 풀 시크릿을 다운로드했습니다.

-

선택 사항:

$PULL_SECRET변수에 풀 시크릿을 할당했습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

새 클러스터를 등록합니다.

선택 사항: 요청에 풀 시크릿 파일을 슬루핑하여 새 클러스터를 등록할 수 있습니다.

$ curl -s -X POST https://api.openshift.com/api/assisted-install/v2/clusters \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "name": "testcluster", "openshift_version": "4.11", "cpu_architecture" : "<architecture_name>", 1 "high_availability_mode": "<cluster_type>", 2 "base_dns_domain": "example.com", "pull_secret": $pull_secret[0] | tojson } ')" | jq '.id'선택 사항: JSON 파일에 구성을 작성한 다음 요청에서 참조하여 새 클러스터를 등록할 수 있습니다.

cat << EOF > cluster.json { "name": "testcluster", "openshift_version": "4.11", "high_availability_mode": "<cluster_type>", 1 "base_dns_domain": "example.com", "network_type": "examplenetwork", "cluster_network_cidr":"11.111.1.0/14" "cluster_network_host_prefix": 11, "service_network_cidr": "111.11.1.0/16", "api_vips":[{"ip": ""}], "ingress_vips": [{"ip": ""}], "vip_dhcp_allocation": false, "additional_ntp_source": "clock.redhat.com,clock2.redhat.com", "ssh_public_key": "$CLUSTER_SSHKEY", "pull_secret": $PULL_SECRET } EOF참고- 1

- 기본값

Full을 사용하여 다중 노드 OpenShift Container Platform 클러스터를 나타내거나 단일 노드 OpenShift 클러스터를 나타내는None을 사용합니다.full은 여러 마스터 노드를 통해고가용성클러스터를 설치하고 설치된 클러스터의 가용성을 보장합니다.어느 하나도하나의 노드에 전체 클러스터를 설치하지 않습니다.

$ curl -s -X POST "https://api.openshift.com/api/assisted-install/v2/clusters" \ -d @./cluster.json \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.id'

반환된

cluster_id를CLUSTER_ID변수에 할당하고 내보냅니다.$ export CLUSTER_ID=<cluster_id>

참고터미널 세션을 종료하는 경우

CLUSTER_ID변수를 새 터미널 세션에서 다시 내보내야 합니다.새 클러스터의 상태를 확인합니다.

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ -H "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq

새 클러스터 정의를 등록하면 클러스터의 인프라 환경을 생성합니다.

인프라 환경을 생성할 때까지 지원 설치 관리자 사용자 인터페이스에서 클러스터 구성 설정을 볼 수 없습니다.

추가 리소스

4.5.1. 선택사항: Operator 설치

새 클러스터를 등록할 때 다음 Operator를 설치할 수 있습니다.

OpenShift Virtualization Operator

참고현재 OpenShift Virtualization은 IBM zSystems 및 IBM Power에서 지원되지 않습니다.

- 다중 클러스터 엔진 Operator

- OpenShift Data Foundation Operator

- LVM Storage Operator

고급 옵션이 필요한 경우 클러스터를 설치한 후 Operator를 설치합니다.

프로세스

다음 명령을 실행합니다.

$ curl -s -X POST https://api.openshift.com/api/assisted-install/v2/clusters \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "name": "testcluster", "openshift_version": "4.15", "cpu_architecture" : "x86_64", "base_dns_domain": "example.com", "olm_operators": [ { "name": "mce" } 1 , { "name": "odf" } 2 ] "pull_secret": $pull_secret[0] | tojson } ')" | jq '.id'

4.6. 클러스터 수정

API로 클러스터 정의를 수정하려면 /v2/clusters/{cluster_id} 끝점을 사용합니다. 클러스터 리소스 수정은 네트워크 유형 변경 또는 사용자 관리 네트워킹 활성화와 같은 설정을 추가하는 일반적인 작업입니다. 클러스터 정의를 수정할 때 설정할 수 있는 필드에 대한 자세한 내용은 API 뷰어 의 v2-cluster-update-params 모델을 참조하십시오.

이미 등록된 클러스터 리소스에서 Operator를 추가하거나 제거할 수 있습니다.

노드에서 파티션을 생성하려면 OpenShift Container Platform 설명서의 노드에서 스토리지 구성 을 참조하십시오.

사전 요구 사항

- 새 클러스터 리소스를 생성했습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

클러스터를 수정합니다. 예를 들어 SSH 키를 변경합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "ssh_public_key": "ssh-rsa AAAAB3NzaC1yc2EAAAADAQABAAABgQDZrD4LMkAEeoU2vShhF8VM+cCZtVRgB7tqtsMxms2q3TOJZAgfuqReKYWm+OLOZTD+DO3Hn1pah/mU3u7uJfTUg4wEX0Le8zBu9xJVym0BVmSFkzHfIJVTn6SfZ81NqcalisGWkpmkKXVCdnVAX6RsbHfpGKk9YPQarmRCn5KzkelJK4hrSWpBPjdzkFXaIpf64JBZtew9XVYA3QeXkIcFuq7NBuUH9BonroPEmIXNOa41PUP1IWq3mERNgzHZiuU8Ks/pFuU5HCMvv4qbTOIhiig7vidImHPpqYT/TCkuVi5w0ZZgkkBeLnxWxH0ldrfzgFBYAxnpTU8Ih/4VhG538Ix1hxPaM6cXds2ic71mBbtbSrk+zjtNPaeYk1O7UpcCw4jjHspU/rVV/DY51D5gSiiuaFPBMucnYPgUxy4FMBFfGrmGLIzTKiLzcz0DiSz1jBeTQOX++1nz+KDLBD8CPdi5k4dq7lLkapRk85qdEvgaG5RlHMSPSS3wDrQ51fD8= user@hostname" } ' | jq

4.6.1. Operator 수정

이전 설치의 일부로 이미 등록된 클러스터 리소스에서 Operator를 추가하거나 제거할 수 있습니다. 이는 OpenShift Container Platform 설치를 시작하기 전에만 가능합니다.

/v2/clusters/{cluster_id} 엔드포인트에 PATCH 방법을 사용하여 필요한 Operator 정의를 설정합니다.

사전 요구 사항

- API 토큰을 새로 고쳐야 합니다.

-

CLUSTER_ID를 환경 변수로 내보냈습니다.

프로세스

다음 명령을 실행하여 Operator를 수정합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "olm_operators": [{"name": "mce"}, {"name": "cnv"}], 1 } ' | jq '.id'- 1

- OpenShift Virtualization용

cnv, 다중 클러스터 엔진mce, Red Hat OpenShift Data Foundation의 경우odf또는 Logical Volume Manager Storage의 경우lvm을 지정합니다. 이전에 설치한 Operator를 제거하려면 값 목록에서 제외합니다. 이전에 설치한 모든 Operator를 제거하려면 빈 배열"olm_operators": []를 지정합니다.

샘플 출력

{ <various cluster properties>, "monitored_operators": [ { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "console", "operator_type": "builtin", "status_updated_at": "0001-01-01T00:00:00.000Z", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "cvo", "operator_type": "builtin", "status_updated_at": "0001-01-01T00:00:00.000Z", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "mce", "namespace": "multicluster-engine", "operator_type": "olm", "status_updated_at": "0001-01-01T00:00:00.000Z", "subscription_name": "multicluster-engine", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "cnv", "namespace": "openshift-cnv", "operator_type": "olm", "status_updated_at": "0001-01-01T00:00:00.000Z", "subscription_name": "hco-operatorhub", "timeout_seconds": 3600 }, { "cluster_id": "b5259f97-be09-430e-b5eb-d78420ee509a", "name": "lvm", "namespace": "openshift-local-storage", "operator_type": "olm", "status_updated_at": "0001-01-01T00:00:00.000Z", "subscription_name": "local-storage-operator", "timeout_seconds": 4200 } ], <more cluster properties>참고출력은 새 클러스터 상태에 대한 설명입니다. 출력의

monitored_operators속성에는 다음 두 가지 유형의 Operator가 포함되어 있습니다.-

"operator_type": "builtin": 이 유형의 Operator는 OpenShift Container Platform의 통합 부분입니다. -

"operator_type": "olm": 이 유형의 Operator는 사용자가 수동으로 추가하거나 종속성으로 자동으로 추가됩니다. 이 예에서는 LVM Storage Operator가 OpenShift Virtualization의 종속성으로 자동으로 추가됩니다.

4.7. 새 인프라 환경 등록

지원 설치 프로그램 API로 새 클러스터 정의를 등록하면 v2/infra-envs 끝점을 사용하여 인프라 환경을 생성합니다. 새 인프라 환경을 등록하려면 다음 설정이 필요합니다.

-

name -

pull_secret -

cpu_architecture

새 인프라 환경을 등록할 때 설정할 수 있는 필드에 대한 자세한 내용은 API 뷰어 의 infra-env-create-params 모델을 참조하십시오. 인프라 환경을 생성한 후 수정할 수 있습니다. 새 인프라 환경을 생성할 때 cluster_id 를 포함하는 것이 좋습니다. cluster_id 는 인프라 환경을 클러스터 정의와 연결합니다. 새 인프라 환경을 생성할 때 지원 설치 관리자도 검색 ISO를 생성합니다.

사전 요구 사항

-

유효한

API_TOKEN을 생성했습니다. 토큰은 15분마다 만료됩니다. - 풀 시크릿을 다운로드했습니다.

-

선택 사항: 새 클러스터 정의를 등록하고

cluster_id를 내보냈습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

새 인프라 환경을 등록합니다. 클러스터 이름을 포함하는 이름을 제공해야 합니다. 이 예에서는 인프라 환경을 클러스터 리소스와 연결하는 클러스터 ID를 제공합니다. 다음 예제에서는

image_type을 지정합니다.full-iso또는minimal-iso중 하나를 지정할 수 있습니다. 기본값은minimal-iso입니다.선택 사항: 요청에 풀 시크릿 파일을 슬루핑하여 새 인프라 환경을 등록할 수 있습니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt \ --arg cluster_id ${CLUSTER_ID} ' { "name": "testcluster-infra-env", "image_type":"full-iso", "cluster_id": $cluster_id, "cpu_architecture" : "<architecture_name>", 1 "pull_secret": $pull_secret[0] | tojson } ')" | jq '.id'참고- 1

- 유효한 값을 나타냅니다.

x86_64,arm64,ppc64le,s390x,multi

선택 사항: JSON 파일에 구성을 작성한 다음 요청에서 참조하여 새 인프라 환경을 등록할 수 있습니다.

$ cat << EOF > infra-envs.json { "name": "testcluster", "pull_secret": $PULL_SECRET, "proxy": { "http_proxy": "", "https_proxy": "", "no_proxy": "" }, "ssh_authorized_key": "$CLUSTER_SSHKEY", "image_type": "full-iso", "cluster_id": "${CLUSTER_ID}", "openshift_version": "4.11" } EOF$ curl -s -X POST "https://api.openshift.com/api/assisted-install/v2/infra-envs" -d @./infra-envs.json -H "Content-Type: application/json" -H "Authorization: Bearer $API_TOKEN" | jq '.id'

반환된 ID

를INFRA_ENV_ID변수에 할당하고 내보냅니다.$ export INFRA_ENV_ID=<id>

인프라 환경을 생성하여 cluster_id 를 통해 클러스터 정의에 연결하면 지원 관리자 웹 사용자 인터페이스에서 클러스터 설정을 볼 수 있습니다. 터미널 세션을 종료하는 경우 새 터미널 세션에서 ID 를 다시 내보내야 합니다.

4.8. 인프라 환경 수정

/v2/infra-envs/{infra_env_id} 엔드포인트를 사용하여 인프라 환경을 수정할 수 있습니다. 인프라 환경 수정은 네트워킹, SSH 키 또는 Ignition 구성 덮어쓰기와 같은 설정을 추가하는 일반적인 작업입니다.

인프라 환경을 수정할 때 설정할 수 있는 필드에 대한 자세한 내용은 API 뷰어 의 infra-env-update-params 모델을 참조하십시오. 새로운 인프라 환경을 수정할 때 지원 설치 관리자도 검색 ISO를 다시 생성합니다.

사전 요구 사항

- 새 인프라 환경을 생성했습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

인프라 환경을 수정합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "image_type":"minimal-iso", "pull_secret": $pull_secret[0] | tojson } ')" | jq

4.8.1. 선택 사항: 커널 인수 추가

지원 설치 관리자를 통해 RHCOS(Red Hat Enterprise Linux CoreOS) 커널에 커널 인수를 제공하는 것은 특히 검색 ISO의 커널 매개 변수를 사용자 지정할 수 없는 경우 부팅 시 특정 매개변수 또는 옵션을 커널에 전달하는 것을 의미합니다. 커널 매개 변수는 커널 동작 및 운영 체제 구성의 다양한 측면을 제어하여 하드웨어 상호 작용, 시스템 성능 및 기능에 영향을 미칩니다. 커널 인수는 노드의 RHCOS 커널에 하드웨어 구성, 디버깅 기본 설정, 시스템 서비스 및 기타 하위 수준 설정에 대해 사용자 지정하거나 알리는 데 사용됩니다.

RHCOS 설치 프로그램 kargs modify 명령은 append,delete, replace 옵션을 지원합니다.

/v2/infra-envs/{infra_env_id} 엔드포인트를 사용하여 인프라 환경을 수정할 수 있습니다. 새로운 인프라 환경을 수정할 때 지원 설치 관리자도 검색 ISO를 다시 생성합니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

커널 인수를 수정합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d "$(jq --null-input \ --slurpfile pull_secret ~/Downloads/pull-secret.txt ' { "kernel_arguments": [{ "operation": "append", "value": "<karg>=<value>" }], 1 "image_type":"minimal-iso", "pull_secret": $pull_secret[0] | tojson } ')" | jq- 1

- &

lt;karg>를 커널 인수로 바꾸고 <value>를 kernal 인수 값으로 바꿉니다. 예:rd.net.timeout.carrier=60. 각 커널 인수에 JSON 오브젝트를 추가하여 여러 커널 인수를 지정할 수 있습니다.

4.9. 호스트 추가

클러스터 리소스 및 인프라 환경을 구성한 후 검색 ISO 이미지를 다운로드합니다. 다음 두 이미지 중에서 선택할 수 있습니다.

-

전체 ISO 이미지: 부팅 시 전체 ISO 이미지를 자체 포함시켜야 합니다. 이미지에는 지원 설치 프로그램 에이전트를 부팅하고 시작하는 데 필요한 모든 것이 포함되어 있습니다. ISO 이미지는 약 1GB의 크기입니다. 이는 RHEL KVM을 사용하여 설치할 때

s390x아키텍처에 권장되는 방법입니다. - 최소 ISO 이미지: 가상 미디어 연결을 통한 대역폭이 제한되는 경우 최소 ISO 이미지를 사용합니다. 이 설정은 기본 설정입니다. 이미지에는 네트워킹을 사용하여 호스트를 부팅하는 데 필요한 항목만 포함됩니다. 대부분의 콘텐츠는 부팅 시 다운로드됩니다. ISO 이미지는 약 100MB 크기입니다.

현재 z/VM이 있는 IBM Z(s390x)의 설치에는 ISO 이미지가 지원되지 않습니다. 자세한 내용은 iPXE를 사용하여 호스트 부팅을 참조하십시오.

세 가지 방법을 사용하여 검색 이미지로 호스트를 부팅할 수 있습니다. 자세한 내용은 검색 이미지를 사용하여 호스트 부팅을 참조하십시오.

사전 요구 사항

- 클러스터가 생성되어 있습니다.

- 인프라 환경을 생성했습니다.

- 구성을 완료했습니다.

- 클러스터 호스트가 프록시를 사용해야 하는 방화벽 뒤에 있는 경우 프록시 서버의 HTTP 및 HTTPS URL에 대한 사용자 이름, 암호, IP 주소 및 포트를 구성했습니다.

-

이미지 유형을 선택했거나 기본

minimal-iso를 사용합니다.

프로세스

- 필요한 경우 검색 이미지를 구성합니다. 자세한 내용은 검색 이미지 구성을 참조하십시오.

API 토큰을 새로 고칩니다.

$ source refresh-token

다운로드 URL을 가져옵니다.

$ curl -H "Authorization: Bearer ${API_TOKEN}" \ https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/downloads/image-url출력 예

{ "expires_at": "2024-02-07T20:20:23.000Z", "url": "https://api.openshift.com/api/assisted-images/bytoken/<TOKEN>/<OCP_VERSION>/<CPU_ARCHITECTURE>/<FULL_OR_MINIMAL_IMAGE>.iso" }검색 이미지를 다운로드합니다.

$ wget -O discovery.iso <url>

&

lt;url>을 이전 단계의 다운로드 URL로 바꿉니다.- 검색 이미지를 사용하여 호스트를 부팅합니다.

- 호스트에 역할을 할당합니다.

4.10. 호스트 수정

호스트를 추가한 후 필요에 따라 호스트를 수정합니다. 가장 일반적인 수정 사항은 host_name 및 host_role 매개 변수에 대한 것입니다.

/v2/infra-envs/{infra_env_id}/hosts/{host_id} 엔드포인트를 사용하여 호스트를 수정할 수 있습니다. 호스트를 수정할 때 설정할 수 있는 필드에 대한 자세한 내용은 API 뷰어 의 host-update-params 모델을 참조하십시오.

호스트는 다음 두 가지 역할 중 하나일 수 있습니다.

-

master: 마스터 역할이 있는 호스트는 컨트롤 플레인 호스트로 작동합니다. -

worker:worker역할이 있는 호스트는 작업자 호스트로 작동합니다.

기본적으로 지원 설치 관리자는 호스트를 자동 할당 으로 설정합니다. 즉, 설치 프로그램이 호스트가 마스터 또는 작업자 역할인지 여부를 자동으로 결정합니다. 다음 절차에 따라 호스트의 역할을 설정합니다.

사전 요구 사항

- 클러스터에 호스트를 추가했습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

호스트 ID를 가져옵니다.

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

호스트를 수정합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "host_role":"worker" "host_name" : "worker-1" } ' | jq- 1

- &

lt;host_id>를 호스트의 ID로 바꿉니다.

4.10.1. 스토리지 디스크 구성 수정

호스트 검색 중에 검색된 각 호스트에는 여러 스토리지 디스크가 있을 수 있습니다. 선택적으로 각 디스크의 기본 구성을 수정할 수 있습니다.

사전 요구 사항

- 클러스터를 구성하고 호스트를 검색합니다. 자세한 내용은 추가 리소스를 참조하십시오.

스토리지 디스크 보기

클러스터의 호스트와 각 호스트의 디스크를 볼 수 있습니다. 이를 통해 특정 디스크에 대한 작업을 수행할 수 있습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

클러스터의 호스트 ID를 가져옵니다.

$ curl -s "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

샘플 출력

$ "1022623e-7689-8b2d-7fbd-e6f4d5bb28e5"

참고단일 호스트의 ID입니다. 여러 호스트 ID는 쉼표로 구분됩니다.

특정 호스트의 디스크를 가져옵니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -H "Authorization: Bearer ${API_TOKEN}" \ | jq '.inventory | fromjson | .disks'- 1

- &

lt;host_id>를 관련 호스트의 ID로 바꿉니다.

샘플 출력

$ [ { "by_id": "/dev/disk/by-id/wwn-0x6c81f660f98afb002d3adc1a1460a506", "by_path": "/dev/disk/by-path/pci-0000:03:00.0-scsi-0:2:0:0", "drive_type": "HDD", "has_uuid": true, "hctl": "1:2:0:0", "id": "/dev/disk/by-id/wwn-0x6c81f660f98afb002d3adc1a1460a506", "installation_eligibility": { "eligible": true, "not_eligible_reasons": null }, "model": "PERC_H710P", "name": "sda", "path": "/dev/sda", "serial": "0006a560141adc3a2d00fb8af960f681", "size_bytes": 6595056500736, "vendor": "DELL", "wwn": "0x6c81f660f98afb002d3adc1a1460a506" } ]참고이는 하나의 디스크에 대한 출력입니다. 디스크에 대한

disk_id및installation_eligibility속성이 포함되어 있습니다.

설치 디스크 변경

지원 설치 관리자는 기본적으로 설치 디스크를 무작위로 할당합니다. 호스트에 대한 스토리지 디스크가 여러 개 있는 경우 다른 디스크를 선택하여 설치 디스크가 될 수 있습니다. 이렇게 하면 이전 디스크가 자동으로 할당 해제됩니다.

installation_eligibility 속성이 true 인 디스크를 설치 디스크로 선택할 수 있습니다.

프로세스

- 호스트 및 스토리지 디스크 ID를 가져옵니다. 자세한 내용은 스토리지 디스크 보기를 참조하십시오.

선택 사항: 현재 설치 디스크를 식별합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -H "Authorization: Bearer ${API_TOKEN}" \ | jq '.installation_disk_id'- 1

- &

lt;host_id>를 관련 호스트의 ID로 바꿉니다.

새 설치 디스크를 할당합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -X PATCH \ -H "Content-Type: application/json" \ -H "Authorization: Bearer ${API_TOKEN}" \ { "disks_selected_config": [ { "id": "<disk_id>", 2 "role": "install" } ] }

디스크 형식 비활성화

지원 설치 프로그램은 설치 디스크로 정의되었는지 여부에 관계없이 설치 프로세스 중에 포맷할 수 있는 모든 부팅 가능한 디스크를 표시합니다. 포맷으로 인해 데이터가 손실됩니다.

특정 디스크의 포맷을 비활성화하도록 선택할 수 있습니다. 부팅 가능한 디스크가 부팅 순서 측면에서 설치 프로세스를 방해할 수 있으므로 이 작업은 주의해서 수행해야 합니다.

설치 디스크의 포맷을 비활성화할 수 없습니다.

프로세스

- 호스트 및 스토리지 디스크 ID를 가져옵니다. 자세한 내용은 스토리지 디스크 보기를 참조하십시오.

다음 명령을 실행합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ 1 -X PATCH \ -H "Content-Type: application/json" \ -H "Authorization: Bearer ${API_TOKEN}" \ { "disks_skip_formatting": [ { "disk_id": "<disk_id>", 2 "skip_formatting": true 3 } ] }

4.11. 사용자 정의 매니페스트 추가

사용자 정의 매니페스트는 지원 설치 관리자 사용자 인터페이스에서 현재 지원되지 않는 고급 구성이 포함된 JSON 또는 YAML 파일입니다. 사용자 정의 매니페스트를 생성하거나 타사에서 제공하는 매니페스트를 사용할 수 있습니다. API를 사용하여 사용자 정의 매니페스트를 생성하려면 /v2/clusters/$CLUSTER_ID/manifests 엔드포인트를 사용합니다.

base64로 인코딩된 사용자 정의 매니페스트를 openshift 폴더 또는 지원 설치 프로그램 API를 사용하여 매니페스트 폴더에 업로드할 수 있습니다. 허용된 사용자 정의 매니페스트 수에는 제한이 없습니다.

하나의 base64로 인코딩된 JSON 매니페스트만 한 번에 업로드할 수 있습니다. 그러나 업로드된 base64로 인코딩된 YAML 파일은 여러 사용자 정의 매니페스트를 포함할 수 있습니다. 여러 문서 YAML 매니페스트를 업로드하는 것이 YAML 파일을 개별적으로 추가하는 것보다 빠릅니다.

단일 사용자 정의 매니페스트가 포함된 파일의 경우 허용되는 파일 확장자에는 .yaml,.yml 또는 .json 이 포함됩니다.

단일 사용자 정의 매니페스트 예

{

"apiVersion": "machineconfiguration.openshift.io/v1",

"kind": "MachineConfig",

"metadata": {

"labels": {

"machineconfiguration.openshift.io/role": "primary"

},

"name": "10_primary_storage_config"

},

"spec": {

"config": {

"ignition": {

"version": "3.2.0"

},

"storage": {

"disks": [

{

"device": "</dev/xxyN>",

"partitions": [

{

"label": "recovery",

"startMiB": 32768,

"sizeMiB": 16384

}

]

}

],

"filesystems": [

{

"device": "/dev/disk/by-partlabel/recovery",

"label": "recovery",

"format": "xfs"

}

]

}

}

}

}

여러 사용자 지정 매니페스트가 포함된 파일의 경우 허용되는 파일 유형에는 .yaml 또는 .yml 이 포함됩니다.

여러 사용자 정의 매니페스트 예

apiVersion: machineconfiguration.openshift.io/v1

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: master

name: 99-openshift-machineconfig-master-kargs

spec:

kernelArguments:

- loglevel=7

---

apiVersion: machineconfiguration.openshift.io/v2

kind: MachineConfig

metadata:

labels:

machineconfiguration.openshift.io/role: worker

name: 98-openshift-machineconfig-worker-kargs

spec:

kernelArguments:

- loglevel=5

- Oracle Cloud Infrastructure(OCI) 외부 플랫폼에 OpenShift Container Platform을 설치하는 경우 Oracle에서 제공하는 사용자 정의 매니페스트를 추가해야 합니다. vSphere 또는 Nutanix와 같은 추가 외부 파트너 통합의 경우 이 단계는 선택 사항입니다.

- 사용자 정의 매니페스트에 대한 자세한 내용은 추가 리소스 를 참조하십시오.

사전 요구 사항

-

유효한

API_TOKEN을 생성했습니다. 토큰은 15분마다 만료됩니다. -

새 클러스터 정의를 등록하고

cluster_id를$CLUSTER_IDBASH 변수로 내보냈습니다.

프로세스

- 사용자 정의 매니페스트 파일을 생성합니다.

- 파일 형식에 적절한 확장자를 사용하여 사용자 정의 매니페스트 파일을 저장합니다.

API 토큰을 새로 고칩니다.

$ source refresh-token

다음 명령을 실행하여 사용자 정의 매니페스트를 클러스터에 추가합니다.

$ curl -X POST "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/manifests" \ -H "Authorization: Bearer $API_TOKEN" \ -H "Content-Type: application/json" \ -d '{ "file_name":"manifest.json", "folder":"manifests", "content":"'"$(base64 -w 0 ~/manifest.json)"'" }' | jqmanifest.json을 매니페스트 파일 이름으로 교체합니다.manifest.json의 두 번째 인스턴스는 파일 경로입니다. 경로가 올바른지 확인합니다.출력 예

{ "file_name": "manifest.json", "folder": "manifests" }참고base64 -w 0명령은 매니페스트를 문자열로 작성하고 반환을 생략합니다. 반환을 사용하여 인코딩하면 예외가 발생합니다.지원 설치 프로그램이 매니페스트를 추가했는지 확인합니다.

curl -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/manifests/files?folder=manifests&file_name=manifest.json" -H "Authorization: Bearer $API_TOKEN"

manifest.json을 매니페스트 파일 이름으로 교체합니다.

추가 리소스

4.12. 사전 설치 검증

지원 설치 관리자는 복잡한 설치 후 문제 해결을 제거하므로 설치 전에 클러스터가 사전 요구 사항을 충족할 수 있도록 하여 상당한 시간과 노력을 절약할 수 있습니다. 클러스터를 설치하기 전에 클러스터와 각 호스트가 사전 설치 검증을 통과했는지 확인합니다.

추가 리소스

4.13. 클러스터 설치

클러스터의 유효성을 검증한 후 클러스터를 설치할 수 있습니다.

사전 요구 사항

- 클러스터 및 인프라 환경을 생성했습니다.

- 인프라 환경에 호스트를 추가했습니다.

- 호스트가 검증을 통과했습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

클러스터를 설치합니다.

$ curl -H "Authorization: Bearer $API_TOKEN" \ -X POST \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/actions/install | jq

- 설치 후 플랫폼 통합 단계를 완료합니다.

추가 리소스

5장. 선택 사항: 디스크 암호화 활성화

TPM v2 또는 Tang 암호화 모드를 사용하여 설치 디스크의 암호화를 활성화할 수 있습니다.

경우에 따라 베어 메탈 호스트의 펌웨어에서 TPM 디스크 암호화를 활성화한 다음 지원 설치 관리자를 사용하여 생성하는 ISO에서 부팅하면 클러스터 배포가 중단될 수 있습니다. 이는 호스트에 이전 설치의 왼쪽 TPM 암호화 키가 있는 경우 발생할 수 있습니다. 자세한 내용은 BZ#2011634 를 참조하십시오. 이 문제가 발생하면 Red Hat 지원에 문의하십시오.

5.1. TPM v2 암호화 활성화

사전 요구 사항

-

각 호스트의 BIOS에서 TPM v2 암호화가 활성화되어 있는지 확인합니다. 대부분의 Dell 시스템에는 이 작업이 필요합니다. 컴퓨터 설명서를 확인하십시오. 지원 설치 관리자는 펌웨어에서 TPM이 활성화되어 있는지도 확인합니다. 자세한 내용은 지원 설치 관리자 API 의

디스크증가 모델을 참조하십시오.

TPM v2 암호화 칩이 각 노드에 설치되어 펌웨어에 활성화되어 있는지 확인합니다.

프로세스

- 선택 사항: 사용자 인터페이스 마법사의 클러스터 세부 정보 단계에서 UI를 사용하여 컨트롤 플레인 노드, 작업자 또는 둘 다에서 TPM v2 암호화를 활성화하도록 선택합니다.

선택 사항: API를 사용하여 "호스트 수정" 절차를 따릅니다.

disk_encryption.enable_on설정을모든,masters또는workers로 설정합니다.disk_encryption.mode설정을tpmv2로 설정합니다.API 토큰을 새로 고칩니다.

$ source refresh-token

TPM v2 암호화를 활성화합니다.

$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "disk_encryption": { "enable_on": "none", "mode": "tpmv2" } } ' | jqenable_on에 유효한 설정은모두,master,worker또는none입니다.

5.2. Tang 암호화 활성화

사전 요구 사항

- Tang 교환 키의 지문을 생성하는 데 사용할 수 있는 RHEL (Red Hat Enterprise Linux) 8 시스템에 액세스할 수 있습니다.

프로세스

- Tang 서버를 설정하거나 기존 서버에 액세스합니다. 자세한 내용은 Network-bound disk encryption에서 참조하십시오. 여러 Tang 서버를 설정할 수 있지만 지원 설치 프로그램은 설치 중에 모든 서버에 연결할 수 있어야 합니다.

Tang 서버에서

tang-show-keys를 사용하여 Tang 서버의 지문을 검색합니다.$ tang-show-keys <port>

선택 사항: &

lt;port>를 포트 번호로 바꿉니다. 기본 포트 번호는80입니다.지문 예

1gYTN_LpU9ZMB35yn5IbADY5OQ0

선택 사항:

jose를 사용하여 Tang 서버의 지문을 검색합니다.jose가 Tang 서버에 설치되어 있는지 확인합니다.$ sudo dnf install jose

Tang 서버에서

jose를 사용하여 지문을 검색합니다.$ sudo jose jwk thp -i /var/db/tang/<public_key>.jwk

&

lt;public_key>를 Tang 서버의 공개 교환 키로 바꿉니다.지문 예

1gYTN_LpU9ZMB35yn5IbADY5OQ0

- 선택 사항: 사용자 인터페이스 마법사의 클러스터 세부 정보 단계에서 컨트롤 플레인 노드, 작업자 또는 둘 다에서 Tang 암호화를 활성화하도록 선택합니다. Tang 서버의 URL과 지문을 입력해야 합니다.

선택 사항: API를 사용하여 "호스트 수정" 절차를 따릅니다.

API 토큰을 새로 고칩니다.

$ source refresh-token

disk_encryption.enable_on설정을모든,masters또는workers로 설정합니다.disk_encryption.mode설정을tang로 설정합니다.disk_encyrption.tang_servers를 설정하여 하나 이상의 Tang 서버에 대한 URL 및 지문 세부 정보를 제공합니다.$ curl https://api.openshift.com/api/assisted-install/v2/clusters/${CLUSTER_ID} \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "disk_encryption": { "enable_on": "all", "mode": "tang", "tang_servers": "[{\"url\":\"http://tang.example.com:7500\",\"thumbprint\":\"PLjNyRdGw03zlRoGjQYMahSZGu9\"},{\"url\":\"http://tang2.example.com:7500\",\"thumbprint\":\"XYjNyRdGw03zlRoGjQYMahSZGu3\"}]" } } ' | jqenable_on에 유효한 설정은모두,master,worker또는none입니다.tang_servers값 내에서 오브젝트 내의 따옴표를 주석 처리합니다.

5.3. 추가 리소스

6장. 검색 이미지 구성

지원 설치 프로그램은 초기 이미지를 사용하여 OpenShift Container Platform 설치를 시도하기 전에 하드웨어 및 네트워크 검증을 수행하는 에이전트를 실행합니다. Ignition 을 사용하여 검색 이미지를 사용자 지정할 수 있습니다.

검색 이미지에 대한 수정 사항은 시스템에 유지되지 않습니다.

6.1. Ignition 구성 파일 생성

Ignition은 임시 초기 루트 파일 시스템의 일부인 initramfs 의 일부인 하위 수준 시스템 구성 유틸리티입니다. Ignition이 첫 번째 부팅 시 실행되는 경우 Ignition 구성 파일에서 구성 데이터를 찾아 호스트의 루트 파일 시스템을 피벗하기 위해 switch_root 가 호출되기 전에 호스트에 적용합니다.

Ignition은 JSON 구성 사양 파일을 사용하여 첫 번째 부팅 시 발생하는 변경 사항을 나타냅니다.

3.2 미만의 Ignition 버전은 지원되지 않으며 오류가 발생합니다.

프로세스

Ignition 파일을 생성하고 구성 사양 버전을 지정합니다.

$ vim ~/ignition.conf

{ "ignition": { "version": "3.1.0" } }Ignition 파일에 구성 데이터를 추가합니다. 예를 들어

core사용자에게 암호를 추가합니다.암호 해시를 생성합니다.

$ openssl passwd -6

생성된 암호 해시를

core사용자에게 추가합니다.{ "ignition": { "version": "3.1.0" }, "passwd": { "users": [ { "name": "core", "passwordHash": "$6$spam$M5LGSMGyVD.9XOboxcwrsnwNdF4irpJdAWy.1Ry55syyUiUssIzIAHaOrUHr2zg6ruD8YNBPW9kW0H8EnKXyc1" } ] } }

Ignition 파일을 저장하고

IGNITION_FILE변수로 내보냅니다.$ export IGNITION_FILE=~/ignition.conf

6.2. Ignition을 사용하여 검색 이미지 수정

Ignition 구성 파일을 생성하면 지원 설치 관리자 API를 사용하여 인프라 환경을 패치하여 검색 이미지를 수정할 수 있습니다.

사전 요구 사항

- UI를 사용하여 클러스터를 생성한 경우 API 인증을 설정했습니다.

-

인프라 환경이 있고 인프라 환경 ID를

INFRA_ENV_ID변수로 내보냈습니다. -

유효한 Ignition 파일이 있으며

$IGNITION_FILE로 파일 이름을 내보냈습니다.

프로세스

ignition_config_overrideJSON 오브젝트를 생성하여 파일로 리디렉션합니다.$ jq -n \ --arg IGNITION "$(jq -c . $IGNITION_FILE)" \ '{ignition_config_override: $IGNITION}' \ > discovery_ignition.jsonAPI 토큰을 새로 고칩니다.

$ source refresh-token

인프라 환경을 패치합니다.

$ curl \ --header "Authorization: Bearer $API_TOKEN" \ --header "Content-Type: application/json" \ -XPATCH \ -d @discovery_ignition.json \ https://api.openshift.com/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID | jq

ignition_config_override오브젝트는 Ignition 파일을 참조합니다.- 업데이트된 검색 이미지를 다운로드합니다.

7장. 검색 이미지를 사용하여 호스트 부팅

지원 설치 프로그램은 초기 이미지를 사용하여 OpenShift Container Platform 설치를 시도하기 전에 하드웨어 및 네트워크 검증을 수행하는 에이전트를 실행합니다. 세 가지 방법을 사용하여 검색 이미지로 호스트를 부팅할 수 있습니다.

- USB 드라이브

- RedFish 가상 미디어

- iPXE

7.1. USB 드라이브에 ISO 이미지 생성

검색 ISO 이미지가 포함된 USB 드라이브를 사용하여 지원 설치 관리자 에이전트를 설치할 수 있습니다. USB 드라이브로 호스트를 시작하면 소프트웨어 설치를 위한 호스트가 준비됩니다.

프로세스

- 관리 호스트에서 USB 드라이브를 USB 포트에 삽입합니다.

ISO 이미지를 USB 드라이브에 복사합니다. 예를 들면 다음과 같습니다.

# dd if=<path_to_iso> of=<path_to_usb> status=progress

다음과 같습니다.

- <path_to_iso>

-

다운로드한 검색 ISO 파일의 상대 경로(예:

discovery.iso)입니다. - <path_to_usb>

연결된 USB 드라이브의 위치입니다(예:

/dev/sdb).ISO가 USB 드라이브에 복사되면 USB 드라이브를 사용하여 클러스터 호스트에 지원 설치 관리자 에이전트를 설치할 수 있습니다.

7.2. USB 드라이브로 부팅

부팅 가능한 USB 드라이브를 사용하여 지원 설치 프로그램으로 노드를 등록하려면 다음 절차를 사용하십시오.

프로세스

- RHCOS 검색 ISO USB 드라이브를 대상 호스트에 삽입합니다.

- 연결된 검색 ISO에서 부팅하도록 서버 펌웨어 설정에서 부팅 드라이브 순서를 구성한 다음 서버를 재부팅합니다.

호스트가 부팅될 때까지 기다립니다.

- UI 설치의 경우 관리 호스트에서 브라우저로 돌아갑니다. 검색된 호스트 목록에 호스트가 표시될 때까지 기다립니다.

API 설치의 경우 토큰을 새로고침하고 활성화된 호스트 수를 확인하고 호스트 ID를 수집합니다.

$ source refresh-token

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.enabled_host_count'

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

출력 예

[ "1062663e-7989-8b2d-7fbb-e6f4d5bb28e5" ]

7.3. Redfish API를 사용하여 HTTP 호스팅 ISO 이미지에서 부팅

Redfish BMC(Baseboard Management Controller) API를 사용하여 설치하는 ISO를 사용하여 네트워크에 호스트를 프로비저닝할 수 있습니다.

사전 요구 사항

- 설치 RHCOS(Red Hat Enterprise Linux CoreOS) ISO를 다운로드합니다.

프로세스

- 네트워크에서 액세스할 수 있는 HTTP 서버에 ISO 파일을 복사합니다.

호스트 ISO 파일에서 호스트를 부팅합니다. 예를 들면 다음과 같습니다.

다음 명령을 실행하여 호스팅된 ISO를

VirtualMedia부팅 미디어로 설정하려면 redfish API를 호출합니다.$ curl -k -u <bmc_username>:<bmc_password> \ -d '{"Image":"<hosted_iso_file>", "Inserted": true}' \ -H "Content-Type: application/json" \ -X POST <host_bmc_address>/redfish/v1/Managers/iDRAC.Embedded.1/VirtualMedia/CD/Actions/VirtualMedia.InsertMedia다음과 같습니다.

- <bmc_username>:<bmc_password>

- 대상 호스트 BMC의 사용자 이름과 암호입니다.

- <hosted_iso_file>

-

호스팅된 설치 ISO의 URL입니다(예:

https://example.com/rhcos-live-minimal.iso). 대상 호스트 시스템에서 ISO에 액세스할 수 있어야 합니다. - <host_bmc_address>

- 대상 호스트 시스템의 BMC IP 주소입니다.

다음 명령을 실행하여

VirtualMedia장치에서 부팅되도록 호스트를 설정합니다.$ curl -k -u <bmc_username>:<bmc_password> \ -X PATCH -H 'Content-Type: application/json' \ -d '{"Boot": {"BootSourceOverrideTarget": "Cd", "BootSourceOverrideMode": "UEFI", "BootSourceOverrideEnabled": "Once"}}' \ <host_bmc_address>/redfish/v1/Systems/System.Embedded.1호스트를 재부팅합니다.

$ curl -k -u <bmc_username>:<bmc_password> \ -d '{"ResetType": "ForceRestart"}' \ -H 'Content-type: application/json' \ -X POST <host_bmc_address>/redfish/v1/Systems/System.Embedded.1/Actions/ComputerSystem.Reset선택 사항: 호스트의 전원이 꺼지면

{"ResetType": "On"}스위치를 사용하여 부팅할 수 있습니다. 다음 명령을 실행합니다.$ curl -k -u <bmc_username>:<bmc_password> \ -d '{"ResetType": "On"}' -H 'Content-type: application/json' \ -X POST <host_bmc_address>/redfish/v1/Systems/System.Embedded.1/Actions/ComputerSystem.Reset

7.4. iPXE를 사용하여 호스트 부팅

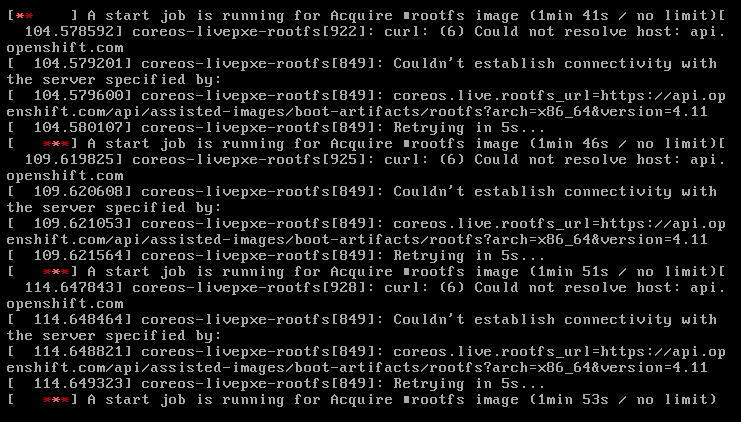

지원 설치 프로그램은 인프라 환경의 검색 이미지를 부팅하는 데 필요한 모든 아티팩트를 포함하여 iPXE 스크립트를 제공합니다. iPXE의 현재 HTTPS 구현의 제한 사항으로 인해 HTTP 서버에서 필요한 아티팩트를 다운로드하여 노출하는 것이 좋습니다. 현재 iPXE가 HTTPS 프로토콜을 지원하는 경우에도 지원되는 알고리즘은 오래되어 권장되지 않습니다.

지원되는 암호의 전체 목록은 https://ipxe.org/crypto 입니다.

사전 요구 사항

- API를 사용하여 인프라 환경을 생성하거나 UI를 사용하여 클러스터를 생성했습니다.

-

쉘에서 인프라 환경 ID를

$INFRA_ENV_ID로 내보내야 합니다. -

API에 액세스할 때 사용할 인증 정보가 있으며 쉘에서

$API_TOKEN으로 토큰을 내보냈습니다. - 이미지를 호스팅할 HTTP 서버가 있습니다.

UI를 통해 구성할 때 $INFRA_ENV_ID 및 $API_TOKEN 변수가 이미 제공됩니다.

IBM Power는 PXE만 지원합니다. 필요한 PXE만 지원합니다. /var/lib/tftpboot에 grub2 를 설치했습니다. PXE용 DHCP 및 TFTP를 설치했습니다.

프로세스

UI에서 직접 iPXE 스크립트를 다운로드하거나 지원 설치 관리자에서 iPXE 스크립트를 가져옵니다.

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/infra-envs/$INFRA_ENV_ID/downloads/files?file_name=ipxe-script > ipxe-script

예제

#!ipxe initrd --name initrd http://api.openshift.com/api/assisted-images/images/<infra_env_id>/pxe-initrd?arch=x86_64&image_token=<token_string>&version=4.10 kernel http://api.openshift.com/api/assisted-images/boot-artifacts/kernel?arch=x86_64&version=4.10 initrd=initrd coreos.live.rootfs_url=http://api.openshift.com/api/assisted-images/boot-artifacts/rootfs?arch=x86_64&version=4.10 random.trust_cpu=on rd.luks.options=discard ignition.firstboot ignition.platform.id=metal console=tty1 console=ttyS1,115200n8 coreos.inst.persistent-kargs="console=tty1 console=ttyS1,115200n8" boot

ipxe-script에서 URL을 추출하여 필요한 아티팩트를 다운로드합니다.초기 RAM 디스크를 다운로드합니다.

$ awk '/^initrd /{print $NF}' ipxe-script | curl -o initrd.imglinux 커널을 다운로드합니다.

$ awk '/^kernel /{print $2}' ipxe-script | curl -o kernel루트 파일 시스템을 다운로드합니다.

$ grep ^kernel ipxe-script | xargs -n1| grep ^coreos.live.rootfs_url | cut -d = -f 2- | curl -o rootfs.img

로컬 HTTP 서버와 일치하도록

ipxe-script'의 다른 아티팩트로 URL을 변경합니다. 예를 들면 다음과 같습니다.#!ipxe set webserver http://192.168.0.1 initrd --name initrd $webserver/initrd.img kernel $webserver/kernel initrd=initrd coreos.live.rootfs_url=$webserver/rootfs.img random.trust_cpu=on rd.luks.options=discard ignition.firstboot ignition.platform.id=metal console=tty1 console=ttyS1,115200n8 coreos.inst.persistent-kargs="console=tty1 console=ttyS1,115200n8" boot

선택 사항: IBM zSystems에 RHEL KVM을 사용하여 설치할 때 추가 커널 인수를 지정하여 호스트를 부팅해야 합니다.

random.trust_cpu=on rd.luks.options=discard ignition.firstboot ignition.platform.id=metal console=tty1 console=ttyS1,115200n8 coreos.inst.persistent-kargs="console=tty1 console=ttyS1,115200n8

참고RHEL KVM에 iPXE를 사용하여 설치하는 경우 경우에 따라 VM 호스트의 VM이 첫 번째 부팅 시 재부팅되지 않으므로 수동으로 시작해야 합니다.

선택 사항: IBM Power에 설치할 때 다음과 같이 intramfs, kernel 및 root를 다운로드해야 합니다.

- initrd.img 및 kernel.img를 PXE 디렉터리 '/var/lib/tftpboot/rhcos'로 복사합니다.

- rootfs.img를 HTTPD 디렉터리 '/var/www/html/install '에 복사합니다.

'/var/lib/tftpboot/boot/grub2/grub.cfg ':

if [ ${net_default_mac} == fa:1d:67:35:13:20 ]; then default=0 fallback=1 timeout=1 menuentry "CoreOS (BIOS)" { echo "Loading kernel" linux "/rhcos/kernel.img" ip=dhcp rd.neednet=1 ignition.platform.id=metal ignition.firstboot coreos.live.rootfs_url=http://9.114.98.8:8000/install/rootfs.img echo "Loading initrd" initrd "/rhcos/initrd.img" } fi

8장. 호스트에 역할 할당

검색된 호스트에 역할을 할당할 수 있습니다. 이러한 역할은 클러스터 내에서 호스트의 기능을 정의합니다. 역할은 표준 Kubernetes 유형인 컨트롤 플레인(마스터) 또는 작업자 중 하나일 수 있습니다.

호스트는 선택한 역할에 대한 최소 요구 사항을 충족해야 합니다. 이 문서의 사전 요구 사항 섹션을 참조하거나 사전 요구 사항 API를 사용하여 하드웨어 요구 사항을 확인할 수 있습니다.

역할을 선택하지 않으면 시스템에서 역할을 선택합니다. 설치를 시작하기 전에 언제든지 역할을 변경할 수 있습니다.

8.1. UI를 사용하여 역할 선택

호스트 검색이 완료된 후 역할을 선택할 수 있습니다.

프로세스

- Host Discovery (호스트 검색) 탭으로 이동하여 Host Inventory (호스트 인벤토리) 테이블까지 아래로 스크롤합니다.

- 필요한 호스트에 대해 자동 할당 드롭다운 을 선택합니다.

- 컨트롤 플레인 노드를 선택하여 이 호스트에 컨트롤 플레인 역할을 할당합니다.

- Worker 를 선택하여 이 호스트에 작업자 역할을 할당합니다.

- 검증 상태를 확인합니다.

8.2. API를 사용하여 역할 선택

/v2/infra-envs/{infra_env_id}/hosts/{host_id} 엔드포인트를 사용하여 호스트의 역할을 선택할 수 있습니다. 호스트는 다음 두 가지 역할 중 하나일 수 있습니다.

-

master: 마스터 역할이 있는 호스트는 컨트롤 플레인 호스트로 작동합니다. -

worker:worker역할이 있는 호스트는 작업자 호스트로 작동합니다.

기본적으로 지원 설치 관리자는 호스트를 자동 할당 으로 설정합니다. 즉, 설치 프로그램에서 호스트가 마스터 또는 작업자 역할인지 자동으로 결정합니다. 호스트 역할을 설정하려면 다음 절차를 사용하십시오.

사전 요구 사항

- 클러스터에 호스트를 추가했습니다.

프로세스

API 토큰을 새로 고칩니다.

$ source refresh-token

호스트 ID를 가져옵니다.

$ curl -s -X GET "https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID" \ --header "Content-Type: application/json" \ -H "Authorization: Bearer $API_TOKEN" \ | jq '.host_networks[].host_ids'

출력 예

[ "1062663e-7989-8b2d-7fbb-e6f4d5bb28e5" ]

host_role설정을 수정합니다.$ curl https://api.openshift.com/api/assisted-install/v2/infra-envs/${INFRA_ENV_ID}/hosts/<host_id> \ -X PATCH \ -H "Authorization: Bearer ${API_TOKEN}" \ -H "Content-Type: application/json" \ -d ' { "host_role":"worker" } ' | jq&

lt;host_id>를 호스트의 ID로 바꿉니다.

8.3. 역할 자동 할당

지원 설치 관리자는 역할을 직접 할당하지 않는 경우 호스트에 대해 자동으로 역할을 선택합니다. 역할 선택 메커니즘은 호스트의 메모리, CPU 및 디스크 공간을 따릅니다. 컨트롤 플레인 노드의 최소 요구사항을 충족하는 3개의 약한 호스트에 컨트롤 플레인 역할을 할당하는 것을 목표로 합니다. 다른 모든 호스트는 기본적으로 작업자 노드를 설정합니다. 목표는 컨트롤 플레인을 실행하기에 충분한 리소스를 제공하고 실제 워크로드를 실행하기 위해 더 많은 용량이 많은 호스트를 예약하는 것입니다.

설치하기 전에 언제든지 자동 할당 결정을 재정의할 수 있습니다.

검증은 자동 선택 사항이 유효한지 확인합니다.

8.4. 추가 리소스

9장. 사전 설치 검증

9.1. 사전 설치 검증 정의

지원 설치 관리자는 클러스터 설치를 간단하고 효율적이며 오류 없이 설치하는 것을 목표로 합니다. 지원 설치 관리자는 설치를 시작하기 전에 구성 및 수집된 Telemetry에 대한 유효성 검사 검사를 수행합니다.

지원 설치 프로그램은 컨트롤 플레인 토폴로지, 네트워크 구성 및 호스트 이름과 같이 설치 전에 제공되는 정보를 사용합니다. 또한 설치하려는 호스트의 실시간 Telemetry를 사용합니다.

호스트가 검색 ISO를 부팅하면 에이전트가 호스트에서 시작됩니다. 에이전트는 호스트 상태에 대한 정보를 지원 설치 프로그램에 보냅니다.

지원 설치 관리자는 이 모든 정보를 사용하여 실시간 사전 설치 검증을 계산합니다. 모든 검증은 설치를 차단하거나 차단하지 않습니다.

9.2. 차단 및 비차단 검증

차단 검증으로 인해 설치 진행 상황을 방지할 수 있습니다. 따라서 문제를 해결하고 계속 진행하기 전에 차단 검증을 전달해야 합니다.

비차단 검증은 경고이며 문제가 발생할 수 있는 사항에 대해 알려줍니다.

9.3. 검증 유형

지원 설치 관리자는 다음 두 가지 유형의 검증을 수행합니다.

호스트

호스트 검증은 지정된 호스트의 구성이 설치에 유효한지 확인합니다.

Cluster

클러스터 검증은 전체 클러스터 구성이 설치에 유효한지 확인합니다.

9.4. 호스트 검증

9.4.1. REST API를 사용하여 호스트 검증 가져오기

웹 기반 UI를 사용하는 경우 이러한 검증의 대부분은 이름에 표시되지 않습니다. 라벨과 일치하는 검증 목록을 가져오려면 다음 절차를 사용하십시오.

사전 요구 사항

-

jq유틸리티를 설치했습니다. - API를 사용하여 인프라 환경을 생성하거나 UI를 사용하여 클러스터를 생성했습니다.

- 검색 ISO로 부팅된 호스트가 있습니다.

-

CLUSTER_ID로서 쉘에서 내보낸 클러스터 ID가 있습니다. -

API에 액세스할 때 사용할 인증 정보가 있으며 쉘에서

API_TOKEN으로 토큰을 내보냈습니다.

프로시저

API 토큰을 새로 고칩니다.

$ source refresh-token

모든 호스트에 대한 모든 검증을 가져옵니다.

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/hosts \ | jq -r .[].validations_info \ | jq 'map(.[])'

모든 호스트에 대해 통과하지 않은 검증을 가져옵니다.

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID/hosts \ | jq -r .[].validations_info \ | jq 'map(.[]) | map(select(.status=="failure" or .status=="pending")) | select(length>0)'

9.4.2. 호스트 검증 세부 정보

| 매개변수 | 검증 유형 | 설명 |

|---|---|---|

|

| 비차단(non-blocking) | 호스트가 최근에 지원 설치 프로그램과 통신했는지 확인합니다. |

|

| 비차단(non-blocking) | 지원 설치 프로그램이 호스트에서 인벤토리를 수신했는지 확인합니다. |

|

| 비차단(non-blocking) | CPU 코어 수가 최소 요구 사항을 충족하는지 확인합니다. |

|

| 비차단(non-blocking) | 메모리 양이 최소 요구 사항을 충족하는지 확인합니다. |

|

| 비차단(non-blocking) | 사용 가능한 디스크가 자격 기준을 충족하는지 확인합니다. |

|

| blocking | 코어 수가 호스트 역할의 최소 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 메모리 양이 호스트 역할의 최소 요구 사항을 충족하는지 확인합니다. |

|

| blocking | Day 2 호스트의 경우 호스트가 1일 클러스터에서 ignition 구성을 다운로드할 수 있는지 확인합니다. |

|

| blocking | 대부분의 그룹은 클러스터에서 가장 큰 full-mesh 연결 그룹입니다. 여기서 모든 멤버가 다른 모든 멤버와 통신할 수 있습니다. 이 검증은 다중 노드 1일 클러스터의 호스트가 대부분의 그룹에 있는지 확인합니다. |

|

| blocking | 플랫폼이 네트워크 설정에 유효한지 확인합니다. |

|

| 비차단(non-blocking) | NTP 서버가 호스트의 시간을 동기화하는 데 성공적으로 사용되었는지 확인합니다. |

|

| 비차단(non-blocking) | 이미지 레지스트리에서 컨테이너 이미지를 가져왔는지 확인합니다. |

|

| blocking | 이전 설치의 디스크 속도 지표가 있는 경우 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 클러스터의 호스트 간 평균 네트워크 대기 시간이 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 클러스터의 호스트 간 네트워크 패킷 손실이 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 호스트에 기본 경로가 구성되어 있는지 확인합니다. |

|

| blocking | 사용자 관리 네트워킹이 있는 다중 노드 클러스터의 경우 호스트가 클러스터의 API 도메인 이름을 확인할 수 있는지 확인합니다. |

|

| blocking | 사용자 관리 네트워킹이 있는 다중 노드 클러스터의 경우 호스트가 클러스터의 내부 API 도메인 이름을 확인할 수 있는지 확인합니다. |

|

| blocking | 사용자 관리 네트워킹이 있는 다중 노드 클러스터의 경우 호스트가 클러스터의 내부 앱 도메인 이름을 확인할 수 있는지 확인합니다. |

|

| 비차단(non-blocking) | 호스트가 클러스터 플랫폼과 호환되는지 확인합니다. |

|

| blocking | 와일드카드 DNS *.<cluster_name>.<base_domain>이 구성되지 않았는지 확인합니다. 이로 인해 OpenShift에 알려진 문제가 있기 때문입니다. |

|

| 비차단(non-blocking) | 구성된 호스트 및 디스크 암호화 유형이 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 이 호스트에 중복된 서브넷이 없는지 확인합니다. |

|

| blocking | 클러스터에서 호스트 이름이 고유한지 확인합니다. |

|

| blocking | 호스트 이름의 유효성을 확인합니다. 즉, 일반 호스트 이름과 일치하며 금지되지 않습니다. |

|

| blocking | 호스트 IP가 시스템 CIDR의 주소 범위에 있는지 확인합니다. |

|

| blocking | 클러스터가 Local Storage Operator의 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 클러스터가 Openshift Data Foundation Operator의 요구 사항을 충족하는지 확인합니다.

|

|

| blocking | 클러스터가 Container Native Virtualization의 요구 사항을 충족하는지 확인합니다.

|

|

| blocking | 클러스터가 Logical Volume Manager Operator의 요구 사항을 충족하는지 확인합니다.

|

|

| 비차단(non-blocking) | 각 유효한 디스크가 disk.EnableUUID 를 true 로 설정하는지 확인합니다. VSphere에서 각 디스크에 UUID가 생성됩니다. |

|

| blocking | 검색 에이전트 버전이 에이전트 Docker 이미지 버전과 호환되는지 확인합니다. |

|

| blocking | 설치 디스크가 디스크 포맷을 건너뛰지 않는지 확인합니다. |

|

| blocking | 건너뛰기 포맷으로 표시된 모든 디스크가 인벤토리에 있는지 확인합니다. 재부팅 시 디스크 ID가 변경될 수 있으므로 이 검증으로 인한 문제가 발생하지 않습니다. |

|

| blocking | 호스트에 대한 설치 미디어의 연결을 확인합니다. |

|

| 비차단(non-blocking) | 클러스터에 대한 머신 네트워크 정의가 있는지 확인합니다. |

|

| blocking | 플랫폼이 네트워크 설정과 호환되는지 확인합니다. 일부 플랫폼은 단일 노드 Openshift를 설치하거나 사용자 관리 네트워킹을 사용하는 경우에만 허용됩니다. |

9.5. 클러스터 검증

9.5.1. REST API를 사용하여 클러스터 검증 가져오기

웹 기반 UI를 사용하는 경우 이러한 검증의 대부분은 이름에 표시되지 않습니다. 라벨과 일치하는 검증 목록을 얻으려면 다음 절차를 사용하십시오.

사전 요구 사항

-

jq유틸리티를 설치했습니다. - API를 사용하여 인프라 환경을 생성하거나 UI를 사용하여 클러스터를 생성했습니다.

-

CLUSTER_ID로서 쉘에서 내보낸 클러스터 ID가 있습니다. -

API에 액세스할 때 사용할 인증 정보가 있으며 쉘에서

API_TOKEN으로 토큰을 내보냈습니다.

프로시저

API 토큰을 새로 고칩니다.

$ source refresh-token

모든 클러스터 검증을 가져옵니다.

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID \ | jq -r .validations_info \ | jq 'map(.[])'

통과하지 않는 클러스터 검증을 가져옵니다.

$ curl \ --silent \ --header "Authorization: Bearer $API_TOKEN" \ https://api.openshift.com/api/assisted-install/v2/clusters/$CLUSTER_ID \ | jq -r .validations_info \ | jq '. | map(.[] | select(.status=="failure" or .status=="pending")) | select(length>0)'

9.5.2. 클러스터 검증 세부 정보

| 매개변수 | 검증 유형 | 설명 |

|---|---|---|

|

| 비차단(non-blocking) | 클러스터에 대한 머신 네트워크 정의가 있는지 확인합니다. |

|

| 비차단(non-blocking) | 클러스터에 대한 클러스터 네트워크 정의가 있는지 확인합니다. |

|

| 비차단(non-blocking) | 클러스터에 대한 서비스 네트워크 정의가 있는지 확인합니다. |

|

| blocking | 정의된 네트워크가 겹치지 않는지 확인합니다. |

|

| blocking | 정의된 네트워크가 동일한 주소 제품군을 공유하는지 확인합니다(유효한 주소 제품군은 IPv4, IPv6) |

|

| blocking | 클러스터 네트워크 접두사를 확인하여 유효한지 확인하고 모든 호스트에 충분한 주소 공간을 허용합니다. |

|

| blocking |

사용자 관리 네트워킹 클러스터의 경우 |

|

| 비차단(non-blocking) |

사용자 관리 네트워킹 클러스터의 경우 |

|

| blocking |

사용자 관리 네트워킹 클러스터의 경우 |

|

| blocking |

사용자 관리 네트워킹 클러스터의 경우 |

|

| 비차단(non-blocking) |

사용자 관리 네트워킹 클러스터의 경우 |

|

| blocking | 클러스터의 모든 호스트가 "설치 준비" 상태에 있는지 확인합니다. |

|

| blocking | 이 검증은 다중 노드 클러스터에만 적용됩니다.

|

|

| 비차단(non-blocking) | 클러스터에 대한 기본 DNS 도메인이 있는지 확인합니다. |

|

| 비차단(non-blocking) | 풀 시크릿이 있는지 확인합니다. 풀 시크릿이 유효하거나 권한이 있는지 확인하지 않습니다. |

|

| blocking | 각 호스트 시계가 4분 이상 동기화되지 않았는지 확인합니다. |

|

| blocking | 클러스터가 Local Storage Operator의 요구 사항을 충족하는지 확인합니다. |

|

| blocking | 클러스터가 Openshift Data Foundation Operator의 요구 사항을 충족하는지 확인합니다.

|

|

| blocking | 클러스터가 Container Native Virtualization의 요구 사항을 충족하는지 확인합니다.

|

|

| blocking | 클러스터가 Logical Volume Manager Operator의 요구 사항을 충족하는지 확인합니다.

|

|

| blocking | 네트워크 유형이 존재하는 경우 유효성을 확인합니다.

|

10장. 네트워크 구성

이 섹션에서는 지원 설치 관리자를 사용한 네트워크 구성의 기본 사항에 대해 설명합니다.

10.1. 클러스터 네트워킹

OpenShift에서 사용하는 다양한 네트워크 유형 및 주소가 아래 표에 나열되어 있습니다.

| 유형 | DNS | 설명 |

|---|---|---|

|

| Pod IP 주소가 할당되는 IP 주소 풀입니다. | |

|

| 서비스의 IP 주소 풀입니다. | |

|

| 클러스터를 구성하는 시스템의 IP 주소 블록입니다. | |

|

|

| API 통신에 사용할 VIP입니다. 기본 이름이 올바르게 확인되도록 이 설정을 DNS에서 제공하거나 사전 구성해야 합니다. 듀얼 스택 네트워킹을 사용하여 배포하는 경우 이는 IPv4 주소여야 합니다. |

|

|

|

API 통신에 사용할 VIP입니다. 기본 이름이 올바르게 확인되도록 이 설정을 DNS에서 제공하거나 사전 구성해야 합니다. 듀얼 스택 네트워킹을 사용하는 경우 첫 번째 주소는 IPv4 주소여야 하며 두 번째 주소는 IPv6 주소여야 합니다. |

|

|

| Ingress 트래픽에 사용할 VIP입니다. 듀얼 스택 네트워킹을 사용하여 배포하는 경우 이는 IPv4 주소여야 합니다. |

|

|

|

인그레스 트래픽에 사용할 VIP입니다. 듀얼 스택 네트워킹을 사용하여 배포하는 경우 첫 번째 주소는 IPv4 주소여야 하며 두 번째 주소는 IPv6 주소여야 합니다. |

OpenShift Container Platform 4.12에는 듀얼 스택 네트워킹에 대해 여러 IP 주소를 수락하기 위해 새로운 apiVIP 및 ingressVIPs 설정이 도입되었습니다. 듀얼 스택 네트워킹을 사용하는 경우 첫 번째 IP 주소는 IPv4 주소여야 하며 두 번째 IP 주소는 IPv6 주소여야 합니다. 새 설정은 apiVIP 및 IngressVIP 를 대체하지만 API를 사용하여 구성을 수정할 때 새 설정과 이전 설정을 모두 설정해야 합니다.

원하는 네트워크 스택에 따라 다른 네트워크 컨트롤러를 선택할 수 있습니다. 현재 지원 서비스는 다음 구성 중 하나를 사용하여 OpenShift Container Platform 클러스터를 배포할 수 있습니다.

- IPv4

- IPv6

- Dual-stack (IPv4 + IPv6)

지원되는 네트워크 컨트롤러는 선택한 스택에 따라 다르며 아래 표에 요약되어 있습니다. 자세한 CNI(Container Network Interface) 네트워크 공급자 기능 비교의 경우 OCP 네트워킹 설명서 를 참조하십시오.

| stack | SDN | OVN |

|---|---|---|

| IPv4 | 제공됨 | 제공됨 |

| IPv6 | 없음 | 제공됨 |

| Dual-stack | 없음 | 제공됨 |

OVN은 OpenShift Container Platform 4.12 이상 릴리스의 기본 CNI(Container Network Interface)입니다. SDN은 OpenShift Container Platform 4.14에서 지원되지만 OpenShift Container Platform 4.15 이상 릴리스에서는 지원되지 않습니다.

10.1.1. 제한

10.1.1.1. SDN

- SDN 컨트롤러는 SNO(Single-node OpenShift)에서 지원되지 않습니다.

- SDN 컨트롤러는 IPv6를 지원하지 않습니다.

- OpenShift Container Platform 4.15 이상 릴리스에서는 SDN 컨트롤러가 지원되지 않습니다. 자세한 내용은 OpenShift Container Platform 릴리스 노트 에서 OpenShift SDN 네트워크 플러그인 사용 중단을 참조하십시오.

10.1.1.2. OVN-Kubernetes

10.1.2. 클러스터 네트워크

클러스터 네트워크는 클러스터에 배포된 모든 Pod가 IP 주소를 가져오는 네트워크입니다. 워크로드가 클러스터를 구성하는 여러 노드에 걸쳐 있을 수 있으므로 네트워크 공급자가 Pod의 IP 주소를 기반으로 개별 노드를 쉽게 찾을 수 있어야 합니다. 이를 위해 clusterNetwork.cidr 은 clusterNetwork.hostPrefix 에 정의된 크기의 서브넷으로 추가로 분할됩니다.

호스트 접두사는 클러스터의 각 개별 노드에 할당된 서브넷의 길이를 지정합니다. 클러스터가 다중 노드 클러스터에 대한 주소를 할당하는 방법의 예는 다음과 같습니다.

---

clusterNetwork:

- cidr: 10.128.0.0/14

hostPrefix: 23

---위의 스니펫을 사용하여 3-노드 클러스터를 생성하면 다음 네트워크 토폴로지가 생성될 수 있습니다.

-

노드 #1에 예약된 Pod는

10.128.0.0/23에서 IP를 가져옵니다. -

노드 #2에 예약된 Pod는

10.128.2.0/23에서 IP를 가져옵니다. -

노드 #3에 예약된 Pod는

10.128.4.0/23에서 IP를 가져옵니다.

OVN-K8s 내부를 설명하는 것은 이 문서의 범위가 아니지만 위에 설명된 패턴은 Pod와 해당 노드 간의 매핑 목록을 유지하지 않고 다른 노드 간에 Pod-to-Pod 트래픽을 라우팅하는 방법을 제공합니다.

10.1.3. 머신 네트워크

시스템 네트워크는 클러스터를 구성하는 모든 호스트에서 서로 통신하는 데 사용되는 네트워크입니다. API 및 Ingress VIP를 포함해야 하는 서브넷이기도 합니다.

10.1.4. 다중 노드 클러스터 비교

단일 노드 OpenShift 또는 다중 노드 클러스터를 배포하는지 여부에 따라 다른 값이 필요합니다. 아래 표에서는 이에 대해 자세히 설명합니다.

| 매개변수 | SNO | DHCP 모드가 있는 다중 노드 클러스터 | DHCP 모드가 없는 다중 노드 클러스터 |

|---|---|---|---|

|

| 필수 항목 | 필수 항목 | 필수 항목 |

|

| 필수 항목 | 필수 항목 | 필수 항목 |

|

| 자동 할당 가능 (*) | 자동 할당 가능 (*) | 자동 할당 가능 (*) |

|

| 사용 금지됨 | 사용 금지됨 | 필수 항목 |

|

| 사용 금지됨 | 사용 금지됨 | 4.12 이상 릴리스에서 필수 항목 |

|

| 사용 금지됨 | 사용 금지됨 | 필수 항목 |

|

| 사용 금지됨 | 사용 금지됨 | 4.12 이상 릴리스에서 필수 항목 |

(*) 시스템 네트워크 CIDR의 자동 할당은 단일 호스트 네트워크만 있는 경우 수행됩니다. 그렇지 않으면 명시적으로 지정해야 합니다.

10.1.5. Air-gapped 환경

인터넷 액세스없이 클러스터를 배포하기 위한 워크플로에는 이 문서에서 다루지 않는 몇 가지 사전 요구 사항이 있습니다. 일부 인사이트를 위해 Git 리포지토리를 하드 방식으로 프로비저닝한 제로 터치 프로비저닝 을 참조할 수 있습니다.

10.2. VIP DHCP 할당

VIP DHCP 할당은 사용자가 DHCP 서버에서 해당 IP 주소를 자동으로 할당하는 기능을 활용하여 API 및 Ingress에 대한 가상 IP를 수동으로 제공하는 요구 사항을 건너뛸 수 있는 기능입니다.

클러스터 구성에서 api_vips 및 ingress_vips 를 사용하는 대신 기능을 활성화하면 서비스에서 리스 할당 요청을 보내고 회신에 따라 VIP를 적절하게 사용합니다. 서비스는 Machine Network에서 IP 주소를 할당합니다.

이는 OpenShift Container Platform 기능이 아니며 구성을 더 쉽게 지원하기 위해 지원 서비스로 구현되었습니다.

VIP DHCP 할당은 현재 OpenShift Container Platform SDN 네트워크 유형으로 제한됩니다. OpenShift Container Platform 버전 4.15 이상에서는 SDN이 지원되지 않습니다. 따라서 VIP DHCP 할당 지원도 OpenShift Container Platform 4.15 이상에서 종료됩니다.

10.2.1. 자동 할당을 활성화하는 페이로드 예

---

{

"vip_dhcp_allocation": true,

"network_type": "OVNKubernetes",

"user_managed_networking": false,

"cluster_networks": [

{

"cidr": "10.128.0.0/14",

"host_prefix": 23

}

],

"service_networks": [

{

"cidr": "172.30.0.0/16"

}

],

"machine_networks": [

{

"cidr": "192.168.127.0/24"

}

]

}

---10.2.2. 자동 할당을 비활성화하는 페이로드 예

---

{

"api_vips": [

{

"ip": "192.168.127.100"

}

],

"ingress_vips": [

{

"ip": "192.168.127.101"

}

],

"vip_dhcp_allocation": false,

"network_type": "OVNKubernetes",

"user_managed_networking": false,

"cluster_networks": [

{

"cidr": "10.128.0.0/14",

"host_prefix": 23

}

],

"service_networks": [

{

"cidr": "172.30.0.0/16"

}

]

}

---10.3. 추가 리소스

- 베어 메탈 IPI 설명서에서 는 VIP 주소 구문에 대한 추가 설명을 제공합니다.

10.4. 사용자 및 클러스터 관리 네트워킹 간의 차이점 이해

사용자 관리 네트워킹은 비표준 네트워크 토폴로지를 사용하는 고객이 OpenShift Container Platform 클러스터를 배포할 수 있는 지원 설치 관리자의 기능입니다. 예를 들면 다음과 같습니다.

-

VIP 주소를 처리하기 위해

keepalived및 VRRP를 사용하지 않으려는 외부 로드 밸런서가 있는 고객. - 다양한 L2 네트워크 세그먼트에 분산된 클러스터 노드가 있는 배포.

10.4.1. 검증

설치를 시작하기 전에 지원 설치 프로그램에서 다양한 네트워크 검증이 발생합니다. 사용자 관리 네트워킹을 활성화하면 다음 검증이 변경됩니다.

- L3 연결 검사(ICMP)는 L2 검사(ARP) 대신 수행됩니다.

10.5. 정적 네트워크 구성

검색 ISO를 생성하거나 업데이트할 때 정적 네트워크 구성을 사용할 수 있습니다.

10.5.1. 사전 요구 사항

- NMState 에 대해 잘 알고 있습니다.

10.5.2. NMState 구성

YAML 형식의 NMState 파일은 호스트에 대해 원하는 네트워크 구성을 지정합니다. 검색 시 인터페이스의 실제 이름으로 대체될 인터페이스의 논리적 이름이 있습니다.

10.5.2.1. NMState 구성 예

---

dns-resolver:

config:

server:

- 192.168.126.1

interfaces:

- ipv4:

address:

- ip: 192.168.126.30

prefix-length: 24

dhcp: false

enabled: true

name: eth0

state: up

type: ethernet

- ipv4:

address:

- ip: 192.168.141.30

prefix-length: 24

dhcp: false

enabled: true

name: eth1

state: up

type: ethernet

routes:

config:

- destination: 0.0.0.0/0

next-hop-address: 192.168.126.1

next-hop-interface: eth0

table-id: 254

---10.5.3. MAC 인터페이스 매핑

MAC 인터페이스 맵은 NMState 구성에 정의된 논리 인터페이스를 호스트에 있는 실제 인터페이스로 매핑하는 속성입니다.

매핑은 항상 호스트에 있는 물리적 인터페이스를 사용해야 합니다. 예를 들어 NMState 구성이 본딩 또는 VLAN을 정의하는 경우 매핑에는 상위 인터페이스에 대한 항목만 포함되어야 합니다.

10.5.3.1. MAC 인터페이스 매핑의 예

---

mac_interface_map: [

{

mac_address: 02:00:00:2c:23:a5,

logical_nic_name: eth0

},

{

mac_address: 02:00:00:68:73:dc,

logical_nic_name: eth1

}

]

---10.5.4. 추가 NMState 구성 예

아래 예제는 부분적인 구성만 표시합니다. 현재와 같이 사용할 필요는 없으며 항상 사용할 환경에 맞게 조정해야 합니다. 잘못 사용하는 경우 네트워크 연결이 없는 머신을 남겨 둘 수 있습니다.

10.5.4.1. 태그된 VLAN

---

interfaces:

- ipv4:

address:

- ip: 192.168.143.15

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

name: eth0.404

state: up

type: vlan

vlan:

base-iface: eth0

id: 404

reorder-headers: true

---10.5.4.2. 네트워크 본딩

---

interfaces:

- ipv4:

address:

- ip: 192.168.138.15

prefix-length: 24

dhcp: false

enabled: true

ipv6:

enabled: false

link-aggregation:

mode: active-backup

options:

all_slaves_active: delivered

miimon: "140"

slaves:

- eth0

- eth1

name: bond0

state: up

type: bond

---10.6. API를 사용하여 정적 네트워크 구성 적용

지원 설치 프로그램 API를 사용하여 정적 네트워크 구성을 적용할 수 있습니다.

사전 요구 사항

- API를 사용하여 인프라 환경을 생성했거나 UI를 사용하여 클러스터를 생성했습니다.

-

쉘에서 인프라 환경 ID를

$INFRA_ENV_ID로 내보내야 합니다. -

API에 액세스할 때 사용할 인증 정보가 있으며 쉘에서

$API_TOKEN으로 토큰을 내보냈습니다. -

정적 네트워크 구성을

server-a.yaml및server-b.yaml로 사용할 수 있는 YAML 파일이 있습니다.

프로세스

API 요청을 사용하여 임시 파일