教程

Red Hat OpenShift Service on AWS 指南

摘要

第 1 章 教程概述

红帽专家逐步教程,以帮助您充分利用受管 OpenShift 集群。

为了快速提供此云专家教程内容,可能还没有在每个支持的配置中进行测试。

第 2 章 教程:使用 HCP 激活和帐户链接的 ROSA

本教程介绍了在部署第一个集群前,使用托管的 control plane (HCP)激活 Red Hat OpenShift Service on AWS (ROSA)和链接到 AWS 帐户的过程。

如果您收到产品的私有产品,请确保按照本教程前提供私有提供的说明进行操作。私有产品在产品已激活时(替换有效订阅或首次激活时)被设计。

2.1. 前提条件

- 确保登录到您计划与在前面的步骤中激活 ROSA 和 HCP 的 AWS 帐户关联的红帽帐户。

- 只能将用于服务账单的 AWS 帐户与红帽帐户相关联。通常,具有其他 AWS 帐户(如开发人员帐户)的机构 AWS 帐户通常是被计费的,而不是单独的 AWS 最终用户帐户。

- 属于同一红帽机构的红帽帐户将与同一 AWS 帐户相关联。因此,您可以管理谁有权使用红帽机构帐户级别使用 HCP 集群创建 ROSA。

2.2. 订阅启用和 AWS 帐户设置

点 Get started 按钮在 AWS 控制台页面中使用 HCP 产品激活 ROSA:

如果您在完成此过程前已激活了 ROSA,您可以点该按钮并完成帐户链接,如以下步骤所述。

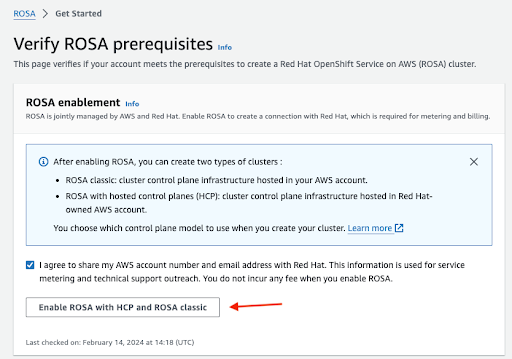

确认您希望与红帽共享联系信息并启用该服务:

- 在此步骤中启用该服务不会收取。该连接是为在部署第一个集群后发生的计费和计量。这可能需要几分钟时间。

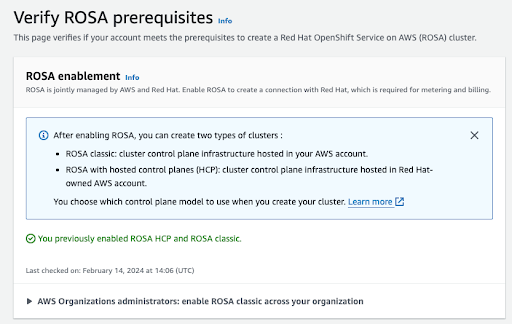

过程完成后,您将看到确认:

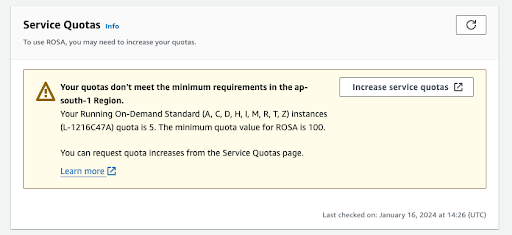

此验证页面中的其他部分显示额外先决条件的状态。如果没有满足任何这些先决条件,则会显示相应的信息。以下是所选区域中配额不足的示例:

- 单击 增加服务配额 按钮,或使用 了解更多 链接来获取有关如何管理服务配额的更多信息。如果配额不足,请注意配额是特定于区域的。您可以使用 web 控制台右上角的 region switcher 来重新运行您感兴趣的任何区域的配额检查,然后根据需要提交服务配额增加请求。

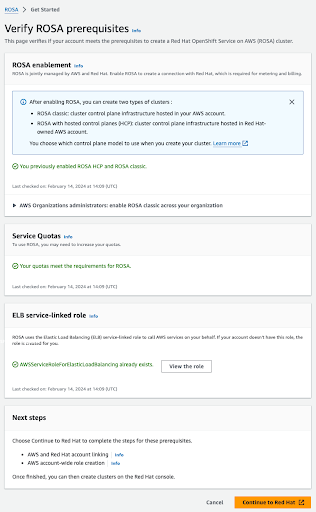

如果满足所有先决条件,页面将类似如下:

自动为您创建 ELB 服务链接的角色。您可以单击任何小的 Info blue 链接来获取上下文帮助和资源。

2.3. AWS 和红帽帐户和订阅链接

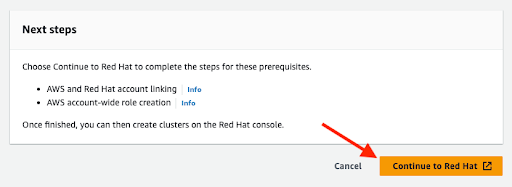

点 orange Continue to Red Hat 按钮继续帐户链接:

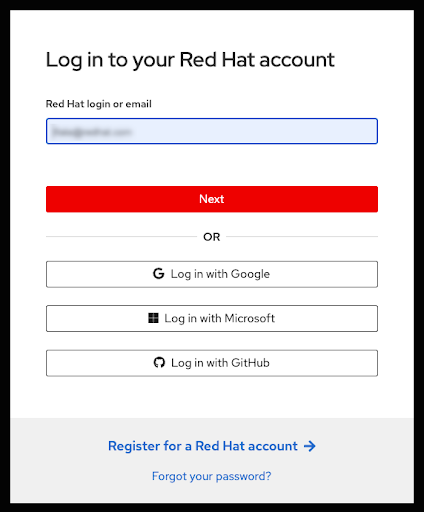

如果您还没有在当前浏览器的会话中登录到您的红帽帐户,则会要求您登录到您的帐户:

- 您还可以注册新的红帽帐户或在此页面中重置密码。

- 确保登录到您计划与在前面的步骤中激活 ROSA 和 HCP 的 AWS 帐户关联的红帽帐户。

- 只能将用于服务账单的 AWS 帐户与红帽帐户相关联。通常,具有其他 AWS 帐户(如开发人员帐户)的机构 AWS 帐户通常是被计费的,而不是单独的 AWS 最终用户帐户。

- 属于同一红帽机构的红帽帐户将与同一 AWS 帐户相关联。因此,您可以管理谁有权使用红帽机构帐户级别使用 HCP 集群创建 ROSA。

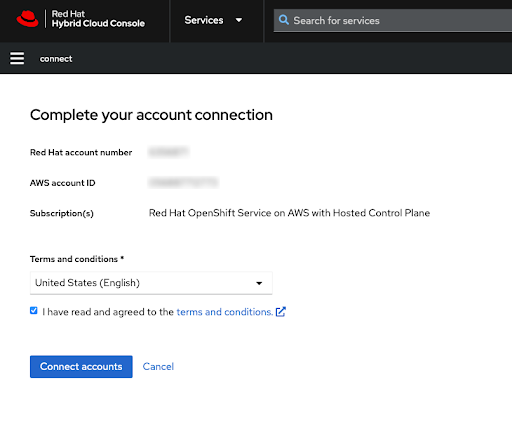

查看条款和条件后完成红帽帐户链接:

注意只有在已登录的红帽帐户或管理红帽帐户的红帽机构之前没有链接到 AWS 帐户时,才提供这个步骤。

此屏幕中会显示 Red Hat 和 AWS 账户号。

如果您同意了服务条款,请单击" 连接帐户 "按钮。

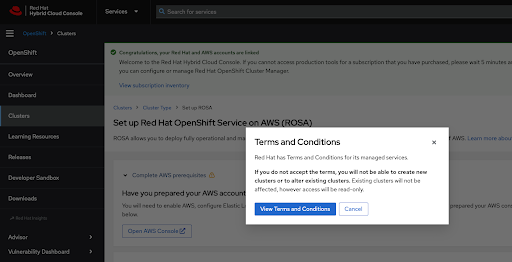

如果您是第一次使用 Red Hat Hybrid Cloud 控制台,在创建第一个 ROSA 集群前,您需要同意常规受管服务条款和条件:

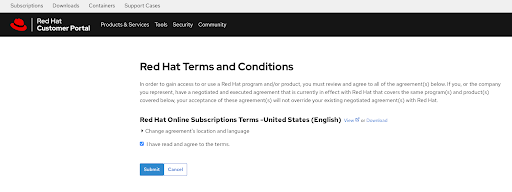

点 View Conditions 和 Conditions 按钮后会显示需要检查和接受的其他条款 :

在此时,您审核的任何其他条款后,提交您的协议。

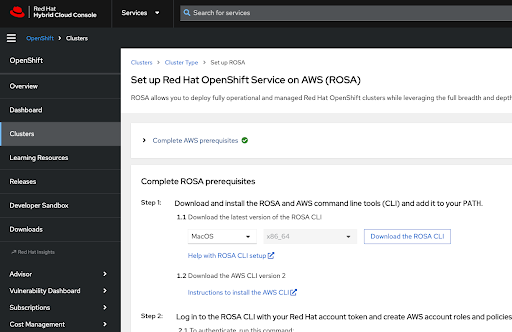

Hybrid Cloud Console 提供一个确认 AWS 的先决条件已完成,并列出了集群部署所需的第一步:

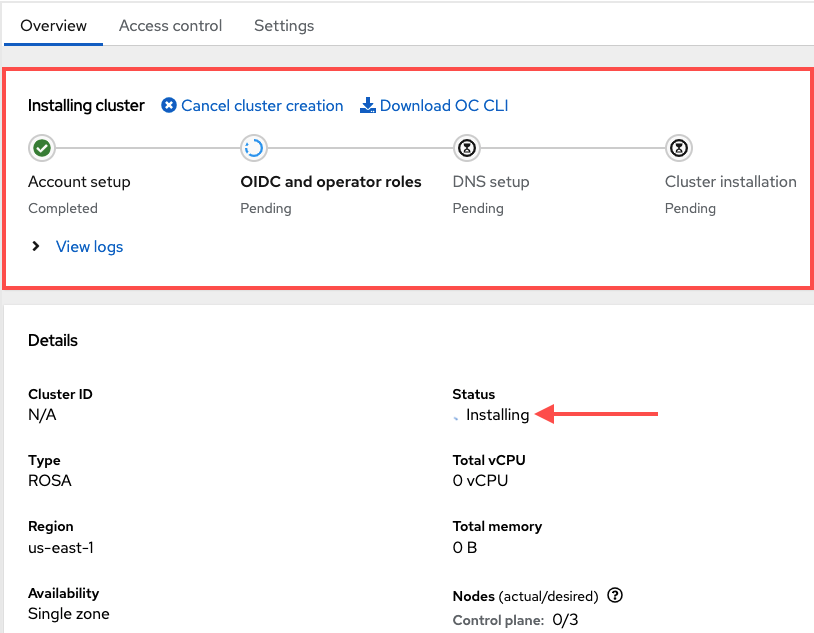

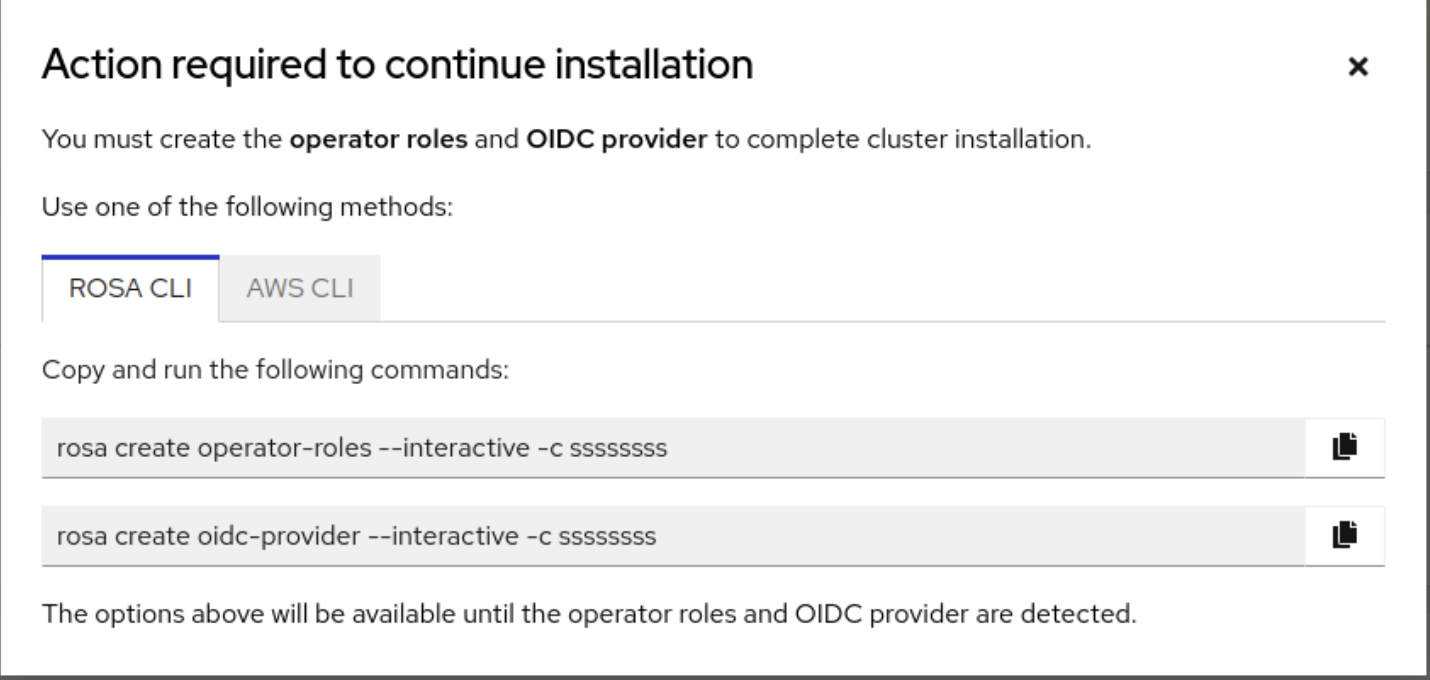

与集群的技术部署相关的以下步骤:

- 这些步骤可能在不同于服务启用和帐户链接完成的不同机器上执行。

如前文所述,任何属于红帽机构(属于激活 ROSA 服务的 AWS 帐户)的红帽帐户都可以访问创建集群,并可以选择之前在 Red Hat 机构下链接的账单 AWS 帐户。

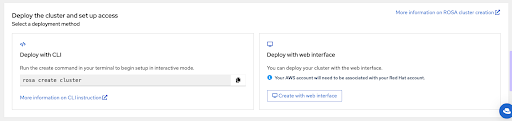

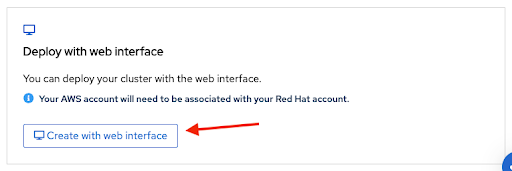

本页的最后一部分显示集群部署选项,可以使用

rosaCLI 或 Web 控制台:

-

以下步骤使用

rosaCLI 描述集群部署。 -

如果您只对使用 Web 控制台进行部署感兴趣,您可以使用 web 控制台部分跳过使用 HCP 集群部署的 ROSA。但请注意,某些任务需要

rosaCLI,如创建帐户角色。如果您要第一次部署 ROSA,请按照此 CLI 步骤操作,直到运行rosa whoami命令,然后再跳到 web 控制台部署步骤。

2.4. 使用 CLI 使用 HCP 集群部署的 ROSA

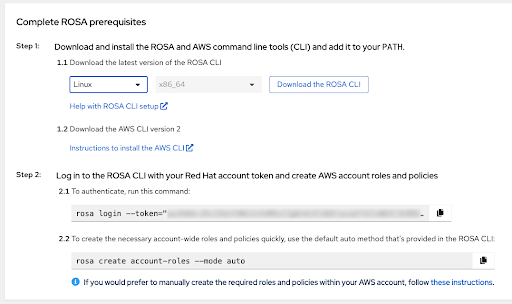

点 Download the ROSA CLI 按钮下载您的操作系统的 ROSA 命令行界面(CLI),并设置它,如使用 ROSA CLI 设置的帮助 中所述。

重要确保安装了最新的 AWS CLI。如需更多信息,请参阅安装 AWS CLI。

-

完成前面的步骤后,您可以通过运行

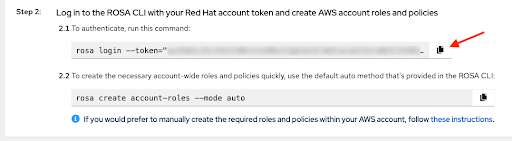

rosa 版本来验证两个 CLI 都可用。如果您在终端中使用旧版本和aws -version命令,这个命令会显示更新通知。 使用 HCP 集群创建 ROSA 的先决条件是通过个人化命令使用

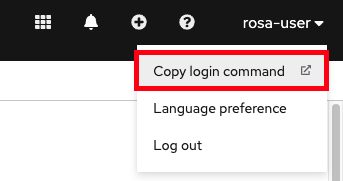

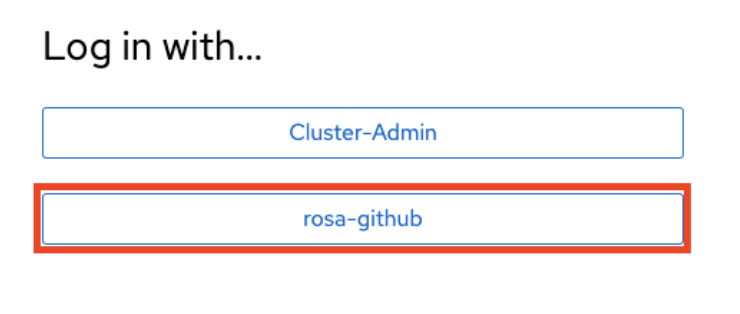

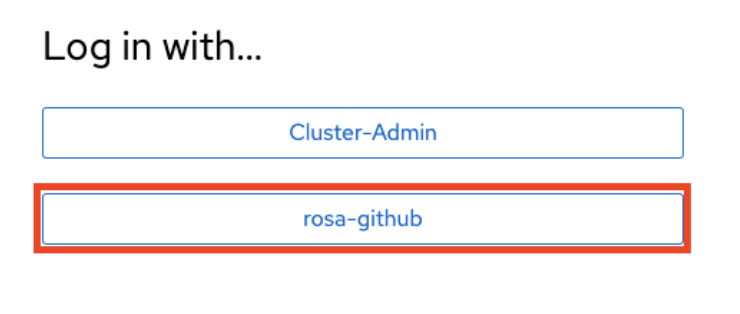

rosacli 登录,并在第 2.1 步中显示的唯一令牌。要进行身份验证,请在 web 控制台中运行这个命令。使用 复制 按钮轻松复制和粘贴带有完整令牌的命令:

不要共享您的唯一令牌。

-

在第一个集群部署前的最后一个先决条件,确保创建了必要的集群范围的角色和策略。

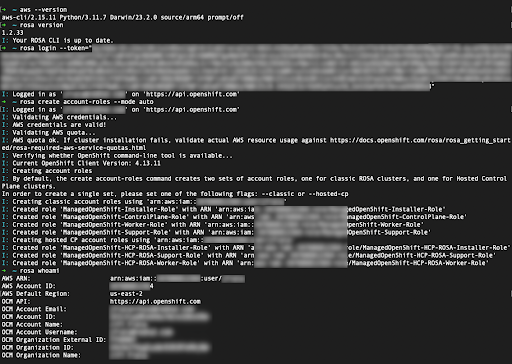

rosaCLI 可以使用第 2.2 步下显示的命令来解决此问题。在 web 控制台中快速创建必要的集群范围的角色和策略…。手动创建这些角色和策略的替代选择。 登录后,创建帐户角色并使用

rosa whoami命令验证您的身份,您的终端将类似如下:

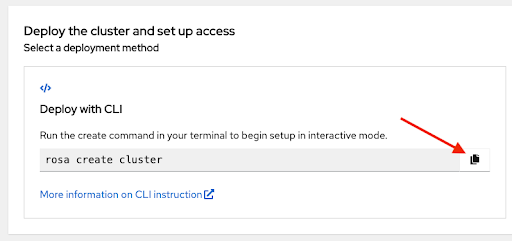

使用提供的命令启动集群部署。您可以再次点 复制 按钮,并在终端中粘贴命令:

-

要使用自定义 AWS 配置集,在

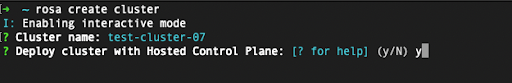

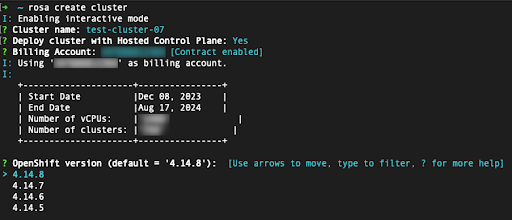

~/.aws/credentials中指定的非默认配置集之一,您可以将-profile <profile_name>选择器添加到 rosa create cluster 命令中,以便命令类似 rosa create cluster-profile stage。如果没有使用这个选项指定 AWS CLI 配置集,则默认 AWS CLI 配置集将决定集群部署到的 AWS 基础架构配置集。账单 AWS 配置集在以下步骤之一中选择。 输入集群名称后,将要求您使用托管的 control plane。选择 yes :

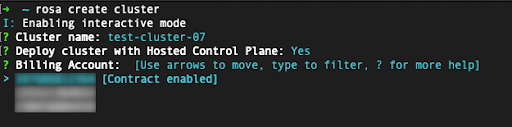

当使用 HCP 集群部署 ROSA 时,需要指定计费 AWS 帐户:

- 只有链接到当前使用的红帽机构的 AWS 帐户才会显示。

- 指定 AWS 帐户将使用 ROSA 服务,无论基础架构 AWS 帐户是否在同一 AWS 机构中链接到它。

- 您可以看到是否为给定的 AWS 计费帐户启用 ROSA 合同的指标。

- 要选择没有启用合同的 AWS 帐户,请参阅本教程中的前几个步骤来启用合同,并允许服务计费,这是成功集群部署所需的。

在以下步骤中,您将指定要部署的集群的技术详情:

- 这些步骤超出了本教程的范围。如需有关如何使用 CLI 完成使用 HCP 集群部署的 ROSA 的详情,请参阅使用默认选项 创建 ROSA。

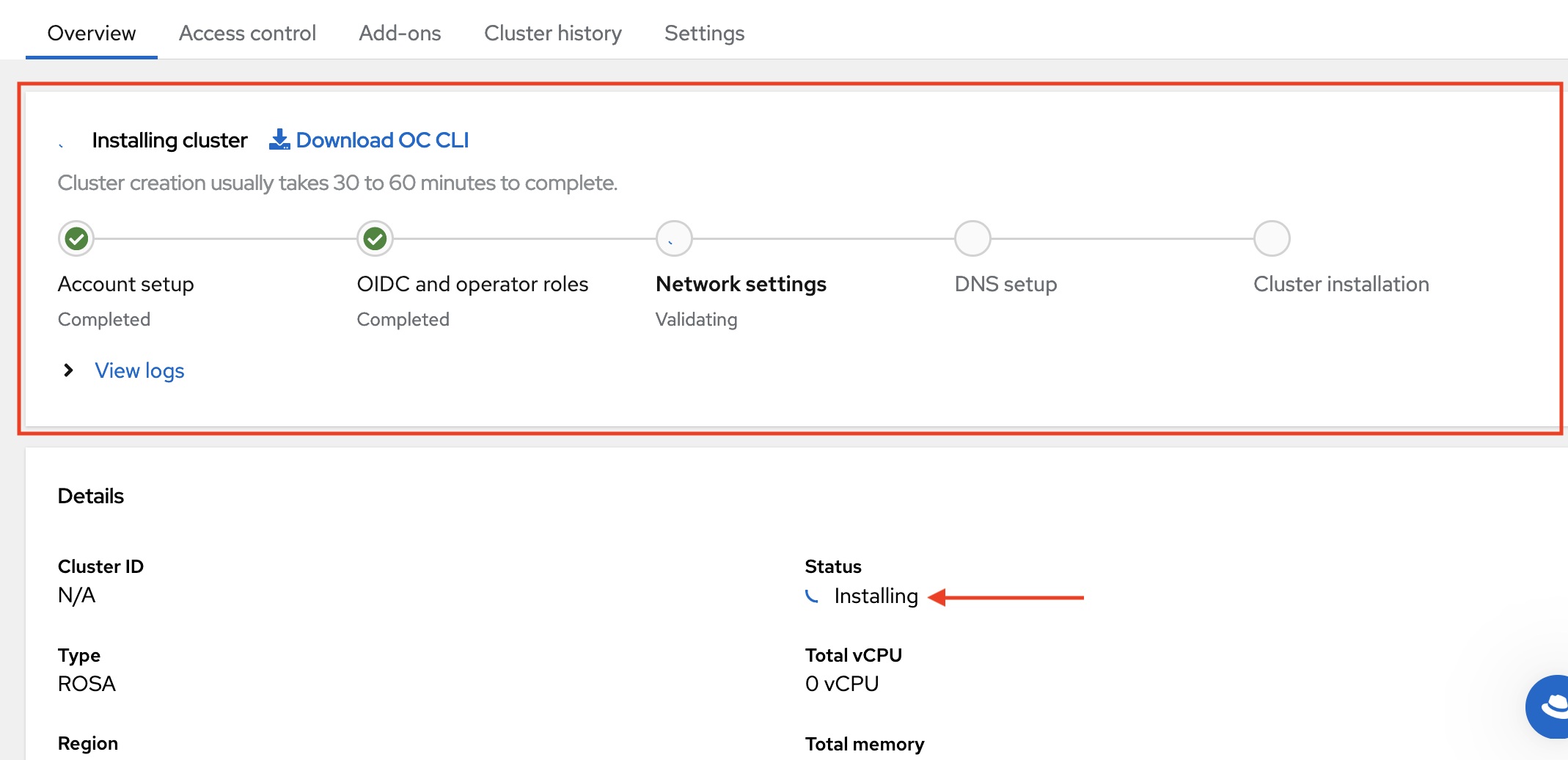

2.5. 使用 web 控制台使用 HCP 集群部署的 ROSA

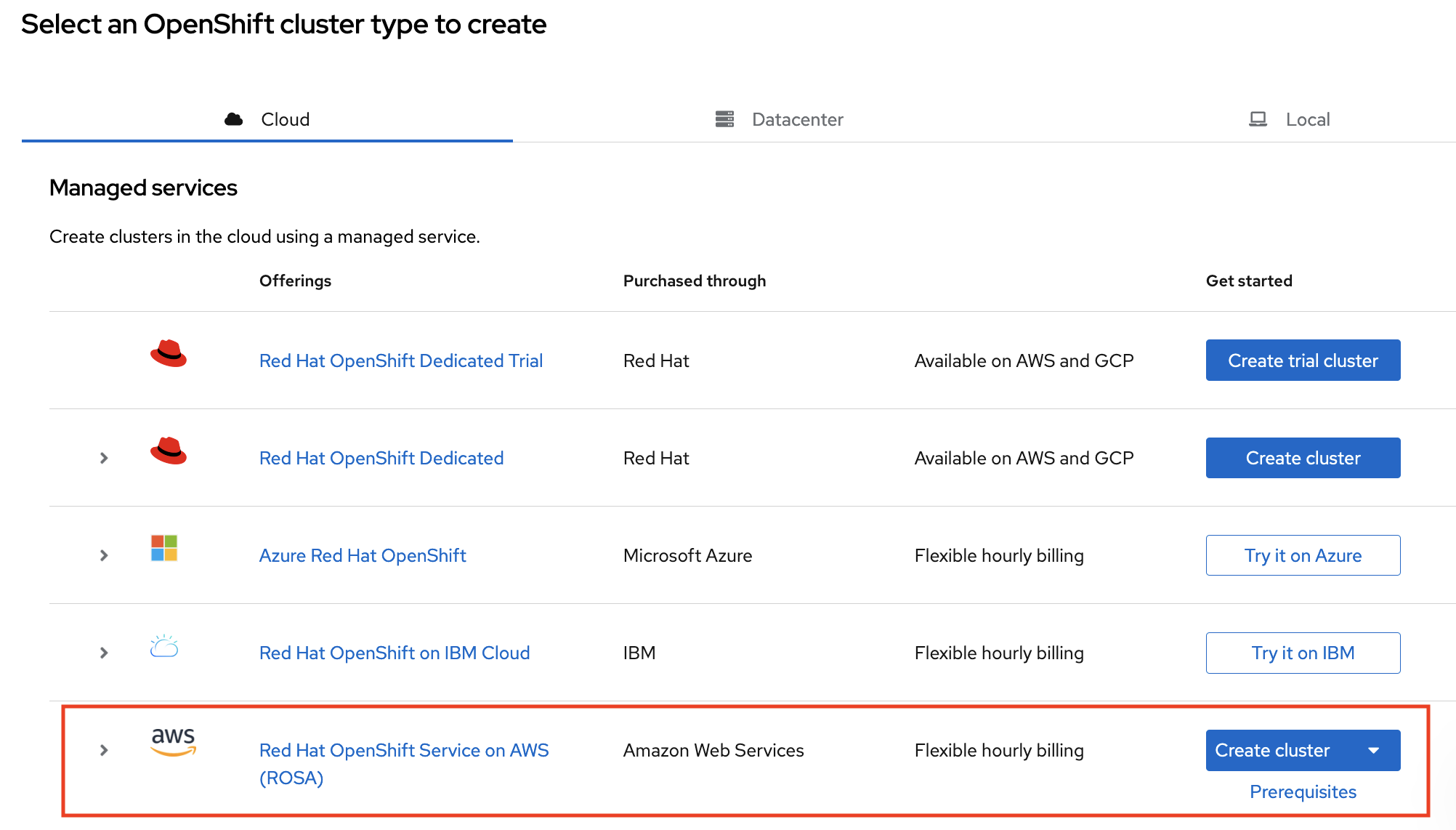

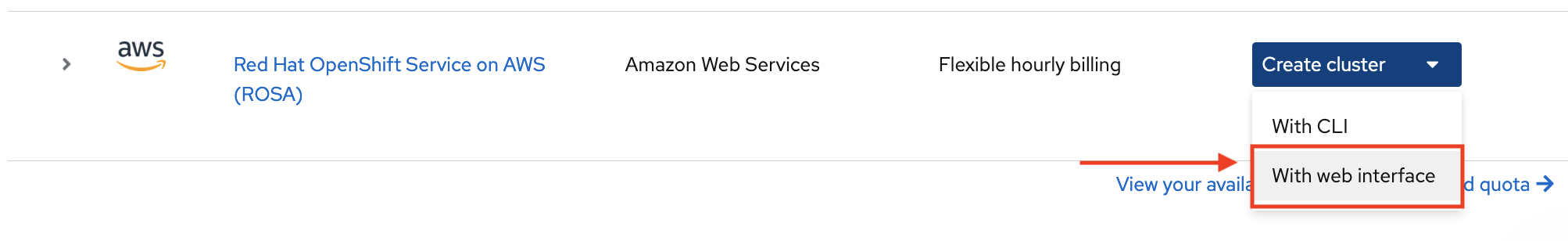

通过选择简介 设置 ROSA 页面底部部分中的第二个选项,可以使用 Web 控制台创建集群:

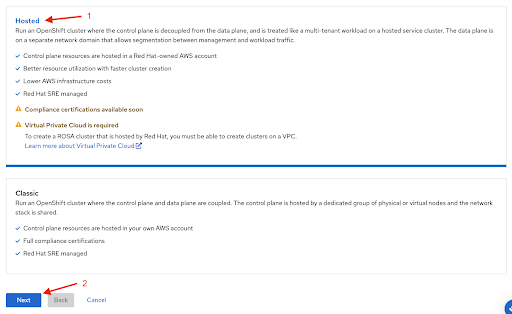

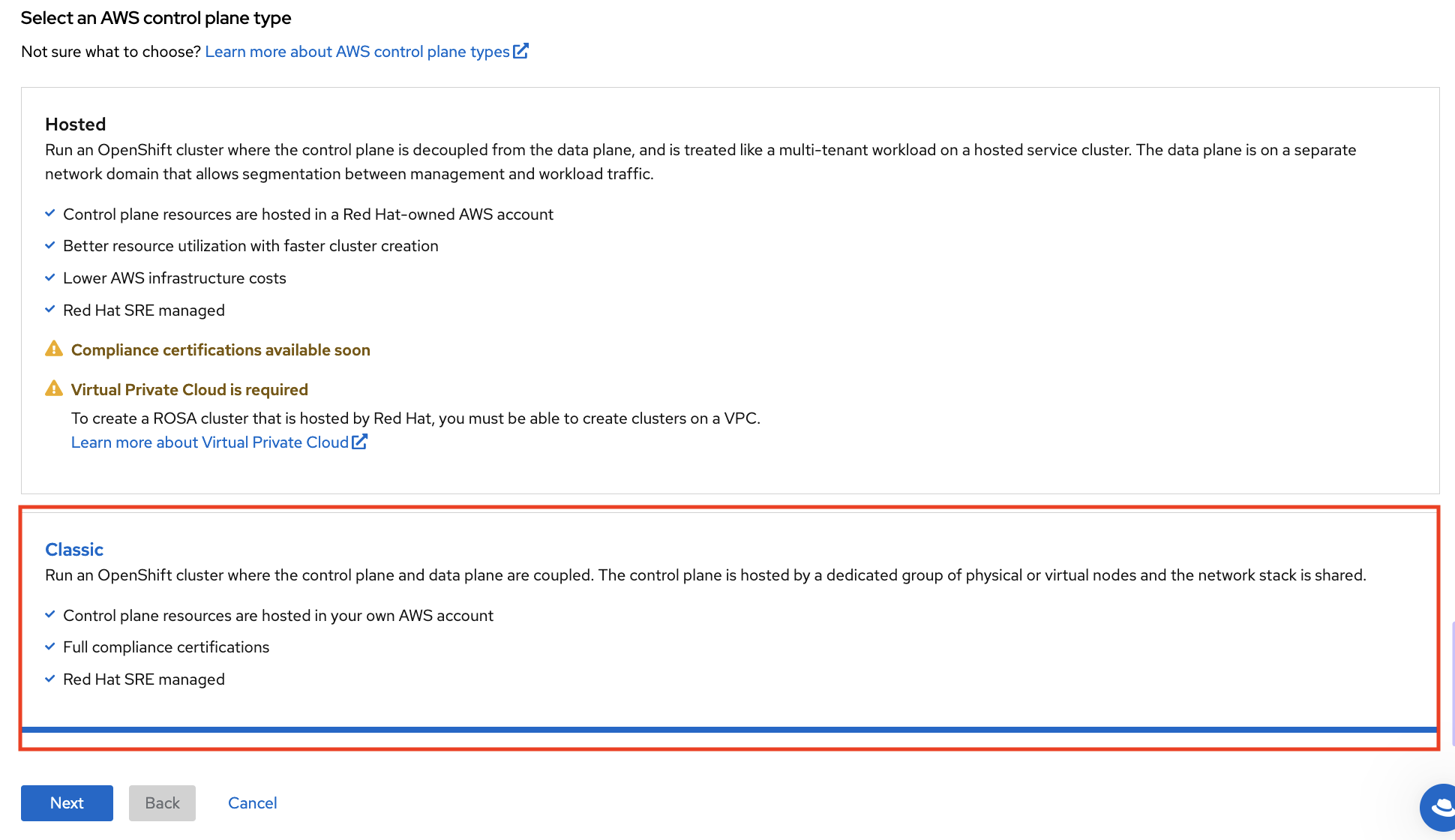

使用 Web 控制台创建 ROSA 集群时的第一步是选择 control plane。在点 Next 按钮前,请确定选择了 Hosted 选项:

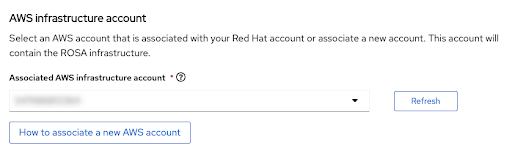

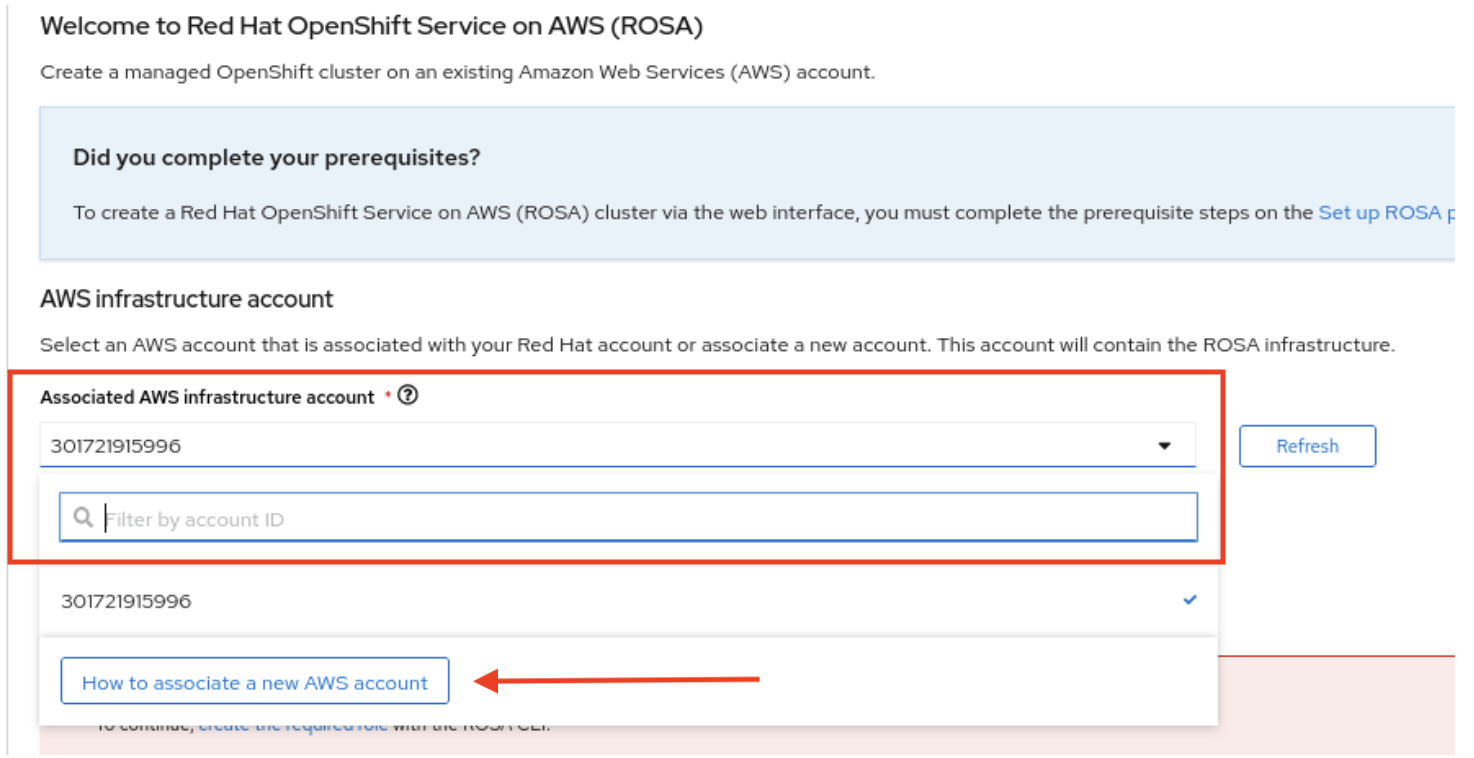

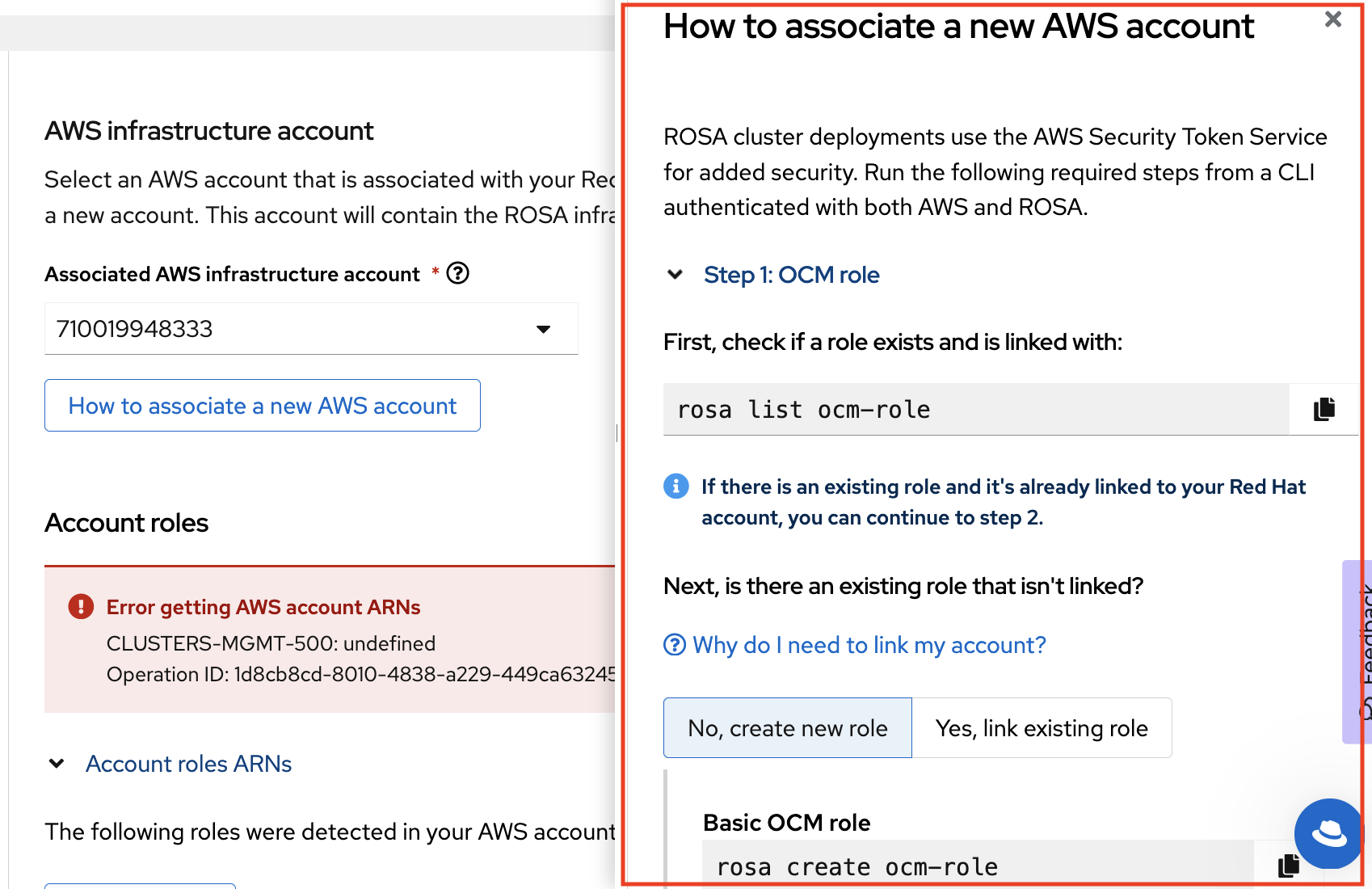

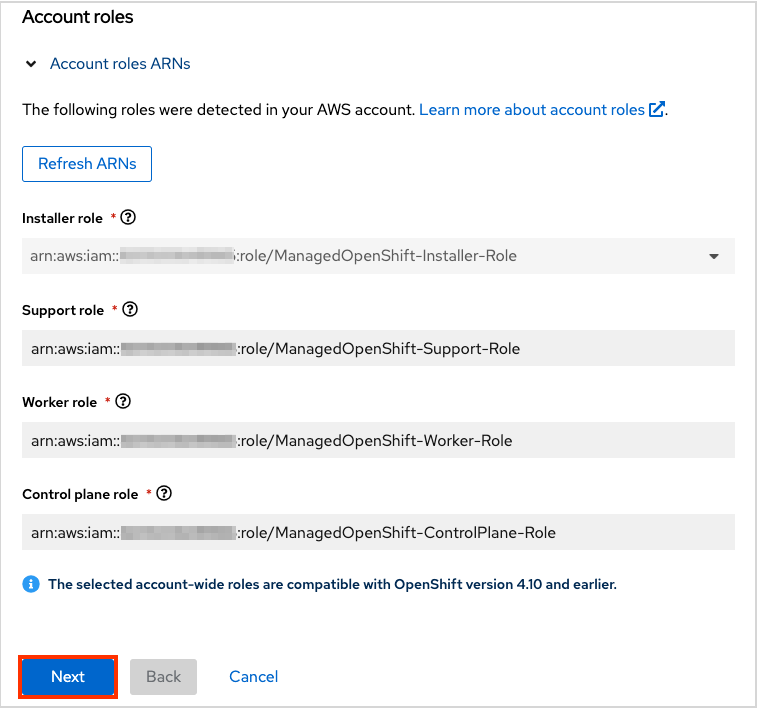

下一步帐户和 角色 允许您指定基础架构 AWS 帐户,将部署到其中,以及资源将被消耗和管理的位置:

- 如果没有看到您要部署 ROSA 集群的帐户,点 How to associate a new AWS account,以了解有关如何为此关联创建或链接帐户角色的详细信息。

-

rosaCLI 用于此目的。 -

如果您使用多个 AWS 帐户,并为 AWS CLI 配置其配置集,您可以在使用

rosaCLI 命令时使用--profile选择器来指定 AWS 配置集。

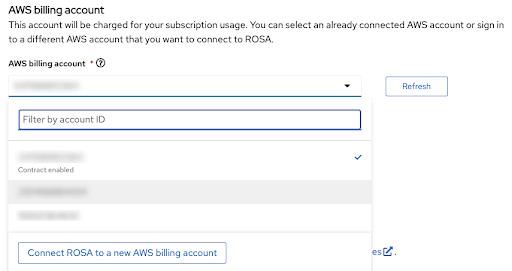

账单 AWS 帐户在以下部分中选择:

- 只有链接到当前使用的红帽机构的 AWS 帐户才会显示。

- 指定 AWS 帐户将使用 ROSA 服务,无论基础架构 AWS 帐户是否在同一 AWS 机构中链接到它。

- 您可以看到是否为给定的 AWS 计费帐户启用 ROSA 合同的指示器。

- 如果您要使用尚未启用合同的 AWS 帐户,您可以使用 Connect ROSA to a new AWS billing 帐户 来访问 ROSA AWS 控制台页面,您可以在其中按照本教程中描述的步骤使用相应 AWS 帐户登录后激活它。

以下步骤粘贴账单 AWS 帐户选择超出了本教程的范围。

其他资源

- 有关使用 CLI 创建集群的详情,请参考使用 CLI 使用 HCP 集群创建 ROSA。

- 有关如何使用 Web 控制台完成 ROSA 集群部署的详情,请参阅此学习路径。

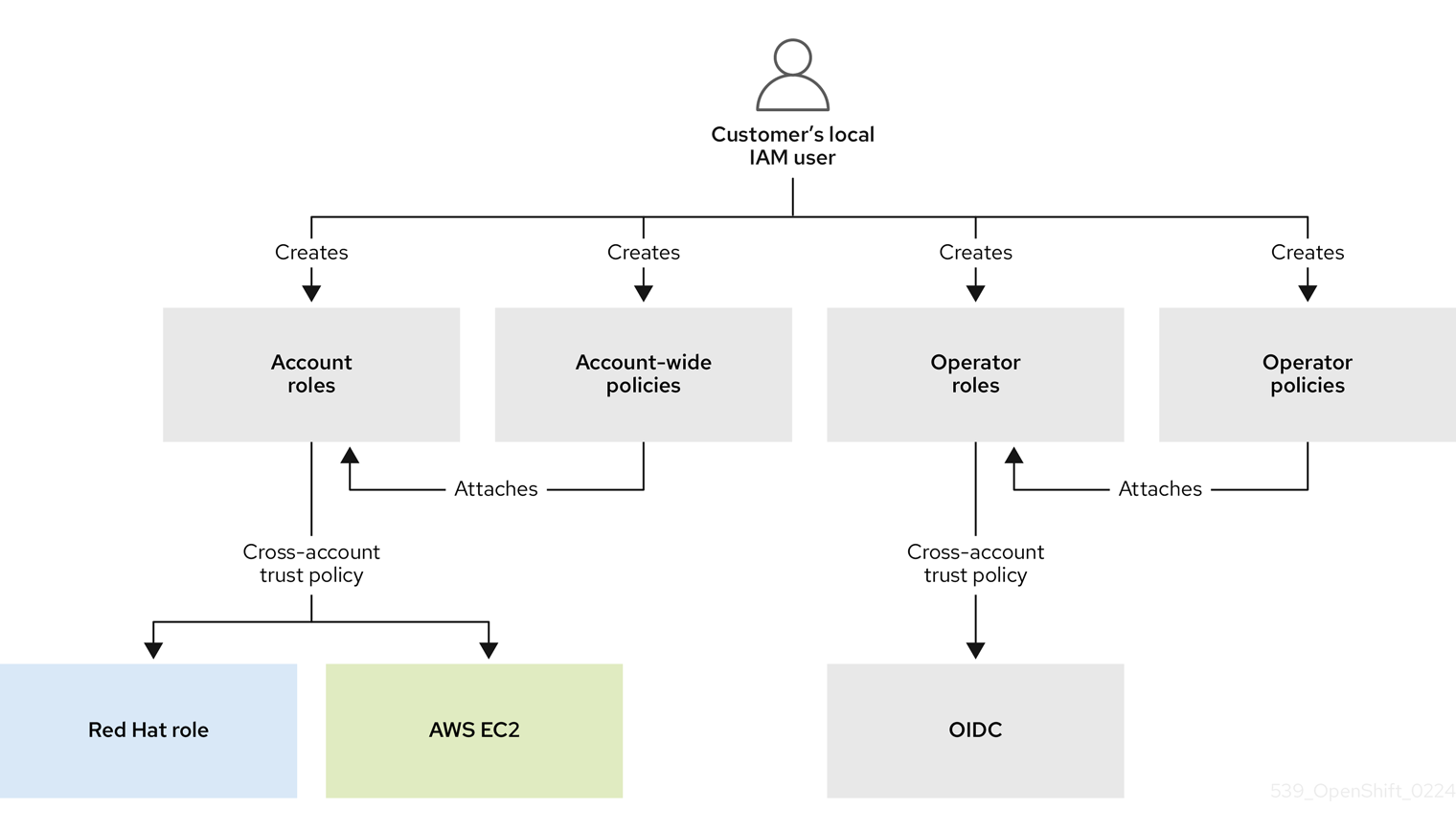

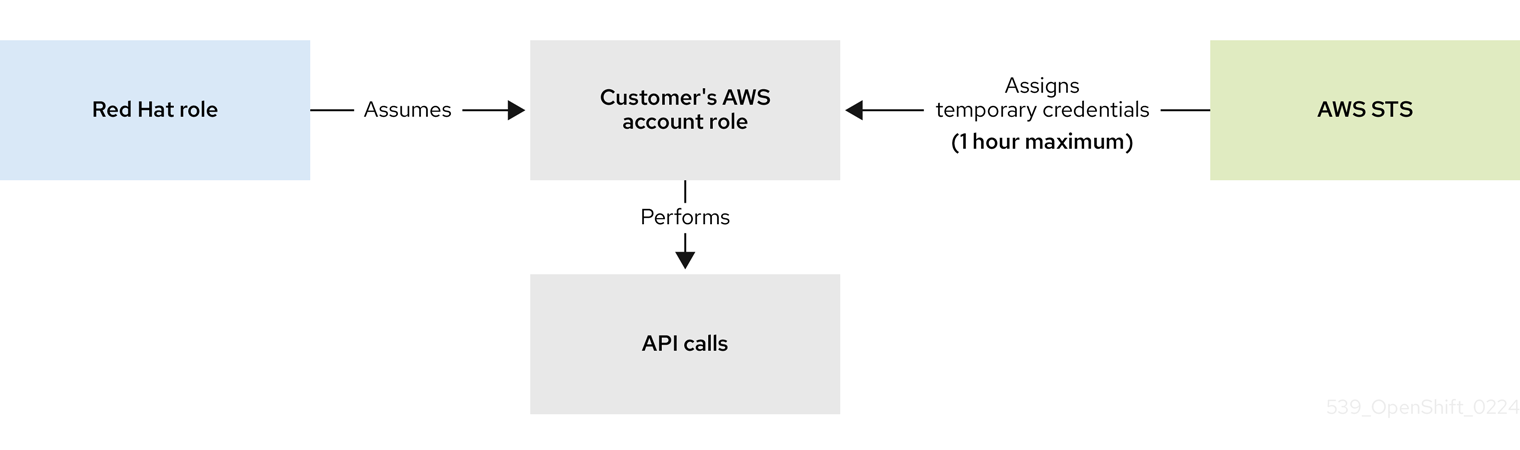

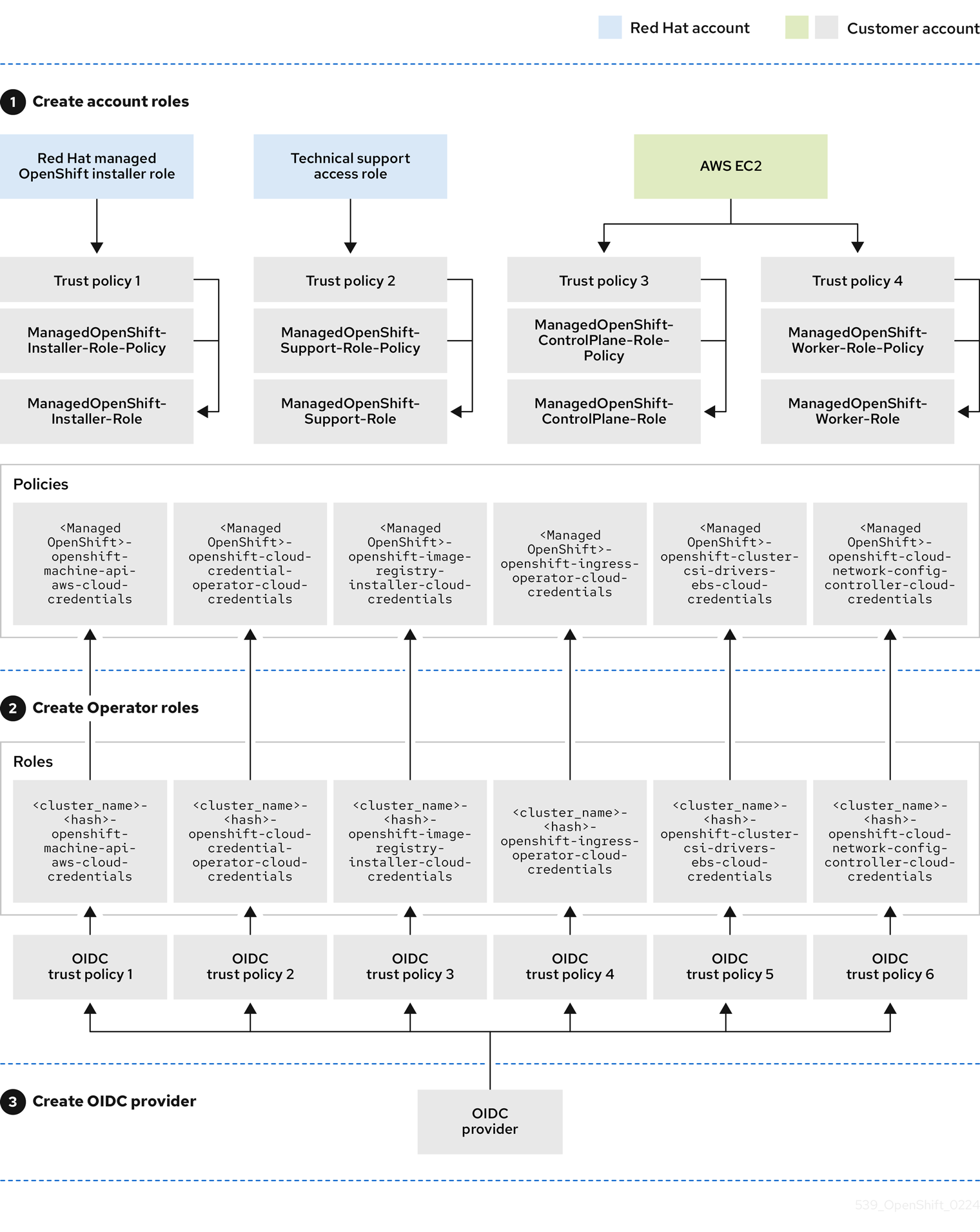

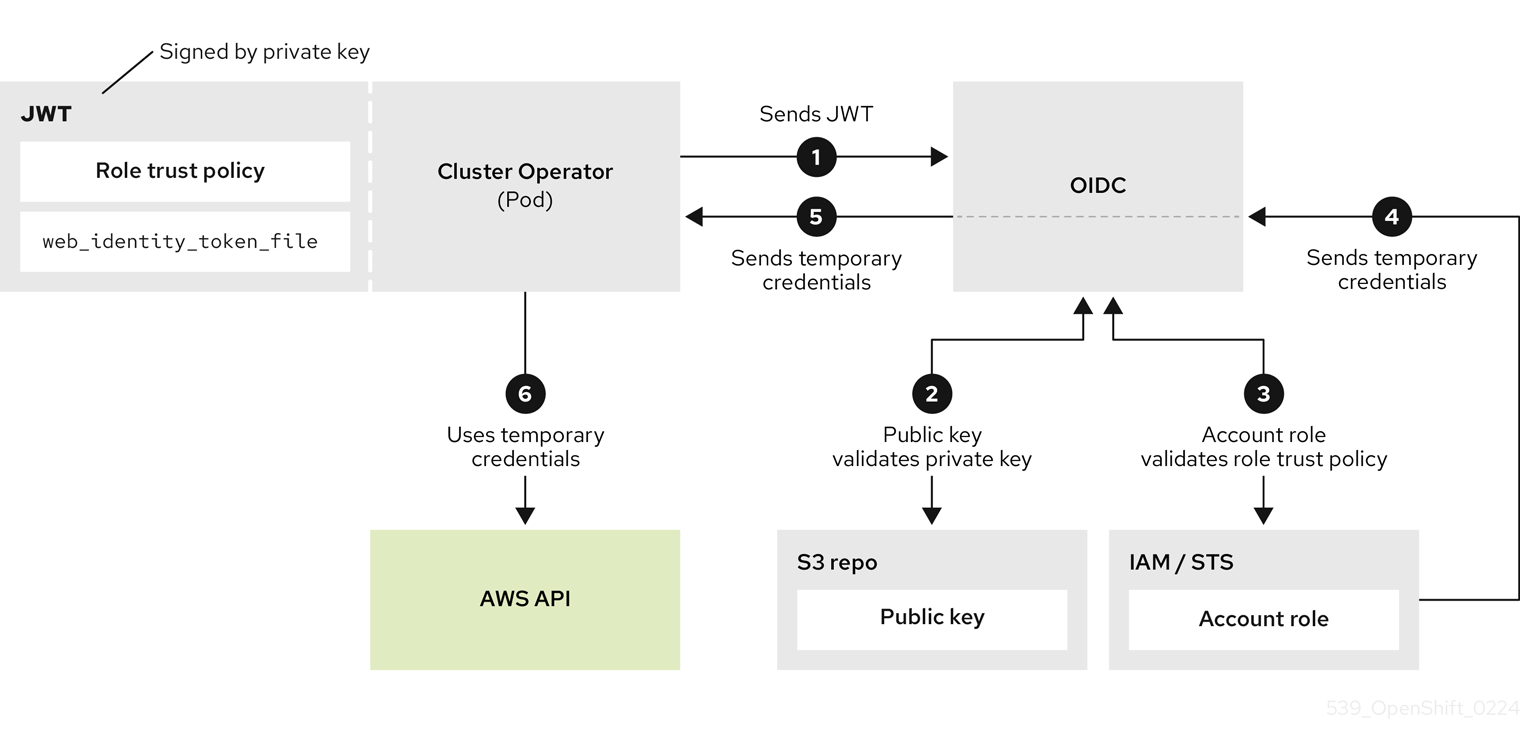

第 3 章 教程:验证 ROSA STS 部署的权限

要继续部署 ROSA 集群,帐户必须支持所需的角色和权限。AWS Service Control Policies (SCP)无法阻止安装程序或 Operator 角色发出的 API 调用。

有关启用了 STS 的安装所需的 IAM 资源的详情,请参考: 关于使用 STS 的 ROSA 集群的 IAM 资源

本指南针对 ROSA v4.11.X 验证。

3.1. 前提条件

- AWS CLI

- ROSA CLI v1.2.6

- jq CLI

- 具有所需权限的 AWS 角色

3.2. 验证 ROSA 权限

要验证 ROSA 所需的权限,我们可以运行以下部分中包含的脚本,而无需创建任何 AWS 资源。

脚本使用 rosa、aws 和 jq CLI 命令在工作目录中创建文件,这些文件将用于验证连接到当前 AWS 配置的帐户中的权限。

AWS Policy Simulator 用于根据由 jq 提取的 API 调用验证每个角色策略的权限;然后,结果会存储在附加 .results 的文本文件中。

此脚本旨在验证当前帐户和地区的权限。

3.3. 使用说明

要使用该脚本,请在

bash终端中运行以下命令( -p 选项定义角色的前缀):$ mkdir scratch $ cd scratch $ cat << 'EOF' > verify-permissions.sh #!/bin/bash while getopts 'p:' OPTION; do case "$OPTION" in p) PREFIX="$OPTARG" ;; ?) echo "script usage: $(basename \$0) [-p PREFIX]" >&2 exit 1 ;; esac done shift "$(($OPTIND -1))" rosa create account-roles --mode manual --prefix $PREFIX INSTALLER_POLICY=$(cat sts_installer_permission_policy.json | jq ) CONTROL_PLANE_POLICY=$(cat sts_instance_controlplane_permission_policy.json | jq) WORKER_POLICY=$(cat sts_instance_worker_permission_policy.json | jq) SUPPORT_POLICY=$(cat sts_support_permission_policy.json | jq) simulatePolicy () { outputFile="${2}.results" echo $2 aws iam simulate-custom-policy --policy-input-list "$1" --action-names $(jq '.Statement | map(select(.Effect == "Allow"))[].Action | if type == "string" then . else .[] end' "$2" -r) --output text > $outputFile } simulatePolicy "$INSTALLER_POLICY" "sts_installer_permission_policy.json" simulatePolicy "$CONTROL_PLANE_POLICY" "sts_instance_controlplane_permission_policy.json" simulatePolicy "$WORKER_POLICY" "sts_instance_worker_permission_policy.json" simulatePolicy "$SUPPORT_POLICY" "sts_support_permission_policy.json" EOF $ chmod +x verify-permissions.sh $ ./verify-permissions.sh -p SimPolTest脚本完成后,查看每个结果文件以确保没有所需的 API 调用被阻止:

$ for file in $(ls *.results); do echo $file; cat $file; done

输出结果类似如下:

sts_installer_permission_policy.json.results EVALUATIONRESULTS autoscaling:DescribeAutoScalingGroups allowed * MATCHEDSTATEMENTS PolicyInputList.1 IAM Policy ENDPOSITION 6 195 STARTPOSITION 17 3 EVALUATIONRESULTS ec2:AllocateAddress allowed * MATCHEDSTATEMENTS PolicyInputList.1 IAM Policy ENDPOSITION 6 195 STARTPOSITION 17 3 EVALUATIONRESULTS ec2:AssociateAddress allowed * MATCHEDSTATEMENTS PolicyInputList.1 IAM Policy ...

注意如果阻止了任何操作,请查看 AWS 提供的错误,并咨询您的管理员来确定 SCP 是否阻断所需的 API 调用。

第 4 章 为 CloudWatch 日志和 STS 配置日志转发

使用此教程来部署 Red Hat OpenShift Logging Operator,并将其配置为使用安全令牌服务(STS)身份验证将日志转发到 CloudWatch。

前提条件

- Red Hat OpenShift Service on AWS (ROSA) Classic 集群

-

jq命令行界面(CLI) -

Amazon Web Services (AWS) CLI (

aws)

4.1. 设置您的环境

配置以下环境变量,将集群名称更改为适合您的集群:

注意必须已经以管理员身份登录。

$ export ROSA_CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(rosa describe cluster -c ${ROSA_CLUSTER_NAME} --output json | jq -r .region.id) $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o json | jq -r .spec.serviceAccountIssuer | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export AWS_PAGER="" $ export SCRATCH="/tmp/${ROSA_CLUSTER_NAME}/clf-cloudwatch-sts" $ mkdir -p ${SCRATCH}在移动到下一部分前,请确定所有字段都正确输出:

$ echo "Cluster: ${ROSA_CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

4.2. 准备 AWS 帐户

为日志记录创建 Identity Access Management (IAM)策略:

$ POLICY_ARN=$(aws iam list-policies --query "Policies[?PolicyName=='RosaCloudWatch'].{ARN:Arn}" --output text) $ if [[ -z "${POLICY_ARN}" ]]; then cat << EOF > ${SCRATCH}/policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "logs:CreateLogGroup", "logs:CreateLogStream", "logs:DescribeLogGroups", "logs:DescribeLogStreams", "logs:PutLogEvents", "logs:PutRetentionPolicy" ], "Resource": "arn:aws:logs:*:*:*" } ] } EOF POLICY_ARN=$(aws iam create-policy --policy-name "RosaCloudWatch" \ --policy-document file:///${SCRATCH}/policy.json --query Policy.Arn --output text) fi $ echo ${POLICY_ARN}为集群创建 IAM 角色信任策略:

$ cat <<EOF > ${SCRATCH}/trust-policy.json { "Version": "2012-10-17", "Statement": [{ "Effect": "Allow", "Principal": { "Federated": "arn:aws:iam::${AWS_ACCOUNT_ID}:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${OIDC_ENDPOINT}:sub": "system:serviceaccount:openshift-logging:logcollector" } } }] } EOF $ ROLE_ARN=$(aws iam create-role --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch" \ --assume-role-policy-document file://${SCRATCH}/trust-policy.json \ --query Role.Arn --output text) $ echo ${ROLE_ARN}将 IAM 策略附加到 IAM 角色:

$ aws iam attach-role-policy --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch" \ --policy-arn ${POLICY_ARN}

4.3. 部署 Operator

部署 Red Hat OpenShift Logging Operator:

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: labels: operators.coreos.com/cluster-logging.openshift-logging: "" name: cluster-logging namespace: openshift-logging spec: channel: stable installPlanApproval: Automatic name: cluster-logging source: redhat-operators sourceNamespace: openshift-marketplace EOF创建 secret:

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Secret metadata: name: cloudwatch-credentials namespace: openshift-logging stringData: role_arn: $ROLE_ARN EOF

4.4. 配置集群日志记录

创建

ClusterLogForwarder自定义资源(CR):$ cat << EOF | oc apply -f - apiVersion: "logging.openshift.io/v1" kind: ClusterLogForwarder metadata: name: instance namespace: openshift-logging spec: outputs: - name: cw type: cloudwatch cloudwatch: groupBy: namespaceName groupPrefix: rosa-${ROSA_CLUSTER_NAME} region: ${REGION} secret: name: cloudwatch-credentials pipelines: - name: to-cloudwatch inputRefs: - infrastructure - audit - application outputRefs: - cw EOF创建

ClusterLoggingCR:$ cat << EOF | oc apply -f - apiVersion: logging.openshift.io/v1 kind: ClusterLogging metadata: name: instance namespace: openshift-logging spec: collection: logs: type: vector managementState: Managed EOF

4.5. 检查 CloudWatch 的日志

使用 AWS 控制台或 AWS CLI 验证是否有来自集群的日志流。

要在 AWS CLI 中验证日志,请运行以下命令:

$ aws logs describe-log-groups --log-group-name-prefix rosa-${ROSA_CLUSTER_NAME}输出示例

{ "logGroups": [ { "logGroupName": "rosa-xxxx.audit", "creationTime": 1661286368369, "metricFilterCount": 0, "arn": "arn:aws:logs:us-east-2:xxxx:log-group:rosa-xxxx.audit:*", "storedBytes": 0 }, { "logGroupName": "rosa-xxxx.infrastructure", "creationTime": 1661286369821, "metricFilterCount": 0, "arn": "arn:aws:logs:us-east-2:xxxx:log-group:rosa-xxxx.infrastructure:*", "storedBytes": 0 } ] }注意如果这是新集群,您可能不会看到应用程序日志的日志组,因为应用程序还没有运行。

4.6. 清理资源

删除

ClusterLogForwarderCR:$ oc delete -n openshift-logging clusterlogforwarder instance

删除

ClusterLoggingCR:$ oc delete -n openshift-logging clusterlogging instance

将 IAM 策略分离到 IAM 角色:

$ aws iam detach-role-policy --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch" \ --policy-arn "${POLICY_ARN}"删除 IAM 角色:

$ aws iam delete-role --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch"删除 IAM 策略:

重要只有没有使用该策略的其他资源时,才删除 IAM 策略。

$ aws iam delete-policy --policy-arn "${POLICY_ARN}"删除 CloudWatch 日志组:

$ aws logs delete-log-group --log-group-name "rosa-${ROSA_CLUSTER_NAME}.audit" $ aws logs delete-log-group --log-group-name "rosa-${ROSA_CLUSTER_NAME}.infrastructure"

第 5 章 教程: 使用 AWS WAF 和 Amazon CloudFront 来保护 ROSA 工作负载

AWS WAF 是一个 web 应用程序防火墙,可让您监控转发到受保护的 web 应用程序资源的 HTTP 和 HTTPS 请求。

您可以使用 Amazon CloudFront 将 Web 应用程序防火墙(WAF)添加到 Red Hat OpenShift Service on AWS (ROSA)工作负载中。使用外部解决方案可防止 ROSA 资源因为处理 WAF 而导致拒绝服务。

5.1. 前提条件

- ROSA 经典集群。

-

您可以访问 OpenShift CLI(

oc)。 -

您可以访问 AWS CLI (

aws)。

5.1.1. 环境设置

准备环境变量:

$ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/cloudfront-waf" $ mkdir -p ${SCRATCH} $ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, AWS Account ID: ${AWS_ACCOUNT_ID}"

5.2. 自定义域设置

需要将二级入口控制器配置为将外部 WAF 保护的流量与标准(和默认)集群入口控制器进行分段。在 ROSA 中,我们使用 Custom Domain Operator 执行此操作。

前提条件

-

唯一的域,如 If

apps.<company_name>.io -

自定义 SAN 或通配符证书,如

CNcategories.apps.<company_name>.io

流程

创建新项目

$ oc new-project waf-demo

从私钥和公共证书创建一个新的 TLS secret,其中

fullchain.pem是您的完整的通配符证书链(包括任何中间人),privkey.pem是您的通配符证书的私钥。示例

$ oc -n waf-demo create secret tls waf-tls --cert=fullchain.pem --key=privkey.pem

创建新的

CustomDomain自定义资源(CR):waf-custom-domain.yaml示例apiVersion: managed.openshift.io/v1alpha1 kind: CustomDomain metadata: name: cloudfront-waf spec: domain: apps.<company_name>.io 1 scope: External loadBalancerType: NLB certificate: name: waf-tls namespace: waf-demo routeSelector: 2 matchLabels: route: waf

应用 CR:

示例

$ oc apply -f waf-custom-domain.yaml

验证您的自定义域入口控制器是否已部署并处于

Ready:$ oc get customdomains

输出示例

NAME ENDPOINT DOMAIN STATUS cloudfront-waf xxrywp.<company_name>.cluster-01.opln.s1.openshiftapps.com *.apps.<company_name>.io Ready

5.2.1. 配置 AWS WAF

AWS WAF 服务是一个 web 应用程序防火墙,可让您监控、保护和控制转发到受保护的 web 应用程序资源(如 ROSA)的 HTTP 和 HTTPS 请求。

创建 AWS WAF 规则文件以应用到我们的 Web ACL:

$ cat << EOF > ${SCRATCH}/waf-rules.json [ { "Name": "AWS-AWSManagedRulesCommonRuleSet", "Priority": 0, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesCommonRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesCommonRuleSet" } }, { "Name": "AWS-AWSManagedRulesSQLiRuleSet", "Priority": 1, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesSQLiRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesSQLiRuleSet" } } ] EOF这将启用 Core (Common)和 SQL AWS Managed Rule Sets。

使用上面指定的规则创建 AWS WAF Web ACL:

$ WAF_WACL=$(aws wafv2 create-web-acl \ --name cloudfront-waf \ --region ${REGION} \ --default-action Allow={} \ --scope CLOUDFRONT \ --visibility-config SampledRequestsEnabled=true,CloudWatchMetricsEnabled=true,MetricName=${CLUSTER_NAME}-waf-metrics \ --rules file://${SCRATCH}/waf-rules.json \ --query 'Summary.Name' \ --output text)

5.3. Configure Amazon CloudFront

检索新创建的自定义域入口控制器的 NLB 主机名:

$ NLB=$(oc -n openshift-ingress get service router-cloudfront-waf \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ echo "Origin domain: ${NLB}"将您的证书导入到 Amazon 证书管理器中,其中

cert.pem是您的通配符证书,fullchain.pem是您的通配符证书的链,privkey.pem是您的通配符证书的私钥。注意无论您部署了集群是什么,都必须将此证书导入到

us-east-1中,因为 Amazon CloudFront 都是全局 AWS 服务。示例

$ aws acm import-certificate --certificate file://cert.pem \ --certificate-chain file://fullchain.pem \ --private-key file://privkey.pem \ --region us-east-1

- 登录到 AWS 控制台 以创建 CloudFront 发行版。

使用以下信息配置 CloudFront 发行版:

注意如果没有在下表中指定选项,请保留默认值(可能为空)。

选项 值 原始域

上面的命令的输出 [1]

Name

rosa-waf-ingress [2]

查看器协议策略

将 HTTP 重定向到 HTTPS

允许的 HTTP 方法

GET, HEAD, OPTIONS, PUT, POST, PATCH, DELETE

缓存策略

CachingDisabled

原始请求策略

AllViewer

Web 应用程序防火墙(WAF)

启用安全保护

使用现有的 WAF 配置

true

选择 Web ACL

cloudfront-waf备用域名(CNAME)

*.apps.<company_name>.io [3]

自定义 SSL 证书

从上面的步骤中选择您导入的证书 [4]

-

运行

echo ${NLB}以获取原始域。 - 如果您有多个集群,请确保原始名称是唯一的。

- 这应该与您用来创建自定义域入口控制器的通配符域匹配。

- 这应该与上面输入的替代域名匹配。

-

运行

检索 Amazon CloudFront Distribution 端点:

$ aws cloudfront list-distributions --query "DistributionList.Items[?Origins.Items[?DomainName=='${NLB}']].DomainName" --output text使用 CNAME 将自定义通配符域的 DNS 更新到上面步骤中的 Amazon CloudFront 分发端点。

示例

*.apps.<company_name>.io CNAME d1b2c3d4e5f6g7.cloudfront.net

5.4. 部署示例应用程序

部署 hello world 应用:

$ oc -n waf-demo new-app --image=docker.io/openshift/hello-openshift

为应用程序创建指定自定义域名的路由:

示例

$ oc -n waf-demo create route edge --service=hello-openshift hello-openshift-tls \ --hostname hello-openshift.apps.<company_name>.io

标记路由以接受您的自定义域入口控制器:

$ oc -n waf-demo label route.route.openshift.io/hello-openshift-tls route=waf

5.5. 测试 WAF

测试应用程序是否可以在 Amazon CloudFront 后面访问:

示例

$ curl "https://hello-openshift.apps.<company_name>.io"

输出示例

Hello OpenShift!

测试 WAF 是否拒绝错误请求:

示例

$ curl -X POST "https://hello-openshift.apps.<company_name>.io" \ -F "user='<script><alert>Hello></alert></script>'"

输出示例

<html> <head><title>403 Forbidden</title></head> <body> <center><h1>403 Forbidden</h1></center> </body> </html

预期的结果是一个

403 Forbidden错误,这意味着 AWS WAF 正在保护您的应用程序。

5.6. 其他资源

第 6 章 教程: 使用 AWS WAF 和 AWS ALB 来保护 ROSA 工作负载

AWS WAF 是一个 web 应用程序防火墙,可让您监控转发到受保护的 web 应用程序资源的 HTTP 和 HTTPS 请求。

您可以使用 AWS Application Load Balancer (ALB)将 Web 应用程序防火墙(WAF)添加到 Red Hat OpenShift Service on AWS (ROSA)工作负载中。使用外部解决方案可防止 ROSA 资源因为处理 WAF 而导致拒绝服务。

建议您使用 CloudFront 方法,除非绝对必须使用基于 ALB 的解决方案。

6.1. 前提条件

AWS ALB 需要 Multi-AZ 集群,以及与集群相同的 VPC 中的三个公共子网分割。

- 一个 Multi-AZ ROSA Classic 集群。

-

您可以访问 OpenShift CLI(

oc)。 -

您可以访问 AWS CLI (

aws)。

6.1.1. 环境设置

准备环境变量:

$ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/alb-waf" $ mkdir -p ${SCRATCH} $ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

6.1.2. AWS VPC 和子网

本节只适用于部署到现有 VPC 的集群。如果您没有将集群部署到现有的 VPC 中,请跳过本节并继续以下安装部分。

将以下变量设置为您的 ROSA 部署的正确值:

$ export VPC_ID=<vpc-id> $ export PUBLIC_SUBNET_IDS=<public-subnets> $ export PRIVATE_SUBNET_IDS=<private-subnets>

使用集群名称在集群 VPC 中添加标签:

$ aws ec2 create-tags --resources ${VPC_ID} --tags Key=kubernetes.io/cluster/${CLUSTER_NAME},Value=owned --region ${REGION}在您的公共子网中添加标签:

$ aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='' \ --region ${REGION}在您的私有子网中添加标签:

$ aws ec2 create-tags \ --resources "${PRIVATE_SUBNET_IDS}" \ --tags Key=kubernetes.io/role/internal-elb,Value='' \ --region ${REGION}

6.2. 部署 AWS Load Balancer Operator

AWS Load Balancer Operator 用于在 ROSA 集群中安装、管理和配置 aws-load-balancer-controller 实例。要在 ROSA 中部署 ALB,我们需要首先部署 AWS Load Balancer Operator。

为 AWS Load Balancer Controller 创建 AWS IAM 策略:

注意该策略 来自上游 AWS Load Balancer Controller 策略,以及在子网上创建标签的权限。Operator 需要它才能正常工作。

$ oc new-project aws-load-balancer-operator $ POLICY_ARN=$(aws iam list-policies --query \ "Policies[?PolicyName=='aws-load-balancer-operator-policy'].{ARN:Arn}" \ --output text) $ if [[ -z "${POLICY_ARN}" ]]; then wget -O "${SCRATCH}/load-balancer-operator-policy.json" \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/rosa/aws-load-balancer-operator/load-balancer-operator-policy.json POLICY_ARN=$(aws --region "$REGION" --query Policy.Arn \ --output text iam create-policy \ --policy-name aws-load-balancer-operator-policy \ --policy-document "file://${SCRATCH}/load-balancer-operator-policy.json") fi $ echo $POLICY_ARN为 AWS Load Balancer Operator 创建 AWS IAM 信任策略:

$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": ["system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-operator-controller-manager", "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-controller-cluster"] } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOF为 AWS Load Balancer Operator 创建 AWS IAM 角色:

$ ROLE_ARN=$(aws iam create-role --role-name "${CLUSTER_NAME}-alb-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text) $ echo $ROLE_ARN $ aws iam attach-role-policy --role-name "${CLUSTER_NAME}-alb-operator" \ --policy-arn $POLICY_ARN为 AWS Load Balancer Operator 创建 secret,以假定我们新创建的 AWS IAM 角色:

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Secret metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator stringData: credentials: | [default] role_arn = $ROLE_ARN web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF安装 Red Hat AWS Load Balancer Operator:

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: channel: stable-v1.0 installPlanApproval: Automatic name: aws-load-balancer-operator source: redhat-operators sourceNamespace: openshift-marketplace startingCSV: aws-load-balancer-operator.v1.0.0 EOF

使用 Operator 部署 AWS Load Balancer Controller 实例:

注意如果您在此处收到错误并尝试重试,这意味着 Operator 还没有完成安装。

$ cat << EOF | oc apply -f - apiVersion: networking.olm.openshift.io/v1 kind: AWSLoadBalancerController metadata: name: cluster spec: credentials: name: aws-load-balancer-operator enabledAddons: - AWSWAFv2 EOF检查 Operator 和控制器 pod 是否都在运行:

$ oc -n aws-load-balancer-operator get pods

如果没有等待片刻并重试,您应该看到以下内容:

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4s

6.3. 部署示例应用程序

为示例应用程序创建一个新项目:

$ oc new-project hello-world

部署 hello world 应用:

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

将预先创建的服务资源转换为 NodePort 服务类型:

$ oc -n hello-world patch service hello-openshift -p '{"spec":{"type":"NodePort"}}'使用 AWS Load Balancer Operator 部署 AWS ALB:

$ cat << EOF | oc apply -f - apiVersion: networking.k8s.io/v1 kind: Ingress metadata: name: hello-openshift-alb namespace: hello-world annotations: alb.ingress.kubernetes.io/scheme: internet-facing spec: ingressClassName: alb rules: - http: paths: - path: / pathType: Exact backend: service: name: hello-openshift port: number: 8080 EOFcurl AWS ALB Ingress 端点,以验证 hello world 应用程序是否可访问:

注意AWS ALB 置备需要几分钟。如果您收到显示

curl: (6) Could not resolve host的错误,请等待再试一次。$ INGRESS=$(oc -n hello-world get ingress hello-openshift-alb -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${INGRESS}"输出示例

Hello OpenShift!

6.3.1. 配置 AWS WAF

AWS WAF 服务是一个 web 应用程序防火墙,可让您监控、保护和控制转发到受保护的 web 应用程序资源(如 ROSA)的 HTTP 和 HTTPS 请求。

创建 AWS WAF 规则文件以应用到我们的 Web ACL:

$ cat << EOF > ${SCRATCH}/waf-rules.json [ { "Name": "AWS-AWSManagedRulesCommonRuleSet", "Priority": 0, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesCommonRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesCommonRuleSet" } }, { "Name": "AWS-AWSManagedRulesSQLiRuleSet", "Priority": 1, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesSQLiRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesSQLiRuleSet" } } ] EOF这将启用 Core (Common)和 SQL AWS Managed Rule Sets。

使用上面指定的规则创建 AWS WAF Web ACL:

$ WAF_ARN=$(aws wafv2 create-web-acl \ --name ${CLUSTER_NAME}-waf \ --region ${REGION} \ --default-action Allow={} \ --scope REGIONAL \ --visibility-config SampledRequestsEnabled=true,CloudWatchMetricsEnabled=true,MetricName=${CLUSTER_NAME}-waf-metrics \ --rules file://${SCRATCH}/waf-rules.json \ --query 'Summary.ARN' \ --output text)使用 AWS WAF Web ACL ARN 注解 Ingress 资源:

$ oc annotate -n hello-world ingress.networking.k8s.io/hello-openshift-alb \ alb.ingress.kubernetes.io/wafv2-acl-arn=${WAF_ARN}等待 10 秒,以便规则传播并测试应用程序是否仍然可以正常工作:

$ curl "http://${INGRESS}"输出示例

Hello OpenShift!

测试 WAF 是否拒绝错误请求:

$ curl -X POST "http://${INGRESS}" \ -F "user='<script><alert>Hello></alert></script>'"输出示例

<html> <head><title>403 Forbidden</title></head> <body> <center><h1>403 Forbidden</h1></center> </body> </html

预期的结果是一个

403 Forbidden错误,这意味着 AWS WAF 正在保护您的应用程序。

6.4. 其他资源

第 7 章 教程:在 ROSA 集群上部署 OpenShift API for Data Protection

此内容由红帽专家编写,但尚未在所有支持的配置中进行测试。

前提条件

环境

准备环境变量:

注意更改集群名称以匹配您的 ROSA 集群,并确保您以管理员身份登录到集群。在继续之前,请确保正确输出所有字段。

$ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export ROSA_CLUSTER_ID=$(rosa describe cluster -c ${CLUSTER_NAME} --output json | jq -r .id) $ export REGION=$(rosa describe cluster -c ${CLUSTER_NAME} --output json | jq -r .region.id) $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export CLUSTER_VERSION=`rosa describe cluster -c ${CLUSTER_NAME} -o json | jq -r .version.raw_id | cut -f -2 -d '.'` $ export ROLE_NAME="${CLUSTER_NAME}-openshift-oadp-aws-cloud-credentials" $ export AWS_PAGER="" $ export SCRATCH="/tmp/${CLUSTER_NAME}/oadp" $ mkdir -p ${SCRATCH} $ echo "Cluster ID: ${ROSA_CLUSTER_ID}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

7.1. 准备 AWS 帐户

创建一个 IAM 策略来允许 S3 访问:

$ POLICY_ARN=$(aws iam list-policies --query "Policies[?PolicyName=='RosaOadpVer1'].{ARN:Arn}" --output text) if [[ -z "${POLICY_ARN}" ]]; then $ cat << EOF > ${SCRATCH}/policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:CreateBucket", "s3:DeleteBucket", "s3:PutBucketTagging", "s3:GetBucketTagging", "s3:PutEncryptionConfiguration", "s3:GetEncryptionConfiguration", "s3:PutLifecycleConfiguration", "s3:GetLifecycleConfiguration", "s3:GetBucketLocation", "s3:ListBucket", "s3:GetObject", "s3:PutObject", "s3:DeleteObject", "s3:ListBucketMultipartUploads", "s3:AbortMultipartUpload", "s3:ListMultipartUploadParts", "ec2:DescribeSnapshots", "ec2:DescribeVolumes", "ec2:DescribeVolumeAttribute", "ec2:DescribeVolumesModifications", "ec2:DescribeVolumeStatus", "ec2:CreateTags", "ec2:CreateVolume", "ec2:CreateSnapshot", "ec2:DeleteSnapshot" ], "Resource": "*" } ]} EOF $ POLICY_ARN=$(aws iam create-policy --policy-name "RosaOadpVer1" \ --policy-document file:///${SCRATCH}/policy.json --query Policy.Arn \ --tags Key=rosa_openshift_version,Value=${CLUSTER_VERSION} Key=rosa_role_prefix,Value=ManagedOpenShift Key=operator_namespace,Value=openshift-oadp Key=operator_name,Value=openshift-oadp \ --output text) fi $ echo ${POLICY_ARN}为集群创建 IAM 角色信任策略:

$ cat <<EOF > ${SCRATCH}/trust-policy.json { "Version": "2012-10-17", "Statement": [{ "Effect": "Allow", "Principal": { "Federated": "arn:aws:iam::${AWS_ACCOUNT_ID}:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${OIDC_ENDPOINT}:sub": [ "system:serviceaccount:openshift-adp:openshift-adp-controller-manager", "system:serviceaccount:openshift-adp:velero"] } } }] } EOF $ ROLE_ARN=$(aws iam create-role --role-name \ "${ROLE_NAME}" \ --assume-role-policy-document file://${SCRATCH}/trust-policy.json \ --tags Key=rosa_cluster_id,Value=${ROSA_CLUSTER_ID} Key=rosa_openshift_version,Value=${CLUSTER_VERSION} Key=rosa_role_prefix,Value=ManagedOpenShift Key=operator_namespace,Value=openshift-adp Key=operator_name,Value=openshift-oadp \ --query Role.Arn --output text) $ echo ${ROLE_ARN}将 IAM 策略附加到 IAM 角色:

$ aws iam attach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn ${POLICY_ARN}

7.2. 在集群中部署 OADP

为 OADP 创建命名空间:

$ oc create namespace openshift-adp

创建凭证 secret:

$ cat <<EOF > ${SCRATCH}/credentials [default] role_arn = ${ROLE_ARN} web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF $ oc -n openshift-adp create secret generic cloud-credentials \ --from-file=${SCRATCH}/credentials部署 OADP Operator:

注意目前,Operator 版本 1.1 存在一个带有

PartiallyFailed状态的备份版本 1.1 的问题。这不会影响备份和恢复过程,但应注意,因为它存在问题。$ cat << EOF | oc create -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: generateName: openshift-adp- namespace: openshift-adp name: oadp spec: targetNamespaces: - openshift-adp --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: redhat-oadp-operator namespace: openshift-adp spec: channel: stable-1.2 installPlanApproval: Automatic name: redhat-oadp-operator source: redhat-operators sourceNamespace: openshift-marketplace EOF

等待 Operator 就绪:

$ watch oc -n openshift-adp get pods

输出示例

NAME READY STATUS RESTARTS AGE openshift-adp-controller-manager-546684844f-qqjhn 1/1 Running 0 22s

创建云存储:

$ cat << EOF | oc create -f - apiVersion: oadp.openshift.io/v1alpha1 kind: CloudStorage metadata: name: ${CLUSTER_NAME}-oadp namespace: openshift-adp spec: creationSecret: key: credentials name: cloud-credentials enableSharedConfig: true name: ${CLUSTER_NAME}-oadp provider: aws region: $REGION EOF检查应用程序的存储默认存储类:

$ oc get pvc -n <namespace> 1- 1

- 输入应用程序的命名空间。

输出示例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE applog Bound pvc-351791ae-b6ab-4e8b-88a4-30f73caf5ef8 1Gi RWO gp3-csi 4d19h mysql Bound pvc-16b8e009-a20a-4379-accc-bc81fedd0621 1Gi RWO gp3-csi 4d19h

$ oc get storageclass

输出示例

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE gp2 kubernetes.io/aws-ebs Delete WaitForFirstConsumer true 4d21h gp2-csi ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3 ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3-csi (default) ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h

使用 gp3-csi, gp2-csi, gp3 或 gp2 将可以正常工作。如果要备份的应用程序都使用带有 CSI 的 PV,请在 OADP DPA 配置中包含 CSI 插件。

仅限 CSI:部署数据保护应用程序:

$ cat << EOF | oc create -f - apiVersion: oadp.openshift.io/v1alpha1 kind: DataProtectionApplication metadata: name: ${CLUSTER_NAME}-dpa namespace: openshift-adp spec: backupImages: true features: dataMover: enable: false backupLocations: - bucket: cloudStorageRef: name: ${CLUSTER_NAME}-oadp credential: key: credentials name: cloud-credentials prefix: velero default: true config: region: ${REGION} configuration: velero: defaultPlugins: - openshift - aws - csi restic: enable: false EOF注意如果为 CSI 卷运行这个命令,您可以跳过下一步。

非 CSI 卷:部署数据保护应用程序:

$ cat << EOF | oc create -f - apiVersion: oadp.openshift.io/v1alpha1 kind: DataProtectionApplication metadata: name: ${CLUSTER_NAME}-dpa namespace: openshift-adp spec: backupImages: true features: dataMover: enable: false backupLocations: - bucket: cloudStorageRef: name: ${CLUSTER_NAME}-oadp credential: key: credentials name: cloud-credentials prefix: velero default: true config: region: ${REGION} configuration: velero: defaultPlugins: - openshift - aws restic: enable: false snapshotLocations: - velero: config: credentialsFile: /tmp/credentials/openshift-adp/cloud-credentials-credentials enableSharedConfig: 'true' profile: default region: ${REGION} provider: aws EOF

-

在 OADP 1.1.x ROSA STS 环境中,容器镜像备份和恢复(

spec.backupImages)值必须设置为false,因为它不被支持。 -

Restic 功能(

restic.enable=false)被禁用,在 ROSA STS 环境中不支持。 -

DataMover 功能(

dataMover.enable=false)被禁用,在 ROSA STS 环境中不支持。

7.3. 执行备份

以下示例 hello-world 应用没有附加的持久性卷。DPA 配置都将正常工作。

创建要备份的工作负载:

$ oc create namespace hello-world $ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

公开路由:

$ oc expose service/hello-openshift -n hello-world

检查应用程序是否正常工作:

$ curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`输出示例

Hello OpenShift!

备份工作负载:

$ cat << EOF | oc create -f - apiVersion: velero.io/v1 kind: Backup metadata: name: hello-world namespace: openshift-adp spec: includedNamespaces: - hello-world storageLocation: ${CLUSTER_NAME}-dpa-1 ttl: 720h0m0s EOF等待备份完成:

$ watch "oc -n openshift-adp get backup hello-world -o json | jq .status"

输出示例

{ "completionTimestamp": "2022-09-07T22:20:44Z", "expiration": "2022-10-07T22:20:22Z", "formatVersion": "1.1.0", "phase": "Completed", "progress": { "itemsBackedUp": 58, "totalItems": 58 }, "startTimestamp": "2022-09-07T22:20:22Z", "version": 1 }删除 demo 工作负载:

$ oc delete ns hello-world

从备份中恢复:

$ cat << EOF | oc create -f - apiVersion: velero.io/v1 kind: Restore metadata: name: hello-world namespace: openshift-adp spec: backupName: hello-world EOF

等待 Restore 完成:

$ watch "oc -n openshift-adp get restore hello-world -o json | jq .status"

输出示例

{ "completionTimestamp": "2022-09-07T22:25:47Z", "phase": "Completed", "progress": { "itemsRestored": 38, "totalItems": 38 }, "startTimestamp": "2022-09-07T22:25:28Z", "warnings": 9 }检查工作负载是否已恢复:

$ oc -n hello-world get pods

输出示例

NAME READY STATUS RESTARTS AGE hello-openshift-9f885f7c6-kdjpj 1/1 Running 0 90s

$ curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`输出示例

Hello OpenShift!

- 有关故障排除提示的信息,请参阅 OADP 团队的 故障排除文档

- 其他示例应用程序可以在 OADP 团队 的示例应用程序目录中找到

7.4. cleanup

删除工作负载:

$ oc delete ns hello-world

如果不再需要,从集群中删除备份和恢复资源:

$ oc delete backup hello-world $ oc delete restore hello-world

删除 s3 中的备份/恢复和远程对象:

$ velero backup delete hello-world $ velero restore delete hello-world

删除数据保护应用程序:

$ oc -n openshift-adp delete dpa ${CLUSTER_NAME}-dpa删除云存储:

$ oc -n openshift-adp delete cloudstorage ${CLUSTER_NAME}-oadp警告如果这个命令挂起,您可能需要删除终结器:

$ oc -n openshift-adp patch cloudstorage ${CLUSTER_NAME}-oadp -p '{"metadata":{"finalizers":null}}' --type=merge如果不再需要,删除 Operator:

$ oc -n openshift-adp delete subscription oadp-operator

删除 Operator 的命名空间:

$ oc delete ns redhat-openshift-adp

如果不再有它们,请从集群中删除自定义资源定义:

$ for CRD in `oc get crds | grep velero | awk '{print $1}'`; do oc delete crd $CRD; done $ for CRD in `oc get crds | grep -i oadp | awk '{print $1}'`; do oc delete crd $CRD; done删除 AWS S3 Bucket:

$ aws s3 rm s3://${CLUSTER_NAME}-oadp --recursive $ aws s3api delete-bucket --bucket ${CLUSTER_NAME}-oadp将 Policy 从角色分离:

$ aws iam detach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn "${POLICY_ARN}"删除角色:

$ aws iam delete-role --role-name "${ROLE_NAME}"

第 8 章 教程:AWS Load Balancer Operator on ROSA

此内容由红帽专家编写,但尚未在所有支持的配置中进行测试。

AWS Load Balancer Operator 创建的 Load Balancers 不能用于 OpenShift Route,并且应该只用于不需要 OpenShift 路由 的完整第 7 层功能的单个服务或入口资源。

AWS Load Balancer Controller 为 AWS (ROSA)集群管理 Red Hat OpenShift Service 的 AWS Elastic Load Balancers。在使用类型为 LoadBalancer 的 Kubernetes Service 资源时,控制器在创建 Kubernetes Ingress 资源和 AWS Network Load Balancers (NLB) 时置备 AWS Application Load Balancers (ALB)。

与默认的 AWS 树内负载均衡器供应商相比,这个控制器使用 ALB 和 NLBs 的高级注解开发。一些高级用例是:

- 使用带有 ALB 的原生 Kubernetes Ingress 对象

- 将 ALB 与 AWS Web Application Firewall (WAF)服务集成

- 指定自定义 NLB 源 IP 范围

- 指定自定义 NLB 内部 IP 地址

AWS Load Balancer Operator 用于在 ROSA 集群中安装、管理和配置 aws-load-balancer-controller 实例。

8.1. 前提条件

AWS ALB 需要 Multi-AZ 集群,以及与集群相同的 VPC 中的三个公共子网分割。这使得 ALB 不适用于许多 PrivateLink 集群。AWS NLBs 没有这个限制。

- 一个 Multi-AZ ROSA 经典集群

- BYO VPC 集群

- AWS CLI

- OC CLI

8.1.1. 环境

准备环境变量:

$ export AWS_PAGER="" $ export ROSA_CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${ROSA_CLUSTER_NAME}/alb-operator" $ mkdir -p ${SCRATCH} $ echo "Cluster: ${ROSA_CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

8.1.2. AWS VPC 和子网

本节只适用于部署到现有 VPC 的集群。如果您没有将集群部署到现有的 VPC 中,请跳过本节并继续以下安装部分。

将以下变量设置为您的 ROSA 部署的正确值:

$ export VPC_ID=<vpc-id> $ export PUBLIC_SUBNET_IDS=<public-subnets> $ export PRIVATE_SUBNET_IDS=<private-subnets> $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}")使用集群名称在集群 VPC 中添加标签:

$ aws ec2 create-tags --resources ${VPC_ID} --tags Key=kubernetes.io/cluster/${CLUSTER_NAME},Value=owned --region ${REGION}在您的公共子网中添加标签:

$ aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='' \ --region ${REGION}在您的私有子网中添加标签:

$ aws ec2 create-tags \ --resources "${PRIVATE_SUBNET_IDS}" \ --tags Key=kubernetes.io/role/internal-elb,Value='' \ --region ${REGION}

8.2. 安装

为 AWS Load Balancer Controller 创建 AWS IAM 策略:

注意该策略 来自上游 AWS Load Balancer Controller 策略,以及在子网上创建标签的权限。Operator 需要它才能正常工作。

$ oc new-project aws-load-balancer-operator $ POLICY_ARN=$(aws iam list-policies --query \ "Policies[?PolicyName=='aws-load-balancer-operator-policy'].{ARN:Arn}" \ --output text) $ if [[ -z "${POLICY_ARN}" ]]; then wget -O "${SCRATCH}/load-balancer-operator-policy.json" \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/rosa/aws-load-balancer-operator/load-balancer-operator-policy.json POLICY_ARN=$(aws --region "$REGION" --query Policy.Arn \ --output text iam create-policy \ --policy-name aws-load-balancer-operator-policy \ --policy-document "file://${SCRATCH}/load-balancer-operator-policy.json") fi $ echo $POLICY_ARN为 AWS Load Balancer Operator 创建 AWS IAM 信任策略:

$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": ["system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-operator-controller-manager", "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-controller-cluster"] } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOF为 AWS Load Balancer Operator 创建 AWS IAM 角色:

$ ROLE_ARN=$(aws iam create-role --role-name "${ROSA_CLUSTER_NAME}-alb-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text) $ echo $ROLE_ARN $ aws iam attach-role-policy --role-name "${ROSA_CLUSTER_NAME}-alb-operator" \ --policy-arn $POLICY_ARN为 AWS Load Balancer Operator 创建 secret,以假定我们新创建的 AWS IAM 角色:

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Secret metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator stringData: credentials: | [default] role_arn = $ROLE_ARN web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF安装 Red Hat AWS Load Balancer Operator:

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: channel: stable-v1.0 installPlanApproval: Automatic name: aws-load-balancer-operator source: redhat-operators sourceNamespace: openshift-marketplace startingCSV: aws-load-balancer-operator.v1.0.0 EOF

使用 Operator 部署 AWS Load Balancer Controller 实例:

注意如果您在此处收到错误并尝试重试,这意味着 Operator 还没有完成安装。

$ cat << EOF | oc apply -f - apiVersion: networking.olm.openshift.io/v1 kind: AWSLoadBalancerController metadata: name: cluster spec: credentials: name: aws-load-balancer-operator EOF检查 Operator 和控制器 pod 是否都在运行:

$ oc -n aws-load-balancer-operator get pods

如果没有等待片刻并重试,您应该看到以下内容:

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4s

8.3. 验证部署

创建一个新项目

$ oc new-project hello-world

部署 hello world 应用:

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

为 AWS ALB 配置 NodePort 服务以连接:

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Service metadata: name: hello-openshift-nodeport namespace: hello-world spec: ports: - port: 80 targetPort: 8080 protocol: TCP type: NodePort selector: deployment: hello-openshift EOF使用 AWS Load Balancer Operator 部署 AWS ALB:

$ cat << EOF | oc apply -f - apiVersion: networking.k8s.io/v1 kind: Ingress metadata: name: hello-openshift-alb namespace: hello-world annotations: alb.ingress.kubernetes.io/scheme: internet-facing spec: ingressClassName: alb rules: - http: paths: - path: / pathType: Exact backend: service: name: hello-openshift-nodeport port: number: 80 EOFcurl AWS ALB Ingress 端点,以验证 hello world 应用程序是否可访问:

注意AWS ALB 置备需要几分钟。如果您收到显示

curl: (6) Could not resolve host的错误,请等待再试一次。$ INGRESS=$(oc -n hello-world get ingress hello-openshift-alb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${INGRESS}"输出示例

Hello OpenShift!

为您的 hello world 应用程序部署 AWS NLB :

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Service metadata: name: hello-openshift-nlb namespace: hello-world annotations: service.beta.kubernetes.io/aws-load-balancer-type: external service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: instance service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing spec: ports: - port: 80 targetPort: 8080 protocol: TCP type: LoadBalancer selector: deployment: hello-openshift EOF测试 AWS NLB 端点:

注意NLB 置备需要几分钟时间。如果您收到显示

curl: (6) Could not resolve host的错误,请等待再试一次。$ NLB=$(oc -n hello-world get service hello-openshift-nlb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${NLB}"输出示例

Hello OpenShift!

8.4. 清理

删除 hello world 应用命名空间(以及命名空间中的所有资源):

$ oc delete project hello-world

删除 AWS Load Balancer Operator 和 AWS IAM 角色:

$ oc delete subscription aws-load-balancer-operator -n aws-load-balancer-operator $ aws iam detach-role-policy \ --role-name "${ROSA_CLUSTER_NAME}-alb-operator" \ --policy-arn $POLICY_ARN $ aws iam delete-role \ --role-name "${ROSA_CLUSTER_NAME}-alb-operator"删除 AWS IAM 策略:

$ aws iam delete-policy --policy-arn $POLICY_ARN

第 9 章 教程:配置 ROSA/OSD 以使用 Ingress Controller 上的自定义 TLS 密码

此内容由红帽专家编写,但尚未在所有支持的配置中进行测试。

本指南演示了如何正确修补集群 Ingress Controller 以及 Custom Domain Operator 创建的 Ingress Controller。此功能允许客户修改集群 Ingress Controller 上的 tlsSecurityProfile 值。本指南演示了如何应用自定义 tlsSecurityProfile、具有关联角色和角色绑定的范围服务帐户,以及在重新创建或修改 Ingress Controller 时密码更改以 60 分钟重新应用的 CronJob。

前提条件

-

查看 OpenShift 文档,它解释了

tlsSecurityProfile的选项。默认情况下,Ingress Controller 配置为使用Intermediate配置集,它对应于 Intermediate Mozilla 配置集。

流程

为要使用的 CronJob 创建服务帐户。

服务帐户允许我们的 CronJob 直接访问集群 API,而无需使用常规用户的凭证。要创建服务帐户,请运行以下命令:

$ oc create sa cron-ingress-patch-sa -n openshift-ingress-operator

创建一个角色和角色绑定,允许有限的访问来修补 Ingress Controller。

基于角色的访问控制(RBAC)对于确保集群中的安全性至关重要。通过创建角色,我们可以仅提供集群中所需 API 资源的有范围访问权限。要创建角色,请运行以下命令:

$ oc create role cron-ingress-patch-role --verb=get,patch,update --resource=ingresscontroller.operator.openshift.io -n openshift-ingress-operator

创建角色后,您必须使用角色绑定将角色绑定到服务帐户。要创建角色绑定,请运行以下命令:

$ oc create rolebinding cron-ingress-patch-rolebinding --role=cron-ingress-patch-role --serviceaccount=openshift-ingress-operator:cron-ingress-patch-sa -n openshift-ingress-operator

对 Ingress Controller 进行补丁。

重要以下示例在 Ingress Controller 的

tlsSecurityProfile中添加额外的密码,以允许 IE 11 从 Windows Server 2008 R2 访问。修改此命令,以满足您的特定业务需求。在创建 CronJob 之前,请应用

tlsSecurityProfile配置以验证更改。此过程取决于您是否使用 Custom Domain Operator。集群不使用 Custom Domain Operator :

如果您只使用默认 Ingress Controller,而不使用 Custom Domain Operator,请运行以下命令来修补 Ingress Controller:

$ oc patch ingresscontroller/default -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}'此补丁添加了

TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA密码,在使用 RSA 证书时允许从 Windows Server 2008 R2 上的 IE 11 访问。运行命令后,您将收到类似如下的响应:

输出示例

ingresscontroller.operator.openshift.io/default patched

使用 Custom Domain Operator 的集群:

使用 Custom Domain Operator 的客户需要通过每个 Ingress Controller 进行循环来修补每个 Ingress Controller。要修补集群的 Ingress Controller,请运行以下命令:

$ for ic in $(oc get ingresscontroller -o name -n openshift-ingress-operator); do oc patch ${ic} -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}'; done运行命令后,您将收到类似如下的响应:

输出示例

ingresscontroller.operator.openshift.io/default patched ingresscontroller.operator.openshift.io/custom1 patched ingresscontroller.operator.openshift.io/custom2 patched

创建 CronJob 以确保 TLS 配置不会被覆盖。

有时,集群的 Ingress Controller 可以被重新创建。在这些情况下,Ingress Controller 可能不会保留应用的

tlsSecurityProfile更改。为确保不会发生这种情况,请创建一个通过和更新集群的 Ingress Controller 的 CronJob。此过程取决于您是否使用 Custom Domain Operator。集群不使用 Custom Domain Operator :

如果您不使用 Custom Domain Operator,请运行以下命令来创建 CronJob:

$ cat << EOF | oc apply -f - apiVersion: batch/v1 kind: CronJob metadata: name: tls-patch namespace: openshift-ingress-operator spec: schedule: '@hourly' jobTemplate: spec: template: spec: containers: - name: tls-patch image: registry.redhat.io/openshift4/ose-tools-rhel8:latest args: - /bin/sh - '-c' - oc patch ingresscontroller/default -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}' restartPolicy: Never serviceAccountName: cron-ingress-patch-sa EOF注意此 CronJob 每小时运行,并在需要时修补 Ingress Controller。此 CronJob 不会持续运行,因为它可能会触发可能过载 OpenShift Ingress Operator 的协调。大多数时候,Cronon pod 的日志类似以下示例,因为它不会更改任何内容:

输出示例

ingresscontroller.operator.openshift.io/default patched (no change)

使用 Custom Domain Operator 的集群:

如果您使用 Custom Domain Operator,Cronr 需要通过并修补每个 Ingress Controller。要创建此 CronJob,请运行以下命令:

$ cat << EOF | oc apply -f - apiVersion: batch/v1 kind: CronJob metadata: name: tls-patch namespace: openshift-ingress-operator spec: schedule: '@hourly' jobTemplate: spec: template: spec: containers: - name: tls-patch image: registry.redhat.io/openshift4/ose-tools-rhel8:latest args: - /bin/sh - '-c' - for ic in $(oc get ingresscontroller -o name -n openshift-ingress-operator); do oc patch ${ic} -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}'; done restartPolicy: Never serviceAccountName: cron-ingress-patch-sa EOF注意此 CronJob 每小时运行,并在需要时修补 Ingress Controller。此 CronJob 不会持续运行,因为它可能会触发可能过载 OpenShift Ingress Operator 的协调。大多数时候,Cronon pod 的日志类似如下,因为它不会更改任何内容:

输出示例

ingresscontroller.operator.openshift.io/default patched (no change) ingresscontroller.operator.openshift.io/custom1 patched (no change) ingresscontroller.operator.openshift.io/custom2 patched (no change)

第 10 章 教程:将 Microsoft Entra ID (以前称为 Azure Active Directory)配置为身份提供程序

您可以将 Microsoft Entra ID (以前称为 Azure Active Directory)配置为 Red Hat OpenShift Service on AWS (ROSA)中的集群身份提供程序。

本教程指导您完成以下任务:

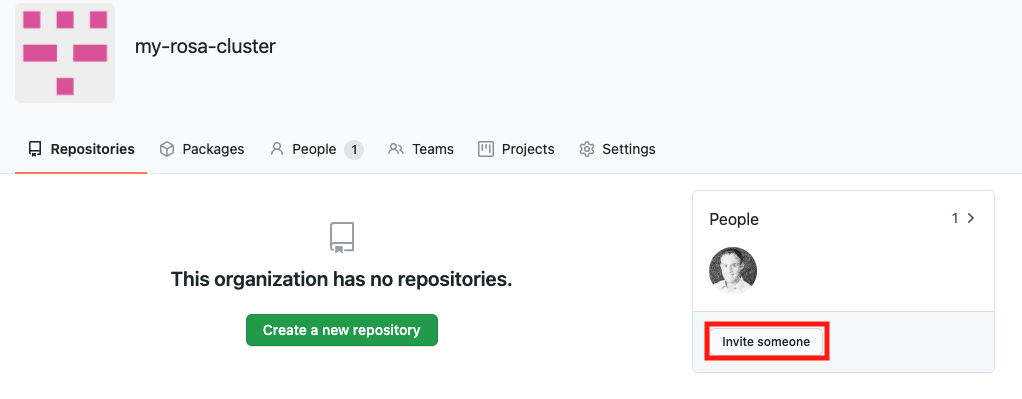

- 在 Entra ID 中注册新应用程序进行验证。

- 在 Entra ID 中配置应用程序注册,以在令牌中包含可选和组声明。

- 将 Red Hat OpenShift Service on AWS 集群配置为使用 Entra ID 作为身份提供程序。

- 为各个组授予额外权限。

10.1. 前提条件

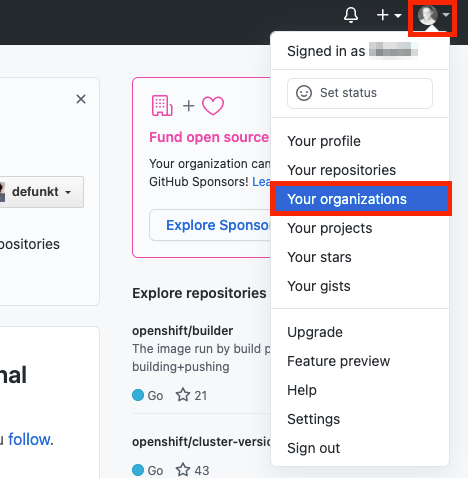

- 您已按照 Microsoft 文档 创建了一组安全组并分配用户。

10.2. 在 Entra ID 中注册新应用程序进行验证

要在 Entra ID 中注册您的应用程序,首先创建 OAuth 回调 URL,然后注册您的应用程序。

流程

通过更改指定的变量并运行以下命令来创建集群的 OAuth 回调 URL:

注意请记住保存此回调 URL;之后需要用到。

$ domain=$(rosa describe cluster -c <cluster_name> | grep "DNS" | grep -oE '\S+.openshiftapps.com') $ echo "OAuth callback URL: https://oauth-openshift.apps.$domain/oauth2callback/AAD"

OAuth 回调 URL 末尾的"AAD"目录必须与稍后在此过程中设置的 OAuth 身份提供程序名称匹配。

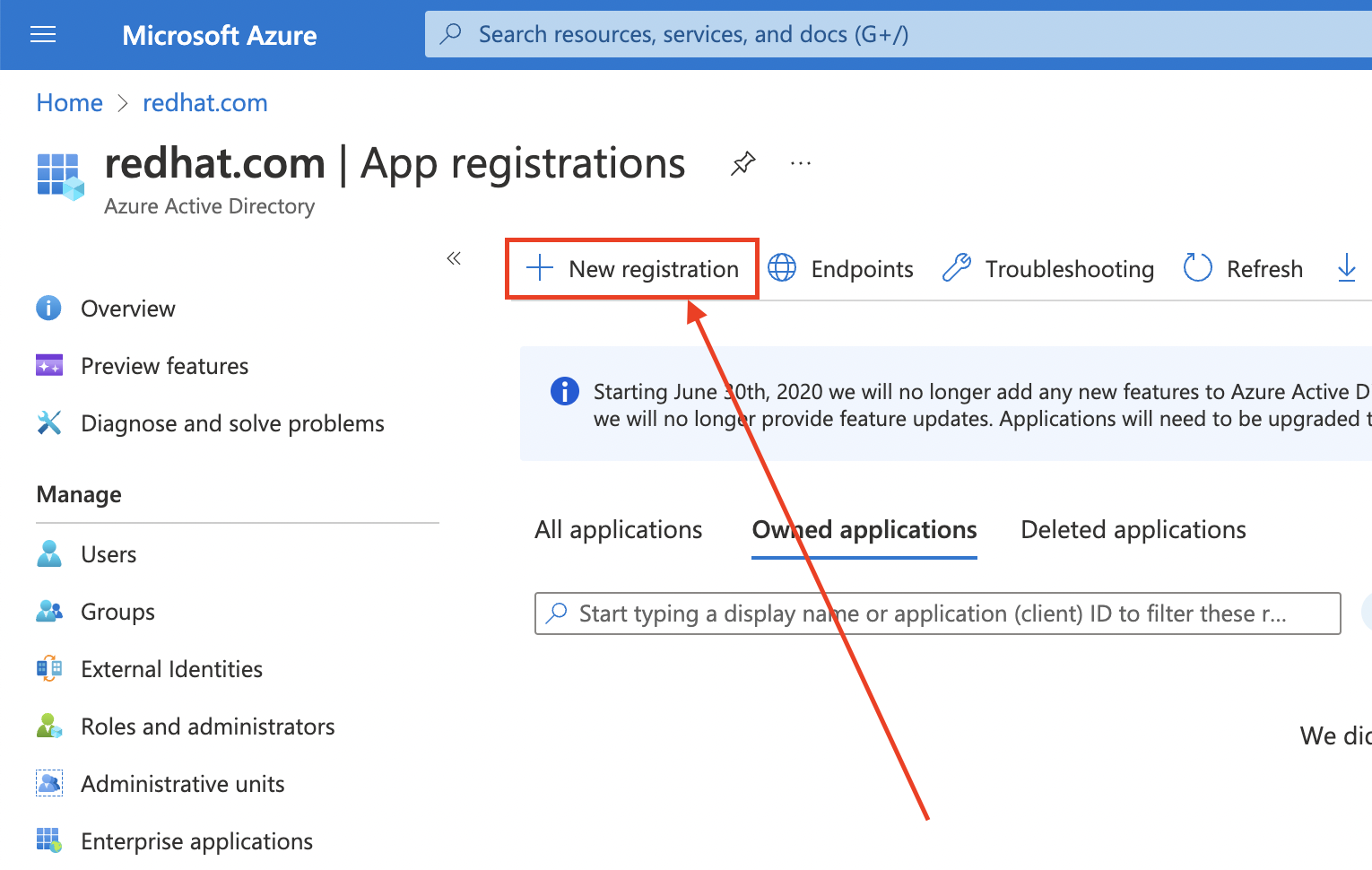

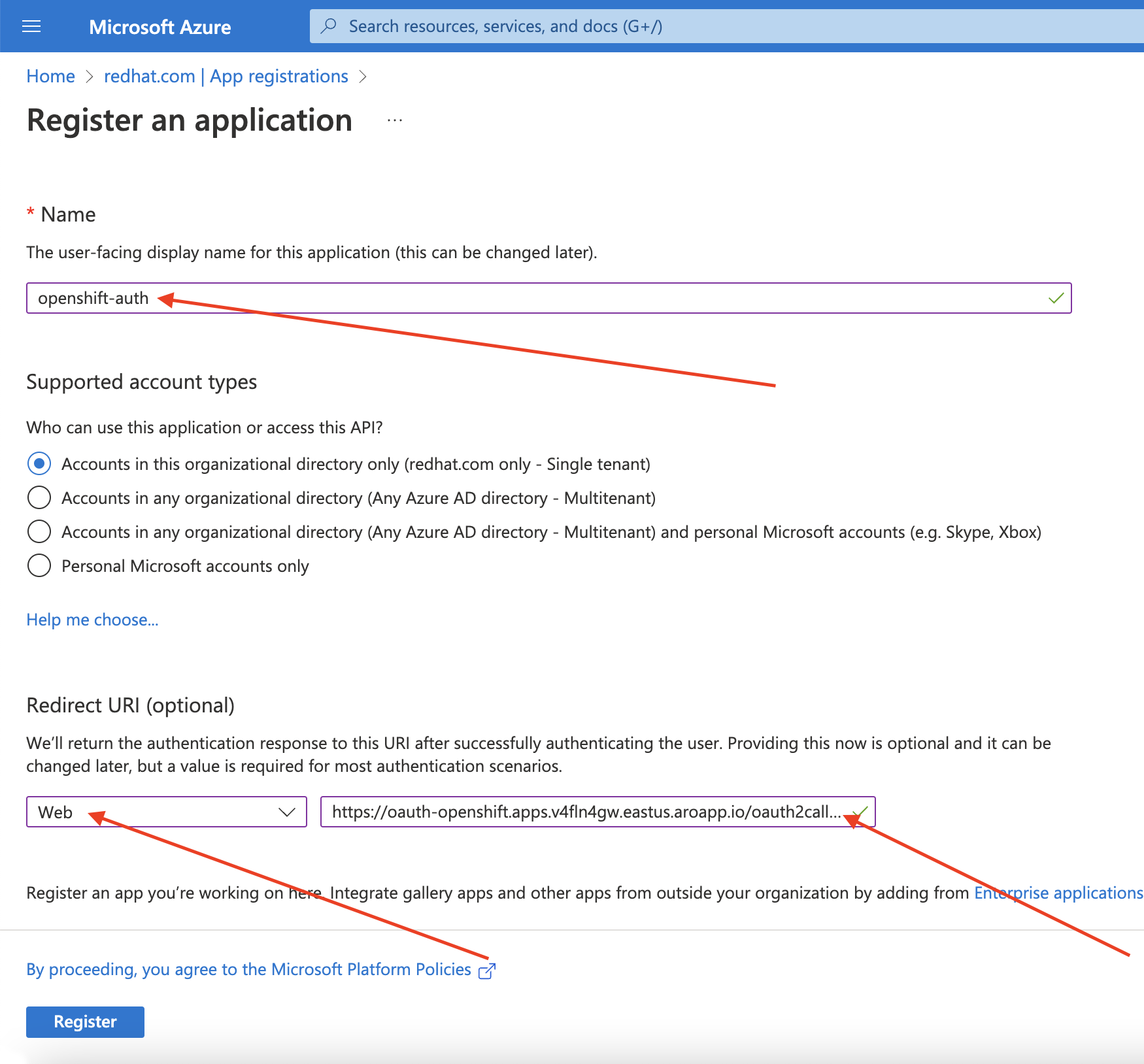

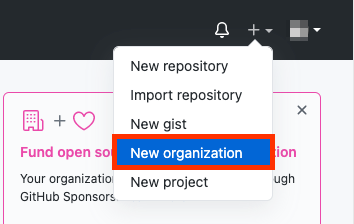

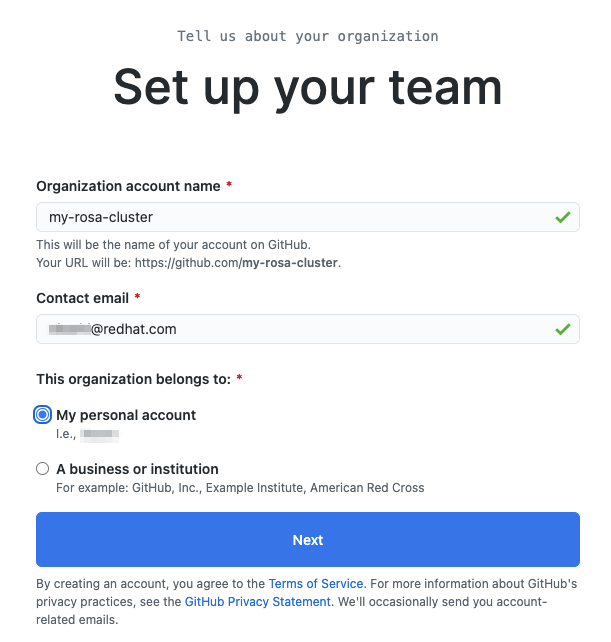

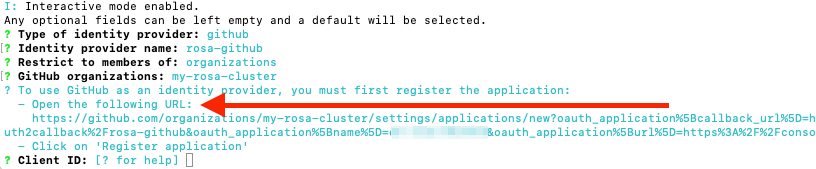

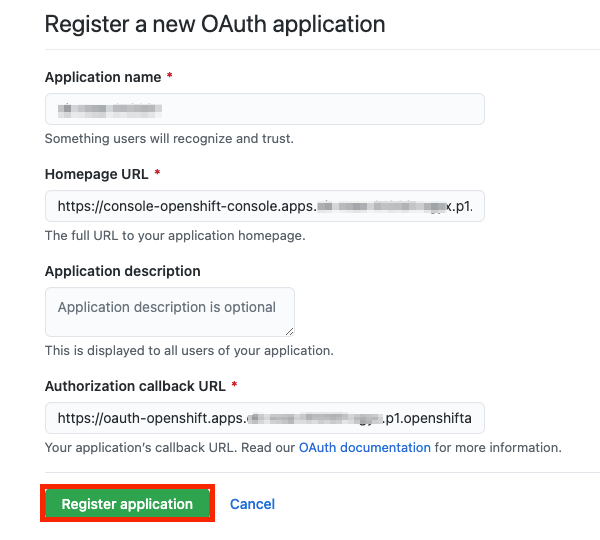

通过登录到 Azure 门户来创建 Entra ID 应用,然后选择 App registrations Blade。然后,选择 New registration 来创建新应用程序。

-

将应用程序命名为,如

openshift-auth。 - 从 Redirect URI 下拉菜单中选择 Web,并输入您在上一步中检索的 OAuth 回调 URL 的值。

提供所需信息后,点 Register 创建应用程序。

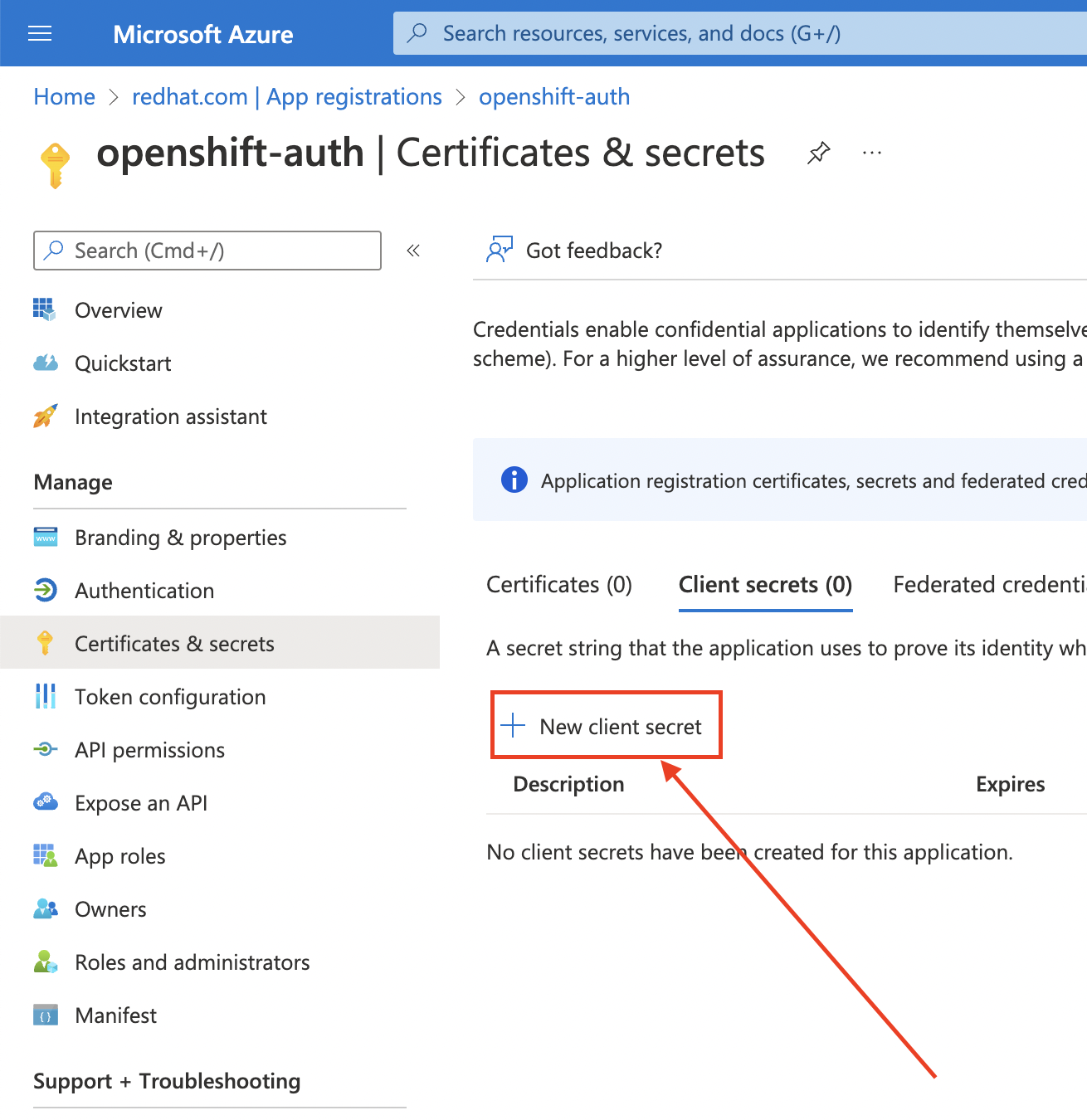

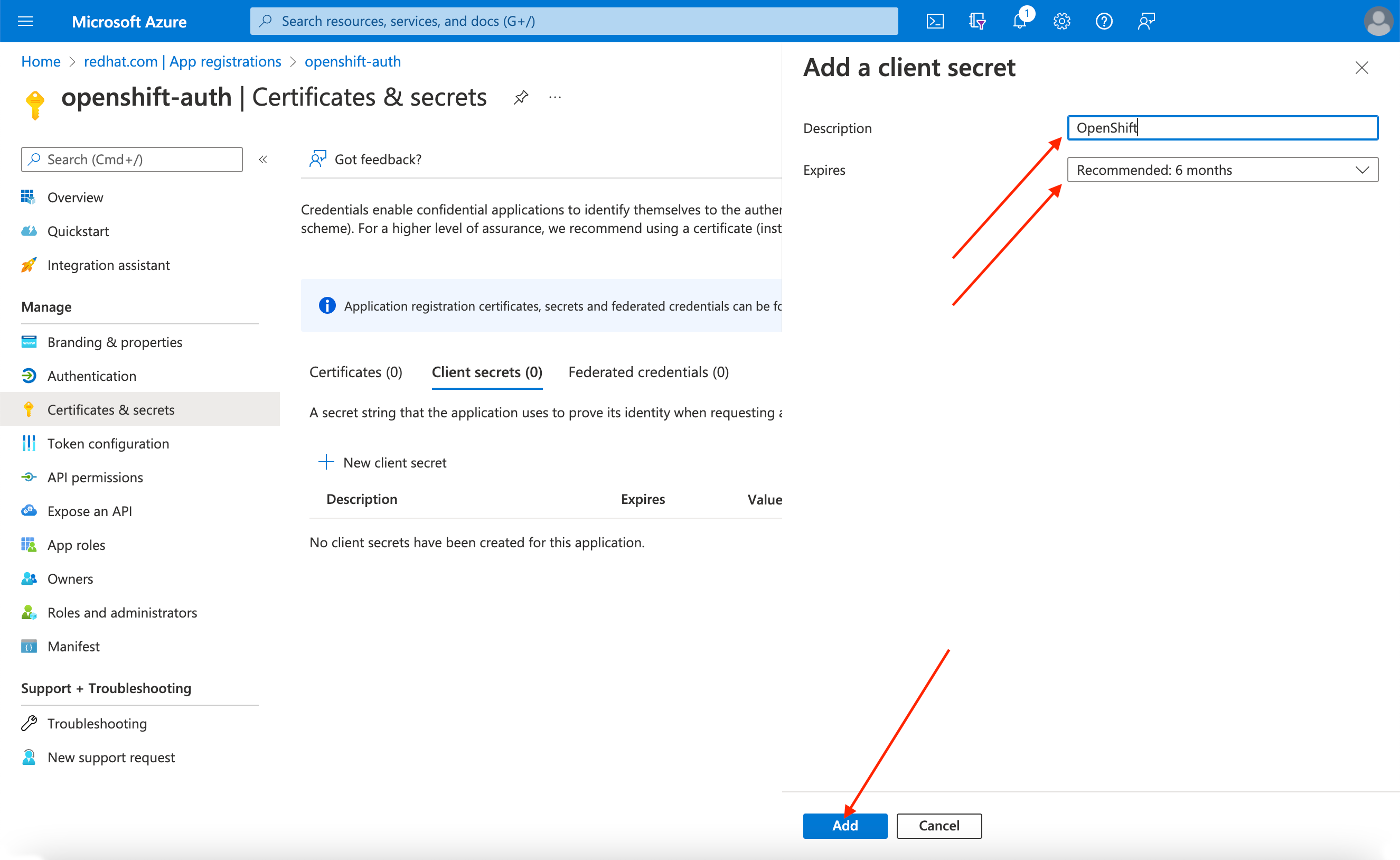

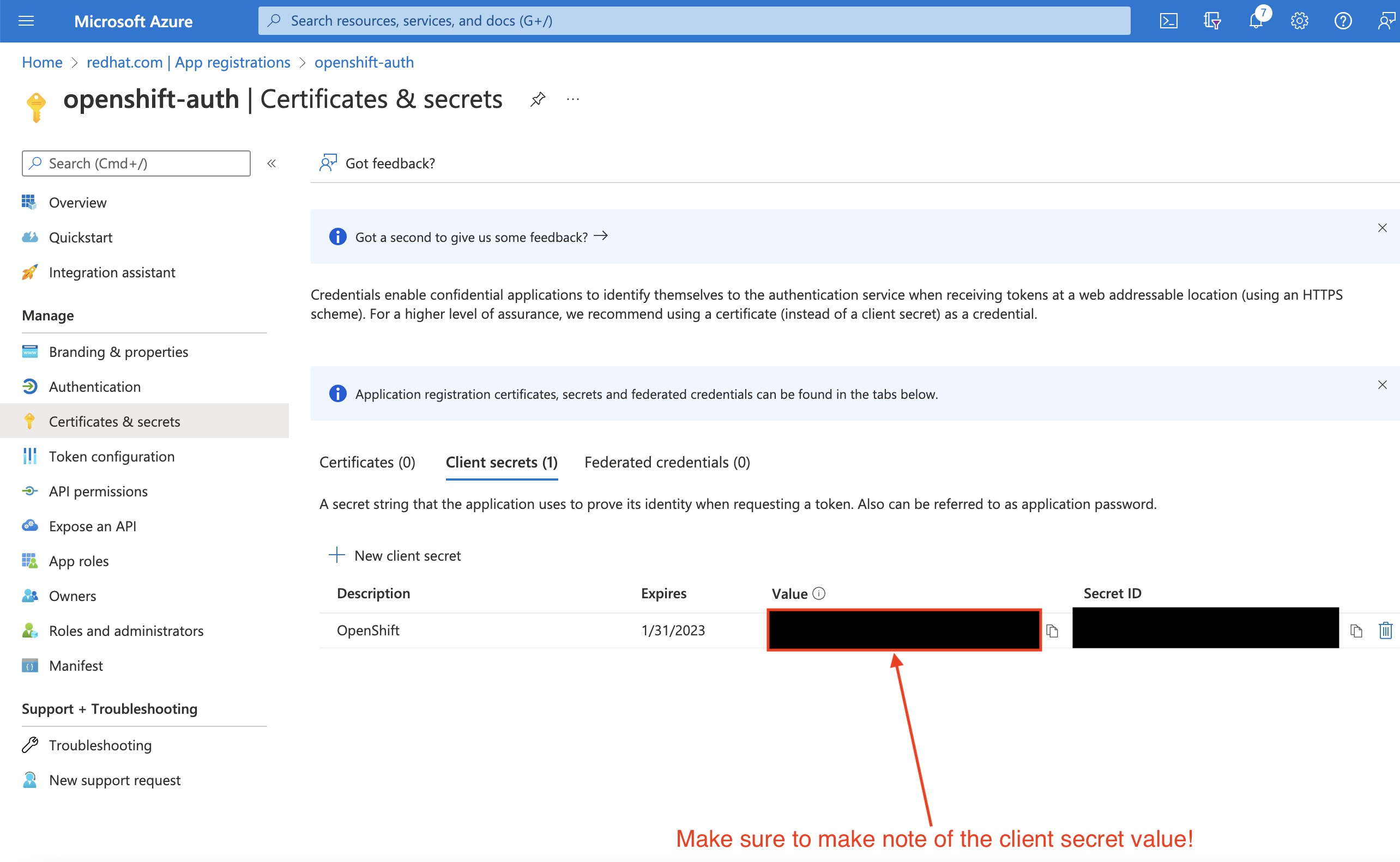

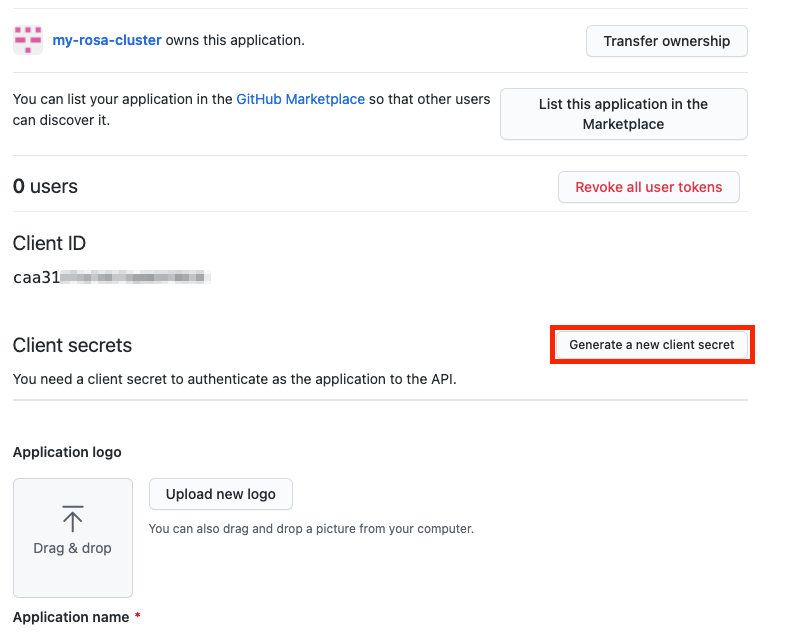

选择 Certificates & secrets sub-blade 并选择 New client secret。

完成请求的详细信息,并存储生成的客户端 secret 值。此过程稍后需要此 secret。

重要初始设置后,您无法看到客户端 secret。如果没有记录客户端 secret,则必须生成新的 secret。

选择 Overview 子组合并记下

应用程序(客户端)ID和目录(租户)ID。以后的步骤中您将需要这些值。

10.3. 在 Entra ID 中配置应用程序注册,使其包含可选和组声明

因此,AWS 上的 Red Hat OpenShift Service 有充足的信息来创建用户帐户,您必须配置 Entra ID,以提供两个可选声明: email 和 preferred_username。有关 Entra ID 中的可选声明的更多信息,请参阅 Microsoft 文档。

除了单独的用户身份验证外,Red Hat OpenShift Service on AWS 还提供组声明功能。此功能允许 OpenID Connect (OIDC)身份提供程序(如 Entra ID)提供用户的组成员资格,以便在 AWS 上的 Red Hat OpenShift Service 中使用。

配置可选声明

您可以在 Entra ID 中配置可选声明。

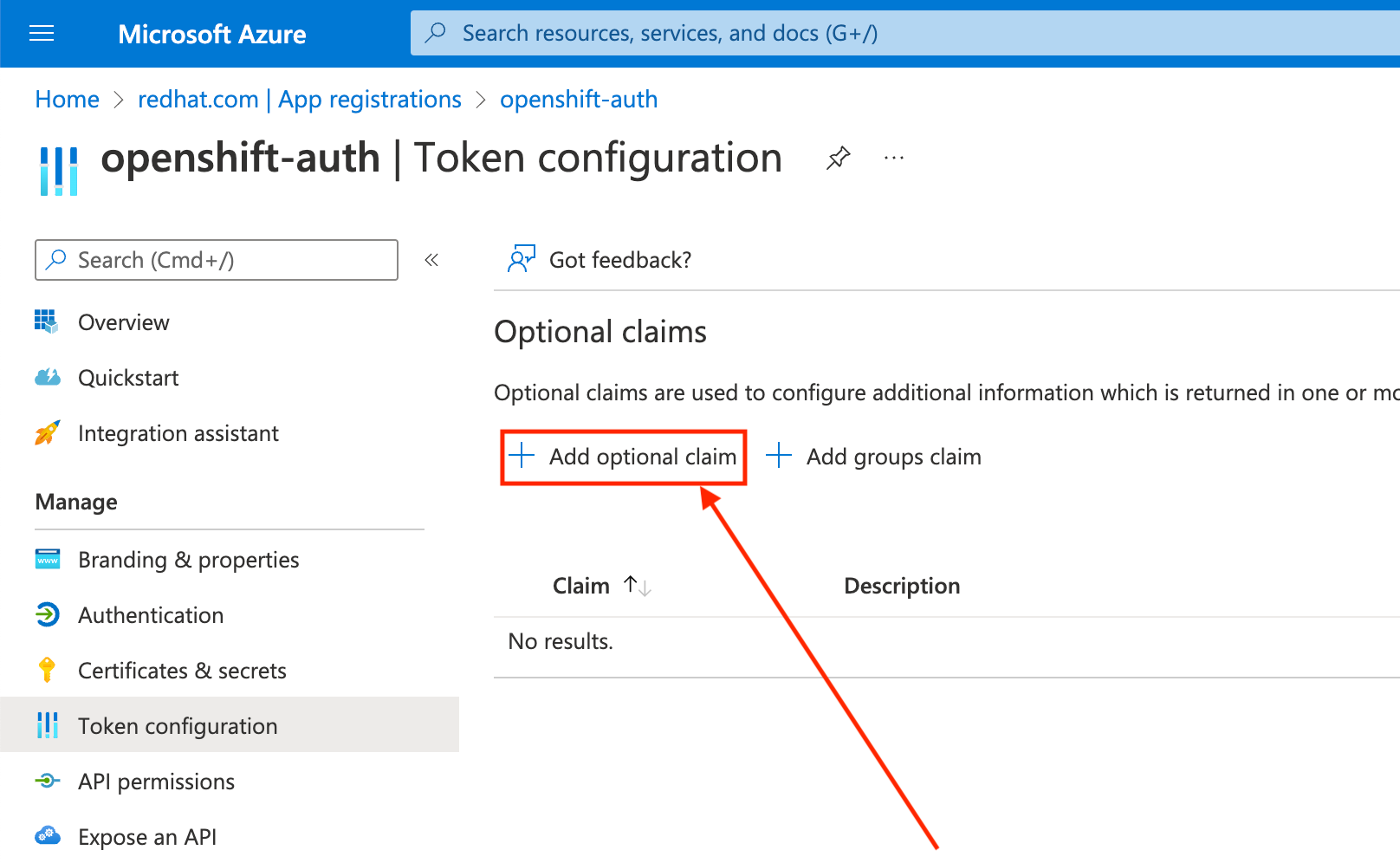

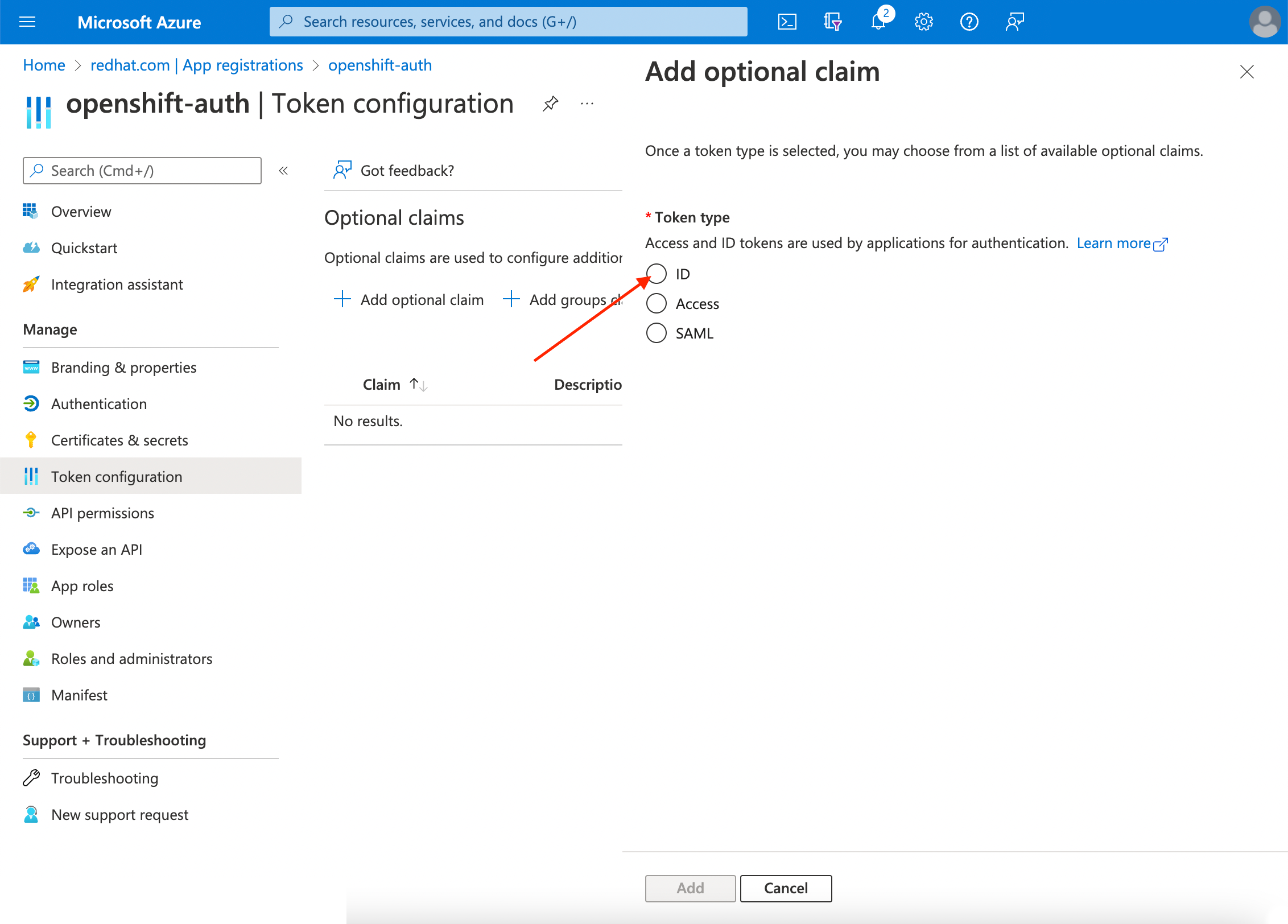

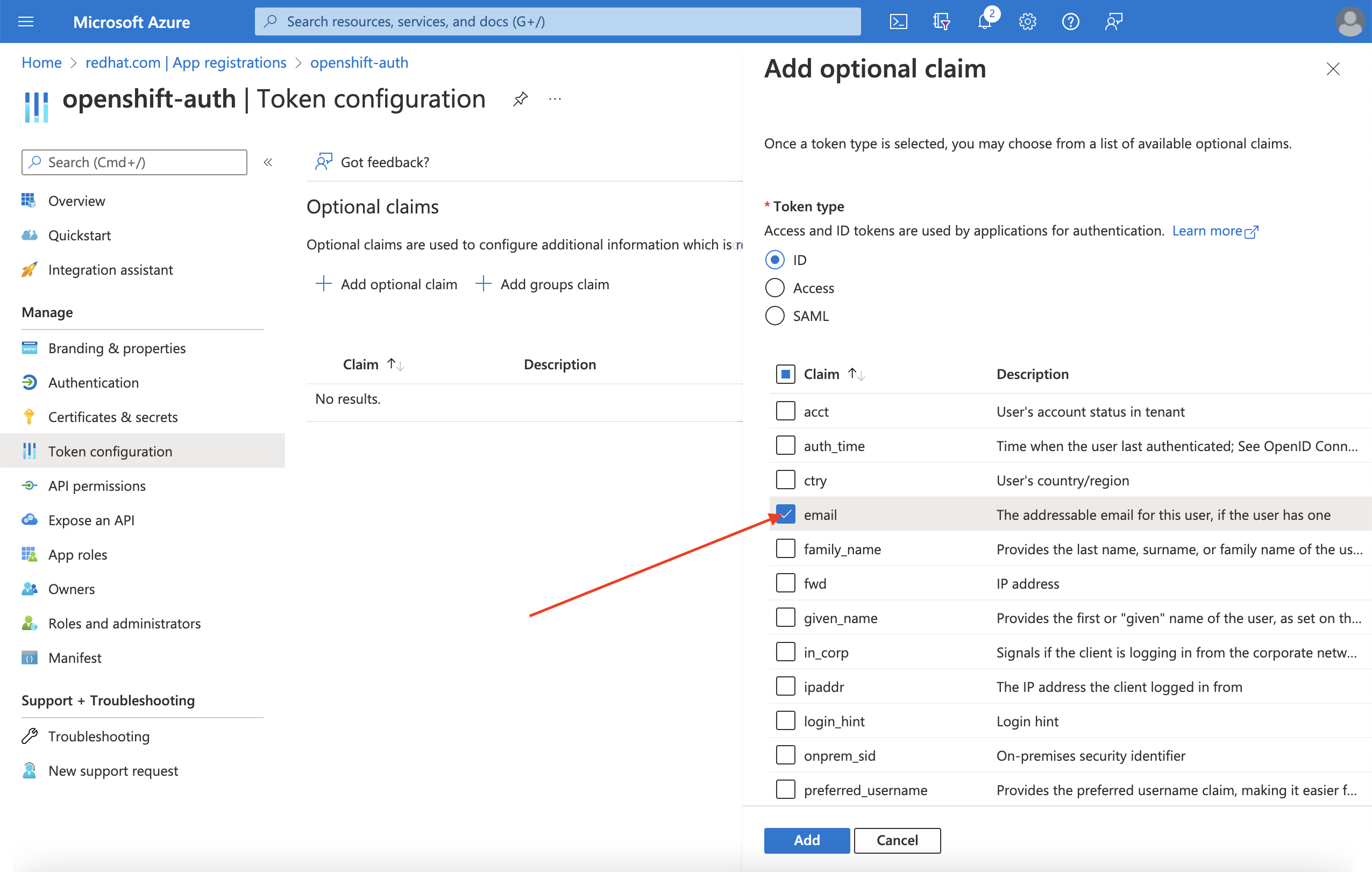

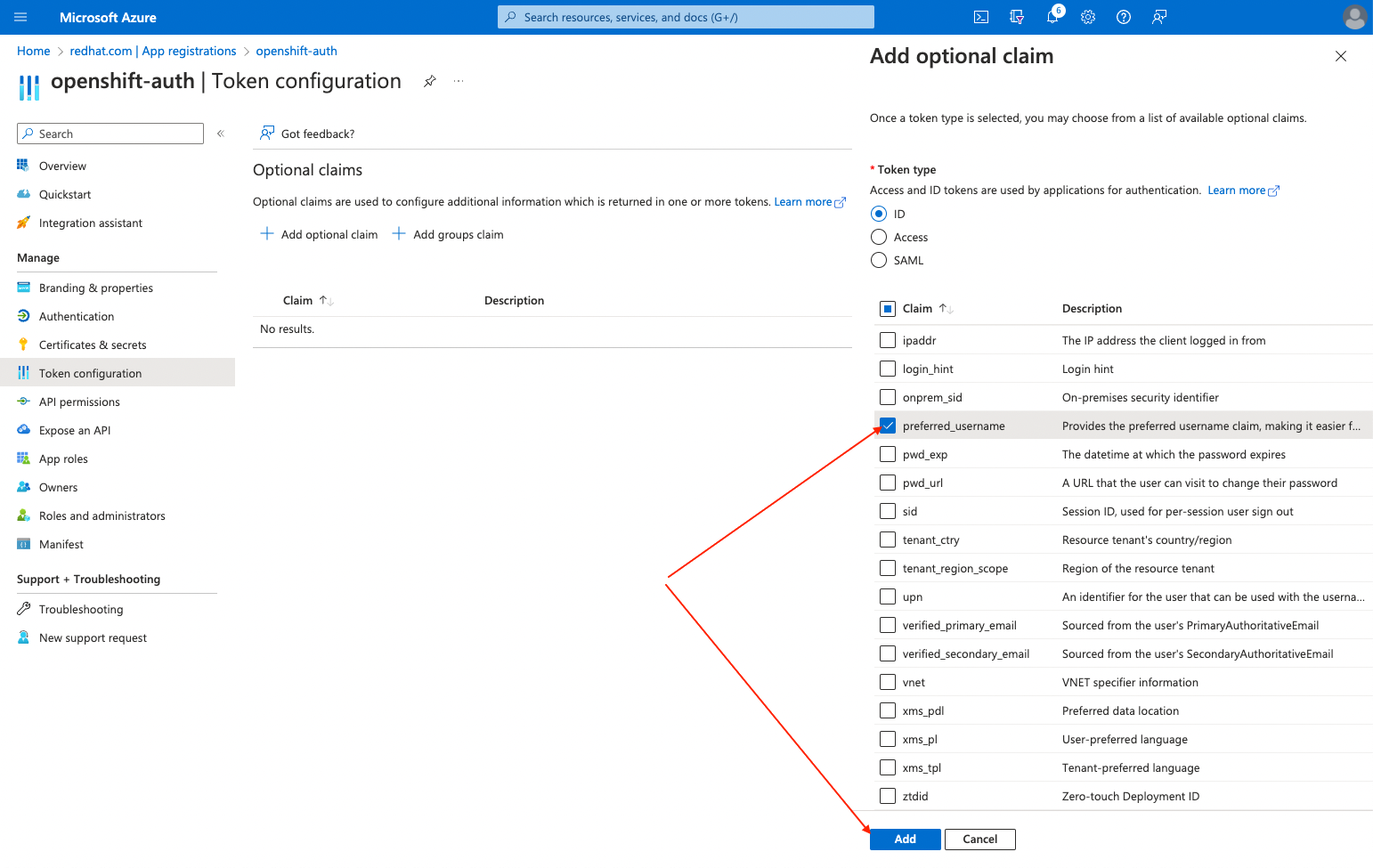

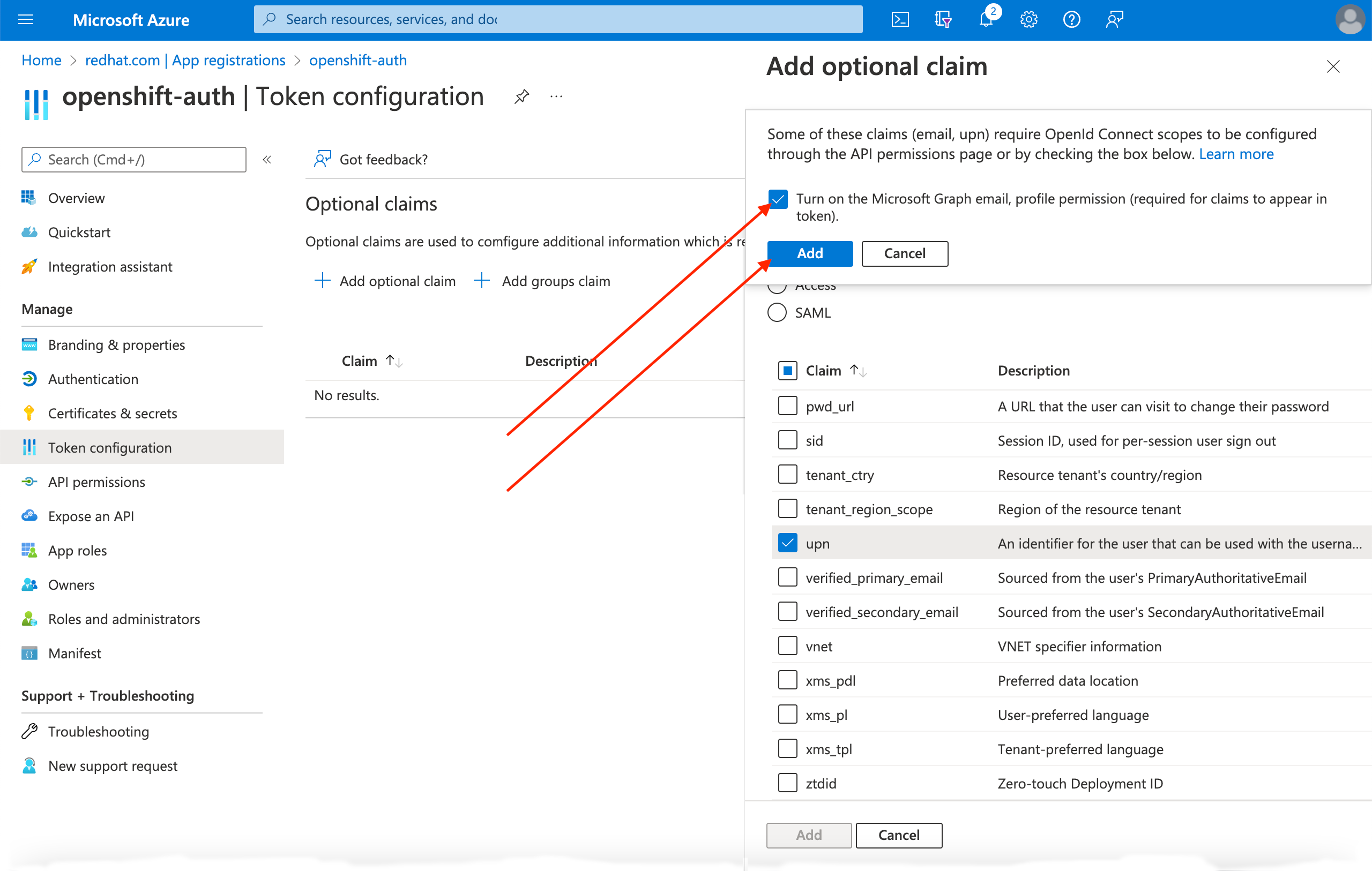

点 Token configuration sub-blade 并选择 Add optional claim 按钮。

选择 ID 单选按钮。

选中 电子邮件 声明复选框。

选中

preferred_username声明复选框。然后,点 Add 来配置 电子邮件和 preferred_username 声明您的 Entra ID 应用程序。

页面的顶部会出现一个对话框。按照提示启用必要的 Microsoft Graph 权限。

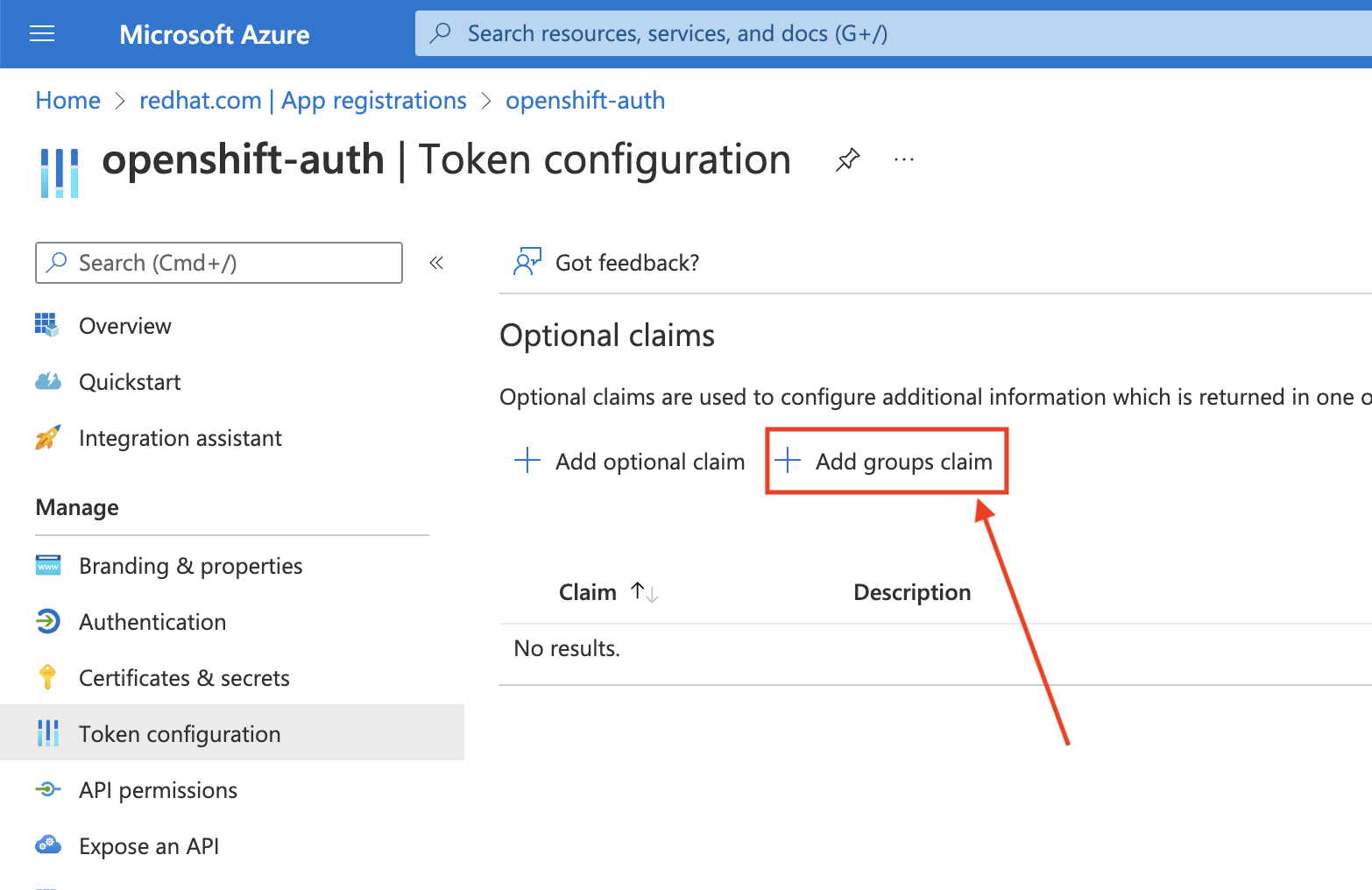

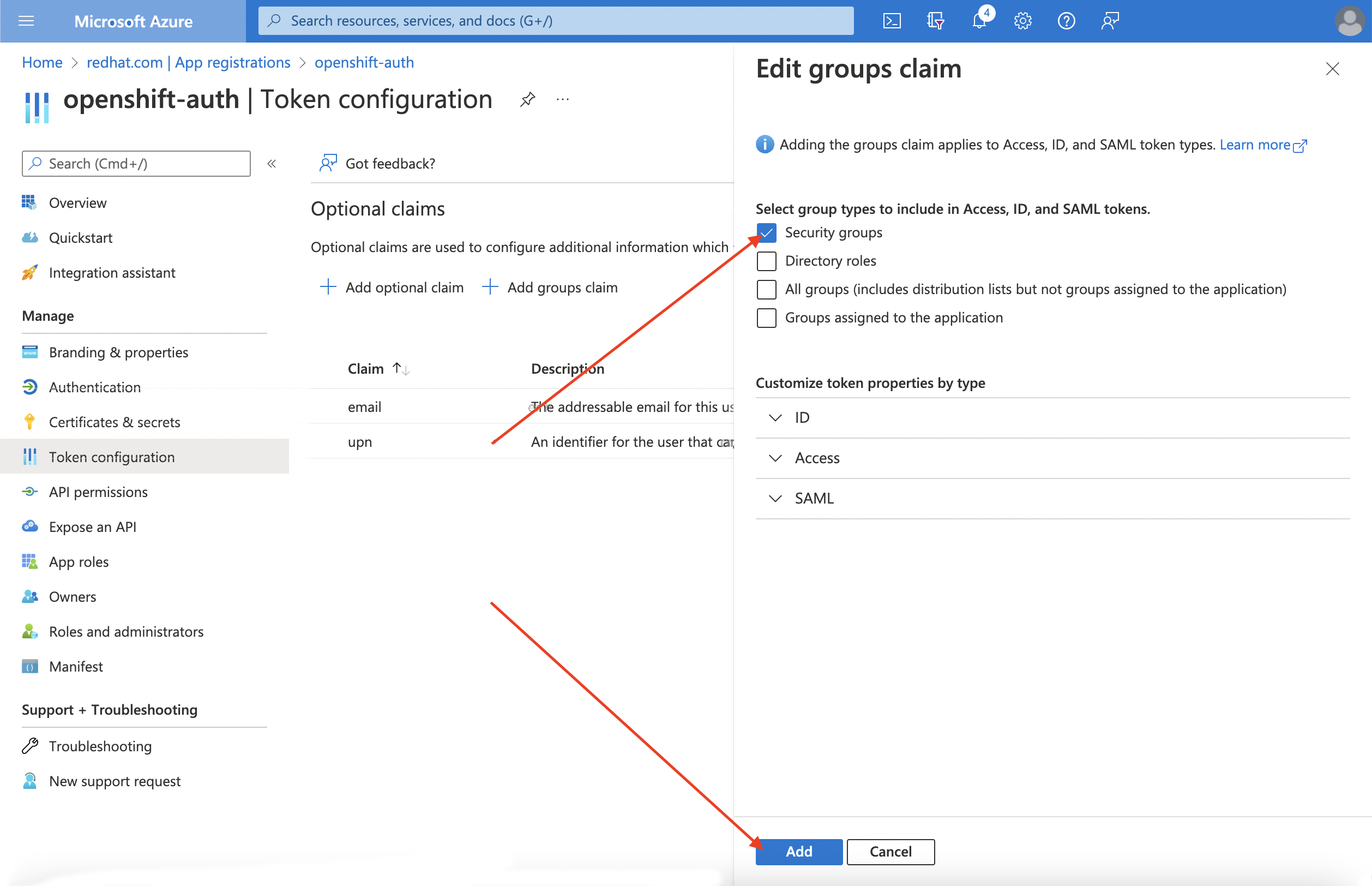

配置组声明(可选)

配置 Entra ID 以提供组声明。

流程

在 Token configuration sub-blade 中点 Add groups claim。

要为您的 Entra ID 应用程序配置组声明,请选择 Security groups,然后点 Add。

注意在本例中,组声明包含用户所属的所有安全组。在真实生产环境中,确保组声明仅包含适用于 Red Hat OpenShift Service on AWS 的组。

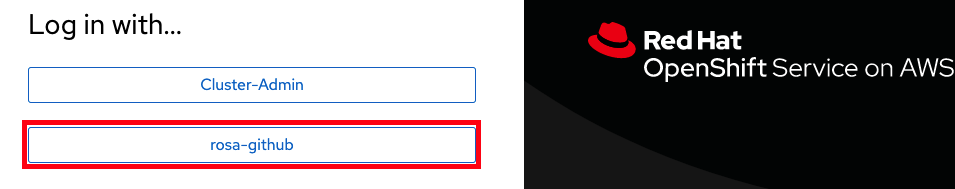

10.4. 配置 Red Hat OpenShift Service on AWS 集群以使用 Entra ID 作为身份提供程序

您必须将 Red Hat OpenShift Service on AWS 配置为使用 Entra ID 作为其身份提供程序。

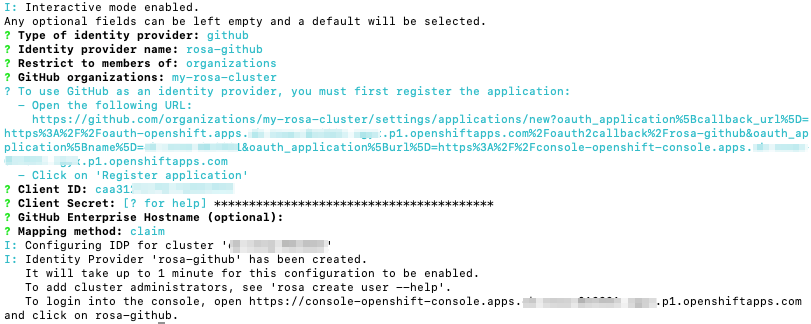

虽然 ROSA 提供了使用 OpenShift Cluster Manager 配置身份提供程序的功能,但 ROSA CLI 使用 ROSA CLI 将集群的 OAuth 供应商配置为使用 Entra ID 作为其身份提供程序。在配置身份提供程序前,为身份提供程序配置设置必要的变量。

流程

运行以下命令来创建变量:

$ CLUSTER_NAME=example-cluster 1 $ IDP_NAME=AAD 2 $ APP_ID=yyyyyyyy-yyyy-yyyy-yyyy-yyyyyyyyyyyy 3 $ CLIENT_SECRET=xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxxxx 4 $ TENANT_ID=zzzzzzzz-zzzz-zzzz-zzzz-zzzzzzzzzzzz 5

运行以下命令来配置集群的 OAuth 提供程序。如果启用了组声明,请确保使用

--group-claims groups参数。如果启用了组声明,请运行以下命令:

$ rosa create idp \ --cluster ${CLUSTER_NAME} \ --type openid \ --name ${IDP_NAME} \ --client-id ${APP_ID} \ --client-secret ${CLIENT_SECRET} \ --issuer-url https://login.microsoftonline.com/${TENANT_ID}/v2.0 \ --email-claims email \ --name-claims name \ --username-claims preferred_username \ --extra-scopes email,profile \ --groups-claims groups如果没有启用组声明,请运行以下命令:

$ rosa create idp \ --cluster ${CLUSTER_NAME} \ --type openid \ --name ${IDP_NAME} \ --client-id ${APP_ID} \ --client-secret ${CLIENT_SECRET} \ --issuer-url https://login.microsoftonline.com/${TENANT_ID}/v2.0 \ --email-claims email \ --name-claims name \ --username-claims preferred_username \ --extra-scopes email,profile

几分钟后,集群身份验证 Operator 会协调您的更改,您可以使用 Entra ID 登录到集群。

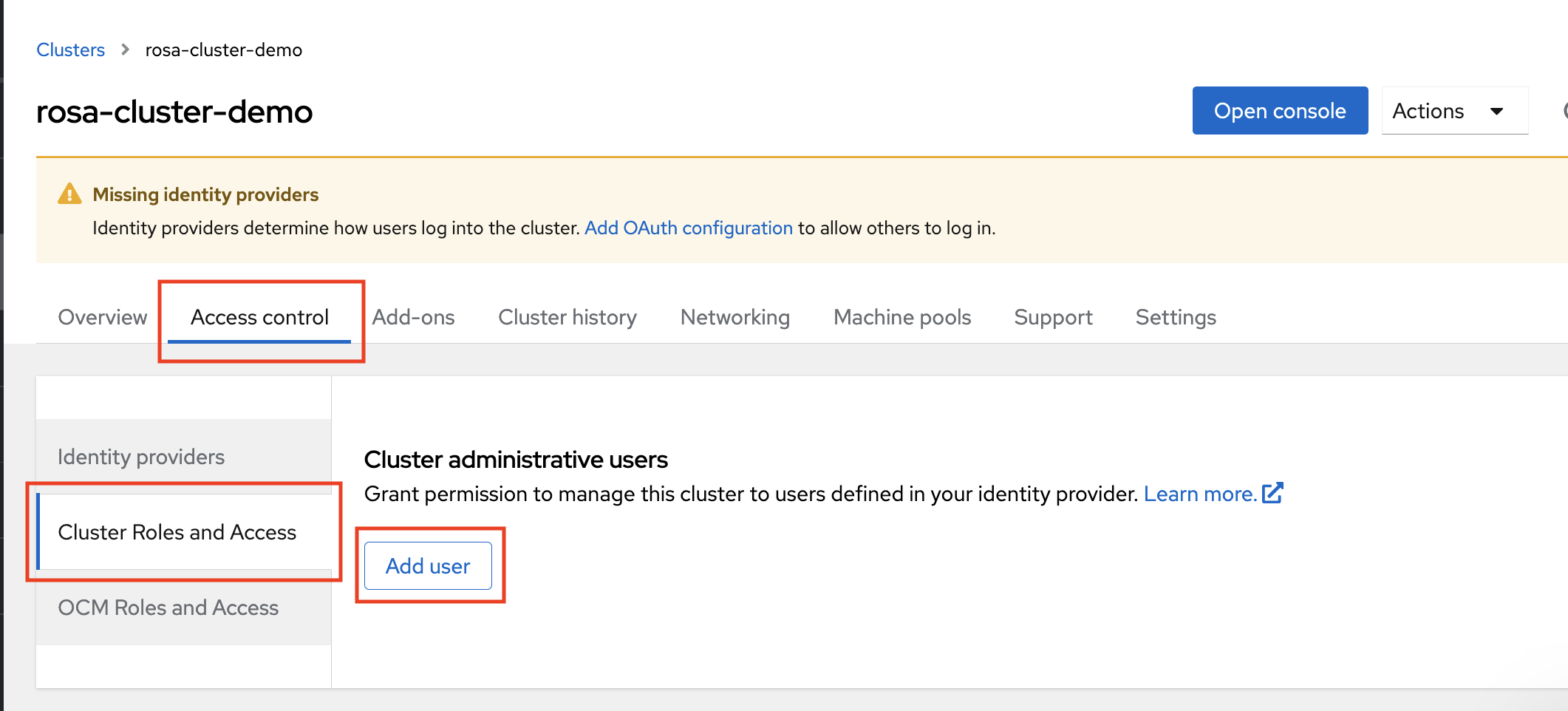

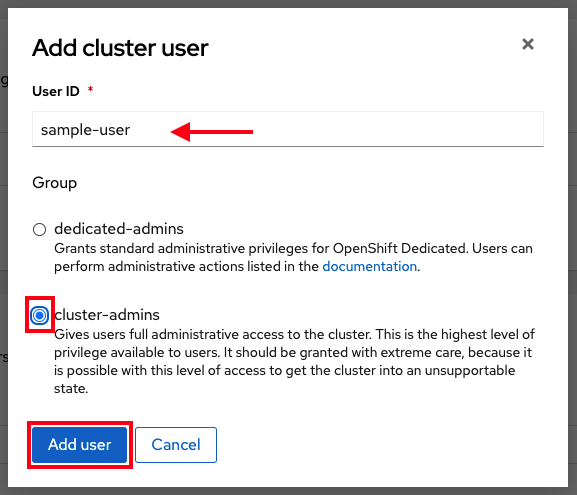

10.5. 为各个用户和组授予额外权限

第一次登录时,您可能会注意到您具有非常有限的权限。默认情况下,Red Hat OpenShift Service on AWS 仅授予您在集群中创建新项目或命名空间的权限。其他项目在视图中受到限制。

您必须向各个用户和组授予这些额外功能。

为单个用户授予额外权限

Red Hat OpenShift Service on AWS 包括大量预配置的角色,包括允许对集群的完整访问权限和控制的 cluster-admin 角色。

流程

运行以下命令,授予用户对

cluster-admin角色的访问权限:$ rosa grant user cluster-admin \ --user=<USERNAME> 1 --cluster=${CLUSTER_NAME}- 1

- 提供您要具有集群管理员权限的 Entra ID 用户名。

为单个组授予额外权限

如果您选择启用组声明,集群 OAuth 供应商将使用组 ID 自动创建或更新用户的组成员资格。集群 OAuth 供应商不会自动为创建的组创建 RoleBindings 和 ClusterRoleBindings,而是负责使用您自己的进程创建这些绑定。

要授予自动生成的对 cluster-admin 角色的组访问权限,您必须为组 ID 创建 ClusterRoleBinding。

流程

运行以下命令来创建

ClusterRoleBinding:$ oc create clusterrolebinding cluster-admin-group \ --clusterrole=cluster-admin \ --group=<GROUP_ID> 1- 1

- 提供您要具有集群管理员权限的 Entra ID 组 ID。

现在,指定组中的任何用户都会自动接收

cluster-admin访问权限。

10.6. 其他资源

有关如何使用 RBAC 在 AWS 中定义和应用权限的更多信息,请参阅 Red Hat OpenShift Service on AWS 文档。

第 11 章 教程: 在带有 STS 的 ROSA 上使用 AWS Secrets Manager CSI

AWS Secret 和配置提供程序(ASCP)提供了一种将 AWS Secret 公开为 Kubernetes 存储卷的方法。使用 ASCP,您可以在 Secrets Manager 中存储和管理您的 secret,然后通过 Red Hat OpenShift Service on AWS (ROSA)上运行的工作负载来检索它们。

11.1. 前提条件

在开始此过程前,请确定您有以下资源和工具:

- 使用 STS 部署的 ROSA 集群

- Helm 3

-

AWSCLI -

ocCLI -

jqCLI

额外的环境要求

运行以下命令登录到您的 ROSA 集群:

$ oc login --token=<your-token> --server=<your-server-url>

您可以通过从 Red Hat OpenShift Cluster Manager 访问 pull secret 来查找您的登录令牌。

运行以下命令,验证集群是否有 STS:

$ oc get authentication.config.openshift.io cluster -o json \ | jq .spec.serviceAccountIssuer

输出示例

"https://xxxxx.cloudfront.net/xxxxx"

如果您的输出不同,请不要继续。在继续此过程前 ,请参阅有关创建 STS 集群的红帽文档。

运行以下命令,将

SecurityContextConstraints权限设置为允许 CSI 驱动程序运行:$ oc new-project csi-secrets-store $ oc adm policy add-scc-to-user privileged \ system:serviceaccount:csi-secrets-store:secrets-store-csi-driver $ oc adm policy add-scc-to-user privileged \ system:serviceaccount:csi-secrets-store:csi-secrets-store-provider-aws运行以下命令,创建环境变量以便稍后使用:

$ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster \ -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export AWS_PAGER=""

11.2. 部署 AWS Secret 和配置提供程序

运行以下命令,使用 Helm 注册 secret 存储 CSI 驱动程序:

$ helm repo add secrets-store-csi-driver \ https://kubernetes-sigs.github.io/secrets-store-csi-driver/charts运行以下命令来更新 Helm 仓库:

$ helm repo update

运行以下命令来安装 secret 存储 CSI 驱动程序:

$ helm upgrade --install -n csi-secrets-store \ csi-secrets-store-driver secrets-store-csi-driver/secrets-store-csi-driver运行以下命令来部署 AWS 供应商:

$ oc -n csi-secrets-store apply -f \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/misc/secrets-store-csi/aws-provider-installer.yaml运行以下命令,检查两个 Daemonsets 是否正在运行:

$ oc -n csi-secrets-store get ds \ csi-secrets-store-provider-aws \ csi-secrets-store-driver-secrets-store-csi-driver运行以下命令,标记 Secrets Store CSI Driver 以允许与受限 pod 安全配置集一起使用:

$ oc label csidriver.storage.k8s.io/secrets-store.csi.k8s.io security.openshift.io/csi-ephemeral-volume-profile=restricted

11.3. 创建 Secret 和 IAM 访问策略

运行以下命令,在 Secret Manager 中创建 secret:

$ SECRET_ARN=$(aws --region "$REGION" secretsmanager create-secret \ --name MySecret --secret-string \ '{"username":"shadowman", "password":"hunter2"}' \ --query ARN --output text) $ echo $SECRET_ARN运行以下命令来创建 IAM 访问策略文档:

$ cat << EOF > policy.json { "Version": "2012-10-17", "Statement": [{ "Effect": "Allow", "Action": [ "secretsmanager:GetSecretValue", "secretsmanager:DescribeSecret" ], "Resource": ["$SECRET_ARN"] }] } EOF运行以下命令来创建 IAM 访问策略:

$ POLICY_ARN=$(aws --region "$REGION" --query Policy.Arn \ --output text iam create-policy \ --policy-name openshift-access-to-mysecret-policy \ --policy-document file://policy.json) $ echo $POLICY_ARN

运行以下命令来创建 IAM 角色信任策略文档:

注意信任策略被锁定到您稍后在此过程中创建的命名空间的默认服务帐户。

$ cat <<EOF > trust-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": ["system:serviceaccount:my-application:default"] } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOF运行以下命令来创建 IAM 角色:

$ ROLE_ARN=$(aws iam create-role --role-name openshift-access-to-mysecret \ --assume-role-policy-document file://trust-policy.json \ --query Role.Arn --output text) $ echo $ROLE_ARN

运行以下命令,将角色附加到策略:

$ aws iam attach-role-policy --role-name openshift-access-to-mysecret \ --policy-arn $POLICY_ARN

11.4. 创建应用程序以使用此 secret

运行以下命令来创建 OpenShift 项目:

$ oc new-project my-application

运行以下命令,注解 default 服务帐户以使用 STS 角色:

$ oc annotate -n my-application serviceaccount default \ eks.amazonaws.com/role-arn=$ROLE_ARN运行以下命令,创建 secret 供应商类以访问我们的 secret:

$ cat << EOF | oc apply -f - apiVersion: secrets-store.csi.x-k8s.io/v1 kind: SecretProviderClass metadata: name: my-application-aws-secrets spec: provider: aws parameters: objects: | - objectName: "MySecret" objectType: "secretsmanager" EOF使用以下命令,使用我们的 secret 创建 Deployment:

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Pod metadata: name: my-application labels: app: my-application spec: volumes: - name: secrets-store-inline csi: driver: secrets-store.csi.k8s.io readOnly: true volumeAttributes: secretProviderClass: "my-application-aws-secrets" containers: - name: my-application-deployment image: k8s.gcr.io/e2e-test-images/busybox:1.29 command: - "/bin/sleep" - "10000" volumeMounts: - name: secrets-store-inline mountPath: "/mnt/secrets-store" readOnly: true EOF运行以下命令,验证 Pod 是否已挂载了 secret:

$ oc exec -it my-application -- cat /mnt/secrets-store/MySecret

11.5. 清理

运行以下命令来删除应用程序:

$ oc delete project my-application

运行以下命令来删除 secret 存储 csi 驱动程序:

$ helm delete -n csi-secrets-store csi-secrets-store-driver

运行以下命令来删除安全性上下文约束:

$ oc adm policy remove-scc-from-user privileged \ system:serviceaccount:csi-secrets-store:secrets-store-csi-driver $ oc adm policy remove-scc-from-user privileged \ system:serviceaccount:csi-secrets-store:csi-secrets-store-provider-aws运行以下命令来删除 AWS 供应商:

$ oc -n csi-secrets-store delete -f \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/misc/secrets-store-csi/aws-provider-installer.yaml

运行以下命令来删除 AWS 角色和策略:

$ aws iam detach-role-policy --role-name openshift-access-to-mysecret \ --policy-arn $POLICY_ARN $ aws iam delete-role --role-name openshift-access-to-mysecret $ aws iam delete-policy --policy-arn $POLICY_ARN运行以下命令来删除 Secrets Manager secret:

$ aws secretsmanager --region $REGION delete-secret --secret-id $SECRET_ARN

第 12 章 教程:在 ROSA 上使用 AWS Controller for Kubernetes

AWS Controller for Kubernetes (ACK)可让您直接从 Red Hat OpenShift Service on AWS (ROSA)定义和使用 AWS 服务资源。使用 ACK,您可以为应用程序利用 AWS 管理的服务,而无需定义集群外的资源,或运行提供集群中数据库或消息队列等支持功能的服务。

您可以直接从 OperatorHub 安装各种 ACK Operator。这样便可轻松开始,并将 Operator 用于您的应用程序。此控制器是 Kubernetes 项目的 AWS Controller 的一个组件,当前处于开发人员预览状态。

使用此教程部署 ACK S3 Operator。您还可以针对集群的 OperatorHub 中的任何其他 ACK Operator 进行调整。

12.1. 前提条件

- ROSA 集群

-

具有

cluster-admin特权的用户帐户 -

OpenShift CLI (

oc) -

Amazon Web Services (AWS) CLI (

aws)

12.2. 设置您的环境

配置以下环境变量,将集群名称更改为适合您的集群:

$ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(rosa describe cluster -c ${ROSA_CLUSTER_NAME} --output json | jq -r .region.id) $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o json | jq -r .spec.serviceAccountIssuer | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export ACK_SERVICE=s3 $ export ACK_SERVICE_ACCOUNT=ack-${ACK_SERVICE}-controller $ export POLICY_ARN=arn:aws:iam::aws:policy/AmazonS3FullAccess $ export AWS_PAGER="" $ export SCRATCH="/tmp/${ROSA_CLUSTER_NAME}/ack" $ mkdir -p ${SCRATCH}在移动到下一部分前,请确定所有字段都正确输出:

$ echo "Cluster: ${ROSA_CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

12.3. 准备 AWS 帐户

为 ACK Operator 创建 AWS Identity Access Management (IAM)信任策略:

$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": "system:serviceaccount:ack-system:${ACK_SERVICE_ACCOUNT}" } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOF为 ACK Operator 创建 AWS IAM 角色,以假设附加

AmazonS3FullAccess策略:注意您可以在每个项目的 GitHub 仓库中找到推荐的策略,例如 https://github.com/aws-controllers-k8s/s3-controller/blob/main/config/iam/recommended-policy-arn。

$ ROLE_ARN=$(aws iam create-role --role-name "ack-${ACK_SERVICE}-controller" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text) $ echo $ROLE_ARN $ aws iam attach-role-policy --role-name "ack-${ACK_SERVICE}-controller" \ --policy-arn ${POLICY_ARN}

12.4. 安装 ACK S3 Controller

创建一个项目,将 ACK S3 Operator 安装到:

$ oc new-project ack-system

使用 ACK S3 Operator 配置创建文件:

注意ACK_WATCH_NAMESPACE被视为空白,以便控制器可以正确地监视集群中的所有命名空间。$ cat <<EOF > "${SCRATCH}/config.txt" ACK_ENABLE_DEVELOPMENT_LOGGING=true ACK_LOG_LEVEL=debug ACK_WATCH_NAMESPACE= AWS_REGION=${REGION} AWS_ENDPOINT_URL= ACK_RESOURCE_TAGS=${CLUSTER_NAME} ENABLE_LEADER_ELECTION=true LEADER_ELECTION_NAMESPACE= EOF使用上一步中的文件来创建 ConfigMap:

$ oc -n ack-system create configmap \ --from-env-file=${SCRATCH}/config.txt ack-${ACK_SERVICE}-user-config从 OperatorHub 安装 ACK S3 Operator:

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: ack-${ACK_SERVICE}-controller namespace: ack-system spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: ack-${ACK_SERVICE}-controller namespace: ack-system spec: channel: alpha installPlanApproval: Automatic name: ack-${ACK_SERVICE}-controller source: community-operators sourceNamespace: openshift-marketplace EOF使用 AWS IAM 角色注解 ACK S3 Operator 服务帐户,以假定和重启部署:

$ oc -n ack-system annotate serviceaccount ${ACK_SERVICE_ACCOUNT} \ eks.amazonaws.com/role-arn=${ROLE_ARN} && \ oc -n ack-system rollout restart deployment ack-${ACK_SERVICE}-controller验证 ACK S3 Operator 是否正在运行:

$ oc -n ack-system get pods

输出示例

NAME READY STATUS RESTARTS AGE ack-s3-controller-585f6775db-s4lfz 1/1 Running 0 51s

12.5. 验证部署

部署 S3 存储桶资源:

$ cat << EOF | oc apply -f - apiVersion: s3.services.k8s.aws/v1alpha1 kind: Bucket metadata: name: ${CLUSTER-NAME}-bucket namespace: ack-system spec: name: ${CLUSTER-NAME}-bucket EOF验证 AWS 中 S3 存储桶是否已创建:

$ aws s3 ls | grep ${CLUSTER_NAME}-bucket输出示例

2023-10-04 14:51:45 mrmc-test-maz-bucket

12.6. 清理

删除 S3 存储桶资源:

$ oc -n ack-system delete bucket.s3.services.k8s.aws/${CLUSTER-NAME}-bucket删除 ACK S3 Operator 和 AWS IAM 角色:

$ oc -n ack-system delete subscription ack-${ACK_SERVICE}-controller $ aws iam detach-role-policy \ --role-name "ack-${ACK_SERVICE}-controller" \ --policy-arn ${POLICY_ARN} $ aws iam delete-role \ --role-name "ack-${ACK_SERVICE}-controller"删除

ack-system项目:$ oc delete project ack-system

第 13 章 教程:在 ROSA 上部署外部 DNS Operator

从 Red Hat OpenShift Service on AWS 4.14 开始,自定义域 Operator 已被弃用。要在 AWS 4.14 上的 Red Hat OpenShift Service 中管理 Ingress,请使用 Ingress Operator。对于 Red Hat OpenShift Service on AWS 4.13 及更早的版本,这个功能不会改变。

配置 Custom Domain Operator 需要 Amazon Route 53 托管区域中的通配符 CNAME DNS 记录。如果您不想使用通配符记录,您可以使用 External DNS Operator 为路由创建单独的条目。

本教程使用 Red Hat OpenShift Service on AWS (ROSA)中的自定义域部署和配置 外部 DNS Operator。

External DNS Operator 不支持使用 IAM 角色用于服务帐户(IRSA)的 STS,并使用长期的 Identity Access Management (IAM)凭证。当 Operator 支持 STS 时,将更新本教程。

13.1. 前提条件

- ROSA 集群

-

具有

dedicated-admin特权的用户帐户 -

OpenShift CLI (

oc) -

Amazon Web Services (AWS) CLI (

aws) -

唯一的域,如 If

apps.<company_name>.io - 以上域的 Amazon Route 53 公共托管区

13.2. 设置您的环境

配置以下环境变量,将

CLUSTER_NAME替换为集群的名称:$ export DOMAIN=apps.<company_name>.io 1 $ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/external-dns" $ mkdir -p ${SCRATCH}- 1

- 自定义域。

在移动到下一部分前,请确定所有字段都正确输出:

$ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, AWS Account ID: ${AWS_ACCOUNT_ID}"

13.3. 设置自定义域

ROSA 使用 Custom Domain Operator 管理辅助 Ingress Controller。使用以下步骤使用自定义域部署二级 Ingress Controller。

前提条件

-

唯一的域,如 If

apps.<company_name>.io -

自定义 SAN 或通配符证书,如

CNcategories.apps.<company_name>.io

流程

创建一个新项目

$ oc new-project external-dns-operator

从私钥和公共证书创建一个新的 TLS secret,其中

fullchain.pem是您的完整的通配符证书链(包括任何中间)和privkey.pem是您的通配符证书:$ oc -n external-dns-operator create secret tls external-dns-tls --cert=fullchain.pem --key=privkey.pem

创建新的

CustomDomain自定义资源(CR):external-dns-custom-domain.yaml示例apiVersion: managed.openshift.io/v1alpha1 kind: CustomDomain metadata: name: external-dns spec: domain: apps.<company_name>.io 1 scope: External loadBalancerType: NLB certificate: name: external-dns-tls namespace: external-dns-operator- 1

- 自定义域。

应用 CR:

$ oc apply -f external-dns-custom-domain.yaml

验证您的自定义域 Ingress Controller 是否已部署并处于

Ready状态:$ oc get customdomains

输出示例

NAME ENDPOINT DOMAIN STATUS external-dns xxrywp.<company_name>.cluster-01.opln.s1.openshiftapps.com *.apps.<company_name>.io Ready

13.4. 准备 AWS 帐户

检索 Amazon Route 53 公共托管区 ID:

$ export ZONE_ID=$(aws route53 list-hosted-zones-by-name --output json \ --dns-name "${DOMAIN}." --query 'HostedZones[0]'.Id --out text | sed 's/\/hostedzone\///')创建一个 AWS IAM 策略文档,允许

外部 DNSOperator 仅 更新自定义域公共托管区:$ cat << EOF > "${SCRATCH}/external-dns-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "route53:ChangeResourceRecordSets" ], "Resource": [ "arn:aws:route53:::hostedzone/${ZONE_ID}" ] }, { "Effect": "Allow", "Action": [ "route53:ListHostedZones", "route53:ListResourceRecordSets" ], "Resource": [ "*" ] } ] } EOF创建 AWS IAM 策略:

$ export POLICY_ARN=$(aws iam create-policy --policy-name "${CLUSTER_NAME}-AllowExternalDNSUpdates" \ --policy-document file://${SCRATCH}/external-dns-policy.json \ --query 'Policy.Arn' --output text)创建 AWS IAM 用户:

$ aws iam create-user --user-name "${CLUSTER_NAME}-external-dns-operator"附加策略:

$ aws iam attach-user-policy --user-name "${CLUSTER_NAME}-external-dns-operator" --policy-arn $POLICY_ARN注意这将在以后的版本中使用 IRSA 改为 STS。

为 IAM 用户创建 AWS 密钥:

$ SECRET_ACCESS_KEY=$(aws iam create-access-key --user-name "${CLUSTER_NAME}-external-dns-operator")创建静态凭证:

$ cat << EOF > "${SCRATCH}/credentials" [default] aws_access_key_id = $(echo $SECRET_ACCESS_KEY | jq -r '.AccessKey.AccessKeyId') aws_secret_access_key = $(echo $SECRET_ACCESS_KEY | jq -r '.AccessKey.SecretAccessKey') EOF

13.5. 安装 External DNS Operator

从 OperatorHub 安装

外部 DNSOperator:$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: external-dns-group namespace: external-dns-operator spec: targetNamespaces: - external-dns-operator --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: external-dns-operator namespace: external-dns-operator spec: channel: stable-v1.1 installPlanApproval: Automatic name: external-dns-operator source: redhat-operators sourceNamespace: openshift-marketplace EOF

等待

外部 DNSOperator 正在运行:$ oc rollout status deploy external-dns-operator --timeout=300s

从 AWS IAM 用户凭证创建 secret:

$ oc -n external-dns-operator create secret generic external-dns \ --from-file "${SCRATCH}/credentials"部署

ExternalDNS控制器:$ cat << EOF | oc apply -f - apiVersion: externaldns.olm.openshift.io/v1beta1 kind: ExternalDNS metadata: name: ${DOMAIN} spec: domains: - filterType: Include matchType: Exact name: ${DOMAIN} provider: aws: credentials: name: external-dns type: AWS source: openshiftRouteOptions: routerName: external-dns type: OpenShiftRoute zones: - ${ZONE_ID} EOF等待控制器运行:

$ oc rollout status deploy external-dns-${DOMAIN} --timeout=300s

13.6. 部署示例应用程序

现在 ExternalDNS 控制器正在运行,您可以部署一个示例应用程序,以确认在公开新路由时配置了自定义域并信任。

为您的示例应用程序创建一个新项目:

$ oc new-project hello-world

部署 hello world 应用:

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

为应用程序创建指定自定义域名的路由:

$ oc -n hello-world create route edge --service=hello-openshift hello-openshift-tls \ --hostname hello-openshift.${DOMAIN}检查 ExternalDNS 会自动创建 DNS 记录:

注意记录可能需要几分钟时间才会出现在 Amazon Route 53 中。

$ aws route53 list-resource-record-sets --hosted-zone-id ${ZONE_ID} \ --query "ResourceRecordSets[?Type == 'CNAME']" | grep hello-openshift可选: 您还可以查看 ExternalDNS 创建的 TXT 记录:

$ aws route53 list-resource-record-sets --hosted-zone-id ${ZONE_ID} \ --query "ResourceRecordSets[?Type == 'TXT']" | grep ${DOMAIN}在您看到 OpenShift 登录的浏览器中导航到自定义控制台域:

$ echo console.${DOMAIN}

第 14 章 教程:在 ROSA 上使用 cert-manager Operator 动态发布证书

虽然通配符证书通过保护给定域的所有第一级子域和单个证书提供简单性,但其他用例可能需要为每个域使用单个证书。

了解如何使用 cert-manager Operator for Red Hat OpenShift,Let's Encrypt 为使用自定义域创建的路由动态发布证书。

14.1. 前提条件

- ROSA 集群

-

具有

cluster-admin特权的用户帐户 -

OpenShift CLI (

oc) -

Amazon Web Services (AWS) CLI (

aws) -

唯一的域,如 If

apps.<company_name>.io - 以上域的 Amazon Route 53 公共托管区

14.2. 设置您的环境

配置以下环境变量:

$ export DOMAIN=apps.<company_name>.io 1 $ export EMAIL=<youremail@company_name.io> 2 $ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o json | jq -r .spec.serviceAccountIssuer | sed 's|^https://||') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/dynamic-certs" $ mkdir -p ${SCRATCH}

在移动到下一部分前,请确定所有字段都正确输出:

$ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

14.3. 准备 AWS 帐户

当 cert-manager 从 Let's Encrypt (或其他 ACME 证书签发者)请求证书时,Let 的 Encrypt 服务器会验证您是否使用 质询 控制该证书中的域名。在本教程中,您使用 DNS-01 质询,它证明您通过在域名下将特定值放在 TXT 记录中来控制您的域名的 DNS。这一切都由 cert-manager 自动完成。要允许 cert-manager 权限为您的域修改 Amazon Route 53 公共托管区,您需要创建一个具有特定策略权限的 Identity Access Management (IAM)角色,以及允许访问 pod 的信任关系。

本教程中使用的公共托管区与 ROSA 集群位于同一个 AWS 帐户。如果您的公共托管区位于不同的帐户中,则需要执行一些额外的步骤来 跨 帐户访问。

检索 Amazon Route 53 公共托管区 ID:

注意此命令查找与之前作为

DOMAIN环境变量指定的自定义域匹配的公共托管区。您可以通过运行export ZONE_ID=<zone_ID> 来手动指定 Amazon Route 53 公共托管区,将 <zone_ID> 替换为您的特定的 Amazon Route 53 公共托管区 ID。$ export ZONE_ID=$(aws route53 list-hosted-zones-by-name --output json \ --dns-name "${DOMAIN}." --query 'HostedZones[0]'.Id --out text | sed 's/\/hostedzone\///')为

cert-managerOperator 创建 AWS IAM 策略文档,它提供 仅 更新指定的公共托管区:$ cat <<EOF > "${SCRATCH}/cert-manager-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": "route53:GetChange", "Resource": "arn:aws:route53:::change/*" }, { "Effect": "Allow", "Action": [ "route53:ChangeResourceRecordSets", "route53:ListResourceRecordSets" ], "Resource": "arn:aws:route53:::hostedzone/${ZONE_ID}" }, { "Effect": "Allow", "Action": "route53:ListHostedZonesByName", "Resource": "*" } ] } EOF使用您在上一步中创建的文件创建 IAM 策略:

$ POLICY_ARN=$(aws iam create-policy --policy-name "${CLUSTER_NAME}-cert-manager-policy" \ --policy-document file://${SCRATCH}/cert-manager-policy.json \ --query 'Policy.Arn' --output text)为

cert-managerOperator 创建 AWS IAM 信任策略:$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": "system:serviceaccount:cert-manager:cert-manager" } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOF使用您在上一步中创建的信任策略为

cert-managerOperator 创建 IAM 角色:$ ROLE_ARN=$(aws iam create-role --role-name "${CLUSTER_NAME}-cert-manager-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text)将权限策略附加到角色:

$ aws iam attach-role-policy --role-name "${CLUSTER_NAME}-cert-manager-operator" \ --policy-arn ${POLICY_ARN}

14.4. 安装 cert-manager Operator

创建一个项目,将

cert-managerOperator 安装到:$ oc new-project cert-manager-operator

重要不要试图在集群中使用多个

cert-managerOperator。如果在集群中安装了社区cert-managerOperator,则必须在为 Red Hat OpenShift 安装cert-managerOperator 前卸载它。为 Red Hat OpenShift 安装

cert-managerOperator:$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: openshift-cert-manager-operator-group namespace: cert-manager-operator spec: targetNamespaces: - cert-manager-operator --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: openshift-cert-manager-operator namespace: cert-manager-operator spec: channel: stable-v1 installPlanApproval: Automatic name: openshift-cert-manager-operator source: redhat-operators sourceNamespace: openshift-marketplace EOF

注意此 Operator 需要几分钟时间来安装并完成它的设置。

验证

cert-managerOperator 是否正在运行:$ oc -n cert-manager-operator get pods

输出示例

NAME READY STATUS RESTARTS AGE cert-manager-operator-controller-manager-84b8799db5-gv8mx 2/2 Running 0 12s

使用之前创建的 AWS IAM 角色注解

cert-managerpod 使用的服务帐户:$ oc -n cert-manager annotate serviceaccount cert-manager eks.amazonaws.com/role-arn=${ROLE_ARN}运行以下命令重启现有的

cert-manager控制器 pod:$ oc -n cert-manager delete pods -l app.kubernetes.io/name=cert-manager

修补 Operator 配置以使用外部名称服务器以防止 DNS-01 质询问题:

$ oc patch certmanager.operator.openshift.io/cluster --type merge \ -p '{"spec":{"controllerConfig":{"overrideArgs":["--dns01-recursive-nameservers-only","--dns01-recursive-nameservers=1.1.1.1:53"]}}}'运行以下命令,创建一个

ClusterIssuer资源以使用 Let 的 Encrypt :$ cat << EOF | oc apply -f - apiVersion: cert-manager.io/v1 kind: ClusterIssuer metadata: name: letsencrypt-production spec: acme: server: https://acme-v02.api.letsencrypt.org/directory email: ${EMAIL} # This key doesn't exist, cert-manager creates it privateKeySecretRef: name: prod-letsencrypt-issuer-account-key solvers: - dns01: route53: hostedZoneID: ${ZONE_ID} region: ${REGION} secretAccessKeySecretRef: name: '' EOF验证

ClusterIssuer资源是否已就绪:$ oc get clusterissuer.cert-manager.io/letsencrypt-production

输出示例

NAME READY AGE letsencrypt-production True 47s

14.5. 创建自定义域 Ingress Controller

创建一个新项目

$ oc new-project custom-domain-ingress

创建并配置证书资源来为自定义域 Ingress Controller 置备证书:

注意以下示例使用单个域证书。还支持 SAN 和通配符证书。

$ cat << EOF | oc apply -f - apiVersion: cert-manager.io/v1 kind: Certificate metadata: name: custom-domain-ingress-cert namespace: custom-domain-ingress spec: secretName: custom-domain-ingress-cert-tls issuerRef: name: letsencrypt-production kind: ClusterIssuer commonName: "${DOMAIN}" dnsNames: - "${DOMAIN}" EOF验证证书是否已发布:

注意Let's Encrypt 发布此证书需要几分钟时间。如果超过 5 分钟,请运行

oc -n custom-domain-ingress describe certificate.cert-manager.io/custom-domain-ingress-cert来查看 cert-manager 报告的任何问题。$ oc -n custom-domain-ingress get certificate.cert-manager.io/custom-domain-ingress-cert

输出示例

NAME READY SECRET AGE custom-domain-ingress-cert True custom-domain-ingress-cert-tls 9m53s

创建新的

CustomDomain自定义资源(CR):$ cat << EOF | oc apply -f - apiVersion: managed.openshift.io/v1alpha1 kind: CustomDomain metadata: name: custom-domain-ingress spec: domain: ${DOMAIN} scope: External loadBalancerType: NLB certificate: name: custom-domain-ingress-cert-tls namespace: custom-domain-ingress EOF验证您的自定义域 Ingress Controller 是否已部署并处于

Ready状态:$ oc get customdomains

输出示例

NAME ENDPOINT DOMAIN STATUS custom-domain-ingress tfoxdx.custom-domain-ingress.cluster.1234.p1.openshiftapps.com example.com Ready

准备带有所需 DNS 更改的文档,为您的自定义域 Ingress Controller 启用 DNS 解析:

$ INGRESS=$(oc get customdomain.managed.openshift.io/custom-domain-ingress --template={{.status.endpoint}}) $ cat << EOF > "${SCRATCH}/create-cname.json" { "Comment":"Add CNAME to custom domain endpoint", "Changes":[{ "Action":"CREATE", "ResourceRecordSet":{ "Name": "*.${DOMAIN}", "Type":"CNAME", "TTL":30, "ResourceRecords":[{ "Value": "${INGRESS}" }] } }] } EOF提交您对 Amazon Route 53 的更改以进行传播: