チュートリアル

Red Hat OpenShift Service on AWS のチュートリアル

概要

第1章 チュートリアルの概要

マネージド OpenShift クラスターを最大限に活用するのに役立つ、Red Hat のエキスパートによるステップバイステップのチュートリアルです。

クラウドエキスパートによるこのチュートリアルコンテンツの一部は、迅速な提供のために、サポート対象のすべての構成でテストされていない場合があります。

第2章 チュートリアル: ROSA with HCP のアクティベーションとアカウントのリンク

このチュートリアルでは、最初のクラスターをデプロイする前に、Hosted Control Plane (HCP) を使用して Red Hat OpenShift Service on AWS (ROSA) をアクティブ化し、AWS アカウントにリンクするプロセスについて説明します。

製品のプライベートオファーを受け取っている場合、このチュートリアルを始める前に、プライベートオファーに記載されている手順に従ってください。プライベートオファーは、製品がすでにアクティブ化されている場合 (この場合はアクティブなサブスクリプションを置き換えます)、また初めてアクティブ化する場合に利用できるように設計されています。

2.1. 前提条件

- 前の手順で ROSA with HCP をアクティブ化した AWS アカウントに関連付ける予定の Red Hat アカウントにログインしてください。

- Red Hat アカウントに関連付けることができるのは、サービスの請求に使用される AWS アカウント 1 つのみです。通常、個々の AWS エンドユーザーアカウントではなく、開発者アカウントなどの他の AWS アカウントがリンクされている組織の AWS アカウントが請求の対象となります。

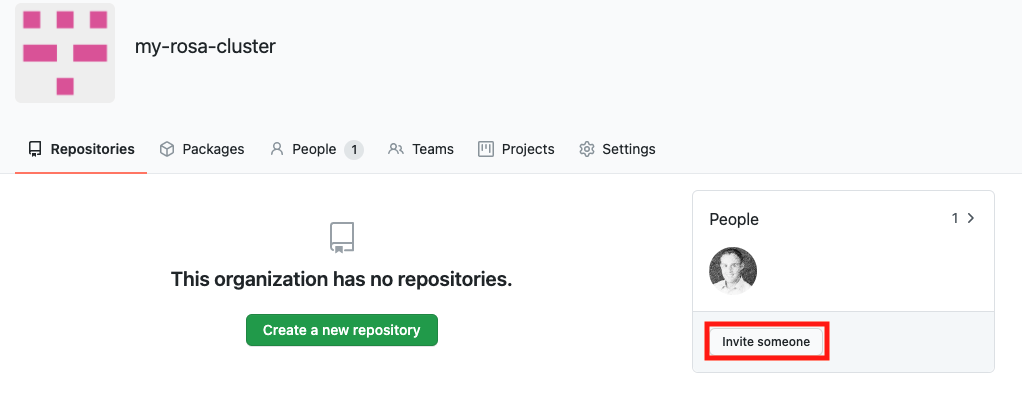

- 同じ Red Hat 組織に属する Red Hat アカウントは、同じ AWS アカウントにリンクされます。したがって、ROSA with HCP クラスターの作成にアクセスできるユーザーを Red Hat 組織アカウントレベルで管理できます。

2.2. サブスクリプションの有効化と AWS アカウントのセットアップ

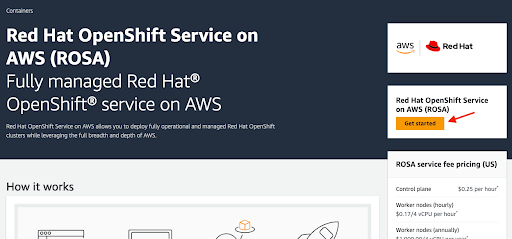

AWS コンソールページで Get started ボタンをクリックして、ROSA with HCP 製品をアクティブ化します。

以前に ROSA をアクティブ化したが、プロセスを完了していない場合は、ボタンをクリックして、次の手順で説明するようにアカウントのリンクを完了できます。

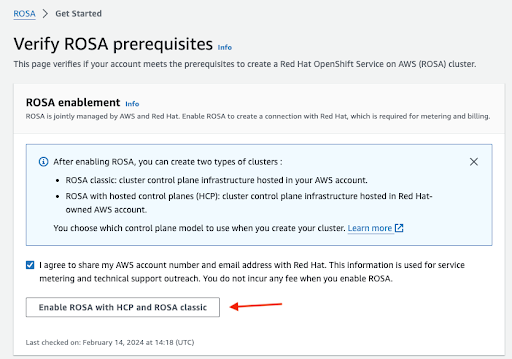

連絡先情報を Red Hat と共有することを確認し、サービスを有効にします。

- このステップでサービスを有効にしても料金は発生しません。課金と計測が連携されるのは、最初のクラスターをデプロイした後のみです。これには数分かかる場合があります。

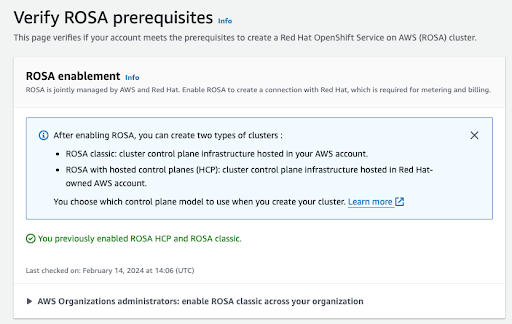

プロセスが完了すると、確認メッセージが表示されます。

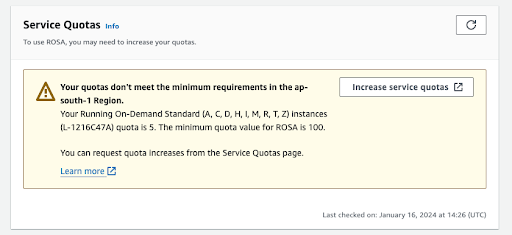

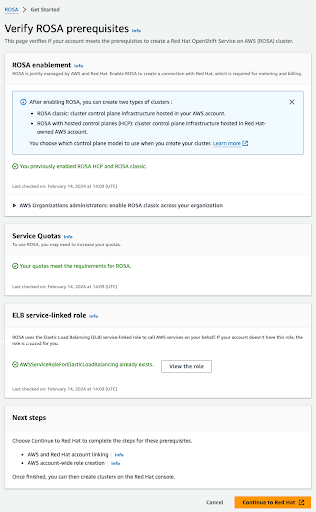

この検証ページの他のセクションには、追加の前提条件 (が満たされているかどうか) のステータスが表示されます。これらの前提条件のいずれかが満たされていない場合は、それぞれのメッセージが表示されます。選択したリージョンで割り当てが不十分な例を次に示します。

- Increase service quotas ボタンをクリックするか、Learn more リンクを使用して、サービスクォータの管理方法に関する詳細情報を取得します。クォータが不十分な場合、クォータはリージョン固有であることに注意してください。Web コンソールの右上隅にあるリージョンスイッチャーを使用して、関心のあるリージョンのクォータチェックを再実行し、必要に応じてサービスクォータの増加リクエストを送信できます。

すべての前提条件が満たされている場合、ページは次のようになります。

ELB サービスにリンクされたロールは自動的に作成されます。青色の小さな Info リンクをクリックすると、状況に応じたヘルプやリソースが表示されます。

2.3. AWS と Red Hat のアカウントとサブスクリプションのリンク

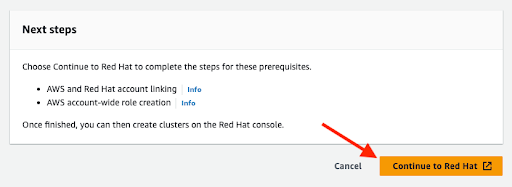

オレンジ色の Continue to Red Hat ボタンをクリックして、アカウントのリンクを続行します。

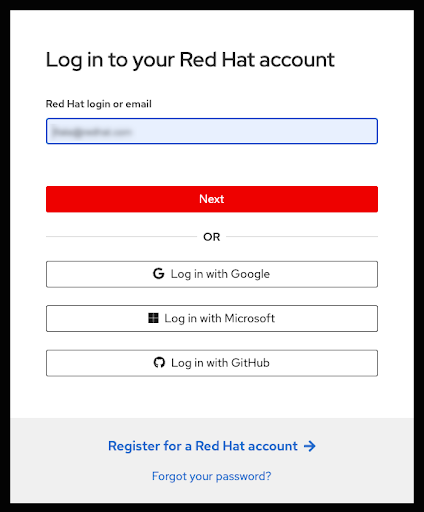

現在のブラウザーのセッションで Red Hat アカウントにまだログインしていない場合は、アカウントにログインするように求められます。

- このページでは、新しい Red Hat アカウントに登録したり、パスワードをリセットしたりすることもできます。

- 前の手順で ROSA with HCP をアクティブ化した AWS アカウントに関連付ける予定の Red Hat アカウントにログインしてください。

- Red Hat アカウントに関連付けることができるのは、サービスの請求に使用される AWS アカウント 1 つのみです。通常、個々の AWS エンドユーザーアカウントではなく、開発者アカウントなどの他の AWS アカウントがリンクされている組織の AWS アカウントが請求の対象となります。

- 同じ Red Hat 組織に属する Red Hat アカウントは、同じ AWS アカウントにリンクされます。したがって、ROSA with HCP クラスターの作成にアクセスできるユーザーを Red Hat 組織アカウントレベルで管理できます。

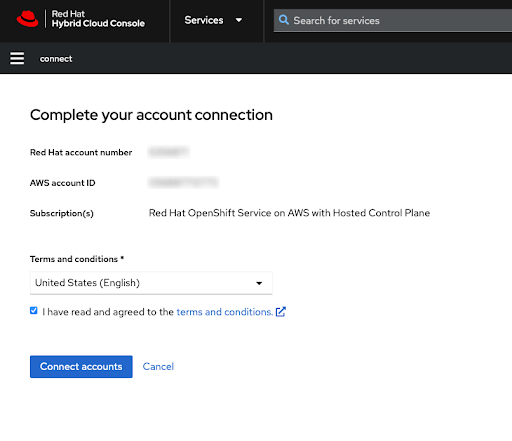

利用規約を確認した後、Red Hat アカウントの連携を完了させます。

注記このステップは、ログインしている Red Hat アカウント、または Red Hat アカウントを管理する Red Hat 組織が以前に AWS アカウントにリンクされていない場合にのみ使用できます。

Red Hat と AWS の両方のアカウント番号がこの画面に表示されます。

サービス規約に同意する場合は、Connect accounts ボタンをクリックします。

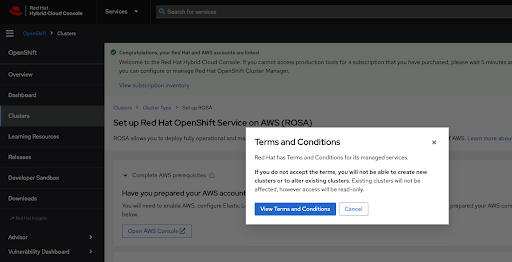

Red Hat Hybrid Cloud Console を初めて使用する場合は、最初の ROSA クラスターを作成する前に、一般的なマネージドサービスの利用規約に同意するよう求められます。

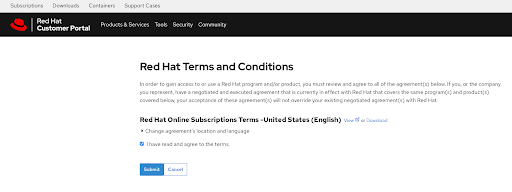

View Terms and Conditions ボタンをクリックすると、確認して同意する必要がある追加の規約が表示されます。

この時点で追加の条件を確認し、プロンプトが表示されたら同意を確定します。

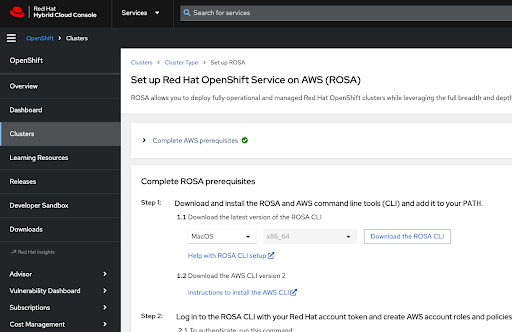

Hybrid Cloud Console は、AWS の前提条件に対応済みであることを認識し、クラスターデプロイメントに必要な最初の手順がリストされます。

次の手順は、クラスターの技術的なデプロイメントに関連するものです。

- これらの手順は、サービスの有効化とアカウントのリンクが完了したマシンとは別のマシンで実行される可能性があります。

前述したように、Red Hat アカウントが、ROSA サービスをアクティブ化した AWS アカウントにリンクされた Red Hat 組織に属する場合は、クラスターの作成権限があり、以前に Red Hat 組織にリンクされていた請求 AWS アカウントを選択できます。

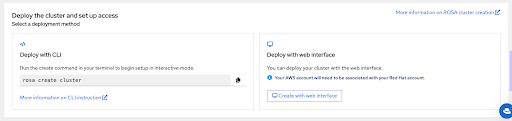

このページの最後のセクションでは、

rosaCLI または Web コンソールを使用したクラスターデプロイメントオプションを示します。

-

次の手順では、

rosaCLI を使用したクラスターデプロイメントについて説明します。 -

Web コンソールのみを使用したデプロイメントを行う場合は、ROSA with HCP cluster deployment using the web console セクションまでスキップできます。ただし、アカウントロールの作成など、特定のタスクには

rosaCLI が必要であることに注意してください。ROSA を初めてデプロイする場合は、rosa whoamiコマンドを実行するまで、この CLI の手順に従い、その後はスキップして Web コンソールのデプロイメント手順を実行してください。

2.4. CLI を使用した ROSA with HCP クラスターのデプロイメント

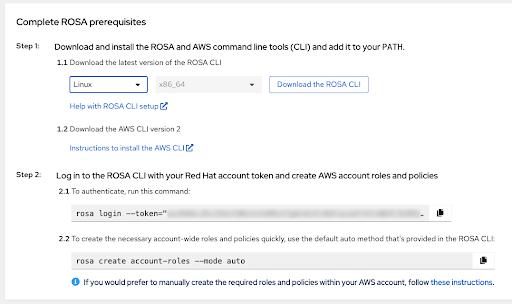

Download the ROSA CLI ボタンをクリックして、オペレーティングシステム用の ROSA コマンドラインインターフェイス (CLI) をダウンロードし、Help with ROSA CLI setup の説明に従ってセットアップします。

重要最新の AWS CLI がインストールされていることを確認してください。詳細は AWS CLI をインストールする手順 を参照してください。

-

前の手順が完了したら、

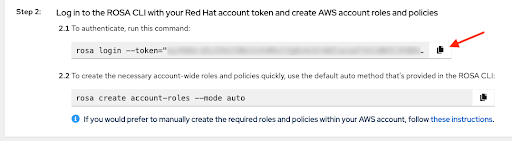

rosa versionを実行して、両方の CLI が使用できることを確認できます。このコマンドは、ターミナルで古いバージョンとaws –versionコマンドを使用している場合に更新通知を表示します。 ROSA with HCP クラスターを作成するための前提条件は、Web コンソールで

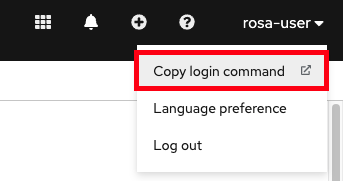

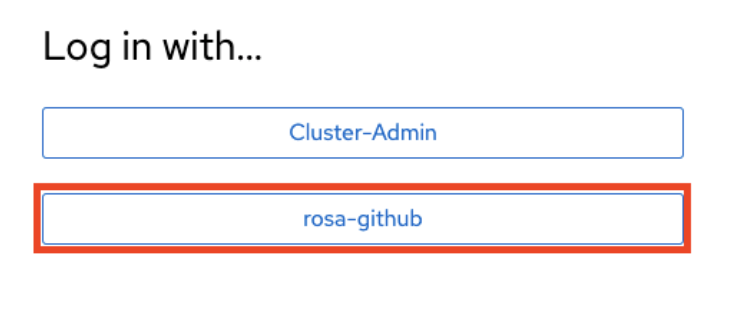

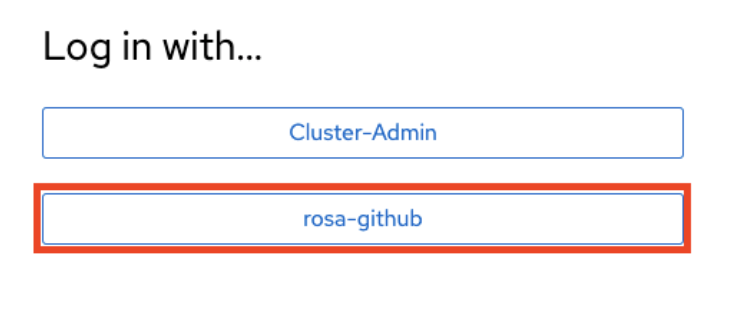

rosacli を使用して、一意のトークンで独自のコマンドを実行し、ログインしてください。この説明は、2.1To authenticate, run this command を参照してください。copy ボタンを使用すると、完全なトークンを含むコマンドを簡単にコピーしてターミナルに貼り付けることができます。

独自のトークンを共有しないでください。

-

初めてクラスターをデプロイするための最後の前提条件として、必要とされるアカウント全体のロールおよびポリシーを作成します。

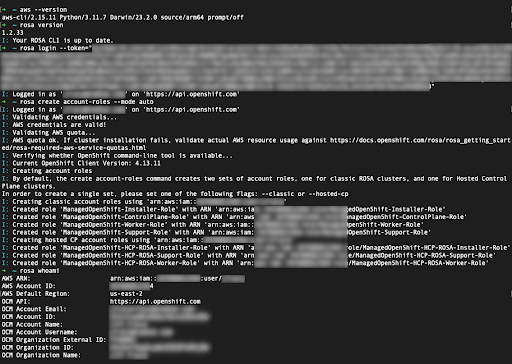

rosaCLI で、該当するコマンドを使用できます。方法は、2.2必要とされるアカウント全体のロールおよびポリシーを素早く作成する方法 を参照してください。これに代わる方法は、これらのロールとポリシーを手動で作成することです。 ログインし、アカウントロールを作成して、

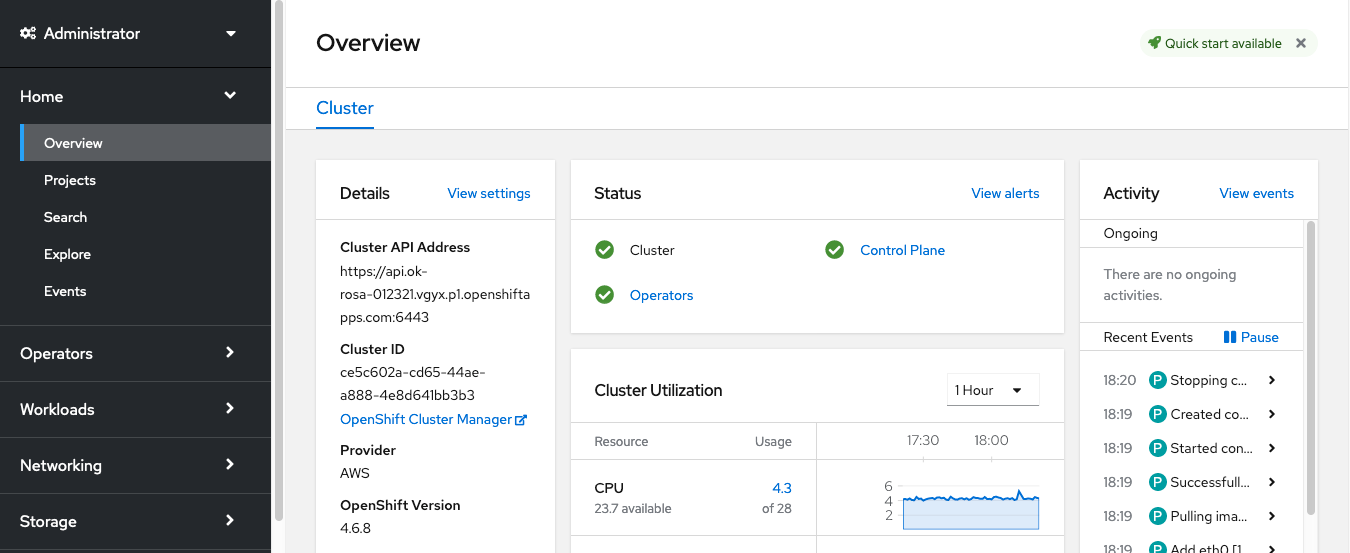

rosa whoamiコマンドを使用し、アイデンティティーを確認します。この操作のターミナルの内容は、次のようになります。

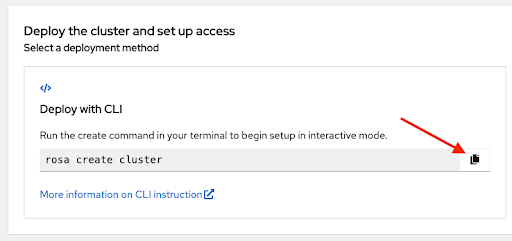

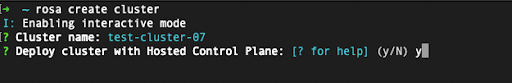

表示されたコマンドを使用してクラスターのデプロイメントを開始します。もう一度 copy ボタンをクリックして、ターミナルにコマンドを貼り付けます。

-

カスタムの AWS プロファイルを使用するには、

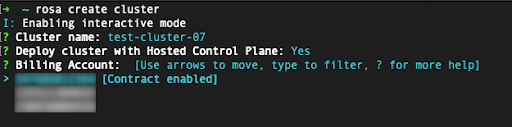

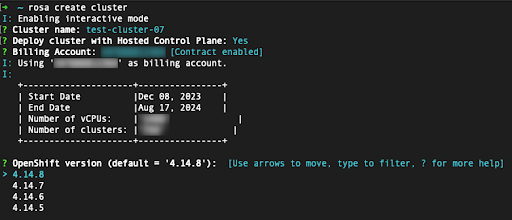

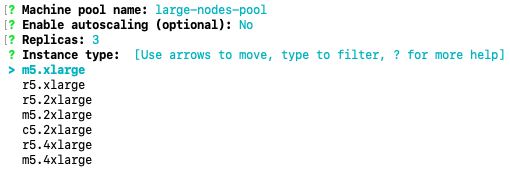

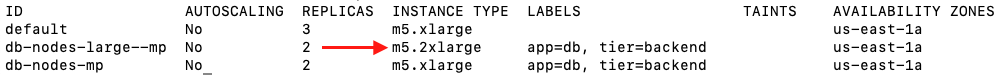

~/.aws/credentialsで指定したデフォルト以外のプロファイルのいずれかを使用します。rosa create cluster コマンドに–profile <profile_name>のセレクターを追加すると、コマンドは rosa create cluster–profile stageのようになります。このオプションを使用して、AWS CLI プロファイルが指定されていない場合は、デフォルトの AWS CLI プロファイルにより、AWS インフラストラクチャーのプロファイルがどのクラスターにデプロイされるかが決定されます。請求用 AWS プロファイルは、次のいずれかの手順で選択します。 クラスター名を入力すると、Hosted Control Plane を使用するかどうかを尋ねられます。YES を選択します。

ROSA with HCP クラスターをデプロイする場合、請求先の AWS アカウントを指定する必要があります。

- 現在使用されている Red Hat 組織にリンクされている AWS アカウントのみが表示されます。

- インフラストラクチャー AWS アカウントが同じ AWS 組織内でそのアカウントにリンクされているかどうかに関係なく、指定された AWS アカウントは ROSA サービスの使用に対して課金されます。

- 特定の AWS 請求先アカウントに対して ROSA の契約が有効になっているかどうかを示すインジケーターが表示されます。

- 契約が有効になっていない AWS アカウントを選択するには、このチュートリアルの最初のいくつかの手順を参照して契約を有効にし、クラスターデプロイメントを正常に実行するために必要なサービス課金を許可します。

次の手順では、デプロイするクラスターの技術的な詳細を指定します。

- これらの手順は、このチュートリアルの範囲外です。CLI を使用して ROSA with HCP クラスターのデプロイメントを完了する方法の詳細は デフォルトオプションを使用した ROSA with HCP クラスターの作成 を参照してください。

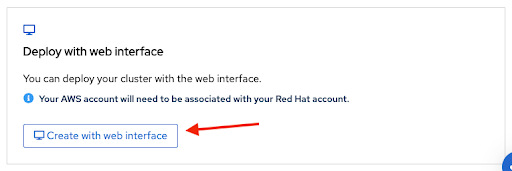

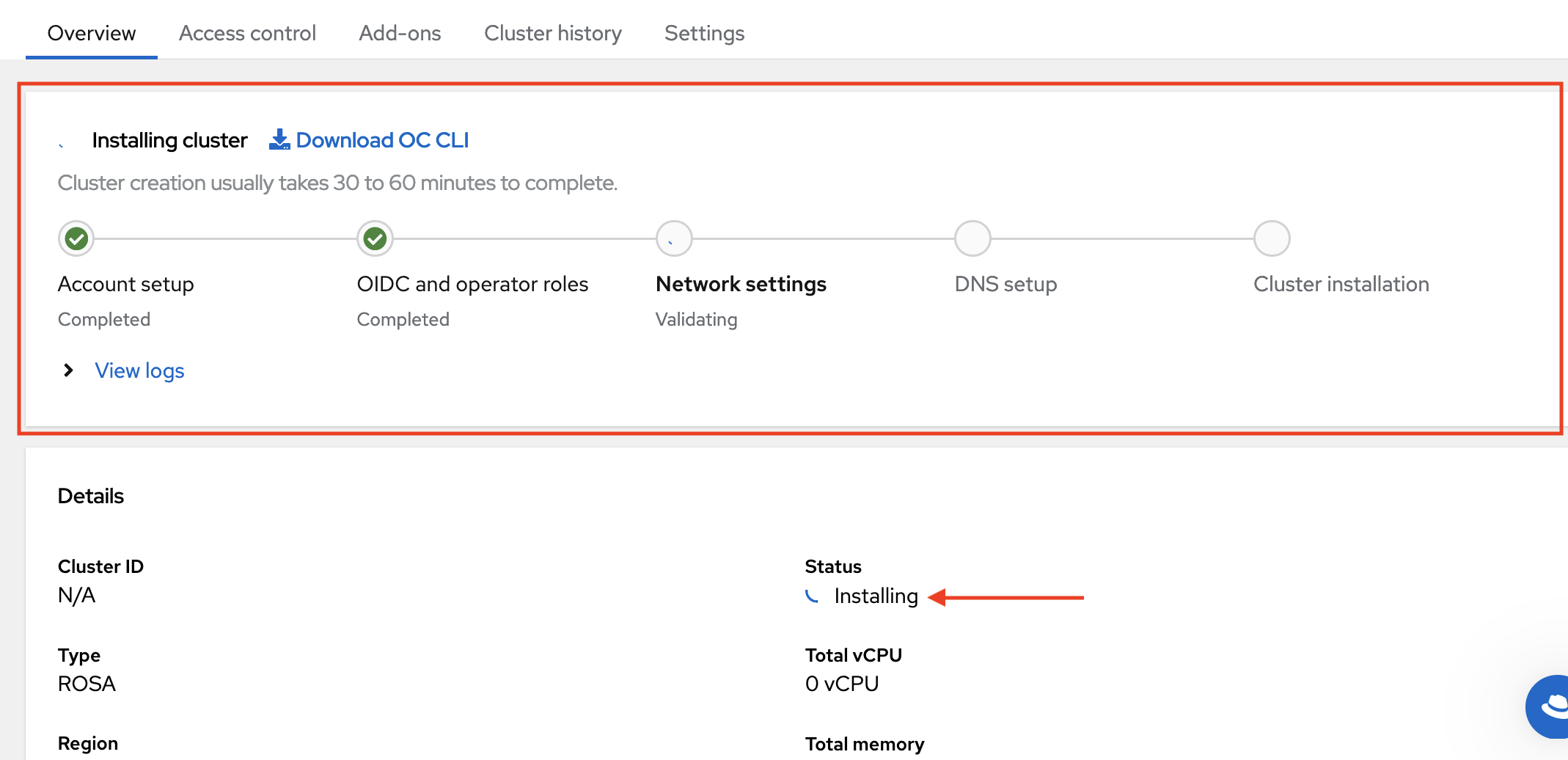

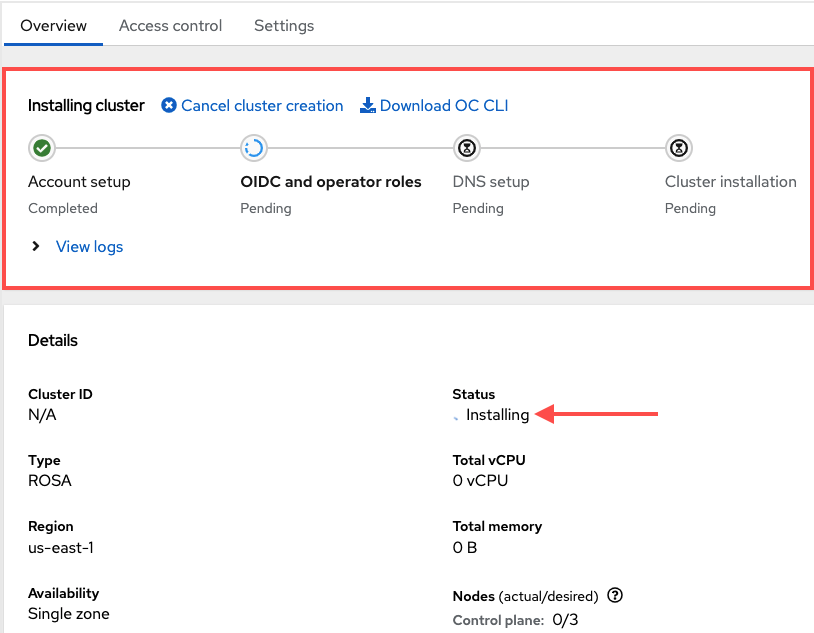

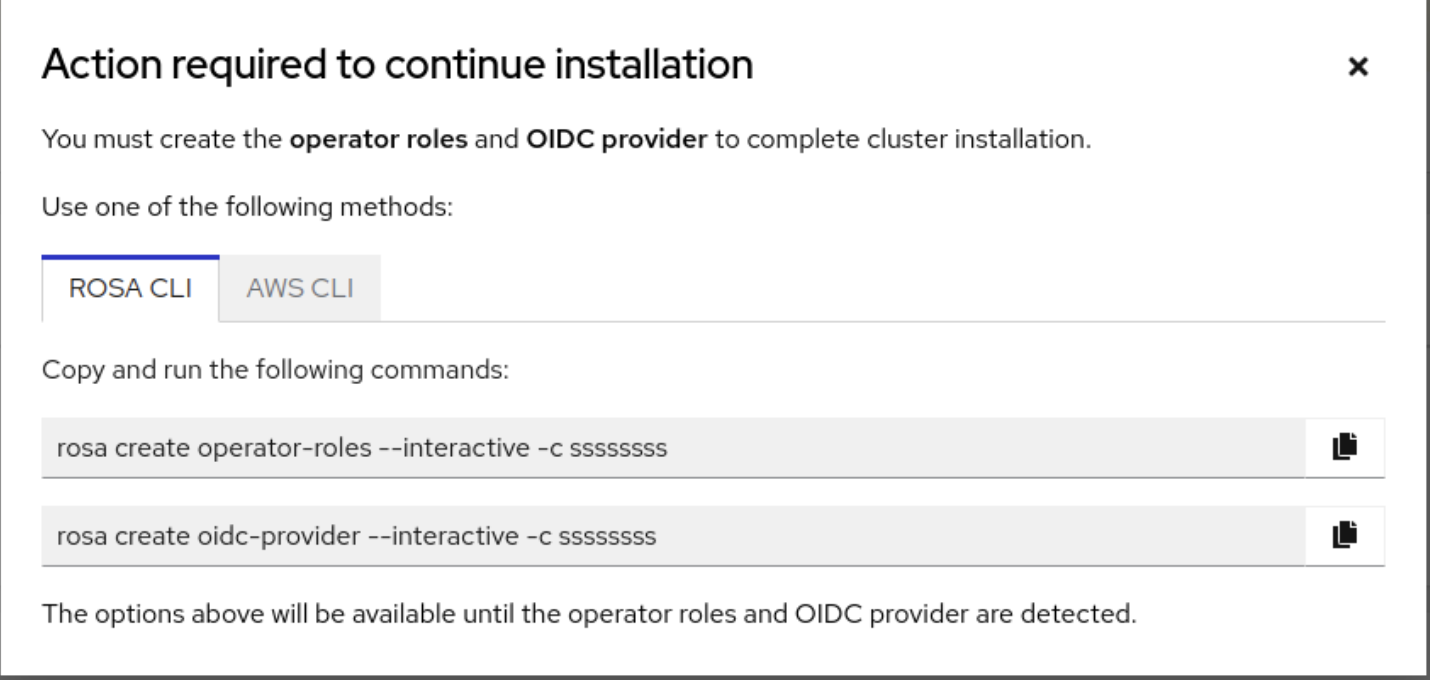

2.5. Web コンソールを使用した ROSA with HCP クラスターのデプロイメント

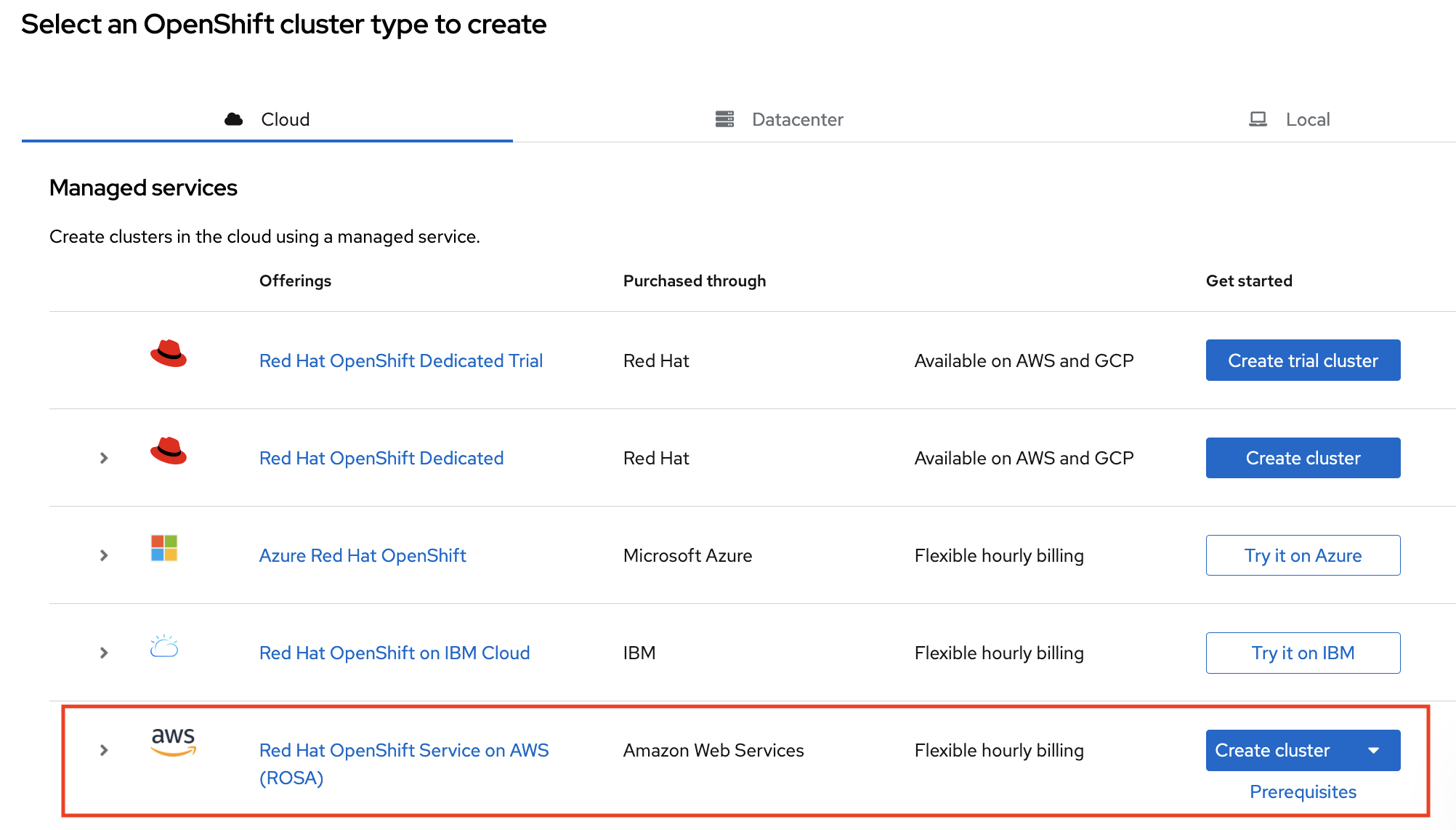

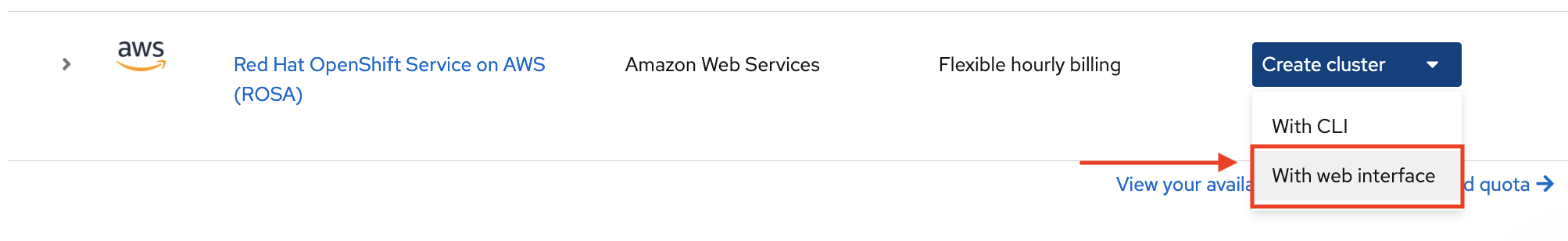

Web コンソールを使用してクラスターを作成するには、ROSA のセットアップ ページの下部セクションにある 2 番目のオプションを選択します。

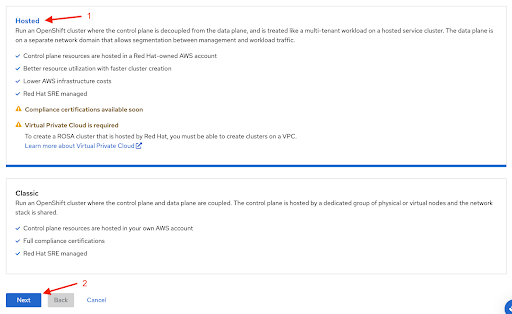

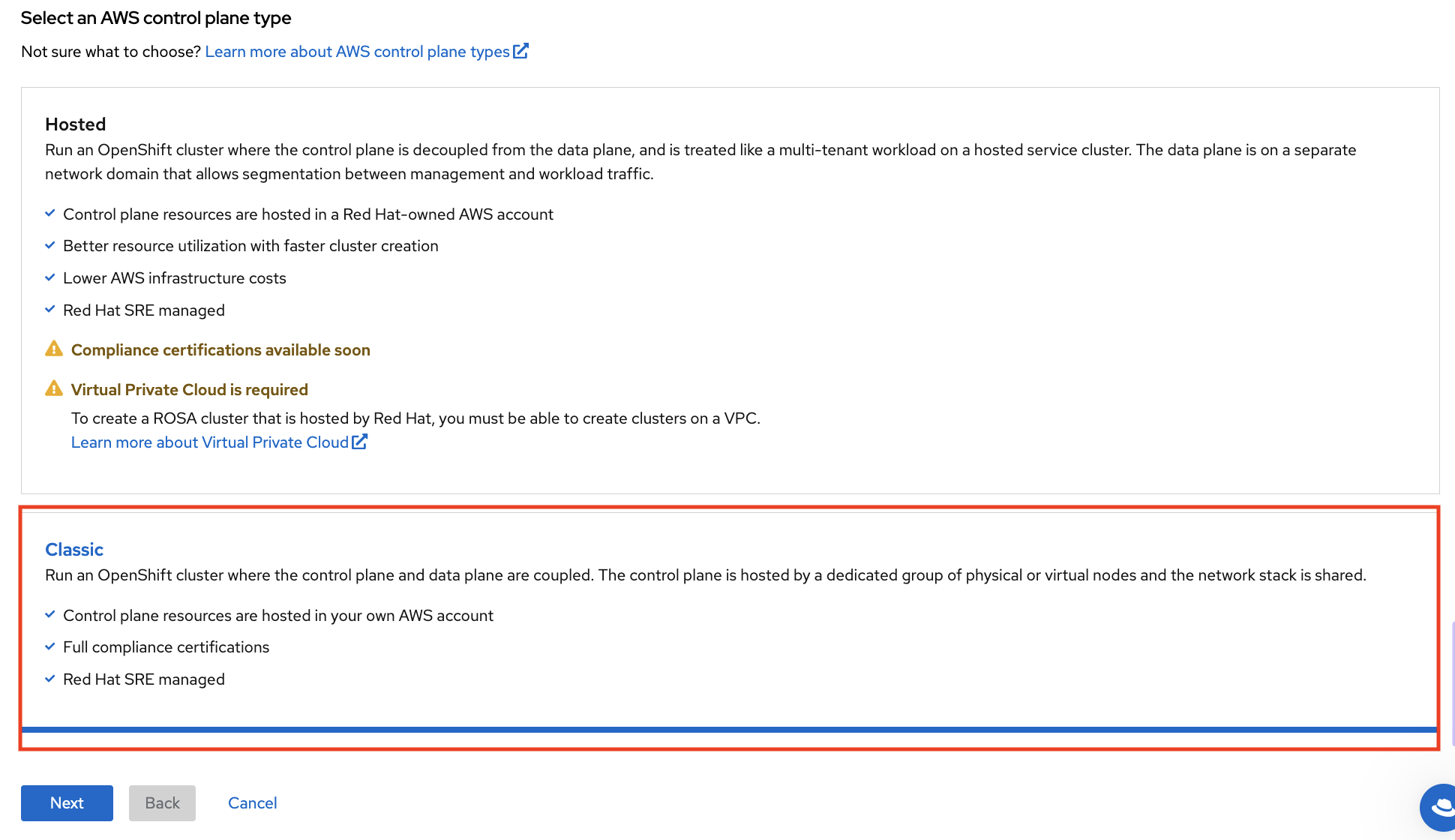

Web コンソールを使用して ROSA クラスターを作成する場合の最初のステップは、コントロールプレーンの選択です。Next ボタンをクリックする前に、Hosted オプションが選択されていることを確認してください。

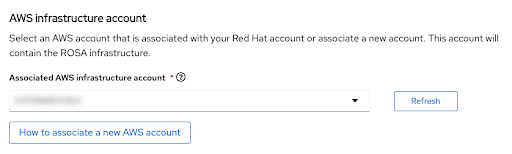

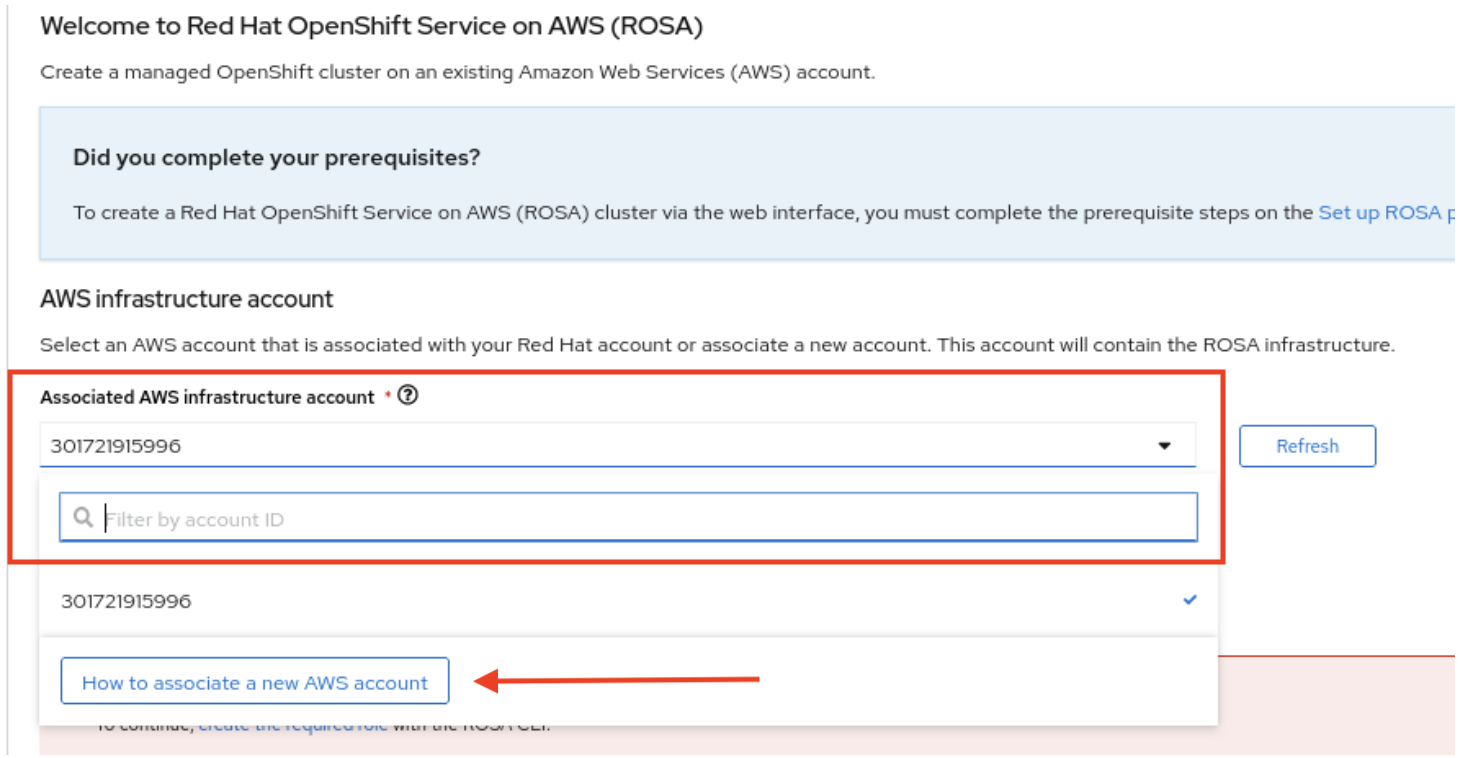

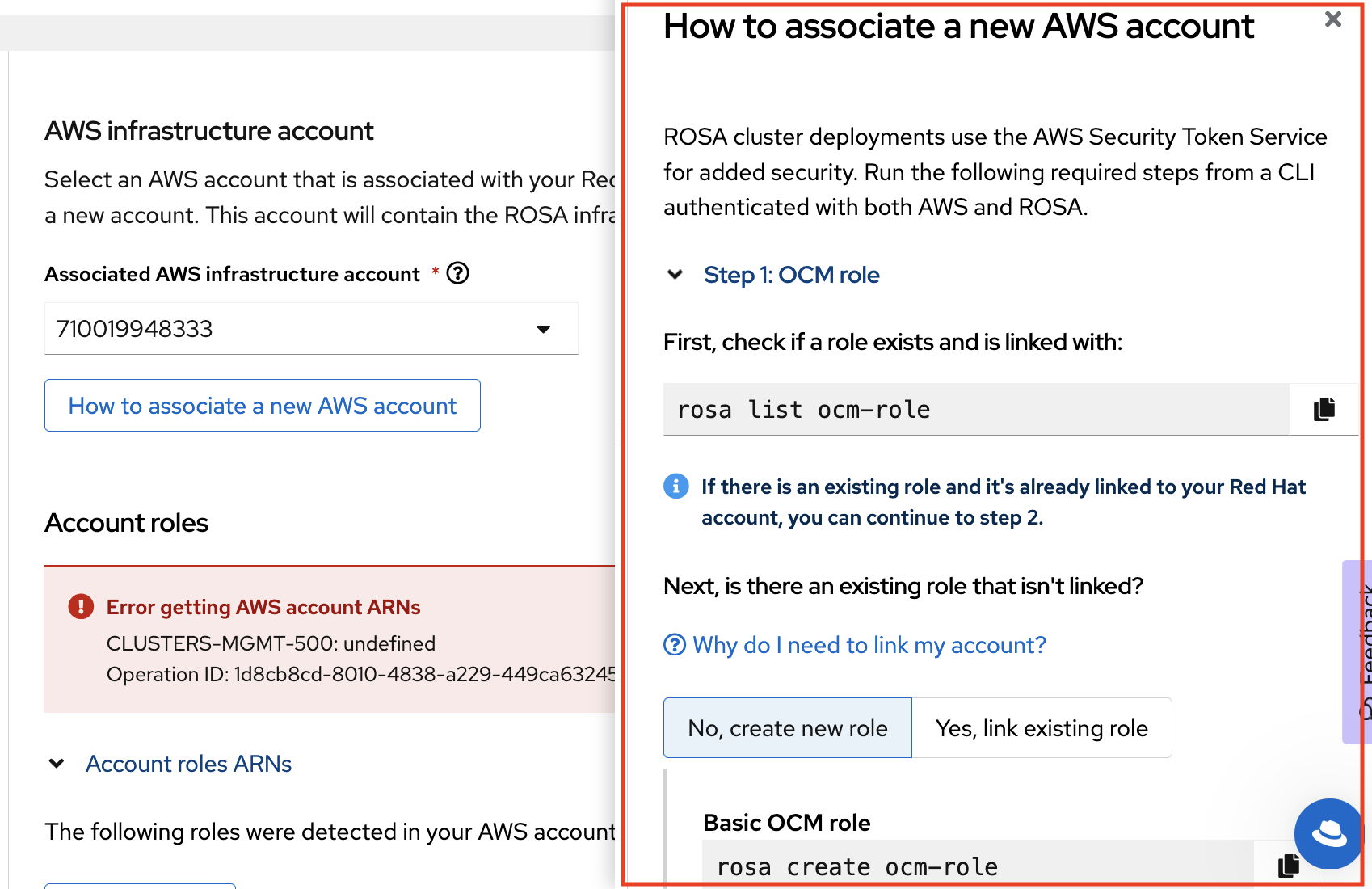

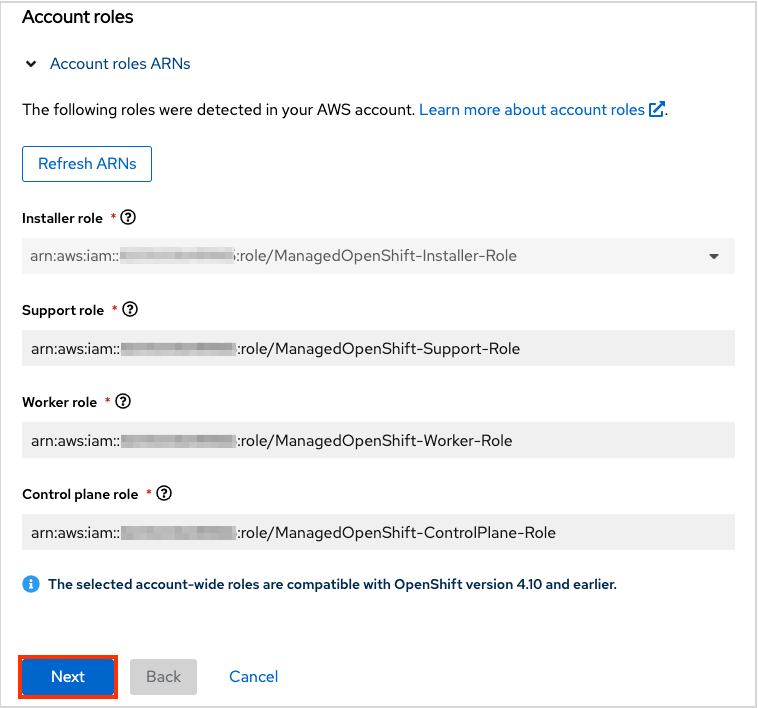

次のステップ アカウントとロール では、ROSA クラスターがデプロイされ、リソースを消費および管理するインフラストラクチャー AWS アカウントを指定できます。

- ROSA クラスターのデプロイ先のアカウントが表示されない場合は、How to associate a new AWS account をクリックして、この関連付けに関して、アカウントロールの作成またはリンクの情報を参照してください。

-

これには

rosaCLI を使用します。 -

複数の AWS アカウントを使用しており、それらのプロファイルが AWS CLI 用に設定されている場合は、

rosaCLI コマンドを使用するときに--profileセレクターを使用して AWS プロファイルを指定できます。

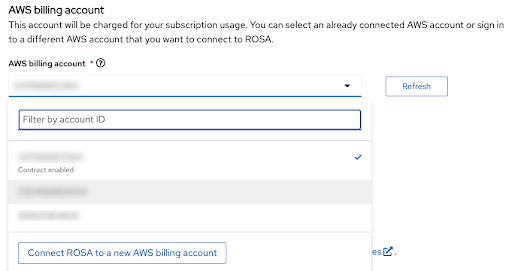

請求先の AWS アカウントは、すぐ次のセクションで選択されます。

- 現在使用されている Red Hat 組織にリンクされている AWS アカウントのみが表示されます。

- インフラストラクチャー AWS アカウントが同じ AWS 組織内でそのアカウントにリンクされているかどうかに関係なく、指定された AWS アカウントは ROSA サービスの使用に対して課金されます。

- 特定の AWS 請求先アカウントに対して ROSA 契約が有効になっているかどうかを示すインジケーターを確認できます。

- 契約がまだ有効になっていない AWS アカウントを使用したい場合は、Connect ROSA to a new AWS billing account を使用して ROSA AWS コンソールページにアクセスし、ログイン後に有効化できます。先ほど、このチュートリアルで説明した手順に従って、それぞれの AWS アカウントを作成するか、AWS アカウントの管理者に依頼してください。

請求先の AWS アカウントの選択以降の手順は、このチュートリアルの範囲外です。

関連情報

- CLI を使用してクラスターを作成する方法は、CLI を使用した ROSA with HCP クラスターの作成 を参照してください。

- Web コンソールを使用して ROSA クラスターのデプロイメントを完了する方法の詳細は、 この学習パス を参照してください。

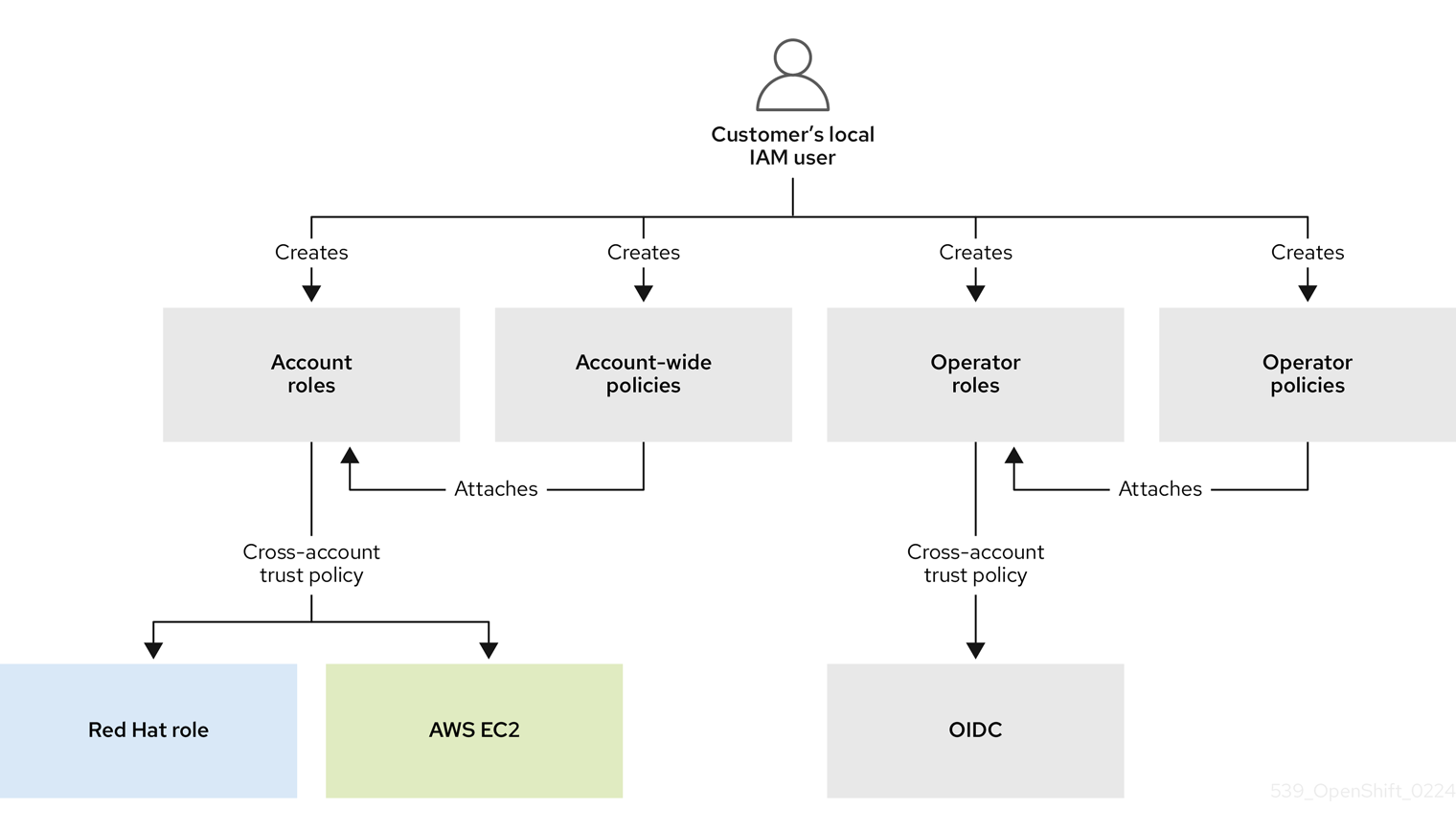

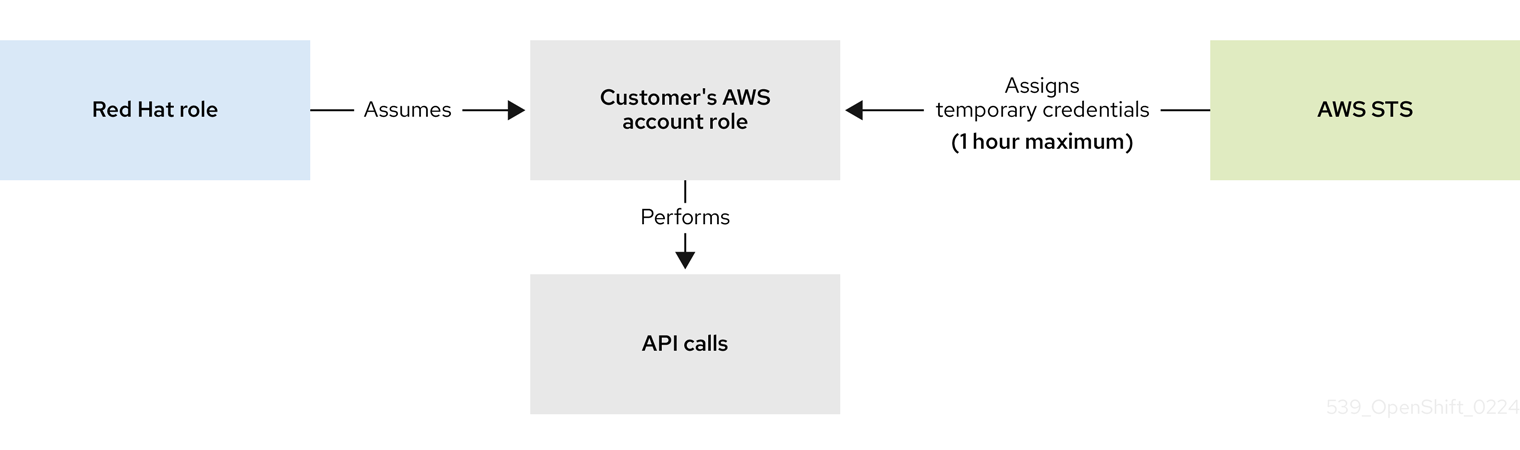

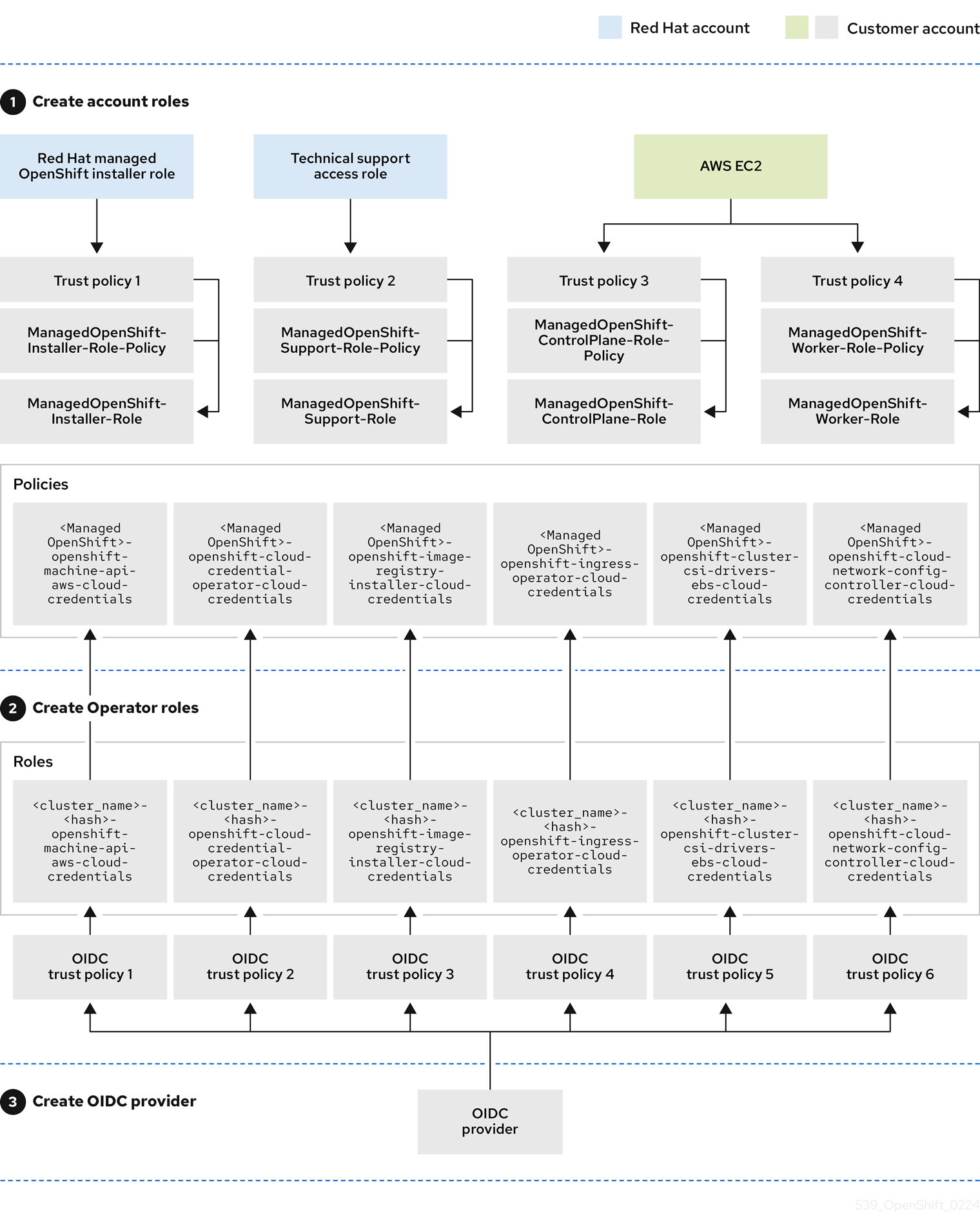

第3章 チュートリアル: ROSA STS デプロイメントの権限の検証

ROSA クラスターのデプロイに進むには、アカウントによって必要なロールと権限がサポートされている必要があります。AWS Service Control Policies (SCP) は、インストーラーまたは Operator ロールによって行われる API 呼び出しをブロックできません。

ROSA の STS 対応インストールに必要な IAM リソースの詳細は、STS を使用する ROSA クラスターの IAM リソースについて を参照してください。

このガイドは ROSA v4.11.X で検証されています。

3.1. 前提条件

- AWS CLI

- ROSA CLI v1.2.6

- jq CLI

- 必要な権限を持つ AWS ロール

3.2. ROSA 権限の検証

ROSA に必要な権限を検証するには、AWS リソースを作成していない状態で、次のセクションに示すスクリプトを実行します。

このスクリプトは、rosa、aws、および jq CLI コマンドを使用して、現在の AWS 設定に接続されているアカウントの権限の検証に使用されるファイルを作業ディレクトリーに作成します。

AWS Policy Simulator を使用して、jq によって抽出された API 呼び出しに対して各ロールポリシーの権限を検証します。結果は、.results が追加されたテキストファイルに保存されます。

このスクリプトは、現在のアカウントとリージョンの権限を確認するように設計されています。

3.3. 使用手順

スクリプトを使用するには、

bashターミナルで次のコマンドを実行します (-p オプションはロールの接頭辞を定義します)。$ mkdir scratch $ cd scratch $ cat << 'EOF' > verify-permissions.sh #!/bin/bash while getopts 'p:' OPTION; do case "$OPTION" in p) PREFIX="$OPTARG" ;; ?) echo "script usage: $(basename \$0) [-p PREFIX]" >&2 exit 1 ;; esac done shift "$(($OPTIND -1))" rosa create account-roles --mode manual --prefix $PREFIX INSTALLER_POLICY=$(cat sts_installer_permission_policy.json | jq ) CONTROL_PLANE_POLICY=$(cat sts_instance_controlplane_permission_policy.json | jq) WORKER_POLICY=$(cat sts_instance_worker_permission_policy.json | jq) SUPPORT_POLICY=$(cat sts_support_permission_policy.json | jq) simulatePolicy () { outputFile="${2}.results" echo $2 aws iam simulate-custom-policy --policy-input-list "$1" --action-names $(jq '.Statement | map(select(.Effect == "Allow"))[].Action | if type == "string" then . else .[] end' "$2" -r) --output text > $outputFile } simulatePolicy "$INSTALLER_POLICY" "sts_installer_permission_policy.json" simulatePolicy "$CONTROL_PLANE_POLICY" "sts_instance_controlplane_permission_policy.json" simulatePolicy "$WORKER_POLICY" "sts_instance_worker_permission_policy.json" simulatePolicy "$SUPPORT_POLICY" "sts_support_permission_policy.json" EOF $ chmod +x verify-permissions.sh $ ./verify-permissions.sh -p SimPolTestスクリプトが完了したら、各結果ファイルを確認して、必要な API 呼び出しがブロックされていないことを確認します。

$ for file in $(ls *.results); do echo $file; cat $file; done

出力は以下のようになります。

sts_installer_permission_policy.json.results EVALUATIONRESULTS autoscaling:DescribeAutoScalingGroups allowed * MATCHEDSTATEMENTS PolicyInputList.1 IAM Policy ENDPOSITION 6 195 STARTPOSITION 17 3 EVALUATIONRESULTS ec2:AllocateAddress allowed * MATCHEDSTATEMENTS PolicyInputList.1 IAM Policy ENDPOSITION 6 195 STARTPOSITION 17 3 EVALUATIONRESULTS ec2:AssociateAddress allowed * MATCHEDSTATEMENTS PolicyInputList.1 IAM Policy ...

注記アクションがブロックされている場合は、AWS が提供するエラーを確認し、管理者に相談して、SCP によって必要な API 呼び出しがブロックされているかどうかを判断してください。

第4章 CloudWatch ログと STS のログ転送の設定

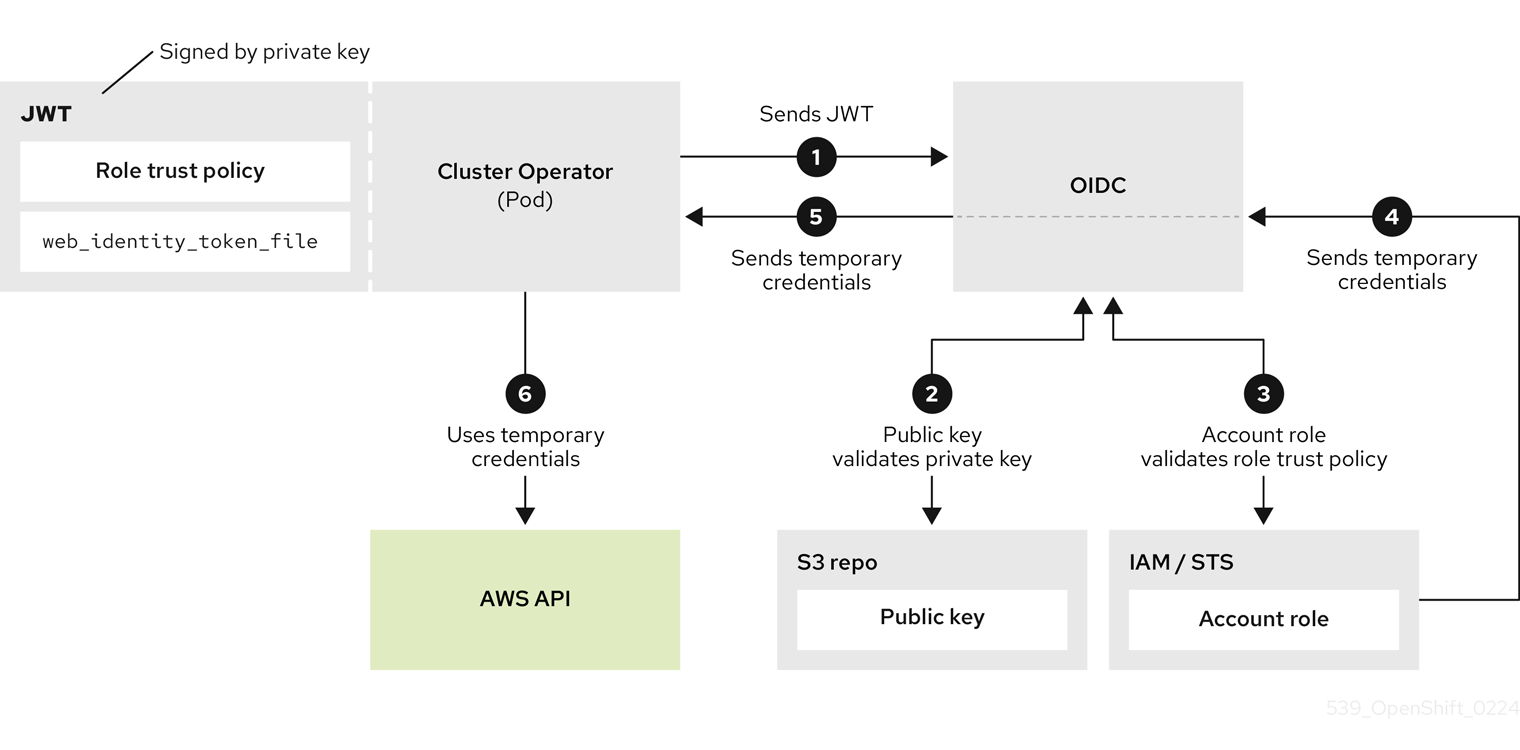

このチュートリアルでは、Red Hat OpenShift Logging Operator をデプロイし、Security Token Services (STS) 認証を使用してログを CloudWatch に転送するように設定します。

前提条件

- Red Hat OpenShift Service on AWS (ROSA) Classic クラスター

-

jqコマンドラインインターフェイス (CLI) -

Amazon Web Services (AWS) CLI (

aws)

4.1. 環境の設定

次の環境変数を設定し、お使いのクラスターに合わせてクラスター名を変更します。

注記管理者としてログインしている必要があります。

$ export ROSA_CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(rosa describe cluster -c ${ROSA_CLUSTER_NAME} --output json | jq -r .region.id) $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o json | jq -r .spec.serviceAccountIssuer | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export AWS_PAGER="" $ export SCRATCH="/tmp/${ROSA_CLUSTER_NAME}/clf-cloudwatch-sts" $ mkdir -p ${SCRATCH}次のセクションに進む前に、すべてのフィールドが正しく出力されていることを確認してください。

$ echo "Cluster: ${ROSA_CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

4.2. AWS アカウントの準備

ロギング用の Identity Access Management (IAM) ポリシーを作成します。

$ POLICY_ARN=$(aws iam list-policies --query "Policies[?PolicyName=='RosaCloudWatch'].{ARN:Arn}" --output text) $ if [[ -z "${POLICY_ARN}" ]]; then cat << EOF > ${SCRATCH}/policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "logs:CreateLogGroup", "logs:CreateLogStream", "logs:DescribeLogGroups", "logs:DescribeLogStreams", "logs:PutLogEvents", "logs:PutRetentionPolicy" ], "Resource": "arn:aws:logs:*:*:*" } ] } EOF POLICY_ARN=$(aws iam create-policy --policy-name "RosaCloudWatch" \ --policy-document file:///${SCRATCH}/policy.json --query Policy.Arn --output text) fi $ echo ${POLICY_ARN}クラスターの IAM ロール信頼ポリシーを作成します。

$ cat <<EOF > ${SCRATCH}/trust-policy.json { "Version": "2012-10-17", "Statement": [{ "Effect": "Allow", "Principal": { "Federated": "arn:aws:iam::${AWS_ACCOUNT_ID}:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${OIDC_ENDPOINT}:sub": "system:serviceaccount:openshift-logging:logcollector" } } }] } EOF $ ROLE_ARN=$(aws iam create-role --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch" \ --assume-role-policy-document file://${SCRATCH}/trust-policy.json \ --query Role.Arn --output text) $ echo ${ROLE_ARN}IAM ポリシーを IAM ロールに割り当てます。

$ aws iam attach-role-policy --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch" \ --policy-arn ${POLICY_ARN}

4.3. Operator のデプロイ

Red Hat OpenShift Logging Operator をデプロイします。

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: labels: operators.coreos.com/cluster-logging.openshift-logging: "" name: cluster-logging namespace: openshift-logging spec: channel: stable installPlanApproval: Automatic name: cluster-logging source: redhat-operators sourceNamespace: openshift-marketplace EOFシークレットを作成します。

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Secret metadata: name: cloudwatch-credentials namespace: openshift-logging stringData: role_arn: $ROLE_ARN EOF

4.4. クラスターロギングの設定

ClusterLogForwarderカスタムリソース (CR) を作成します。$ cat << EOF | oc apply -f - apiVersion: "logging.openshift.io/v1" kind: ClusterLogForwarder metadata: name: instance namespace: openshift-logging spec: outputs: - name: cw type: cloudwatch cloudwatch: groupBy: namespaceName groupPrefix: rosa-${ROSA_CLUSTER_NAME} region: ${REGION} secret: name: cloudwatch-credentials pipelines: - name: to-cloudwatch inputRefs: - infrastructure - audit - application outputRefs: - cw EOFClusterLoggingCR を作成します。$ cat << EOF | oc apply -f - apiVersion: logging.openshift.io/v1 kind: ClusterLogging metadata: name: instance namespace: openshift-logging spec: collection: logs: type: vector managementState: Managed EOF

4.5. CloudWatch のログの確認

AWS コンソールまたは AWS CLI を使用して、クラスターからのログストリームがあることを検証します。

AWS CLI でログを検証するには、次のコマンドを実行します。

$ aws logs describe-log-groups --log-group-name-prefix rosa-${ROSA_CLUSTER_NAME}出力例

{ "logGroups": [ { "logGroupName": "rosa-xxxx.audit", "creationTime": 1661286368369, "metricFilterCount": 0, "arn": "arn:aws:logs:us-east-2:xxxx:log-group:rosa-xxxx.audit:*", "storedBytes": 0 }, { "logGroupName": "rosa-xxxx.infrastructure", "creationTime": 1661286369821, "metricFilterCount": 0, "arn": "arn:aws:logs:us-east-2:xxxx:log-group:rosa-xxxx.infrastructure:*", "storedBytes": 0 } ] }注記これが新しいクラスターの場合は、アプリケーションがまだ実行されていないため、

applicationログのロググループが表示されない可能性があります。

4.6. リソースのクリーンアップ

ClusterLogForwarderCR を削除します。$ oc delete -n openshift-logging clusterlogforwarder instance

ClusterLoggingCR を削除します。$ oc delete -n openshift-logging clusterlogging instance

IAM ロールから IAM ポリシーの割り当てを解除します。

$ aws iam detach-role-policy --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch" \ --policy-arn "${POLICY_ARN}"IAM ロールを削除します。

$ aws iam delete-role --role-name "${ROSA_CLUSTER_NAME}-RosaCloudWatch"IAM ポリシーを削除します。

重要IAM ポリシーは、そのポリシーを使用している他のリソースがない場合にのみ削除してください。

$ aws iam delete-policy --policy-arn "${POLICY_ARN}"CloudWatch ロググループを削除します。

$ aws logs delete-log-group --log-group-name "rosa-${ROSA_CLUSTER_NAME}.audit" $ aws logs delete-log-group --log-group-name "rosa-${ROSA_CLUSTER_NAME}.infrastructure"

第5章 チュートリアル: AWS WAF と Amazon CloudFront を使用した ROSA ワークロードの保護

AWS WAF は Web アプリケーションファイアウォールです。保護対象の Web アプリケーションリソースに転送される HTTP および HTTPS 要求を監視できます。

Amazon CloudFront を使用して、Web Application Firewall (WAF) を Red Hat OpenShift Service on AWS (ROSA) ワークロードに追加できます。外部ソリューションを使用すると、WAF の処理によるサービス拒否から ROSA リソースを保護できます。

5.1. 前提条件

- ROSA Classic クラスター。

-

OpenShift CLI (

oc) にアクセスできる。 -

AWS CLI (

aws) にアクセスできる。

5.1.1. 環境設定

環境変数を準備します。

$ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/cloudfront-waf" $ mkdir -p ${SCRATCH} $ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, AWS Account ID: ${AWS_ACCOUNT_ID}"

5.2. カスタムドメインの設定

標準 (およびデフォルト) クラスター Ingress Controller からの WAF 保護対象の外部トラフィックをセグメント化するために、セカンダリー Ingress Controller を設定する必要があります。ROSA では、Custom Domain Operator を使用してこれを行います。

前提条件

-

一意のドメイン (

*.apps.<company_name>.ioなど) -

カスタム SAN またはワイルドカード証明書 (

CN=*.apps.<company_name>.ioなど)

手順

新しいプロジェクトを作成する

$ oc new-project waf-demo

秘密鍵と公開証明書から新しい TLS シークレットを作成します。

fullchain.pemは完全なワイルドカード証明書チェーン (中間証明書を含む)、privkey.pemはワイルドカード証明書の秘密鍵です。例

$ oc -n waf-demo create secret tls waf-tls --cert=fullchain.pem --key=privkey.pem

新規の

CustomDomainカスタムリソース (CR) を作成します。waf-custom-domain.yamlの例apiVersion: managed.openshift.io/v1alpha1 kind: CustomDomain metadata: name: cloudfront-waf spec: domain: apps.<company_name>.io 1 scope: External loadBalancerType: NLB certificate: name: waf-tls namespace: waf-demo routeSelector: 2 matchLabels: route: waf

CR を適用します。

例

$ oc apply -f waf-custom-domain.yaml

カスタムドメイン Ingress Controller がデプロイされ、

Readyステータスになっていることを確認します。$ oc get customdomains

出力例

NAME ENDPOINT DOMAIN STATUS cloudfront-waf xxrywp.<company_name>.cluster-01.opln.s1.openshiftapps.com *.apps.<company_name>.io Ready

5.2.1. AWS WAF の設定

AWS WAF サービスは Web アプリケーションファイアウォールです。ROSA などの保護対象の Web アプリケーションリソースに転送される HTTP および HTTPS 要求を監視、保護、制御できます。

Web ACL に適用する AWS WAF ルールファイルを作成します。

$ cat << EOF > ${SCRATCH}/waf-rules.json [ { "Name": "AWS-AWSManagedRulesCommonRuleSet", "Priority": 0, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesCommonRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesCommonRuleSet" } }, { "Name": "AWS-AWSManagedRulesSQLiRuleSet", "Priority": 1, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesSQLiRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesSQLiRuleSet" } } ] EOFこれにより、コア (共通) および SQL AWS マネージドルールセットが有効になります。

上記で指定したルールを使用して、AWS WAF の Web ACL を作成します。

$ WAF_WACL=$(aws wafv2 create-web-acl \ --name cloudfront-waf \ --region ${REGION} \ --default-action Allow={} \ --scope CLOUDFRONT \ --visibility-config SampledRequestsEnabled=true,CloudWatchMetricsEnabled=true,MetricName=${CLUSTER_NAME}-waf-metrics \ --rules file://${SCRATCH}/waf-rules.json \ --query 'Summary.Name' \ --output text)

5.3. Amazon CloudFront の設定

新しく作成したカスタムドメイン Ingress Controller の NLB ホスト名を取得します。

$ NLB=$(oc -n openshift-ingress get service router-cloudfront-waf \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ echo "Origin domain: ${NLB}"証明書を Amazon Certificate Manager にインポートします。

cert.pemはワイルドカード証明書、fullchain.pemはワイルドカード証明書のチェーン、privkey.pemはワイルドカード証明書の秘密鍵です。注記この証明書は、クラスターがデプロイされているリージョンに関係なく

us-east-1にインポートする必要があります。Amazon CloudFront はグローバル AWS サービスであるためです。例

$ aws acm import-certificate --certificate file://cert.pem \ --certificate-chain file://fullchain.pem \ --private-key file://privkey.pem \ --region us-east-1

- AWS コンソール にログインして、CloudFront ディストリビューションを作成します。

次の情報を使用して、CloudFront ディストリビューションを設定します。

注記以下の表でオプションが指定されていない場合は、デフォルトのままにしておきます (空白でも構いません)。

オプション 値 Origin domain

上記のコマンドの出力 [1]

Name

rosa-waf-ingress [2]

Viewer protocol policy

Redirect HTTP to HTTPS

Allowed HTTP methods

GET, HEAD, OPTIONS, PUT, POST, PATCH, DELETE

Cache policy

CachingDisabled

Origin request policy

AllViewer

Web Application Firewall (WAF)

Enable security protections

Use existing WAF configuration

true

Choose a web ACL

cloudfront-wafAlternate domain name (CNAME)

*.apps.<company_name>.io [3]

Custom SSL certificate

上のステップでインポートした証明書を選択 [4]

-

origin domain を取得するには、

echo ${NLB}を実行します。 - 複数のクラスターがある場合は、オリジンの名前が一意であることを確認してください。

- これは、カスタムドメイン Ingress Controller の作成に使用したワイルドカードドメインと同じである必要があります。

- これは、上で入力した alternate domain name と同じである必要があります。

-

origin domain を取得するには、

Amazon CloudFront ディストリビューションエンドポイントを取得します。

$ aws cloudfront list-distributions --query "DistributionList.Items[?Origins.Items[?DomainName=='${NLB}']].DomainName" --output textCNAME を持つカスタムのワイルドカードドメインの DNS を、前述のステップの Amazon CloudFront ディストリビューションエンドポイントに更新します。

例

*.apps.<company_name>.io CNAME d1b2c3d4e5f6g7.cloudfront.net

5.4. サンプルアプリケーションのデプロイ

Hello World アプリケーションをデプロイします。

$ oc -n waf-demo new-app --image=docker.io/openshift/hello-openshift

カスタムドメイン名を指定してアプリケーションのルートを作成します。

例

$ oc -n waf-demo create route edge --service=hello-openshift hello-openshift-tls \ --hostname hello-openshift.apps.<company_name>.io

ルートにラベルを付けて、カスタムドメイン Ingress Controller へのアクセスを許可します。

$ oc -n waf-demo label route.route.openshift.io/hello-openshift-tls route=waf

5.5. WAF のテスト

アプリが Amazon CloudFront の背後でアクセスできることをテストします。

例

$ curl "https://hello-openshift.apps.<company_name>.io"

出力例

Hello OpenShift!

WAF が不正な要求を拒否することをテストします。

例

$ curl -X POST "https://hello-openshift.apps.<company_name>.io" \ -F "user='<script><alert>Hello></alert></script>'"

出力例

<html> <head><title>403 Forbidden</title></head> <body> <center><h1>403 Forbidden</h1></center> </body> </html

予期される結果は

403 Forbiddenエラーです。このエラーが返されれば、アプリケーションは AWS WAF によって保護されています。

5.6. 関連情報

- Red Hat ドキュメントの アプリケーションのカスタムドメイン

- YouTube の Adding Extra Security with AWS WAF, CloudFront and ROSA | Amazon Web Services

第6章 チュートリアル: AWS WAF と AWS ALB を使用した ROSA ワークロードの保護

AWS WAF は Web アプリケーションファイアウォールです。保護対象の Web アプリケーションリソースに転送される HTTP および HTTPS 要求を監視できます。

Amazon CloudFront を使用して、AWS Application Load Balancer (ALB) を Red Hat OpenShift Service on AWS (ROSA) ワークロードに追加できます。外部ソリューションを使用すると、WAF の処理によるサービス拒否から ROSA リソースを保護できます。

ALB ベースのソリューションを使用する必要がある場合を除き、CloudFront 方式 を使用することを推奨します。

6.1. 前提条件

AWS ALB には、マルチ AZ クラスターと、クラスターと同じ VPC 内の 3 つの AZ に分割された 3 つのパブリックサブネットが必要です。

- マルチ AZ ROSA Classic クラスター。

-

OpenShift CLI (

oc) にアクセスできる。 -

AWS CLI (

aws) にアクセスできる。

6.1.1. 環境設定

環境変数を準備します。

$ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/alb-waf" $ mkdir -p ${SCRATCH} $ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

6.1.2. AWS VPC とサブネット

このセクションは、既存の VPC にデプロイされたクラスターにのみ適用されます。クラスターを既存の VPC にデプロイしなかった場合は、このセクションをスキップして、その後のインストールセクションに進んでください。

以下の変数を、ROSA デプロイメントに合わせて適切な値に設定します。

$ export VPC_ID=<vpc-id> $ export PUBLIC_SUBNET_IDS=<public-subnets> $ export PRIVATE_SUBNET_IDS=<private-subnets>

クラスター名を使用してクラスターの VPC にタグを追加します。

$ aws ec2 create-tags --resources ${VPC_ID} --tags Key=kubernetes.io/cluster/${CLUSTER_NAME},Value=owned --region ${REGION}パブリックサブネットにタグを追加します。

$ aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='' \ --region ${REGION}プライベートサブネットにタグを追加します。

$ aws ec2 create-tags \ --resources "${PRIVATE_SUBNET_IDS}" \ --tags Key=kubernetes.io/role/internal-elb,Value='' \ --region ${REGION}

6.2. AWS Load Balancer Operator のデプロイ

AWS Load Balancer Operator は、ROSA クラスター内の aws-load-balancer-controller のインスタンスをインストール、管理、設定するために使用します。ROSA に ALB をデプロイするには、まず AWS Load Balancer Operator をデプロイする必要があります。

AWS Load Balancer Controller の AWS IAM ポリシーを作成します。

注記このポリシーは、アップストリームの AWS Load Balancer Controller ポリシー に加えて、サブネット上にタグを作成する権限から取得されます。これは Operator が機能するために必要です。

$ oc new-project aws-load-balancer-operator $ POLICY_ARN=$(aws iam list-policies --query \ "Policies[?PolicyName=='aws-load-balancer-operator-policy'].{ARN:Arn}" \ --output text) $ if [[ -z "${POLICY_ARN}" ]]; then wget -O "${SCRATCH}/load-balancer-operator-policy.json" \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/rosa/aws-load-balancer-operator/load-balancer-operator-policy.json POLICY_ARN=$(aws --region "$REGION" --query Policy.Arn \ --output text iam create-policy \ --policy-name aws-load-balancer-operator-policy \ --policy-document "file://${SCRATCH}/load-balancer-operator-policy.json") fi $ echo $POLICY_ARNAWS Load Balancer Operator の AWS IAM 信頼ポリシーを作成します。

$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": ["system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-operator-controller-manager", "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-controller-cluster"] } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOFAWS Load Balancer Operator の AWS IAM ロールを作成します。

$ ROLE_ARN=$(aws iam create-role --role-name "${CLUSTER_NAME}-alb-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text) $ echo $ROLE_ARN $ aws iam attach-role-policy --role-name "${CLUSTER_NAME}-alb-operator" \ --policy-arn $POLICY_ARN新しく作成した AWS IAM ロールを引き受けるための AWS Load Balancer Operator 用のシークレットを作成します。

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Secret metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator stringData: credentials: | [default] role_arn = $ROLE_ARN web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOFRed Hat AWS Load Balancer Operator をインストールします。

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: channel: stable-v1.0 installPlanApproval: Automatic name: aws-load-balancer-operator source: redhat-operators sourceNamespace: openshift-marketplace startingCSV: aws-load-balancer-operator.v1.0.0 EOF

次の Operator を使用して、AWS Load Balancer Controller のインスタンスをデプロイします。

注記ここでエラーが発生した場合は、少し待ってから再試行してください。エラーが発生するのは、Operator がまだインストールを完了していないためです。

$ cat << EOF | oc apply -f - apiVersion: networking.olm.openshift.io/v1 kind: AWSLoadBalancerController metadata: name: cluster spec: credentials: name: aws-load-balancer-operator enabledAddons: - AWSWAFv2 EOFOperator Pod とコントローラー Pod の両方が実行されていることを確認します。

$ oc -n aws-load-balancer-operator get pods

次のようなメッセージが表示されます。表示されない場合は、少し待ってから再試行してください。

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4s

6.3. サンプルアプリケーションのデプロイ

サンプルアプリケーション用に新しいプロジェクトを作成します。

$ oc new-project hello-world

Hello World アプリケーションをデプロイします。

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

事前に作成済みのサービスリソースを NodePort サービスタイプに変換します。

$ oc -n hello-world patch service hello-openshift -p '{"spec":{"type":"NodePort"}}'AWS Load Balancer Operator を使用して AWS ALB をデプロイします。

$ cat << EOF | oc apply -f - apiVersion: networking.k8s.io/v1 kind: Ingress metadata: name: hello-openshift-alb namespace: hello-world annotations: alb.ingress.kubernetes.io/scheme: internet-facing spec: ingressClassName: alb rules: - http: paths: - path: / pathType: Exact backend: service: name: hello-openshift port: number: 8080 EOFAWS ALB Ingress エンドポイントを curl して、Hello World アプリケーションにアクセスできることを確認します。

注記AWS ALB のプロビジョニングには数分かかります。

curl: (6) Could not resolve hostというエラーが表示された場合は、待機してから再試行してください。$ INGRESS=$(oc -n hello-world get ingress hello-openshift-alb -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${INGRESS}"出力例

Hello OpenShift!

6.3.1. AWS WAF の設定

AWS WAF サービスは Web アプリケーションファイアウォールです。ROSA などの保護対象の Web アプリケーションリソースに転送される HTTP および HTTPS 要求を監視、保護、制御できます。

Web ACL に適用する AWS WAF ルールファイルを作成します。

$ cat << EOF > ${SCRATCH}/waf-rules.json [ { "Name": "AWS-AWSManagedRulesCommonRuleSet", "Priority": 0, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesCommonRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesCommonRuleSet" } }, { "Name": "AWS-AWSManagedRulesSQLiRuleSet", "Priority": 1, "Statement": { "ManagedRuleGroupStatement": { "VendorName": "AWS", "Name": "AWSManagedRulesSQLiRuleSet" } }, "OverrideAction": { "None": {} }, "VisibilityConfig": { "SampledRequestsEnabled": true, "CloudWatchMetricsEnabled": true, "MetricName": "AWS-AWSManagedRulesSQLiRuleSet" } } ] EOFこれにより、コア (共通) および SQL AWS マネージドルールセットが有効になります。

上記で指定したルールを使用して、AWS WAF の Web ACL を作成します。

$ WAF_ARN=$(aws wafv2 create-web-acl \ --name ${CLUSTER_NAME}-waf \ --region ${REGION} \ --default-action Allow={} \ --scope REGIONAL \ --visibility-config SampledRequestsEnabled=true,CloudWatchMetricsEnabled=true,MetricName=${CLUSTER_NAME}-waf-metrics \ --rules file://${SCRATCH}/waf-rules.json \ --query 'Summary.ARN' \ --output text)Ingress リソースに AWS WAF の Web ACL ARN のアノテーションを付けます。

$ oc annotate -n hello-world ingress.networking.k8s.io/hello-openshift-alb \ alb.ingress.kubernetes.io/wafv2-acl-arn=${WAF_ARN}ルールが反映されるまで 10 秒待ち、アプリケーションがまだ動作するかテストします。

$ curl "http://${INGRESS}"出力例

Hello OpenShift!

WAF が不正な要求を拒否することをテストします。

$ curl -X POST "http://${INGRESS}" \ -F "user='<script><alert>Hello></alert></script>'"出力例

<html> <head><title>403 Forbidden</title></head> <body> <center><h1>403 Forbidden</h1></center> </body> </html

予期される結果は

403 Forbiddenエラーです。このエラーが返されれば、アプリケーションは AWS WAF によって保護されています。

6.4. 関連情報

- Red Hat ドキュメントの アプリケーションのカスタムドメイン

- YouTube の Adding Extra Security with AWS WAF, CloudFront and ROSA | Amazon Web Services

第7章 チュートリアル: ROSA クラスターへの OpenShift API for Data Protection のデプロイ

このコンテンツは Red Hat のエキスパートが作成したものですが、サポート対象のすべての設定でまだテストされていません。

前提条件

環境

環境変数を準備します。

注記ROSA クラスターに一致するようにクラスター名を変更し、管理者としてクラスターにログインしていることを確認してください。次に進む前に、すべてのフィールドが正しく出力されていることを確認してください。

$ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export ROSA_CLUSTER_ID=$(rosa describe cluster -c ${CLUSTER_NAME} --output json | jq -r .id) $ export REGION=$(rosa describe cluster -c ${CLUSTER_NAME} --output json | jq -r .region.id) $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export CLUSTER_VERSION=`rosa describe cluster -c ${CLUSTER_NAME} -o json | jq -r .version.raw_id | cut -f -2 -d '.'` $ export ROLE_NAME="${CLUSTER_NAME}-openshift-oadp-aws-cloud-credentials" $ export AWS_PAGER="" $ export SCRATCH="/tmp/${CLUSTER_NAME}/oadp" $ mkdir -p ${SCRATCH} $ echo "Cluster ID: ${ROSA_CLUSTER_ID}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

7.1. AWS アカウントの準備

S3 アクセスを許可する IAM ポリシーを作成します。

$ POLICY_ARN=$(aws iam list-policies --query "Policies[?PolicyName=='RosaOadpVer1'].{ARN:Arn}" --output text) if [[ -z "${POLICY_ARN}" ]]; then $ cat << EOF > ${SCRATCH}/policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "s3:CreateBucket", "s3:DeleteBucket", "s3:PutBucketTagging", "s3:GetBucketTagging", "s3:PutEncryptionConfiguration", "s3:GetEncryptionConfiguration", "s3:PutLifecycleConfiguration", "s3:GetLifecycleConfiguration", "s3:GetBucketLocation", "s3:ListBucket", "s3:GetObject", "s3:PutObject", "s3:DeleteObject", "s3:ListBucketMultipartUploads", "s3:AbortMultipartUpload", "s3:ListMultipartUploadParts", "ec2:DescribeSnapshots", "ec2:DescribeVolumes", "ec2:DescribeVolumeAttribute", "ec2:DescribeVolumesModifications", "ec2:DescribeVolumeStatus", "ec2:CreateTags", "ec2:CreateVolume", "ec2:CreateSnapshot", "ec2:DeleteSnapshot" ], "Resource": "*" } ]} EOF $ POLICY_ARN=$(aws iam create-policy --policy-name "RosaOadpVer1" \ --policy-document file:///${SCRATCH}/policy.json --query Policy.Arn \ --tags Key=rosa_openshift_version,Value=${CLUSTER_VERSION} Key=rosa_role_prefix,Value=ManagedOpenShift Key=operator_namespace,Value=openshift-oadp Key=operator_name,Value=openshift-oadp \ --output text) fi $ echo ${POLICY_ARN}クラスターの IAM ロール信頼ポリシーを作成します。

$ cat <<EOF > ${SCRATCH}/trust-policy.json { "Version": "2012-10-17", "Statement": [{ "Effect": "Allow", "Principal": { "Federated": "arn:aws:iam::${AWS_ACCOUNT_ID}:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { "${OIDC_ENDPOINT}:sub": [ "system:serviceaccount:openshift-adp:openshift-adp-controller-manager", "system:serviceaccount:openshift-adp:velero"] } } }] } EOF $ ROLE_ARN=$(aws iam create-role --role-name \ "${ROLE_NAME}" \ --assume-role-policy-document file://${SCRATCH}/trust-policy.json \ --tags Key=rosa_cluster_id,Value=${ROSA_CLUSTER_ID} Key=rosa_openshift_version,Value=${CLUSTER_VERSION} Key=rosa_role_prefix,Value=ManagedOpenShift Key=operator_namespace,Value=openshift-adp Key=operator_name,Value=openshift-oadp \ --query Role.Arn --output text) $ echo ${ROLE_ARN}IAM ポリシーを IAM ロールに割り当てます。

$ aws iam attach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn ${POLICY_ARN}

7.2. クラスターへの OADP のデプロイ

OADP の namespace を作成します。

$ oc create namespace openshift-adp

認証情報のシークレットを作成します。

$ cat <<EOF > ${SCRATCH}/credentials [default] role_arn = ${ROLE_ARN} web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOF $ oc -n openshift-adp create secret generic cloud-credentials \ --from-file=${SCRATCH}/credentialsOADP Operator をデプロイします。

注記現在、Operator のバージョン 1.1 では、バックアップが

PartiallyFailedステータスになるという問題があります。これはバックアップと復元のプロセスには影響しないと思われますが、それに関連する問題があるため注意が必要です。$ cat << EOF | oc create -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: generateName: openshift-adp- namespace: openshift-adp name: oadp spec: targetNamespaces: - openshift-adp --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: redhat-oadp-operator namespace: openshift-adp spec: channel: stable-1.2 installPlanApproval: Automatic name: redhat-oadp-operator source: redhat-operators sourceNamespace: openshift-marketplace EOF

Operator の準備が整うまで待ちます。

$ watch oc -n openshift-adp get pods

出力例

NAME READY STATUS RESTARTS AGE openshift-adp-controller-manager-546684844f-qqjhn 1/1 Running 0 22s

クラウドストレージを作成します。

$ cat << EOF | oc create -f - apiVersion: oadp.openshift.io/v1alpha1 kind: CloudStorage metadata: name: ${CLUSTER_NAME}-oadp namespace: openshift-adp spec: creationSecret: key: credentials name: cloud-credentials enableSharedConfig: true name: ${CLUSTER_NAME}-oadp provider: aws region: $REGION EOFアプリケーションのストレージのデフォルトのストレージクラスを確認します。

$ oc get pvc -n <namespace> 1- 1

- アプリケーションの namespace を入力します。

出力例

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE applog Bound pvc-351791ae-b6ab-4e8b-88a4-30f73caf5ef8 1Gi RWO gp3-csi 4d19h mysql Bound pvc-16b8e009-a20a-4379-accc-bc81fedd0621 1Gi RWO gp3-csi 4d19h

$ oc get storageclass

出力例

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE gp2 kubernetes.io/aws-ebs Delete WaitForFirstConsumer true 4d21h gp2-csi ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3 ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h gp3-csi (default) ebs.csi.aws.com Delete WaitForFirstConsumer true 4d21h

gp3-csi、gp2-csi、gp3、または gp2 のいずれかを使用すると機能します。バックアップ対象のアプリケーションがすべて CSI を使用した PV を使用している場合は、OADP の DPA 設定に CSI プラグインを含めます。

CSI のみ: Data Protection Application をデプロイします。

$ cat << EOF | oc create -f - apiVersion: oadp.openshift.io/v1alpha1 kind: DataProtectionApplication metadata: name: ${CLUSTER_NAME}-dpa namespace: openshift-adp spec: backupImages: true features: dataMover: enable: false backupLocations: - bucket: cloudStorageRef: name: ${CLUSTER_NAME}-oadp credential: key: credentials name: cloud-credentials prefix: velero default: true config: region: ${REGION} configuration: velero: defaultPlugins: - openshift - aws - csi restic: enable: false EOF注記CSI ボリュームに対してこのコマンドを実行する場合は、次のステップをスキップできます。

非 CSI ボリューム: Data Protection Application をデプロイします。

$ cat << EOF | oc create -f - apiVersion: oadp.openshift.io/v1alpha1 kind: DataProtectionApplication metadata: name: ${CLUSTER_NAME}-dpa namespace: openshift-adp spec: backupImages: true features: dataMover: enable: false backupLocations: - bucket: cloudStorageRef: name: ${CLUSTER_NAME}-oadp credential: key: credentials name: cloud-credentials prefix: velero default: true config: region: ${REGION} configuration: velero: defaultPlugins: - openshift - aws restic: enable: false snapshotLocations: - velero: config: credentialsFile: /tmp/credentials/openshift-adp/cloud-credentials-credentials enableSharedConfig: 'true' profile: default region: ${REGION} provider: aws EOF

-

OADP 1.1.x ROSA STS 環境では、コンテナーイメージのバックアップと復元 (

spec.backupImages) の値はサポートされていないため、falseに設定する必要があります。 -

Restic 機能 (

restic.enable=false) は、ROSA STS 環境では無効になっており、サポートされていません。 -

DataMover 機能 (

dataMover.enable=false) は、ROSA STS 環境では無効になっており、サポートされていません。

7.3. バックアップの実行

次のサンプル hello-world アプリケーションには、永続ボリュームが接続されていません。どちらの DPA 設定も機能します。

バックアップするワークロードを作成します。

$ oc create namespace hello-world $ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

ルートを公開します。

$ oc expose service/hello-openshift -n hello-world

アプリケーションが動作していることを確認します。

$ curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`出力例

Hello OpenShift!

ワークロードをバックアップします。

$ cat << EOF | oc create -f - apiVersion: velero.io/v1 kind: Backup metadata: name: hello-world namespace: openshift-adp spec: includedNamespaces: - hello-world storageLocation: ${CLUSTER_NAME}-dpa-1 ttl: 720h0m0s EOFバックアップが完了するまで待ちます。

$ watch "oc -n openshift-adp get backup hello-world -o json | jq .status"

出力例

{ "completionTimestamp": "2022-09-07T22:20:44Z", "expiration": "2022-10-07T22:20:22Z", "formatVersion": "1.1.0", "phase": "Completed", "progress": { "itemsBackedUp": 58, "totalItems": 58 }, "startTimestamp": "2022-09-07T22:20:22Z", "version": 1 }デモワークロードを削除します。

$ oc delete ns hello-world

バックアップから復元します。

$ cat << EOF | oc create -f - apiVersion: velero.io/v1 kind: Restore metadata: name: hello-world namespace: openshift-adp spec: backupName: hello-world EOF

復元が完了するまで待ちます。

$ watch "oc -n openshift-adp get restore hello-world -o json | jq .status"

出力例

{ "completionTimestamp": "2022-09-07T22:25:47Z", "phase": "Completed", "progress": { "itemsRestored": 38, "totalItems": 38 }, "startTimestamp": "2022-09-07T22:25:28Z", "warnings": 9 }ワークロードが復元されていることを確認します。

$ oc -n hello-world get pods

出力例

NAME READY STATUS RESTARTS AGE hello-openshift-9f885f7c6-kdjpj 1/1 Running 0 90s

$ curl `oc get route/hello-openshift -n hello-world -o jsonpath='{.spec.host}'`出力例

Hello OpenShift!

- トラブルシューティングのヒントについては、OADP チームの トラブルシューティングドキュメント を参照してください。

- 追加のサンプルアプリケーションは、OADP チームの サンプルアプリケーションディレクトリー にあります。

7.4. クリーンアップ

ワークロードを削除します。

$ oc delete ns hello-world

バックアップおよび復元リソースが不要になった場合は、クラスターからリソースを削除します。

$ oc delete backup hello-world $ oc delete restore hello-world

s3 のバックアップ/復元オブジェクトとリモートオブジェクトを削除するには、以下を実行します。

$ velero backup delete hello-world $ velero restore delete hello-world

Data Protection Application を削除します。

$ oc -n openshift-adp delete dpa ${CLUSTER_NAME}-dpaクラウドストレージを削除します。

$ oc -n openshift-adp delete cloudstorage ${CLUSTER_NAME}-oadp警告このコマンドがハングした場合は、ファイナライザーの削除が必要になる場合があります。

$ oc -n openshift-adp patch cloudstorage ${CLUSTER_NAME}-oadp -p '{"metadata":{"finalizers":null}}' --type=mergeOperator が不要になった場合は、Operator を削除します。

$ oc -n openshift-adp delete subscription oadp-operator

Operator の namespace を削除します。

$ oc delete ns redhat-openshift-adp

カスタムリソース定義が不要になった場合は、クラスターからカスタムリソース定義を削除します。

$ for CRD in `oc get crds | grep velero | awk '{print $1}'`; do oc delete crd $CRD; done $ for CRD in `oc get crds | grep -i oadp | awk '{print $1}'`; do oc delete crd $CRD; doneAWS S3 バケットを削除します。

$ aws s3 rm s3://${CLUSTER_NAME}-oadp --recursive $ aws s3api delete-bucket --bucket ${CLUSTER_NAME}-oadpロールからポリシーの割り当てを解除します。

$ aws iam detach-role-policy --role-name "${ROLE_NAME}" \ --policy-arn "${POLICY_ARN}"ロールを削除します。

$ aws iam delete-role --role-name "${ROLE_NAME}"

第8章 チュートリアル: ROSA 上の AWS Load Balancer Operator

このコンテンツは Red Hat のエキスパートが作成したものですが、サポート対象のすべての設定でまだテストされていません。

AWS Load Balancer Operator によって作成されたロードバランサーは、OpenShift ルート には使用できません。OpenShift ルートのレイヤー 7 機能をすべて必要としない個々のサービスまたは Ingress リソースにのみ使用する必要があります。

AWS Load Balancer Controller は、Red Hat OpenShift Service on AWS (ROSA) クラスターの AWS Elastic Load Balancer を管理します。このコントローラーは、Kubernetes Ingress リソースを作成するときに AWS Application Load Balancer (ALB) をプロビジョニングし、LoadBalancer タイプを使用して Kubernetes Service リソースを実装するときに AWS Network Load Balancer (NLB) をプロビジョニングします。

デフォルトの AWS インツリーロードバランサープロバイダーと比較して、このコントローラーは ALB と NLB 用の詳細なアノテーションを使用して開発されています。高度な使用例としては以下が挙げられます。

- ネイティブ Kubernetes Ingress オブジェクトと ALB を使用する

- AWS ウェブアプリケーションファイアウォール (WAF) サービスと ALB を統合する

- カスタムの NLB ソース IP 範囲を指定する

- カスタムの NLB 内部 IP アドレスを指定する

AWS Load Balancer Operator は、ROSA クラスター内の aws-load-balancer-controller のインスタンスをインストール、管理、設定するために使用します。

8.1. 前提条件

AWS ALB には、マルチ AZ クラスターと、クラスターと同じ VPC 内の 3 つの AZ に分割された 3 つのパブリックサブネットが必要です。このため、ALB は多くの PrivateLink クラスターには適していません。AWS NLB にはこの制限はありません。

- マルチ AZ ROSA Classic クラスター

- BYO VPC クラスター

- AWS CLI

- OC CLI

8.1.1. 環境

環境変数を準備します。

$ export AWS_PAGER="" $ export ROSA_CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${ROSA_CLUSTER_NAME}/alb-operator" $ mkdir -p ${SCRATCH} $ echo "Cluster: ${ROSA_CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

8.1.2. AWS VPC とサブネット

このセクションは、既存の VPC にデプロイされたクラスターにのみ適用されます。クラスターを既存の VPC にデプロイしなかった場合は、このセクションをスキップして、その後のインストールセクションに進んでください。

以下の変数を、ROSA デプロイメントに合わせて適切な値に設定します。

$ export VPC_ID=<vpc-id> $ export PUBLIC_SUBNET_IDS=<public-subnets> $ export PRIVATE_SUBNET_IDS=<private-subnets> $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}")クラスター名を使用してクラスターの VPC にタグを追加します。

$ aws ec2 create-tags --resources ${VPC_ID} --tags Key=kubernetes.io/cluster/${CLUSTER_NAME},Value=owned --region ${REGION}パブリックサブネットにタグを追加します。

$ aws ec2 create-tags \ --resources ${PUBLIC_SUBNET_IDS} \ --tags Key=kubernetes.io/role/elb,Value='' \ --region ${REGION}プライベートサブネットにタグを追加します。

$ aws ec2 create-tags \ --resources "${PRIVATE_SUBNET_IDS}" \ --tags Key=kubernetes.io/role/internal-elb,Value='' \ --region ${REGION}

8.2. Installation

AWS Load Balancer Controller の AWS IAM ポリシーを作成します。

注記このポリシーは、アップストリームの AWS Load Balancer Controller ポリシー に加えて、サブネット上にタグを作成する権限から取得されます。これは Operator が機能するために必要です。

$ oc new-project aws-load-balancer-operator $ POLICY_ARN=$(aws iam list-policies --query \ "Policies[?PolicyName=='aws-load-balancer-operator-policy'].{ARN:Arn}" \ --output text) $ if [[ -z "${POLICY_ARN}" ]]; then wget -O "${SCRATCH}/load-balancer-operator-policy.json" \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/rosa/aws-load-balancer-operator/load-balancer-operator-policy.json POLICY_ARN=$(aws --region "$REGION" --query Policy.Arn \ --output text iam create-policy \ --policy-name aws-load-balancer-operator-policy \ --policy-document "file://${SCRATCH}/load-balancer-operator-policy.json") fi $ echo $POLICY_ARNAWS Load Balancer Operator の AWS IAM 信頼ポリシーを作成します。

$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": ["system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-operator-controller-manager", "system:serviceaccount:aws-load-balancer-operator:aws-load-balancer-controller-cluster"] } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOFAWS Load Balancer Operator の AWS IAM ロールを作成します。

$ ROLE_ARN=$(aws iam create-role --role-name "${ROSA_CLUSTER_NAME}-alb-operator" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text) $ echo $ROLE_ARN $ aws iam attach-role-policy --role-name "${ROSA_CLUSTER_NAME}-alb-operator" \ --policy-arn $POLICY_ARN新しく作成した AWS IAM ロールを引き受けるための AWS Load Balancer Operator 用のシークレットを作成します。

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Secret metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator stringData: credentials: | [default] role_arn = $ROLE_ARN web_identity_token_file = /var/run/secrets/openshift/serviceaccount/token EOFRed Hat AWS Load Balancer Operator をインストールします。

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: aws-load-balancer-operator namespace: aws-load-balancer-operator spec: channel: stable-v1.0 installPlanApproval: Automatic name: aws-load-balancer-operator source: redhat-operators sourceNamespace: openshift-marketplace startingCSV: aws-load-balancer-operator.v1.0.0 EOF

次の Operator を使用して、AWS Load Balancer Controller のインスタンスをデプロイします。

注記ここでエラーが発生した場合は、少し待ってから再試行してください。エラーが発生するのは、Operator がまだインストールを完了していないためです。

$ cat << EOF | oc apply -f - apiVersion: networking.olm.openshift.io/v1 kind: AWSLoadBalancerController metadata: name: cluster spec: credentials: name: aws-load-balancer-operator EOFOperator Pod とコントローラー Pod の両方が実行されていることを確認します。

$ oc -n aws-load-balancer-operator get pods

次のようなメッセージが表示されます。表示されない場合は、少し待ってから再試行してください。

NAME READY STATUS RESTARTS AGE aws-load-balancer-controller-cluster-6ddf658785-pdp5d 1/1 Running 0 99s aws-load-balancer-operator-controller-manager-577d9ffcb9-w6zqn 2/2 Running 0 2m4s

8.3. デプロイメントの検証

新しいプロジェクトを作成します。

$ oc new-project hello-world

Hello World アプリケーションをデプロイします。

$ oc new-app -n hello-world --image=docker.io/openshift/hello-openshift

AWS ALB が接続する NodePort サービスを設定します。

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Service metadata: name: hello-openshift-nodeport namespace: hello-world spec: ports: - port: 80 targetPort: 8080 protocol: TCP type: NodePort selector: deployment: hello-openshift EOFAWS Load Balancer Operator を使用して AWS ALB をデプロイします。

$ cat << EOF | oc apply -f - apiVersion: networking.k8s.io/v1 kind: Ingress metadata: name: hello-openshift-alb namespace: hello-world annotations: alb.ingress.kubernetes.io/scheme: internet-facing spec: ingressClassName: alb rules: - http: paths: - path: / pathType: Exact backend: service: name: hello-openshift-nodeport port: number: 80 EOFAWS ALB Ingress エンドポイントを curl して、Hello World アプリケーションにアクセスできることを確認します。

注記AWS ALB のプロビジョニングには数分かかります。

curl: (6) Could not resolve hostというエラーが表示された場合は、待機してから再試行してください。$ INGRESS=$(oc -n hello-world get ingress hello-openshift-alb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${INGRESS}"出力例

Hello OpenShift!

Hello World アプリケーション用に AWS NLB をデプロイします。

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Service metadata: name: hello-openshift-nlb namespace: hello-world annotations: service.beta.kubernetes.io/aws-load-balancer-type: external service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: instance service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing spec: ports: - port: 80 targetPort: 8080 protocol: TCP type: LoadBalancer selector: deployment: hello-openshift EOFAWS NLB エンドポイントをテストします。

注記NLB のプロビジョニングには数分かかります。

curl: (6) Could not resolve hostというエラーが表示された場合は、待機してから再試行してください。$ NLB=$(oc -n hello-world get service hello-openshift-nlb \ -o jsonpath='{.status.loadBalancer.ingress[0].hostname}') $ curl "http://${NLB}"出力例

Hello OpenShift!

8.4. クリーンアップ

hello world アプリケーションの namespace (および namespace 内のすべてのリソース) を削除します。

$ oc delete project hello-world

AWS Load Balancer Operator と AWS IAM ロールを削除します。

$ oc delete subscription aws-load-balancer-operator -n aws-load-balancer-operator $ aws iam detach-role-policy \ --role-name "${ROSA_CLUSTER_NAME}-alb-operator" \ --policy-arn $POLICY_ARN $ aws iam delete-role \ --role-name "${ROSA_CLUSTER_NAME}-alb-operator"AWS IAM ポリシーを削除します。

$ aws iam delete-policy --policy-arn $POLICY_ARN

第9章 チュートリアル: Ingress Controller でカスタム TLS 暗号を使用するように ROSA/OSD を設定する

このコンテンツは Red Hat のエキスパートが作成したものですが、サポート対象のすべての設定でまだテストされていません。

ここでは、クラスターの Ingress Controller と、Custom Domain Operator によって作成された Ingress Controller に適切にパッチを適用する方法を説明します。この機能を使用すると、クラスター Ingress Controller の tlsSecurityProfile 値を変更できます。ここでは、カスタムの tlsSecurityProfile、関連するロールとロールバインディングを持つスコープ指定されたサービスアカウント、および Ingress Controller が再作成または変更された場合に暗号の変更を 60 分で再適用する CronJob を適用する方法を説明します。

前提条件

-

tlsSecurityProfileのオプションについて説明している OpenShift ドキュメント を確認している。デフォルトでは、Ingress Controller は、Intermediate Mozilla プロファイル に相当するIntermediateプロファイルを使用するように設定されています。

手順

CronJob が使用するサービスアカウントを作成します。

サービスアカウントを使用すると、CronJob は通常のユーザーの認証情報を使用せずにクラスター API に直接アクセスできます。サービスアカウントを作成するには、次のコマンドを実行します。

$ oc create sa cron-ingress-patch-sa -n openshift-ingress-operator

Ingress Controller にパッチを適用するための制限付きアクセスを許可するロールとロールバインディングを作成します。

クラスター内のセキュリティーを確保するには、ロールベースのアクセス制御 (RBAC) が重要です。ロールを作成すると、クラスター内で必要な API リソースだけにスコープが限定されたアクセス権を提供できるようになります。ロールを作成するには、次のコマンドを実行します。

$ oc create role cron-ingress-patch-role --verb=get,patch,update --resource=ingresscontroller.operator.openshift.io -n openshift-ingress-operator

ロールを作成したら、ロールバインディングを使用してサービスアカウントにロールをバインドする必要があります。ロールバインディングを作成するには、次のコマンドを実行します。

$ oc create rolebinding cron-ingress-patch-rolebinding --role=cron-ingress-patch-role --serviceaccount=openshift-ingress-operator:cron-ingress-patch-sa -n openshift-ingress-operator

Ingress Controller にパッチを適用します。

重要以下に示す例では、Ingress Controller の

tlsSecurityProfileに別の暗号を追加して、Windows Server 2008 R2 からの IE 11 アクセスを許可します。このコマンドはお客様固有のビジネス要件に合わせて変更してください。CronJob を作成する前に、

tlsSecurityProfile設定を適用して変更を検証します。このプロセスは、Custom Domain Operator を使用するかどうかによって異なります。Custom Domain Operator を使用しないクラスターの場合:

デフォルトの Ingress Controller のみを使用し、Custom Domain Operator を使用しない場合は、次のコマンドを実行して Ingress Controller にパッチを適用します。

$ oc patch ingresscontroller/default -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}'このパッチは、RSA 証明書の使用時に Windows Server 2008 R2 上の IE 11 からのアクセスを許可する

TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA暗号を追加します。コマンドを実行すると、次のような応答が返されます。

出力例

ingresscontroller.operator.openshift.io/default patched

Custom Domain Operator を使用するクラスターの場合:

Custom Domain Operator を使用するお客様は、各 Ingress Controller をループ処理して、それぞれにパッチを適用する必要があります。クラスターのすべての Ingress Controller にパッチを適用するには、次のコマンドを実行します。

$ for ic in $(oc get ingresscontroller -o name -n openshift-ingress-operator); do oc patch ${ic} -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}'; doneコマンドを実行すると、次のような応答が返されます。

出力例

ingresscontroller.operator.openshift.io/default patched ingresscontroller.operator.openshift.io/custom1 patched ingresscontroller.operator.openshift.io/custom2 patched

CronJob を作成して、TLS 設定が上書きされないようにします。

場合によっては、クラスターの Ingress Controller が再作成されることがあります。このような場合、Ingress Controller は適用された

tlsSecurityProfileの変更を保持しない可能性があります。これを回避するには、クラスターの Ingress Controller を経由および更新する CronJob を作成します。このプロセスは、Custom Domain Operator を使用するかどうかによって異なります。Custom Domain Operator を使用しないクラスターの場合:

Custom Domain Operator を使用しない場合は、次のコマンドを実行して CronJob を作成します。

$ cat << EOF | oc apply -f - apiVersion: batch/v1 kind: CronJob metadata: name: tls-patch namespace: openshift-ingress-operator spec: schedule: '@hourly' jobTemplate: spec: template: spec: containers: - name: tls-patch image: registry.redhat.io/openshift4/ose-tools-rhel8:latest args: - /bin/sh - '-c' - oc patch ingresscontroller/default -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}' restartPolicy: Never serviceAccountName: cron-ingress-patch-sa EOF注記この CronJob は 1 時間ごとに実行され、必要に応じて Ingress Controller にパッチを適用します。この CronJob は常時実行しないことが重要です。調整がトリガーされ、OpenShift Ingress Operator に過負荷がかかる可能性があるためです。ほとんどの場合、何も変更されないため、CronJob Pod のログは次の例のようになります。

出力例

ingresscontroller.operator.openshift.io/default patched (no change)

Custom Domain Operator を使用するクラスターの場合:

Custom Domain Operator を使用する場合、CronJob は各 Ingress Controller をループ処理して、それぞれにパッチを適用する必要があります。この CronJob を作成するには、次のコマンドを実行します。

$ cat << EOF | oc apply -f - apiVersion: batch/v1 kind: CronJob metadata: name: tls-patch namespace: openshift-ingress-operator spec: schedule: '@hourly' jobTemplate: spec: template: spec: containers: - name: tls-patch image: registry.redhat.io/openshift4/ose-tools-rhel8:latest args: - /bin/sh - '-c' - for ic in $(oc get ingresscontroller -o name -n openshift-ingress-operator); do oc patch ${ic} -n openshift-ingress-operator --type=merge -p '{"spec":{"tlsSecurityProfile":{"type":"Custom","custom":{"ciphers":["TLS_AES_128_GCM_SHA256","TLS_AES_256_GCM_SHA384","ECDHE-ECDSA-AES128-GCM-SHA256","ECDHE-RSA-AES128-GCM-SHA256","ECDHE-ECDSA-AES256-GCM-SHA384","ECDHE-RSA-AES256-GCM-SHA384","ECDHE-ECDSA-CHACHA20-POLY1305","ECDHE-RSA-CHACHA20-POLY1305","DHE-RSA-AES128-GCM-SHA256","DHE-RSA-AES256-GCM-SHA384","TLS_CHACHA20_POLY1305_SHA256","TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA"],"minTLSVersion":"VersionTLS12"}}}}'; done restartPolicy: Never serviceAccountName: cron-ingress-patch-sa EOF注記この CronJob は 1 時間ごとに実行され、必要に応じて Ingress Controller にパッチを適用します。この CronJob は常時実行しないことが重要です。調整がトリガーされ、OpenShift Ingress Operator に過負荷がかかる可能性があるためです。ほとんどの場合、何も変更されないため、CronJob Pod のログは次のようになります。

出力例

ingresscontroller.operator.openshift.io/default patched (no change) ingresscontroller.operator.openshift.io/custom1 patched (no change) ingresscontroller.operator.openshift.io/custom2 patched (no change)

第10章 チュートリアル: Microsoft Entra ID (旧称 Azure Active Directory) をアイデンティティープロバイダーとして設定する

Microsoft Entra ID (旧称 Azure Active Directory) を Red Hat OpenShift Service on AWS (ROSA) のクラスターアイデンティティープロバイダーとして設定できます。

このチュートリアルでは、次のタスクを完了する手順を示します。

- 認証のために Entra ID に新しいアプリケーションを登録します。

- Entra ID でのアプリケーション登録を設定して、トークンに任意のクレームとグループクレームを含めます。

- Entra ID をアイデンティティープロバイダーとして使用するように Red Hat OpenShift Service on AWS クラスターを設定します。

- 個々のグループに追加の権限を付与します。

10.1. 前提条件

- Microsoft のドキュメント に従って、一連のセキュリティーグループを作成し、ユーザーを割り当てている。

10.2. 認証のために Entra ID に新規アプリケーションを登録する

Entra ID にアプリケーションを登録するには、まず OAuth コールバック URL を作成し、次にアプリケーションを登録します。

手順

指定の変数を変更し、次のコマンドを実行して、クラスターの OAuth コールバック URL を作成します。

注記このコールバック URL を忘れずに保存してください。後のプロセスで必要になります。

$ domain=$(rosa describe cluster -c <cluster_name> | grep "DNS" | grep -oE '\S+.openshiftapps.com') $ echo "OAuth callback URL: https://oauth-openshift.apps.$domain/oauth2callback/AAD"

OAuth コールバック URL の末尾にある "AAD" ディレクトリーは、このプロセスで後で設定する OAuth アイデンティティープロバイダー名と同じである必要があります。

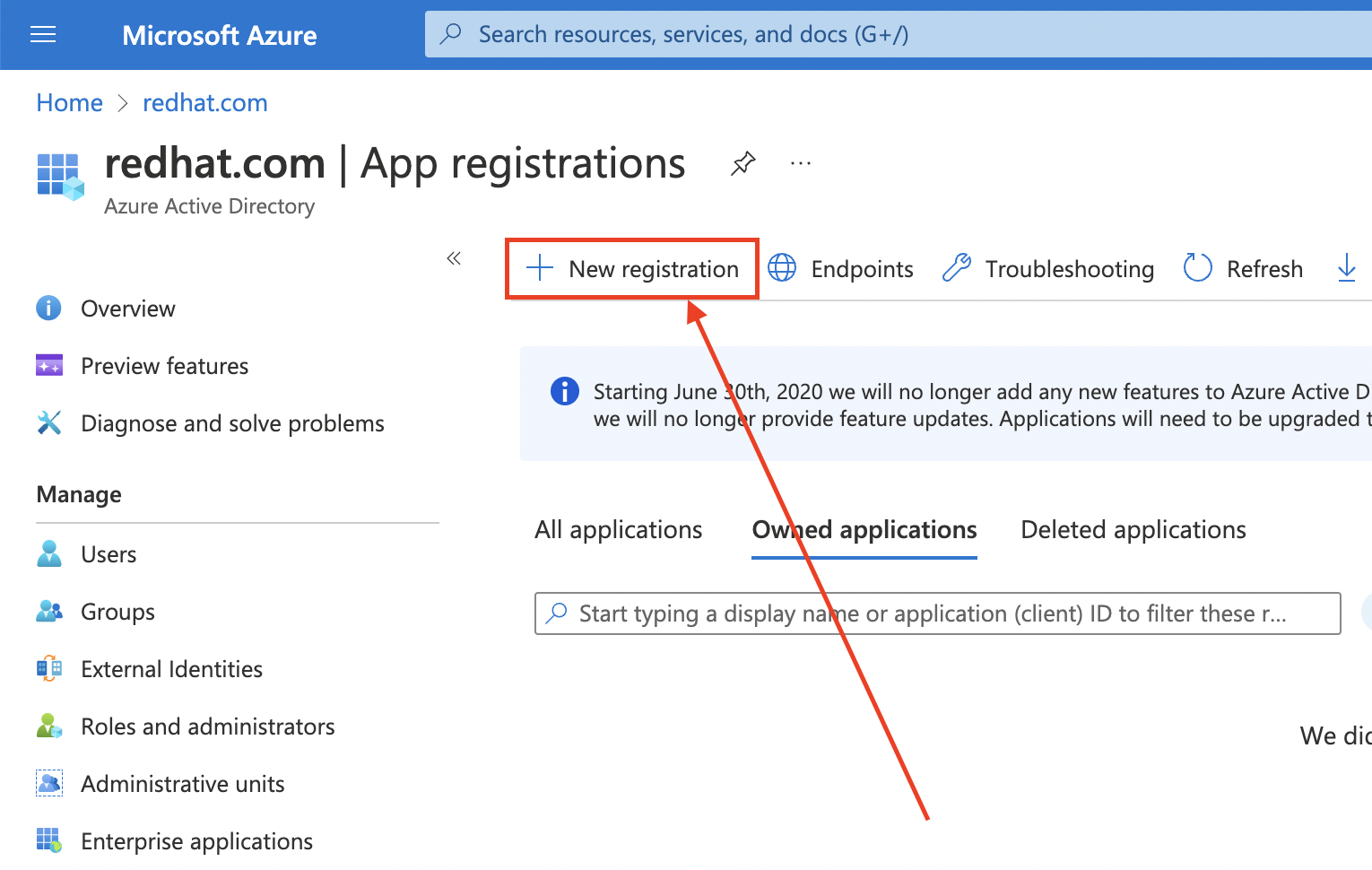

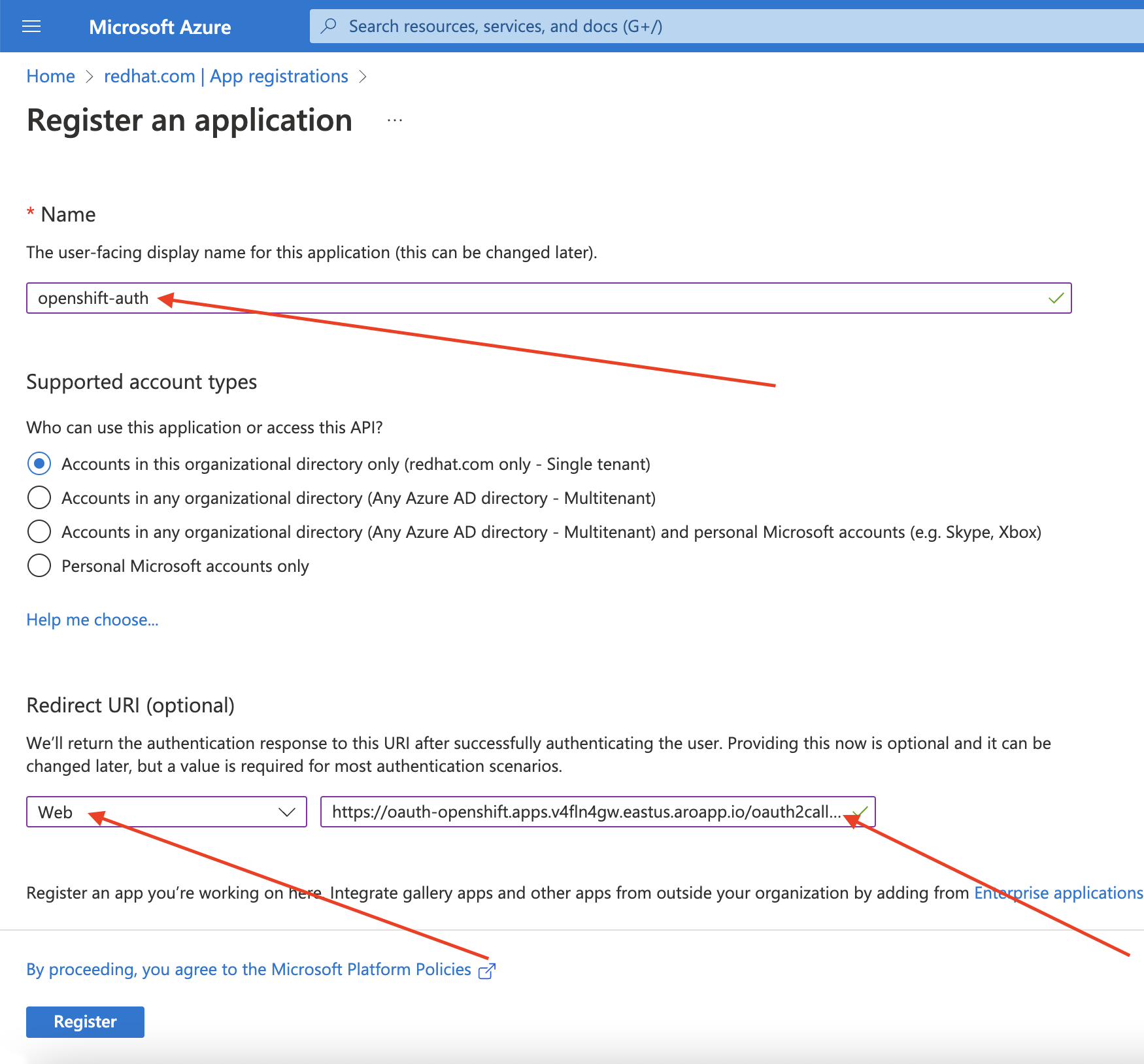

Azure portal にログインして Entra ID アプリケーションを作成し、App registrations ブレード を選択します。次に、New registration を選択して新しいアプリケーションを作成します。

-

アプリケーションに名前を付けます (例:

openshift-auth)。 - Redirect URI ドロップダウンから Web を選択し、前のステップで取得した OAuth コールバック URL の値を入力します。

必要な情報を入力したら、Register をクリックしてアプリケーションを作成します。

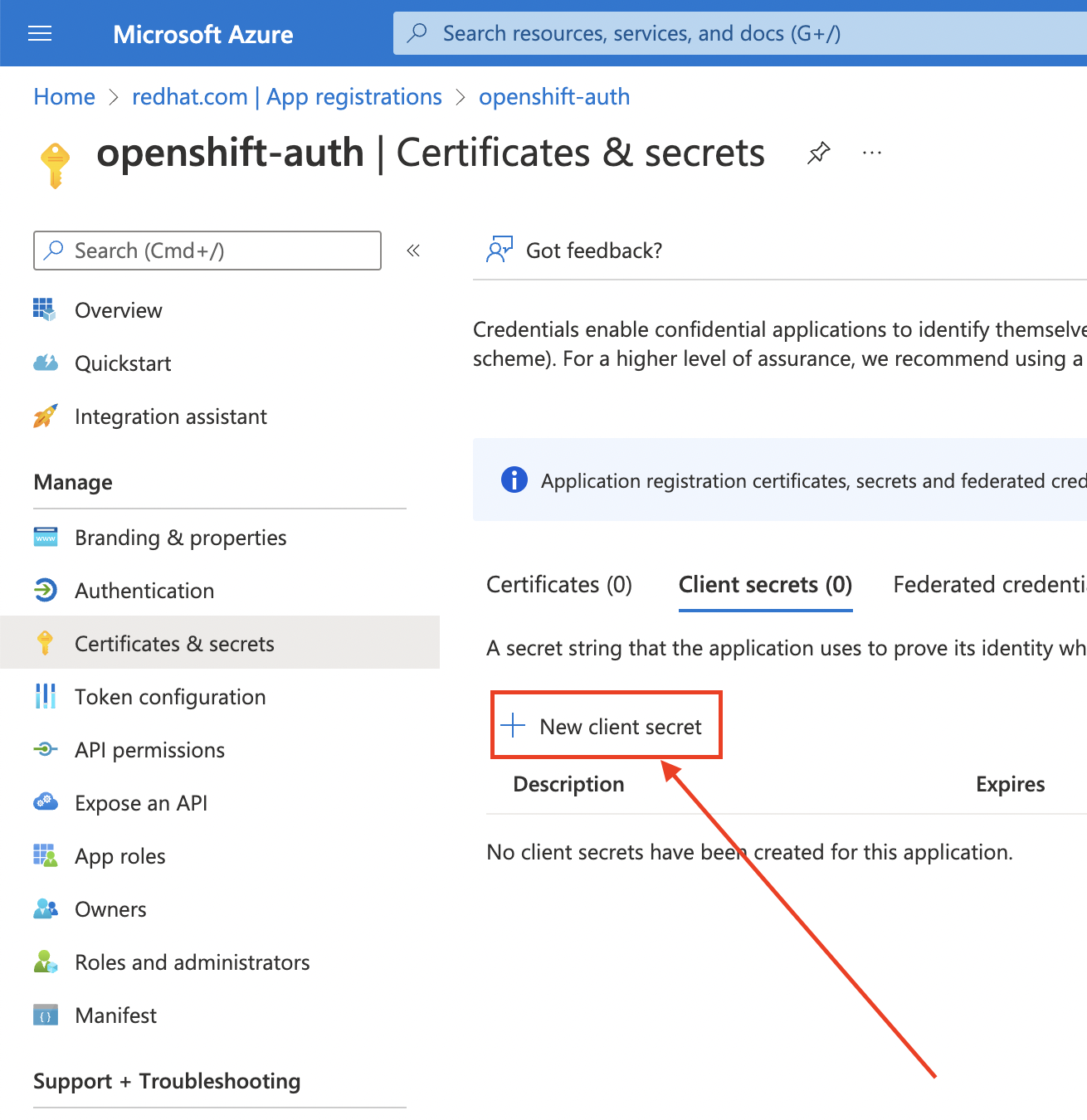

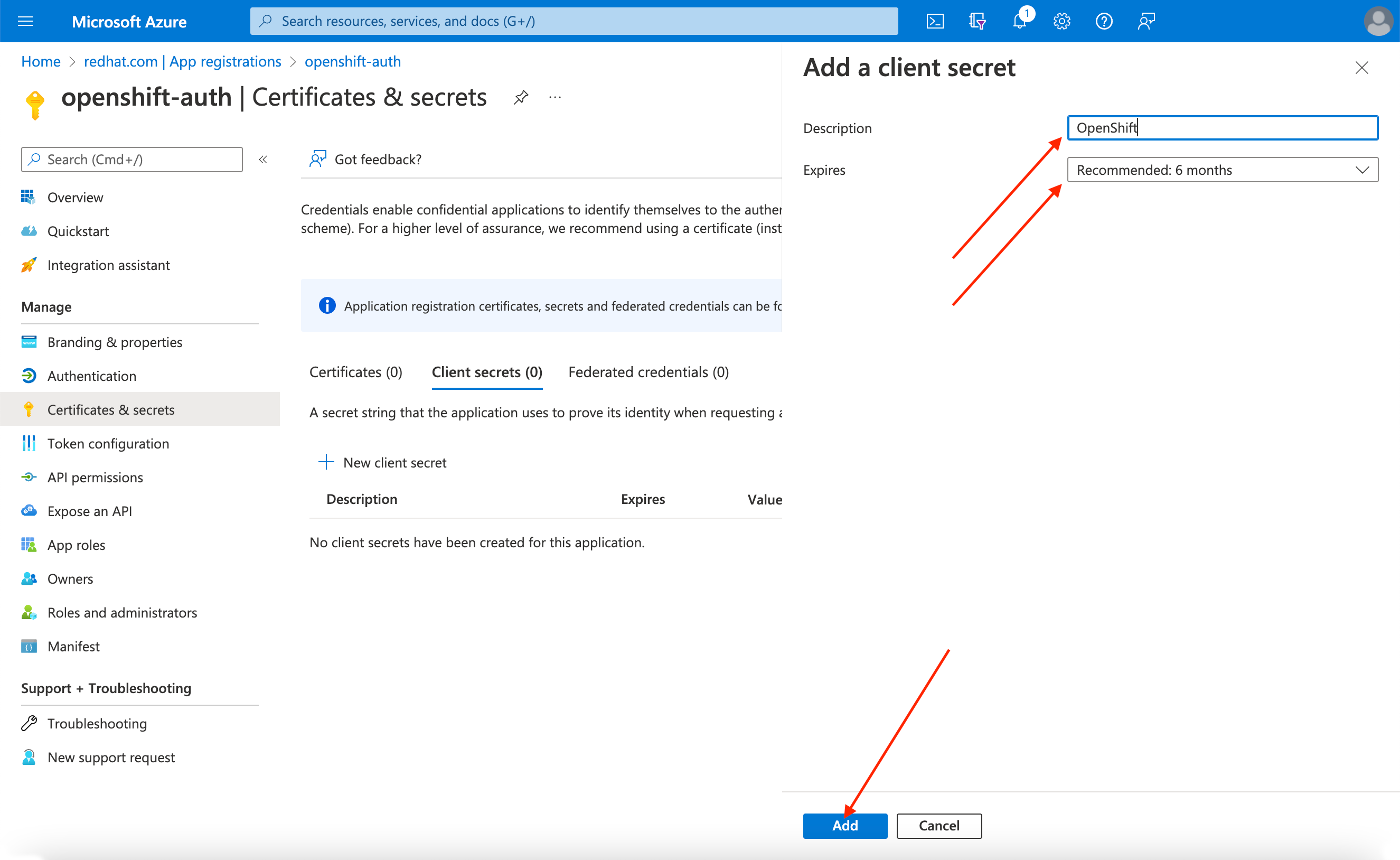

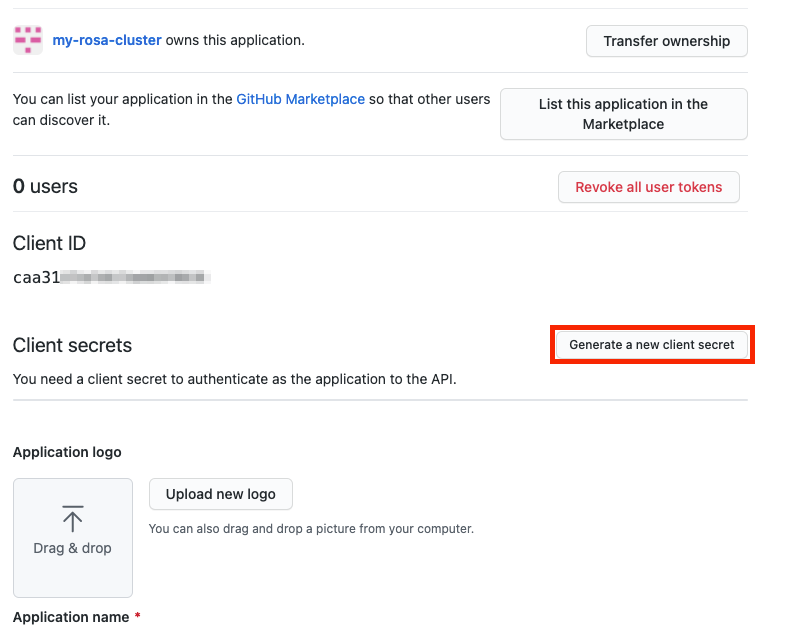

Certificates & secrets サブブレードを選択し、New client secret を選択します。

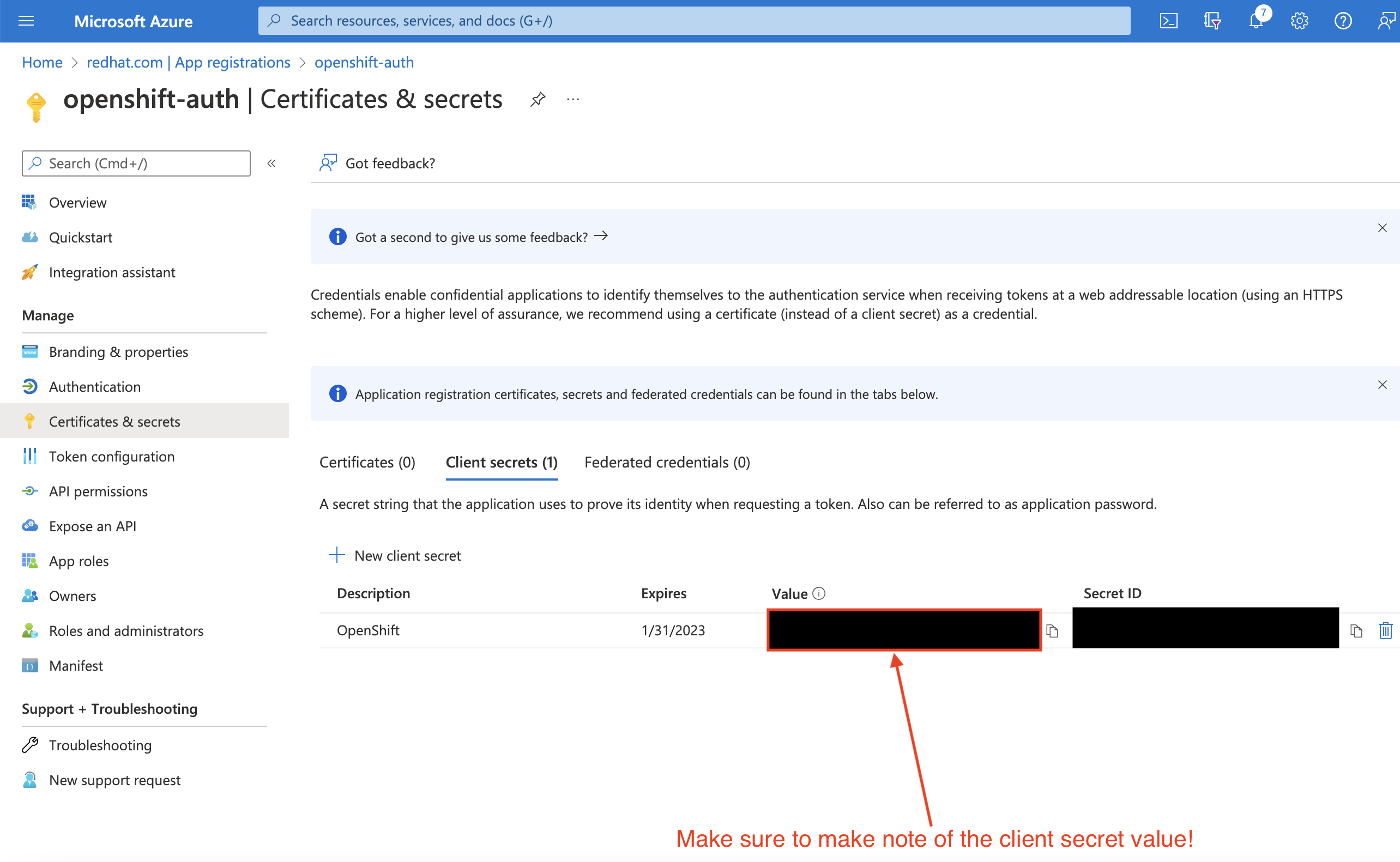

要求された詳細を入力し、生成されたクライアントシークレット値を保存します。このシークレットは、このプロセスで後で必要になります。

重要初期セットアップ後は、クライアントシークレットを確認できません。クライアントシークレットを保存しなかった場合は、新しいクライアントシークレットを生成する必要があります。

Overview サブブレードを選択し、

Application (client) IDとDirectory (tenant) IDをメモします。これらの値は後のステップで必要になります。

10.3. 任意のクレームとグループクレームを含めるように Entra ID でのアプリケーション登録を設定する

Red Hat OpenShift Service on AWS がユーザーのアカウントを作成するのに十分な情報を取得できるように、Entra ID を設定して 2 つの任意のクレーム (email と preferred_username) を指定する必要があります。Entra ID の任意のクレームに関する詳細は、Microsoft のドキュメント を参照してください。

個々のユーザー認証に加えて、Red Hat OpenShift Service on AWS はグループクレーム機能を提供します。この機能により、Entra ID などの OpenID Connect (OIDC) アイデンティティープロバイダーが、Red Hat OpenShift Service on AWS 内で使用するユーザーのグループメンバーシップを提供できるようになります。

任意のクレームの設定

Entra ID の任意のクレームを設定できます。

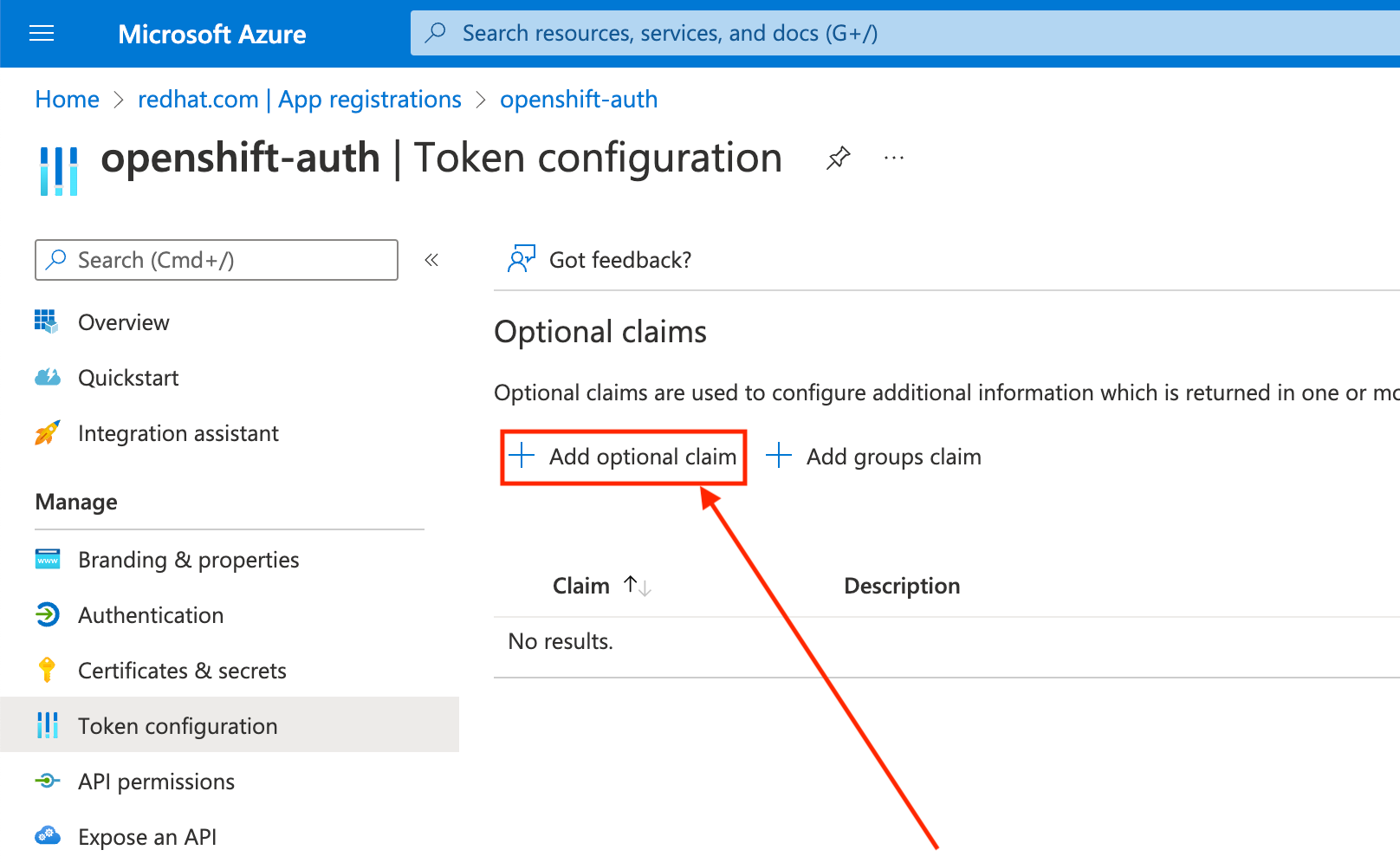

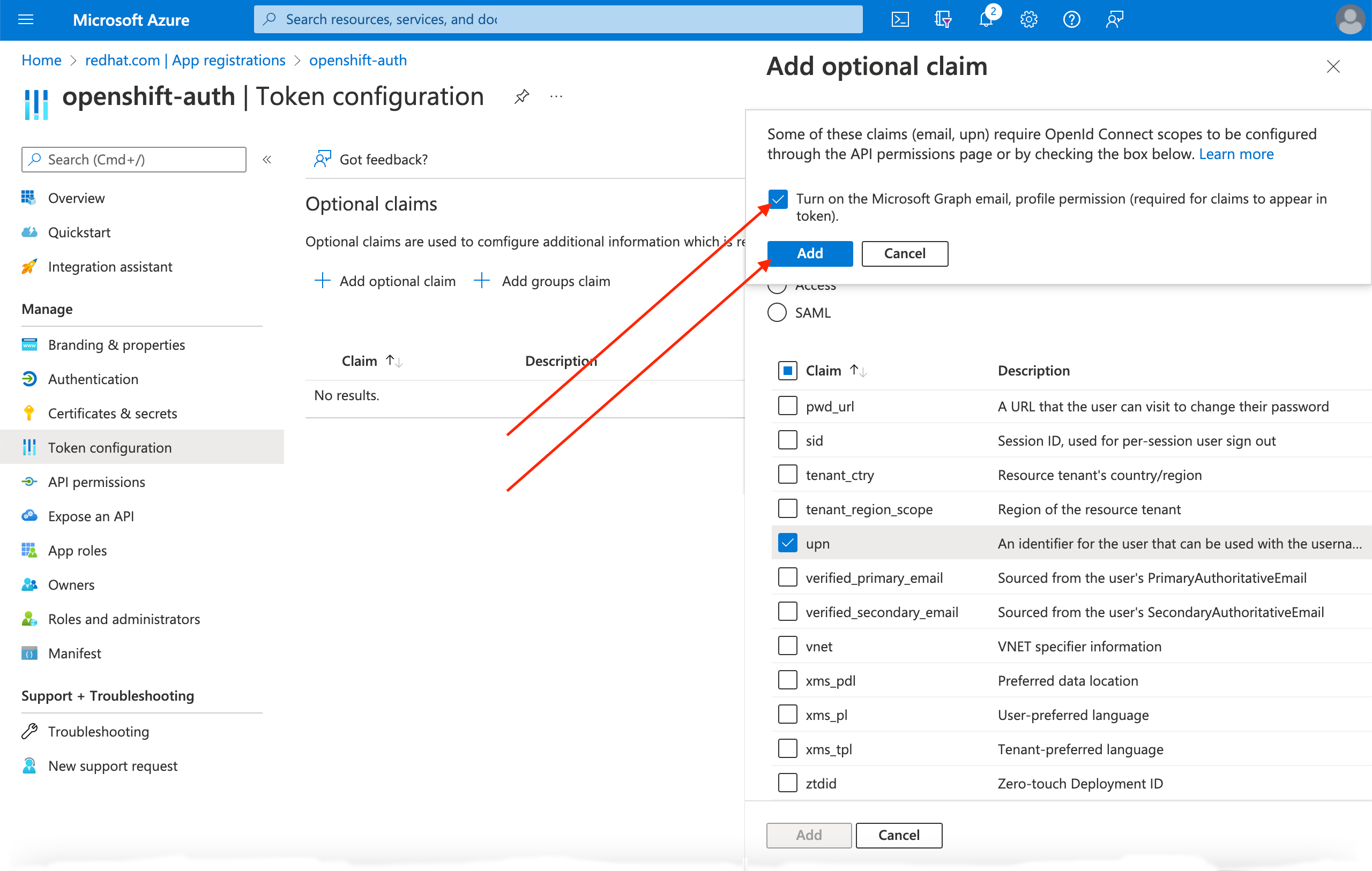

Token configuration サブブレードをクリックし、Add optional claim ボタンを選択します。

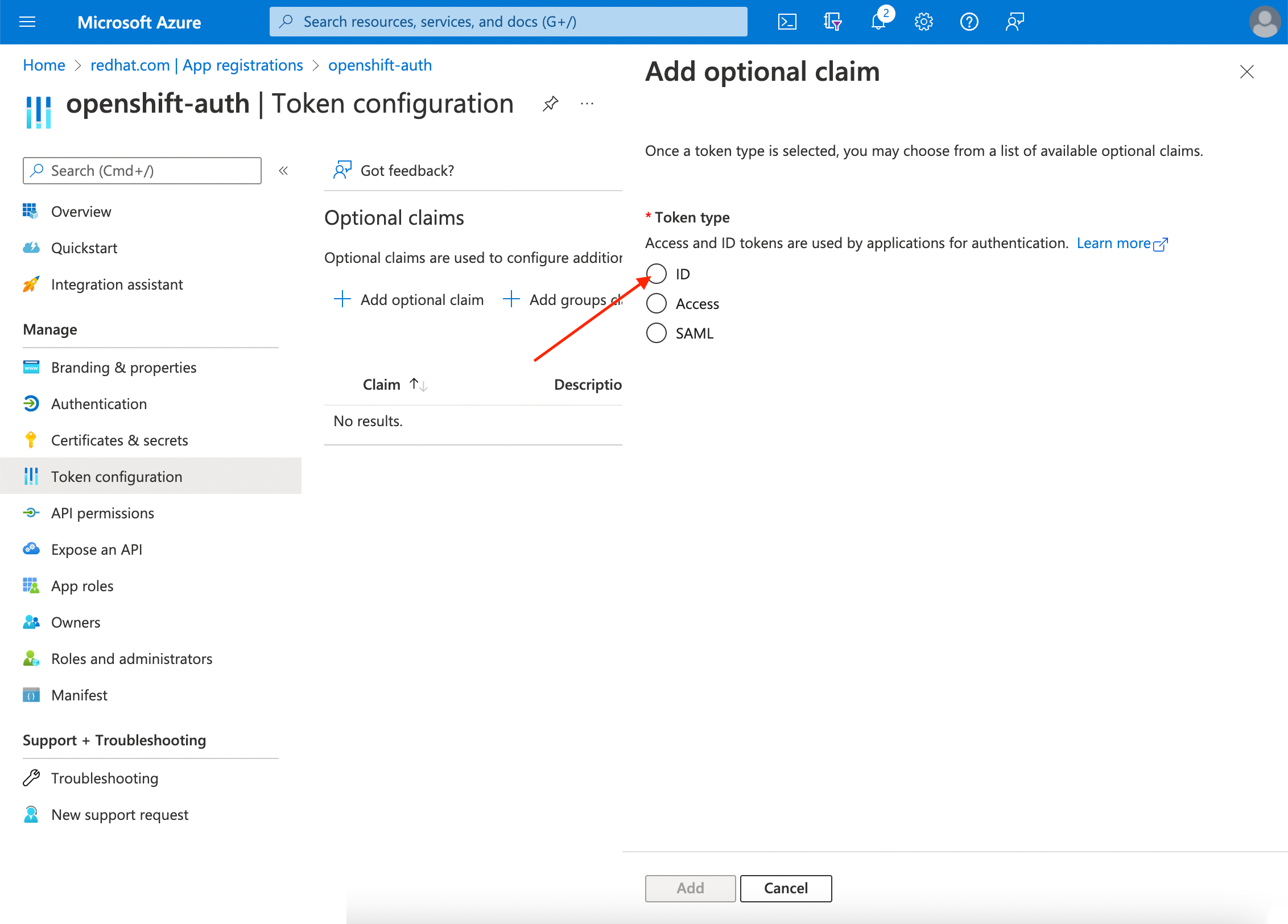

ID ラジオボタンを選択します。

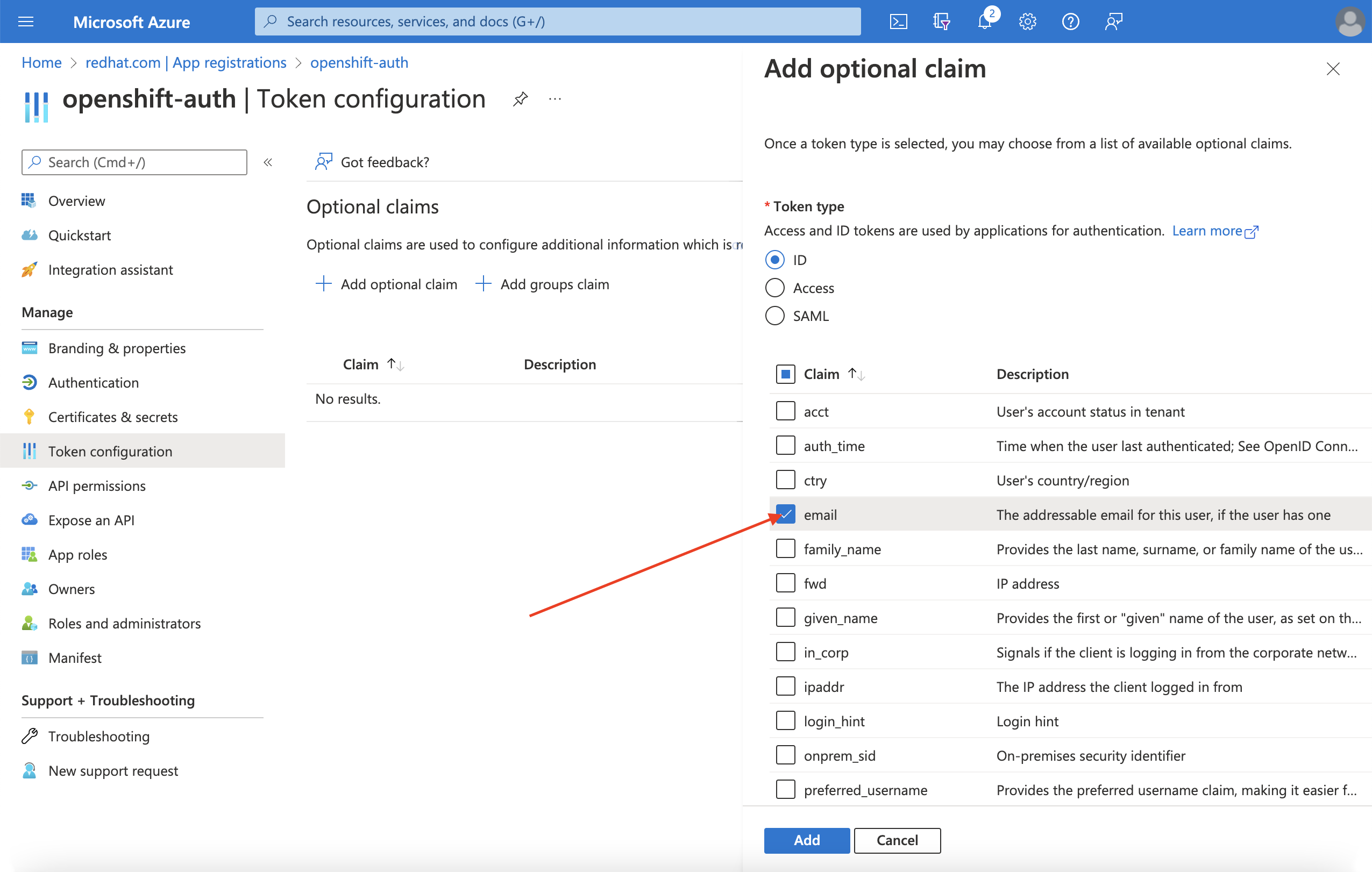

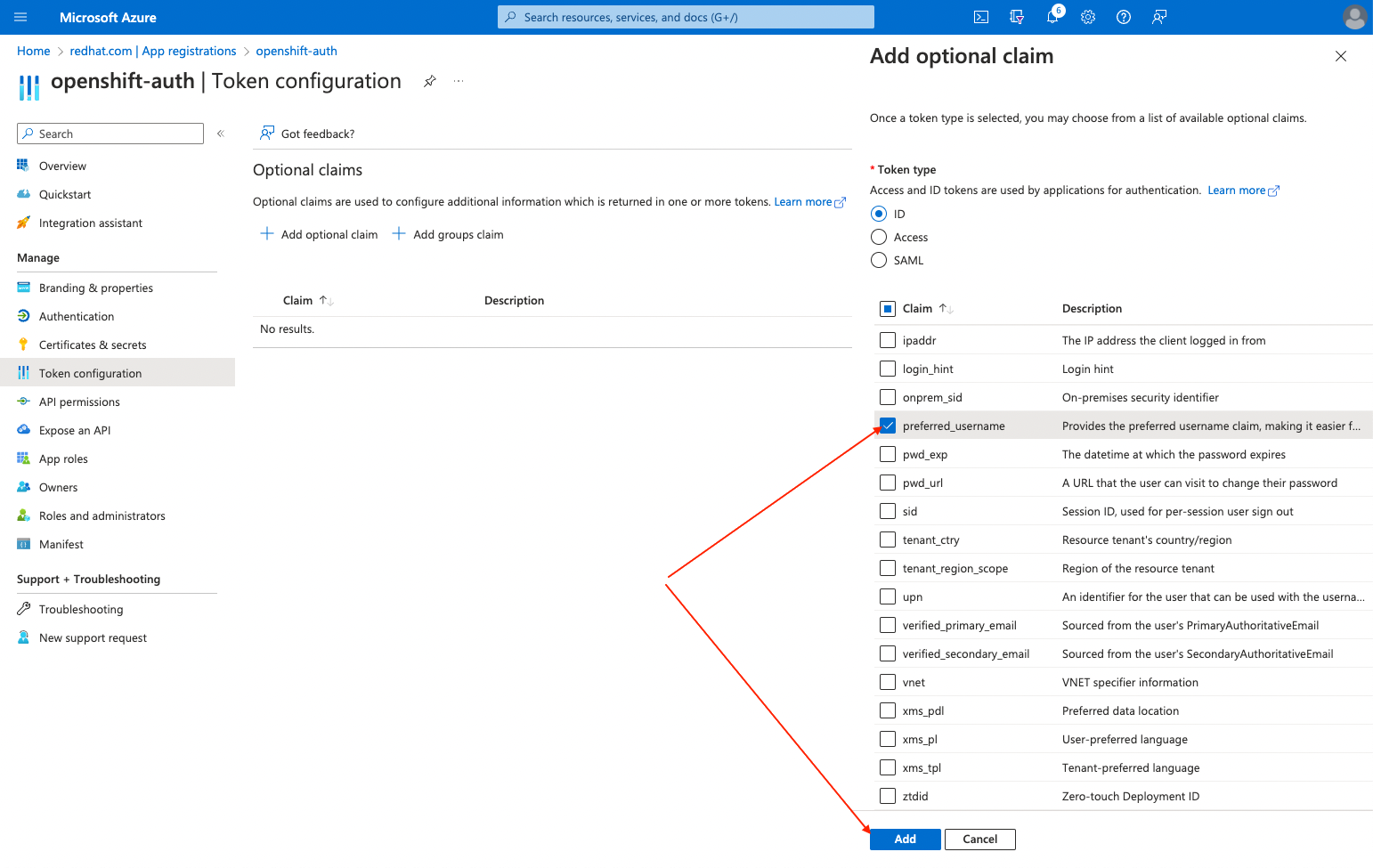

email クレームのチェックボックスを選択します。

preferred_usernameクレームのチェックボックスを選択します。次に、Add をクリックし、Entra ID アプリケーションの email および preferred_username クレームを設定します。

ページの上部にダイアログボックスが表示されます。プロンプトに従って、必要な Microsoft Graph 権限を有効にします。

グループクレームの設定 (オプション)

グループクレームを提供するように Entra ID を設定します。

手順

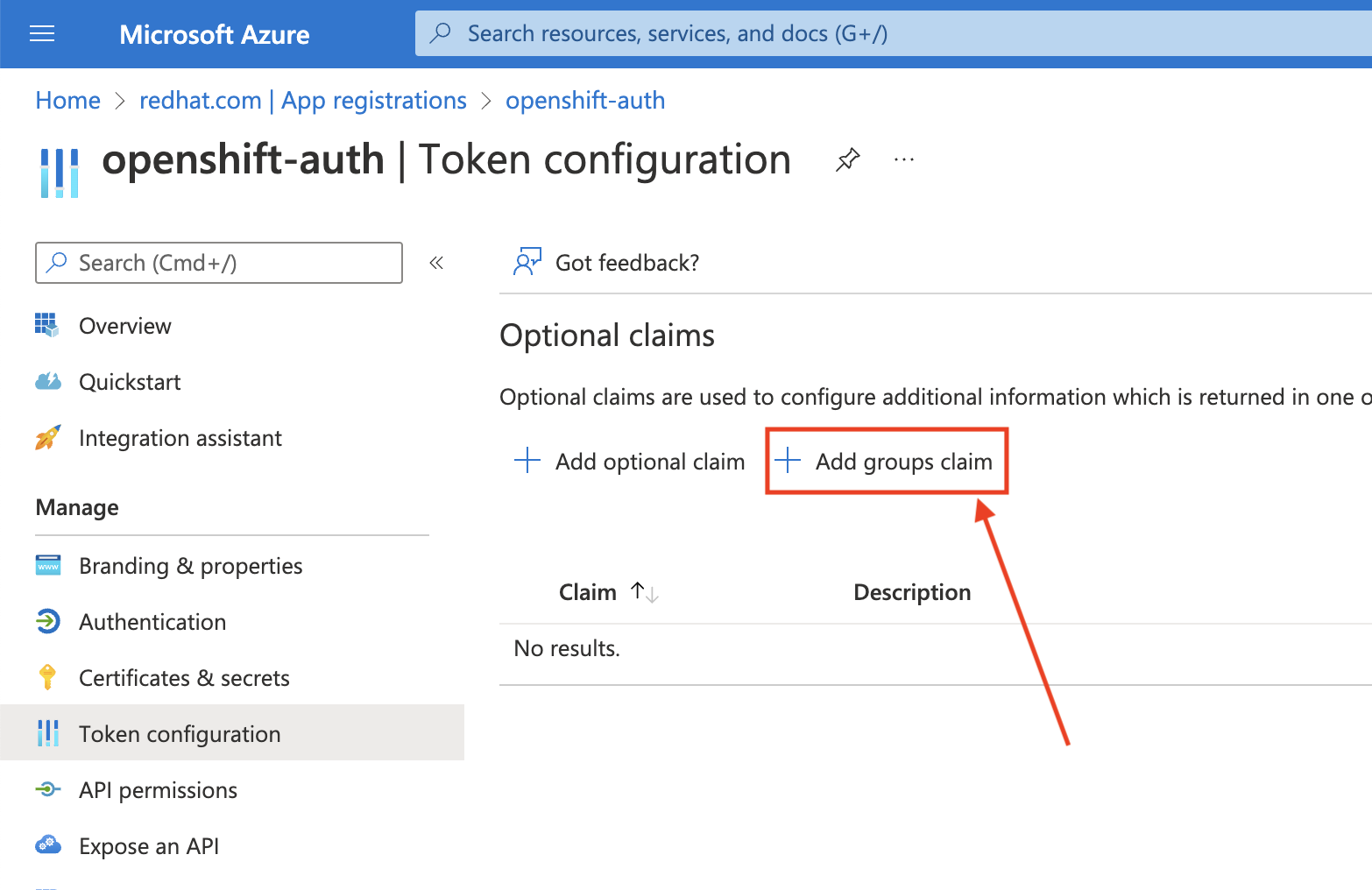

Token configuration サブブレードで、Add groups claim をクリックします。

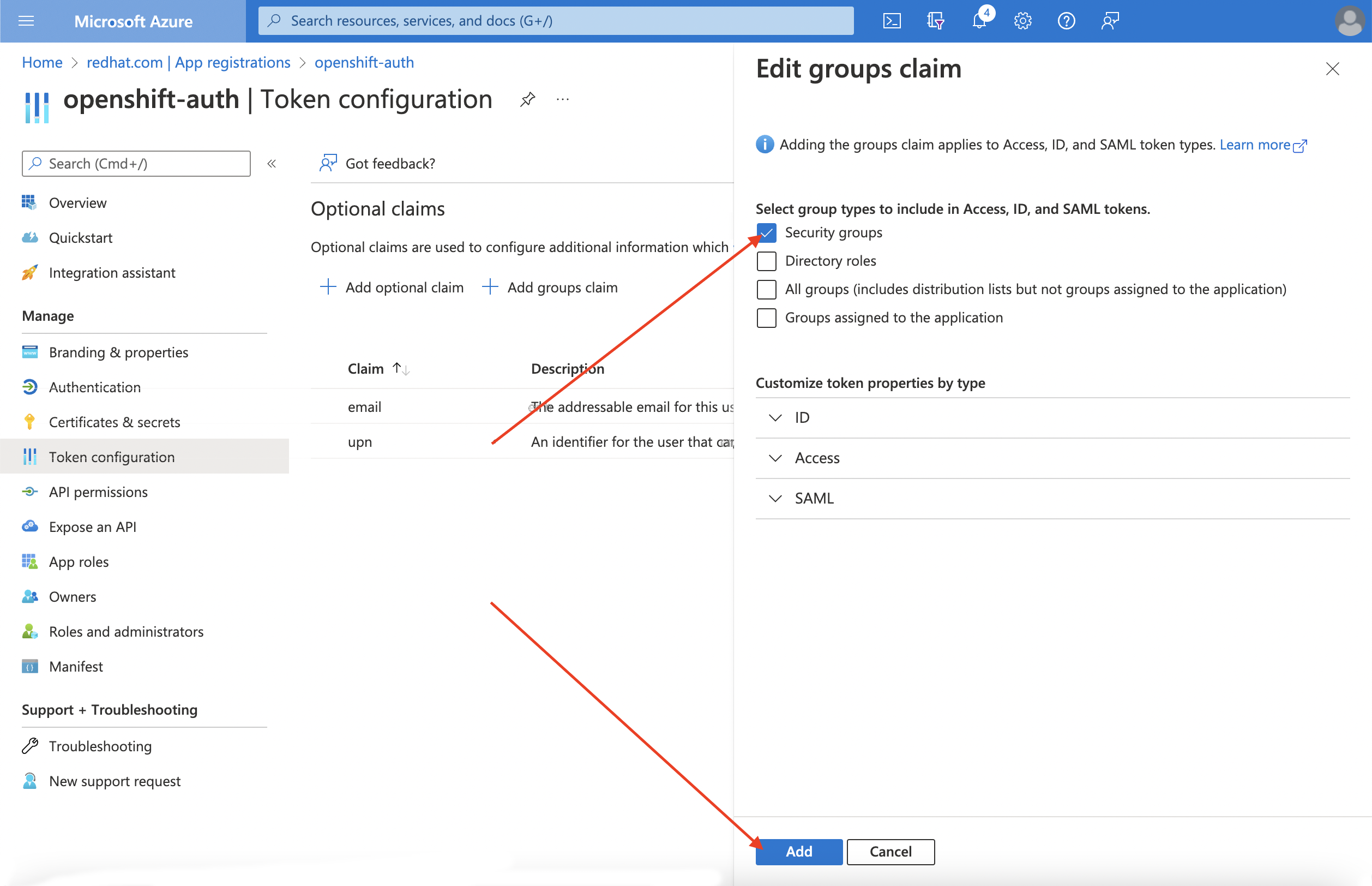

Entra ID アプリケーションのグループクレームを設定するには、Security groups を選択し、Add をクリックします。

注記この例では、グループクレームに、ユーザーがメンバーとなっているすべてのセキュリティーグループを含めます。実際の実稼働環境では、グループクレームに、Red Hat OpenShift Service on AWS に適用するグループのみを含めてください。

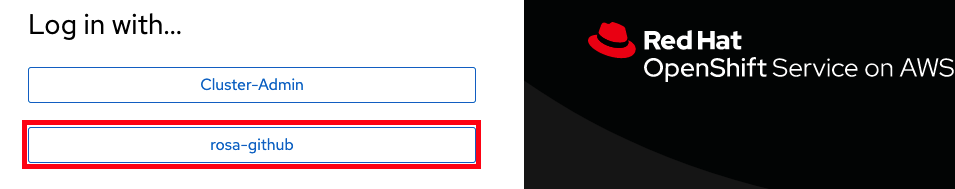

10.4. Entra ID をアイデンティティープロバイダーとして使用するように Red Hat OpenShift Service on AWS クラスターを設定する

Entra ID をアイデンティティープロバイダーとして使用するように Red Hat OpenShift Service on AWS を設定する必要があります。

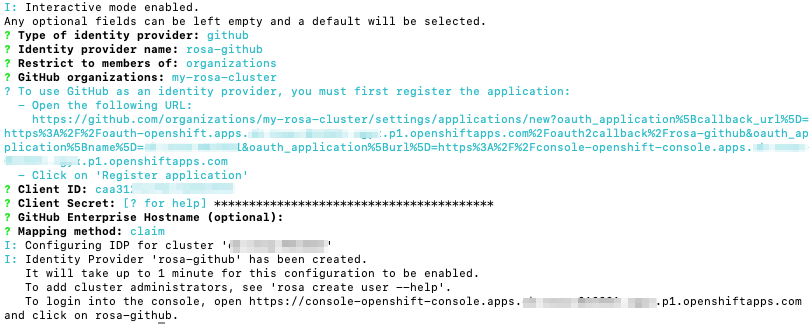

ROSA は OpenShift Cluster Manager を使用してアイデンティティープロバイダーを設定する機能を提供しますが、ここでは ROSA CLI を使用して、Entra ID をアイデンティティープロバイダーとして使用するようにクラスターの OAuth プロバイダーを設定します。アイデンティティープロバイダーを設定する前に、アイデンティティープロバイダー設定に必要な変数を設定します。

手順

次のコマンドを実行して変数を作成します。

$ CLUSTER_NAME=example-cluster 1 $ IDP_NAME=AAD 2 $ APP_ID=yyyyyyyy-yyyy-yyyy-yyyy-yyyyyyyyyyyy 3 $ CLIENT_SECRET=xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxxxx 4 $ TENANT_ID=zzzzzzzz-zzzz-zzzz-zzzz-zzzzzzzzzzzz 5

次のコマンドを実行して、クラスターの OAuth プロバイダーを設定します。グループクレームを有効にした場合は、必ず

--group-claims groups引数を使用してください。グループクレームを有効にした場合は、次のコマンドを実行します。

$ rosa create idp \ --cluster ${CLUSTER_NAME} \ --type openid \ --name ${IDP_NAME} \ --client-id ${APP_ID} \ --client-secret ${CLIENT_SECRET} \ --issuer-url https://login.microsoftonline.com/${TENANT_ID}/v2.0 \ --email-claims email \ --name-claims name \ --username-claims preferred_username \ --extra-scopes email,profile \ --groups-claims groupsグループクレームを有効にしなかった場合は、次のコマンドを実行します。

$ rosa create idp \ --cluster ${CLUSTER_NAME} \ --type openid \ --name ${IDP_NAME} \ --client-id ${APP_ID} \ --client-secret ${CLIENT_SECRET} \ --issuer-url https://login.microsoftonline.com/${TENANT_ID}/v2.0 \ --email-claims email \ --name-claims name \ --username-claims preferred_username \ --extra-scopes email,profile

数分後、クラスター認証 Operator が変更を調整します。すると、Entra ID を使用してクラスターにログインできるようになります。

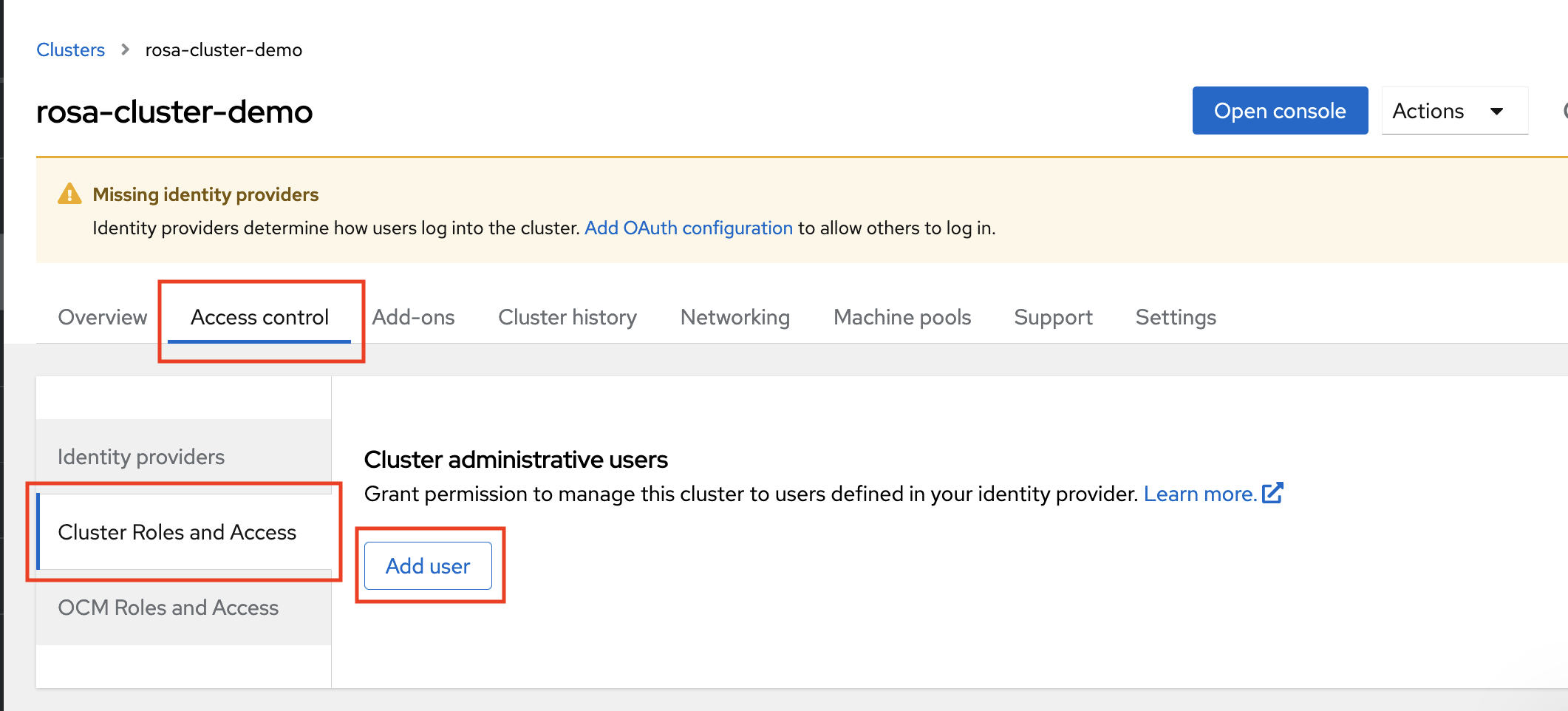

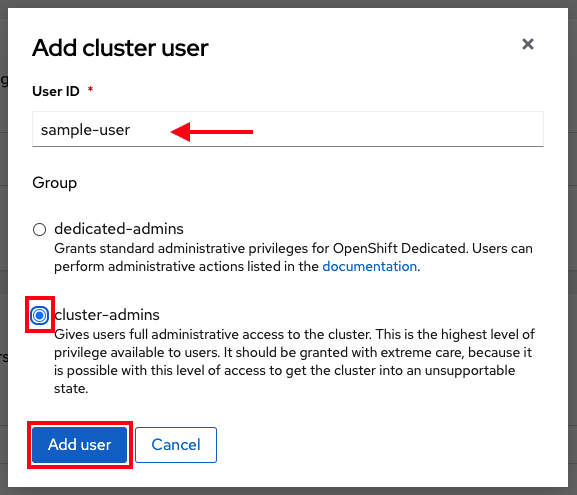

10.5. 個々のユーザーおよびグループへの追加の権限の付与

初めてログインすると、権限が非常に制限されていることがわかります。デフォルトでは、Red Hat OpenShift Service on AWS はクラスター内に新しいプロジェクトまたは namespace を作成する権限のみを付与します。他のプロジェクトの表示は制限されています。

このような追加の権限を個々のユーザーおよびグループに付与する必要があります。

個々のユーザーに追加の権限を付与する

Red Hat OpenShift Service on AWS には、クラスターに対する完全なアクセスと制御を付与する cluster-admin ロールなど、事前設定済みの多数のロールが組み込まれています。

手順

次のコマンドを実行して、ユーザーに

cluster-adminロールへのアクセス権を付与します。$ rosa grant user cluster-admin \ --user=<USERNAME> 1 --cluster=${CLUSTER_NAME}- 1

- cluster-admin 権限を付与する Entra ID ユーザー名を指定します。

個々のグループに追加の権限を付与する

グループクレームを有効にすることを選択した場合、クラスター OAuth プロバイダーによって、ユーザーのグループメンバーシップがグループ ID を使用して自動的に作成または更新されます。クラスター OAuth プロバイダーは、作成されたグループの RoleBinding と ClusterRoleBindings を自動的に作成しません。これらのバインディングは、ユーザーが独自のプロセスを使用して作成する必要があります。

自動生成されたグループに cluster-admin ロールへのアクセス権を付与するには、グループ ID への ClusterRoleBinding を作成する必要があります。

手順

次のコマンドを実行して、

ClusterRoleBindingを作成します。$ oc create clusterrolebinding cluster-admin-group \ --clusterrole=cluster-admin \ --group=<GROUP_ID> 1- 1

- cluster-admin 権限を付与する Entra ID グループ ID を指定します。

これで、指定したグループ内のすべてのユーザーに

cluster-adminアクセス権が自動的に付与されます。

10.6. 関連情報

RBAC を使用して Red Hat OpenShift Service on AWS の権限を定義および適用する方法の詳細は、Red Hat OpenShift Service on AWS のドキュメント を参照してください。

第11章 チュートリアル: STS を使用する ROSA での AWS Secrets Manager CSI の使用

AWS Secrets and Configuration Provider (ASCP) は、AWS シークレットを Kubernetes ストレージボリュームとして公開する方法を提供します。ASCP を使用すると、Secrets Manager のシークレットを保存および管理し、Red Hat OpenShift Service on AWS (ROSA) で実行されているワークロードを通じてシークレットを取得できます。

11.1. 前提条件

このプロセスを開始する前に、次のリソースとツールがあることを確認してください。

- STS とともにデプロイされた ROSA クラスター

- Helm 3

-

awsCLI -

ocCLI -

jqCLI

その他の環境要件

次のコマンドを実行して、ROSA クラスターにログインします。

$ oc login --token=<your-token> --server=<your-server-url>

ログイントークンを見つけるには、Red Hat OpenShift Cluster Manager からプルシークレット でクラスターにアクセスします。

次のコマンドを実行して、クラスターに STS があることを検証します。

$ oc get authentication.config.openshift.io cluster -o json \ | jq .spec.serviceAccountIssuer

出力例

"https://xxxxx.cloudfront.net/xxxxx"

出力が異なる場合は、続行しないでください。このプロセスを続行する前に、STS クラスターの作成に関する Red Hat ドキュメント を参照してください。

次のコマンドを実行して、CSI ドライバーの実行を許可するように

SecurityContextConstraints権限を設定します。$ oc new-project csi-secrets-store $ oc adm policy add-scc-to-user privileged \ system:serviceaccount:csi-secrets-store:secrets-store-csi-driver $ oc adm policy add-scc-to-user privileged \ system:serviceaccount:csi-secrets-store:csi-secrets-store-provider-aws次のコマンドを実行して、このプロセスで後で使用する環境変数を作成します。

$ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster \ -o jsonpath='{.spec.serviceAccountIssuer}' | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export AWS_PAGER=""

11.2. AWS シークレットと設定プロバイダーのデプロイ

次のコマンドを実行し、Helm を使用してシークレットストア CSI ドライバーを登録します。

$ helm repo add secrets-store-csi-driver \ https://kubernetes-sigs.github.io/secrets-store-csi-driver/charts次のコマンドを実行して、Helm リポジトリーを更新します。

$ helm repo update

次のコマンドを実行して、シークレットストア CSI ドライバーをインストールします。

$ helm upgrade --install -n csi-secrets-store \ csi-secrets-store-driver secrets-store-csi-driver/secrets-store-csi-driver次のコマンドを実行して、AWS プロバイダーをデプロイします。

$ oc -n csi-secrets-store apply -f \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/misc/secrets-store-csi/aws-provider-installer.yaml次のコマンドを実行して、両方の Daemonset が実行されていることを確認します。

$ oc -n csi-secrets-store get ds \ csi-secrets-store-provider-aws \ csi-secrets-store-driver-secrets-store-csi-driver次のコマンドを実行して、シークレットストア CSI ドライバーにラベルを付けて、制限付き Pod セキュリティープロファイルとともに使用することを許可します。

$ oc label csidriver.storage.k8s.io/secrets-store.csi.k8s.io security.openshift.io/csi-ephemeral-volume-profile=restricted

11.3. シークレットと IAM アクセスポリシーの作成

次のコマンドを実行して、Secrets Manager のシークレットを作成します。

$ SECRET_ARN=$(aws --region "$REGION" secretsmanager create-secret \ --name MySecret --secret-string \ '{"username":"shadowman", "password":"hunter2"}' \ --query ARN --output text) $ echo $SECRET_ARN次のコマンドを実行して、IAM アクセスポリシードキュメントを作成します。

$ cat << EOF > policy.json { "Version": "2012-10-17", "Statement": [{ "Effect": "Allow", "Action": [ "secretsmanager:GetSecretValue", "secretsmanager:DescribeSecret" ], "Resource": ["$SECRET_ARN"] }] } EOF次のコマンドを実行して、IAM アクセスポリシーを作成します。

$ POLICY_ARN=$(aws --region "$REGION" --query Policy.Arn \ --output text iam create-policy \ --policy-name openshift-access-to-mysecret-policy \ --policy-document file://policy.json) $ echo $POLICY_ARN

次のコマンドを実行して、IAM ロール信頼ポリシードキュメントを作成します。

注記信頼ポリシーは、このプロセスで後で作成する namespace のデフォルトのサービスアカウントにロックされます。

$ cat <<EOF > trust-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": ["system:serviceaccount:my-application:default"] } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOF次のコマンドを実行して、IAM ロールを作成します。

$ ROLE_ARN=$(aws iam create-role --role-name openshift-access-to-mysecret \ --assume-role-policy-document file://trust-policy.json \ --query Role.Arn --output text) $ echo $ROLE_ARN

次のコマンドを実行して、ロールをポリシーに割り当てます。

$ aws iam attach-role-policy --role-name openshift-access-to-mysecret \ --policy-arn $POLICY_ARN

11.4. このシークレットを使用するアプリケーションの作成

次のコマンドを実行して、OpenShift プロジェクトを作成します。

$ oc new-project my-application

次のコマンドを実行して、STS ロールを使用するようにデフォルトのサービスアカウントにアノテーションを付けます。

$ oc annotate -n my-application serviceaccount default \ eks.amazonaws.com/role-arn=$ROLE_ARN次のコマンドを実行して、シークレットにアクセスするためのシークレットプロバイダークラスを作成します。

$ cat << EOF | oc apply -f - apiVersion: secrets-store.csi.x-k8s.io/v1 kind: SecretProviderClass metadata: name: my-application-aws-secrets spec: provider: aws parameters: objects: | - objectName: "MySecret" objectType: "secretsmanager" EOF次のコマンドでシークレットを使用してデプロイメントを作成します。

$ cat << EOF | oc apply -f - apiVersion: v1 kind: Pod metadata: name: my-application labels: app: my-application spec: volumes: - name: secrets-store-inline csi: driver: secrets-store.csi.k8s.io readOnly: true volumeAttributes: secretProviderClass: "my-application-aws-secrets" containers: - name: my-application-deployment image: k8s.gcr.io/e2e-test-images/busybox:1.29 command: - "/bin/sleep" - "10000" volumeMounts: - name: secrets-store-inline mountPath: "/mnt/secrets-store" readOnly: true EOF次のコマンドを実行して、Pod にシークレットがマウントされていることを確認します。

$ oc exec -it my-application -- cat /mnt/secrets-store/MySecret

11.5. クリーンアップ

次のコマンドを実行してアプリケーションを削除します。

$ oc delete project my-application

次のコマンドを実行して、シークレットストア CSI ドライバーを削除します。

$ helm delete -n csi-secrets-store csi-secrets-store-driver

次のコマンドを実行して、Security Context Constraints を削除します。

$ oc adm policy remove-scc-from-user privileged \ system:serviceaccount:csi-secrets-store:secrets-store-csi-driver $ oc adm policy remove-scc-from-user privileged \ system:serviceaccount:csi-secrets-store:csi-secrets-store-provider-aws次のコマンドを実行して、AWS プロバイダーを削除します。

$ oc -n csi-secrets-store delete -f \ https://raw.githubusercontent.com/rh-mobb/documentation/main/content/misc/secrets-store-csi/aws-provider-installer.yaml

次のコマンドを実行して、AWS のロールとポリシーを削除します。

$ aws iam detach-role-policy --role-name openshift-access-to-mysecret \ --policy-arn $POLICY_ARN $ aws iam delete-role --role-name openshift-access-to-mysecret $ aws iam delete-policy --policy-arn $POLICY_ARN次のコマンドを実行して、Secrets Manager のシークレットを削除します。

$ aws secretsmanager --region $REGION delete-secret --secret-id $SECRET_ARN

第12章 チュートリアル: ROSA での AWS Controllers for Kubernetes の使用

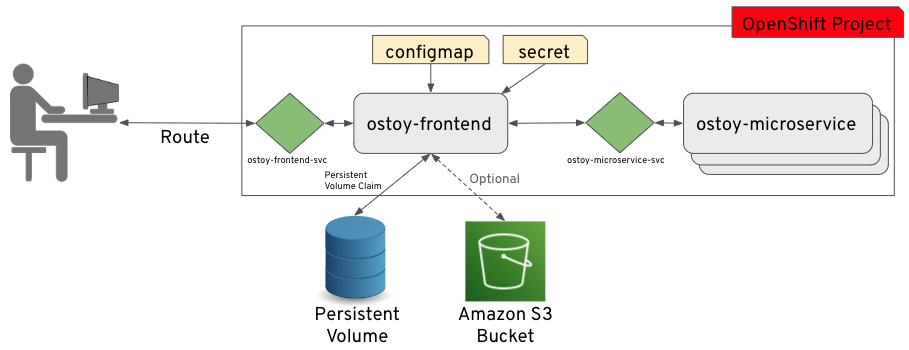

AWS Controllers for Kubernetes (ACK) を使用すると、AWS サービスリソースを Red Hat OpenShift Service on AWS (ROSA) から直接定義して使用できます。ACK を使用すると、クラスター外のリソースを定義したり、クラスター内のデータベースやメッセージキューなどのサポート機能を提供するサービスを実行したりすることなく、アプリケーションで AWS マネージドサービスを利用できます。

OperatorHub からさまざまな ACK Operator を直接インストールできます。これにより、アプリケーションで Operator を簡単に使い始めることができます。このコントローラーは AWS Controller for Kubernetes プロジェクトのコンポーネントであり、現在開発者プレビュー段階にあります。

このチュートリアルを使用して、ACK S3 Operator をデプロイしてください。クラスターの OperatorHub 内の他の ACK Operator に合わせて調整することもできます。

12.1. 前提条件

- ROSA クラスター

-

cluster-admin権限を持つユーザーアカウント -

OpenShift CLI (

oc) -

Amazon Web Services (AWS) CLI (

aws)

12.2. 環境の設定

次の環境変数を設定し、お使いのクラスターに合わせてクラスター名を変更します。

$ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(rosa describe cluster -c ${ROSA_CLUSTER_NAME} --output json | jq -r .region.id) $ export OIDC_ENDPOINT=$(oc get authentication.config.openshift.io cluster -o json | jq -r .spec.serviceAccountIssuer | sed 's|^https://||') $ export AWS_ACCOUNT_ID=`aws sts get-caller-identity --query Account --output text` $ export ACK_SERVICE=s3 $ export ACK_SERVICE_ACCOUNT=ack-${ACK_SERVICE}-controller $ export POLICY_ARN=arn:aws:iam::aws:policy/AmazonS3FullAccess $ export AWS_PAGER="" $ export SCRATCH="/tmp/${ROSA_CLUSTER_NAME}/ack" $ mkdir -p ${SCRATCH}次のセクションに進む前に、すべてのフィールドが正しく出力されていることを確認してください。

$ echo "Cluster: ${ROSA_CLUSTER_NAME}, Region: ${REGION}, OIDC Endpoint: ${OIDC_ENDPOINT}, AWS Account ID: ${AWS_ACCOUNT_ID}"

12.3. AWS アカウントの準備

ACK Operator の AWS Identity Access Management (IAM) 信頼ポリシーを作成します。

$ cat <<EOF > "${SCRATCH}/trust-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Condition": { "StringEquals" : { "${OIDC_ENDPOINT}:sub": "system:serviceaccount:ack-system:${ACK_SERVICE_ACCOUNT}" } }, "Principal": { "Federated": "arn:aws:iam::$AWS_ACCOUNT_ID:oidc-provider/${OIDC_ENDPOINT}" }, "Action": "sts:AssumeRoleWithWebIdentity" } ] } EOFAmazonS3FullAccessポリシーを割り当てた、ACK Operator が引き受ける AWS IAM ロールを作成します。注記推奨されるポリシーは、各プロジェクトの GitHub リポジトリー (例: https://github.com/aws-controllers-k8s/s3-controller/blob/main/config/iam/recommended-policy-arn) で見つけることができます。

$ ROLE_ARN=$(aws iam create-role --role-name "ack-${ACK_SERVICE}-controller" \ --assume-role-policy-document "file://${SCRATCH}/trust-policy.json" \ --query Role.Arn --output text) $ echo $ROLE_ARN $ aws iam attach-role-policy --role-name "ack-${ACK_SERVICE}-controller" \ --policy-arn ${POLICY_ARN}

12.4. ACK S3 コントローラーのインストール

ACK S3 Operator をインストールするプロジェクトを作成します。

$ oc new-project ack-system

ACK S3 Operator の設定を含むファイルを作成します。

注記ACK_WATCH_NAMESPACEは、コントローラーがクラスター内のすべての namespace を適切に監視できるように、意図的に空白のままにします。$ cat <<EOF > "${SCRATCH}/config.txt" ACK_ENABLE_DEVELOPMENT_LOGGING=true ACK_LOG_LEVEL=debug ACK_WATCH_NAMESPACE= AWS_REGION=${REGION} AWS_ENDPOINT_URL= ACK_RESOURCE_TAGS=${CLUSTER_NAME} ENABLE_LEADER_ELECTION=true LEADER_ELECTION_NAMESPACE= EOF前のステップのファイルを使用して ConfigMap を作成します。

$ oc -n ack-system create configmap \ --from-env-file=${SCRATCH}/config.txt ack-${ACK_SERVICE}-user-configOperatorHub から ACK S3 Operator をインストールします。

$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: ack-${ACK_SERVICE}-controller namespace: ack-system spec: upgradeStrategy: Default --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: ack-${ACK_SERVICE}-controller namespace: ack-system spec: channel: alpha installPlanApproval: Automatic name: ack-${ACK_SERVICE}-controller source: community-operators sourceNamespace: openshift-marketplace EOFACK S3 Operator サービスアカウントに、割り当てる AWS IAM ロールのアノテーションを付けて、デプロイメントを再起動します。

$ oc -n ack-system annotate serviceaccount ${ACK_SERVICE_ACCOUNT} \ eks.amazonaws.com/role-arn=${ROLE_ARN} && \ oc -n ack-system rollout restart deployment ack-${ACK_SERVICE}-controllerACK S3 Operator が実行されていることを確認します。

$ oc -n ack-system get pods

出力例

NAME READY STATUS RESTARTS AGE ack-s3-controller-585f6775db-s4lfz 1/1 Running 0 51s

12.5. デプロイメントの検証

S3 バケットリソースをデプロイします。

$ cat << EOF | oc apply -f - apiVersion: s3.services.k8s.aws/v1alpha1 kind: Bucket metadata: name: ${CLUSTER-NAME}-bucket namespace: ack-system spec: name: ${CLUSTER-NAME}-bucket EOFS3 バケットが AWS で作成されたことを確認します。

$ aws s3 ls | grep ${CLUSTER_NAME}-bucket出力例

2023-10-04 14:51:45 mrmc-test-maz-bucket

12.6. クリーンアップ

S3 バケットリソースを削除します。

$ oc -n ack-system delete bucket.s3.services.k8s.aws/${CLUSTER-NAME}-bucketACK S3 Operator と AWS IAM ロールを削除します。

$ oc -n ack-system delete subscription ack-${ACK_SERVICE}-controller $ aws iam detach-role-policy \ --role-name "ack-${ACK_SERVICE}-controller" \ --policy-arn ${POLICY_ARN} $ aws iam delete-role \ --role-name "ack-${ACK_SERVICE}-controller"ack-systemプロジェクトを削除します。$ oc delete project ack-system

第13章 チュートリアル: ROSA への External DNS Operator のデプロイ

Red Hat OpenShift Service on AWS 4.14 以降、Custom Domain Operator は非推奨になりました。Red Hat OpenShift Service on AWS 4.14 で Ingress を管理するには、Ingress Operator を使用します。Red Hat OpenShift Service on AWS 4.13 以前のバージョンでは機能に変更はありません。

Custom Domain Operator を設定するには、Amazon Route 53 ホストゾーンにワイルドカード CNAME DNS レコードが必要です。ワイルドカードレコードを使用しない場合は、External DNS Operator を使用してルートの個別のエントリーを作成できます。

このチュートリアルを使用して、Red Hat OpenShift Service on AWS (ROSA) のカスタムドメインで External DNS Operator をデプロイおよび設定します。

External DNS Operator は、IAM Roles for Service Accounts (IRSA) を使用した STS をサポートせず、代わりに有効期間の長い Identity Access Management (IAM) 認証情報を使用します。このチュートリアルは、Operator で STS がサポートされた際に更新される予定です。

13.1. 前提条件

- ROSA クラスター

-

dedicated-admin権限を持つユーザーアカウント -

OpenShift CLI (

oc) -

Amazon Web Services (AWS) CLI (

aws) -

一意のドメイン (

*.apps.<company_name>.ioなど) - 上記ドメイン用の Amazon Route 53 パブリックホストゾーン

13.2. 環境の設定

次の環境変数を設定します。

CLUSTER_NAMEはクラスターの名前に置き換えます。$ export DOMAIN=apps.<company_name>.io 1 $ export AWS_PAGER="" $ export CLUSTER_NAME=$(oc get infrastructure cluster -o=jsonpath="{.status.infrastructureName}" | sed 's/-[a-z0-9]\{5\}$//') $ export REGION=$(oc get infrastructure cluster -o=jsonpath="{.status.platformStatus.aws.region}") $ export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query Account --output text) $ export SCRATCH="/tmp/${CLUSTER_NAME}/external-dns" $ mkdir -p ${SCRATCH}- 1

- カスタムドメイン。

次のセクションに進む前に、すべてのフィールドが正しく出力されていることを確認してください。

$ echo "Cluster: ${CLUSTER_NAME}, Region: ${REGION}, AWS Account ID: ${AWS_ACCOUNT_ID}"

13.3. カスタムドメインの設定

ROSA は、Custom Domain Operator を使用してセカンダリー Ingress Controller を管理します。カスタムドメインを使用してセカンダリー Ingress Controller をデプロイするには、次の手順を実行します。

前提条件

-

一意のドメイン (

*.apps.<company_name>.ioなど) -

カスタム SAN またはワイルドカード証明書 (

CN=*.apps.<company_name>.ioなど)

手順

新しいプロジェクトを作成します。

$ oc new-project external-dns-operator

秘密鍵と公開証明書から新しい TLS シークレットを作成します。

fullchain.pemは完全なワイルドカード証明書チェーン (中間証明書を含む)、privkey.pemはワイルドカード証明書の秘密鍵です。$ oc -n external-dns-operator create secret tls external-dns-tls --cert=fullchain.pem --key=privkey.pem

新規の

CustomDomainカスタムリソース (CR) を作成します。external-dns-custom-domain.yamlの例apiVersion: managed.openshift.io/v1alpha1 kind: CustomDomain metadata: name: external-dns spec: domain: apps.<company_name>.io 1 scope: External loadBalancerType: NLB certificate: name: external-dns-tls namespace: external-dns-operator- 1

- カスタムドメイン。

CR を適用します。

$ oc apply -f external-dns-custom-domain.yaml

カスタムドメイン Ingress Controller がデプロイされ、

Readyステータスになっていることを確認します。$ oc get customdomains

出力例

NAME ENDPOINT DOMAIN STATUS external-dns xxrywp.<company_name>.cluster-01.opln.s1.openshiftapps.com *.apps.<company_name>.io Ready

13.4. AWS アカウントの準備

Amazon Route 53 のパブリックホストゾーン ID を取得します。

$ export ZONE_ID=$(aws route53 list-hosted-zones-by-name --output json \ --dns-name "${DOMAIN}." --query 'HostedZones[0]'.Id --out text | sed 's/\/hostedzone\///')External DNSOperator がカスタムドメインのパブリックホストゾーン のみ を更新できるようにする AWS IAM ポリシードキュメントを作成します。$ cat << EOF > "${SCRATCH}/external-dns-policy.json" { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "route53:ChangeResourceRecordSets" ], "Resource": [ "arn:aws:route53:::hostedzone/${ZONE_ID}" ] }, { "Effect": "Allow", "Action": [ "route53:ListHostedZones", "route53:ListResourceRecordSets" ], "Resource": [ "*" ] } ] } EOFAWS IAM ポリシーを作成します。

$ export POLICY_ARN=$(aws iam create-policy --policy-name "${CLUSTER_NAME}-AllowExternalDNSUpdates" \ --policy-document file://${SCRATCH}/external-dns-policy.json \ --query 'Policy.Arn' --output text)AWS IAM ユーザーを作成します。

$ aws iam create-user --user-name "${CLUSTER_NAME}-external-dns-operator"ポリシーを割り当てします。

$ aws iam attach-user-policy --user-name "${CLUSTER_NAME}-external-dns-operator" --policy-arn $POLICY_ARN注記これは将来的には IRSA を使用した STS に変更される予定です。

IAM ユーザーの AWS キーを作成します。

$ SECRET_ACCESS_KEY=$(aws iam create-access-key --user-name "${CLUSTER_NAME}-external-dns-operator")静的認証情報を作成します。

$ cat << EOF > "${SCRATCH}/credentials" [default] aws_access_key_id = $(echo $SECRET_ACCESS_KEY | jq -r '.AccessKey.AccessKeyId') aws_secret_access_key = $(echo $SECRET_ACCESS_KEY | jq -r '.AccessKey.SecretAccessKey') EOF

13.5. External DNS Operator のインストール

OperatorHub から

External DNSOperator をインストールします。$ cat << EOF | oc apply -f - apiVersion: operators.coreos.com/v1 kind: OperatorGroup metadata: name: external-dns-group namespace: external-dns-operator spec: targetNamespaces: - external-dns-operator --- apiVersion: operators.coreos.com/v1alpha1 kind: Subscription metadata: name: external-dns-operator namespace: external-dns-operator spec: channel: stable-v1.1 installPlanApproval: Automatic name: external-dns-operator source: redhat-operators sourceNamespace: openshift-marketplace EOF