Configuration et gestion des réseaux

Gestion des interfaces réseau et des fonctions réseau avancées

Résumé

- Vous pouvez configurer des liens, des VLAN, des ponts, des tunnels et d'autres types de réseaux pour connecter l'hôte au réseau.

- IPSec et WireGuard fournissent des VPN sécurisés entre les hôtes et les réseaux.

- RHEL prend également en charge des fonctions réseau avancées, telles que le routage basé sur des règles et le protocole TCP MultiPath (MPTCP).

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Dénomination cohérente des périphériques d'interface réseau

Le noyau Linux attribue des noms aux interfaces réseau en combinant un préfixe fixe et un nombre qui augmente au fur et à mesure que le noyau initialise les périphériques réseau. Par exemple, eth0 représente le premier périphérique interrogé au démarrage. Si vous ajoutez une autre carte d'interface réseau au système, l'attribution des noms de périphériques du noyau n'est plus fixe. Par conséquent, après un redémarrage, le noyau peut nommer le périphérique différemment.

Pour résoudre ce problème, le gestionnaire de périphériques udev prend en charge plusieurs schémas de dénomination différents. Par défaut, udev attribue des noms fixes basés sur le micrologiciel, la topologie et les informations de localisation. Cela présente les avantages suivants :

- Les noms des appareils sont entièrement prévisibles.

- Les noms de périphériques restent fixes même si vous ajoutez ou supprimez du matériel, car il n'y a pas de nouvelle énumération.

- Le matériel défectueux peut être remplacé sans problème.

Red Hat ne prend pas en charge les systèmes dont le nommage cohérent des périphériques est désactivé. Pour plus de détails, voir Est-il sûr de définir net.ifnames=0 ?

1.1. Hiérarchie de dénomination des périphériques d'interface réseau

Si la dénomination cohérente des périphériques est activée, ce qui est le cas par défaut dans Red Hat Enterprise Linux, le gestionnaire de périphériques udev génère des noms de périphériques basés sur les schémas suivants :

| Régime | Description | Exemple : |

|---|---|---|

| 1 |

Les noms des périphériques intègrent les numéros d'index fournis par le firmware ou le BIOS pour les périphériques embarqués. Si cette information n'est pas disponible ou applicable, |

|

| 2 |

Les noms des dispositifs intègrent les numéros d'index de l'emplacement du hot plug PCI Express (PCIe) fournis par le micrologiciel ou le BIOS. Si cette information n'est pas disponible ou applicable, |

|

| 3 |

Les noms de dispositifs intègrent l'emplacement physique du connecteur du matériel. Si cette information n'est pas disponible ou applicable, |

|

| 4 | Les noms de périphériques intègrent l'adresse MAC. Red Hat Enterprise Linux n'utilise pas ce schéma par défaut, mais les administrateurs peuvent l'utiliser de manière optionnelle. |

|

| 5 |

Le schéma traditionnel de dénomination imprévisible du noyau. Si |

|

Par défaut, Red Hat Enterprise Linux sélectionne le nom du périphérique en fonction du paramètre NamePolicy dans le fichier /usr/lib/systemd/network/99-default.link. L'ordre des valeurs dans NamePolicy est important. Red Hat Enterprise Linux utilise le premier nom de périphérique qui est à la fois spécifié dans le fichier et généré par udev.

Si vous avez configuré manuellement les règles udev pour modifier le nom des périphériques du noyau, ces règles sont prioritaires.

1.2. Comment fonctionne le renommage des périphériques réseau

Par défaut, la dénomination cohérente des périphériques est activée dans Red Hat Enterprise Linux. Le gestionnaire de périphériques udev traite différentes règles pour renommer les périphériques. Le service udev traite ces règles dans l'ordre suivant :

-

Le fichier

/usr/lib/udev/rules.d/60-net.rulesdéfinit que l'utilitaire d'aide/lib/udev/rename_devicedoit rechercher le paramètreHWADDRdans les fichiers/etc/sysconfig/network-scripts/ifcfg-*. Si la valeur définie dans la variable correspond à l'adresse MAC d'une interface, l'utilitaire d'aide renomme l'interface avec le nom défini dans le paramètreDEVICEdu fichier. Ce fichier n'existe qu'après l'installation du paquetageinitscripts. -

Le fichier

/usr/lib/udev/rules.d/71-biosdevname.rulesdéfinit que l'utilitairebiosdevnamerenomme l'interface conformément à sa politique de dénomination, à condition qu'elle n'ait pas été renommée à l'étape précédente. -

Le fichier

/usr/lib/udev/rules.d/75-net-description.rulesdéfinit queudevexamine le périphérique d'interface réseau et définit les propriétés dansudev- variables internes qui seront traitées à l'étape suivante. Notez que certaines de ces propriétés peuvent être indéfinies. Le fichier

/usr/lib/udev/rules.d/80-net-setup-link.rulesappelle le fichiernet_setup_linkudevintégré qui applique alors la politique. Voici la politique par défaut qui est stockée dans le fichier/usr/lib/systemd/network/99-default.link:[Link] NamePolicy=kernel database onboard slot path MACAddressPolicy=persistent

Avec cette politique, si le noyau utilise un nom persistant,

udevne renomme pas l'interface. Si le noyau n'utilise pas de nom persistant,udevrenomme l'interface avec le nom fourni par la base de données matérielle deudev. Si cette base de données n'est pas disponible, Red Hat Enterprise Linux se rabat sur les mécanismes décrits ci-dessus.Il est également possible de définir le paramètre

NamePolicyde ce fichier surmacpour les noms d'interface basés sur l'adresse MAC (Media Access Control).Le fichier

/usr/lib/udev/rules.d/80-net-setup-link.rulesdéfinit queudevrenomme l'interface en fonction des paramètres internesudevdans l'ordre suivant :-

ID_NET_NAME_ONBOARD -

ID_NET_NAME_SLOT -

ID_NET_NAME_PATH

Si l'un des paramètres n'est pas défini,

udevutilise le suivant. Si aucun des paramètres n'est défini, l'interface n'est pas renommée.-

Les étapes 3 et 4 mettent en œuvre les schémas de dénomination 1 à 4 décrits dans Hiérarchie de dénomination des périphériques d'interface réseau.

Ressources supplémentaires

1.3. Explication des noms prévisibles des périphériques d'interface réseau sur la plate-forme x86_64

Lorsque la fonction de nom cohérent des périphériques réseau est activée, le gestionnaire de périphériques udev crée les noms des périphériques en fonction de différents critères. Le nom de l'interface commence par un préfixe de deux caractères en fonction du type d'interface :

-

enpour Ethernet -

wlpour le réseau local sans fil (WLAN) -

wwpour les réseaux étendus sans fil (WWAN)

En outre, l'un des éléments suivants est ajouté à l'un des préfixes susmentionnés en fonction du schéma appliqué par le gestionnaire de périphériques udev:

-

o<on-board_index_number> s<hot_plug_slot_index_number>[f<function>][d<device_id>]Notez que tous les périphériques PCI multifonctions ont le numéro

[f<function>]dans le nom du périphérique, y compris le périphérique de fonction0.-

x<MAC_address> [P<domain_number>]p<bus>s<slot>[f<function>][d<device_id>]La partie

[P<domain_number>]définit l'emplacement géographique du PCI. Cette partie n'est définie que si le numéro de domaine n'est pas0.[P<domain_number>]p<bus>s<slot>[f<function>][u<usb_port>][…][c<config>][i<interface>]Pour les dispositifs USB, la chaîne complète des numéros de port des concentrateurs est composée. Si le nom est plus long que le maximum (15 caractères), il n'est pas exporté. S'il y a plusieurs dispositifs USB dans la chaîne,

udevsupprime les valeurs par défaut des descripteurs de configuration USB (c1) et des descripteurs d'interface USB (i0).

1.4. Explication des noms prévisibles des périphériques d'interface réseau sur la plate-forme System z

Lorsque la fonction de nom de périphérique réseau cohérent est activée, le gestionnaire de périphériques udev sur la plate-forme System z crée les noms de périphériques en fonction de l'ID de bus. L'ID de bus identifie un périphérique dans le sous-système de canaux s390.

Pour un dispositif à mot de commande de canal (CCW), l'ID de bus est le numéro de dispositif avec un préfixe 0.n où n est l'ID de l'ensemble de sous-canaux.

Les interfaces Ethernet sont nommées, par exemple, enccw0.0.1234. Les périphériques réseau de type canal à canal (CTC) du protocole Internet de ligne série (SLIP) sont nommés, par exemple, slccw0.0.1234.

Utilisez les commandes znetconf -c ou lscss -a pour afficher les périphériques réseau disponibles et leurs ID de bus.

Red Hat Enterprise Linux prend également en charge les noms d'interface prévisibles et persistants pour les fonctions PCI RDMA over Converged Ethernet (RoCE) Express. Deux identifiants fournissent des noms d'interface prévisibles : l'identifiant de l'utilisateur (UID) et l'identifiant de la fonction (FID). Pour obtenir des noms d'interface prévisibles basés sur l'UID, un système doit imposer l'unicité de l'UID, qui est le schéma de dénomination préféré. Si aucun UID unique n'est disponible, RHEL utilise les FID pour définir les noms d'interface prévisibles.

1.5. Personnalisation du préfixe des interfaces Ethernet lors de l'installation

Vous pouvez personnaliser le préfixe des noms d'interface Ethernet lors de l'installation de Red Hat Enterprise Linux.

Red Hat ne prend pas en charge la personnalisation du préfixe à l'aide de l'utilitaire prefixdevname sur des systèmes déjà déployés.

Après l'installation de RHEL, le service udev nomme les périphériques Ethernet <prefix>.<index>. Par exemple, si vous sélectionnez le préfixe net, RHEL nomme les interfaces Ethernet net0, net1, etc.

Conditions préalables

Le préfixe que vous souhaitez définir répond aux exigences suivantes :

- Il se compose de caractères ASCII.

- Il s'agit d'une chaîne alphanumérique.

- Il est inférieur à 16 caractères.

-

Il n'entre pas en conflit avec d'autres préfixes bien connus utilisés pour nommer les interfaces réseau, tels que

eth,eno,ensetem.

Procédure

- Démarrez le support d'installation de Red Hat Enterprise Linux.

Dans le gestionnaire de démarrage :

-

Sélectionnez l'entrée

Install Red Hat Enterprise Linux <version>et appuyez sur Tab pour modifier l'entrée. -

Ajouter

net.ifnames.prefix=<prefix>aux options du noyau. - Appuyez sur Entrée pour lancer le programme d'installation.

-

Sélectionnez l'entrée

- Installer Red Hat Enterprise Linux.

Vérification

Après l'installation, affichez les interfaces Ethernet :

# ip link show ... 2: net0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:53:00:c5:98:1c brd ff:ff:ff:ff:ff:ff 3: net1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:53:00:c2:39:9e brd ff:ff:ff:ff:ff:ff ...

1.6. Attribution de noms d'interface réseau définis par l'utilisateur à l'aide des règles udev

Le gestionnaire de périphériques udev prend en charge un ensemble de règles permettant de personnaliser les noms d'interface.

Procédure

Affiche toutes les interfaces réseau et leurs adresses MAC :

# ip link list enp6s0f0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:58 brd ff:ff:ff:ff:ff:ff enp6s0f1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:5a brd ff:ff:ff:ff:ff:ff enp4s0f0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:90:fa:6a:7d:90 brd ff:ff:ff:ff:ff:ffCréez le fichier

/etc/udev/rules.d/70-custom-ifnames.rulesavec le contenu suivant :SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="b4:96:91:14:ae:58",ATTR{type}=="1",NAME="provider0" SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="b4:96:91:14:ae:5a",ATTR{type}=="1",NAME="provider1" SUBSYSTEM=="net",ACTION=="add",ATTR{address}=="00:90:fa:6a:7d:90",ATTR{type}=="1",NAME="dmz"

Ces règles correspondent à l'adresse MAC des interfaces réseau et les renomment en fonction du nom indiqué dans la propriété NAME. Dans ces exemples, la valeur du paramètre ATTR{type} 1 définit que l'interface est de type Ethernet.

Vérification

Redémarrer le système.

# rebootVérifiez que les noms d'interface de chaque adresse MAC correspondent à la valeur définie dans le paramètre

NAMEdu fichier de règles :# ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:58 brd ff:ff:ff:ff:ff:ff altname enp6s0f0 provider1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:5a brd ff:ff:ff:ff:ff:ff altname enp6s0f1 dmz: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether 00:90:fa:6a:7d:90 brd ff:ff:ff:ff:ff:ff altname enp4s0f0

Ressources supplémentaires

-

udev(7)page de manuel -

udevadm(8)page de manuel -

/usr/src/kernels/<kernel_version>/include/uapi/linux/if_arp.hfournie par le paquetkernel-doc

1.7. Attribution de noms d'interface réseau définis par l'utilisateur à l'aide des fichiers de liaison de systemd

Créez un schéma de dénomination en renommant les interfaces réseau en provider0.

Procédure

Affiche les noms de toutes les interfaces et leurs adresses MAC :

# ip link show enp6s0f0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:58 brd ff:ff:ff:ff:ff:ff enp6s0f1: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:5a brd ff:ff:ff:ff:ff:ff enp4s0f0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000 link/ether 00:90:fa:6a:7d:90 brd ff:ff:ff:ff:ff:ffPour nommer l'interface avec l'adresse MAC b4:96:91:14:ae:58 à provider0, créez le fichier /etc/systemd/network/70-custom-ifnames.link avec le contenu suivant :

[Match] MACAddress=b4:96:91:14:ae:58 [Link] Name=provider0

Ce fichier de liaison correspond à une adresse MAC et renomme l'interface réseau en fonction du nom défini dans le paramètre

Name.

Vérification

Redémarrer le système :

# rebootVérifiez que l'appareil portant l'adresse MAC que vous avez spécifiée dans le fichier de liaison a été attribué à

provider0:# ip link show provider0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP mode DEFAULT group default qlen 1000 link/ether b4:96:91:14:ae:58 brd ff:ff:ff:ff:ff:ff

Ressources supplémentaires

-

systemd.link(5)page de manuel

1.8. Attribution de noms supplémentaires à l'interface réseau à l'aide des fichiers de liaison de systemd

Le nommage alternatif des interfaces permet au noyau de définir d'autres noms pour les interfaces réseau. Par défaut, il fournit le même schéma de dénomination que le paramètre de dénomination d'interface normal - NamePolicy. Vous pouvez écrire votre fichier de lien systemd personnalisé à l'aide des directives AlternativeNamesPolicy ou AlternativeName pour donner des noms alternatifs aux interfaces réseau de votre choix.

La dernière mise en œuvre de la dénomination alternative des interfaces vous permet de.. :

- Créer des noms alternatifs de longueur arbitraire.

- Avoir un ou plusieurs noms alternatifs pour la même interface réseau.

- Utiliser des noms alternatifs pour les commandes.

Conditions préalables

-

Vous connaissez l'adresse MAC (Media Access Control) ou un autre identifiant d'interface réseau. Pour plus de détails, voir la partie OPTIONS DE SECTION [MATCH] à l'adresse

systemd.link(5).

Procédure

Créez le fichier

/etc/systemd/network/10-altnames.linkavec le contenu suivant :[Match] MACAddress=52:54:00:76:e0:2a [Link] AlternativeName=production_alias_of_arbitrary_length AlternativeName=PRD

- Redémarrez votre système pour que les modifications soient prises en compte.

Vérification

Vous pouvez utiliser le nom alternatif pour afficher l'état de l'interface réseau :

# ip address show production_alias_of_arbitrary_length 2: enp1s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000 link/ether 52:54:00:76:e0:2a brd ff:ff:ff:ff:ff:ff altname production_alias_of_arbitrary_length altname PRD inet 192.0.2.1/24 brd 192.0.2.255 scope global dynamic noprefixroute enp1s0 valid_lft 2760sec preferred_lft 2760sec inet6 2001:db8::/64 scope link noprefixroute valid_lft forever preferred_lft forever

Chapitre 2. Configuration d'une connexion Ethernet

Red Hat Enterprise Linux offre aux administrateurs différentes options pour configurer les connexions Ethernet. Par exemple :

-

Utilisez

nmclipour configurer les connexions sur la ligne de commande. -

Utilisez

nmtuipour configurer les connexions dans une interface utilisateur textuelle. - Utilisez les rôles système RHEL pour automatiser la configuration des connexions sur un ou plusieurs hôtes.

-

Utilisez le menu Paramètres de GNOME ou l'application

nm-connection-editorpour configurer les connexions dans une interface graphique. -

Utilisez

nmstatectlpour configurer les connexions via l'API Nmstate.

Si vous souhaitez configurer manuellement les connexions Ethernet sur des hôtes fonctionnant dans le nuage Microsoft Azure, désactivez le service cloud-init ou configurez-le de manière à ce qu'il ignore les paramètres réseau récupérés dans l'environnement du nuage. Sinon, cloud-init remplacera au prochain redémarrage les paramètres réseau que vous avez configurés manuellement.

2.1. Configuration d'une connexion Ethernet avec une adresse IP statique à l'aide de nmcli

Pour configurer une connexion Ethernet sur la ligne de commande, utilisez l'utilitaire nmcli.

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager pour le périphérique enp7s0 avec les paramètres suivants :

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

Procédure

Ajouter un nouveau profil de connexion NetworkManager pour la connexion Ethernet :

# nmcli connection add con-name Example-Connection ifname enp7s0 type ethernetLes étapes suivantes modifient le profil de connexion

Example-Connectionque vous avez créé.Définir l'adresse IPv4 :

# nmcli connection modify Example-Connection ipv4.addresses 192.0.2.1/24Définir l'adresse IPv6 :

# nmcli connection modify Example-Connection ipv6.addresses 2001:db8:1::1/64Réglez la méthode de connexion IPv4 et IPv6 sur

manual:# nmcli connection modify Example-Connection ipv4.method manual # nmcli connection modify Example-Connection ipv6.method manual

Définir les passerelles par défaut IPv4 et IPv6 :

# nmcli connection modify Example-Connection ipv4.gateway 192.0.2.254 # nmcli connection modify Example-Connection ipv6.gateway 2001:db8:1::fffe

Définissez les adresses des serveurs DNS IPv4 et IPv6 :

# nmcli connection modify Example-Connection ipv4.dns "192.0.2.200" # nmcli connection modify Example-Connection ipv6.dns "2001:db8:1::ffbb"

Pour définir plusieurs serveurs DNS, indiquez-les en les séparant par des espaces et en les plaçant entre guillemets.

Définir le domaine de recherche DNS pour la connexion IPv4 et IPv6 :

# nmcli connection modify Example-Connection ipv4.dns-search example.com # nmcli connection modify Example-Connection ipv6.dns-search example.com

Activer le profil de connexion :

# nmcli connection up Example-Connection Connection successfully activated (D-Bus active path: /org/freedesktop/NetworkManager/ActiveConnection/13)

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Résolution de problèmes

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources supplémentaires

-

nm-settings(5)page de manuel -

nmcli(1)page de manuel - Configurer NetworkManager pour éviter d'utiliser un profil spécifique pour fournir une passerelle par défaut

2.2. Configuration d'une connexion Ethernet avec une adresse IP statique à l'aide de l'éditeur interactif nmcli

Vous pouvez configurer une connexion Ethernet sur la ligne de commande en utilisant le mode interactif de l'utilitaire nmcli.

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager pour le périphérique enp7s0 avec les paramètres suivants :

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

Procédure

Pour ajouter un nouveau profil de connexion NetworkManager pour la connexion Ethernet et démarrer le mode interactif, entrez :

# nmcli connection edit type ethernet con-name Example-ConnectionDéfinir l'interface réseau :

nmcli> set connection.interface-name enp7s0Définir l'adresse IPv4 :

nmcli> set ipv4.addresses 192.0.2.1/24Définir l'adresse IPv6 :

nmcli> set ipv6.addresses 2001:db8:1::1/64Réglez la méthode de connexion IPv4 et IPv6 sur

manual:nmcli> set ipv4.method manual nmcli> set ipv6.method manual

Définir les passerelles par défaut IPv4 et IPv6 :

nmcli> set ipv4.gateway 192.0.2.254 nmcli> set ipv6.gateway 2001:db8:1::fffe

Définissez les adresses des serveurs DNS IPv4 et IPv6 :

nmcli> set ipv4.dns 192.0.2.200 nmcli> set ipv6.dns 2001:db8:1::ffbb

Pour définir plusieurs serveurs DNS, indiquez-les en les séparant par des espaces et en les plaçant entre guillemets.

Définir le domaine de recherche DNS pour la connexion IPv4 et IPv6 :

nmcli> set ipv4.dns-search example.com nmcli> set ipv6.dns-search example.com

Sauvegarder et activer la connexion :

nmcli> save persistent Saving the connection with 'autoconnect=yes'. That might result in an immediate activation of the connection. Do you still want to save? (yes/no) [yes] yes

Quitter le mode interactif :

nmcli> quit

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Résolution de problèmes

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources supplémentaires

-

nm-settings(5)page de manuel -

nmcli(1)page de manuel - Configurer NetworkManager pour éviter d'utiliser un profil spécifique pour fournir une passerelle par défaut

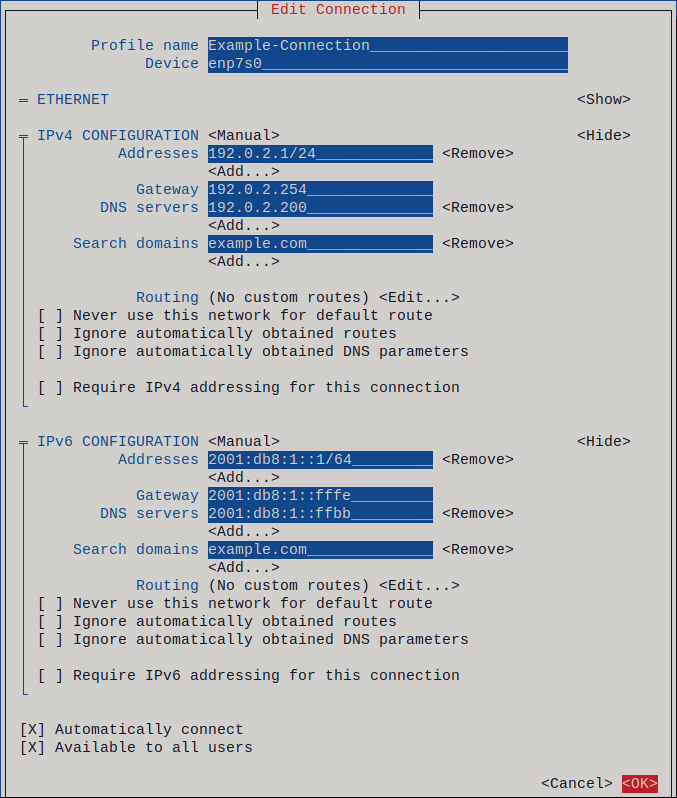

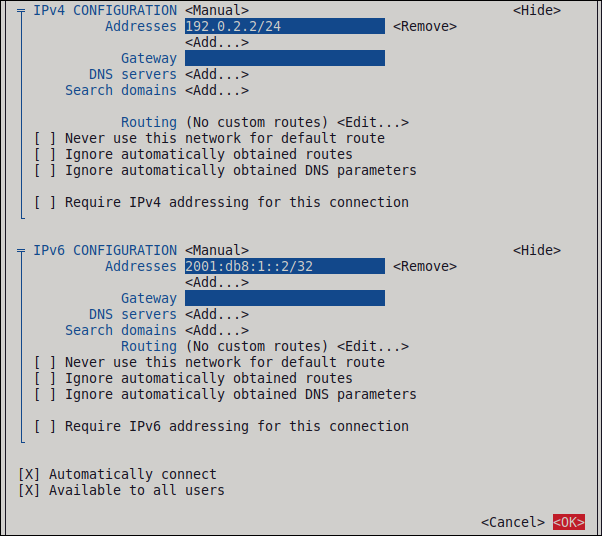

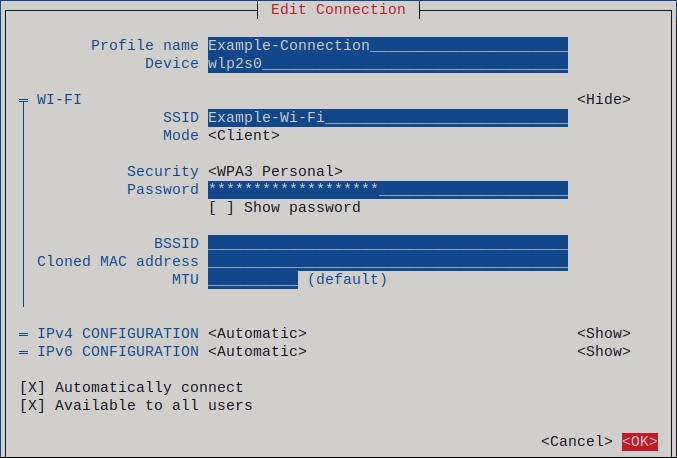

2.3. Configuration d'une connexion Ethernet avec une adresse IP statique à l'aide de nmtui

L'application nmtui fournit une interface utilisateur textuelle pour NetworkManager. Vous pouvez utiliser nmtui pour configurer une connexion Ethernet avec une adresse IP statique sur un hôte sans interface graphique.

Sur nmtui:

- Naviguer à l'aide des touches du curseur.

- Appuyez sur un bouton en le sélectionnant et en appuyant sur Entrée.

- Sélectionnez et désélectionnez les cases à cocher en utilisant l'espace.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

Procédure

Si vous ne connaissez pas le nom du périphérique réseau que vous souhaitez utiliser pour la connexion, affichez les périphériques disponibles :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet unavailable -- ...

Démarrer

nmtui:# nmtui-

Sélectionnez

Edit a connectionet appuyez sur Enter. -

Appuyez sur le bouton

Add. -

Sélectionnez

Ethernetdans la liste des types de réseaux et appuyez sur Entrée. - Optionnel : Entrez un nom pour le profil NetworkManager à créer.

-

Saisissez le nom de l'appareil réseau dans le champ

Device. Configurez les paramètres des adresses IPv4 et IPv6 dans les zones

IPv4 configurationetIPv6 configuration:-

Appuyez sur la touche

Automaticet sélectionnezManualdans la liste affichée. -

Appuyez sur le bouton

Showen regard du protocole que vous souhaitez configurer pour afficher des champs supplémentaires. Appuyez sur le bouton

Addà côté deAddresses, et entrez l'adresse IP et le masque de sous-réseau au format CIDR (Classless Inter-Domain Routing).Si vous ne spécifiez pas de masque de sous-réseau, NetworkManager définit un masque de sous-réseau

/32pour les adresses IPv4 et/64pour les adresses IPv6.- Saisissez l'adresse de la passerelle par défaut.

-

Appuyez sur la touche

Addà côté deDNS servers, et entrez l'adresse du serveur DNS. -

Appuyez sur la touche

Addà côté deSearch domains, et entrez le domaine de recherche DNS.

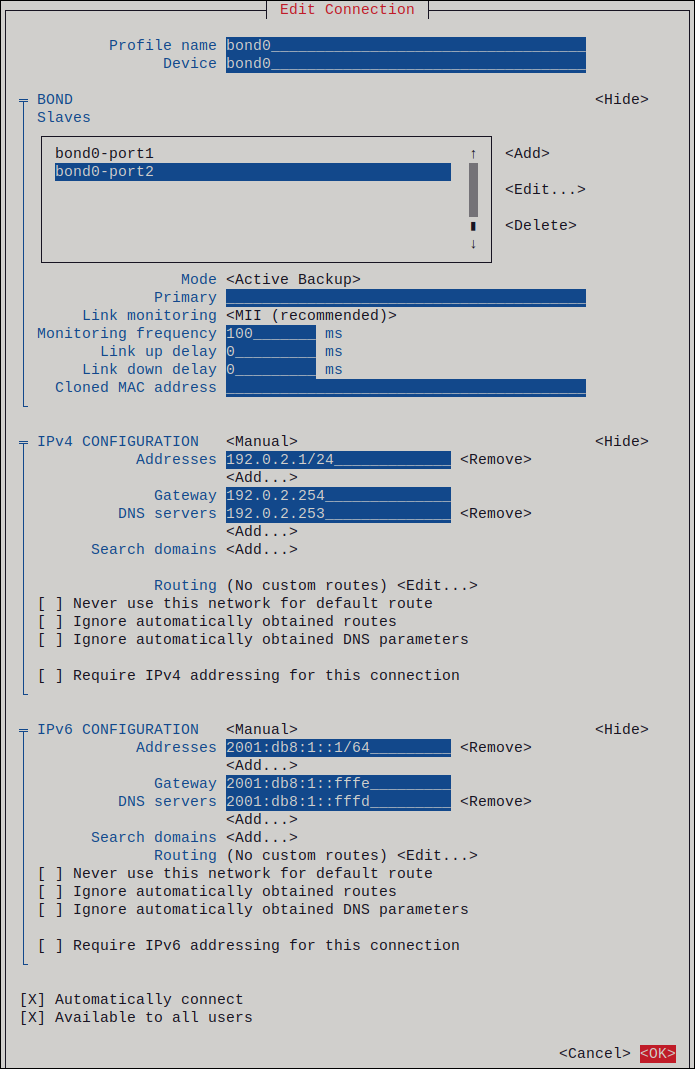

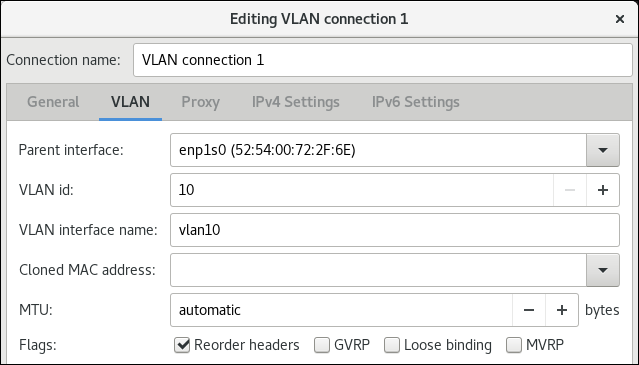

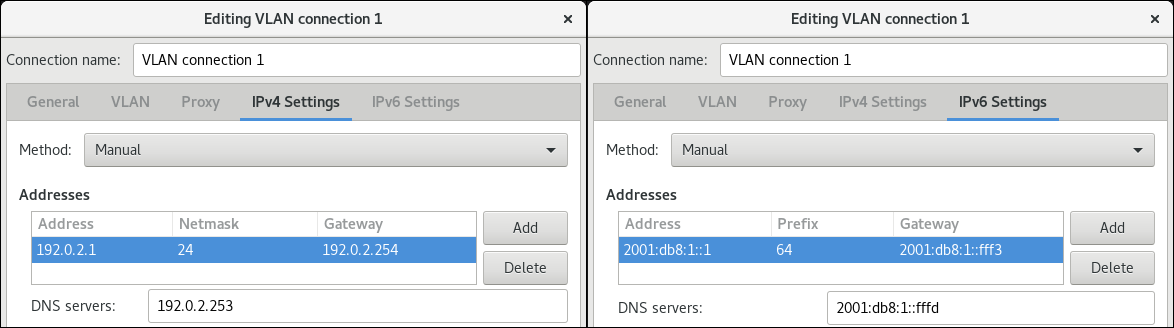

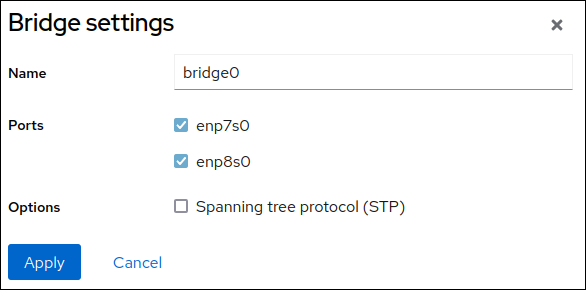

Figure 2.1. Exemple d'une connexion Ethernet avec des paramètres d'adresse IP statiques

-

Appuyez sur la touche

-

Appuyez sur le bouton

OKpour créer et activer automatiquement la nouvelle connexion. -

Appuyez sur le bouton

Backpour revenir au menu principal. -

Sélectionnez

Quitet appuyez sur Entrée pour fermer l'applicationnmtui.

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Résolution de problèmes

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources supplémentaires

2.4. Configuration d'une connexion Ethernet avec une adresse IP statique à l'aide de nmstatectl

Pour configurer une connexion Ethernet à l'aide de l'API Nmstate, utilisez l'utilitaire nmstatectl.

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager pour le périphérique enp7s0 avec les paramètres suivants :

-

Une adresse IPv4 statique -

192.0.2.1avec le masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec le masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

L'utilitaire nmstatectl s'assure qu'après avoir défini la configuration, le résultat correspond au fichier de configuration. En cas d'échec, nmstatectl annule automatiquement les modifications pour éviter de laisser le système dans un état incorrect.

La procédure définit la configuration de l'interface au format YAML. Vous pouvez également spécifier la configuration au format JSON.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

-

Le paquet

nmstateest installé.

Procédure

Créez un fichier YAML, par exemple

~/create-ethernet-profile.yml, avec le contenu suivant :--- interfaces: - name: enp7s0 type: ethernet state: up ipv4: enabled: true address: - ip: 192.0.2.1 prefix-length: 24 dhcp: false ipv6: enabled: true address: - ip: 2001:db8:1::1 prefix-length: 64 autoconf: false dhcp: false routes: config: - destination: 0.0.0.0/0 next-hop-address: 192.0.2.254 next-hop-interface: enp7s0 - destination: ::/0 next-hop-address: 2001:db8:1::fffe next-hop-interface: enp7s0 dns-resolver: config: search: - example.com server: - 192.0.2.200 - 2001:db8:1::ffbbAppliquer les paramètres au système :

# nmstatectl apply ~/create-ethernet-profile.yml

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected enp7s0

Affiche tous les paramètres du profil de connexion :

# nmcli connection show enp7s0 connection.id: enp7s0 connection.uuid: b6cdfa1c-e4ad-46e5-af8b-a75f06b79f76 connection.stable-id: -- connection.type: 802-3-ethernet connection.interface-name: enp7s0 ...

Affiche les paramètres de connexion au format YAML :

# nmstatectl show enp7s0

Ressources supplémentaires

-

nmstatectl(8)page de manuel -

/usr/share/doc/nmstate/examples/répertoire

2.5. Configuration d'une connexion Ethernet avec une adresse IP statique en utilisant le rôle de système RHEL avec un nom d'interface

Vous pouvez configurer à distance une connexion Ethernet à l'aide de network RHEL System Role.

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager pour le périphérique enp7s0 avec les paramètres suivants :

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-static-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 interface_name: enp7s0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: upExécutez le manuel de jeu :

# ansible-playbook ~/ethernet-static-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

2.6. Configuration d'une connexion Ethernet avec une adresse IP statique en utilisant le rôle de système RHEL avec un chemin d'accès aux périphériques

Vous pouvez configurer à distance une connexion Ethernet à l'aide de network RHEL System Role.

Vous pouvez identifier le chemin d'accès à l'appareil à l'aide de la commande suivante :

# udevadm info /sys/class/net/<device_name> | grep ID_PATH=

Par exemple, la procédure ci-dessous crée un profil de connexion NetworkManager avec les paramètres suivants pour le périphérique qui correspond à l'expression PCI ID 0000:00:0[1-3].0, mais pas 0000:00:02.0:

-

Une adresse IPv4 statique -

192.0.2.1avec un masque de sous-réseau/24 -

Une adresse IPv6 statique -

2001:db8:1::1avec un masque de sous-réseau/64 -

Une passerelle par défaut IPv4 -

192.0.2.254 -

Une passerelle par défaut IPv6 -

2001:db8:1::fffe -

Un serveur DNS IPv4 -

192.0.2.200 -

Un serveur DNS IPv6 -

2001:db8:1::ffbb -

Un domaine de recherche DNS -

example.com

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-static-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with static IP include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: address: - 192.0.2.1/24 - 2001:db8:1::1/64 gateway4: 192.0.2.254 gateway6: 2001:db8:1::fffe dns: - 192.0.2.200 - 2001:db8:1::ffbb dns_search: - example.com state: up

Le paramètre

matchdans cet exemple définit qu'Ansible applique la pièce aux périphériques qui correspondent à l'ID PCI0000:00:0[1-3].0, mais pas à0000:00:02.0. Pour plus de détails sur les modificateurs spéciaux et les jokers que vous pouvez utiliser, consultez la description du paramètrematchdans le fichier/usr/share/ansible/roles/rhel-system-roles.network/README.md.Exécutez le manuel de jeu :

# ansible-playbook ~/ethernet-static-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

2.7. Configuration d'une connexion Ethernet avec une adresse IP dynamique à l'aide de nmcli

Pour configurer une connexion Ethernet sur la ligne de commande, utilisez l'utilitaire nmcli. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

Procédure

Ajouter un nouveau profil de connexion NetworkManager pour la connexion Ethernet :

# nmcli connection add con-name Example-Connection ifname enp7s0 type ethernetOptionnellement, changer le nom d'hôte que NetworkManager envoie au serveur DHCP lors de l'utilisation du profil

Example-Connection:# nmcli connection modify Example-Connection ipv4.dhcp-hostname Example ipv6.dhcp-hostname ExampleOptionnellement, changer l'ID client que NetworkManager envoie à un serveur DHCP IPv4 lors de l'utilisation du profil

Example-Connection:# nmcli connection modify Example-Connection ipv4.dhcp-client-id client-IDNotez qu'il n'y a pas de paramètre

dhcp-client-idpour IPv6. Pour créer un identifiant pour IPv6, configurez le servicedhclient.

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Résolution de problèmes

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources supplémentaires

-

dhclient(8)page de manuel -

nm-settings(5) -

nmcli(1)page de manuel - Configurer NetworkManager pour éviter d'utiliser un profil spécifique pour fournir une passerelle par défaut

2.8. Configuration d'une connexion Ethernet avec une adresse IP dynamique à l'aide de l'éditeur interactif nmcli

Vous pouvez configurer une connexion Ethernet sur la ligne de commande en utilisant le mode interactif de l'utilitaire nmcli. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

Procédure

Pour ajouter un nouveau profil de connexion NetworkManager pour la connexion Ethernet et démarrer le mode interactif, entrez :

# nmcli connection edit type ethernet con-name Example-ConnectionDéfinir l'interface réseau :

nmcli> set connection.interface-name enp7s0Optionnellement, changer le nom d'hôte que NetworkManager envoie au serveur DHCP lors de l'utilisation du profil

Example-Connection:nmcli> set ipv4.dhcp-hostname Example nmcli> set ipv6.dhcp-hostname Example

Optionnellement, changer l'ID client que NetworkManager envoie à un serveur DHCP IPv4 lors de l'utilisation du profil

Example-Connection:nmcli> set ipv4.dhcp-client-id client-IDNotez qu'il n'y a pas de paramètre

dhcp-client-idpour IPv6. Pour créer un identifiant pour IPv6, configurez le servicedhclient.Sauvegarder et activer la connexion :

nmcli> save persistent Saving the connection with 'autoconnect=yes'. That might result in an immediate activation of the connection. Do you still want to save? (yes/no) [yes] yes

Quitter le mode interactif :

nmcli> quit

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Résolution de problèmes

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources supplémentaires

-

nm-settings(5)page de manuel -

nmcli(1)page de manuel - Configurer NetworkManager pour éviter d'utiliser un profil spécifique pour fournir une passerelle par défaut

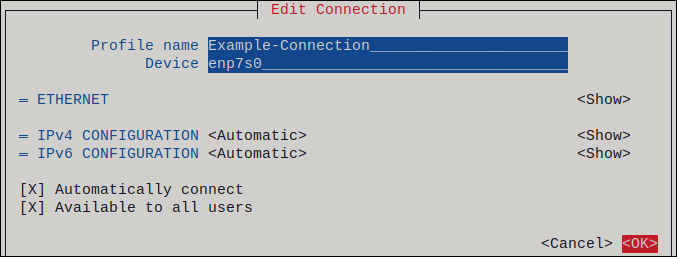

2.9. Configuration d'une connexion Ethernet avec une adresse IP dynamique à l'aide de nmtui

L'application nmtui fournit une interface utilisateur textuelle pour NetworkManager. Vous pouvez utiliser nmtui pour configurer une connexion Ethernet avec une adresse IP dynamique sur un hôte sans interface graphique.

Sur nmtui:

- Naviguer à l'aide des touches du curseur.

- Appuyez sur un bouton en le sélectionnant et en appuyant sur Entrée.

- Sélectionnez et désélectionnez les cases à cocher en utilisant l'espace.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

Procédure

Si vous ne connaissez pas le nom du périphérique réseau que vous souhaitez utiliser pour la connexion, affichez les périphériques disponibles :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet unavailable -- ...

Démarrer

nmtui:# nmtui-

Sélectionnez

Edit a connectionet appuyez sur Enter. -

Appuyez sur le bouton

Add. -

Sélectionnez

Ethernetdans la liste des types de réseaux et appuyez sur Entrée. - Optionnel : Entrez un nom pour le profil NetworkManager à créer.

-

Saisissez le nom de l'appareil réseau dans le champ

Device. Appuyez sur le bouton

OKpour créer et activer automatiquement la nouvelle connexion.

-

Appuyez sur le bouton

Backpour revenir au menu principal. -

Sélectionnez

Quitet appuyez sur Entrée pour fermer l'applicationnmtui.

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Résolution de problèmes

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources supplémentaires

2.10. Configuration d'une connexion Ethernet avec une adresse IP dynamique à l'aide de nmstatectl

Pour configurer une connexion Ethernet à l'aide de l'API Nmstate, utilisez l'utilitaire nmstatectl. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

L'utilitaire nmstatectl s'assure qu'après avoir défini la configuration, le résultat correspond au fichier de configuration. En cas d'échec, nmstatectl annule automatiquement les modifications pour éviter de laisser le système dans un état incorrect.

La procédure définit la configuration de l'interface au format YAML. Vous pouvez également spécifier la configuration au format JSON.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

-

Le paquet

nmstateest installé.

Procédure

Créez un fichier YAML, par exemple

~/create-ethernet-profile.yml, avec le contenu suivant :--- interfaces: - name: enp7s0 type: ethernet state: up ipv4: enabled: true auto-dns: true auto-gateway: true auto-routes: true dhcp: true ipv6: enabled: true auto-dns: true auto-gateway: true auto-routes: true autoconf: true dhcp: trueAppliquer les paramètres au système :

# nmstatectl apply ~/create-ethernet-profile.yml

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected enp7s0

Affiche tous les paramètres du profil de connexion :

# nmcli connection show enp7s0 connection.id: enp7s0 connection.uuid: b6cdfa1c-e4ad-46e5-af8b-a75f06b79f76 connection.stable-id: -- connection.type: 802-3-ethernet connection.interface-name: enp7s0 ...

Affiche les paramètres de connexion au format YAML :

# nmstatectl show enp7s0

Ressources supplémentaires

-

nmstatectl(8)page de manuel -

/usr/share/doc/nmstate/examples/répertoire

2.11. Configuration d'une connexion Ethernet avec une adresse IP dynamique en utilisant le rôle de système RHEL avec un nom d'interface

Vous pouvez configurer à distance une connexion Ethernet à l'aide du rôle de système RHEL network. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau

- Les nœuds gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-dynamic-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with dynamic IP include_role: name: rhel-system-roles.network vars: network_connections: - name: enp7s0 interface_name: enp7s0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: upExécutez le manuel de jeu :

# ansible-playbook ~/ethernet-dynamic-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

2.12. Configuration d'une connexion Ethernet avec une adresse IP dynamique en utilisant le rôle de système RHEL avec un chemin d'accès de périphérique

Vous pouvez configurer à distance une connexion Ethernet à l'aide du rôle de système RHEL network. Pour les connexions avec des paramètres d'adresse IP dynamiques, NetworkManager demande les paramètres IP pour la connexion à partir d'un serveur DHCP.

Vous pouvez identifier le chemin d'accès à l'appareil à l'aide de la commande suivante :

# udevadm info /sys/class/net/<device_name> | grep ID_PATH=Effectuez cette procédure sur le nœud de contrôle Ansible.

Conditions préalables

- Vous avez préparé le nœud de contrôle et les nœuds gérés

- Vous êtes connecté au nœud de contrôle en tant qu'utilisateur pouvant exécuter des séquences sur les nœuds gérés.

-

Le compte que vous utilisez pour vous connecter aux nœuds gérés dispose des autorisations

sudo. - Les nœuds gérés ou les groupes de nœuds gérés sur lesquels vous souhaitez exécuter cette séquence sont répertoriés dans le fichier d'inventaire Ansible.

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

- Les hôtes gérés utilisent NetworkManager pour configurer le réseau.

Procédure

Créez un fichier playbook, par exemple

~/ethernet-dynamic-IP.ymlavec le contenu suivant :--- - name: Configure the network hosts: managed-node-01.example.com tasks: - name: Configure an Ethernet connection with dynamic IP include_role: name: rhel-system-roles.network vars: network_connections: - name: example match: path: - pci-0000:00:0[1-3].0 - &!pci-0000:00:02.0 type: ethernet autoconnect: yes ip: dhcp4: yes auto6: yes state: upLe paramètre

matchdans cet exemple définit qu'Ansible applique la pièce aux périphériques qui correspondent à l'ID PCI0000:00:0[1-3].0, mais pas à0000:00:02.0. Pour plus de détails sur les modificateurs spéciaux et les jokers que vous pouvez utiliser, consultez la description du paramètrematchdans le fichier/usr/share/ansible/roles/rhel-system-roles.network/README.md.Exécutez le manuel de jeu :

# ansible-playbook ~/ethernet-dynamic-IP.yml

Ressources supplémentaires

-

/usr/share/ansible/roles/rhel-system-roles.network/README.mdfichier

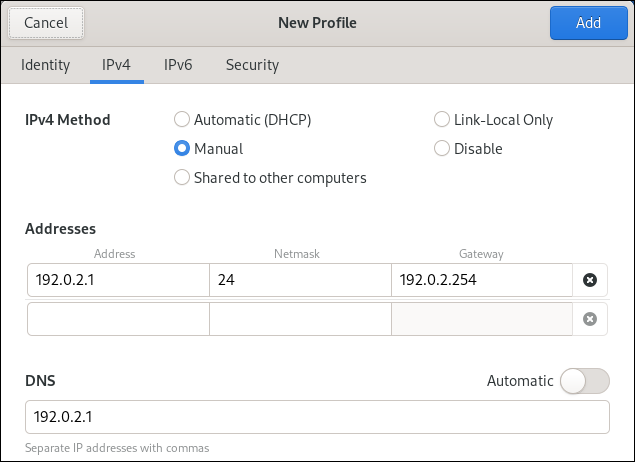

2.13. Configuration d'une connexion Ethernet à l'aide du centre de contrôle

Les connexions Ethernet sont les types de connexions les plus fréquemment utilisés dans les machines physiques ou virtuelles. Si vous utilisez Red Hat Enterprise Linux avec une interface graphique, vous pouvez configurer ce type de connexion dans la fenêtre GNOME control-center.

Notez que control-center ne prend pas en charge autant d'options de configuration que l'application nm-connection-editor ou l'utilitaire nmcli.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- GNOME est installé.

Procédure

-

Appuyez sur la touche Super, entrez

Settingset appuyez sur Entrée. -

Sélectionnez

Networkdans le menu de gauche. -

Cliquez sur le bouton à côté de l'entrée

Wiredpour créer un nouveau profil. -

Facultatif : Définissez un nom pour la connexion dans l'onglet

Identity. Dans l'onglet

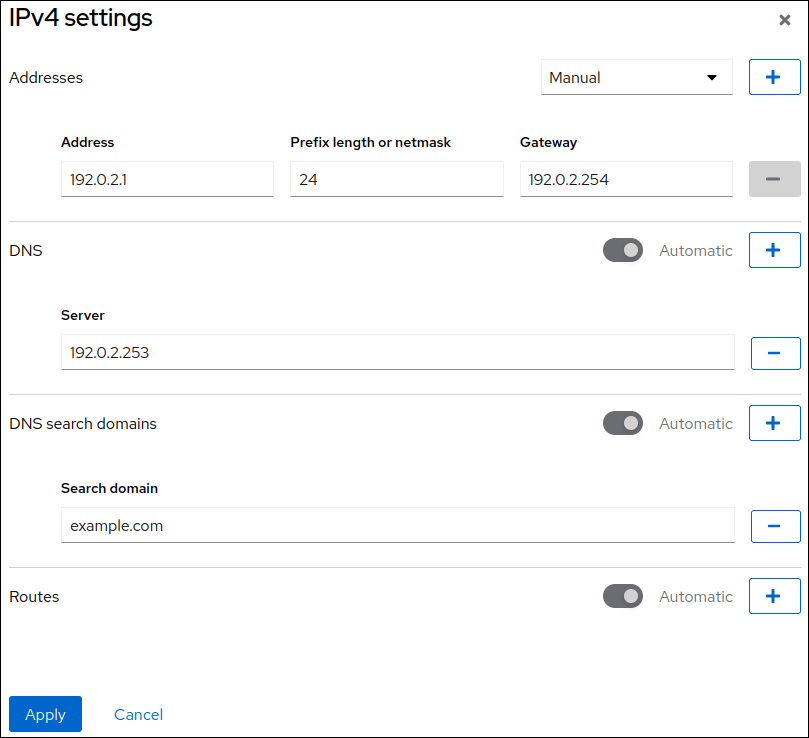

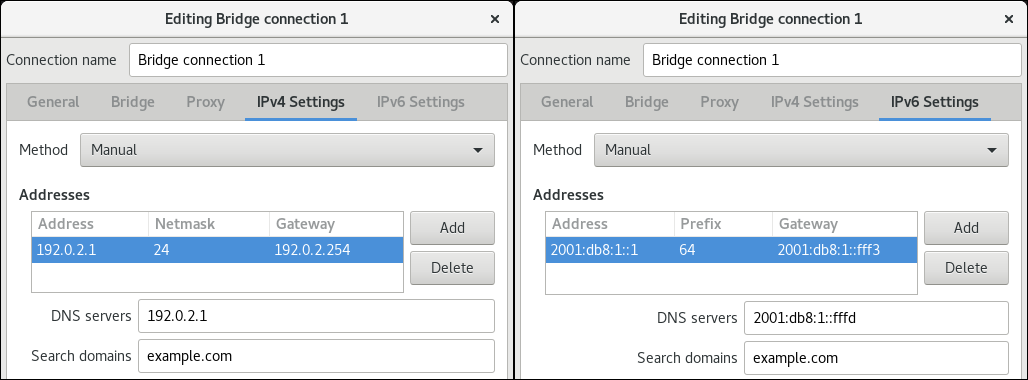

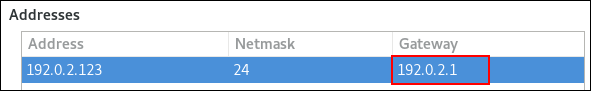

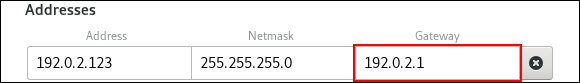

IPv4, configurez les paramètres IPv4. Par exemple, sélectionnez la méthodeManual, définissez une adresse IPv4 statique, un masque de réseau, une passerelle par défaut et un serveur DNS :

Dans l'onglet

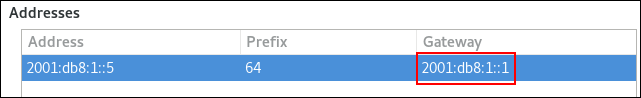

IPv6, configurez les paramètres IPv6. Par exemple, sélectionnez la méthodeManual, définissez une adresse IPv6 statique, un masque de réseau, une passerelle par défaut et un serveur DNS :

-

Cliquez sur le bouton Ajouter pour enregistrer la connexion. Le site GNOME

control-centeractive automatiquement la connexion.

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Étapes de dépannage

- Vérifiez que le câble réseau est branché sur l'hôte et sur un commutateur.

- Vérifiez si la défaillance de la liaison existe uniquement sur cet hôte ou également sur d'autres hôtes connectés au même commutateur.

- Vérifiez que le câble réseau et l'interface réseau fonctionnent comme prévu. Effectuez les étapes de diagnostic du matériel et remplacez les câbles et les cartes d'interface réseau défectueux.

- Si la configuration du disque ne correspond pas à celle du périphérique, le démarrage ou le redémarrage de NetworkManager crée une connexion en mémoire qui reflète la configuration du périphérique. Pour plus de détails et pour savoir comment éviter ce problème, voir NetworkManager duplique une connexion après le redémarrage du service NetworkManager.

Ressources complémentaires

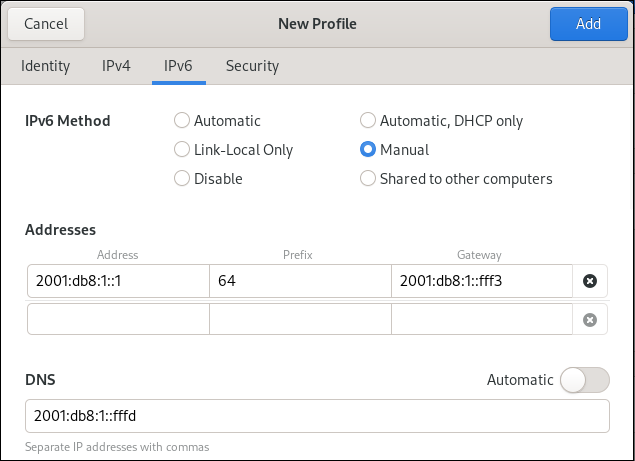

2.14. Configuration d'une connexion Ethernet à l'aide de nm-connection-editor

Les connexions Ethernet sont les types de connexion les plus fréquemment utilisés dans les serveurs physiques ou virtuels. Si vous utilisez Red Hat Enterprise Linux avec une interface graphique, vous pouvez configurer ce type de connexion à l'aide de l'application nm-connection-editor.

Conditions préalables

- Un périphérique Ethernet physique ou virtuel existe dans la configuration du serveur.

- GNOME est installé.

Procédure

Ouvrez un terminal et entrez :

$ nm-connection-editor- Cliquez sur le bouton pour ajouter une nouvelle connexion.

-

Sélectionnez le type de connexion

Ethernetet cliquez sur Créer. Dans l'onglet

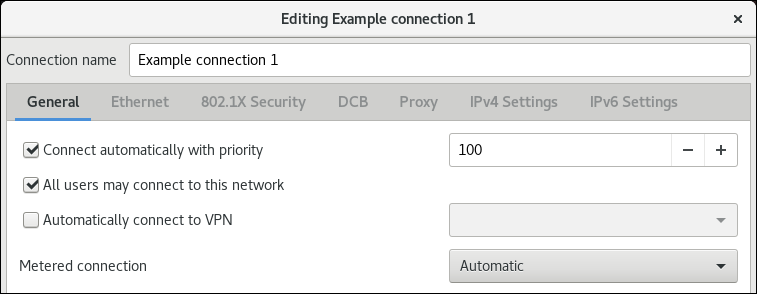

General:Pour activer automatiquement cette connexion lorsque le système démarre ou lorsque vous redémarrez le service

NetworkManager:-

Sélectionnez

Connect automatically with priority. Optionnel : Modifiez la valeur de la priorité à côté de

Connect automatically with priority.Si plusieurs profils de connexion existent pour le même appareil, NetworkManager n'active qu'un seul profil. Par défaut, NetworkManager active le dernier profil utilisé dont l'auto-connexion est activée. Cependant, si vous définissez des valeurs de priorité dans les profils, NetworkManager active le profil ayant la priorité la plus élevée.

-

Sélectionnez

-

Décochez la case

All users may connect to this networksi le profil ne doit être accessible qu'à l'utilisateur qui a créé le profil de connexion.

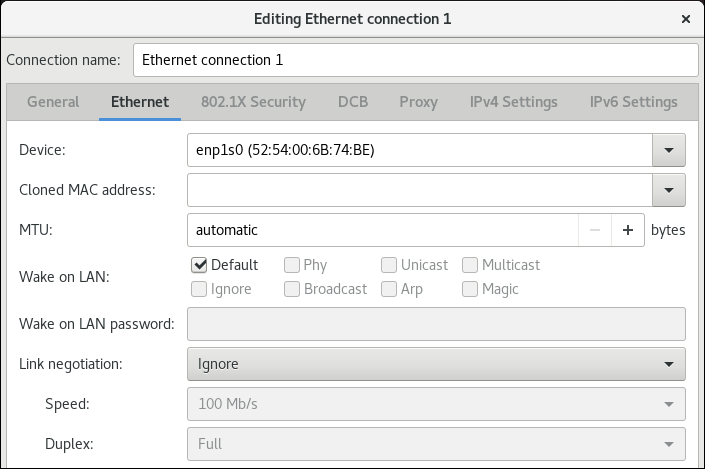

Dans l'onglet

Ethernet, sélectionnez un appareil et, éventuellement, d'autres paramètres liés à l'Ethernet.

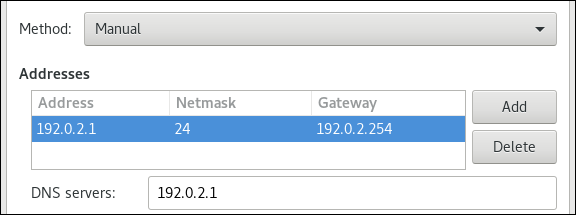

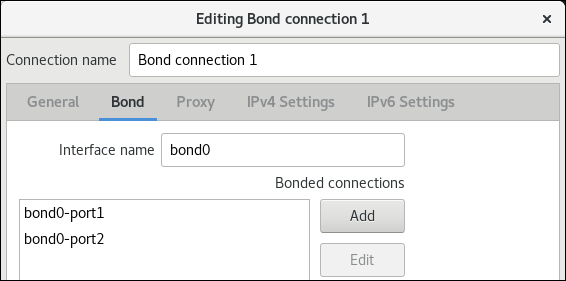

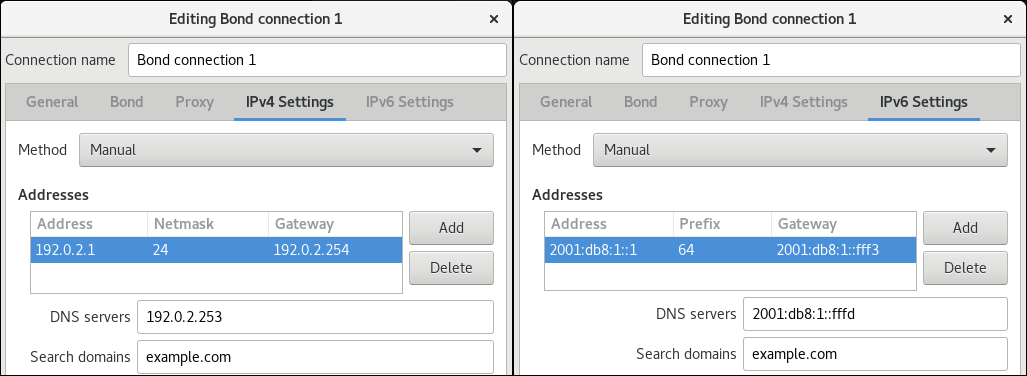

Dans l'onglet

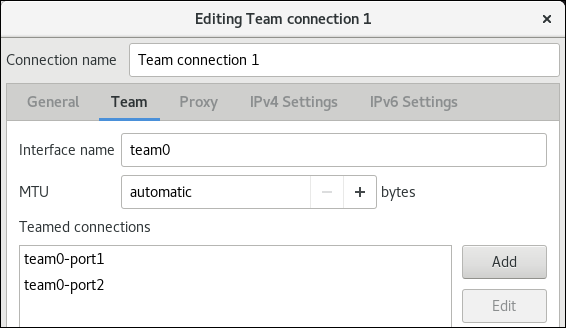

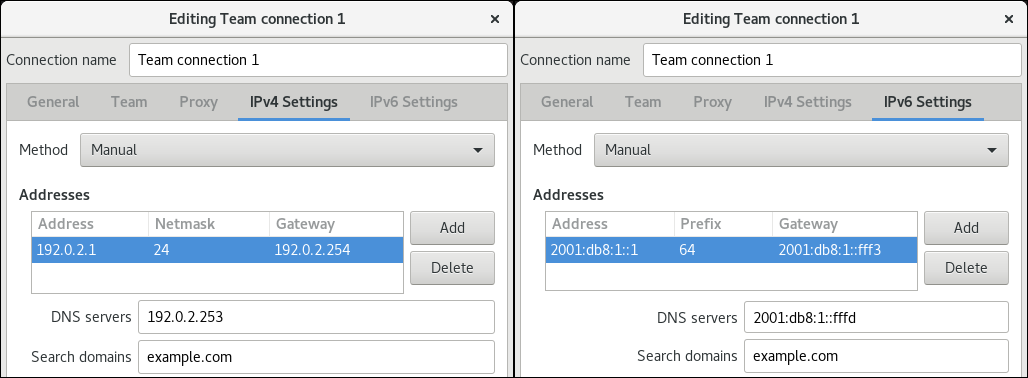

IPv4 Settings, configurez les paramètres IPv4. Par exemple, définissez une adresse IPv4 statique, un masque de réseau, une passerelle par défaut et un serveur DNS :

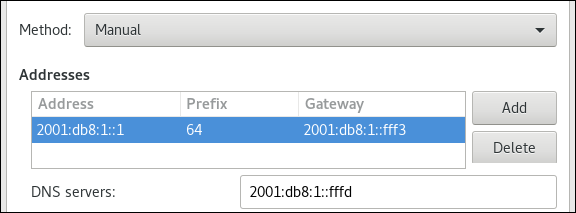

Dans l'onglet

IPv6 Settings, configurez les paramètres IPv6. Par exemple, définissez une adresse IPv6 statique, un masque de réseau, une passerelle par défaut et un serveur DNS :

- Sauvegarder la connexion.

-

Fermer

nm-connection-editor.

Vérification

Affiche l'état des appareils et des connexions :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet connected Example-Connection

Utilisez l'utilitaire

pingpour vérifier que cet hôte peut envoyer des paquets à d'autres hôtes :# ping host_name_or_IP_address

Ressources complémentaires

2.15. Changement du client DHCP du NetworkManager

Par défaut, NetworkManager utilise son client DHCP interne. Cependant, si vous avez besoin d'un client DHCP avec des fonctionnalités que le client intégré ne fournit pas, vous pouvez configurer NetworkManager pour qu'il utilise dhclient.

Notez que RHEL ne fournit pas dhcpcd et que, par conséquent, NetworkManager ne peut pas utiliser ce client.

Procédure

Créez le fichier

/etc/NetworkManager/conf.d/dhcp-client.confavec le contenu suivant :[main] dhcp=dhclient

Vous pouvez régler le paramètre

dhcpsurinternal(valeur par défaut) oudhclient.Si vous attribuez la valeur

dhclientau paramètredhcp, installez le paquetdhcp-client:# dnf install dhcp-clientRedémarrer NetworkManager :

# systemctl restart NetworkManagerNotez que le redémarrage interrompt temporairement toutes les connexions réseau.

Vérification

Recherchez dans le fichier journal

/var/log/messagesune entrée similaire à la suivante :Apr 26 09:54:19 server NetworkManager[27748]: <info> [1650959659.8483] dhcp-init: Using DHCP client 'dhclient'

Cette entrée de journal confirme que NetworkManager utilise

dhclientcomme client DHCP.

Ressources supplémentaires

-

NetworkManager.conf(5)page de manuel

2.16. Configuration du comportement DHCP d'une connexion NetworkManager

Un client DHCP (Dynamic Host Configuration Protocol) demande une adresse IP dynamique et les informations de configuration correspondantes à un serveur DHCP chaque fois qu'un client se connecte au réseau.

Lorsque vous avez configuré une connexion pour récupérer une adresse IP à partir d'un serveur DHCP, le NetworkManager demande une adresse IP à un serveur DHCP. Par défaut, le client attend 45 secondes que cette demande soit terminée. Lorsqu'une connexion DHCP est lancée, un client dhcp demande une adresse IP à un serveur DHCP.

Conditions préalables

- Une connexion utilisant DHCP est configurée sur l'hôte.

Procédure

Définissez les propriétés

ipv4.dhcp-timeoutetipv6.dhcp-timeout. Par exemple, pour définir les deux options sur30seconds, entrez :# nmcli connection modify connection_name ipv4.dhcp-timeout 30 ipv6.dhcp-timeout 30Vous pouvez également définir les paramètres sur

infinitypour configurer NetworkManager de manière à ce qu'il n'arrête pas d'essayer de demander et de renouveler une adresse IP jusqu'à ce qu'il y parvienne.Optionnel : Configurer le comportement si NetworkManager ne reçoit pas d'adresse IPv4 avant l'expiration du délai :

# nmcli connection modify connection_name ipv4.may-fail valueSi l'option

ipv4.may-failest réglée sur :yesl'état de la connexion dépend de la configuration IPv6 :- Si la configuration IPv6 est activée et réussie, NetworkManager active la connexion IPv6 et n'essaie plus d'activer la connexion IPv4.

- Si la configuration IPv6 est désactivée ou non configurée, la connexion échoue.

nola connexion est désactivée. Dans ce cas, la connexion est désactivée :-

Si la propriété

autoconnectde la connexion est activée, NetworkManager tente d'activer la connexion autant de fois que défini dans la propriétéautoconnect-retries. La valeur par défaut est4. - Si la connexion ne peut toujours pas acquérir une adresse DHCP, l'auto-activation échoue. Notez qu'après 5 minutes, le processus d'auto-connexion recommence pour acquérir une adresse IP à partir du serveur DHCP.

-

Si la propriété

Optionnel : Configurer le comportement si NetworkManager ne reçoit pas d'adresse IPv6 avant l'expiration du délai :

# nmcli connection modify connection_name ipv6.may-fail value

Ressources supplémentaires

-

nm-settings(5)page de manuel

2.17. Configuration de plusieurs interfaces Ethernet à l'aide d'un seul profil de connexion par nom d'interface

Dans la plupart des cas, un profil de connexion contient les paramètres d'un seul périphérique réseau. Cependant, NetworkManager prend également en charge les caractères génériques lorsque vous définissez le nom de l'interface dans les profils de connexion. Si un hôte passe d'un réseau Ethernet à l'autre avec une attribution dynamique d'adresse IP, vous pouvez utiliser cette fonctionnalité pour créer un profil de connexion unique que vous pouvez utiliser pour plusieurs interfaces Ethernet.

Conditions préalables

- Plusieurs périphériques Ethernet physiques ou virtuels existent dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

- Aucun profil de connexion n'existe sur l'hôte.

Procédure

Ajouter un profil de connexion qui s'applique à tous les noms d'interface commençant par

enp:# nmcli connection add con-name Example connection.multi-connect multiple match.interface-name enp* type ethernet

Vérification

Affiche tous les paramètres du profil de connexion unique :

# nmcli connection show Example connection.id: Example ... connection.multi-connect: 3 (multiple) match.interface-name:

enp*...3indique le nombre d'interfaces actives sur le profil de connexion au même moment, et non le nombre d'interfaces réseau dans le profil de connexion. Le profil de connexion utilise tous les appareils qui correspondent au modèle du paramètrematch.interface-nameet, par conséquent, les profils de connexion ont le même identifiant universel unique (UUID).Affiche l'état des connexions :

# nmcli connection show NAME UUID TYPE DEVICE ... Example 6f22402e-c0cc-49cf-b702-eaf0cd5ea7d1 ethernet enp7s0 Example 6f22402e-c0cc-49cf-b702-eaf0cd5ea7d1 ethernet enp8s0 Example 6f22402e-c0cc-49cf-b702-eaf0cd5ea7d1 ethernet enp9s0

Ressources supplémentaires

-

nmcli(1)page de manuel -

nm-settings(5)page de manuel

2.18. Configuration d'un profil de connexion unique pour plusieurs interfaces Ethernet à l'aide d'ID PCI

L'ID PCI est un identifiant unique des appareils connectés au système. Le profil de connexion ajoute plusieurs périphériques en faisant correspondre les interfaces sur la base d'une liste d'ID PCI. Vous pouvez utiliser cette procédure pour connecter plusieurs ID PCI de périphériques à un seul profil de connexion.

Conditions préalables

- Plusieurs périphériques Ethernet physiques ou virtuels existent dans la configuration du serveur.

- Un serveur DHCP est disponible dans le réseau.

- Aucun profil de connexion n'existe sur l'hôte.

Procédure

Identifiez le chemin d'accès au périphérique. Par exemple, pour afficher les chemins d'accès aux périphériques de toutes les interfaces commençant par

enp, entrez :# udevadm info /sys/class/net/enp* | grep ID_PATH= ... E: ID_PATH=pci-0000:07:00.0 E: ID_PATH=pci-0000:08:00.0Ajouter un profil de connexion qui s'applique à tous les ID PCI correspondant à l'expression

0000:00:0[7-8].0:# nmcli connection add type ethernet connection.multi-connect multiple match.path "pci-0000:07:00.0 pci-0000:08:00.0" con-name Example

Vérification

Affiche l'état de la connexion :

# nmcli connection show NAME UUID TYPE DEVICE Example 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp7s0 Example 9cee0958-512f-4203-9d3d-b57af1d88466 ethernet enp8s0 ...Pour afficher tous les paramètres du profil de connexion :

# nmcli connection show Example connection.id: Example ... connection.multi-connect: 3 (multiple) match.path: pci-0000:07:00.0,pci-0000:08:00.0 ...Ce profil de connexion utilise tous les appareils dont l'ID PCI correspond au modèle du paramètre

match.pathet, par conséquent, les profils de connexion ont le même identifiant universel unique (UUID).

Ressources supplémentaires

-

nmcli(1)page de manuel -

nm-settings(5)page de manuel

Chapitre 3. Configuration de la liaison réseau

Une liaison réseau est une méthode permettant de combiner ou d'agréger des interfaces réseau physiques et virtuelles afin de fournir une interface logique avec un débit plus élevé ou une redondance. Dans un lien, le noyau gère exclusivement toutes les opérations. Vous pouvez créer des liens sur différents types de périphériques, tels que des périphériques Ethernet ou des VLAN.

Red Hat Enterprise Linux offre aux administrateurs différentes options pour configurer les périphériques d'équipe. Par exemple :

-

Utilisez

nmclipour configurer les connexions de liaison à l'aide de la ligne de commande. - Utilisez la console web RHEL pour configurer les connexions bond à l'aide d'un navigateur web.

-

Utilisez

nmtuipour configurer les connexions de liaison dans une interface utilisateur textuelle. -

Utilisez l'application

nm-connection-editorpour configurer les connexions de liaison dans une interface graphique. -

Utilisez

nmstatectlpour configurer les connexions de liaison par l'intermédiaire de l'API Nmstate. - Utilisez les rôles système RHEL pour automatiser la configuration des liens sur un ou plusieurs hôtes.

3.1. Comprendre la liaison réseau

La liaison réseau est une méthode permettant de combiner ou d'agréger des interfaces réseau afin de fournir une interface logique avec un débit plus élevé ou une redondance.

Les modes active-backup, balance-tlb et balance-alb ne nécessitent aucune configuration spécifique du commutateur réseau. Cependant, d'autres modes de liaison nécessitent de configurer le commutateur pour agréger les liens. Par exemple, les commutateurs Cisco nécessitent EtherChannel pour les modes 0, 2 et 3, mais pour le mode 4, le protocole LACP (Link Aggregation Control Protocol) et EtherChannel sont nécessaires. Pour plus de détails, consultez la documentation de votre commutateur.

Certaines fonctions de liaison réseau, telles que le mécanisme de basculement, ne prennent pas en charge les connexions directes par câble sans commutateur réseau. Pour plus de détails, voir la section Le bonding est-il pris en charge avec une connexion directe utilisant des câbles croisés ? Solution KCS.

3.2. Comprendre le comportement par défaut des interfaces des contrôleurs et des ports

Tenez compte du comportement par défaut suivant lorsque vous gérez ou dépannez des interfaces de port d'équipe ou de liaison à l'aide du service NetworkManager:

- Le démarrage de l'interface du contrôleur ne démarre pas automatiquement les interfaces des ports.

- Le démarrage d'une interface de port entraîne toujours le démarrage de l'interface du contrôleur.

- L'arrêt de l'interface du contrôleur entraîne également l'arrêt de l'interface du port.

- Un contrôleur sans ports peut démarrer des connexions IP statiques.

- Un contrôleur sans ports attend les ports lors du démarrage des connexions DHCP.

- Un contrôleur avec une connexion DHCP en attente de ports se termine lorsque vous ajoutez un port avec une porteuse.

- Un contrôleur avec une connexion DHCP en attente de ports continue d'attendre lorsque vous ajoutez un port sans support.

3.3. Configuration du commutateur en amont en fonction des modes de liaison

Appliquez les paramètres suivants au commutateur en amont en fonction du mode de liaison :

| Mode de liaison | Configuration sur le commutateur |

|---|---|

|

| Nécessite un canal d'échange statique activé (non négocié LACP) |

|

| Nécessite des ports autonomes |

|

| Nécessite un canal d'échange statique activé (non négocié LACP) |

|

| Nécessite un canal d'échange statique activé (non négocié LACP) |

|

| Nécessite l'activation du canal Ethernet négocié LACP |

|

| Nécessite des ports autonomes |

|

| Nécessite des ports autonomes |

Pour configurer ces paramètres sur votre commutateur, consultez la documentation du commutateur.

3.4. Configuration d'une liaison réseau à l'aide de nmcli

Pour configurer une liaison réseau sur la ligne de commande, utilisez l'utilitaire nmcli.

Conditions préalables

- Deux ou plusieurs périphériques réseau physiques ou virtuels sont installés sur le serveur.

- Pour utiliser des périphériques Ethernet comme ports de la liaison, les périphériques Ethernet physiques ou virtuels doivent être installés sur le serveur.

Pour utiliser des périphériques team, bridge ou VLAN comme ports de la liaison, vous pouvez soit créer ces périphériques lors de la création de la liaison, soit les créer à l'avance comme décrit dans la section :

Procédure

Créer une interface de liaison :

# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup"Cette commande crée un lien nommé

bond0qui utilise le modeactive-backup.Pour définir en plus un intervalle de surveillance de l'interface indépendante de média (MII), ajoutez l'option

miimon=intervalà la propriétébond.options, par exemple :# nmcli connection add type bond con-name bond0 ifname bond0 bond.options "mode=active-backup,miimon=1000"Affichez les interfaces réseau et notez les noms des interfaces que vous prévoyez d'ajouter au lien :

# nmcli device status DEVICE TYPE STATE CONNECTION enp7s0 ethernet disconnected -- enp8s0 ethernet disconnected -- bridge0 bridge connected bridge0 bridge1 bridge connected bridge1 ...Dans cet exemple :

-

enp7s0etenp8s0ne sont pas configurés. Pour utiliser ces dispositifs comme ports, ajoutez des profils de connexion à l'étape suivante. -

bridge0etbridge1ont des profils de connexion existants. Pour utiliser ces dispositifs comme ports, modifiez leurs profils à l'étape suivante.

-

Attribuer des interfaces à la liaison :

Si les interfaces que vous souhaitez attribuer à la liaison ne sont pas configurées, créez de nouveaux profils de connexion pour elles :

# nmcli connection add type ethernet slave-type bond con-name bond0-port1 ifname enp7s0 master bond0 # nmcli connection add type ethernet slave-type bond con-name bond0-port2 ifname enp8s0 master bond0

Ces commandes créent des profils pour

enp7s0etenp8s0et les ajoutent à la connexionbond0.Pour affecter un profil de connexion existant à la liaison :

Réglez le paramètre

masterde ces connexions surbond0:# nmcli connection modify bridge0 master bond0 # nmcli connection modify bridge1 master bond0

Ces commandes affectent les profils de connexion existants nommés

bridge0etbridge1à la connexionbond0.Réactiver les connexions :

# nmcli connection up bridge0 # nmcli connection up bridge1

Configurez les paramètres IPv4 :

Pour utiliser ce périphérique de liaison comme port d'autres périphériques, entrez :

# nmcli connection modify bond0 ipv4.method disabled- Pour utiliser le DHCP, aucune action n'est nécessaire.

Pour définir une adresse IPv4 statique, un masque de réseau, une passerelle par défaut et un serveur DNS pour la connexion

bond0, entrez :# nmcli connection modify bond0 ipv4.addresses '192.0.2.1/24' ipv4.gateway '192.0.2.254' ipv4.dns '192.0.2.253' ipv4.dns-search 'example.com' ipv4.method manual

Configurez les paramètres IPv6 :

Pour utiliser ce périphérique de liaison comme port d'autres périphériques, entrez :

# nmcli connection modify bond0 ipv6.method disabled- Pour utiliser le DHCP, aucune action n'est nécessaire.

Pour définir une adresse IPv6 statique, un masque de réseau, une passerelle par défaut et un serveur DNS pour la connexion

bond0, entrez :# nmcli connection modify bond0 ipv6.addresses '2001:db8:1::1/64' ipv6.gateway '2001:db8:1::fffe' ipv6.dns '2001:db8:1::fffd' ipv6.dns-search 'example.com' ipv6.method manual

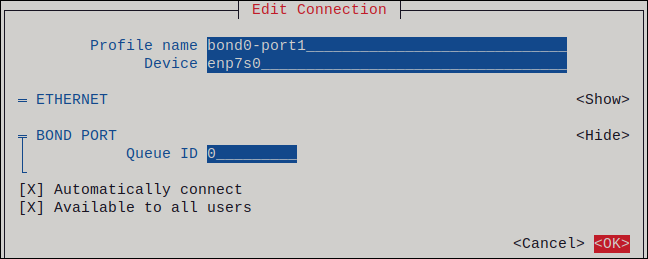

Facultatif : si vous souhaitez définir des paramètres sur les ports de liaison, utilisez la commande suivante :

# nmcli connection modify bond0-port1 bond-port.<parameter> <value>Activer la connexion :

# nmcli connection up bond0Vérifiez que les ports sont connectés et que la colonne

CONNECTIONaffiche le nom de connexion du port :# nmcli device DEVICE TYPE STATE CONNECTION ... enp7s0 ethernet connected bond0-port1 enp8s0 ethernet connected bond0-port2Lorsque vous activez un port de la connexion, NetworkManager active également le lien, mais pas les autres ports. Vous pouvez configurer Red Hat Enterprise Linux pour qu'il active automatiquement tous les ports lorsque la liaison est activée :

Active le paramètre

connection.autoconnect-slavesde la connexion de la liaison :# nmcli connection modify bond0 connection.autoconnect-slaves 1Réactiver le pont :

# nmcli connection up bond0

Vérification

Retirez temporairement le câble réseau de l'hôte.

Il convient de noter qu'il n'existe aucune méthode permettant de tester correctement les événements de défaillance de liaison à l'aide d'utilitaires logiciels. Les outils qui désactivent les connexions, tels que

nmcli, ne montrent que la capacité du pilote de liaison à gérer les changements de configuration des ports et non les événements réels de défaillance de la liaison.Affiche l'état de la liaison :

# cat /proc/net/bonding/bond0

3.5. Configuration d'une liaison réseau à l'aide de la console web RHEL

Utilisez la console web RHEL pour configurer une liaison réseau si vous préférez gérer les paramètres réseau à l'aide d'une interface basée sur un navigateur web.

Conditions préalables

- Vous êtes connecté à la console web RHEL.

- Deux ou plusieurs périphériques réseau physiques ou virtuels sont installés sur le serveur.

- Pour utiliser des périphériques Ethernet comme membres du lien, les périphériques Ethernet physiques ou virtuels doivent être installés sur le serveur.

Pour utiliser des périphériques d'équipe, de pont ou de VLAN en tant que membres du lien, créez-les à l'avance comme décrit dans la section :

Procédure

-

Sélectionnez l'onglet

Networkingdans le menu de navigation situé à gauche de l'écran. -

Cliquez sur Add bond dans la section

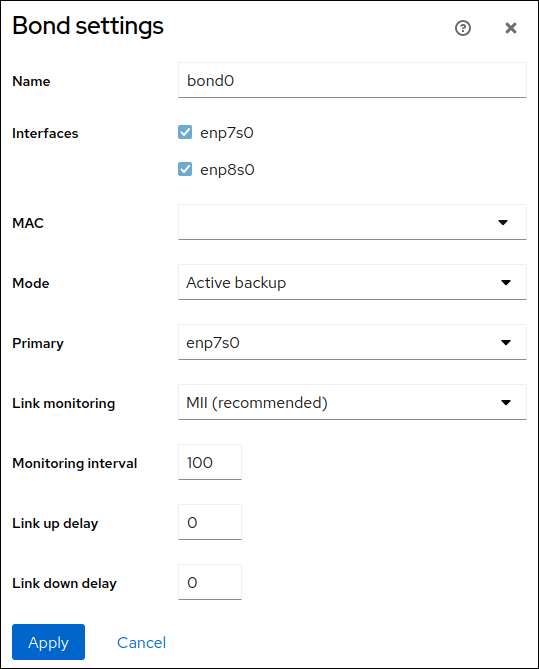

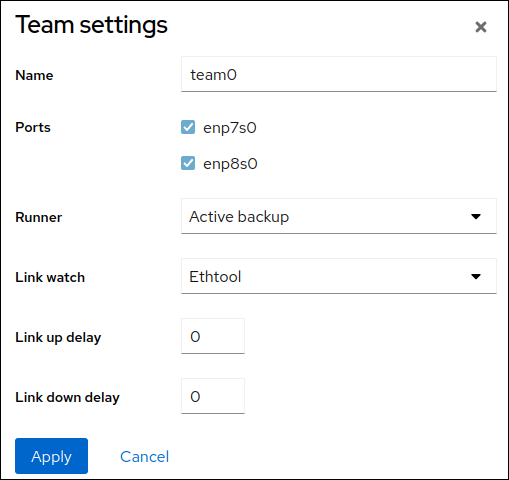

Interfaces. - Saisissez le nom du dispositif de liaison que vous souhaitez créer.

- Sélectionnez les interfaces qui doivent être membres de la liaison.

Sélectionnez le mode de l'obligation.

Si vous sélectionnez

Active backup, la console web affiche le champ supplémentairePrimarydans lequel vous pouvez sélectionner l'appareil actif préféré.-

Définissez le mode de surveillance des liens. Par exemple, lorsque vous utilisez le mode

Adaptive load balancing, réglez-le surARP. En option : Ajustez les paramètres de l'intervalle de surveillance, du délai d'établissement de la liaison et du délai de rétablissement de la liaison. En général, vous ne modifiez les paramètres par défaut qu'à des fins de dépannage.

- Cliquez sur Appliquer.

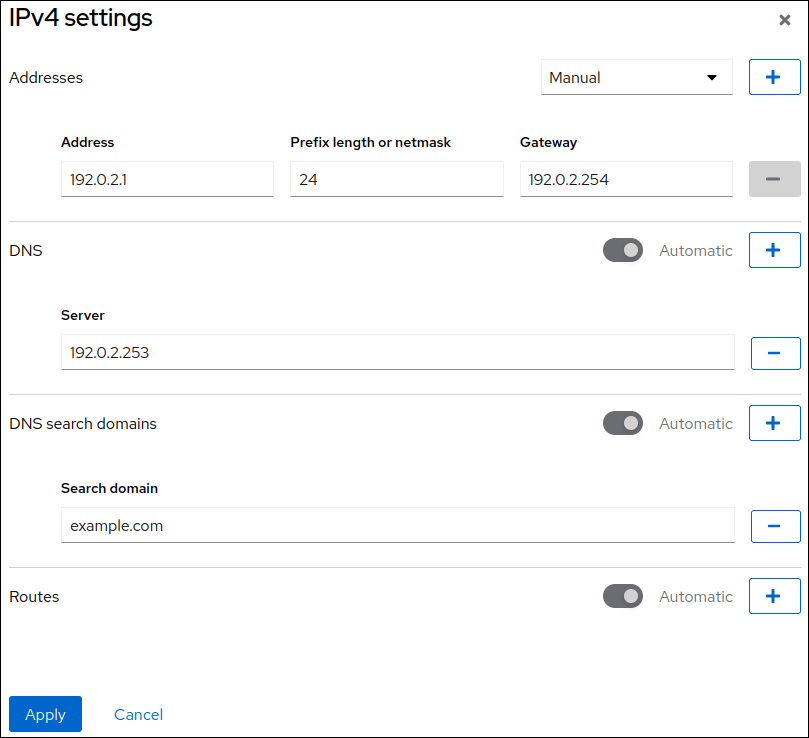

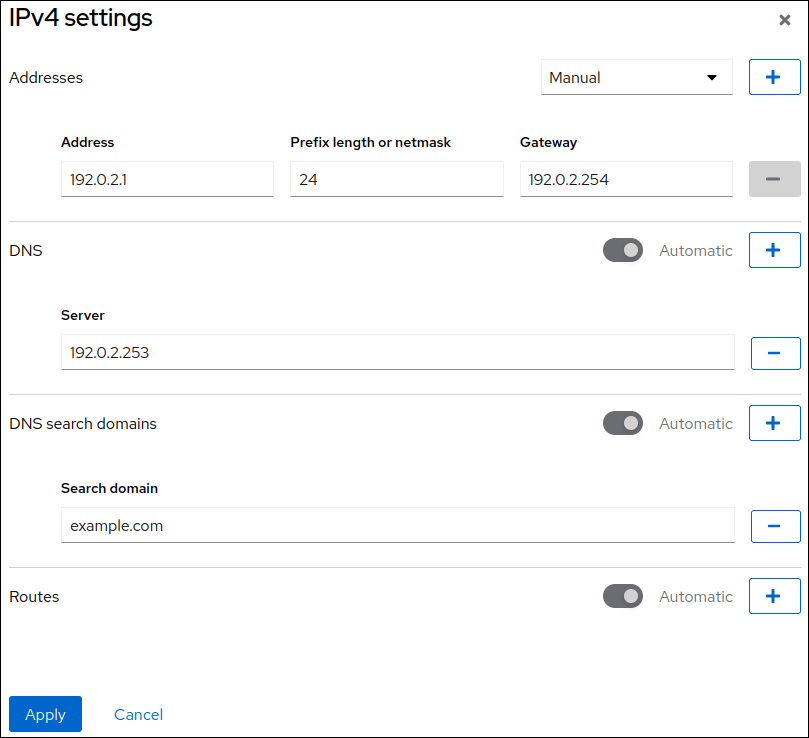

Par défaut, la liaison utilise une adresse IP dynamique. Si vous souhaitez définir une adresse IP statique :

-

Cliquez sur le nom de l'obligation dans la section

Interfaces. -

Cliquez sur

Editen regard du protocole que vous souhaitez configurer. -

Sélectionnez

Manualà côté deAddresses, et entrez l'adresse IP, le préfixe et la passerelle par défaut. -

Dans la section

DNS, cliquez sur le bouton et entrez l'adresse IP du serveur DNS. Répétez cette étape pour définir plusieurs serveurs DNS. -

Dans la section

DNS search domains, cliquez sur le bouton et entrez le domaine de recherche. Si l'interface nécessite des routes statiques, configurez-les dans la section

Routes.

- Cliquez sur Appliquer

-

Cliquez sur le nom de l'obligation dans la section

Vérification

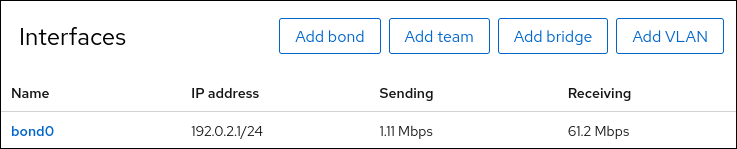

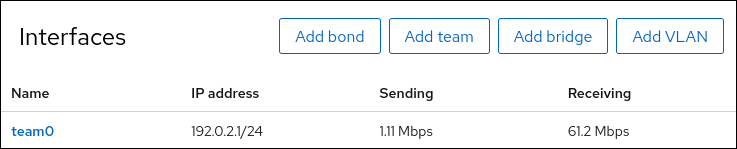

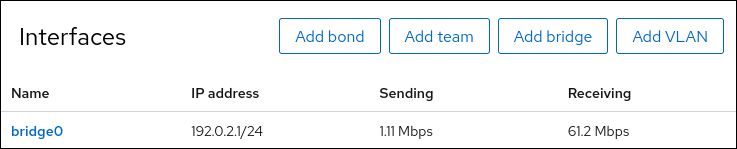

Sélectionnez l'onglet

Networkingdans la navigation sur le côté gauche de l'écran, et vérifiez s'il y a du trafic entrant et sortant sur l'interface :

Retirez temporairement le câble réseau de l'hôte.

Notez qu'il n'existe aucune méthode permettant de tester correctement les événements de défaillance de liaison à l'aide d'utilitaires logiciels. Les outils qui désactivent les connexions, comme la console web, ne montrent que la capacité du pilote de liaison à gérer les changements de configuration des membres et non les événements réels de défaillance de la liaison.

Affiche l'état de la liaison :

# cat /proc/net/bonding/bond0

3.6. Configuration d'une liaison réseau à l'aide de nmtui

L'application nmtui fournit une interface utilisateur textuelle pour NetworkManager. Vous pouvez utiliser nmtui pour configurer une liaison réseau sur un hôte dépourvu d'interface graphique.

Sur nmtui:

- Naviguer à l'aide des touches du curseur.

- Appuyez sur un bouton en le sélectionnant et en appuyant sur Entrée.