虚拟化

OpenShift Virtualization 安装和使用。

摘要

第 1 章 关于

1.1. 关于 OpenShift virtualization

OpenShift Virtualization 的功能与支持范围。

1.1.1. OpenShift Virtualization 的作用

OpenShift Virtualization 是 Red Hat OpenShift Service on AWS 的一个附加组件,可让您运行和管理虚拟机工作负载以及容器工作负载。

OpenShift Virtualization 使用 Kubernetes 自定义资源添加新对象至 Red Hat OpenShift Service on AWS 集群中,以启用虚拟化任务。这些任务包括:

- 创建和管理 Linux 和 Windows 虚拟机 (VM)

- 在集群中运行 pod 和虚拟机工作负载

- 通过各种控制台和 CLI 工具连接至虚拟机

- 导入和克隆现有虚拟机

- 管理虚拟机上附加的网络接口控制器和存储磁盘

- 在节点间实时迁移虚拟机

增强的 Web 控制台提供了一个图形门户,用于管理这些虚拟化资源以及 Red Hat OpenShift Service on AWS 集群容器和基础架构。

您可以将 OpenShift Virtualization 与 OVN-Kubernetes 或 OpenShift SDN 搭配使用。

您可以通过安装 Compliance Operator 并使用 ocp4-moderate 和 ocp4-moderate-node 配置集运行扫描来检查 OpenShift Virtualization 集群的合规性问题。Compliance Operator 使用 NIST 认证工具 OpenSCAP 扫描并执行安全策略。

1.1.1.1. OpenShift Virtualization 支持的集群版本

OpenShift Virtualization 4.15 支持在 Red Hat OpenShift Service on AWS 4 集群中使用。要使用 OpenShift Virtualization 的最新 z-stream 版本,您必须首先升级到 Red Hat OpenShift Service on AWS 的最新版本。

1.1.2. 关于虚拟机磁盘的卷和访问模式

如果您将存储 API 与已知的存储供应商搭配使用,则会自动选择卷和访问模式。但是,如果您使用没有存储配置集的存储类,您必须配置卷和访问模式。

要获得最佳结果,请使用 ReadWriteMany (RWX)访问模式和 Block 卷模式。这一点非常重要:

-

实时迁移需要

ReadWriteMany(RWX) 访问模式。 -

块卷模式的性能优于Filesystem卷模式。这是因为Filesystem卷模式使用更多存储层,包括文件系统层和磁盘镜像文件。虚拟机磁盘存储不需要这些层。

您不能使用以下配置实时迁移虚拟机:

-

具有

ReadWriteOnce(RWO) 访问模式的存储卷 - 透传功能,比如 GPU

对于这些虚拟机,不要将 evictionStrategy 字段设置为 LiveMigrate。

1.1.3. 其他资源

1.2. 安全策略

了解 OpenShift Virtualization 安全和授权。

关键点

-

OpenShift Virtualization 遵循

restrictedKubernetes pod 安全标准配置集,旨在强制实施 Pod 安全性的当前最佳实践。 - 虚拟机 (VM) 工作负载作为非特权 pod 运行。

-

为

kubevirt-controller服务帐户定义 安全性上下文约束 (SCC)。 - OpenShift Virtualization 组件的 TLS 证书都会被更新并自动轮转。

1.2.1. 关于工作负载安全性

默认情况下,虚拟机 (VM) 工作负载不会在 OpenShift Virtualization 中使用 root 权限运行,且不支持的 OpenShift Virtualization 功能需要 root 权限。

对于每个虚拟机,virt-launcher pod 以 会话模式运行一个 libvirt 实例,用于管理虚拟机进程。在会话模式中,libvirt 守护进程以非 root 用户帐户运行,仅允许同一用户标识符 (UID) 下运行的客户端的连接。因此,虚拟机作为非特权 pod 运行,遵循最小特权的安全原则。

1.2.2. TLS 证书

OpenShift Virtualization 组件的 TLS 证书都会被更新并自动轮转。您不需要手动刷新它们。

自动续订计划

TLS 证书会根据以下调度自动删除并替换:

- kubeVirt 证书每天都会被更新。

- 容器化数据导入程序控制器(CDI)证书每 15 天更新一次。

- MAC 池证书会每年续订。

自动 TLS 证书轮转不会破坏任何操作。例如,以下操作可在没有任何中断的情况下继续工作:

- 迁移

- 镜像上传

- VNC 和控制台连接

1.2.3. 授权

OpenShift Virtualization 使用基于角色的访问控制 (RBAC)为人用户和服务帐户定义权限。为服务帐户定义的权限控制 OpenShift Virtualization 组件可以执行的操作。

您还可以使用 RBAC 角色管理用户对虚拟化功能的访问。例如,管理员可以创建一个 RBAC 角色,它提供启动虚拟机所需的权限。然后,管理员可以通过将角色绑定到特定用户来限制访问权限。

1.2.3.1. OpenShift Virtualization 的默认集群角色

通过使用集群角色聚合,OpenShift Virtualization 扩展默认的 Red Hat OpenShift Service on AWS 集群角色,使其包含访问虚拟化对象的权限。

表 1.1. OpenShift Virtualization 集群角色

| 默认集群角色 | OpenShift Virtualization 集群角色 | OpenShift Virtualization 集群角色描述 |

|---|---|---|

|

|

| 此用户可以查看集群中的所有 OpenShift Virtualization 资源,但不能创建、删除、修改或访问它们。例如,用户可以看到虚拟机 (VM) 正在运行,但不能将其关闭或访问其控制台。 |

|

|

| 可以修改集群中的所有 OpenShift Virtualization 资源的用户。例如,用户可以创建虚拟机、访问虚拟机控制台和删除虚拟机。 |

|

|

|

具有所有 OpenShift Virtualization 资源的完整权限的用户,包括删除资源集合。用户也可以查看和修改 OpenShift Virtualization 运行时配置,该配置位于 |

1.2.3.2. OpenShift Virtualization 中存储功能的 RBAC 角色

为 Containerized Data Importer (CDI) 授予以下权限,包括 cdi-operator 和 cdi-controller 服务帐户。

1.2.3.2.1. 集群范围的 RBAC 角色

表 1.2. cdi.kubevirt.io API 组的聚合集群角色

| CDI 集群角色 | Resources | Verbs |

|---|---|---|

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

|

|

| |

|

|

|

|

表 1.3. cdi-operator 服务帐户的集群范围角色

| API 组 | Resources | Verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

允许列表: |

|

|

|

允许列表: |

|

|

|

|

|

表 1.4. cdi-controller 服务帐户的集群范围角色

| API 组 | Resources | Verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.2.3.2.2. 命名空间的 RBAC 角色

表 1.5. cdi-operator 服务帐户的命名空间角色

| API 组 | Resources | Verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

表 1.6. cdi-controller 服务帐户的命名空间角色

| API 组 | Resources | Verbs |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1.2.3.3. kubevirt-controller 服务帐户的额外 SCC 和权限

Pod 的安全上下文约束(SCC)控制权限。这些权限包括 Pod(容器集合)可以执行的操作以及它们可以访问的资源。您可以使用 SCC 定义 Pod 运行必须满足的一组条件,以便其能被系统接受。

virt-controller 是一个集群控制器,可为集群中的虚拟机创建 virt-launcher pod。这些 pod 由 kubevirt-controller 服务帐户授予权限。

kubevirt-controller 服务帐户被授予额外的 SCC 和 Linux 功能,以便能够创建具有适当权限的 virt-launcher Pod。这些扩展权限允许虚拟机使用超出典型 pod 范围的 OpenShift Virtualization 功能。

kubevirt-controller 服务帐户被授予以下 SCC:

-

scc.AllowHostDirVolumePlugin = true

这允许虚拟机使用 hostpath 卷插件。 -

scc.AllowPrivilegedContainer = false

可确保 virt-launcher pod 不是作为特权容器运行。 scc.AllowedCapabilities = []corev1.Capability{"SYS_NICE", "NET_BIND_SERVICE"}-

SYS_NICE允许设置 CPU 关联性。 -

NET_BIND_SERVICE允许 DHCP 和 Slirp 操作。

-

查看 kubevirt-controller 的 SCC 和 RBAC 定义

您可以使用 oc 工具查看 kubevirt-controller 的 SecurityContextConstraints 定义:

$ oc get scc kubevirt-controller -o yaml

您可以使用 oc 工具查看 kubevirt-controller clusterrole 的 RBAC 定义:

$ oc get clusterrole kubevirt-controller -o yaml

1.2.4. 其他资源

1.3. OpenShift Virtualization 架构

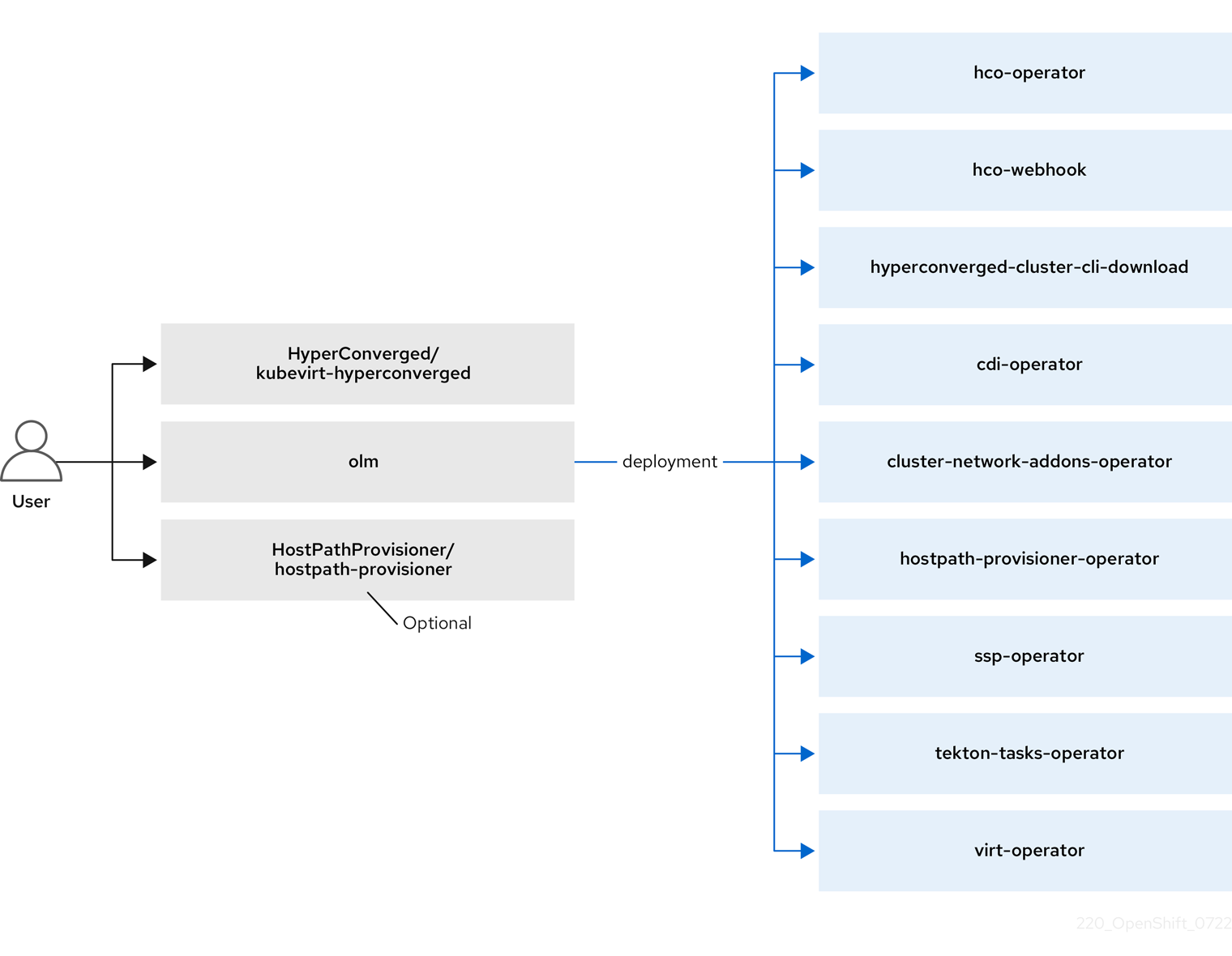

Operator Lifecycle Manager (OLM) 为 OpenShift Virtualization 的每个组件部署 Operator pod:

-

Compute:

virt-operator -

Storage:

cdi-operator -

Network:

cluster-network-addons-operator -

Scaling:

ssp-operator -

Templating:

tekton-tasks-operator

OLM 还会部署 hyperconverged-cluster-operator pod,它负责其他组件的部署、配置和生命周期,以及几个 helper pod: hco-webhook 和 hyperconverged-cluster-cli-download。

成功部署所有 Operator pod 后,您应该创建 HyperConverged 自定义资源 (CR)。HyperConverged CR 中的配置充当 OpenShift Virtualization 的单个来源,并指导 CR 的行为。

HyperConverged CR 为其协调循环中的所有其他组件的 operator 创建对应的 CR。然后,每个 Operator 会为 OpenShift Virtualization control plane 创建资源,如守护进程集、配置映射和其他组件。例如,当 HyperConverged Operator (HCO) 创建 KubeVirt CR 时,OpenShift Virtualization Operator 会协调它并创建其他资源,如 virt-controller、virt-handler 和 virt-api。

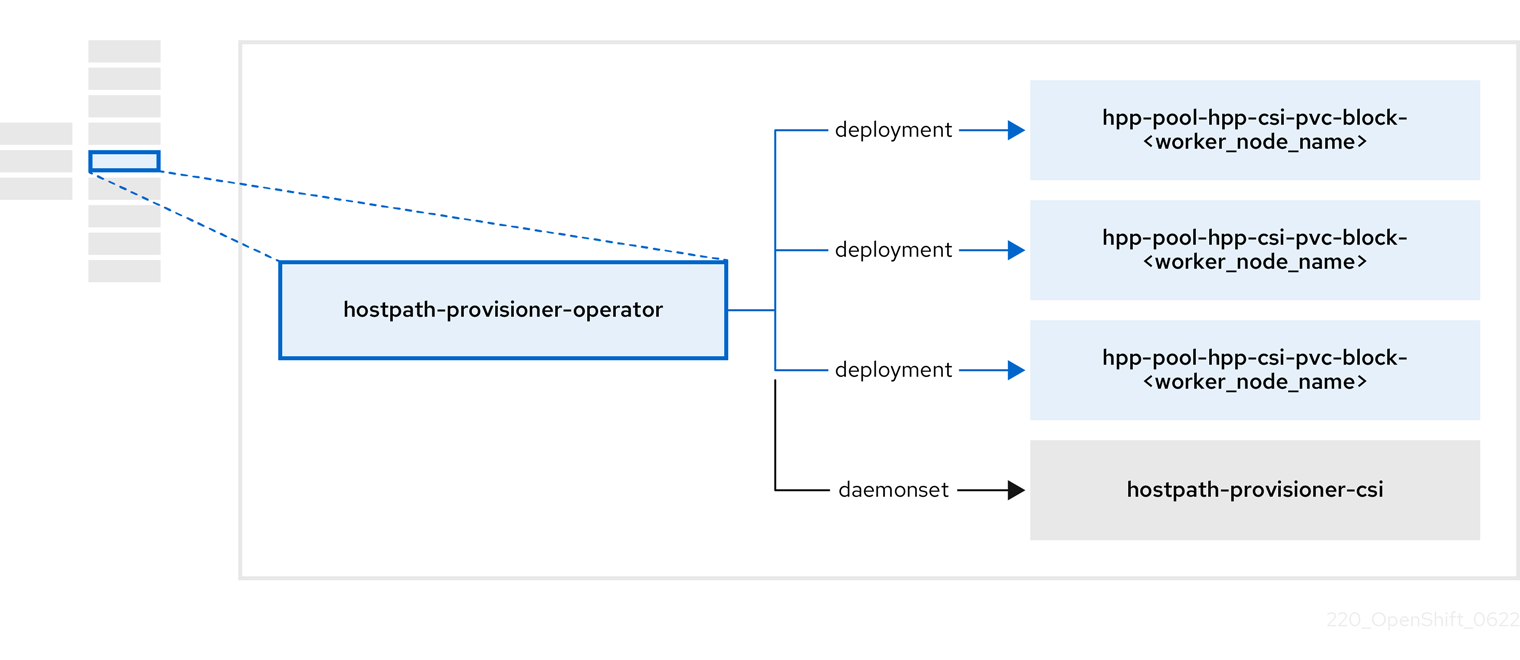

OLM 部署 Hostpath Provisioner (HPP) Operator,但在创建 hostpath-provisioner CR 前它无法正常工作。

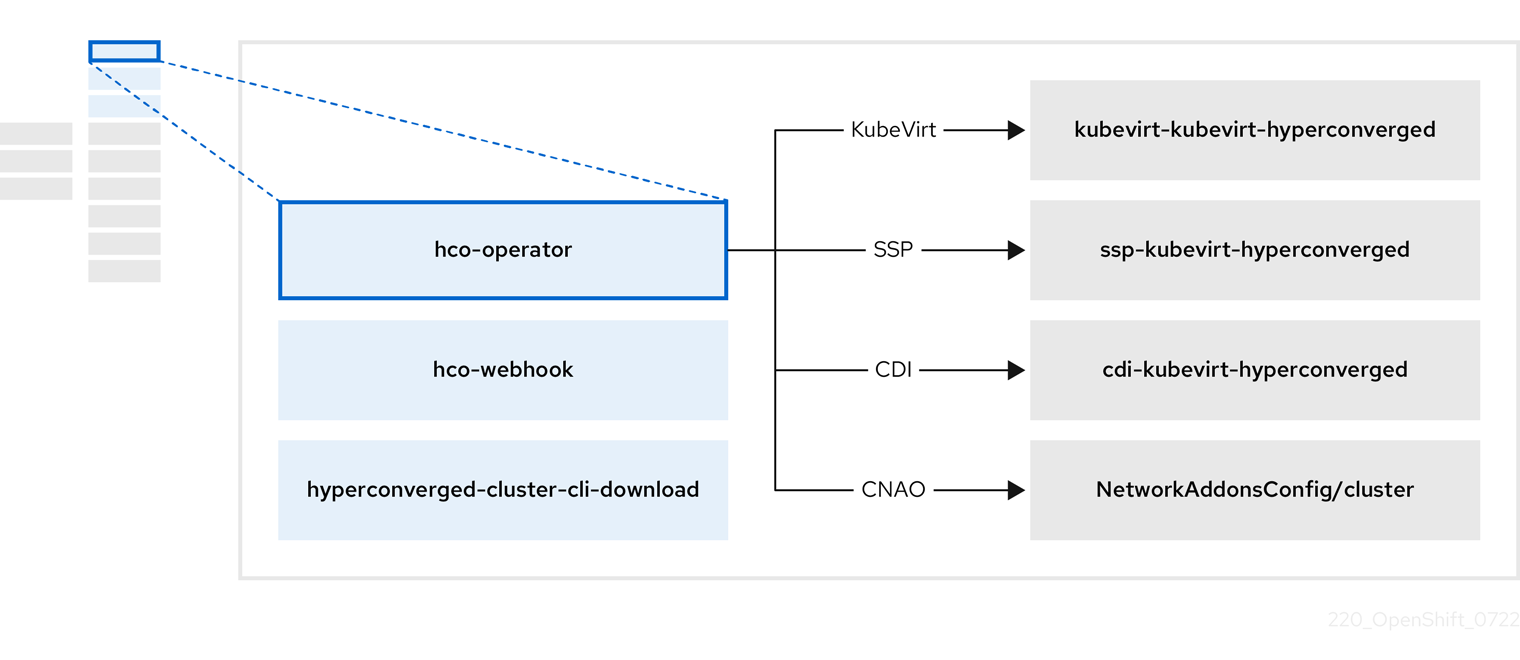

1.3.1. 关于 HyperConverged Operator (HCO)

HCO、hco-operator 提供了一种单一入口点,用于部署和管理 OpenShift Virtualization 和几个带有建议的默认值的帮助程序运算符。它还会为这些操作器创建自定义资源(CR)。

表 1.7. HyperConverged Operator 组件

| 组件 | 描述 |

|---|---|

|

|

验证 |

|

|

提供 |

|

| 包含 OpenShift Virtualization 需要的所有 operator、CR 和对象。 |

|

| 调度、扩展和性能 (SSP) CR。这由 HCO 自动创建。 |

|

| Containerized Data Importer (CDI) CR。这由 HCO 自动创建。 |

|

|

指示并由 |

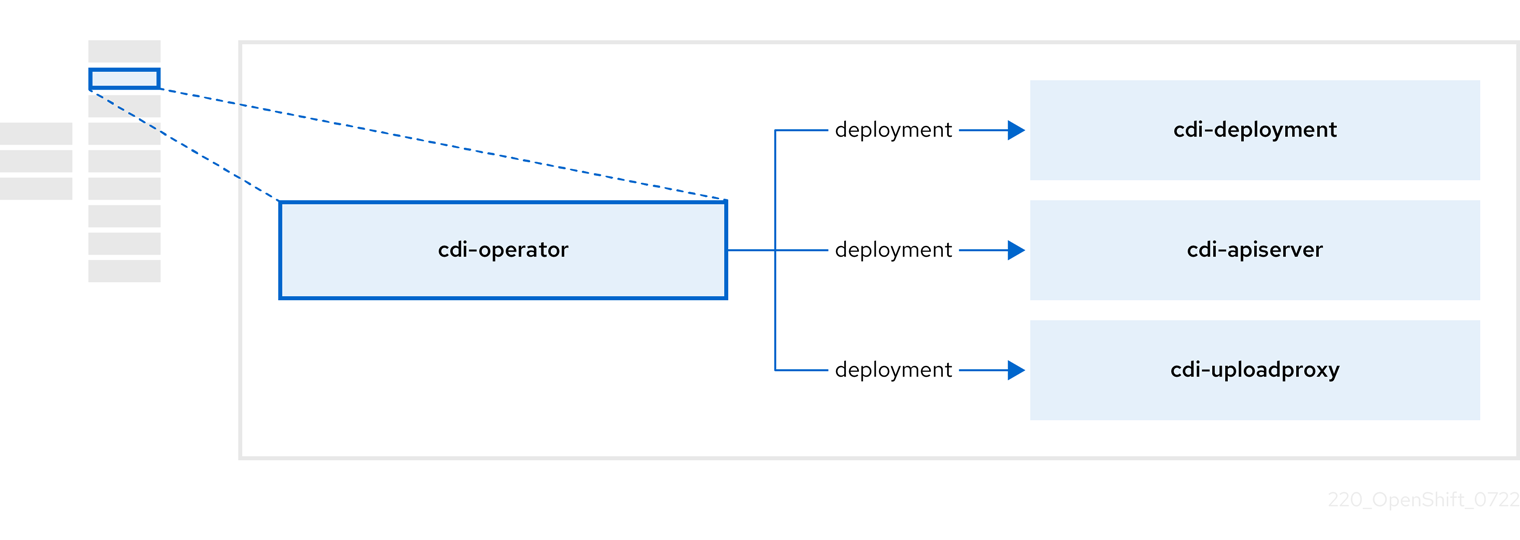

1.3.2. 关于 Containerized Data Importer (CDI) Operator

CDI Operator cdi-operator, 管理 CDI 及其相关资源,它使用数据卷将虚拟机(VM)镜像导入到持久性卷声明(PVC)中。

表 1.8. CDI Operator 组件

| 组件 | 描述 |

|---|---|

|

| 通过提供安全上传令牌来管理将虚拟机磁盘上传到 PVC 的授权过程。 |

|

| 将外部磁盘上传流量定向到适当的上传服务器 pod,以便将其写入正确的 PVC。需要有效的上传令牌。 |

|

| helper(帮助程序)Pod,在创建数据卷时将虚拟机镜像导入到 PVC 中。 |

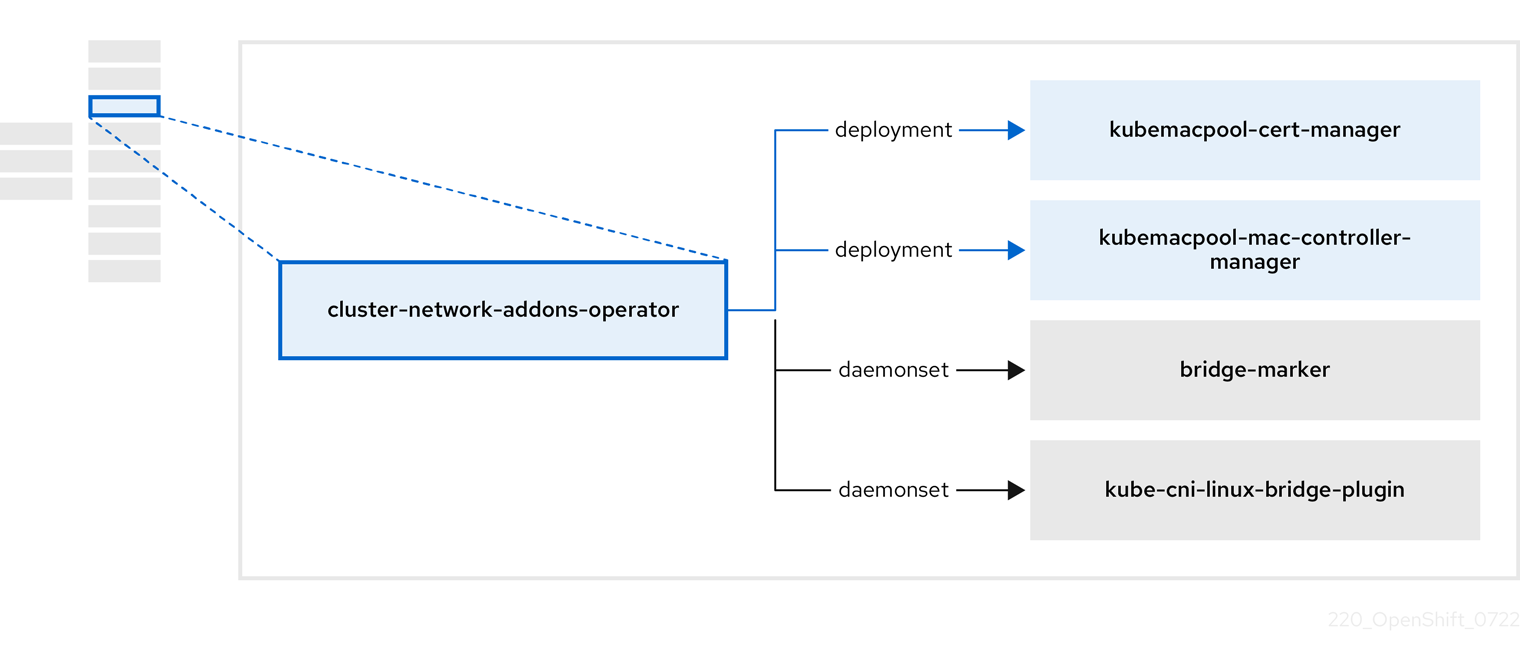

1.3.3. 关于 Cluster Network Addons Operator

Cluster Network Addons Operator cluster-network-addons-operator 在集群中部署网络组件,并管理扩展网络功能的相关资源。

表 1.9. Cluster Network Addons Operator 组件

| 组件 | 描述 |

|---|---|

|

| 管理 Kubemacpool 的 webhook 的 TLS 证书。 |

|

| 为虚拟机(VM)网络接口卡(NIC)提供 MAC 地址池服务。 |

|

| 将节点上可用的网络桥接标记为节点资源。 |

|

| 在集群节点上安装 Container Network Interface (CNI) 插件,通过网络附加定义将虚拟机附加到 Linux 网桥。 |

1.3.4. 关于 Hostpath Provisioner (HPP) Operator

HPP Operator hostpath-provisioner-operator,部署和管理多节点 HPP 和相关资源。

表 1.10. HPP Operator 组件

| 组件 | 描述 |

|---|---|

|

| 为指定 HPP 的每个节点提供一个 worker。pod 在节点上挂载指定的后备存储。 |

|

| 实现 HPP 的容器存储接口(CSI)驱动程序接口。 |

|

| 实现 HPP 的传统驱动程序接口。 |

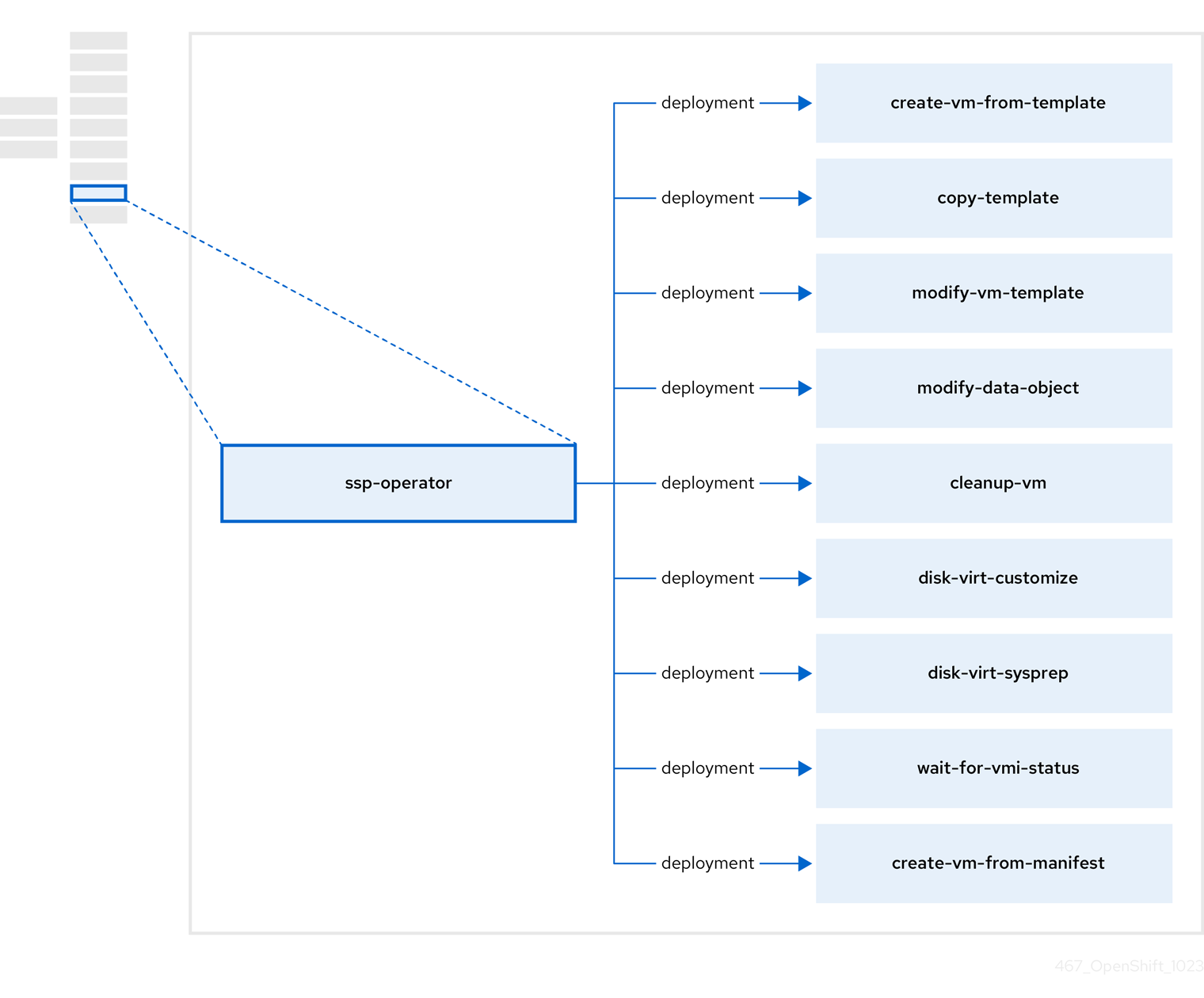

1.3.5. 关于 Scheduling、Scale 和 Performance (SSP) Operator

SSP Operator、ssp-operator、部署通用模板、相关的默认引导源、管道任务和模板验证器。

表 1.11. SSP Operator 组件

| 组件 | 描述 |

|---|---|

|

| 从模板创建虚拟机。 |

|

| 复制虚拟机模板。 |

|

| 创建和删除虚拟机模板。 |

|

| 创建和删除数据卷或数据源。 |

|

| 在虚拟机上运行脚本或命令,然后在之后停止或删除虚拟机。 |

|

|

使用 |

|

|

使用 |

|

| 等待特定的虚拟机实例(VMI)状态,然后根据该状态失败或成功。 |

|

| 从清单创建虚拟机。 |

1.3.6. 关于 OpenShift Virtualization Operator

OpenShift Virtualization Operator、virt-operator 部署、升级和管理 OpenShift Virtualization,而不影响当前虚拟机(VM)工作负载。

表 1.12. virt-operator 组件

| 组件 | 描述 |

|---|---|

|

| 用作所有与虚拟化相关的流的入口点的 HTTP API 服务器。 |

|

|

观察创建新虚拟机实例对象并创建对应的 pod。当 pod 调度到某个节点上时, |

|

|

监控对虚拟机的任何更改并指示 |

|

|

包含由 |

第 2 章 开始使用

2.1. OpenShift Virtualization 入门

您可以通过安装和配置基本环境来探索 OpenShift Virtualization 的功能和功能。

集群配置过程需要 cluster-admin 权限。

2.1.1. 规划和安装 OpenShift Virtualization

在 Red Hat OpenShift Service on AWS 集群中计划并安装 OpenShift Virtualization:

规划和安装资源

2.1.2. 创建和管理虚拟机

创建虚拟机:

您可以使用红帽模板创建虚拟机。

您可以通过从容器 registry 或网页导入自定义镜像来创建虚拟机,方法是从本地机器上传镜像,或者克隆持久性卷声明(PVC)。

将虚拟机连接到二级网络:

- 注意

默认情况下,虚拟机连接到 pod 网络。

连接到虚拟机:

管理虚拟机:

2.1.3. 后续步骤

2.2. 使用 virtctl 和 libguestfs CLI 工具

您可使用 virtctl 命令行工具管理 OpenShift Virtualization 资源。

您可以使用 libguestfs 命令行工具访问和修改虚拟机(VM)磁盘镜像。您可以使用 virtctl libguestfs 命令部署 libguestfs。

2.2.1. 安装 virtctl

要在 Red Hat Enterprise Linux (RHEL) 9、Linux、Windows 和 MacOS 操作系统上安装 virtctl,您可以下载并安装 virtctl 二进制文件。

要在 RHEL 8 上安装 virtctl,您可以启用 OpenShift Virtualization 仓库,然后安装 kubevirt-virtctl 软件包。

2.2.1.1. 在 RHEL 9、Linux、Windows 或 macOS 上安装 virtctl 二进制文件

您可以从 Red Hat OpenShift Service on AWS Web 控制台下载您的操作系统的 virtctl 二进制文件,然后安装它。

流程

- 在 web 控制台中进入到 Virtualization → Overview 页面。

-

点 Download virtctl 链接为您的操作系统下载

virtctl二进制文件。 安装

virtctl:对于 RHEL 9 和其他 Linux 操作系统:

解压缩存档文件:

$ tar -xvf <virtctl-version-distribution.arch>.tar.gz

运行以下命令使

virtctl二进制可执行文件:$ chmod +x <path/virtctl-file-name>

将

virtctl二进制文件移到PATH环境变量中的目录中。您可以运行以下命令来检查您的路径:

$ echo $PATH

设置

KUBECONFIG环境变量:$ export KUBECONFIG=/home/<user>/clusters/current/auth/kubeconfig

对于 Windows:

- 解压缩存档文件。

-

进入解压的目录中,双击

virtctl可执行文件来安装客户端。 将

virtctl二进制文件移到PATH环境变量中的目录中。您可以运行以下命令来检查您的路径:

C:\> path

macOS:

- 解压缩存档文件。

将

virtctl二进制文件移到PATH环境变量中的目录中。您可以运行以下命令来检查您的路径:

echo $PATH

2.2.1.2. 在 RHEL 8 上安装 virtctl RPM

您可以通过启用 OpenShift Virtualization 仓库并安装 kubevirt-virtctl 软件包,在 Red Hat Enterprise Linux (RHEL) 8 上安装 virtctl RPM 软件包。

先决条件

- 集群中的每个主机都必须通过 Red Hat Subscription Manager (RHSM)注册,并具有有效的 Red Hat OpenShift Service on AWS 订阅。

流程

使用

subscription-managerCLI 工具启用 OpenShift Virtualization 存储库,以运行以下命令:# subscription-manager repos --enable cnv-4.15-for-rhel-8-x86_64-rpms

运行以下命令安装

kubevirt-virtctl软件包:# yum install kubevirt-virtctl

2.2.2. virtctl 命令

virtctl 客户端是用于管理 OpenShift Virtualization 资源的命令行实用程序。

除非另有指定,否则虚拟机(VM)命令也适用于虚拟机实例(VMI)。

2.2.2.1. virtctl 信息命令

您可使用 virtctl 信息命令查看 virtctl 客户端的信息。

表 2.1. 信息命令

| 命令 | 描述 |

|---|---|

|

|

查看 |

|

|

查看 |

|

| 查看特定命令的选项列表。 |

|

|

查看任何 |

2.2.2.2. VM 信息命令

您可使用 virtctl 查看有关虚拟机(VM)和虚拟机实例(VMI)的信息。

表 2.2. VM 信息命令

| 命令 | 描述 |

|---|---|

|

| 查看客户机机器上可用的文件系统。 |

|

| 查看客户机机器上操作系统的信息。 |

|

| 查看客户机机器上的登录用户。 |

2.2.2.3. VM 清单创建命令

您可使用 virtctl create 命令为虚拟机、实例类型和首选项创建清单。

表 2.3. VM 清单创建命令

| 命令 | 描述 |

|---|---|

|

创建 |

|

| 创建虚拟机清单,指定虚拟机的名称。 |

|

| 创建使用现有集群范围实例类型的虚拟机清单。 |

|

| 创建使用现有命名空间的实例类型的虚拟机清单。 |

|

| 为集群范围的实例类型创建清单。 |

|

| 为命名空间实例类型创建清单。 |

|

| 为集群范围的虚拟机首选项创建清单,为首选项指定一个名称。 |

|

| 为命名空间虚拟机首选项创建清单。 |

2.2.2.4. VM 管理命令

您可使用 virtctl 虚拟机(VM)管理命令管理和迁移虚拟机(VM)和虚拟机实例(VMI)。

表 2.4. VM 管理命令

| 命令 | 描述 |

|---|---|

|

| 启动虚拟机。 |

|

| 以暂停状态启动虚拟机。这个选项可让您从 VNC 控制台中断引导过程。 |

|

| 停止虚拟机。 |

|

| 强制停止虚拟机。这个选项可能会导致数据不一致或数据丢失。 |

|

| 暂停虚拟机。机器状态保存在内存中。 |

|

| 取消暂停虚拟机。 |

|

| 迁移虚拟机。 |

|

| 取消虚拟机迁移。 |

|

| 重启虚拟机。 |

2.2.2.5. VM 连接命令

您可使用 virtctl connection 命令来公开端口并连接到虚拟机(VM)和虚拟机实例(VMI)。

表 2.5. VM 连接命令

| 命令 | 描述 |

|---|---|

|

| 连接到虚拟机的串行控制台。 |

|

| 创建转发虚拟机的指定端口的服务,并在节点的指定端口上公开服务。

示例: |

|

| 将文件从机器复制到虚拟机。此命令使用 SSH 密钥对的私钥。虚拟机必须配置有公钥。 |

|

| 将文件从虚拟机复制到您的机器中。此命令使用 SSH 密钥对的私钥。虚拟机必须配置有公钥。 |

|

| 与虚拟机打开 SSH 连接。此命令使用 SSH 密钥对的私钥。虚拟机必须配置有公钥。 |

|

| 连接到虚拟机的 VNC 控制台。

已安装 |

|

| 显示端口号,并使用任何查看器通过 VNC 连接手动连接到 VMI。 |

|

| 如果该端口可用,则指定端口号用于在指定端口上运行代理。 如果没有指定端口号,代理会在随机端口上运行。 |

2.2.2.6. VM 导出命令

使用 virtctl vmexport 命令来创建、下载或删除从虚拟机、虚拟机快照或持久性卷声明 (PVC) 导出的卷。某些清单还包含标头 secret,它授予对端点的访问权限,以 OpenShift Virtualization 可以使用的格式导入磁盘镜像。

表 2.6. VM 导出命令

| 命令 | 描述 |

|---|---|

|

|

创建一个

|

|

|

手动删除 |

|

|

下载在

可选:

|

|

|

创建一个 |

|

| 检索一个现有导出的清单。清单不包括标头 secret。 |

|

| 为虚拟机创建虚拟机导出,并检索清单。清单不包括标头 secret。 |

|

| 为虚拟机快照示例创建虚拟机导出,并检索清单。清单不包括标头 secret。 |

|

| 检索一个现有导出的清单。清单包括标头 secret。 |

|

| 以 json 格式检索现有导出的清单。清单不包括标头 secret。 |

|

| 检索一个现有导出的清单。清单包括标头 secret,并将其写入指定的文件中。 |

2.2.2.7. VM 内存转储命令

您可使用 virtctl memory-dump 命令在 PVC 上输出虚拟机 (VM) 内存转储。您可以指定现有的 PVC,或使用 --create-claim 标志来创建新 PVC。

先决条件

-

PVC 卷模式必须是

FileSystem。 PVC 必须足够大以保存内存转储。

计算 PVC 大小的公式为

(VMMemorySize + 100Mi)* FileSystemOverhead,其中100Mi是内存转储开销。您必须运行以下命令来在

HyperConverged自定义资源中启用热插功能:$ oc patch hyperconverged kubevirt-hyperconverged -n openshift-cnv \ --type json -p '[{"op": "add", "path": "/spec/featureGates", \ "value": "HotplugVolumes"}]'

下载内存转储

您必须使用 virtctl vmexport download 命令下载内存转储:

$ virtctl vmexport download <vmexport_name> --vm|pvc=<object_name> \ --volume=<volume_name> --output=<output_file>

表 2.7. VM 内存转储命令

| 命令 | 描述 |

|---|---|

|

|

在 PVC 上保存虚拟机的内存转储。内存转储状态显示在 可选:

|

|

|

使用相同的 PVC 重新运行 这个命令覆盖以前的内存转储。 |

|

| 删除内存转储。 如果要更改目标 PVC,则必须手动删除内存转储。

这个命令会删除虚拟机和 PVC 之间的关联,以便在 |

2.2.2.8. 热插和热拔命令

您可使用 virtctl 从正在运行的虚拟机(VM)和虚拟机实例(VMI)中添加或删除资源。

表 2.8. 热插和热拔命令

| 命令 | 描述 |

|---|---|

|

| 热插数据卷或持久性卷声明 (PVC)。 可选:

|

|

| 热拔虚拟磁盘。 |

|

| 热插 Linux 网桥网络接口。 |

|

| 热拔 Linux 网桥网络接口。 |

2.2.2.9. 镜像上传命令

您可使用 virtctl image-upload 命令将虚拟机镜像上传到数据卷中。

表 2.9. 镜像上传命令

| 命令 | 描述 |

|---|---|

|

| 将虚拟机镜像上传到已存在的数据卷中。 |

|

| 将虚拟机镜像上传到指定请求大小的新数据卷中。 |

2.2.3. 使用 virtctl 部署 libguestfs

您可以使用 virtctl guestfs 命令部署带有 libguestfs-tools 以及附加到它的持久性卷声明 (PVC) 的交互式容器。

流程

要部署一个带有

libguestfs-tools的容器,挂载 PVC 并为其附加一个 shell,运行以下命令:$ virtctl guestfs -n <namespace> <pvc_name> 1- 1

- PVC 名称是必需的参数。如果没有包括它,则会出现错误消息。

2.2.3.1. libguestfs 和 virtctl guestfs 命令

libguestfs 工具可帮助您访问和修改虚拟机 (VM) 磁盘镜像。您可以使用 libguestfs 工具查看和编辑客户机中的文件、克隆和构建虚拟机,以及格式化和调整磁盘大小。

您还可以使用 virtctl guestfs 命令及其子命令在 PVC 上修改、检查和调试虚拟机磁盘。要查看可能子命令的完整列表,请在命令行中输入 virt- 并按 Tab 键。例如:

| 命令 | 描述 |

|---|---|

|

| 在终端中以交互方式编辑文件。 |

|

| 将 ssh 密钥注入客户系统并创建登录。 |

|

| 查看虚拟机使用了多少磁盘空间。 |

|

| 通过创建包含完整列表的输出文件,查看虚拟客户机上安装的所有 RPM 的完整列表。 |

|

|

在终端中使用 |

|

| 封装要用作模板的虚拟机磁盘镜像。 |

默认情况下,virtctl guestfs 会创建一个会话,其中包含管理 VM 磁盘所需的一切内容。但是,如果想要自定义行为,该命令还支持几个标志选项:

| 标记选项 | 描述 |

|---|---|

|

|

为 |

|

带有 | 使用特定命名空间中的 PVC。

如果不使用

如果没有包括 |

|

|

列出

您可以使用 |

|

|

代表

默认情况下,

如果群集没有任何

如果没有设置, |

|

|

显示

您还可以通过设置 |

这个命令还会检查 PVC 是否被另一个 pod 使用,这时会出现错误消息。但是,libguestfs-tools 进程启动后,设置无法避免使用相同的 PVC 的新 pod。在启动虚拟机访问同一 PVC 前,您必须先验证没有活跃的 virtctl guestfs pod。

virtctl guestfs 命令只接受附加到交互式 pod 的单个 PVC。

2.3. Web 控制台概述

Red Hat OpenShift Service on AWS Web 控制台的 Virtualization 部分包含以下页面来管理和监控 OpenShift Virtualization 环境。

表 2.10. 虚拟化 页面

| 页面 | 描述 |

|---|---|

| 管理和监控 OpenShift Virtualization 环境。 | |

| 从模板目录创建虚拟机。 | |

| 创建和管理虚拟机。 | |

| 创建和管理模板。 | |

| 创建和管理虚拟机实例类型。 | |

| 创建和管理虚拟机首选项。 | |

| 为可引导卷创建和管理数据源。 | |

| 创建和管理工作负载的迁移策略。 | |

| 为虚拟机运行网络延迟和存储检查。 |

表 2.11. 键

| 图标 | 描述 |

|---|---|

|

| 编辑图标 |

|

| 链接图标 |

|

| 启动虚拟机图标 |

|

| 停止虚拟机图标 |

|

| 重启虚拟机图标 |

|

| 暂停虚拟机图标 |

|

| 取消暂停虚拟机图标 |

2.3.1. 概述页面

Overview 页面显示资源、指标、迁移进度和集群级别设置。

例 2.1. 概述页面

| 元素 | 描述 |

|---|---|

|

下载 virtctl |

下载 |

| 资源、使用、警报和状态. | |

| CPU、内存和存储资源的主要消费者。 | |

| 实时迁移状态。 | |

| Settings 选项卡包含 Cluster 标签页、User 选项卡和 Preview features 选项卡。 | |

| Settings → Cluster 标签页 | OpenShift Virtualization 版本、更新状态、实时迁移、模板项目、负载均衡器服务、客户机管理、资源管理和 SCSI 持久保留设置。 |

| Settings → User 标签页 | 公共 SSH 密钥、用户权限和欢迎信息设置。 |

| Settings → Preview features | 在 web 控制台中启用选择 预览功能。此选项卡中的功能会频繁变化。 预览功能默认是禁用的,不得在生产环境中启用。 |

2.3.1.1. 概述标签

Overview 选项卡显示资源、使用情况、警报和状态。

例 2.2. 概述标签页

| 元素 | 描述 |

|---|---|

| 入门资源卡 |

|

| 内存标题 | 内存用量,图表显示最后 1 天的趋势。 |

| 存储标题 | 存储使用,图表显示最后 1 天的趋势。 |

| vCPU 使用标题 | vCPU 使用量,图表显示最后 1 天的趋势。 |

| VirtualMachines 标题 | 虚拟机数量,图表显示最后 1 天的趋势。 |

| 警报标题 | OpenShift Virtualization 警报,按严重性分组。 |

| VirtualMachine 状态标题 | 虚拟机数量,按状态分组。 |

| 每个资源的 VirtualMachines 图表 | 从模板和实例类型创建的虚拟机数量。 |

2.3.1.2. 顶级消费者选项卡

Top consumers 选项卡显示 CPU、内存和存储的主要使用者。

例 2.3. 顶级消费者选项卡

| 元素 | 描述 |

|---|---|

|

查看虚拟化仪表板 | 指向 Observe → Dashboards,显示 OpenShift Virtualization 的顶部用户。 |

| 时间周期列表 | 选择过滤结果的时间周期。 |

| 顶级消费者列表 | 选择顶级消费者的数量来过滤结果。 |

| CPU chart | CPU 使用率最高的虚拟机。 |

| 内存图表 | 内存用量最高的虚拟机。 |

| 内存交换流量图表 | 内存交换流量最高的虚拟机。 |

| vCPU 等待图表 | 具有最高 vCPU 等待期的虚拟机。 |

| 存储吞吐量图表 | 具有最高存储吞吐量使用的虚拟机。 |

| 存储 IOPS图表 | 具有最高每秒使用存储输入/输出操作的虚拟机。 |

2.3.1.3. Migration 标签页

Migrations 选项卡显示虚拟机迁移的状态。

例 2.4. Migration 标签页

| 元素 | 描述 |

|---|---|

| 时间周期列表 | 选择一个时间段来过滤虚拟机迁移。 |

| VirtualMachineInstanceMigrations 信息表 | 虚拟机迁移列表。 |

2.3.1.4. 设置标签页

Settings 选项卡显示集群范围的设置。

例 2.5. Settings 标签卡中的标签页

| 标签页 | 描述 |

|---|---|

| OpenShift Virtualization 版本、更新状态、实时迁移、模板项目、负载均衡器服务、客户机管理、资源管理和 SCSI 持久保留设置。 | |

| 公共 SSH 密钥管理、用户权限和欢迎信息设置。 | |

| 在 web 控制台中启用选择 预览功能。这些功能经常改变。 |

2.3.1.4.1. 集群标签页

Cluster 选项卡显示 OpenShift Virtualization 版本和更新状态。您可以在 Cluster 标签页中配置实时迁移和其他设置。

例 2.6. 集群 标签页

| 元素 | 描述 |

|---|---|

| 已安装的版本 | OpenShift Virtualization 版本。 |

| 更新状态 | OpenShift Virtualization 更新状态。 |

| Channel | OpenShift Virtualization 更新频道。 |

| 常规设置部分 | 展开本节,以配置 实时迁移 设置、SSH 配置设置 和 Template 项目 设置。 |

| 常规设置 → 实时迁移 部分 | 展开本节以配置实时迁移设置。 |

| General Settings → Live Migration → Max. migration per cluster 字段 | 选择每个集群的最大实时迁移数量。 |

| General Settings → Live Migration → Max. migration per node 字段 | 选择每个节点的最大实时迁移数量。 |

| General Settings → Live Migration → Live migration network 列表 | 为实时迁移选择专用的二级网络。 |

| 常规设置 → SSH Configuration → SSH over LoadBalancer 服务 开关 | 启用为虚拟机的 SSH 连接创建 LoadBalancer 服务。 您必须配置负载均衡器。 |

| 常规设置 → SSH Configuration → SSH over NodePort 服务 开关 | 允许为与虚拟机进行 SSH 连接创建节点端口服务。 |

| 常规设置 → Template 项目 部分 |

展开此部分,为红帽模板选择项目。默认项目为 要将红帽模板存储在多个项目中,请 克隆模板,然后选择克隆的模板的项目。 |

| 客户机管理 | 展开这个部分,以配置 Automatic subscription of new RHEL VirtualMachines 设置和 Enable guest system log access 开关。 |

| Guest Management → Automatic subscription of new RHEL VirtualMachines | 展开这个部分,以便为 Red Hat Enterprise Linux (RHEL) 虚拟机和客户机系统日志访问启用自动订阅。 要启用此功能,您需要集群管理员权限、机构 ID 和激活码。 |

| Guest Management → Automatic subscription of new RHEL VirtualMachines → Activation Key 字段 | 输入激活码。 |

| Guest Management → Automatic subscription of new RHEL VirtualMachines → Organization ID 字段 | 输入机构 ID。 |

| Guest Management → Automatic subscription of new RHEL VirtualMachines → Enable auto updates for RHEL VirtualMachines 开关 | 启用从 RHEL 存储库自动拉取更新。 要启用此功能,您需要一个激活码和机构 ID。 |

| Guest Management → Enable guest system log access 开关 | 启用对虚拟机的客户机系统日志的访问。 |

| 资源管理 | 展开本节,以配置 Auto-compute CPU 限制 设置和 内核同页合并(KSM) 开关。 |

| Resource Management → Auto-compute CPU limits | 对包含标签的项目启用自动计算 CPU 限制。 |

| Resource Management → Kernel Samepage Merging (KSM) | 为集群中的所有节点启用 KSM。 |

| SCSI Persistent Reservation | 展开这个部分,以配置 Enable persistent reserved 开关。 |

| SCSI Persistent Reservation → Enable persistent reservation | 为磁盘启用 SCSI 保留。这个选项必须仅用于集群感知应用程序。 |

2.3.1.4.2. 用户标签页

您查看用户权限并管理公共 SSH 密钥,并在 User 选项卡上查看欢迎信息。

例 2.7. 用户 标签页

| 元素 | 描述 |

|---|---|

| 管理 SSH 密钥 部分 | 展开本节,将公共 SSH 密钥添加到项目中。 密钥会自动添加到您随后在所选项目中创建的所有虚拟机。 |

| 权限 部分 | 展开本节以查看集群范围的用户权限。 |

| 欢迎信息 部分 | 展开此部分,以显示或隐藏 欢迎信息 对话框。 |

2.3.1.4.3. 技术预览功能标签页

在 web 控制台中启用选择 预览功能。此选项卡中的功能会频繁变化。

2.3.2. 目录页面

您可以从 Catalog 页面中的模板或实例类型创建虚拟机。

例 2.8. 目录 页面

| 元素 | 描述 |

|---|---|

| 显示用于创建虚拟机的可引导卷和实例类型。 | |

| 显示用于创建虚拟机的模板目录。 |

2.3.2.1. Instancetypes 标签页

您可以从 InstanceTypes 选项卡上的实例类型创建虚拟机。

| 元素 | 描述 |

|---|---|

| 添加卷 按钮 | 点击来上传卷或使用现有的持久性卷声明、卷快照或数据源。 |

| volumes 项目 字段 |

存储可引导卷的项目。默认值为 |

| Filter 字段 | 按操作系统或资源过滤引导源。 |

| 搜索字段 | 按名称搜索引导源。 |

| 管理列 图标 | 选择要在表中显示 9 列。 |

| 卷表 | 为您的虚拟机选择一个可引导卷。 |

| Red Hat provided 标签页 | 选择红帽提供的实例类型。 |

| 用户提供的标签页 | 选择在 InstanceType 页面中创建的实例类型。 |

| VirtualMachine 详情 窗格 | 显示虚拟机设置。 |

| Name 字段 | 可选:输入虚拟机名称。 |

| Storage class 字段 | 选择存储类。 |

| 公共 SSH 密钥 | 点编辑图标添加新或现有公共 SSH 密钥。 |

| 动态 SSH 密钥注入开关 | 启用动态 SSH 密钥注入。 只有 RHEL 支持动态 SSH 密钥注入。 |

| Start this VirtualMachine after creation 复选框 | 清除此复选框以防止虚拟机自动启动。 |

| 创建 VirtualMachine 按钮 | 创建虚拟机。 |

| View YAML & CLI 按钮 |

显示 YAML 配置文件和 |

2.3.2.2. 模板目录标签页

您可以在 Template catalog 选项卡中选择一个模板来创建虚拟机。

例 2.9. 模板目录 标签页

| 元素 | 描述 |

|---|---|

| 模板项目列表 | 选择红帽模板所在的项目。

默认情况下,红帽模板存储在 |

| All items | Default templates | User templates | 点 All items 以显示所有可用的模板、默认模板,以显示默认模板和 用户模板,以显示用户创建的模板。 |

| Boot source available 复选框 | 选中复选框以显示带有可用引导源的模板。 |

| 操作系统 复选框 | 选中复选框以显示带有所选操作系统的模板。 |

| 工作负载 复选框 | 选中复选框以显示带有所选工作负载的模板。 |

| 搜索字段 | 按关键字搜索模板。 |

| 模板标题 | 点模板标题查看模板详情并创建虚拟机。 |

2.3.3. VirtualMachines 页面

您可以在 VirtualMachines 页面中创建和管理虚拟机。

例 2.10. VirtualMachines 页面

| 元素 | 描述 |

|---|---|

| 创建 按钮 | 从模板、卷或 YAML 配置文件创建虚拟机。 |

| Filter 字段 | 根据状态、模板、操作系统或节点过滤虚拟机。 |

| 搜索字段 | 根据名称、标签或 IP 地址搜索虚拟机。 |

| 管理列 图标 | 选择要在表中显示 9 列。只有在从 Projects 列表中选择 All Projects 时,才会显示 Namespace 列。 |

| 虚拟机表 | 虚拟机列表。

点虚拟机旁边的操作菜单

点虚拟机进入 VirtualMachine 详情页。 |

2.3.3.1. VirtualMachine 详情页面

您可以在 VirtualMachine 详情页面的 Configuration 选项卡中配置虚拟机。

例 2.11. VirtualMachine 详情页

| 元素 | 描述 |

|---|---|

| 操作菜单 | 点 Actions 菜单,选择 Stop, Restart, Pause, Clone, Migrate, Copy SSH command, Edit labels, Edit annotations, 或 Delete。如果选择 Stop,则强制停止 在操作菜单中选择 Stop。如果操作系统变得无响应,请使用 Force stop 启动即时关闭。 |

| 资源使用情况、警报、磁盘和设备。 | |

| 内存、CPU、存储、网络和迁移指标。 | |

| 虚拟机 YAML 配置文件。 | |

| 包括 Details, Storage, Network, Scheduling, SSH, Initial run, 和 Metadata 标签页。 | |

| 配置虚拟机的 VirtualMachine 详情。 | |

| 配置虚拟机的存储。 | |

| 配置网络。 | |

| 将虚拟机的调度配置为在特定节点上运行。 | |

| 配置虚拟机的 SSH 设置。 | |

| 为虚拟机配置 cloud-init 设置,如果虚拟机是 Windows,则为 Sysprep 设置。 | |

| 配置虚拟机的标签和注解元数据。 | |

| 查看虚拟机事件列表。 | |

| 打开虚拟机的控制台会话。 | |

| 创建快照并从快照恢复虚拟机。 | |

| 查看状态条件和卷快照状态。 |

2.3.3.1.1. 概述标签

Overview 选项卡显示资源使用情况、警报和配置信息。

例 2.12. 概述标签页

| 元素 | 描述 |

|---|---|

| 详情标题 | 常规虚拟机信息。 |

| 使用标题 | CPU, Memory, Storage, 和 Network transfer 图。默认情况下,Network transfer 显示所有网络的总和。要查看特定网络的分类,请点 Breakdown by network。 |

| 硬件设备标题 | GPU 和主机设备。 |

| 文件系统标题 | 文件系统信息。 此信息由客户机代理提供。 |

| Services 标题 | 服务列表。 |

| 活跃用户标题 | 活跃用户列表。 |

| 警报标题 | OpenShift Virtualization 警报,按严重性分组。 |

| 常规 标题 | 命名空间、节点、VirtualMachineInstance、Pod 和 Owner 信息。 |

| 快照标题 |

进行快照 |

| 网络接口标题 | 网络接口表。 |

| 磁盘标题 | 磁盘表。 |

2.3.3.1.2. Metrics 标签页

Metrics 选项卡显示内存、CPU、网络、存储和迁移使用图表,以及实时迁移进度。

例 2.13. Metrics 标签页

| 元素 | 描述 |

|---|---|

| 时间范围列表 | 选择一个时间范围来过滤结果。 |

|

虚拟化仪表板 | 链接到当前项目的 Workloads 选项卡。 |

| 使用率 | 内存和CPU 图表。 |

| 存储 | 存储总读/写和存储 IOPS 总读/写图表 |

| Network | Network in,Network out,Network bandwidth, 和 Network interface 图表。从 Network interface 列表中选择 All networks 或一个特定的网络。 |

| Migration(迁移) | Migration 和 KV data transfer rate 图。 |

| LiveMigration 进度 | LiveMigration 完成状态。 |

2.3.3.1.3. YAML 标签页

您可以通过编辑 YAML 选项卡上的 YAML 文件来配置虚拟机。

例 2.14. YAML 标签页

| 元素 | 描述 |

|---|---|

| 保存按钮 | 保存对 YAML 文件的更改。 |

| 重新加载按钮 | 丢弃您的更改并重新载入 YAML 文件。 |

| 取消 按钮 | 退出 YAML 选项卡。 |

| 下载 按钮 | 将 YAML 文件下载到您的本地计算机。 |

2.3.3.1.4. 配置标签页

您可以在 Configuration 选项卡中配置调度、网络接口、磁盘和其他选项。

例 2.15. Configuration 选项卡上的标签页

2.3.3.1.4.1. 详情标签页

您可以在 Details 标签页中管理虚拟机详情。

例 2.16. 详情标签页

| 设置 | 描述 |

|---|---|

| 描述 | 点编辑图标,以输入描述。 |

| Workload 配置集 | 点编辑图标编辑工作负载配置集。 |

| CPU | 内存 | 点编辑图标编辑 CPU | Memory 请求。重启虚拟机以应用更改。 |

| 主机名 | 虚拟机的主机名。重启虚拟机以应用更改。 |

| 无头模式 | 启用无头模式。重启虚拟机以应用更改。 |

| 客户端系统日志访问 | 启用客户端系统日志访问。 |

| 硬件设备 | 管理 GPU 和主机设备。 |

| 引导管理 | 更改引导模式和顺序,并在暂停模式中启用 Start。 |

2.3.3.1.4.2. 存储选项卡

您可以在 Storage 选项卡中管理虚拟机的磁盘和环境。

例 2.17. 存储 标签页

| 设置 | 描述 |

|---|---|

| 添加磁盘按钮 | 为虚拟机添加一个磁盘。 |

| Filter 字段 | 按磁盘类型过滤。 |

| 搜索字段 | 按名称搜索磁盘。 |

| 挂载 Windows 驱动程序磁盘 复选框 |

选择将 |

| 磁盘表 | 虚拟机磁盘列表。

点磁盘旁的操作菜单

|

| 添加配置映射、Secret 或服务帐户 | 点链接,然后从资源列表中选择配置映射、secret 或服务帐户。 |

2.3.3.1.4.3. 网络标签页

您可以在 Network 标签页中管理网络接口。

例 2.18. 网络接口表

| 设置 | 描述 |

|---|---|

| 添加网络接口按钮 | 将网络接口添加到虚拟机。 |

| Filter 字段 | 按接口类型过滤。 |

| 搜索字段 | 根据名称或标签搜索网络接口。 |

| 网络接口表 | 网络接口列表。

点网络接口

|

2.3.3.1.4.4. 调度标签

您可以将虚拟机配置为在 Scheduling 选项卡上的特定节点上运行。

重启虚拟机以应用更改。

例 2.19. 调度 标签页

| 设置 | 描述 |

|---|---|

| 节点选择器 | 点编辑图标添加标签来指定合格节点。 |

| 容限(Tolerations) | 点编辑图标,以添加容限来指定合格节点。 |

| 关联性规则 | 点编辑图标来添加关联性规则。 |

| Descheduler 交换机 | 启用或禁用 descheduler。descheduler 驱除正在运行的 pod,以便可将 pod 重新调度到更合适的节点上。 如果虚拟机无法实时迁移,则此字段被禁用。 |

| 专用资源 | 点编辑图标,选择 Schedule this workload with dedicated resources (guaranteed policy)。 |

| 驱除策略 | 点编辑图标选择 LiveMigrate 作为虚拟机驱除策略。 |

2.3.3.1.4.5. SSH 标签页

您可以在 SSH 标签页中配置 SSH 详情。

例 2.20. SSH 标签页

| 设置 | 描述 |

|---|---|

| SSH 访问 部分 | 展开此部分配置 SSH using virtctl 和 SSH service type。 |

| 公共 SSH 密钥部分 | 展开本节,以配置公共 SSH 密钥和动态 SSH 公钥注入。 |

2.3.3.1.4.6. 初始运行

您可以在 Initial run 选项卡上管理 cloud-init 设置或为 Windows 虚拟机配置 Sysprep。

重启虚拟机以应用更改。

例 2.21. 初始运行标签页

| 元素 | 描述 |

|---|---|

| Cloud-init | 点编辑图标来编辑 cloud-init 设置。 |

| Sysprep |

点编辑图标上传 |

2.3.3.1.4.7. 元数据标签页

您可以在 Metadata 选项卡中配置标签和注解。

例 2.22. 元数据标签页

| 元素 | 描述 |

|---|---|

| 标签 | 点编辑图标管理您的标签。 |

| 注解 | 点编辑图标来管理注解。 |

2.3.3.1.5. Events 标签页

Events 选项卡显示虚拟机事件列表。

2.3.3.1.6. 控制台标签页

您可以在 Console 选项卡中打开到虚拟机的控制台会话。

例 2.23. 控制台 标签页

| 元素 | 描述 |

|---|---|

| 客户机登录凭证部分 |

展开 Guest login credentials 以查看使用 |

| 控制台列表 | 选择 VNC console 或 Serial console。 Desktop viewer 选项为 Windows 虚拟机显示。您必须在同一网络的机器上安装 RDP 客户端。 |

| send key 列表 | 选择要发送到控制台的键组合。 |

| 粘贴 按钮 | 将剪贴板中的字符串粘贴到 VNC 控制台。 |

| Disconnect 按钮 | 断开控制台连接。 如果您打开新的控制台会话,则必须手动断开控制台连接。否则,第一个控制台会话会在后台继续运行。 |

2.3.3.1.7. 快照选项卡

您可以创建一个快照,从快照创建虚拟机的副本,恢复快照、编辑标签或注解,并在 Snapshots 选项卡上编辑或删除卷快照。

例 2.24. 快照 标签页

| 元素 | 描述 |

|---|---|

| 创建快照按钮 | 创建快照。 |

| Filter 字段 | 根据状态过滤快照。 |

| 搜索字段 | 根据名称或标签搜索快照。 |

| 快照表 | 快照列表 点快照名称编辑标签或注解。

点快照旁的操作菜单

|

2.3.3.1.8. 诊断标签页

您可以在 Diagnostics 选项卡中查看状态条件和卷快照状态。

例 2.25. 诊断 标签页

| 元素 | 描述 |

|---|---|

| 状态条件表 | 显示为虚拟机报告的条件列表。 |

| Filter 字段 | 根据类别和条件过滤状态条件。 |

| 搜索字段 | 按原因搜索状态条件。 |

| 管理列 图标 | 选择要在表中显示 9 列。 |

| 卷快照状态 表 | 卷列表、其快照启用状态和原因。 |

| DataVolume 状态表 | 数据卷及其 Phase 和 Progress 值列表。 |

2.3.4. 模板页

您可以在 VirtualMachine Templates 页面中创建、编辑和克隆虚拟机模板。

您不能编辑红帽模板。但是,您可以克隆红帽模板并编辑它以创建自定义模板。

例 2.26. VirtualMachine Templates 页面

| 元素 | 描述 |

|---|---|

| 创建模板按钮 | 通过编辑 YAML 配置文件创建模板。 |

| Filter 字段 | 根据类型、引导源、模板供应商或操作系统过滤模板。 |

| 搜索字段 | 根据名称或标签搜索模板。 |

| 管理列 图标 | 选择要在表中显示 9 列。只有在从 Projects 列表中选择 All Projects 时,才会显示 Namespace 列。 |

| 虚拟机模板表 | 虚拟机模板列表。

点模板旁的操作菜单

|

2.3.4.1. 模板详情页面

您可以查看模板设置并在 Template 详情页中编辑自定义模板。

例 2.27. 模板详情页

| 元素 | 描述 |

|---|---|

| YAML 开关 | 设置为 ON,以在 YAML 配置文件中查看您的实时更改。 |

| 操作菜单 | 点 Actions 菜单,以选择 Edit,Clone,Edit boot source,Edit boot source reference,Edit labels,Edit annotations, 或 Delete。 |

| 模板设置和配置。 | |

| YAML 配置文件。 | |

| 调度配置。 | |

| 网络接口管理。 | |

| 磁盘管理。 | |

| cloud-init、SSH 密钥和 Sysprep 管理。 | |

| 名称和云用户密码管理。 |

2.3.4.1.1. 详情标签页

您可以在 Details 标签页中配置自定义模板。

例 2.28. 详情标签页

| 元素 | 描述 |

|---|---|

| Name | 模板名称。 |

| Namespace | 模板命名空间。 |

| 标签 | 点编辑图标编辑标签。 |

| 注解 | 点编辑图标编辑注解。 |

| 显示名称 | 点编辑图标编辑显示名称。 |

| 描述 | 点编辑图标,以输入描述。 |

| 操作系统 | 操作系统名称。 |

| CPU|内存 | 点编辑图标编辑 CPU|Memory 请求。

CPU 数量通过以下公式来计算: |

| 机器类型 | 模板机器类型。 |

| 引导模式 | 点编辑图标编辑引导模式。 |

| 基本模板 | 用于创建此模板的基本模板的名称。 |

| 创建于 | 模板创建日期。 |

| 所有者 | 模板所有者。 |

| 引导顺序 | 模板引导顺序。 |

| 引导源 | 引导源可用性。 |

| 供应商 | 模板提供程序。 |

| 支持 | 模板支持级别。 |

| GPU 设备 | 点编辑图标添加 GPU 设备。 |

| 主机设备 | 点编辑图标添加主机设备。 |

| 无头模式 | 点编辑图标将无头模式设置为 ON,并禁用 VNC 控制台。 |

2.3.4.1.2. YAML 标签页

您可以通过编辑 YAML 选项卡上的 YAML 文件来配置自定义模板。

例 2.29. YAML 标签页

| 元素 | 描述 |

|---|---|

| 保存按钮 | 保存对 YAML 文件的更改。 |

| 重新加载按钮 | 丢弃您的更改并重新载入 YAML 文件。 |

| 取消 按钮 | 退出 YAML 选项卡。 |

| 下载 按钮 | 将 YAML 文件下载到您的本地计算机。 |

2.3.4.1.3. 调度标签

您可以在 Scheduling 选项卡中配置调度。

例 2.30. 调度 标签页

| 设置 | 描述 |

|---|---|

| 节点选择器 | 点编辑图标添加标签来指定合格节点。 |

| 容限(Tolerations) | 点编辑图标,以添加容限来指定合格节点。 |

| 关联性规则 | 点编辑图标来添加关联性规则。 |

| Descheduler 交换机 | 启用或禁用 descheduler。descheduler 驱除正在运行的 pod,以便可将 pod 重新调度到更合适的节点上。 |

| 专用资源 | 点编辑图标,选择 Schedule this workload with dedicated resources (guaranteed policy)。 |

| 驱除策略 | 点编辑图标选择 LiveMigrate 作为虚拟机驱除策略。 |

2.3.4.1.4. 网络接口选项卡

您可以在 Network interfaces 选项卡上管理网络接口。

例 2.31. 网络接口标签页

| 设置 | 描述 |

|---|---|

| 添加网络接口按钮 | 向模板添加网络接口。 |

| Filter 字段 | 按接口类型过滤。 |

| 搜索字段 | 根据名称或标签搜索网络接口。 |

| 网络接口表 | 网络接口列表。

点网络接口

|

2.3.4.1.5. Disk 标签页

您可以在 Disks 选项卡上管理磁盘。

例 2.32. Disk 标签页

| 设置 | 描述 |

|---|---|

| 添加磁盘按钮 | 向模板添加磁盘。 |

| Filter 字段 | 按磁盘类型过滤。 |

| 搜索字段 | 按名称搜索磁盘。 |

| 磁盘表 | 模板磁盘列表。

点磁盘旁的操作菜单

|

2.3.4.1.6. Script 标签页

您可以在 Scripts 选项卡上管理 cloud-init 设置、SSH 密钥和 Sysprep 回答文件。

例 2.33. Script 标签页

| 元素 | 描述 |

|---|---|

| Cloud-init | 点编辑图标来编辑 cloud-init 设置。 |

| 公共 SSH 密钥 | 点编辑图标创建新 secret 或将现有 secret 附加到 Linux 虚拟机。 |

| Sysprep |

点编辑图标上传 |

2.3.4.1.7. 参数标签页

您可以在 Parameters 选项卡中编辑所选模板设置。

例 2.34. 参数 标签页

| 元素 | 描述 |

|---|---|

| NAME | 设置从该模板创建的虚拟机的名称参数。 |

| CLOUD_USER_PASSWORD | 为从该模板创建的虚拟机设置云用户密码参数。 |

2.3.5. Instancetypes 页面

您可以在 InstanceTypes 页面中查看和管理虚拟机实例类型。

例 2.35. VirtualMachineClusterInstancetypes 页面

| 元素 | 描述 |

|---|---|

| 创建 按钮 | 通过编辑 YAML 配置文件创建实例类型。 |

| 搜索字段 | 根据名称或标签搜索实例类型。 |

| 管理列 图标 | 选择要在表中显示 9 列。只有在从 Projects 列表中选择 All Projects 时,才会显示 Namespace 列。 |

| 实例类型表 | 实例列表。

点实例类型旁边的操作菜单

|

点一个实例类型查看 VirtualMachineClusterInstancetypes 详情页。

2.3.5.1. VirtualMachineClusterInstancetypes 详情页

您可以在 VirtualMachineClusterInstancetypes 详情页中配置实例类型。

例 2.36. VirtualMachineClusterInstancetypes 详情页

| 元素 | 描述 |

|---|---|

| 详情标签页 | 通过编辑表单来配置实例类型。 |

| YAML 标签页 | 通过编辑 YAML 配置文件来配置实例类型。 |

| 操作菜单 | 选择 Edit labels,Edit annotations,Edit VirtualMachineClusterInstancetype, 或 Delete VirtualMachineClusterInstancetype。 |

2.3.5.1.1. 详情标签页

您可以通过编辑 Details 选项卡中的表单来配置实例类型。

例 2.37. 详情标签页

| 元素 | 描述 |

|---|---|

| Name | VirtualMachineClusterInstancetype 名称。 |

| 标签 | 点编辑图标编辑标签。 |

| 注解 | 点编辑图标编辑注解。 |

| 创建于 | 实例类型创建日期。 |

| 所有者 | 实例类型所有者。 |

2.3.5.1.2. YAML 标签页

您可以通过编辑 YAML 选项卡上的 YAML 文件来配置实例类型。

例 2.38. YAML 标签页

| 元素 | 描述 |

|---|---|

| 保存按钮 | 保存对 YAML 文件的更改。 |

| 重新加载按钮 | 丢弃您的更改并重新载入 YAML 文件。 |

| 取消 按钮 | 退出 YAML 选项卡。 |

| 下载 按钮 | 将 YAML 文件下载到您的本地计算机。 |

2.3.6. 首选项页面

您可以在 Preferences 页面中查看和管理虚拟机首选项。

例 2.39. VirtualMachineClusterPreferences 页面

| 元素 | 描述 |

|---|---|

| 创建 按钮 | 通过编辑 YAML 配置文件创建首选项。 |

| 搜索字段 | 根据名称或标签搜索首选项。 |

| 管理列 图标 | 选择要在表中显示 9 列。只有在从 Projects 列表中选择 All Projects 时,才会显示 Namespace 列。 |

| 首选项表 | 首选项列表。

点首选选择 Clone 或 Delete 旁边的操作菜单

|

点首选项查看 VirtualMachineClusterPreference 详情页。

2.3.6.1. VirtualMachineClusterPreference 详情页

您可以在 VirtualMachineClusterPreference 详情页中配置首选项。

例 2.40. VirtualMachineClusterPreference 详情页

| 元素 | 描述 |

|---|---|

| 详情标签页 | 通过编辑表单来配置首选项。 |

| YAML 标签页 | 通过编辑 YAML 配置文件来配置首选项。 |

| 操作菜单 | 选择 Edit labels,Edit annotations,Edit VirtualMachineClusterPreference, 或 Delete VirtualMachineClusterPreference。 |

2.3.6.1.1. 详情标签页

您可以通过编辑 Details 标签页中的表单来配置首选项。

例 2.41. 详情标签页

| 元素 | 描述 |

|---|---|

| Name | VirtualMachineClusterPreference 名称。 |

| 标签 | 点编辑图标编辑标签。 |

| 注解 | 点编辑图标编辑注解。 |

| 创建于 | 首选创建日期。 |

| 所有者 | 首选所有者。 |

2.3.6.1.2. YAML 标签页

您可以通过编辑 YAML 选项卡上的 YAML 文件来配置首选项类型。

例 2.42. YAML 标签页

| 元素 | 描述 |

|---|---|

| 保存按钮 | 保存对 YAML 文件的更改。 |

| 重新加载按钮 | 丢弃您的更改并重新载入 YAML 文件。 |

| 取消 按钮 | 退出 YAML 选项卡。 |

| 下载 按钮 | 将 YAML 文件下载到您的本地计算机。 |

2.3.7. 可引导卷页面

您可以在 Bootable volumes 页面中查看和管理可用的可引导卷。

例 2.43. 可引导卷 页

| 元素 | 描述 |

|---|---|

| 添加卷 按钮 | 通过填写表单或编辑 YAML 配置文件来添加可引导卷。 |

| Filter 字段 | 根据操作系统和资源类型过滤可引导卷。 |

| 搜索字段 | 根据名称或标签搜索可引导卷。 |

| 管理列 图标 | 选择要在表中显示 9 列。只有在从 Projects 列表中选择 All Projects 时,才会显示 Namespace 列。 |

| 可引导卷表 | 可引导卷列表。

点可引导卷旁的操作菜单

|

点可引导卷查看 DataSource 详情页面。

2.3.7.1. 数据源详情页面

您可以在 DataSource 详情页面中配置可引导卷的持久性卷声明 (PVC)。

例 2.44. 数据源详情页面

| 元素 | 描述 |

|---|---|

| 详情标签页 | 通过编辑表单来配置 PVC。 |

| YAML 标签页 | 通过编辑 YAML 配置文件来配置 PVC。 |

2.3.7.1.1. 详情标签页

您可以通过编辑 Details 选项卡中的表单来配置可引导卷的持久性卷声明(PVC)。

例 2.45. 详情标签页

| 元素 | 描述 |

|---|---|

| Name | 数据源名称。 |

| Namespace | 数据源命名空间。 |

| 标签 | 点编辑图标编辑标签。 |

| 注解 | 点编辑图标编辑注解。 |

| 创建于 | 数据源创建日期。 |

| 所有者 | 数据源所有者。 |

| DataImportCron |

数据源的 |

| 默认实例类型 | 此数据源的默认实例类型。 |

| Preference |

运行给定工作负载所需的首选 |

| conditions 表 | 显示数据源的类型、状态、最后更新、原因和消息。 |

2.3.7.1.2. YAML 标签页

您可以通过编辑 YAML 选项卡上的 YAML 文件来配置可引导卷的持久性卷声明。

例 2.46. YAML 标签页

| 元素 | 描述 |

|---|---|

| 保存按钮 | 保存对 YAML 文件的更改。 |

| 重新加载按钮 | 丢弃您的更改并重新载入 YAML 文件。 |

| 取消 按钮 | 退出 YAML 选项卡。 |

| 下载 按钮 | 将 YAML 文件下载到您的本地计算机。 |

2.3.8. MigrationPolicies 页面

您可以在 MigrationPolicies 页面中管理工作负载的迁移策略。

例 2.47. MigrationPolicies 页面

| 元素 | 描述 |

|---|---|

| 创建 MigrationPolicy | 通过以表单或编辑 YAML 文件输入配置和标签来创建迁移策略。 |

| 搜索字段 | 根据名称或标签搜索迁移策略。 |

| 管理列 图标 | 选择要在表中显示 9 列。只有在从 Projects 列表中选择 All Projects 时,才会显示 Namespace 列。 |

| MigrationPolicies 表 | 迁移策略列表。

点迁移策略旁的操作菜单

|

点迁移策略查看 MigrationPolicy 详情页。

2.3.8.1. MigrationPolicy 详情页面

您可以在 MigrationPolicy 详情页中配置迁移策略。

例 2.48. MigrationPolicy 详情页

| 元素 | 描述 |

|---|---|

| 详情标签页 | 通过编辑表单来配置迁移策略。 |

| YAML 标签页 | 通过编辑 YAML 配置文件来配置迁移策略。 |

| 操作菜单 | 选择 Edit 或 Delete。 |

2.3.8.1.1. 详情标签页

您可以在 Details 标签页中配置自定义模板。

例 2.49. 详情标签页

| 元素 | 描述 |

|---|---|

| Name | 迁移策略名称。 |

| 描述 | 迁移策略描述。 |

| 配置 | 点编辑图标更新迁移策略配置。 |

| 每个迁移的带宽 |

每个迁移的带宽请求。对于无限带宽,请将值设为 |

| 自动聚合 | 启用自动聚合时,可能会降低虚拟机的性能和可用性,以确保迁移成功。 |

| Post-copy | 后复制策略。 |

| 完成超时 | 完成超时值(以秒为单位)。 |

| 项目标签 | 点 Edit 以编辑项目标签。 |

| VirtualMachine 标签 | 点 Edit 以编辑虚拟机标签。 |

2.3.8.1.2. YAML 标签页

您可以通过编辑 YAML 选项卡上的 YAML 文件来配置迁移策略。

例 2.50. YAML 标签页

| 元素 | 描述 |

|---|---|

| 保存按钮 | 保存对 YAML 文件的更改。 |

| 重新加载按钮 | 丢弃您的更改并重新载入 YAML 文件。 |

| 取消 按钮 | 退出 YAML 选项卡。 |

| 下载 按钮 | 将 YAML 文件下载到您的本地计算机。 |

2.3.9. Checkups 页面

您在 Checkups 页面中为虚拟机运行网络延迟和存储检查。

例 2.51. Checkups 页面

| 元素 | 描述 |

|---|---|

| 网络延迟标签页 | 运行网络延迟检查。 |

| 存储 标签页 | 运行存储检查。 |

第 3 章 安装

3.1. 为 OpenShift Virtualization 准备集群

在安装 OpenShift Virtualization 前,参阅这个部分以确保集群满足要求。

3.1.1. 支持的平台

您可以在 OpenShift Virtualization 中使用以下平台:

- Amazon Web Services 裸机实例。

3.1.1.1. OpenShift Virtualization on Red Hat OpenShift Service on AWS

您可以在 AWS (ROSA) Classic 集群上运行 OpenShift Virtualization。

在设置集群前,请查看以下支持的功能和限制概述:

- 安装

您可以使用安装程序置备的基础架构安装集群,通过编辑

install-config.yaml文件来确保为 worker 节点指定裸机实例类型。例如,您可以对基于 x86_64 架构的机器使用c5n.metal类型值。如需更多信息,请参阅在 AWS 上安装 Red Hat OpenShift Service on AWS 文档。

- 访问虚拟机 (VM)

-

使用

virtctlCLI 工具或 Red Hat OpenShift Service on AWS Web 控制台没有更改您如何访问虚拟机。 您可以使用

NodePort或LoadBalancer服务公开虚拟机。- 负载均衡器方法是首选的,因为 Red Hat OpenShift Service on AWS 会在 AWS 中自动创建负载均衡器并管理其生命周期。另外,还会为负载均衡器创建一个安全组,您可以使用注解来附加现有的安全组。删除服务时,Red Hat OpenShift Service on AWS 会移除负载均衡器及其关联的资源。

- 网络

- 如果您的应用程序需要扁平第 2 层网络或对 IP 池进行控制,请考虑使用 OVN-Kubernetes 二级覆盖网络。

- Storage

您可以使用存储厂商认证的任何存储解决方案与底层平台一起使用。

重要AWS 裸机和 ROSA 集群可能有不同的存储解决方案。确保您确认支持您的存储供应商。

- 由于性能和功能限制,不推荐将 Amazon Elastic File System (EFS) 和 Amazon Elastic Block Store (EBS) 与 OpenShift Virtualization 一起使用。应使用共享存储。

3.1.2. 硬件和操作系统要求

查看 OpenShift Virtualization 的以下硬件和操作系统要求。

3.1.2.1. CPU 要求

由 Red Hat Enterprise Linux (RHEL) 9 支持。

参阅用于支持的 CPU 红帽生态系统目录。

注意如果您的 worker 节点有不同的 CPU,则可能会出现实时迁移失败,因为不同的 CPU 具有不同的功能。您可以通过确保 worker 节点具有适当容量的 CPU,并为虚拟机配置节点关联性规则来缓解这个问题。

详情请参阅 配置所需的节点关联性规则。

- 支持 AMD 和 Intel 64 位架构 (x86-64-v2)。

- 支持 Intel 64 或 AMD64 CPU 扩展。

- 启用 Intel VT 或 AMD-V 硬件虚拟化扩展。

- 启用 NX (无执行)标记。

3.1.2.2. 操作系统要求

- 在 worker 节点上安装的 Red Hat Enterprise Linux CoreOS (RHCOS)。

3.1.2.3. 存储要求

- 由 Red Hat OpenShift Service on AWS 支持。

-

如果存储置备程序支持快照,您必须将

VolumeSnapshotClass对象与默认存储类关联。

3.1.2.3.1. 关于虚拟机磁盘的卷和访问模式

如果您将存储 API 与已知的存储供应商搭配使用,则会自动选择卷和访问模式。但是,如果您使用没有存储配置集的存储类,您必须配置卷和访问模式。

要获得最佳结果,请使用 ReadWriteMany (RWX)访问模式和 Block 卷模式。这一点非常重要:

-

实时迁移需要

ReadWriteMany(RWX) 访问模式。 -

块卷模式的性能优于Filesystem卷模式。这是因为Filesystem卷模式使用更多存储层,包括文件系统层和磁盘镜像文件。虚拟机磁盘存储不需要这些层。

您不能使用以下配置实时迁移虚拟机:

-

具有

ReadWriteOnce(RWO) 访问模式的存储卷 - 透传功能,比如 GPU

对于这些虚拟机,不要将 evictionStrategy 字段设置为 LiveMigrate。

3.1.3. 实时迁移要求

-

使用

ReadWriteMany(RWX)访问模式的共享存储. 足够的 RAM 和网络带宽。

注意您必须确保集群中有足够的内存请求容量来支持节点排空会导致实时迁移。您可以使用以下计算来确定大约所需的备用内存:

Product of (Maximum number of nodes that can drain in parallel) and (Highest total VM memory request allocations across nodes)

默认的在集群中可以并行运行的迁移数量为 5。

- 如果虚拟机使用主机型号 CPU,则节点必须支持虚拟机的主机型号 CPU。

- 强烈建议使用专用的 Multus 网络进行实时迁移。专用网络可最小化迁移期间对租户工作负载网络饱和的影响。

3.1.4. 物理资源开销要求

OpenShift Virtualization 是 Red Hat OpenShift Service on AWS 的一个附加组件,并需要额外的开销,您必须在规划集群时考虑这些开销。除了 Red Hat OpenShift Service on AWS 要求外,每个集群机器都必须满足以下开销要求。覆盖集群中的物理资源可能会影响性能。

本文档中给出的数字基于红帽的测试方法和设置。这些数字会根据您自己的设置和环境而有所不同。

内存开销

使用以下因素计算 OpenShift Virtualization 的内存开销值。

集群内存开销

Memory overhead per infrastructure node ≈ 150 MiB

Memory overhead per worker node ≈ 360 MiB

另外,OpenShift Virtualization 环境资源需要总计 2179 MiB 的内存,分布到所有基础架构节点。

虚拟机内存开销

Memory overhead per virtual machine ≈ (1.002 × requested memory) \

+ 218 MiB \ 1

+ 8 MiB × (number of vCPUs) \ 2

+ 16 MiB × (number of graphics devices) \ 3

+ (additional memory overhead) 4

CPU 开销

使用以下内容计算 OpenShift Virtualization 的集群处理器开销要求。每个虚拟机的 CPU 开销取决于您的单独设置。

集群 CPU 开销

CPU overhead for infrastructure nodes ≈ 4 cores

OpenShift Virtualization 增加集群级别服务的整体使用,如日志记录、路由和监控。要考虑这个工作负载,请确保托管基础架构组件的节点分配了用于不同节点的 4 个额外内核(4000 毫秒)的容量。

CPU overhead for worker nodes ≈ 2 cores + CPU overhead per virtual machine

除了虚拟机工作负载所需的 CPU 外,每个托管虚拟机的 worker 节点都必须有 2 个额外内核(2000 毫秒)用于 OpenShift Virtualization 管理工作负载。

虚拟机 CPU 开销

如果请求专用 CPU,则会对集群 CPU 开销要求有 1:1 影响。否则,没有有关虚拟机所需 CPU 数量的具体规则。

存储开销

使用以下指南来估算 OpenShift Virtualization 环境的存储开销要求。

集群存储开销

Aggregated storage overhead per node ≈ 10 GiB

10 GiB 在安装 OpenShift Virtualization 时,集群中每个节点的磁盘存储影响估计值。

虚拟机存储开销

每个虚拟机的存储开销取决于虚拟机内的具体资源分配请求。该请求可能用于集群中其他位置托管的节点或存储资源的临时存储。OpenShift Virtualization 目前不会为正在运行的容器本身分配任何额外的临时存储。

Example

作为集群管理员,如果您计划托管集群中的 10 个虚拟机,每个虚拟机都有 1 GiB RAM 和 2 个 vCPU,集群中的内存影响为 11.68 GiB。集群中每个节点的磁盘存储影响估算为 10 GiB,托管虚拟机工作负载的 worker 节点的 CPU 影响最小 2 个内核。

3.2. 安装 OpenShift Virtualization

安装 OpenShift Virtualization 以便在 AWS 集群上的 Red Hat OpenShift Service 中添加虚拟化功能。

3.2.1. 安装 OpenShift Virtualization Operator

使用 Red Hat OpenShift Service on AWS Web 控制台或命令行安装 OpenShift Virtualization Operator。

3.2.1.1. 使用 Web 控制台安装 OpenShift Virtualization Operator

您可以使用 Red Hat OpenShift Service on AWS Web 控制台部署 OpenShift Virtualization Operator。

先决条件

- 在集群上安装 Red Hat OpenShift Service on AWS 4。

-

以具有

cluster-admin权限的用户身份登录 Red Hat OpenShift Service on AWS web 控制台。 - 基于裸机计算节点实例类型创建机器池。如需更多信息,请参阅本节的附加资源中的"创建机器池"。

流程

- 从 Administrator 视角中,点 Operators → OperatorHub。

- 在 Filter by keyword 字段中,键入 Virtualization。

- 选择带有 Red Hat source 标签的 OpenShift Virtualization Operator 标题。

- 阅读 Operator 信息并单击 Install。

在 Install Operator 页面中:

- 从可用 Update Channel 选项列表中选择 stable。这样可确保安装与 Red Hat OpenShift Service on AWS 版本兼容的 OpenShift Virtualization 版本。

对于安装的命名空间,请确保选择了 Operator 推荐的命名空间选项。这会在

openshift-cnv命名空间中安装 Operator,该命名空间在不存在时自动创建。警告尝试在

openshift-cnv以外的命名空间中安装 OpenShift Virtualization Operator 会导致安装失败。对于 Approval Strategy,强烈建议您选择 Automatic (默认值),以便在 stable 更新频道中提供新版本时 OpenShift Virtualization 会自动更新。

虽然可以选择 Manual 批准策略,但这不可取,因为它会给集群提供支持和功能带来高风险。只有在您完全了解这些风险且无法使用 Automatic 时,才选择 Manual。

警告因为 OpenShift Virtualization 仅在与对应的 Red Hat OpenShift Service on AWS 版本搭配使用时被支持,所以缺少的 OpenShift Virtualization 更新可能会导致集群不被支持。

-

点击 Install 使 Operator 可供

openshift-cnv命名空间使用。 - 当 Operator 成功安装时,点 Create HyperConverged。

- 可选: 为 OpenShift Virtualization 组件配置 Infra 和 Workloads 节点放置选项。

- 点击 Create 启动 OpenShift Virtualization。

验证

- 导航到 Workloads → Pods 页面,并监控 OpenShift Virtualization Pod,直至全部处于 Running 状态。在所有 pod 都处于 Running 状态后,您可以使用 OpenShift Virtualization。

其他资源

3.2.1.2. 使用命令行安装 OpenShift Virtualization Operator

订阅 OpenShift Virtualization 目录,并通过将清单应用到集群来安装 OpenShift Virtualization Operator。

3.2.1.2.1. 使用 CLI 订阅 OpenShift virtualization 目录

在安装 OpenShift Virtualization 前,需要订阅到 OpenShift Virtualization catalog。订阅会授予 OpenShift virtualization Operator 对 openshift-cnv 命名空间的访问权限。

为了订阅,在您的集群中应用一个单独的清单(manifest)来配置 Namespace、OperatorGroup 和 Subscription 对象。

先决条件

- 在集群上安装 Red Hat OpenShift Service on AWS 4。

-

安装 OpenShift CLI (

oc) 。 -

以具有

cluster-admin特权的用户身份登录。

流程

运行以下命令,为 OpenShift Virtualization 创建所需的

Namespace、OperatorGroup和Subscription对象:$ oc apply -f <file name>.yaml

您可以在 YAML 文件中配置证书轮转参数。

3.2.1.2.2. 使用 CLI 部署 OpenShift Virtualization Operator

您可以使用 oc CLI 部署 OpenShift Virtualization Operator。

先决条件

-

在

openshift-cnv命名空间中订阅 OpenShift Virtualization 目录。 -

以具有

cluster-admin特权的用户身份登录。 - 基于裸机计算节点实例类型创建机器池。

流程

创建一个包含以下清单的 YAML 文件:

apiVersion: hco.kubevirt.io/v1beta1 kind: HyperConverged metadata: name: kubevirt-hyperconverged namespace: openshift-cnv spec:

运行以下命令来部署 OpenShift Virtualization Operator:

$ oc apply -f <file_name>.yaml

验证

通过观察

openshift-cnv命名空间中集群服务版本(CSV)的PHASE来确保 OpenShift Virtualization 已被成功部署。运行以下命令:$ watch oc get csv -n openshift-cnv

如果部署成功,则会显示以下输出:

输出示例

NAME DISPLAY VERSION REPLACES PHASE kubevirt-hyperconverged-operator.v4.15.1 OpenShift Virtualization 4.15.1 Succeeded

其他资源

3.2.2. 后续步骤

- hostpath 置备程序是设计用于 OpenShift Virtualization 的本地存储置备程序。如果要为虚拟机配置本地存储,您必须首先启用 hostpath 置备程序。

3.3. 卸载 OpenShift Virtualization

您可以使用 Web 控制台或命令行界面 (CLI) 卸载 OpenShift Virtualization,以删除 OpenShift Virtualization 工作负载、Operator 及其资源。

3.3.1. 使用 Web 控制台卸载 OpenShift Virtualization

您可以使用 Web 控制台卸载 OpenShift Virtualization 来执行以下任务:

3.3.1.1. 删除 HyperConverged 自定义资源

要卸载 OpenShift Virtualization,首先删除 HyperConverged 自定义资源 (CR)。

先决条件

-

您可以使用具有

cluster-admin权限的账户访问 Red Hat OpenShift Service on AWS 集群。

流程

- 进入到 Operators → Installed Operators 页面。

- 选择 OpenShift Virtualization Operator。

- 点 OpenShift Virtualization Deployment 选项卡。

-

点

kubevirt-hyperconverged旁边的 Options 菜单 ,然后选择 Delete HyperConverged。

,然后选择 Delete HyperConverged。

- 在确认窗口中点击 Delete。

3.3.1.2. 使用 Web 控制台从集群中删除 Operator

集群管理员可以使用 Web 控制台从所选命名空间中删除已安装的 Operator。

先决条件

-

您可以使用具有

dedicated-admin权限的账户访问 Red Hat OpenShift Service on AWS 集群 Web 控制台。

流程

- 进入到 Operators → Installed Operators 页面。

- 在 Filter by name 字段中滚动或输入关键字以查找您要删除的 Operator。然后点它。

在 Operator Details 页面右侧,从 Actions 列表中选择 Uninstall Operator。

此时会显示 Uninstall Operator? 对话框。

选择 Uninstall 来删除 Operator、Operator 部署和 pod。按照此操作,Operator 将停止运行,不再接收更新。

注意此操作不会删除 Operator 管理的资源,包括自定义资源定义 (CRD) 和自定义资源 (CR) 。Web 控制台和继续运行的集群资源启用的仪表板和导航项可能需要手动清理。要在卸载 Operator 后删除这些,您可能需要手动删除 Operator CRD。

3.3.1.3. 使用 web 控制台删除命令空间

您可以使用 Red Hat OpenShift Service on AWS Web 控制台删除命名空间。

先决条件

-

您可以使用具有

cluster-admin权限的账户访问 Red Hat OpenShift Service on AWS 集群。

流程

- 导航至 Administration → Namespaces。

- 在命名空间列表中找到您要删除的命名空间。

-

在命名空间列表的右侧,从 Options 菜单

中选择 Delete Namespace。

中选择 Delete Namespace。

- 当 Delete Namespace 页打开时,在相关项中输入您要删除的命名空间的名称。

- 点击 Delete。

3.3.1.4. 删除 OpenShift Virtualization 自定义资源定义

您可以使用 Web 控制台删除 OpenShift Virtualization 自定义资源定义 (CRD)。

先决条件

-

您可以使用具有

cluster-admin权限的账户访问 Red Hat OpenShift Service on AWS 集群。

流程

- 进入到 Administration → CustomResourceDefinitions。

-

选择 Label 过滤器,并在 Search 字段中输入

operators.coreos.com/kubevirt-hyperconverged.openshift-cnv,以显示 OpenShift Virtualization CRD。 -

点每个 CRD 旁边的 Options 菜单

,然后选择 Delete CustomResourceDefinition。

,然后选择 Delete CustomResourceDefinition。

3.3.2. 使用 CLI 卸载 OpenShift Virtualization

您可以使用 OpenShift CLI (oc) 卸载 OpenShift Virtualization。

先决条件

-

您可以使用具有

cluster-admin权限的账户访问 Red Hat OpenShift Service on AWS 集群。 -

已安装 OpenShift CLI(

oc)。 - 您已删除所有虚拟机和虚拟机实例。当其工作负载保留在集群中时,您无法卸载 OpenShift Virtualization。

流程

删除

HyperConverged自定义资源:$ oc delete HyperConverged kubevirt-hyperconverged -n openshift-cnv

删除 OpenShift Virtualization Operator 订阅:

$ oc delete subscription kubevirt-hyperconverged -n openshift-cnv

删除 OpenShift Virtualization

ClusterServiceVersion资源:$ oc delete csv -n openshift-cnv -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

删除 OpenShift Virtualization 命名空间:

$ oc delete namespace openshift-cnv

使用

dry-run选项运行oc delete crd命令列出 OpenShift Virtualization 自定义资源定义 (CRD):$ oc delete crd --dry-run=client -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

输出示例

customresourcedefinition.apiextensions.k8s.io "cdis.cdi.kubevirt.io" deleted (dry run) customresourcedefinition.apiextensions.k8s.io "hostpathprovisioners.hostpathprovisioner.kubevirt.io" deleted (dry run) customresourcedefinition.apiextensions.k8s.io "hyperconvergeds.hco.kubevirt.io" deleted (dry run) customresourcedefinition.apiextensions.k8s.io "kubevirts.kubevirt.io" deleted (dry run) customresourcedefinition.apiextensions.k8s.io "networkaddonsconfigs.networkaddonsoperator.network.kubevirt.io" deleted (dry run) customresourcedefinition.apiextensions.k8s.io "ssps.ssp.kubevirt.io" deleted (dry run) customresourcedefinition.apiextensions.k8s.io "tektontasks.tektontasks.kubevirt.io" deleted (dry run)

运行

oc delete crd命令来删除 CRD,而无需dry-run选项:$ oc delete crd -l operators.coreos.com/kubevirt-hyperconverged.openshift-cnv

第 4 章 安装后配置

4.1. 安装后配置

以下流程通常在安装 OpenShift Virtualization 后执行。您可以配置与环境相关的组件:

- OpenShift Virtualization Operator、工作负载和控制器的节点放置规则

网络配置 :

- 使用 Red Hat OpenShift Service on AWS Web 控制台启用创建负载均衡器服务

存储配置 :

- 为 Container Storage Interface (CSI) 定义默认存储类

- 使用 Hostpath Provisioner (HPP) 配置本地存储

4.2. 为 OpenShift Virtualization 组件指定节点

裸机节点上虚拟机(VM)的默认调度是适当的。另外,您可以通过配置节点放置规则来指定您要部署 OpenShift Virtualization Operator、工作负载和控制器的节点。

在安装 OpenShift Virtualization 后,您可以为一些组件配置节点放置规则,但如果要为工作负载配置节点放置规则,则虚拟机将无法被存在。

4.2.1. 关于 OpenShift Virtualization 组件的节点放置规则

您可以将节点放置规则用于以下任务:

- 仅在用于虚拟化工作负载的节点上部署虚拟机。

- 仅在基础架构节点上部署 Operator。

- 在工作负载之间保持隔离。

根据对象,您可以使用以下一个或多个规则类型:

nodeSelector- 允许将 Pod 调度到使用您在此字段中指定的键值对标记的节点上。节点必须具有与所有列出的对完全匹配的标签。

关联性- 可让您使用更宽松的语法来设置与 pod 匹配的规则。关联性也允许在规则应用方面更加精细。例如,您可以指定规则是首选项,而不是要求。如果规则是首选项的,则在不满足规则时仍然会调度 pod。

容限(tolerations)- 允许将 pod 调度到具有匹配污点的节点。如果某个节点有污点(taint),则该节点只接受容许该污点的 pod。

4.2.2. 应用节点放置规则

您可以通过使用命令行编辑 HyperConverged 或 HostPathProvisioner 对象来应用节点放置规则。

先决条件

-

已安装

ocCLI 工具。 - 使用集群管理员权限登录。

流程

运行以下命令,在默认编辑器中编辑对象:

$ oc edit <resource_type> <resource_name> -n {CNVNamespace}- 保存文件以使改变生效。

4.2.3. 节点放置规则示例

您可以通过编辑 HyperConverged 或 HostPathProvisioner 对象来为 OpenShift Virtualization 组件指定节点放置规则。

4.2.3.1. HyperConverged 对象节点放置规则示例

要指定 OpenShift Virtualization 部署其组件的节点,您可以在 OpenShift Virtualization 安装过程中创建的 HyperConverged 自定义资源(CR)文件中编辑 nodePlacement 对象。

使用 nodeSelector 规则的 HyperConverged 对象示例

apiVersion: hco.kubevirt.io/v1beta1

kind: HyperConverged

metadata:

name: kubevirt-hyperconverged

namespace: openshift-cnv

spec:

infra:

nodePlacement:

nodeSelector:

example.io/example-infra-key: example-infra-value 1

workloads:

nodePlacement:

nodeSelector:

example.io/example-workloads-key: example-workloads-value 2

使用 关联性规则的 HyperConverged 对象示例

apiVersion: hco.kubevirt.io/v1beta1

kind: HyperConverged

metadata:

name: kubevirt-hyperconverged

namespace: openshift-cnv

spec:

infra:

nodePlacement:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: example.io/example-infra-key

operator: In

values:

- example-infra-value 1

workloads:

nodePlacement:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: example.io/example-workloads-key 2

operator: In

values:

- example-workloads-value

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 1

preference:

matchExpressions:

- key: example.io/num-cpus

operator: Gt

values:

- 8 3

带有 容限 规则的 HyperConverged 对象示例

apiVersion: hco.kubevirt.io/v1beta1

kind: HyperConverged

metadata:

name: kubevirt-hyperconverged

namespace: openshift-cnv

spec:

workloads:

nodePlacement:

tolerations: 1

- key: "key"

operator: "Equal"

value: "virtualization"

effect: "NoSchedule"

- 1

- 为 OpenShift Virtualization 组件保留的节点使用

key = virtualization:NoSchedule污点标记。只有具有匹配容限的 pod 才会调度到保留节点上。

4.2.3.2. HostPathProvisioner 对象节点放置规则示例

您可以直接编辑 HostPathProvisioner 对象,或使用 Web 控制台。

您必须将 hostpath 置备程序和 OpenShift Virtualization 组件调度到同一节点上。否则,使用 hostpath 置备程序的虚拟化 pod 无法运行。您无法运行虚拟机。

使用 hostpath 置备程序(HPP)存储类部署虚拟机(VM)后,您可以使用节点选择器从同一节点中删除 hostpath 置备程序 pod。但是,您必须首先恢复该更改,至少针对该特定节点,并在尝试删除虚拟机前等待 pod 运行。

您可以通过为安装 hostpath 置备程序时创建的 HostPathProvisioner 对象的 spec.workload 字段指定 nodeSelector、affinity 或 tolerations 来配置节点放置规则。

带有 nodeSelector 规则的 HostPathProvisioner 对象示例

apiVersion: hostpathprovisioner.kubevirt.io/v1beta1

kind: HostPathProvisioner

metadata:

name: hostpath-provisioner

spec:

imagePullPolicy: IfNotPresent

pathConfig:

path: "</path/to/backing/directory>"

useNamingPrefix: false

workload:

nodeSelector:

example.io/example-workloads-key: example-workloads-value 1

- 1

- 工作负载放置在带有

example.io/example-workloads-key = example-workloads-value的节点上。

4.2.4. 其他资源

4.3. 安装后的网络配置

默认情况下,OpenShift Virtualization 安装了一个内部 pod 网络。

4.3.1. 安装网络 Operator

4.3.2. 配置 Linux 网桥网络

安装 Kubernetes NMState Operator 后,您可以为实时迁移或外部访问虚拟机(VM)配置 Linux 网桥网络。

4.3.2.1. 创建 Linux 网桥 NNCP

您可以为 Linux 网桥网络创建一个 NodeNetworkConfigurationPolicy (NNCP) 清单。

先决条件

- 已安装 Kubernetes NMState Operator。

流程

创建

NodeNetworkConfigurationPolicy清单。本例包含示例值,您必须替换为您自己的信息。apiVersion: nmstate.io/v1 kind: NodeNetworkConfigurationPolicy metadata: name: br1-eth1-policy 1 spec: desiredState: interfaces: - name: br1 2 description: Linux bridge with eth1 as a port 3 type: linux-bridge 4 state: up 5 ipv4: enabled: false 6 bridge: options: stp: enabled: false 7 port: - name: eth1 8

4.3.2.2. 使用 Web 控制台创建 Linux 网桥 NAD

您可以使用 Red Hat OpenShift Service on AWS web 控制台创建网络附加定义(NAD),为 Pod 和虚拟机提供第 2 层网络。

Linux 网桥网络附加定义是将虚拟机连接至 VLAN 的最有效方法。

不支持在虚拟机的网络附加定义中配置 IP 地址管理(IPAM)。

流程

- 在 Web 控制台中,点 Networking → NetworkAttachmentDefinitions。

点 Create Network Attachment Definition。

注意网络附加定义必须与 pod 或虚拟机位于同一个命名空间中。

- 输入唯一 Name 和可选 Description。

- 从 Network Type 列表中选择 CNV Linux 网桥。

- 在 Bridge Name 字段输入网桥名称。

- 可选:如果资源配置了 VLAN ID,请在 VLAN Tag Number 字段中输入 ID 号。

- 可选: 选择 MAC Spoof Check 来启用 MAC spoof 过滤。此功能只允许单个 MAC 地址退出 pod,从而可以防止使用 MAC 欺骗进行的安全攻击。

- 点 Create。

4.3.3. 配置网络以进行实时迁移

配置了 Linux 网桥网络后,您可以为实时迁移配置专用网络。专用的网络可最小化实时迁移期间对租户工作负载的网络饱和影响。

4.3.3.1. 为实时迁移配置专用的二级网络

要为实时迁移配置专用的二级网络,您必须首先使用 CLI 创建桥接网络附加定义(NAD)。然后,您可以将 NetworkAttachmentDefinition 对象的名称添加到 HyperConverged 自定义资源(CR)。

先决条件

-

已安装 OpenShift CLI(

oc)。 -

您以具有

cluster-admin角色的用户身份登录到集群。 - 每个节点至少有两个网络接口卡 (NIC)。

- 用于实时迁移的 NIC 连接到同一 VLAN。

流程

根据以下示例创建

NetworkAttachmentDefinition清单:配置文件示例

apiVersion: "k8s.cni.cncf.io/v1" kind: NetworkAttachmentDefinition metadata: name: my-secondary-network 1 namespace: openshift-cnv 2 spec: config: '{ "cniVersion": "0.3.1", "name": "migration-bridge", "type": "macvlan", "master": "eth1", 3 "mode": "bridge", "ipam": { "type": "whereabouts", 4 "range": "10.200.5.0/24" 5 } }'

运行以下命令,在默认编辑器中打开

HyperConvergedCR:oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

将

NetworkAttachmentDefinition对象的名称添加到HyperConvergedCR 的spec.liveMigrationConfig小节中:HyperConverged清单示例apiVersion: hco.kubevirt.io/v1beta1 kind: HyperConverged metadata: name: kubevirt-hyperconverged spec: liveMigrationConfig: completionTimeoutPerGiB: 800 network: <network> 1 parallelMigrationsPerCluster: 5 parallelOutboundMigrationsPerNode: 2 progressTimeout: 150 # ...- 1

- 指定要用于实时迁移的 Multus

NetworkAttachmentDefinition对象的名称。

-

保存更改并退出编辑器。

virt-handlerPod 会重启并连接到二级网络。

验证

当运行虚拟机的节点置于维护模式时,虚拟机会自动迁移到集群中的另一个节点。您可以通过检查虚拟机实例(VMI)元数据中的目标 IP 地址,验证迁移是否在二级网络中发生,而不是默认 pod 网络。

$ oc get vmi <vmi_name> -o jsonpath='{.status.migrationState.targetNodeAddress}'

4.3.3.2. 使用 Web 控制台选择专用网络

您可以使用 Red Hat OpenShift Service on AWS Web 控制台为实时迁移选择专用网络。

先决条件

- 为实时迁移配置了 Multus 网络。

流程

- 在 Red Hat OpenShift Service on AWS web 控制台中进入到 Virtualization > Overview。

- 点 Settings 选项卡,然后点 Live migration。

- 从 Live migration network 列表中选择网络。

4.3.4. 使用 Web 控制台启用负载均衡器服务创建

您可以使用 Red Hat OpenShift Service on AWS web 控制台为虚拟机(VM)启用负载均衡器服务。

先决条件

- 已为集群配置负载均衡器。

-

以具有

cluster-admin角色的用户身份登录。

流程

- 进入到 Virtualization → Overview。

- 在 Settings 选项卡中,点 Cluster。

- 展开 General settings 和 SSH 配置。

- 将 SSH over LoadBalancer 服务 设置为 on。

4.4. 安装后存储配置

以下存储配置任务是必需的:

- 如果您的存储供应商没有被 CDI 识别,您必须配置存储配置集。存储配置集根据关联的存储类提供推荐的存储设置。

可选: 您可以使用 hostpath 置备程序(HPP)配置本地存储。

如需了解更多选项,请参阅 存储配置概述,包括配置 Containerized Data Importer (CDI)、数据卷和自动引导源更新。

4.4.1. 使用 HPP 配置本地存储

安装 OpenShift Virtualization Operator 时,会自动安装 Hostpath Provisioner(HPP)Operator。HPP Operator 创建 HPP 置备程序。

HPP 是为 OpenShift Virtualization 设计的本地存储置备程序。要使用 HPP,您必须创建一个 HPP 自定义资源(CR)。

HPP 存储池不能与操作系统位于同一个分区。否则,存储池可能会填满操作系统分区。如果操作系统分区已满,则性能可能会生效,或者节点可能会不稳定或不可用。

4.4.1.1. 使用 storagePools 小节为 CSI 驱动程序创建存储类

要使用 hostpath 置备程序 (HPP),您必须为 Container Storage Interface (CSI) 驱动程序创建关联的存储类。

当您创建存储类时,您将设置参数,它们会影响属于该存储类的持久性卷(PV)的动态置备。您不能在创建 StorageClass 对象后更新其参数。

虚拟机使用基于本地 PV 的数据卷。本地 PV 与特定节点绑定。虽然磁盘镜像准备供虚拟机消耗,但可能不会将虚拟机调度到之前固定本地存储 PV 的节点。

要解决这个问题,使用 Kubernetes pod 调度程序将持久性卷声明(PVC)绑定到正确的节点上的 PV。通过使用 volumeBindingMode 参数设置为 WaitForFirstConsumer 的 StorageClass 值,PV 的绑定和置备会延迟到 pod 使用 PVC。

先决条件

-

以具有

cluster-admin特权的用户身份登录。

流程

创建

storageclass_csi.yaml文件来定义存储类:apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: hostpath-csi provisioner: kubevirt.io.hostpath-provisioner reclaimPolicy: Delete 1 volumeBindingMode: WaitForFirstConsumer 2 parameters: storagePool: my-storage-pool 3

- 保存文件并退出。

运行以下命令来创建

StorageClass对象:$ oc create -f storageclass_csi.yaml

第 5 章 更新

5.1. 更新 OpenShift Virtualization

了解 Operator Lifecycle Manager (OLM) 如何为 OpenShift Virtualization 提供 z-stream 和次要版本更新。

5.1.1. RHEL 9 上的 OpenShift Virtualization

OpenShift Virtualization 4.15 基于 Red Hat Enterprise Linux (RHEL) 9。您可以按照标准 OpenShift Virtualization 更新过程,从一个基于 RHEL 8 的版本升级到 OpenShift Virtualization 4.15。不需要额外的步骤。

与之前的版本一样,您可以在不中断运行工作负载的情况下执行更新。OpenShift Virtualization 4.15 支持从 RHEL 8 节点实时迁移到 RHEL 9 节点。

5.1.1.1. RHEL 9 机器类型

OpenShift Virtualization 中包含的所有虚拟机模板现在默认使用 RHEL 9 机器类型: machineType: pc-q35-rhel9.<y>.0,其中 <y> 是与最新 RHEL 9 次版本对应的数字。例如,值 pc-q35-rhel9.2.0 用于 RHEL 9.2。

更新 OpenShift Virtualization 不会更改任何现有虚拟机的 machineType 值。这些虚拟机在更新前继续正常工作。您可以选择更改虚拟机的机器类型,使其可从 RHEL 9 改进中受益。

在更改虚拟机的 machineType 值前,您必须关闭虚拟机。

5.1.2. 关于更新 OpenShift Virtualization

- Operator Lifecycle Manager (OLM) 管理 OpenShift Virtualization Operator 的生命周期。Marketplace Operator 在 Red Hat OpenShift Service on AWS 安装过程中部署,使外部 Operator 可供集群使用。

- OLM 为 OpenShift Virtualization 提供 z-stream 和次要版本更新。当您将 Red Hat OpenShift Service on AWS 更新至下一个次版本时,次版本更新将可用。在不首先更新 Red Hat OpenShift Service on AWS 的情况下,您无法将 OpenShift Virtualization 更新至下一个次版本。

- OpenShift Virtualization 订阅使用一个名为 stable 的单一更新频道。stable 频道确保 OpenShift Virtualization 和 Red Hat OpenShift Service on AWS 版本兼容。

如果您的订阅的批准策略被设置为 Automatic,则当 stable 频道中提供新版本的 Operator 时,更新过程就会马上启动。强烈建议您使用 Automatic(自动) 批准策略来维护可支持的环境。只有在 AWS 版本上运行对应的 Red Hat OpenShift Service 时,才会支持 OpenShift Virtualization 的每个次要版本。例如,您必须在 Red Hat OpenShift Service on AWS 4.15 上运行 OpenShift Virtualization 4.15。

- 虽然可以选择 Manual(手工) 批准策略,但并不建议这样做,因为它存在集群的支持性和功能风险。使用 Manual 批准策略时,您必须手动批准每个待处理的更新。如果 Red Hat OpenShift Service on AWS 和 OpenShift Virtualization 更新没有同步,您的集群就不被支持。

- 更新完成所需时间取决于您的网络连接情况。大部分自动更新可在十五分钟内完成。

- 更新 OpenShift Virtualization 不会中断网络连接。

- 数据卷及其关联的持久性卷声明会在更新过程中保留。

如果您的虚拟机正在运行使用 AWS Elastic Block Store (EBS)存储,则它们无法实时迁移,并可能会阻止 Red Hat OpenShift Service on AWS 集群更新。

作为临时解决方案,您可以重新配置虚拟机以便在集群更新过程中自动关闭它们。删除 evictionStrategy: LiveMigrate 字段,并将 runStrategy 字段设置为 Always。

5.1.2.1. 关于工作负载更新

更新 OpenShift Virtualization 时,虚拟机工作负载(包括 libvirt、virt-launcher )和 qemu (如果支持实时迁移)会自动更新。

每个虚拟机均有一个 virt-launcher pod,用于运行虚拟机实例(VMI)。virt-launcher pod 运行一个 libvirt 实例,用于管理虚拟机(VM)进程。

您可以通过编辑 HyperConverged 自定义资源 (CR) 的 spec.workloadUpdateStrategy 小节来配置工作负载的更新方式。可用的工作负载更新方法有两种: LiveMigrate 和 Evict。

因为 Evict 方法关闭 VMI pod,所以只启用 LiveMigrate 更新策略。

当 LiveMigrate 是唯一启用的更新策略时:

- 支持实时迁移的 VMI 会在更新过程中进行迁移。VM 客户机会进入启用了更新组件的新 pod。

不支持实时迁移的 VMI 不会中断或更新。

-

如果 VMI 有

LiveMigrate驱除策略,但没有支持实时迁移。

-

如果 VMI 有

如果您同时启用 LiveMigrate 和 Evict :

-

支持实时迁移的 VMI 使用

LiveMigrate更新策略。 -

不支持实时迁移的 VMI 使用

Evict更新策略。如果 VMI 由带有runStrategy: Always设置的VirtualMachine对象控制,则会在带有更新组件的新 pod 中创建一个新的 VMI。

迁移尝试和超时

更新工作负载时,如果 pod 在以下时间段内处于 Pending 状态,实时迁移会失败:

- 5 分钟

-

如果 pod 因为是

Unschedulable而处于 pending 状态。 - 15 分钟

- 如果 pod 因任何原因处于 pending 状态。

当 VMI 无法迁移时,virt-controller 会尝试再次迁移它。它会重复这个过程,直到所有可可迁移的 VMI 在新的 virt-launcher Pod 上运行。如果 VMI 没有被正确配置,这些尝试可能会无限期重复。

每次尝试都会对应于一个迁移对象。只有最近五个尝试才在缓冲区中。这可防止迁移对象在系统上进行积累,同时保留用于调试的信息。

5.1.3. 配置工作负载更新方法

您可以通过编辑 HyperConverged 自定义资源(CR)来配置工作负载更新方法。

先决条件

要使用实时迁移作为更新方法,您必须首先在集群中启用实时迁移。

注意如果

VirtualMachineInstanceCR 包含evictionStrategy: LiveMigrate,且虚拟机实例(VMI)不支持实时迁移,则 VMI 将不会更新。

流程

要在默认编辑器中打开

HyperConvergedCR,请运行以下命令:$ oc edit hyperconverged kubevirt-hyperconverged -n openshift-cnv

编辑

HyperConvergedCR 的workloadUpdateStrategy小节。例如:apiVersion: hco.kubevirt.io/v1beta1 kind: HyperConverged metadata: name: kubevirt-hyperconverged spec: workloadUpdateStrategy: workloadUpdateMethods: 1 - LiveMigrate 2 - Evict 3 batchEvictionSize: 10 4 batchEvictionInterval: "1m0s" 5 # ...- 1

- 可用于执行自动化工作负载更新的方法。可用值为

LiveMigrate和Evict。如果您如本例所示启用这两个选项,则更新会为不支持实时迁移的 VMI 使用LiveMigrate,对于不支持实时迁移的 VMI 使用Evict。要禁用自动工作负载更新,您可以删除workloadUpdateStrategy小节,或设置workloadUpdateMethods: []将数组留空。 - 2

- 具有最低破坏性的更新方法。支持实时迁移的 VMI 通过将虚拟机 (VM) 客户机迁移到启用了更新组件的新 pod 中来更新。如果

LiveMigrate是唯一列出的工作负载更新方法,不支持实时迁移的 VMI 不会中断或更新。 - 3

- 在升级过程中关闭 VMI pod 是一个有破坏性的方法。如果在集群中没有启用实时迁移,

Evict是唯一可用的更新方法。如果 VMI 由带有runStrategy: Always配置的VirtualMachine对象控制,则会在带有更新组件的新 pod 中创建一个新的 VMI。 - 4

- 使用

Evict方法每次可以强制更新的 VMI 数量。这不适用于LiveMigrate方法。 - 5

- 驱除下一批工作负载前等待的时间间隔。这不适用于

LiveMigrate方法。

注意您可以通过编辑

HyperConvergedCR 的spec.liveMigrationConfig小节来配置实时迁移限制和超时。- 若要应用您的更改,请保存并退出编辑器。

5.1.4. 批准待处理的 Operator 更新

5.1.4.1. 手动批准待处理的 Operator 更新

如果已安装的 Operator 的订阅被设置为 Manual,则当其当前更新频道中发布新更新时,在开始安装前必须手动批准更新。

先决条件

- 之前使用 Operator Lifecycle Manager(OLM)安装的 Operator。

流程

- 在 Red Hat OpenShift Service on AWS Web 控制台的 Administrator 视角中,进入到 Operators → Installed Operators。

- 处于待定更新的 Operator 会显示 Upgrade available 状态。点您要更新的 Operator 的名称。

- 点 Subscription 标签页。任何需要批准的更新都会在 Upgrade status 旁边显示。例如:它可能会显示 1 requires approval。

- 点 1 requires approval,然后点 Preview Install Plan。

- 检查列出可用于更新的资源。在满意后,点 Approve。

- 返回到 Operators → Installed Operators 页面,以监控更新的进度。完成后,状态会变为 Succeeded 和 Up to date。

5.1.5. 监控更新状态

5.1.5.1. 监控 OpenShift Virtualization 升级状态

要监控 OpenShift Virtualization Operator 升级的状态,请观察集群服务版本 (CSV) PHASE。此外您还可在 web 控制台中,或运行此处提供的命令来监控 CSV 状况。

PHASE 和状况值均是基于可用信息的近似值。

先决条件

-

以具有

cluster-admin角色的用户身份登录集群。 -

安装 OpenShift CLI(

oc)。

流程

运行以下命令:

$ oc get csv -n openshift-cnv

查看输出,检查

PHASE字段。例如:输出示例

VERSION REPLACES PHASE 4.9.0 kubevirt-hyperconverged-operator.v4.8.2 Installing 4.9.0 kubevirt-hyperconverged-operator.v4.9.0 Replacing

可选:运行以下命令来监控所有 OpenShift Virtualization 组件状况的聚合状态:

$ oc get hyperconverged kubevirt-hyperconverged -n openshift-cnv \ -o=jsonpath='{range .status.conditions[*]}{.type}{"\t"}{.status}{"\t"}{.message}{"\n"}{end}'成功升级后会输出以下内容:

输出示例

ReconcileComplete True Reconcile completed successfully Available True Reconcile completed successfully Progressing False Reconcile completed successfully Degraded False Reconcile completed successfully Upgradeable True Reconcile completed successfully

5.1.5.2. 查看过时的 OpenShift Virtualization 工作负载

您可以使用 CLI 查看过时的工作负载列表。

如果集群中存在过时的虚拟化 pod,OutdatedVirtualMachineInstanceWorkloads 警报会触发。

流程

要查看过时的虚拟机实例 (VMI) 列表,请运行以下命令:

$ oc get vmi -l kubevirt.io/outdatedLauncherImage --all-namespaces

配置工作负载更新以确保 VMI 自动更新。

5.1.6. 其他资源

第 6 章 虚拟机

6.1. 从红帽镜像创建虚拟机

6.1.1. 从红帽镜像创建虚拟机概述

红帽镜像是金级镜像。它们作为容器磁盘在安全 registry 中发布。Containerized Data Importer (CDI) 轮询容器磁盘并将其导入到集群中,并将其存储在 openshift-virtualization-os-images 项目中作为快照或持久性卷声明(PVC)。

红帽镜像会自动更新。您可以为这些镜像禁用和重新启用自动更新。请参阅管理红帽引导源更新。

集群管理员现在可以在 OpenShift Virtualization web 控制台中为 Red Hat Enterprise Linux (RHEL)虚拟机启用自动订阅。

您可以使用以下方法之一从红帽提供的操作系统镜像创建虚拟机(VM):

不要在默认的 openshift Galaxy 命名空间中创建虚拟机。相反,创建一个新命名空间或使用没有 openshift 前缀的现有命名空间。

6.1.1.1. 关于金级镜像

金级镜像是虚拟机(VM)的预配置快照,您可以用作部署新虚拟机的资源。例如,您可以使用金级镜像来更加一致地置备相同的系统环境,并更快高效地部署系统。

6.1.1.1.1. 金级镜像如何工作?

通过在参考机器或虚拟机上安装和配置操作系统和软件应用程序来创建金级镜像。这包括设置系统、安装所需的驱动程序、应用补丁和更新以及配置特定选项和首选项。

创建金级镜像后,它会保存为模板或镜像文件,可在多个集群中复制和部署。金级镜像可以通过维护人员定期更新,以纳入必要的软件更新和补丁,确保镜像保持最新且安全,并且新创建的虚拟机基于这个更新的镜像。

6.1.1.1.2. 红帽对金级镜像的实施

对于 Red Hat Enterprise Linux (RHEL) 版本,红帽发布金级镜像作为 registry 中的容器磁盘。容器磁盘是虚拟机镜像,它作为容器镜像 registry 存储在容器镜像 registry 中。安装 OpenShift Virtualization 后,任何发布的镜像将自动在连接的集群中提供。镜像在集群中可用后,可以使用它们创建虚拟机。

6.1.1.2. 关于虚拟机引导源

虚拟机 (VM) 由虚拟机定义以及由数据卷支持的一个或多个磁盘组成。VM 模板允许您使用预定义的规格创建虚拟机。

每个模板都需要一个引导源,它是一个完全配置的磁盘镜像,包括配置的驱动程序。每个模板都包含一个虚拟机定义,其中包含指向引导源的指针。每个引导源都有一个预定义的名称和命名空间。对于某些操作系统,会自动提供一个引导源。如果没有提供,管理员必须准备自定义引导源。

提供的引导源会自动更新至操作系统的最新版本。对于自动更新的引导源,持久性卷声明 (PVC) 和卷快照会使用集群的默认存储类创建。如果在配置后选择了不同的默认存储类,您必须删除使用之前默认存储类配置的集群命名空间中的现有引导源。

6.1.2. 从模板创建虚拟机

您可以使用 Red Hat OpenShift Service on AWS web 控制台从红帽模板创建虚拟机(VM)。

6.1.2.1. 关于虚拟机模板

- 引导源

您可以使用有可用引导源的模板加快虚拟机创建。如果带有引导源的模板没有自定义标签,则会被标记为 Available boot source。

没有引导源的模板被标记为 Boot source required。请参阅从自定义镜像创建虚拟机。

- 自定义

在启动虚拟机前,您可以自定义磁盘源和虚拟机参数:

- 有关磁盘源设置的详情,请参阅存储卷类型和存储字段。

- 有关虚拟机设置的详情,请查看 Overview、YAML 和 Configuration 选项卡文档。

如果您使用所有标签和注解复制虚拟机模板,则当部署新版本的 Scheduling、Scale 和 Performance (SSP) Operator 时,您的模板版本将被标记为已弃用。您可以删除此设计。请参阅使用 Web 控制台自定义虚拟机模板。

- 单节点 OpenShift

-

由于存储行为的区别,一些模板与单节点 OpenShift 不兼容。为确保兼容性,请不要为使用数据卷或存储配置集的模板或虚拟机设置

evictionStrategy字段。

6.1.2.2. 从模板创建虚拟机

您可以使用 Red Hat OpenShift Service on AWS web 控制台从带有可用引导源的模板创建虚拟机(VM)。

可选: 在启动虚拟机前,您可以自定义模板或虚拟机参数,如数据源、cloud-init 或 SSH 密钥。

流程

- 在 web 控制台中进入到 Virtualization → Catalog。

点 Boot source available 来使用引导源过滤模板。

目录显示默认模板。点 All Items 查看您的过滤器的所有可用模板。

- 点模板标题查看其详情。

点 Quick create VirtualMachine 从模板创建虚拟机。

可选:自定义模板或虚拟机参数:

- 点 Customize VirtualMachine。

- 展开 Storage 或 Optional 参数,以编辑数据源设置。

点 Customize VirtualMachine 参数。

Customize and create VirtualMachine 窗格显示 Overview, YAML, Scheduling, Environment, Network interfaces, Disks, Scripts, 和 Metadata 标签页。

- 编辑在虚拟机引导前必须设置的参数,如 cloud-init 或静态 SSH 密钥。

点 Create VirtualMachine。

VirtualMachine 详情页面会显示 provisioning 状态。

6.1.2.2.1. 存储卷类型

表 6.1. 存储卷类型

| Type | 描述 |

|---|---|

| ephemeral | 将网络卷用作只读后备存储的本地写时复制 (COW) 镜像。后备卷必须为 PersistentVolumeClaim。当虚拟机启动并在本地存储所有写入数据时,便会创建临时镜像。当虚拟机停止、重启或删除时,便会丢弃临时镜像。其底层的卷 (PVC) 不会以任何方式发生变化。 |

| persistentVolumeClaim | 将可用 PV 附加到虚拟机。附加 PV 可确保虚拟机数据在会话之间保持。 使用 CDI 将现有虚拟机磁盘导入到 PVC 中,并将 PVC 附加到虚拟机实例,这是将现有虚拟机导入到 Red Hat OpenShift Service on AWS 的建议方法。在 PVC 中使用磁盘需要满足一些要求。 |

| dataVolume |

通过导入、克隆或上传操作来管理虚拟机磁盘的准备过程,以此在

指定 |

| cloudInitNoCloud | 附加包含所引用的 cloud-init NoCloud 数据源的磁盘,从而向虚拟机提供用户数据和元数据。虚拟机磁盘内部需要安装 cloud-init。 |

| containerDisk | 引用容器镜像 registry 中存储的镜像,如虚拟机磁盘。镜像从 registry 中拉取,并在虚拟机启动时作为磁盘附加到虚拟机。

容器镜像 registry 仅支持 RAW 和 QCOW2 格式的磁盘类型。建议使用 QCOW2 格式以减小镜像的大小。 注意

|

| emptyDisk | 创建额外的稀疏 QCOW2 磁盘,与虚拟机接口的生命周期相关联。当虚拟机中的客户端初始化重启后,数据保留下来,但当虚拟机停止或从 web 控制台重启时,数据将被丢弃。空磁盘用于存储应用程序依赖项和数据,否则这些依赖项和数据会超出临时磁盘有限的临时文件系统。 此外还必须提供磁盘容量大小。 |

6.1.2.2.2. 存储字段

| 字段 | 描述 |

|---|---|

| 空白(创建 PVC) | 创建一个空磁盘。 |

| 通过 URL 导入(创建 PVC) | 通过 URL(HTTP 或 HTTPS 端点)导入内容。 |

| 使用现有的 PVC | 使用集群中已可用的 PVC。 |

| 克隆现有的 PVC(创建 PVC) | 选择集群中可用的现有 PVC 并克隆它。 |

| 通过 Registry 导入(创建 PVC) | 通过容器 registry 导入内容。 |

| Name |

磁盘的名称。名称可包含小写字母 ( |

| Size | GiB 中磁盘的大小。 |

| 类型 | 磁盘类型。示例:磁盘或光盘 |

| Interface | 磁盘设备的类型。支持的接口包括 virtIO、SATA 和 SCSI。 |

| Storage class | 用于创建磁盘的存储类。 |

高级存储设置

以下高级存储设置是可选的,对 Blank, Import via URL, and Clone existing PVC 磁盘可用。

如果没有指定这些参数,系统将使用默认存储配置集值。

| 参数 | 选项 | 参数描述 |

|---|---|---|

| 卷模式 | Filesystem | 在基于文件系统的卷中保存虚拟磁盘。 |

| Block |

直接将虚拟磁盘存储在块卷中。只有底层存储支持时才使用 | |

| 访问模式 | ReadWriteOnce (RWO) | 卷可以被一个节点以读写模式挂载。 |

| ReadWriteMany (RWX) | 卷可以被多个节点以读写模式挂载。 注意 实时迁移需要此模式。 |

6.1.2.2.3. 使用 Web 控制台自定义虚拟机模板

在启动虚拟机前,您可以通过修改 VM 或模板参数(如数据源、cloud-init 或 SSH 密钥)来自定义现有虚拟机(VM)模板。如果您通过复制模板并包含其所有标签和注解,则部署新版本的 Scheduling、Scale 和 Performance (SSP) Operator 时,自定义模板将标记为已弃用。

您可以从自定义模板中删除已弃用的设计。

流程

- 在 web 控制台中进入到 Virtualization → Templates。

- 从虚拟机模板列表中,点标记为已弃用的模板。

- 点 Labels 旁边的铅笔图标旁的 Edit。

删除以下两个标签:

-

template.kubevirt.io/type: "base" -

template.kubevirt.io/version: "version"

-

- 点击 Save。

- 点现有 Annotations 数旁边的铅笔图标。

删除以下注解:

-

template.kubevirt.io/deprecated

-

- 点击 Save。

6.1.3. 从实例类型创建虚拟机

您可以使用实例类型简化虚拟机(VM)创建,无论您使用 Red Hat OpenShift Service on AWS web 控制台或 CLI 创建虚拟机。

Red Hat OpenShift Service on AWS 集群支持从 OpenShift Virtualization 4.15 及更高版本中的实例类型创建虚拟机。在 OpenShift Virtualization 4.14 中,从实例类型创建虚拟机是一项技术预览功能,在 Red Hat OpenShift Service on AWS 集群中不被支持。

6.1.3.1. 关于实例类型

实例类型是一种可重复使用的对象,您可以定义应用到新虚拟机的资源和特征。您可以定义自定义实例类型,或使用安装 OpenShift Virtualization 时包括的各种类型。

要创建新实例类型,您必须首先手动创建清单,也可以使用 virtctl CLI 工具创建清单。然后,您可以通过将清单应用到集群来创建实例类型对象。

OpenShift Virtualization 为配置实例类型提供两个 CRD:

-

一个命名空间对象:

VirtualMachineInstancetype -

集群范围的对象:

VirtualMachineClusterInstancetype

这些对象使用相同的 VirtualMachineInstancetypeSpec。

6.1.3.1.1. 所需属性

配置实例类型时,您必须定义 cpu 和 memory 属性。其他属性是可选的。

从实例类型创建虚拟机时,您无法覆盖实例类型中定义的任何参数。

因为实例类型需要定义的 CPU 和内存属性,所以 OpenShift Virtualization 始终会在从实例类型创建虚拟机时拒绝这些资源的额外请求。

您可以手动创建实例类型清单。例如:

带有必填字段的 YAML 文件示例

apiVersion: instancetype.kubevirt.io/v1beta1

kind: VirtualMachineInstancetype

metadata:

name: example-instancetype

spec:

cpu:

guest: 1 1

memory:

guest: 128Mi 2

您可以使用 virtctl CLI 实用程序创建实例类型清单。例如:

带有必填字段的 virtctl 命令示例

$ virtctl create instancetype --cpu 2 --memory 256Mi

其中:

--cpu <value>- 指定要分配给客户机的 vCPU 数量。必需。

--memory <value>- 指定要分配给客户机的内存量。必需。

您可以运行以下命令来立即从新清单中创建对象:

$ virtctl create instancetype --cpu 2 --memory 256Mi | oc apply -f -

6.1.3.1.2. 可选属性

除了所需的 cpu 和 memory 属性外,您还可以在 VirtualMachineInstancetypeSpec 中包含以下可选属性:

annotations- 列出应用到虚拟机的注解。

GPU- 列出用于 passthrough 的 vGPU。

hostDevices- 列出用于透传的主机设备。

ioThreadsPolicy- 定义用于管理专用磁盘访问的 IO 线程策略。

launchSecurity- 配置安全加密虚拟化(SEV)。

nodeSelector- 指定节点选择器来控制调度此虚拟机的节点。

schedulerName- 定义用于此虚拟机的自定义调度程序,而不是默认的调度程序。

6.1.3.2. 预定义的实例类型

OpenShift Virtualization 包括一组预定义的实例类型,称为 common-instancetypes。一些特定于特定工作负载,另一些则与工作负载无关。

这些实例类型资源根据其系列、版本和大小命名。大小值遵循 . delimiter,范围从 nano 到 8xlarge。

表 6.2. common-instancetypes 系列比较

| 使用案例 | 系列 | 特性 | vCPU 到内存比率 | 资源示例 |

|---|---|---|---|---|

| Universal | U |

| 1:4 |

|

| 过量使用 | O |

| 1:4 |

|

| compute-exclusive | CX |

| 1:2 |

|

| NVIDIA GPU | GN |

| 1:4 |

|

| 内存密集型 | M |

| 1:8 |

|

| 网络密集型 | N |

| 1:2 |

|

6.1.3.3. 使用 virtctl 工具创建清单

您可使用 virtctl CLI 实用程序简化为虚拟机、虚拟机实例类型和虚拟机首选项创建清单。如需更多信息,请参阅 虚拟机清单创建命令。

如果您有 VirtualMachine 清单,可以从命令行创建虚拟机。???

6.1.3.4. 使用 Web 控制台从实例类型创建虚拟机

您可以使用 Red Hat OpenShift Service on AWS web 控制台从实例类型创建虚拟机(VM)。您还可以通过复制现有快照或克隆虚拟机,来使用 Web 控制台创建虚拟机。

流程

- 在 web 控制台中,进入到 Virtualization → Catalog,再点 InstanceTypes 选项卡。

选择以下选项之一:

选择一个可引导卷。

注意可引导的卷表仅列出

openshift-virtualization-os-images命名空间中具有instancetype.kubevirt.io/default-preference标签的卷。- 可选:点星号图标将可引导卷指定为热门卷。不足的可引导卷首先出现在卷列表中。

- 点 Add volume 上传新卷,或使用现有的持久性卷声明 (PVC)、卷快照或数据源。然后点保存。

- 点实例类型标题,然后选择适合您的工作负载的资源大小。

- 如果您还没有在项目中添加公共 SSH 密钥,点 VirtualMachine details 部分中的 Authorized SSH key 旁边的编辑图标。

选择以下选项之一:

- 使用现有 :从 secrets 列表中选择一个 secret。

添加新 :

- 浏览到公共 SSH 密钥文件,或在 key 字段中粘贴文件。

- 输入 secret 名称。

- 可选: 选择 Automatically apply this key to any new VirtualMachine you create in this project。

- 点击 Save。

- 可选:点 View YAML & CLI 查看 YAML 文件。点 CLI 查看 CLI 命令。您还可以下载或复制 YAML 文件内容或 CLI 命令。

- 点 Create VirtualMachine。

创建虚拟机后,您可以在 VirtualMachine 详情页中监控状态。

6.1.4. 从命令行创建虚拟机

您可以通过编辑或创建 VirtualMachine 清单来从命令行创建虚拟机 (VM)。您可以使用虚拟机清单中的实例类型来简化虚拟机配置。???

您还可以使用 Web 控制台 从实例类型创建虚拟机。

6.1.4.1. 使用 virtctl 工具创建清单

您可使用 virtctl CLI 实用程序简化为虚拟机、虚拟机实例类型和虚拟机首选项创建清单。如需更多信息,请参阅 虚拟机清单创建命令。

6.1.4.2. 从 VirtualMachine 清单创建虚拟机

您可以从 VirtualMachine 清单创建虚拟机(VM)。

流程

编辑虚拟机的

VirtualMachine清单。以下示例配置 Red Hat Enterprise Linux (RHEL) 虚拟机:注意这个示例清单没有配置虚拟机身份验证。

RHEL 虚拟机的清单示例

apiVersion: kubevirt.io/v1 kind: VirtualMachine metadata: name: rhel-9-minimal spec: dataVolumeTemplates: - metadata: name: rhel-9-minimal-volume spec: sourceRef: kind: DataSource name: rhel9 1 namespace: openshift-virtualization-os-images 2 storage: {} instancetype: name: u1.medium 3 preference: name: rhel.9 4 running: true template: spec: domain: devices: {} volumes: - dataVolume: name: rhel-9-minimal-volume name: rootdisk使用清单文件创建虚拟机:

$ oc create -f <vm_manifest_file>.yaml

可选:启动虚拟机:

$ virtctl start <vm_name> -n <namespace>

后续步骤

6.2. 从自定义镜像创建虚拟机

6.2.1. 从自定义镜像创建虚拟机概述

您可以使用以下方法之一从自定义操作系统镜像创建虚拟机(VM):

可选:您可以为容器磁盘启用自动更新。详情请参阅管理自动引导源更新。

- 从网页导入镜像。

- 从本地计算机上传镜像。

- 克隆包含镜像的持久性卷声明(PVC)。

Containerized Data Importer (CDI) 使用数据卷将镜像导入到 PVC 中。您可以使用 Red Hat OpenShift Service on AWS Web 控制台或命令行将 PVC 添加到虚拟机。

6.2.2. 使用容器磁盘创建虚拟机

您可以使用从操作系统镜像构建的容器磁盘创建虚拟机 (VM)。

您可以为容器磁盘启用自动更新。详情请参阅管理自动引导源更新。

如果容器磁盘较大,I/O 流量可能会增加,并导致 worker 节点不可用。您可以修剪 DeploymentConfig 对象来解决这个问题:

您可以通过执行以下步骤从容器磁盘创建虚拟机:

- 将操作系统镜像构建到容器磁盘中,并将其上传到容器注册表。

- 如果您的容器 registry 没有 TLS,请将您的环境配置为为您的 registry 禁用 TLS。

- 使用 Web 控制台或命令行使用容器磁盘创建虚拟机作为磁盘源。

您必须在从红帽提供的操作系统镜像创建的虚拟机上安装 QEMU 客户机代理。

6.2.2.1. 构建和上传容器磁盘

您可以将虚拟机(VM)镜像构建到容器磁盘中,并将其上传到 registry。

容器磁盘的大小受托管容器磁盘的 registry 的最大层大小的限制。

对于 Red Hat Quay,您可以通过编辑首次部署 Red Hat Quay 时创建的 YAML 配置文件来更改最大层大小。

先决条件

-

必须安装

podman。 - 您必须具有 QCOW2 或 RAW 镜像文件。

流程

创建 Dockerfile 以将虚拟机镜像构建到容器镜像中。虚拟机镜像必须由 QEMU 所有,其 UID 为

107,并放置在容器内的/disk/目录中。/disk/目录的权限必须设为0440。以下示例在第一阶段使用 Red Hat Universal Base Image(UBI)来处理这些配置更改,并使用第二阶段中的最小