시스템 상태 및 성능 모니터링 및 관리

시스템 처리량, 대기 시간 및 전력 소비 최적화

초록

보다 포괄적 수용을 위한 오픈 소스 용어 교체

Red Hat은 코드, 문서, 웹 속성에서 문제가 있는 용어를 교체하기 위해 최선을 다하고 있습니다. 먼저 마스터(master), 슬레이브(slave), 블랙리스트(blacklist), 화이트리스트(whitelist) 등 네 가지 용어를 교체하고 있습니다. 이러한 변경 작업은 작업 범위가 크므로 향후 여러 릴리스에 걸쳐 점차 구현할 예정입니다. 자세한 내용은 CTO Chris Wright의 메시지를 참조하십시오.

Red Hat 문서에 관한 피드백 제공

문서에 대한 피드백에 감사드립니다. 어떻게 개선할 수 있는지 알려주십시오.

Jira를 통해 피드백 제출 (등록 필요)

- Jira 웹 사이트에 로그인합니다.

- 상단 탐색 모음에서 생성 을 클릭합니다.

- Summary (요약) 필드에 설명 제목을 입력합니다.

- Description (설명) 필드에 개선을 위한 제안을 입력합니다. 문서의 관련 부분에 대한 링크를 포함합니다.

- 대화 상자 하단에서 생성 을 클릭합니다.

1장. TuneD 시작하기

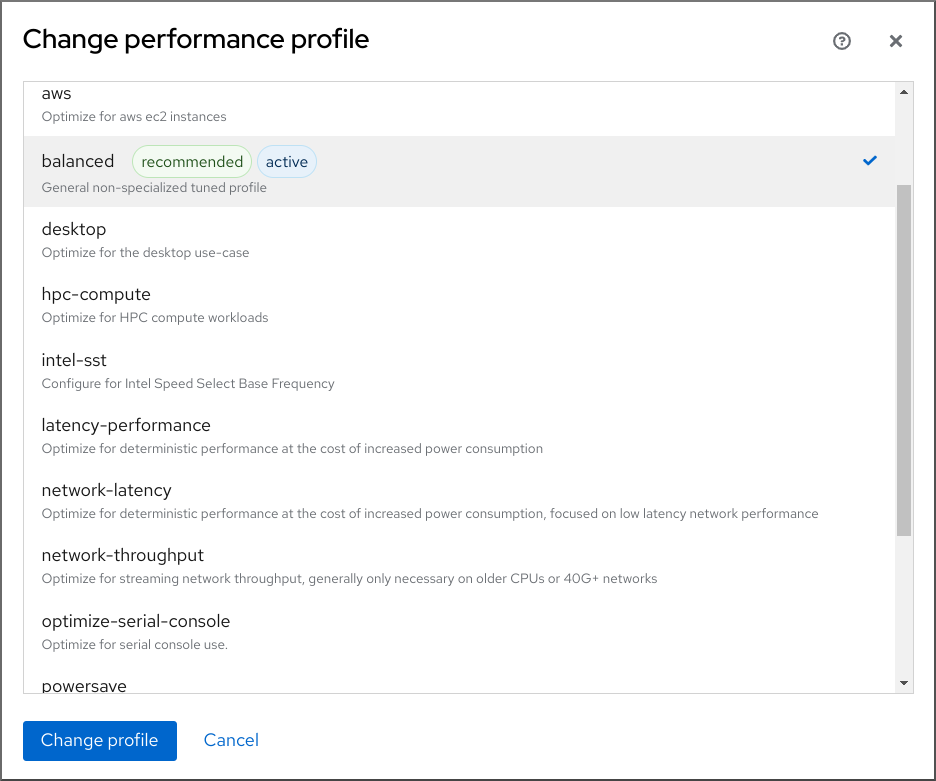

시스템 관리자는 TuneD 애플리케이션을 사용하여 다양한 사용 사례에 맞게 시스템의 성능 프로파일을 최적화할 수 있습니다.

1.1. TuneD의 목적

tuned 는 시스템을 모니터링하고 특정 워크로드에서 성능을 최적화하는 서비스입니다. TuneD 의 코어는 다른 사용 사례에 맞게 시스템을 조정하는 프로필 입니다.

tuned 는 다음과 같은 사용 사례에 대해 사전 정의된 여러 프로필과 함께 배포됩니다.

- 높은 처리량

- 짧은 대기 시간

- 전원 저장

각 프로필에 정의된 규칙을 수정하고 특정 장치를 조정하는 방법을 사용자 지정할 수 있습니다. 다른 프로필로 전환하거나 TuneD 를 비활성화하면 이전 프로필의 시스템 설정에 대한 모든 변경 사항이 원래 상태로 되돌아갑니다.

또한 장치 사용 변경에 대응하고 활성 장치의 성능을 개선하고 비활성 장치의 전력 소비를 줄이기 위해 설정을 조정할 수도 있습니다.

1.2. tuned 프로필

시스템의 상세한 분석은 매우 오래 걸릴 수 있습니다. tuned 는 일반적인 사용 사례에 대해 사전 정의된 여러 프로필을 제공합니다. 프로필을 생성, 수정 및 삭제할 수도 있습니다.

TuneD 로 제공되는 프로필은 다음 범주로 나뉩니다.

- 절전 프로필

- performance-boosting 프로필

performance-boosting 프로필에는 다음과 같은 측면에 중점을 둔 프로필이 포함됩니다.

- 스토리지 및 네트워크에 대한 짧은 대기 시간

- 스토리지 및 네트워크의 높은 처리량

- 가상 머신 성능

- 가상화 호스트 성능

프로필 구성의 구문

tuned.conf 파일에는 하나의 [main] 섹션과 플러그인 인스턴스를 구성하기 위한 다른 섹션을 포함할 수 있습니다. 그러나 모든 섹션은 선택 사항입니다.

해시 기호(#)로 시작하는 행은 주석입니다.

추가 리소스

-

tuned.conf(5)man page.

1.3. 기본 TuneD 프로필

설치하는 동안 시스템에 가장 적합한 프로필이 자동으로 선택됩니다. 현재 기본 프로필은 다음과 같은 사용자 정의 규칙에 따라 선택됩니다.

| 환경 | 기본 프로필 | 목표 |

|---|---|---|

| 컴퓨팅 노드 |

| 최대 처리량 성능 |

| 가상 머신 |

|

최상의 성능. 최상의 성능에 관심이 없는 경우 |

| 기타 사례 |

| 균형 있는 성능 및 전력 소비 |

추가 리소스

-

tuned.conf(5)man page.

1.4. 병합된 TuneD 프로필

실험적 기능으로는 한 번에 더 많은 프로필을 선택할 수 있습니다. tuned 는 로드 중에 병합하려고 합니다.

충돌이 발생하면 마지막으로 지정된 프로필의 설정이 우선합니다.

예 1.1. 가상 게스트의 전력 소비 감소

다음 예제에서는 가상 머신에서 실행하도록 시스템을 최적화하여 최상의 성능을 발휘하고 전력 소비가 낮고 전력 소비가 낮을 때 동시에 조정할 수 있습니다.

# tuned-adm profile virtual-guest powersave

결과 매개변수 조합이 의미가 있는지 확인하지 않고 병합이 자동으로 수행됩니다. 결과적으로 이 기능은 일부 매개 변수를 반대로 튜닝할 수 있습니다. 예를 들어, counterproductive일 수 있습니다. 예를 들어 throughput-performance 프로필을 사용하여 높은 처리량에 대해 디스크를 설정하고, 디스크 회전을 spindown-disk 프로필을 통해 낮은 값으로 디스크를 설정할 수 있습니다.

추가 리소스

*tuned-adm man 페이지. * tuned.conf(5) man page.

1.5. TuneD 프로필의 위치

tuned 는 프로필을 다음 디렉터리에 저장합니다.

/usr/lib/tuned/-

배포별 프로필은 디렉터리에 저장됩니다. 각 프로필에는 자체 디렉터리가 있습니다. 프로필은

tuned.conf라는 기본 구성 파일과 선택적으로 기타 파일(예: 도우미 스크립트)으로 구성됩니다. /etc/tuned/-

프로필을 사용자 지정해야 하는 경우 사용자 지정 프로필에 사용되는 디렉터리에 프로필 디렉터리를 복사합니다. 동일한 이름의 프로필이 두 개 있는 경우

/etc/tuned/에 있는 사용자 지정 프로필이 사용됩니다.

추가 리소스

-

tuned.conf(5)man page.

1.6. RHEL을 사용하여 배포된 tuned 프로필

다음은 Red Hat Enterprise Linux에서 TuneD 와 함께 설치된 프로필 목록입니다.

제품별 또는 타사 TuneD 프로필이 더 있을 수 있습니다. 이러한 프로필은 일반적으로 별도의 RPM 패키지로 제공됩니다.

balanced기본 power- saving 프로필. 이는 성능과 전력 소비 간의 절충을 위한 것입니다. 가능한 경우 자동 확장 및 자동 튜닝을 사용합니다. 유일한 단점은 대기 시간이 증가하는 것입니다. 현재 TuneD 릴리스에서는 CPU, 디스크, 오디오 및 비디오 플러그인을 활성화하고

보존CPU governor를 활성화합니다.radeon_powersave옵션은 지원되는 경우dpm-balanced값을 사용합니다. 그러지 않으면auto로 설정됩니다.energy_performance_preference특성을일반적인에너지 설정으로 변경합니다. 또한scaling_governorpolicy 속성을보존하거나 CPU governor로 변경합니다.powersave최대 성능 절약을 위한 프로필입니다. 실제 전력 소비를 최소화하기 위해 성능을 제한할 수 있습니다. 현재 TuneD 릴리스에서는 SATA 호스트 어댑터의 USB 자동 일시 중지, WiFi 전원 저장 및 Aggressive Link Power Management (ALPM) 전원 절약 기능을 사용할 수 있습니다. 또한 정전 비율이 낮은 시스템의 멀티 코어 전력 절감을 예약하고

온디맨드governor를 활성화합니다. 이는 AC97 오디오 전력 절약을 가능하게 하거나, 시스템에 따라 10초의 시간 초과로HDA-Intel의 전력 절약을 가능하게 합니다. 시스템에 KMS가 활성화된 지원되는 Radeon 그래픽 카드가 포함된 경우 프로필은 자동 전원 저장으로 구성합니다. ASUS Eee PC에서는 동적 슈퍼 하이브리드 엔진을 사용할 수 있습니다.energy_performance_preference속성을powersave또는powerenergy setting로 변경합니다. 또한scaling_governor정책 속성을온 디맨드또는절전CPU governor로 변경합니다.참고경우에 따라

balanced프로파일은powersave프로필에 비해 더 효율적입니다.예를 들어 트랜스코딩이 필요한 비디오 파일 등 수행해야 하는 정의된 작업 양을 고려하십시오. 작업이 빠르게 완료되기 때문에 트랜스코딩이 전체 전원에서 수행되면 컴퓨터가 더 적은 전력을 소비할 수 있으며 머신이 유휴 상태로 시작되고 매우 효율적인 전력 절약 모드로 자동 전환될 수 있습니다. 반면, 스로틀링된 시스템으로 파일을 트랜스코딩하는 경우 시스템은 트랜스코딩 중에 전력을 적게 소비하지만 프로세스는 더 오래 걸리고 전반적으로 소비된 전력이 더 높을 수 있습니다.

따라서

균형 잡힌프로필은 일반적으로 더 나은 옵션이 될 수 있습니다.throughput-performance높은 처리량에 최적화된 서버 프로필입니다. 전원 절감 메커니즘을 비활성화하고 디스크 및 네트워크 IO의 처리량 성능을 향상시키는

sysctl설정을 활성화합니다. CPU governor가성능으로 설정됩니다.energy_performance_preference및scaling_governor속성을성능프로필로 변경합니다.accelerator-performance-

액셀러레이터-성능 프로파일에는throughput-performance프로필과 동일한 튜닝이 포함되어 있습니다. 또한 CPU가 낮은 C 상태로 잠금되므로 대기 시간이 100us 미만입니다. 이를 통해 GPU와 같은 특정 가속기의 성능이 향상됩니다. latency-performance짧은 대기 시간을 위해 최적화된 서버 프로필입니다. 전원 절감 메커니즘을 비활성화하고 대기 시간을 개선하는

sysctl설정을 활성화합니다. CPU governor가성능으로 설정되어 CPU가 낮은 C 상태(PM QoS에 의해)에 고정됩니다.energy_performance_preference및scaling_governor속성을성능프로필로 변경합니다.network-latency대기 시간이 짧은 네트워크 튜닝을 위한 프로필입니다.

latency-performance프로필을 기반으로 합니다. 또한 투명한 대규모 페이지 및 NUMA 분산을 비활성화하고 다른 여러 네트워크 관련sysctl매개변수를 튜닝합니다.latency-performance프로필을 상속하여energy_performance_preference및scaling_governor속성을성능프로필로 변경합니다.hpc-compute-

고성능 컴퓨팅에 최적화된 프로필입니다.

latency-performance프로필을 기반으로 합니다. network-throughput처리량 네트워크 튜닝을 위한 프로필입니다.

throughput-performance프로필을 기반으로 합니다. 커널 네트워크 버퍼를 추가로 늘립니다.latency-performance또는throughput-performance프로필을 상속하고,energy_performance_preference및scaling_governor속성을성능프로필로 변경합니다.virtual-guestRed Hat Enterprise Linux 9 가상 시스템용으로 설계된 프로필과

throughput-performance프로필 중 다른 작업 중 하나를 기반으로 하는 VMWare 게스트로, 가상 메모리 스왑piness 감소 및 디스크 readahead 값이 증가합니다. 디스크 장벽을 비활성화하지 않습니다.throughput-performance프로필을 상속하고energy_performance_preference및scaling_governor속성을성능프로필로 변경합니다.virtual-hostthroughput-performance프로필을 기반으로 하는 가상 호스트를 위해 설계된 프로필로, 다른 작업 중에 가상 메모리 스왑piness를 줄이며, 디스크 readahead 값을 늘리며, 더 공격적인 더티 페이지 쓰기 값을 활성화합니다.throughput-performance프로필을 상속하고energy_performance_preference및scaling_governor속성을성능프로필로 변경합니다.Oracle-

Oracle 데이터베이스에 최적화된 프로필은

throughput-performance프로필을 기반으로 로드됩니다. 또한 투명한 대규모 페이지를 비활성화하고 기타 성능 관련 커널 매개변수를 수정합니다. 이 프로필은tuned-profiles-oracle패키지에서 제공합니다. desktop-

balanced프로필을 기반으로 하는 데스크탑에 최적화된 프로필입니다. 또한 스케줄러 자동 그룹을 활성화하여 대화형 애플리케이션의 대응을 개선할 수 있습니다. optimize-serial-consoleprintk 값을 줄임으로써 직렬 콘솔에 I/O 활동을 조정하는 프로필입니다. 직렬 콘솔의 응답성이 향상되어야 합니다. 이 프로필은 다른 프로필에서 오버레이로 사용하기 위한 것입니다. 예를 들어 다음과 같습니다.

# tuned-adm profile throughput-performance optimize-serial-console

mssql-

Microsoft SQL Server에 제공된 프로필입니다.

throughput-performance프로필을 기반으로 합니다. intel-sst사용자 정의 Intel Speed Select Technology 구성이 있는 시스템에 최적화된 프로필입니다. 이 프로필은 다른 프로필에서 오버레이로 사용하기 위한 것입니다. 예를 들어 다음과 같습니다.

# tuned-adm profile cpu-partitioning intel-sst

1.7. tuned cpu-partitioning 프로필

대기 시간에 민감한 워크로드에 맞게 Red Hat Enterprise Linux 9를 튜닝하려면 cpu-partitioning TuneD 프로필을 사용하는 것이 좋습니다.

Red Hat Enterprise Linux 9 이전에는 대기 시간이 짧은 Red Hat 문서에서는 대기 시간이 짧은 튜닝을 수행하는 데 필요한 수많은 낮은 수준의 단계를 설명했습니다. Red Hat Enterprise Linux 9에서는 cpu-partitioning TuneD 프로필을 사용하여 대기 시간이 짧은 튜닝을 보다 효율적으로 수행할 수 있습니다. 이 프로필은 대기 시간이 짧은 개별 애플리케이션의 요구 사항에 따라 쉽게 사용자 지정할 수 있습니다.

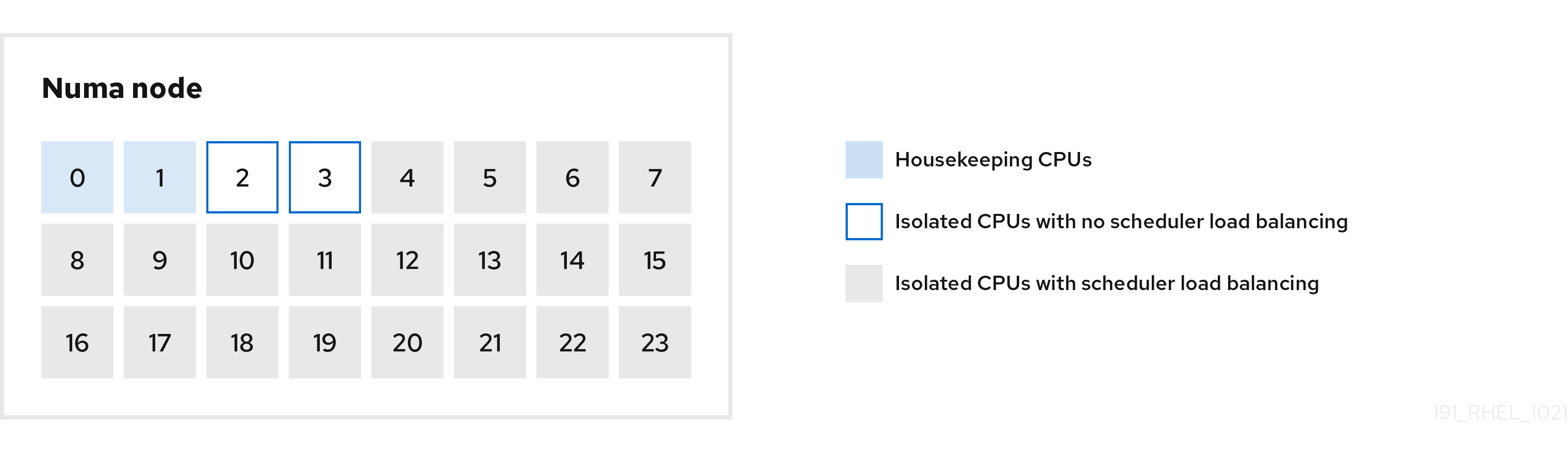

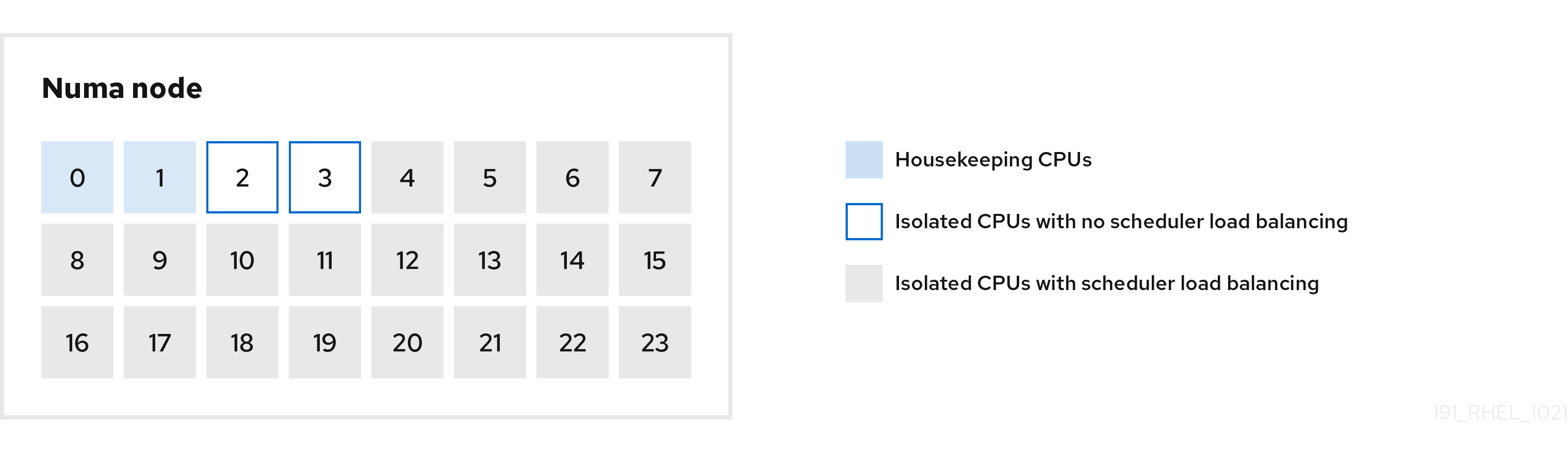

다음 그림은 cpu-partitioning 프로필을 사용하는 방법을 보여줍니다. 이 예에서는 CPU 및 노드 레이아웃을 사용합니다.

그림 1.1. figure cpu-partitioning

다음 구성 옵션을 사용하여 /etc/tuned/cpu-partitioning-ECDHEs.conf 파일에서 cpu-partitioning 프로필을 구성할 수 있습니다.

- 로드 밸런싱이 있는 격리된 CPU

cpu-partitioning figure에서 4에서 23으로 번호가 매겨진 블록은 기본 분리된 CPU입니다. 커널 스케줄러의 프로세스 부하 분산이 이러한 CPU에서 활성화됩니다. 커널 스케줄러 부하 분산이 필요한 여러 스레드가 있는 대기 시간이 짧은 프로세스를 위해 설계되었습니다.

kernel 스케줄러 로드 밸런싱을 사용할 CPU를 나열하는

isolated_cores=프로필을 구성할 수 있습니다.cpu-list옵션을 사용하여 /etc/tuned/cpu-partitions.conf 파일에서 cpu-partitioning분리된 CPU 목록은 쉼표로 구분하거나 dash(예: )를 사용하여 범위를 지정할 수

있습니다. 이 옵션은 필수입니다. 이 목록에서 누락된 CPU는 자동으로 하우스키핑 CPU로 간주됩니다.- 로드 밸런싱이 없는 격리된 CPU

cpu-partitioning 그림에서 번호가 지정된 블록 2와 3은 추가 커널 스케줄러 프로세스 부하 분산을 제공하지 않는 격리된 CPU입니다.

커널 스케줄러 로드 밸런싱을 사용하지 않는 CPU를 나열하는

no_balance_cores=프로필을 구성할 수 있습니다.cpu-list옵션을 사용하여 /etc/tuned/cpu-partitions.conf 파일에서 cpu-partitioningno_balance_cores옵션을 지정하는 것은 선택 사항이지만 이 목록의 모든 CPU는isolated_cores목록에 나열된 CPU의 하위 집합이어야 합니다.이러한 CPU를 사용하는 애플리케이션 스레드를 각 CPU에 개별적으로 고정해야 합니다.

- 하우스키핑 CPU

-

cpu-partitioning-postgresqls.conf파일에서 분리된 CPU는 자동으로 하우스키핑 CPU로 간주됩니다. 하우스키핑 CPU에서 모든 서비스, 데몬, 사용자 프로세스, 이동 가능한 커널 스레드, 인터럽트 처리기, 커널 타이머를 실행할 수 있습니다.

추가 리소스

-

tuned-profiles-cpu-partitioning(7)man page

1.8. 대기 시간이 짧은 튜닝을 위해 TuneD cpu-partitioning 프로파일 사용

이 프로세스에서는 TuneD의 cpu-partitioning 프로필을 사용하여 대기 시간이 짧은 시스템을 조정하는 방법을 설명합니다. cpu-partitioning 및 cpu-partitioning 수치에 언급된 CPU 레이아웃을 사용할 수 있는 대기 시간이 짧은 애플리케이션의 예를 사용합니다.

이 경우 애플리케이션은 다음을 사용합니다.

- 네트워크에서 데이터를 읽는 하나의 전용 리더 스레드가 CPU 2에 고정되어 있습니다.

- 이 네트워크 데이터를 처리하는 많은 수의 스레드가 CPU 4-23에 고정되어 있습니다.

- 처리된 데이터를 네트워크에 쓰는 전용 작성기 스레드는 CPU 3에 고정되어 있습니다.

사전 요구 사항

-

dnf install tuned-profiles-을 설치했습니다.cpu-partitioning명령을 root로 사용하여 cpu-partitioning TuneD 프로필

절차

/etc/tuned/cpu-partitioning-ECDHEs.conf파일을 편집하고 다음 정보를 추가합니다.# All isolated CPUs: isolated_cores=2-23 # Isolated CPUs without the kernel’s scheduler load balancing: no_balance_cores=2,3

cpu-partitioningTuneD 프로필을 설정합니다.# tuned-adm profile cpu-partitioning

reboot

재부팅 후 cpu-partitioning figure의 격리에 따라 대기 시간이 짧아지도록 시스템이 조정됩니다. 애플리케이션은 taskset을 사용하여 reader 및 writer 스레드를 2 및 3에 고정하고 CPU 4-23의 나머지 애플리케이션 스레드를 CPU 2 및 3에 고정할 수 있습니다.

추가 리소스

-

tuned-profiles-cpu-partitioning(7)man page

1.9. cpu-partitioning TuneD 프로파일 사용자 정의

TuneD 프로필을 확장하여 추가 튜닝을 변경할 수 있습니다.

예를 들어 cpu-partitioning 프로필은 CPU가 cstate=1 을 사용하도록 설정합니다. cpu-partitioning 프로필을 사용하지만 CPU cstate를 cstate1에서 cstate0으로 추가로 변경하려면 다음 절차에서는 cpu-partitioning 프로필을 상속하고 C state-0을 설정하는 my_profile 이라는 새 TuneD 프로필을 설명합니다.

절차

/etc/tuned/my_profile디렉토리를 만듭니다.# mkdir /etc/tuned/my_profile이 디렉터리에

tuned.conf파일을 생성하고 다음 콘텐츠를 추가합니다.# vi /etc/tuned/my_profile/tuned.conf [main] summary=Customized tuning on top of cpu-partitioning include=cpu-partitioning [cpu] force_latency=cstate.id:0|1새 프로필을 사용합니다.

# tuned-adm profile my_profile

공유 예에서는 재부팅이 필요하지 않습니다. 그러나 my_profile 프로필의 변경 사항을 적용하려면 재부팅을 수행한 다음 시스템을 재부팅합니다.

추가 리소스

-

tuned-profiles-cpu-partitioning(7)man page

1.10. RHEL을 사용하여 실시간 TuneD 프로필 배포

실시간 프로필은 실시간 커널을 실행하는 시스템을 위한 것입니다. 특별한 커널 빌드가 없으면 시스템을 실시간으로 구성하지 않습니다. RHEL에서는 추가 리포지토리에서 프로필을 사용할 수 있습니다.

다음 실시간 프로필을 사용할 수 있습니다.

realtime베어메탈 실시간 시스템에서 를 사용합니다.

RT 또는 NFV 리포지토리에서 사용할 수 있는

tuned-profiles-realtime패키지에서 제공합니다.realtime-virtual-host실시간으로 구성된 가상화 호스트에서 를 사용합니다.

NFV 리포지토리에서 사용할 수 있는

tuned-profiles-nfv-host패키지에서 제공합니다.realtime-virtual-guest실시간으로 구성된 가상화 게스트에서 를 사용합니다.

NFV 리포지토리에서 사용할 수 있는

tuned-profiles-nfv-guest패키지에서 제공합니다.

1.11. TuneD의 정적 및 동적 튜닝

TuneD 가 적용하는 시스템 튜닝의 두 가지 범주의 차이점을 이해하는 것은 지정된 상황 또는 목적에 사용할 대상을 결정하는 경우 중요합니다.

- 정적 튜닝

-

주로 사전 정의된

sysctl및sysfs설정 애플리케이션과 함께ethtool과 같은 여러 구성 툴의 일회성 활성화로 구성됩니다. - 동적 튜닝

시스템의 가동 시간 동안 다양한 시스템 구성 요소가 사용되는 방식을 감시합니다. tuned 는 모니터링 정보를 기반으로 시스템 설정을 동적으로 조정합니다.

예를 들어 하드 드라이브는 시작 및 로그인 중에 크게 사용되지만 나중에 사용자가 주로 웹 브라우저 또는 이메일 클라이언트 같은 애플리케이션에서 작업할 수 있는 경우 거의 사용되지 않습니다. 마찬가지로 CPU 및 네트워크 장치는 다른 시간에 다르게 사용됩니다. tuned 는 이러한 구성 요소의 활동을 모니터링하고 사용 중인 변경 사항에 반응합니다.

동적 튜닝은 기본적으로 비활성화되어 있습니다. 이를 활성화하려면

/etc/tuned/tuned-main.conf파일을 편집하고dynamic_tuning옵션을1로 변경합니다. 그런 다음 tuned는 정기적으로 시스템 통계를 분석하고 이를 사용하여 시스템 튜닝 설정을 업데이트합니다. 이러한 업데이트 사이의 시간 간격을 초 단위로 구성하려면update_interval옵션을 사용합니다.현재 동적 튜닝 알고리즘은 성능 및 절전의 균형을 유지하려고 시도하므로 성능 프로필에서 비활성화됩니다. 개별 플러그인에 대한 동적 튜닝은 TuneD 프로필에서 활성화하거나 비활성화할 수 있습니다.

예 1.2. 워크스테이션의 정적 및 동적 튜닝

일반적인 사무실 워크스테이션에서 이더넷 네트워크 인터페이스는 대부분의 시간 동안 비활성화됩니다. 일부 이메일만 들어오거나 나가거나 일부 웹 페이지가 로드될 수 있습니다.

이러한 종류의 로드의 경우 네트워크 인터페이스는 기본적으로와 같이 항상 전체 속도로 실행할 필요가 없습니다. tuned 에는 이 낮은 활동을 감지한 다음 해당 인터페이스의 속도를 자동으로 낮추어 일반적으로 전력 사용량을 줄일 수 있는 네트워크 장치에 대한 모니터링 및 튜닝 플러그인이 있습니다.

인터페이스의 활동이 더 긴 기간 동안 증가하는 경우, 예를 들어 DVD 이미지가 다운로드되고 있는 이메일이나 큰 첨부 파일이 있는 이메일이 열리기 때문에, TuneD 는 이를 감지하고 활동 수준이 높은 동안 최상의 성능을 제공하기 위해 인터페이스 속도를 최대로 설정합니다.

이 원칙은 CPU 및 디스크의 다른 플러그인에도 사용됩니다.

1.12. tuned no-daemon 모드

no-daemon 모드에서 TuneD 를 실행하면 상주 메모리가 필요하지 않습니다. 이 모드에서 TuneD 는 설정을 적용하고 종료합니다.

이 모드에서는 다음을 포함하여 많은 TuneD 기능이 없기 때문에 기본적으로 no-daemon 모드가 비활성화되어 있습니다.

- D-Bus 지원

- 핫플러그 지원

- 설정 롤백 지원

no-daemon 모드를 활성화하려면 /etc/tuned/tuned-main.conf 파일에 다음 행을 포함합니다.

daemon = 0

1.13. TuneD 설치 및 활성화

이 절차에서는 TuneD 애플리케이션을 설치 및 활성화하고, TuneD 프로필을 설치하며, 시스템의 기본 TuneD 프로필을 사전 설정합니다.

절차

TuneD패키지를 설치합니다.# dnf install tuned

TuneD서비스를 활성화하고 시작합니다.# systemctl enable --now tuned

필요한 경우 실시간 시스템에 대한 TuneD 프로필을 설치합니다.

실시간 시스템의 TuneD 프로필의 경우

rhel-9리포지토리를 활성화합니다.# subscription-manager repos --enable=rhel-9-for-x86_64-nfv-beta-rpms

설치합니다.

# dnf install tuned-profiles-realtime tuned-profiles-nfv

TuneD 프로필이 활성화되어 적용되는지 확인합니다.

$ tuned-adm active Current active profile: throughput-performance참고활성 프로필 TuneD는 머신 유형 및 시스템 설정에 따라 자동으로 사전 설정됩니다.

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

1.14. 사용 가능한 TuneD 프로필 나열

다음 절차에서는 시스템에서 현재 사용 가능한 모든 TuneD 프로필을 나열합니다.

절차

시스템에서 사용 가능한 모든 TuneD 프로필을 나열하려면 다음을 사용합니다.

$ tuned-adm list Available profiles: - accelerator-performance - Throughput performance based tuning with disabled higher latency STOP states - balanced - General non-specialized TuneD profile - desktop - Optimize for the desktop use-case - latency-performance - Optimize for deterministic performance at the cost of increased power consumption - network-latency - Optimize for deterministic performance at the cost of increased power consumption, focused on low latency network performance - network-throughput - Optimize for streaming network throughput, generally only necessary on older CPUs or 40G+ networks - powersave - Optimize for low power consumption - throughput-performance - Broadly applicable tuning that provides excellent performance across a variety of common server workloads - virtual-guest - Optimize for running inside a virtual guest - virtual-host - Optimize for running KVM guests Current active profile: balanced

현재 활성화된 프로필만 표시하려면 다음을 사용합니다.

$ tuned-adm active Current active profile: throughput-performance

추가 리소스

-

tuned-adm(8)man page.

1.15. TuneD 프로필 설정

이 절차에서는 시스템에서 선택한 TuneD 프로필을 활성화합니다.

사전 요구 사항

-

TuneD서비스가 실행 중입니다. 자세한 내용은 TuneD 설치 및 활성화를 참조하십시오.

절차

필요한 경우 TuneD 가 시스템에 가장 적합한 프로필을 권장하도록 할 수 있습니다.

# tuned-adm recommend throughput-performance프로필을 활성화합니다.

# tuned-adm profile selected-profile또는 여러 프로필의 조합을 활성화할 수도 있습니다.

# tuned-adm profile selected-profile1 selected-profile2

예 1.3. 낮은 전력 사용을 위해 최적화된 가상 머신

다음 예제에서는 시스템을 최적화하여 최상의 성능을 갖춘 가상 시스템에서 실행하고 전력 소비가 낮은 전력을 위해 동시에 튜닝하는 것이 우선 순위입니다.

# tuned-adm profile virtual-guest powersave

시스템에서 현재 활성화된 TuneD 프로필을 확인합니다.

# tuned-adm active Current active profile: selected-profile시스템을 재부팅합니다.

# reboot

검증 단계

TuneD 프로필이 활성화되어 적용되는지 확인합니다.

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

추가 리소스

-

tuned-adm(8)man page

1.16. TuneD D-Bus 인터페이스 사용

TuneD D-Bus 인터페이스를 통해 런타임 시 TuneD와 직접 통신하여 다양한 TuneD 서비스를 제어할 수 있습니다.

busctl 또는 dbus-send 명령을 사용하여 D-Bus API에 액세스할 수 있습니다.

busctl 또는 dbus-send 명령을 사용할 수 있지만 busctl 명령은 systemd 의 일부이므로 이미 대부분의 호스트에 있습니다.

1.16.1. TuneD D-Bus 인터페이스를 사용하여 사용 가능한 TuneD D-Bus API 방법 표시

TuneD D-Bus 인터페이스를 사용하여 TuneD와 함께 사용할 수 있는 D-Bus API 메서드를 확인할 수 있습니다.

사전 요구 사항

- TuneD 서비스가 실행 중입니다. 자세한 내용은 TuneD 설치 및 활성화를 참조하십시오.

절차

사용 가능한 TuneD API 방법을 보려면 다음을 실행합니다.

$ busctl introspect com.redhat.tuned /Tuned com.redhat.tuned.control

출력은 다음과 유사해야 합니다.

NAME TYPE SIGNATURE RESULT/VALUE FLAGS .active_profile method - s - .auto_profile method - (bs) - .disable method - b - .get_all_plugins method - a{sa{ss}} - .get_plugin_documentation method s s - .get_plugin_hints method s a{ss} - .instance_acquire_devices method ss (bs) - .is_running method - b - .log_capture_finish method s s - .log_capture_start method ii s - .post_loaded_profile method - s - .profile_info method s (bsss) - .profile_mode method - (ss) - .profiles method - as - .profiles2 method - a(ss) - .recommend_profile method - s - .register_socket_signal_path method s b - .reload method - b - .start method - b - .stop method - b - .switch_profile method s (bs) - .verify_profile method - b - .verify_profile_ignore_missing method - b - .profile_changed signal sbs - -TuneD 업스트림 리포지토리에서 사용 가능한 다양한 방법에 대한 설명을 찾을 수 있습니다.

1.16.2. TuneD D-Bus 인터페이스를 사용하여 활성 TuneD 프로필 변경

TuneD D-Bus 인터페이스를 사용하여 활성 TuneD 프로필을 원하는 TuneD 프로필로 교체할 수 있습니다.

사전 요구 사항

- TuneD 서비스가 실행 중입니다. 자세한 내용은 TuneD 설치 및 활성화를 참조하십시오.

절차

활성 TuneD 프로필을 변경하려면 다음을 실행합니다.

$ busctl call com.redhat.tuned /Tuned com.redhat.tuned.control switch_profile s profile (bs) true "OK"프로필을 원하는 프로필의 이름으로 바꿉니다.

검증

현재 활성화된 TuneD 프로필을 보려면 다음을 실행합니다.

$ busctl call com.redhat.tuned /Tuned com.redhat.tuned.control active_profile s "profile"

1.17. TuneD 비활성화

이 절차에서는 TuneD 를 비활성화하고 TuneD 를 변경하기 전에 영향을 받는 모든 시스템 설정을 원래 상태로 재설정합니다.

절차

모든 튜닝을 일시적으로 비활성화하려면 다음을 수행합니다.

# tuned-adm off

TuneD서비스를 다시 시작한 후 튜닝이 다시 적용됩니다.또는

TuneD서비스를 영구적으로 중지하고 비활성화하려면 다음을 수행합니다.# systemctl disable --now tuned

추가 리소스

-

tuned-adm(8)man page

2장. TuneD 프로필 사용자 정의

TuneD 프로필을 생성하거나 수정하여 원하는 사용 사례에 맞게 시스템 성능을 최적화할 수 있습니다.

사전 요구 사항

- 자세한 내용은 TuneD 설치 및 Enabling TuneD에 설명된 대로 TuneD 를 설치하고 활성화합니다.

2.1. tuned 프로필

시스템의 상세한 분석은 매우 오래 걸릴 수 있습니다. tuned 는 일반적인 사용 사례에 대해 사전 정의된 여러 프로필을 제공합니다. 프로필을 생성, 수정 및 삭제할 수도 있습니다.

TuneD 로 제공되는 프로필은 다음 범주로 나뉩니다.

- 절전 프로필

- performance-boosting 프로필

performance-boosting 프로필에는 다음과 같은 측면에 중점을 둔 프로필이 포함됩니다.

- 스토리지 및 네트워크에 대한 짧은 대기 시간

- 스토리지 및 네트워크의 높은 처리량

- 가상 머신 성능

- 가상화 호스트 성능

프로필 구성의 구문

tuned.conf 파일에는 하나의 [main] 섹션과 플러그인 인스턴스를 구성하기 위한 다른 섹션을 포함할 수 있습니다. 그러나 모든 섹션은 선택 사항입니다.

해시 기호(#)로 시작하는 행은 주석입니다.

추가 리소스

-

tuned.conf(5)man page.

2.2. 기본 TuneD 프로필

설치하는 동안 시스템에 가장 적합한 프로필이 자동으로 선택됩니다. 현재 기본 프로필은 다음과 같은 사용자 정의 규칙에 따라 선택됩니다.

| 환경 | 기본 프로필 | 목표 |

|---|---|---|

| 컴퓨팅 노드 |

| 최대 처리량 성능 |

| 가상 머신 |

|

최상의 성능. 최상의 성능에 관심이 없는 경우 |

| 기타 사례 |

| 균형 있는 성능 및 전력 소비 |

추가 리소스

-

tuned.conf(5)man page.

2.3. 병합된 TuneD 프로필

실험적 기능으로는 한 번에 더 많은 프로필을 선택할 수 있습니다. tuned 는 로드 중에 병합하려고 합니다.

충돌이 발생하면 마지막으로 지정된 프로필의 설정이 우선합니다.

예 2.1. 가상 게스트의 전력 소비 감소

다음 예제에서는 가상 머신에서 실행하도록 시스템을 최적화하여 최상의 성능을 발휘하고 전력 소비가 낮고 전력 소비가 낮을 때 동시에 조정할 수 있습니다.

# tuned-adm profile virtual-guest powersave

결과 매개변수 조합이 의미가 있는지 확인하지 않고 병합이 자동으로 수행됩니다. 결과적으로 이 기능은 일부 매개 변수를 반대로 튜닝할 수 있습니다. 예를 들어, counterproductive일 수 있습니다. 예를 들어 throughput-performance 프로필을 사용하여 높은 처리량에 대해 디스크를 설정하고, 디스크 회전을 spindown-disk 프로필을 통해 낮은 값으로 디스크를 설정할 수 있습니다.

추가 리소스

*tuned-adm man 페이지. * tuned.conf(5) man page.

2.4. TuneD 프로필의 위치

tuned 는 프로필을 다음 디렉터리에 저장합니다.

/usr/lib/tuned/-

배포별 프로필은 디렉터리에 저장됩니다. 각 프로필에는 자체 디렉터리가 있습니다. 프로필은

tuned.conf라는 기본 구성 파일과 선택적으로 기타 파일(예: 도우미 스크립트)으로 구성됩니다. /etc/tuned/-

프로필을 사용자 지정해야 하는 경우 사용자 지정 프로필에 사용되는 디렉터리에 프로필 디렉터리를 복사합니다. 동일한 이름의 프로필이 두 개 있는 경우

/etc/tuned/에 있는 사용자 지정 프로필이 사용됩니다.

추가 리소스

-

tuned.conf(5)man page.

2.5. TuneD 프로필 간 상속

tuned 프로필은 다른 프로필을 기반으로 하며 해당 상위 프로필의 특정 측면만 수정할 수 있습니다.

TuneD 프로파일의 [main] 섹션은 include 옵션을 인식합니다.

[main]

include=parent부모 프로필의 모든 설정은 이 하위 프로필에 로드됩니다. 다음 섹션의 하위 프로필은 상위 프로필에서 상속된 특정 설정을 재정의하거나 상위 프로필에 없는 새 설정을 추가할 수 있습니다.

일부 매개변수만 조정된 /usr/lib/tuned/ 의 사전 설치된 프로필을 기반으로 /etc/tuned/ 디렉터리에 자체 하위 프로필을 생성할 수 있습니다.

TuneD 업그레이드 후와 같이 상위 프로필이 업데이트되면 변경 사항이 하위 프로필에 반영됩니다.

예 2.2. 균형을 기반으로 한 전력 절감 프로필

다음은 균형 있는 프로필을 확장하고 모든 장치에 대한 Aggressive Link Power Management (ALPM)를 최대 전력으로 설정하는 사용자 정의 프로필의 예입니다.

[main] include=balanced [scsi_host] alpm=min_power

추가 리소스

-

tuned.conf(5)man page

2.6. TuneD의 정적 및 동적 튜닝

TuneD 가 적용하는 시스템 튜닝의 두 가지 범주의 차이점을 이해하는 것은 지정된 상황 또는 목적에 사용할 대상을 결정하는 경우 중요합니다.

- 정적 튜닝

-

주로 사전 정의된

sysctl및sysfs설정 애플리케이션과 함께ethtool과 같은 여러 구성 툴의 일회성 활성화로 구성됩니다. - 동적 튜닝

시스템의 가동 시간 동안 다양한 시스템 구성 요소가 사용되는 방식을 감시합니다. tuned 는 모니터링 정보를 기반으로 시스템 설정을 동적으로 조정합니다.

예를 들어 하드 드라이브는 시작 및 로그인 중에 크게 사용되지만 나중에 사용자가 주로 웹 브라우저 또는 이메일 클라이언트 같은 애플리케이션에서 작업할 수 있는 경우 거의 사용되지 않습니다. 마찬가지로 CPU 및 네트워크 장치는 다른 시간에 다르게 사용됩니다. tuned 는 이러한 구성 요소의 활동을 모니터링하고 사용 중인 변경 사항에 반응합니다.

동적 튜닝은 기본적으로 비활성화되어 있습니다. 이를 활성화하려면

/etc/tuned/tuned-main.conf파일을 편집하고dynamic_tuning옵션을1로 변경합니다. 그런 다음 tuned는 정기적으로 시스템 통계를 분석하고 이를 사용하여 시스템 튜닝 설정을 업데이트합니다. 이러한 업데이트 사이의 시간 간격을 초 단위로 구성하려면update_interval옵션을 사용합니다.현재 동적 튜닝 알고리즘은 성능 및 절전의 균형을 유지하려고 시도하므로 성능 프로필에서 비활성화됩니다. 개별 플러그인에 대한 동적 튜닝은 TuneD 프로필에서 활성화하거나 비활성화할 수 있습니다.

예 2.3. 워크스테이션의 정적 및 동적 튜닝

일반적인 사무실 워크스테이션에서 이더넷 네트워크 인터페이스는 대부분의 시간 동안 비활성화됩니다. 일부 이메일만 들어오거나 나가거나 일부 웹 페이지가 로드될 수 있습니다.

이러한 종류의 로드의 경우 네트워크 인터페이스는 기본적으로와 같이 항상 전체 속도로 실행할 필요가 없습니다. tuned 에는 이 낮은 활동을 감지한 다음 해당 인터페이스의 속도를 자동으로 낮추어 일반적으로 전력 사용량을 줄일 수 있는 네트워크 장치에 대한 모니터링 및 튜닝 플러그인이 있습니다.

인터페이스의 활동이 더 긴 기간 동안 증가하는 경우, 예를 들어 DVD 이미지가 다운로드되고 있는 이메일이나 큰 첨부 파일이 있는 이메일이 열리기 때문에, TuneD 는 이를 감지하고 활동 수준이 높은 동안 최상의 성능을 제공하기 위해 인터페이스 속도를 최대로 설정합니다.

이 원칙은 CPU 및 디스크의 다른 플러그인에도 사용됩니다.

2.7. tuned 플러그인

플러그인은 TuneD 프로필에서 시스템의 다른 장치를 모니터링하거나 최적화하기 위해 사용하는 모듈입니다.

tuned 는 다음 두 가지 유형의 플러그인을 사용합니다.

- 모니터링 플러그인

모니터링 플러그인은 실행 중인 시스템에서 정보를 가져오는 데 사용됩니다. 동적 튜닝을 위해 플러그인을 튜닝하는 경우 모니터링 플러그인 출력을 사용할 수 있습니다.

활성화된 튜닝 플러그인에서 메트릭이 필요할 때마다 모니터링 플러그인이 자동으로 인스턴스화됩니다. 두 개의 튜닝 플러그인에 동일한 데이터가 필요한 경우 모니터링 플러그인의 인스턴스 1개만 생성되고 데이터가 공유됩니다.

- 플러그인 튜닝

- 각 튜닝 플러그인은 개별 하위 시스템을 튜닝하고 TuneD 프로필에서 채워지는 여러 매개변수를 사용합니다. 각 하위 시스템에는 튜닝 플러그인의 개별 인스턴스에서 처리하는 여러 CPU 또는 네트워크 카드와 같은 여러 장치가 있을 수 있습니다. 개별 장치의 특정 설정도 지원됩니다.

TuneD 프로필의 플러그인 구문

플러그인 인스턴스를 설명하는 섹션은 다음과 같이 포맷됩니다.

[NAME] type=TYPE devices=DEVICES

- NAME

- 로그에 사용되는 플러그인 인스턴스의 이름입니다. 임의의 문자열이 될 수 있습니다.

- 유형

- 는 튜닝 플러그인 유형입니다.

- DEVICES

이 플러그인 인스턴스에서 처리하는 장치 목록입니다.

devices행에는 목록, 와일드카드(*) 및 부정(!)이 포함될 수 있습니다.장치줄이 없는 경우 TYPE 시스템에 연결된 모든 장치가 플러그인 인스턴스에서 처리됩니다.devices=*옵션을 사용하는 것과 동일합니다.예 2.4. 플러그인을 사용하여 블록 장치 일치

다음 예제는

sda또는sdb와 같이sd로 시작하는 모든 블록 장치와 일치하며, 이러한 장치에 대한 장벽을 비활성화하지 않습니다.[data_disk] type=disk devices=sd* disable_barriers=false

다음 예제는

sda1및sda2를 제외한 모든 블록 장치와 일치합니다.[data_disk] type=disk devices=!sda1, !sda2 disable_barriers=false

플러그인 인스턴스를 지정하지 않으면 플러그인이 활성화되지 않습니다.

플러그인이 더 많은 옵션을 지원하는 경우 플러그인 섹션에서 지정할 수도 있습니다. 옵션을 지정하지 않고 이전에 포함된 플러그인에 지정하지 않은 경우 기본값이 사용됩니다.

짧은 플러그인 구문

플러그인 인스턴스에 사용자 정의 이름이 필요하지 않고 구성 파일에 인스턴스에 대한 정의가 하나만 있는 경우 TuneD 는 다음과 같은 짧은 구문을 지원합니다.

[TYPE] devices=DEVICES

이 경우 type 행을 생략할 수 있습니다. 그런 다음 인스턴스를 type과 동일한 이름으로 참조합니다. 이전 예제는 다음과 같이 다시 작성할 수 있습니다.

예 2.5. 짧은 구문을 사용하여 블록 장치 일치

[disk] devices=sdb* disable_barriers=false

프로필에서 플러그인 정의 충돌

include 옵션을 사용하여 동일한 섹션을 두 번 이상 지정하면 설정이 병합됩니다. 충돌로 인해 병합할 수 없는 경우 마지막으로 충돌하는 정의가 이전 설정을 덮어씁니다. 이전에 정의한 내용을 모르는 경우 replace 부울 옵션을 사용하여 true 로 설정할 수 있습니다. 이로 인해 이름이 같은 이전 정의를 모두 덮어쓰고 병합이 발생하지 않습니다.

enabled=false 옵션을 지정하여 플러그인을 비활성화할 수도 있습니다. 이 방법은 인스턴스가 정의되지 않은 경우와 동일합니다. 플러그인을 비활성화하면 include 옵션에서 이전 정의를 다시 정의하고 사용자 정의 프로필에서 플러그인을 활성화하지 않으려면 유용합니다.

- 참고

tuned 에는 튜닝 프로파일 활성화 또는 비활성화의 일부로 쉘 명령을 실행하는 기능이 포함되어 있습니다. 이를 통해 아직 TuneD 에 통합되지 않은 기능을 사용하여 TuneD 프로필을 확장할 수 있습니다.

script플러그인을 사용하여 임의의 쉘 명령을 지정할 수 있습니다.

추가 리소스

-

tuned.conf(5)man page

2.8. 사용 가능한 TuneD 플러그인

모니터링 플러그인

현재 다음과 같은 모니터링 플러그인이 구현되어 있습니다.

disk- 장치 및 측정 간격당 디스크 로드( IO 작업 수)를 가져옵니다.

net- 네트워크 카드 및 측정 간격당 네트워크 로드(전송된 패킷 수)를 가져옵니다.

load- CPU 및 측정 간격당 CPU 부하를 가져옵니다.

플러그인 튜닝

현재 다음과 같은 튜닝 플러그인이 구현되어 있습니다. 이러한 플러그인 중 일부만 동적 튜닝을 구현합니다. 플러그인에서 지원하는 옵션도 나열됩니다.

cpuCPU governor 옵션을 통해 지정된 값으로 CPU

governor를 설정하고 CPU 로드에 따라 PM QoS(Power Management Quality of Service) CPU Direct Memory Access(DMA) 대기 시간을 동적으로 변경합니다.CPU 로드가

load_threshold옵션에 지정된 값보다 작으면 대기 시간이latency_high옵션에 지정된 값으로 설정되고, 그렇지 않으면latency_low에 의해 지정된 값으로 설정됩니다.또한 대기 시간을 특정 값으로 강제 적용하고 동적으로 변경되는 것을 방지할 수 있습니다. 이렇게 하려면

force_latency옵션을 필요한 대기 시간으로 설정합니다.eeepc_sheCPU 로드에 따라 프런트 사이드 버스(FSB) 속도를 동적으로 설정합니다.

이 기능은 일부 netbook에서 찾을 수 있으며 ASUS Super Hybrid Engine (SHE)이라고도합니다.

CPU 로드가

load_threshold_powersave옵션에 지정된 값보다 작거나 같은 경우 플러그인은 FSB 속도를she_powersave옵션에 지정된 값으로 설정합니다. CPU 로드가load_threshold_normal옵션에 지정된 값과 크거나 같은 경우 FSB 속도를she_normal옵션에 지정된 값으로 설정합니다.정적 튜닝이 지원되지 않으며 TuneD 에서 이 기능에 대한 하드웨어 지원을 감지하지 않으면 플러그인이 투명하게 비활성화됩니다.

net-

Wake-on-LAN 기능을

wake_on_lan옵션에 지정된 값으로 구성합니다.ethtool유틸리티와 동일한 구문을 사용합니다. 또한 인터페이스 사용률에 따라 인터페이스 속도를 동적으로 변경합니다. sysctl플러그인 옵션으로 지정된 다양한

sysctl설정을 설정합니다.구문은

name=value이며, 여기서 name 은sysctl유틸리티에서 제공하는 이름과 동일합니다.TuneD 에서 사용할 수 있는 다른 플러그인에서 다루지 않는 시스템 설정을 변경해야 하는 경우

sysctl플러그인을 사용합니다. 일부 특정 플러그인에서 설정이 적용되는 경우 이러한 플러그인을 선호합니다.usbUSB 장치의 자동 일시 중지 시간 제한을

autosuspend매개 변수에서 지정한 값으로 설정합니다.값

0은 자동 일시 중지가 비활성화되어 있음을 의미합니다.vmtransparent_hugepages옵션의 값에 따라 투명한 대규모 페이지를 활성화하거나 비활성화합니다.transparent_hugepages옵션의 유효한 값은 다음과 같습니다.- "always"

- "never"

- "madvise"

audio시간 제한 옵션으로 지정된 값으로 오디오 codecs의 자동 대기

시간 제한을설정합니다.현재

snd_hda_intel및snd_ac97_codeccodecs가 지원됩니다. 값0은 자동 일시 중지가 비활성화되어 있음을 의미합니다. 부울 옵션reset_controller를true로 설정하여 컨트롤러 재설정을 적용할 수도 있습니다.disk디스크 로켓을

엘리베이터옵션에 지정된 값으로 설정합니다.또한 다음을 설정합니다.

-

APM 옵션을 통해 지정한

값으로설정 -

스케줄러

_quantum 옵션에 의해 지정된 값에 대한 스케줄러full -

회전 옵션에서 지정한 값에 대한 디스크

회전시간 초과 -

readahead 매개변수로 지정된 값에 대한 디스크

readahead -

current disk readahead to a value multiplied by the constant specified by the

readahead_multiply옵션

또한 이 플러그인은 현재 드라이브 사용률에 따라 드라이브에 대한 고급 전원 관리 및 회전 시간 초과 설정을 동적으로 변경합니다. 동적 튜닝은 부울 옵션

동적로 제어할 수 있으며 기본적으로 활성화되어 있습니다.-

APM 옵션을 통해 지정한

scsi_hostSCSI 호스트의 옵션을 조정합니다.

Aggressive Link Power Management (ALPM)를

alpm옵션에 지정된 값으로 설정합니다.mounts-

disable_barriers옵션의 부울 값에 따라 마운트 장벽을 활성화하거나 비활성화합니다. script프로필이 로드되거나 언로드될 때 외부 스크립트 또는 바이너리를 실행합니다. 임의의 실행 파일을 선택할 수 있습니다.

중요스크립트플러그인은 주로 이전 릴리스와의 호환성을 위해 제공됩니다. 필요한 기능을 포함하는 경우 다른 TuneD 플러그인을 선호하십시오.tuned 는 다음 인수 중 하나를 사용하여 실행 파일을 호출합니다.

-

프로필을 로드할 때

시작 -

프로필을 언로드할 때

중지

실행 파일에

stop작업을 올바르게 구현하고시작작업 중에 변경한 모든 설정을 되돌립니다. 그러지 않으면 TuneD 프로필을 변경한 후 롤백 단계가 작동하지 않습니다.Bash 스크립트는

/usr/lib/tuned/functionsBash 라이브러리를 가져오고 여기에 정의된 함수를 사용할 수 있습니다. 이러한 기능은 TuneD 에서 기본적으로 제공하지 않는 기능에만 사용하십시오. 함수 이름이_wifi_set_power_level과 같은 밑줄로 시작하는 경우 함수를 비공개로 간주하고 나중에 변경될 수 있으므로 스크립트에서 이 함수를 사용하지 마십시오.플러그인 구성에서

script매개 변수를 사용하여 실행 파일의 경로를 지정합니다.예 2.6. 프로필에서 Bash 스크립트 실행

프로필 디렉터리에 있는

script.sh라는 Bash 스크립트를 실행하려면 다음을 사용합니다.[script] script=${i:PROFILE_DIR}/script.sh-

프로필을 로드할 때

sysfs플러그인 옵션으로 지정된 다양한

sysfs설정을 설정합니다.구문은

name=value이며, 여기서 name 은 사용할sysfs경로입니다.다른 플러그인에서 다루지 않는 일부 설정을 변경해야 하는 경우 이 플러그인을 사용하십시오. 필요한 설정을 포함하는 경우 특정 플러그인을 선호합니다.

video비디오 카드에 다양한 전원 저장 수준을 설정합니다. 현재 Radeon 카드만 지원됩니다.

powersave 수준은

radeon_powersave옵션을 사용하여 지정할 수 있습니다. 지원되는 값은 다음과 같습니다.-

default -

auto -

낮음 (LOW) -

mid -

높음 -

dynpm -

dpm-battery -

dpm-balanced -

dpm-perfomance

자세한 내용은 www.x.org 을 참조하십시오. 이 플러그인은 실험적이며 향후 릴리스에서 옵션이 변경될 수 있습니다.

-

bootloader커널 명령줄에 옵션을 추가합니다. 이 플러그인은 GRUB 2 부트 로더만 지원합니다.

GRUB 2 설정 파일의 사용자 지정 비표준 위치는

grub2_cfg_file옵션으로 지정할 수 있습니다.커널 옵션이 현재 GRUB 설정 및 해당 템플릿에 추가됩니다. 커널 옵션을 적용하려면 시스템을 재부팅해야 합니다.

다른 프로필로 전환하거나

TuneD서비스를 수동으로 중지하면 추가 옵션이 제거됩니다. 시스템을 종료하거나 재부팅하는 경우 커널 옵션은grub.cfg파일에 유지됩니다.커널 옵션은 다음 구문으로 지정할 수 있습니다.

cmdline=arg1 arg2 ... argN

예 2.7. 커널 명령줄 수정

예를 들어,

quiet커널 옵션을 TuneD 프로필에 추가하려면tuned.conf파일에 다음 행을 포함합니다.[bootloader] cmdline=quiet

다음은

isolcpus=2옵션을 커널 명령줄에 추가하는 사용자 정의 프로필의 예입니다.[bootloader] cmdline=isolcpus=2

service플러그인 옵션으로 지정된 다양한

sysvinit,sysv-rc,openrc및systemd서비스를 처리합니다.구문은

service.service_name=command[,file:file]입니다.지원되는 서비스 처리 명령은 다음과 같습니다.

-

start -

중지 -

활성화 -

disable

쉼표(

,) 또는 ;(;)를 사용하여 여러 명령을 구분합니다.서비스플러그인에서 마지막으로 나열된 항목을 사용합니다.선택적

file:file지시문을 사용하여systemd에 대해서만 오버레이 구성 파일인file을 설치합니다. 다른 init 시스템은 이 지시문을 무시합니다.서비스플러그인은 오버레이 구성 파일을/etc/systemd/system/service_name.service.d/디렉터리에 복사합니다. 프로필이 언로드되면서비스플러그인은 이러한 디렉터리가 비어 있는 경우 해당 디렉터리를 제거합니다.참고서비스플러그인은systemdinit 이외의 시스템에서만 작동합니다.예 2.8. 오버레이 파일을 사용하여 sendmail

sendmail서비스 시작 및 활성화[service] service.sendmail=start,enable,file:${i:PROFILE_DIR}/tuned-sendmail.conf내부 변수

${i:PROFILE_DIR}은 플러그인이 프로필을 로드하는 디렉터리를 가리킵니다.-

scheduler- 스케줄링 우선 순위, CPU 코어 격리 및 프로세스, 스레드 및 IRQ 작업의 조정에 대한 다양한 옵션을 제공합니다.

사용 가능한 다양한 옵션의 세부 사항은 스케줄러 TuneD 플러그인의 기능을 참조하십시오.

2.9. 스케줄러 TuneD 플러그인의 기능

스케줄러 TuneD 플러그인을 사용하여 스케줄링 우선 순위, CPU 코어 격리 및 프로세스, 스레드 및 IRQ afinities를 제어하고 조정합니다.

CPU 격리

프로세스, 스레드 및 IRQ가 특정 CPU를 사용하지 못하도록 하려면 isolated_cores 옵션을 사용합니다. 프로세스 및 스레드 특성을 변경하고 IRQ에 대한 default_smp_affinity 매개변수를 설정합니다.

CPU 선호도 마스크는 sched_setaffinity() 시스템 호출의 성공 여부에 따라 ps_whitelist 옵션과 일치하는 모든 프로세스 및 스레드에 맞게 조정됩니다. ps_whitelist 정규식의 기본 설정은 모든 프로세스 및 스레드 이름과 일치하는 .* 입니다. 특정 프로세스 및 스레드를 제외하려면 ps_blacklist 옵션을 사용합니다. 이 옵션의 값은 정규식으로도 해석됩니다. 프로세스 및 스레드 이름은 해당 표현식과 일치합니다. 프로필 롤백을 사용하면 일치하는 모든 프로세스 및 스레드를 모든 CPU에서 실행하고 profile 애플리케이션 전에 IRQ 설정을 복원합니다.

ps_whitelist 및 ps_blacklist 옵션은 .로 구분된 여러 정규식이 지원됩니다. \; 은 문자 그대로 사용됩니다.

예 2.9. CPU 2-4 분리

다음 구성은 CPU 2-4를 분리합니다. ps_blacklist 정규식과 일치하는 프로세스 및 스레드는 격리와 관계없이 모든 CPU를 사용할 수 있습니다.

[scheduler] isolated_cores=2-4 ps_blacklist=.*pmd.*;.*PMD.*;^DPDK;.*qemu-kvm.*

IRQ SMP 선호도

/proc/irq/default_smp_affinity 파일에는 모든 비활성 인터럽트 요청(IRQ) 소스에 대해 시스템의 기본 대상 CPU 코어를 나타내는 비트마스크가 포함되어 있습니다. IRQ가 활성화되거나 할당되면 /proc/irq/default_smp_affinity 파일의 값이 IRQ의 선호도 비트마스크를 결정합니다.

default_irq_smp_affinity 매개변수는 /proc/irq/default_smp_affinity 파일에 쓰는 TuneD 를 제어합니다. default_irq_smp_affinity 매개변수는 다음 값과 동작을 지원합니다.

calcisolated_cores매개변수에서/proc/irq/default_smp_affinity파일의 내용을 계산합니다.isolated_cores매개변수의 반전은 격리되지 않은 코어를 계산합니다.그러면 격리되지 않은 코어와

/proc/irq/default_smp_affinity파일의 이전 콘텐츠가/proc/irq/default_smp_affinity파일에 기록됩니다.default_irq_smp_affinity매개변수가 생략된 경우 기본 동작입니다.ignore-

tuned 는

/proc/irq/default_smp_affinity파일을 수정하지 않습니다. - CPU 목록

1과 같은 단일 숫자 형식,1,3과 같은 쉼표로 구분된 목록 또는3-5와 같은 범위를 가져옵니다.CPU 목록의 압축을 풀고

/proc/irq/default_smp_affinity파일에 직접 씁니다.

예 2.10. 명시적 CPU 목록을 사용하여 기본 IRQ smp 유사성 설정

다음 예제에서는 명시적 CPU 목록을 사용하여 기본 IRQ SMP 선호도를 CPU 0 및 2로 설정합니다.

[scheduler] isolated_cores=1,3 default_irq_smp_affinity=0,2

스케줄링 정책

프로세스 또는 스레드 그룹의 우선 순위 및 선호도를 조정하려면 다음 구문을 사용합니다.

group.groupname=rule_prio:sched:prio:affinity:regex

여기서 rule_prio 는 규칙의 내부 TuneD 우선 순위를 정의합니다. 규칙은 우선 순위에 따라 정렬됩니다. 이는 상속이 이전에 정의된 규칙을 다시 정렬할 수 있도록 하는 데 필요합니다. 동일한 rule_prio 규칙을 정의한 순서대로 처리해야 합니다. 그러나 이것은 Python 인터프리터에 의존하는 것입니다. 그룹 이름에 대해 상속된 규칙을 비활성화하려면 다음을 사용합니다.

group.groupname=

Sched는 다음 중 하나여야 합니다.

f- for first in, first out (FIFO)

b- 일괄 처리의 경우

r- 라운드 로빈의 경우

o- 기타의 경우

*- for do not change

유사성 은 16진수의 CPU 선호도입니다. 변경하지 않으려면 * 를 사용하십시오.

P rio 는 스케줄링 우선 순위입니다( chrt -m참조).

regex 는 Python 정규식입니다. ps -eo cmd 명령의 출력과 일치합니다.

지정된 프로세스 이름은 둘 이상의 그룹과 일치할 수 있습니다. 이러한 경우 마지막 일치 regex 는 우선 순위 및 스케줄링 정책을 결정합니다.

예 2.11. 스케줄링 정책 및 우선순위 설정

다음 예제에서는 스케줄링 정책 및 우선순위를 커널 스레드 및 워치독으로 설정합니다.

[scheduler] group.kthreads=0:*:1:*:\[.*\]$ group.watchdog=0:f:99:*:\[watchdog.*\]

스케줄러 플러그인은 perf 이벤트 루프를 사용하여 새로 생성된 프로세스를 식별합니다. 기본적으로 perf.RECORD_COMM 및 perf.RECORD_EXIT 이벤트를 수신합니다.

perf_process_fork 매개변수를 true 로 설정하면 플러그인이 perf.RECORD_FORK 이벤트를 수신 대기하도록 지시합니다. 즉, fork() 시스템 호출에 의해 생성된 하위 프로세스가 처리됩니다.

perf 이벤트를 처리하면 상당한 CPU 오버헤드가 발생할 수 있습니다.

스케줄러 런타임 옵션을 사용하여 0 으로 설정하여 스케줄러 플러그인의 CPU 오버헤드를 완화할 수 있습니다. 이렇게 하면 동적 스케줄러 기능이 완전히 비활성화되고 perf 이벤트가 모니터링되지 않고 작동합니다. 이에 대한 단점은 프로세스 및 스레드 튜닝이 프로필 애플리케이션에서만 수행된다는 것입니다.

예 2.12. 동적 스케줄러 기능 비활성화

다음 예제에서는 CPU 1과 3을 격리하는 동안 동적 스케줄러 기능을 비활성화합니다.

[scheduler] runtime=0 isolated_cores=1,3

mmapped 버퍼는 perf 이벤트에 사용됩니다. 로드가 많은 경우 이 버퍼가 오버플로될 수 있으므로 플러그인이 누락된 이벤트를 시작하고 새로 생성된 일부 프로세스를 처리하지 못할 수 있습니다. 이러한 경우 perf_mmap_pages 매개변수를 사용하여 버퍼 크기를 늘립니다. perf_mmap_pages 매개변수의 값은 2의 power여야 합니다. perf_mmap_pages 매개변수가 수동으로 설정되지 않은 경우 기본값 128이 사용됩니다.

cgroup을 사용한 제한

스케줄러 플러그인은 cgroups v1을 사용하여 프로세스 및 스레드 제한을 지원합니다.

cgroup_mount_point 옵션은 cgroup 파일 시스템을 마운트할 경로를 지정하거나 TuneD 에서 마운트할 것으로 예상합니다. 설정되지 않은 경우 /sys/fs/cgroup/cpuset 이 예상됩니다.

cgroup_groups_init 옵션이 1 로 설정된 경우TuneD 는 cgroup* 옵션으로 정의된 모든 cgroup 을 생성하고 제거합니다. 이는 기본 동작입니다. cgroup_mount_point 옵션이 0 으로 설정된 경우 다른 방법으로 cgroup 을 사전 설정해야 합니다.

cgroup_mount_point_init 옵션이 1 로 설정된 경우TuneD 는 cgroup 마운트 지점을 생성하고 제거합니다. cgroup_groups_init = 1 임을 의미합니다. cgroup_mount_point_init 옵션이 0 으로 설정된 경우 cgroups 마운트 지점을 다른 방법으로 사전 설정해야 합니다. 이는 기본 동작입니다.

cgroup_for_isolated_cores 옵션은 isolated_cores 옵션 기능의 cgroup 이름입니다. 예를 들어 시스템에 CPU가 4개인 경우 isolated_cores=1 은 Tuned 가 모든 프로세스와 스레드를 CPU 0, 2 및 3으로 이동함을 의미합니다. 스케줄러 플러그인은 계산된 CPU 선호도를 지정된 cgroup의 cpuset.cpus 제어 파일에 작성하고 일치하는 모든 프로세스 및 스레드를 이 그룹으로 이동하여 지정된 코어를 분리합니다. 이 옵션이 설정되지 않은 경우 sched_setaffinity() 를 사용하여 클래식 cpuset 선호도가 CPU 선호도를 설정합니다.

cgroup.cgroup_name 옵션은 임의의 cgroup 에 대한 연결을 정의합니다. hierarchic cgroups도 사용할 수 있지만 계층 구조를 올바른 순서로 지정해야 합니다. tuned 는 cgroup_mount_point 옵션에 의해 지정된 위치에 cgroup 을 강제 적용하는 것을 제외하고 여기에 정당성 검사를 수행하지 않습니다.

group 으로 시작하는 스케줄러 옵션의 구문은 16진수 선호도 대신 cgroup.cgroup_name 을 사용하도록 보강되었습니다. 일치하는 프로세스가 cgroup cgroup_name 으로 이동합니다. 위에 설명된 대로 cgroup. 옵션에 정의되지 않은 cgroup을 사용할 수도 있습니다. 예를 들어 cgroup 은 TuneD 에서 관리하지 않습니다.

모든 cgroup 이름은 모든 마침표(.)를 슬래시(/)로 교체하여 종료됩니다. 이렇게 하면 플러그인이 cgroup_mount_point 옵션으로 지정된 위치 외부에 기록되지 않습니다.

예 2.13. 스케줄러 플러그인과 함께 cgroups v1 사용

다음 예제에서는 cgroup 2개,group1 및 group2 를 생성합니다. cgroup group1 선호도를 CPU 2로 설정하고 cgroup group2 를 CPU 0 및 2로 설정합니다. 4 CPU 설정이 지정된 경우 isolated_cores=1 옵션은 모든 프로세스와 스레드를 CPU 코어 0, 2 및 3으로 이동합니다. ps_blacklist 정규식으로 지정된 프로세스 및 스레드는 이동되지 않습니다.

[scheduler] cgroup_mount_point=/sys/fs/cgroup/cpuset cgroup_mount_point_init=1 cgroup_groups_init=1 cgroup_for_isolated_cores=group cgroup.group1=2 cgroup.group2=0,2 group.ksoftirqd=0:f:2:cgroup.group1:ksoftirqd.* ps_blacklist=ksoftirqd.*;rcuc.*;rcub.*;ktimersoftd.* isolated_cores=1

cgroup_ps_blacklist 옵션은 지정된 cgroup 에 속하는 프로세스를 제외합니다. 이 옵션으로 지정된 정규식은 /proc/PID/cgroups 의 cgroup 계층 구조와 일치합니다. 쉼표(,)는 정규식과 일치하기 전에 cgroup v1 계층을 /proc/PID/cgroups 에서 분리합니다. 다음은 정규식이 일치하는 콘텐츠의 예입니다.

10:hugetlb:/,9:perf_event:/,8:blkio:/

여러 정규 표현식은 together(;)으로 구분할 수 있습니다. together는 논리 '또는' 연산자를 나타냅니다.

예 2.14. cgroup을 사용하여 스케줄러에서 프로세스 제외

다음 예에서 스케줄러 플러그인은 cgroup /daemons 에 속하는 프로세스를 제외하고 모든 프로세스를 코어 1에서 이동합니다. \b 문자열은 단어 경계와 일치하는 정규식 메타 문자입니다.

[scheduler] isolated_cores=1 cgroup_ps_blacklist=:/daemons\b

다음 예에서 스케줄러 플러그인은 hierarchy-ID가 8이고 controller-list blkio 인 cgroup에 속하는 모든 프로세스를 제외합니다.

[scheduler] isolated_cores=1 cgroup_ps_blacklist=\b8:blkio:

최근 커널은 sysctl 유틸리티에서 관리하는 /proc/sys/kernel 디렉터리에서 일반적으로 /sys/kernel/ 디렉터리에 마운트된 일부 debug sched_ 및 numa_balancing_ 커널 런타임 매개변수를 /proc/sys/kernel 디렉터리에 이동했습니다. tuned는 스케줄러 플러그인을 통해 다음 매개변수에 대한 추상화 메커니즘을 제공합니다. 여기서 사용된 커널을 기반으로 TuneD 는 지정된 값을 올바른 위치에 씁니다.

-

sched_min_granularity_ns -

sched_latency_ns, -

sched_wakeup_granularity_ns -

sched_tunable_scaling, -

sched_migration_cost_ns -

sched_nr_migrate -

numa_balancing_scan_delay_ms -

numa_balancing_scan_period_min_ms -

numa_balancing_scan_period_max_ms numa_balancing_scan_size_mb예 2.15. 마이그레이션 결정에 대한 작업의 "캐시 핫" 값을 설정합니다.

이전 커널에서 다음 매개변수를 설정하면

sysctl이/proc/sys/kernel/sched_migration_cost_ns파일에500000값을 작성했습니다.[sysctl] kernel.sched_migration_cost_ns=500000

이는

스케줄러플러그인을 통해 다음 매개변수를 설정하는 것과 동일한 최신 커널에서 다음과 같습니다.[scheduler] sched_migration_cost_ns=500000

즉 TuneD 는

/sys/kernel/debug/sched/migration_cost_ns파일에500000값을 씁니다.

2.10. TuneD 프로필의 변수

TuneD 프로필이 활성화되면 런타임에 변수가 확장됩니다.

TuneD 변수를 사용하면 TuneD 프로필에서 필요한 입력 수를 줄일 수 있습니다.

TuneD 프로파일에는 사전 정의된 변수가 없습니다. 프로필에서 [Variables] 섹션을 생성하고 다음 구문을 사용하여 고유한 변수 를 정의할 수 있습니다.

[variables] variable_name=value

프로필의 변수 값을 확장하려면 다음 구문을 사용합니다.

${variable_name}예 2.16. 변수를 사용하여 CPU 코어 분리

다음 예에서 ${isolated_cores} 변수는 12로 확장됩니다. 따라서 커널은 isolcpus=1,2 옵션으로 부팅됩니다.

[variables]

isolated_cores=1,2

[bootloader]

cmdline=isolcpus=${isolated_cores}

변수는 별도의 파일에 지정할 수 있습니다. 예를 들어 tuned.conf 에 다음 행을 추가할 수 있습니다.

[variables]

include=/etc/tuned/my-variables.conf

[bootloader]

cmdline=isolcpus=${isolated_cores}

isolated_cores=1,2 옵션을 /etc/tuned/my-aliass.conf 파일에 추가하면 커널은 isolcpus=1,2 옵션으로 부팅됩니다.

추가 리소스

-

tuned.conf(5)man page

2.11. TuneD 프로파일의 기본 제공 함수

기본 제공 함수는 TuneD 프로필이 활성화되면 런타임에 확장됩니다.

다음을 수행할 수 있습니다.

- TuneD 변수와 함께 다양한 기본 제공 함수 사용

- Python에서 사용자 정의 함수를 생성하고 플러그인 형태로 TuneD 에 추가합니다.

함수를 호출하려면 다음 구문을 사용합니다.

${f:function_name:argument_1:argument_2}

프로필 및 tuned.conf 파일이 있는 디렉터리 경로를 확장하려면 특수 구문이 필요한 PROFILE_DIR 함수를 사용합니다.

${i:PROFILE_DIR}예 2.17. 변수 및 기본 제공 함수를 사용하여 CPU 코어 분리

다음 예에서 ${non_isolated_cores} 변수는 03-5 로 확장되고 cpulist_invert 기본-invert 함수는 인수를 사용하여 호출됩니다.

0,3-5

[variables]

non_isolated_cores=0,3-5

[bootloader]

cmdline=isolcpus=${f:cpulist_invert:${non_isolated_cores}}

cpulist_invert 함수는 CPU 목록을 반전합니다. 6-CPU 시스템의 경우 inversion은 1,2 이며 커널은 isolcpus=1,2 명령줄 옵션으로 부팅됩니다.

추가 리소스

-

tuned.conf(5)man page

2.12. TuneD 프로필에서 사용할 수 있는 기본 제공 함수

다음 기본 제공 함수는 모든 TuneD 프로필에서 사용할 수 있습니다.

PROFILE_DIR-

프로필과

tuned.conf파일이 있는 디렉터리 경로를 반환합니다. exec- 프로세스를 실행하고 출력을 반환합니다.

assertion- 두 개의 인수를 비교합니다. 이 값이 일치하지 않으면 함수에서 첫 번째 인수의 텍스트를 기록하고 프로필 로드를 중단합니다.

assertion_non_equal- 두 개의 인수를 비교합니다. 이 값이 일치하면 함수는 첫 번째 인수의 텍스트를 기록하고 프로필 로드를 중단합니다.

kb2s- 킬로바이트를 디스크 섹터로 변환합니다.

s2kb- 디스크 섹터를 킬로바이트로 변환합니다.

strip- 전달된 모든 인수에서 문자열을 만들고 선행 및 후행 공백을 모두 삭제합니다.

virt_check가상 머신(VM) 내에서 TuneD 가 실행 중인지 또는 베어 메탈에서 실행 중인지 확인합니다.

- VM 내에서 함수는 첫 번째 인수를 반환합니다.

- 베어 메탈에서 함수는 오류가 발생하는 경우에도 두 번째 인수를 반환합니다.

cpulist_invert-

CPU 목록을 반전하여 보완합니다. 예를 들어 CPU가 4개인 시스템에서는 0에서 3으로 번호가 매겨지면 목록

0,2,3의 버전이1입니다. cpulist2hex- CPU 목록을 16진수 CPU 마스크로 변환합니다.

cpulist2hex_invert- CPU 목록을 16진수 CPU 마스크로 변환하고 반전합니다.

hex2cpulist- 16진수 CPU 마스크를 CPU 목록으로 변환합니다.

cpulist_online- 목록의 CPU가 온라인 상태인지 확인합니다. 온라인 CPU만 포함하는 목록을 반환합니다.

cpulist_present- 목록의 CPU가 있는지 확인합니다. 현재 CPU만 포함하는 목록을 반환합니다.

cpulist_unpack-

1-3,4에서1,2,3,4형식으로 CPU 목록의 압축을 풉니다. cpulist_pack-

1,2,3,5에서1-3,5형식의 CPU 목록을 포함합니다.

2.13. 새 TuneD 프로필 생성

이 절차에서는 사용자 정의 성능 규칙을 사용하여 새 TuneD 프로필을 생성합니다.

사전 요구 사항

-

TuneD서비스가 실행 중입니다. 자세한 내용은 TuneD 설치 및 활성화를 참조하십시오.

절차

/etc/tuned/디렉터리에서 생성하려는 프로필과 동일한 라는 새 디렉터리를 생성합니다.# mkdir /etc/tuned/my-profile새 디렉터리에

tuned.conf라는 파일을 생성합니다. 요구 사항에 따라[main]섹션 및 플러그인 정의를 추가합니다.예를 들어

balanced프로파일 구성을 참조하십시오.[main] summary=General non-specialized TuneD profile [cpu] governor=conservative energy_perf_bias=normal [audio] timeout=10 [video] radeon_powersave=dpm-balanced, auto [scsi_host] alpm=medium_power

프로필을 활성화하려면 다음을 사용합니다.

# tuned-adm profile my-profileTuneD 프로필이 활성 상태이고 시스템 설정이 적용되었는지 확인합니다.

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

추가 리소스

-

tuned.conf(5)man page

2.14. 기존 TuneD 프로필 수정

이 절차에서는 기존 TuneD 프로필을 기반으로 수정된 하위 프로필을 생성합니다.

사전 요구 사항

-

TuneD서비스가 실행 중입니다. 자세한 내용은 TuneD 설치 및 활성화를 참조하십시오.

절차

/etc/tuned/디렉터리에서 생성하려는 프로필과 동일한 라는 새 디렉터리를 생성합니다.# mkdir /etc/tuned/modified-profile새 디렉터리에서

tuned.conf라는 파일을 생성하고[main]섹션을 다음과 같이 설정합니다.[main] include=parent-profileparent-profile 을 수정 중인 프로필 이름으로 교체합니다.

프로파일 수정 사항을 포함합니다.

예 2.18. throughput-performance 프로필에서 swappiness 감소

throughput-performance프로필의 설정을 사용하고 기본값 10이 아닌vm.swappiness값을 5로 변경하려면 다음을 사용합니다.[main] include=throughput-performance [sysctl] vm.swappiness=5

프로필을 활성화하려면 다음을 사용합니다.

# tuned-adm profile modified-profileTuneD 프로필이 활성 상태이고 시스템 설정이 적용되었는지 확인합니다.

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

추가 리소스

-

tuned.conf(5)man page

2.15. TuneD를 사용하여 디스크 스케줄러 설정

이 절차에서는 선택한 블록 장치에 지정된 디스크 스케줄러를 설정하는 TuneD 프로필을 생성하고 활성화합니다. 시스템 재부팅 시 설정이 유지됩니다.

다음 명령 및 구성에서 다음을 교체합니다.

-

블록 장치 의 이름이 있는 장치(예:

sdf) -

장치에 설정하려는 디스크 스케줄러가 있는 선택된- scheduler(예:

bfq)

사전 요구 사항

-

TuneD서비스가 설치되고 활성화됩니다. 자세한 내용은 TuneD 설치 및 활성화를 참조하십시오.

절차

선택 사항: 프로필을 기반으로 할 기존 TuneD 프로필을 선택합니다. 사용 가능한 프로필 목록은 RHEL을 사용하여 배포된 TuneD 프로필을 참조하십시오.

현재 활성화되어 있는 프로필을 확인하려면 다음을 사용합니다.

$ tuned-adm active

TuneD 프로필을 저장할 새 디렉터리를 생성합니다.

# mkdir /etc/tuned/my-profile선택한 블록 장치의 시스템 고유 식별자를 찾습니다.

$ udevadm info --query=property --name=/dev/device | grep -E '(WWN|SERIAL)' ID_WWN=0x5002538d00000000_ ID_SERIAL=Generic-_SD_MMC_20120501030900000-0:0 ID_SERIAL_SHORT=20120501030900000

참고이 예제의 명령은 지정된 블록 장치와 연결된 WWN(WWN) 또는 일련 번호로 식별되는 모든 값을 반환합니다. WWN을 사용하는 것이 바람직하지만, 지정된 장치에 WWN을 항상 사용할 수는 없으며 example 명령에서 반환된 모든 값은 장치 시스템 고유 ID 로 사용할 수 있습니다.

/etc/tuned/my-profile/tuned.conf구성 파일을 만듭니다. 파일에서 다음 옵션을 설정합니다.선택 사항: 기존 프로필이 포함되어 있습니다.

[main] include=existing-profileWWN 식별자와 일치하는 장치에 선택한 디스크 스케줄러를 설정합니다.

[disk] devices_udev_regex=IDNAME=device system unique id elevator=selected-scheduler

여기:

-

IDNAME 을 사용 중인 식별자 이름(예:

ID_WWN)으로 바꿉니다. 장치 시스템 고유 ID 를 선택한 식별자의 값으로 바꿉니다(예:

0x5002538d00000000).devices_udev_regex옵션의 여러 장치와 일치하려면 식별자를 괄호로 묶고 세로 막대로 분리합니다.devices_udev_regex=(ID_WWN=0x5002538d00000000)|(ID_WWN=0x1234567800000000)

-

IDNAME 을 사용 중인 식별자 이름(예:

프로필을 활성화합니다.

# tuned-adm profile my-profile

검증 단계

TuneD 프로필이 활성화되어 적용되는지 확인합니다.

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See TuneD log file ('/var/log/tuned/tuned.log') for details./sys/block/device/queue/scheduler파일의 내용을 읽습니다.# cat /sys/block/device/queue/scheduler [mq-deadline] kyber bfq none파일 이름에서 장치를 블록 장치 이름으로 바꿉니다(예:

sdc).활성 스케줄러는 대괄호(

[])로 나열됩니다.

추가 리소스

- TuneD 프로필 사용자 정의 .

3장. tuna 인터페이스를 사용하여 시스템 검토

tuna 툴은 튜닝 작업 수행의 복잡성을 줄입니다. tuna 를 사용하여 스케줄러 튜닝 가능 항목을 조정하고 스레드 우선 순위, IRQ 처리기를 조정하며 CPU 코어와 소켓을 분리합니다. tuna 툴을 사용하면 다음 작업을 수행할 수 있습니다.

- 시스템의 CPU를 나열합니다.

- 시스템에서 현재 실행 중인 인터럽트 요청(IRQ)을 나열합니다.

- 스레드에 대한 정책 및 우선 순위 정보를 변경합니다.

- 시스템의 현재 정책 및 우선 순위를 표시합니다.

3.1. tuna 툴 설치

tuna 툴은 실행 중인 시스템에서 사용하도록 설계되었습니다. 이를 통해 애플리케이션별 측정 툴을 사용하여 변경 후 즉시 시스템 성능을 확인하고 분석할 수 있습니다.

절차

tuna툴을 설치합니다.# dnf install tuna

검증 단계

사용 가능한

tunaCLI 옵션을 표시합니다.# tuna -h

추가 리소스

-

tuna(8)매뉴얼 페이지

3.2. tuna 툴을 사용하여 시스템 상태 보기

tuna CLI(명령줄 인터페이스) 툴을 사용하여 시스템 상태를 볼 수 있습니다.

사전 요구 사항

-

tuna툴이 설치되어 있습니다. 자세한 내용은 tuna 툴 설치를 참조하십시오.

절차

현재 정책 및 우선 순위를 확인합니다.

# tuna show_threads pid SCHED_ rtpri affinity cmd 1 OTHER 0 0,1 init 2 FIFO 99 0 migration/0 3 OTHER 0 0 ksoftirqd/0 4 FIFO 99 0 watchdog/0또는 PID에 해당하는 특정 스레드를 보거나 명령 이름과 일치하는 특정 스레드를 보려면 다음을 입력합니다.

# tuna show_threads -t pid_or_cmd_listpid_or_cmd_list 인수는 쉼표로 구분된 PID 또는 command-name 패턴 목록입니다.

시나리오에 따라 다음 작업 중 하나를 수행합니다.

-

tunaCLI를 사용하여 CPU를 튜닝하려면 tuna 툴을 사용하여 CPU 튜닝 단계를 완료합니다. -

tuna 툴을 사용하여 IRQ를 조정하려면

tuna툴을 사용하여 IRQ 튜닝 단계를 완료합니다.

-

변경된 구성을 저장합니다.

# tuna save filename이 명령은 현재 실행 중인 커널 스레드만 저장합니다. 실행 중이 아닌 프로세스는 저장되지 않습니다.

추가 리소스

-

시스템의

tuna(8)도움말 페이지

3.3. tuna 툴을 사용하여 CPU 튜닝

tuna 툴 명령은 개별 CPU를 대상으로 지정할 수 있습니다. tuna 툴을 사용하면 다음 작업을 수행할 수 있습니다.

CPU 격리- 지정된 CPU에서 실행되는 모든 작업은 사용 가능한 다음 CPU로 이동합니다. CPU를 격리하면 모든 스레드의 선호도 마스크에서 이 CPU를 제거할 수 없습니다.

CPU 포함- 지정된 CPU에서 작업을 실행할 수 있습니다.

CPU 복원- 지정된 CPU를 이전 구성으로 복원합니다.

사전 요구 사항

-

tuna툴이 설치되어 있습니다. 자세한 내용은 tuna 툴 설치를 참조하십시오.

절차

모든 CPU를 나열하고 명령의 영향을 받을 CPU 목록을 지정합니다.

# ps ax | awk 'BEGIN { ORS="," }{ print $1 }' PID,1,2,3,4,5,6,8,10,11,12,13,14,15,16,17,19tuna인터페이스에서 스레드 목록을 표시합니다.# tuna show_threads -t 'thread_list from above cmd'명령의 영향을 받을 CPU 목록을 지정합니다.

# *tuna [command] --cpus cpu_list *

cpu_list 인수는 쉼표로 구분된 CPU 번호 목록입니다(예:

--cpus 0,2).현재 cpu_list 에 특정 CPU를 추가하려면 (예:

--cpus +0)를 사용합니다.시나리오에 따라 다음 작업 중 하나를 수행합니다.

CPU를 분리하려면 다음을 입력합니다.

# tuna isolate --cpus cpu_listCPU를 포함하려면 다음을 입력합니다.

# tuna include --cpus cpu_list

4개 이상의 프로세서가 있는 시스템을 사용하려면 모든

ssh스레드가 CPU 0 과 1 과 CPU 2 및 3 에서 모든http스레드에서 실행되도록 합니다.# tuna move --cpus 0,1 -t ssh* # tuna move --cpus 2,3 -t http\*

검증 단계

현재 구성을 표시하고 변경 사항이 적용되었는지 확인합니다.

# tuna show_threads -t ssh* pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 855 OTHER 0 0,1 23 15 sshd # tuna show_threads -t http\* pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 855 OTHER 0 2,3 23 15 http

추가 리소스

-

/proc/cpuinfo파일 -

시스템의

tuna(8)도움말 페이지

3.4. tuna 툴을 사용하여 IRQ 조정

/proc/interrupts 파일은 IRQ당 인터럽트 수, 인터럽트 유형, IRQ에 있는 장치의 이름을 기록합니다.

사전 요구 사항

-

tuna툴이 설치되어 있습니다. 자세한 내용은 tuna 툴 설치를 참조하십시오.

절차

현재 IRQ 및 해당 선호도를 확인합니다.

# tuna show_irqs # users affinity 0 timer 0 1 i8042 0 7 parport0 0명령의 영향을 받을 IRQ 목록을 지정합니다.

# tuna [command] --irqs irq_list --cpus cpu_listirq_list 인수는 쉼표로 구분된 IRQ 번호 또는 사용자 이름 패턴 목록입니다.

[명령]을 (예:

--spread)로 바꿉니다.인터럽트를 지정된 CPU로 이동합니다.

# tuna show_irqs --irqs 128 users affinity 128 iwlwifi 0,1,2,3 # tuna move --irqs 128 --cpus 3

128 을 irq_list 인수 및 3 으로 cpu_list 인수로 바꿉니다.

cpu_list 인수는 쉼표로 구분된 CPU 번호 목록입니다(예:

--cpus 0,2). 자세한 내용은 tuna 툴을 사용하여 CPU 튜닝을 참조하십시오.

검증 단계

인터럽트를 지정된 CPU로 이동하기 전과 후에 선택한 IRQ의 상태를 비교합니다.

# tuna show_irqs --irqs 128 users affinity 128 iwlwifi 3

추가 리소스

-

/Procs/interrupts파일 -

시스템의

tuna(8)도움말 페이지

4장. RHEL 시스템 역할을 사용하여 성능 모니터링

시스템 관리자는 메트릭 RHEL 시스템 역할을 사용하여 시스템의 성능을 모니터링할 수 있습니다.

4.1. RHEL 시스템 역할을 사용하도록 컨트롤 노드 및 관리형 노드 준비

개별 RHEL 시스템 역할을 사용하여 서비스 및 설정을 관리하려면 먼저 제어 노드와 관리 노드를 준비해야 합니다.

4.1.1. RHEL 9에서 제어 노드 준비

RHEL 시스템 역할을 사용하기 전에 제어 노드를 구성해야 합니다. 그런 다음 이 시스템은 플레이북에 따라 인벤토리에서 관리 호스트를 구성합니다.

사전 요구 사항

- 시스템이 고객 포털에 등록되어 있습니다.

-

Red Hat Enterprise Linux Server서브스크립션이 시스템에 연결되어 있습니다. -

선택 사항:

Ansible Automation Platform서브스크립션이 시스템에 연결되어 있습니다.

절차

ansible이라는 사용자를 생성하여 플레이북을 관리하고 실행합니다.[root@control-node]# useradd ansible새로 생성된

ansible사용자로 전환합니다.[root@control-node]# su - ansible이 사용자로 나머지 절차를 수행합니다.

SSH 공개 및 개인 키를 생성합니다.

[ansible@control-node]$ ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/home/ansible/.ssh/id_rsa): Enter passphrase (empty for no passphrase): <password> Enter same passphrase again: <password> ...

키 파일에 제안된 기본 위치를 사용합니다.

- 선택 사항: Ansible에서 연결을 설정할 때마다 SSH 키 암호를 입력하라는 메시지를 표시하지 않도록 SSH 에이전트를 구성합니다.

다음 콘텐츠를 사용하여

~/.ansible.cfg파일을 생성합니다.[defaults] inventory = /home/ansible/inventory remote_user = ansible [privilege_escalation] become = True become_method = sudo become_user = root become_ask_pass = True

참고~/.ansible.cfg파일의 설정은 우선 순위가 높으며 전역/etc/ansible/ansible.cfg파일의 설정을 재정의합니다.이러한 설정을 통해 Ansible은 다음 작업을 수행합니다.

- 지정된 인벤토리 파일의 호스트를 관리합니다.

-

관리 노드에 대한 SSH 연결을 설정할 때

remote_user매개변수에 설정된 계정을 사용합니다. -

sudo유틸리티를 사용하여 관리 노드에서root사용자로 작업을 실행합니다. - 플레이북을 적용할 때마다 원격 사용자의 루트 암호를 입력하라는 메시지를 표시합니다. 이는 보안상의 이유로 권장됩니다.

관리 호스트의 호스트 이름을 나열하는 INI 또는 YAML 형식으로

~/inventory파일을 생성합니다. 인벤토리 파일에서 호스트 그룹을 정의할 수도 있습니다. 예를 들어 다음은 3개의 호스트와US라는 호스트 그룹 1개가 있는 INI 형식의 인벤토리 파일입니다.managed-node-01.example.com [US] managed-node-02.example.com ansible_host=192.0.2.100 managed-node-03.example.com

제어 노드에서 호스트 이름을 확인할 수 있어야 합니다. DNS 서버가 특정 호스트 이름을 확인할 수 없는 경우 호스트 항목 옆에 있는

ansible_host매개변수를 추가하여 IP 주소를 지정합니다.RHEL 시스템 역할을 설치합니다.

Ansible Automation Platform이 없는 RHEL 호스트에서

rhel-system-roles패키지를 설치합니다.[root@control-node]# dnf install rhel-system-roles이 명령은

/usr/share/ansible/collections/ansible_collections/redhat/rhel_system_roles/디렉터리에 컬렉션을 설치하고ansible-core패키지를 종속성으로 설치합니다.Ansible Automation Platform에서

ansible사용자로 다음 단계를 수행합니다.-

Red Hat 자동화 허브를

~/.ansible.cfg파일의 기본 콘텐츠 소스로 정의합니다. Red Hat 자동화 허브에서

redhat.rhel_system_roles컬렉션을 설치합니다.[ansible@control-node]$ ansible-galaxy collection install redhat.rhel_system_roles이 명령은

~/.ansible/collections/ansible_collections/redhat/rhel_system_roles/디렉터리에 컬렉션을 설치합니다.

-

Red Hat 자동화 허브를

다음 단계

- 관리형 노드를 준비합니다. 자세한 내용은 관리 노드 준비를 참조하십시오.

4.1.2. 관리형 노드 준비

관리형 노드는 인벤토리에 나열되는 시스템이며, 플레이북에 따라 제어 노드에서 구성합니다. 관리 호스트에 Ansible을 설치할 필요가 없습니다.

사전 요구 사항

- 제어 노드를 준비합니다. 자세한 내용은 RHEL 9에서 제어 노드 준비를 참조하십시오.

제어 노드에서 SSH 액세스 권한이 있어야 합니다.

중요root사용자로 직접 SSH 액세스는 보안 위험이 있습니다. 이 위험을 줄이기 위해 이 노드에 로컬 사용자를 생성하고 관리 노드를 준비할 때sudo정책을 구성합니다. 그런 다음 제어 노드의 Ansible은 로컬 사용자 계정을 사용하여 관리 노드에 로그인하고root와 같은 다른 사용자로 플레이북을 실행할 수 있습니다.

절차

ansible이라는 사용자를 생성합니다.[root@managed-node-01]# useradd ansible나중에 제어 노드는 이 사용자를 사용하여 이 호스트에 대한 SSH 연결을 설정합니다.

ansible사용자의 암호를 설정합니다.[root@managed-node-01]# passwd ansible Changing password for user ansible. New password: <password> Retype new password: <password> passwd: all authentication tokens updated successfully.

Ansible에서

sudo를 사용하여 작업을root사용자로 수행할 때 이 암호를 입력해야 합니다.관리 노드에

ansible사용자의 SSH 공개 키를 설치합니다.제어 노드에

ansible사용자로 로그인하고 SSH 공개 키를 관리 노드에 복사합니다.[ansible@control-node]$ ssh-copy-id managed-node-01.example.com /usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/ansible/.ssh/id_rsa.pub" The authenticity of host 'managed-node-01.example.com (192.0.2.100)' can't be established. ECDSA key fingerprint is SHA256:9bZ33GJNODK3zbNhybokN/6Mq7hu3vpBXDrCxe7NAvo.프롬프트가 표시되면

yes를 입력하여 연결합니다.Are you sure you want to continue connecting (yes/no/[fingerprint])? yes /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed /usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keys암호를 입력하라는 메시지가 표시되면 암호를 입력합니다.

ansible@managed-node-01.example.com's password: <password> Number of key(s) added: 1 Now try logging into the machine, with: "ssh 'managed-node-01.example.com'" and check to make sure that only the key(s) you wanted were added.제어 노드에서 명령을 원격으로 실행하여 SSH 연결을 확인합니다.

[ansible@control-node]$ ssh managed-node-01.example.com whoami ansible

ansible사용자에 대한sudo구성을 생성합니다.visudo명령을 사용하여/etc/sudoers.d/ansible파일을 만들고 편집합니다.[root@managed-node-01]# visudo /etc/sudoers.d/ansible일반 편집기에서

visudo를 사용하면 이 유틸리티에서 기본 온전성 검사를 제공하고 파일을 설치하기 전에 구문 분석 오류를 점검할 수 있습니다.요구 사항을 충족하는

/etc/파일에서 sudoers 정책을 구성합니다. 예를 들면 다음과 같습니다.sudoers.d/ansibleansible사용자 암호를 입력한 후 이 호스트의 모든 사용자 및 그룹으로 모든 명령을 실행할 수 있는 권한을ansible사용자에게 부여하려면 다음을 사용합니다.ansible ALL=(ALL) ALL

ansible사용자 암호를 입력하지 않고 이 호스트의 모든 사용자 및 그룹으로 모든 명령을 실행할 수 있는 권한을ansible사용자에게 부여하려면 다음을 사용합니다.ansible ALL=(ALL) NOPASSWD: ALL

또는 보안 요구 사항과 일치하는 더 세분화된 정책을 구성합니다.

sudoers정책에 대한 자세한 내용은sudoers(5)매뉴얼 페이지를 참조하십시오.

검증

모든 관리형 노드의 제어 노드에서 명령을 실행할 수 있는지 확인합니다.

[ansible@control-node]$ ansible all -m ping BECOME password: <password> managed-node-01.example.com | SUCCESS => { "ansible_facts": { "discovered_interpreter_python": "/usr/bin/python3" }, "changed": false, "ping": "pong" } ...

하드 코딩된 모든 그룹에는 인벤토리 파일에 나열된 모든 호스트가 동적으로 포함됩니다.

Ansible

command모듈을 사용하여 관리 호스트에서whoami유틸리티를 실행하여 권한 상승이 올바르게 작동하는지 확인합니다.[ansible@control-node]$ ansible managed-node-01.example.com -m command -a whoami BECOME password: <password> managed-node-01.example.com | CHANGED | rc=0 >> root

명령이 root를 반환하면 관리 노드에서

sudo를 올바르게 구성한 것입니다.

추가 리소스

- RHEL 9에서 제어 노드 준비

-

sudoers(5)매뉴얼 페이지

4.2. 메트릭 시스템 역할 소개

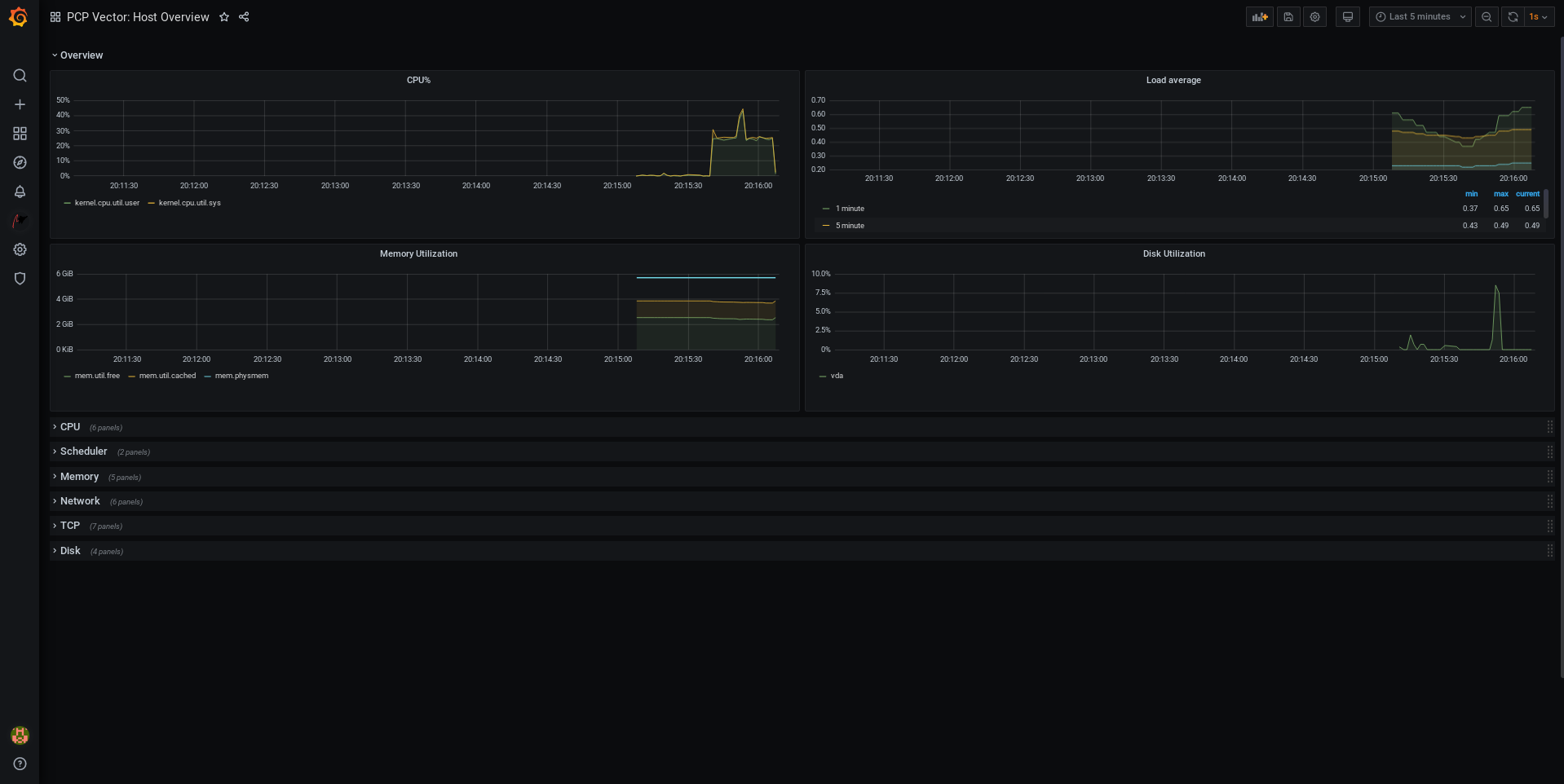

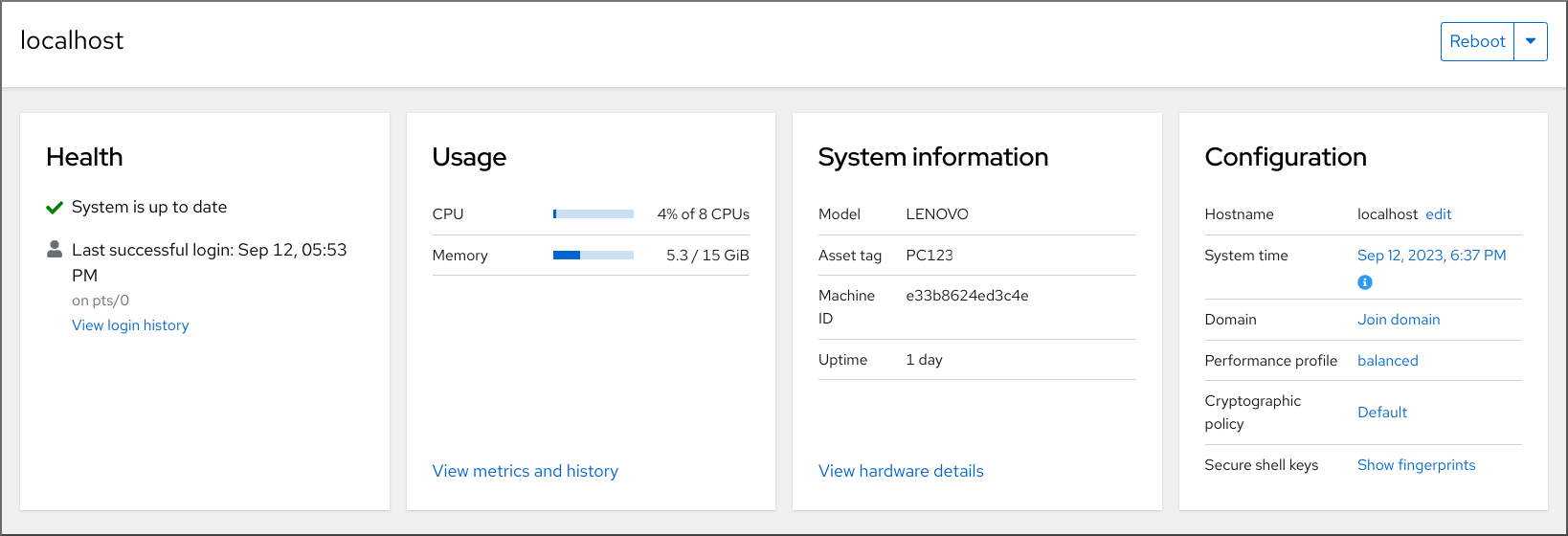

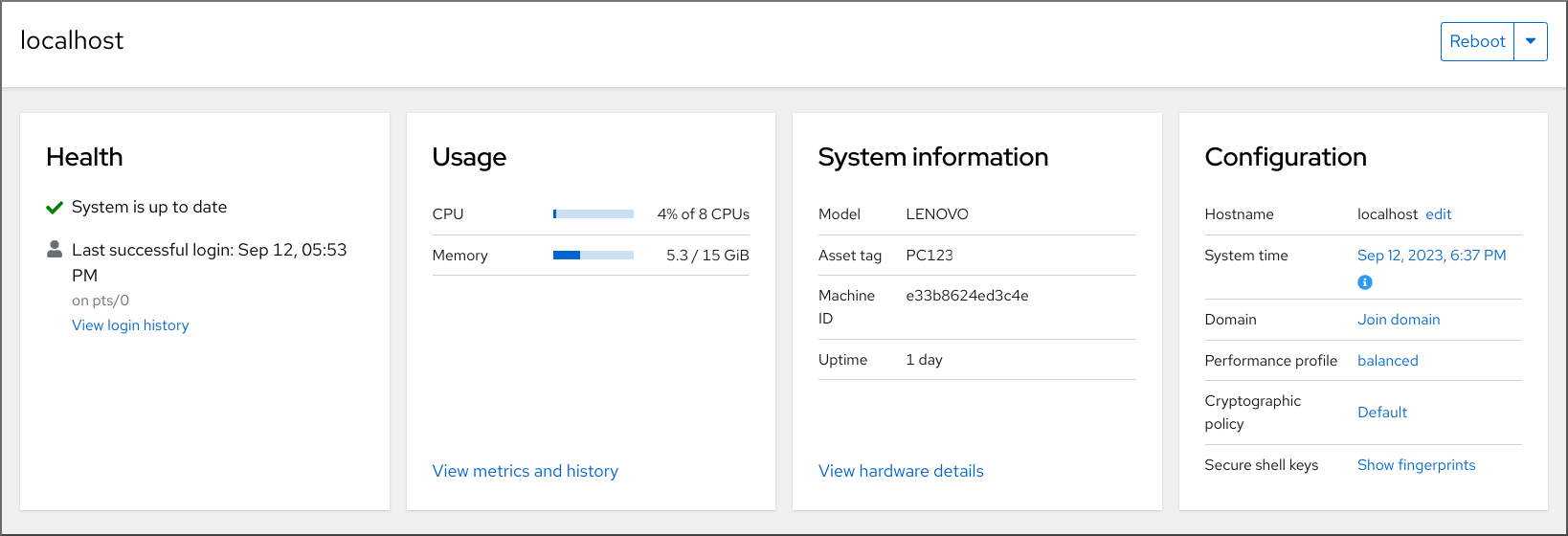

RHEL 시스템 역할은 여러 RHEL 시스템을 원격으로 관리하는 일관된 구성 인터페이스를 제공하는 Ansible 역할 및 모듈의 컬렉션입니다. 지표 시스템 역할은 로컬 시스템에 대한 성능 분석 서비스를 구성하고 선택적으로 로컬 시스템에서 모니터링할 원격 시스템 목록을 포함합니다. 지표 시스템 역할을 사용하면 플레이북에서 설정 및 배포를 처리하므로 pcp를 사용하여 pcp pcp 를 별도로 구성할 필요 없이 시스템 성능을 모니터링할 수 있습니다.

추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.metrics/README.md파일 -

/usr/share/doc/rhel-system-roles/metrics/디렉터리

4.3. 메트릭 시스템 역할을 사용하여 시각화로 로컬 시스템 모니터링

다음 절차에서는 지표 RHEL 시스템 역할을 사용하여 Grafana 를 통해 동시에 데이터 시각화를 프로비저닝하는 동시에 로컬 시스템을 모니터링하는 방법을 설명합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다. localhost는 제어 노드의 인벤토리 파일에 구성되어 있습니다.localhost ansible_connection=local

절차

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.--- - name: Manage metrics hosts: localhost roles: - rhel-system-roles.metrics vars: metrics_graph_service: yes metrics_manage_firewall: true metrics_manage_selinux: truemetrics_graph_service부울이value="yes"로 설정되므로Grafana는 데이터 소스로 추가된pcp를 사용하여 자동으로 설치 및 프로비저닝됩니다.metrics_manage_firewall및metrics_manage_selinux가 모두true로 설정되므로 지표 역할은firewall및selinux시스템 역할을 사용하여 metrics 역할에서 사용하는 포트를 관리합니다.플레이북 구문을 확인합니다.

$ ansible-playbook --syntax-check ~/playbook.yml이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

$ ansible-playbook ~/playbook.yml

검증

-

시스템에서 수집되는 메트릭의 시각화를 보려면 Grafana 웹 UI 액세스에 설명된 대로

grafana웹 인터페이스에 액세스 합니다.

추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.metrics/README.md파일 -

/usr/share/doc/rhel-system-roles/metrics/디렉터리

4.4. 메트릭 시스템 역할을 사용하여 자체적으로 모니터링할 개별 시스템 설정

다음 절차에서는 메트릭 시스템 역할을 사용하여 자체적으로 모니터링할 시스템을 설정하는 방법을 설명합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

절차

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.--- - name: Configure a fleet of machines to monitor themselves hosts: managed-node-01.example.com roles: - rhel-system-roles.metrics vars: metrics_retention_days: 0 metrics_manage_firewall: true metrics_manage_selinux: truemetrics_manage_firewall및metrics_manage_selinux가 모두true로 설정되므로 지표 역할은firewall및selinux역할을 사용하여metrics역할에서 사용하는 포트를 관리합니다.플레이북 구문을 확인합니다.

$ ansible-playbook --syntax-check ~/playbook.yml이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

$ ansible-playbook ~/playbook.yml

추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.metrics/README.md파일 -

/usr/share/doc/rhel-system-roles/metrics/디렉터리

4.5. 메트릭 시스템 역할을 사용하여 로컬 시스템을 통해 중앙에서 시스템을 모니터링

다음 절차에서는 메트릭 시스템 역할을 사용하여 시스템 플릿을 중앙에서 모니터링하면서 grafana 를 통해 데이터 시각화를 프로비저닝하고 redis 를 통해 데이터를 쿼리하는 방법을 설명합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다. localhost는 제어 노드의 인벤토리 파일에 구성되어 있습니다.localhost ansible_connection=local

절차

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.- name: Set up your local machine to centrally monitor a fleet of machines hosts: localhost roles: - rhel-system-roles.metrics vars: metrics_graph_service: yes metrics_query_service: yes metrics_retention_days: 10 metrics_monitored_hosts: ["database.example.com", "webserver.example.com"] metrics_manage_firewall: yes metrics_manage_selinux: yesmetrics_graph_service및metrics_query_service부울이value="yes"로 설정되므로grafana는pcpredis로 인덱싱하여 데이터 소스로 추가되도록 자동으로 설치 및 프로비저닝되므로pcp쿼리 언어를 사용하여 데이터의 복잡한 쿼리에 사용할 수 있습니다.metrics_manage_firewall및metrics_manage_selinux가 모두true로 설정되므로지표역할은firewall및selinux역할을 사용하여metrics역할에서 사용하는 포트를 관리합니다.플레이북 구문을 확인합니다.

$ ansible-playbook --syntax-check ~/playbook.yml이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

$ ansible-playbook ~/playbook.yml

검증

-

시스템에서 중앙에서 수집되는 지표의 그래픽 표현을 보고 데이터를 쿼리하려면 Grafana 웹 UI 액세스에 설명된 대로

grafana웹 인터페이스에 액세스 합니다.

추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.metrics/README.md파일 -

/usr/share/doc/rhel-system-roles/metrics/디렉터리

4.6. 메트릭 시스템 역할을 사용하여 시스템을 모니터링하는 동안 인증 설정

PCP는 SASL(Simple Authentication Security Layer) 프레임워크를 통해 scram-sha-256 인증 메커니즘을 지원합니다. 지표 RHEL 시스템 역할은 scram-sha-256 인증 메커니즘을 사용하여 인증을 설정하는 단계를 자동화합니다. 다음 절차에서는 RHEL 시스템 역할을 사용하여 인증을 설정하는 방법을 설명합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다.

절차

기존 플레이북 파일(예:

~/playbook.yml)을 편집하고 인증 관련 변수를 추가합니다.--- - name: Set up authentication by using the scram-sha-256 authentication mechanism hosts: managed-node-01.example.com roles: - rhel-system-roles.metrics vars: metrics_retention_days: 0 metrics_manage_firewall: true metrics_manage_selinux: true metrics_username: <username> metrics_password: <password>플레이북 구문을 확인합니다.

$ ansible-playbook --syntax-check ~/playbook.yml이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

$ ansible-playbook ~/playbook.yml

검증

sasl구성을 확인합니다.# pminfo -f -h "pcp://managed-node-01.example.com?username=<username>" disk.dev.read Password: <password> disk.dev.read inst [0 or "sda"] value 19540

추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.metrics/README.md파일 -

/usr/share/doc/rhel-system-roles/metrics/디렉터리

4.7. 메트릭 시스템 역할을 사용하여 SQL Server에 대한 메트릭 컬렉션을 구성하고 활성화

다음 절차에서는 RHEL 시스템 역할을 사용하여 로컬 시스템의 pcp 를 통해 Microsoft SQL Server에 대한 메트릭 컬렉션을 자동화하고 활성화하는 방법을 설명합니다.

사전 요구 사항

- 컨트롤 노드 및 관리형 노드를 준비했습니다.

- 관리 노드에서 플레이북을 실행할 수 있는 사용자로 제어 노드에 로그인되어 있습니다.

-

관리 노드에 연결하는 데 사용하는 계정에는

sudo권한이 있습니다. - Red Hat Enterprise Linux용 Microsoft SQL Server를 설치하고 SQL 서버에 대한 신뢰할 수 있는 연결을 설정했습니다.

- Red Hat Enterprise Linux용 SQL Server용 Microsoft ODBC 드라이버를 설치했습니다.

localhost는 제어 노드의 인벤토리 파일에 구성되어 있습니다.localhost ansible_connection=local

절차

다음 콘텐츠를 사용하여 플레이북 파일(예:

~/playbook.yml)을 생성합니다.--- - name: Configure and enable metrics collection for Microsoft SQL Server hosts: localhost roles: - rhel-system-roles.metrics vars: metrics_from_mssql: true metrics_manage_firewall: true metrics_manage_selinux: truemetrics_manage_firewall및metrics_manage_selinux가 모두true로 설정되므로지표역할은firewall및selinux역할을 사용하여metrics역할에서 사용하는 포트를 관리합니다.플레이북 구문을 확인합니다.

$ ansible-playbook --syntax-check ~/playbook.yml이 명령은 구문만 검증하고 잘못되었지만 유효한 구성으로부터 보호하지 않습니다.

Playbook을 실행합니다.

$ ansible-playbook ~/playbook.yml

검증

pcp명령을 사용하여 SQL Server PMDA 에이전트(mssql)가 로드되고 실행되고 있는지 확인합니다.# pcp platform: Linux sqlserver.example.com 4.18.0-167.el8.x86_64 #1 SMP Sun Dec 15 01:24:23 UTC 2019 x86_64 hardware: 2 cpus, 1 disk, 1 node, 2770MB RAM timezone: PDT+7 services: pmcd pmproxy pmcd: Version 5.0.2-1, 12 agents, 4 clients pmda: root pmcd proc pmproxy xfs linux nfsclient mmv kvm mssql jbd2 dm pmlogger: primary logger: /var/log/pcp/pmlogger/sqlserver.example.com/20200326.16.31 pmie: primary engine: /var/log/pcp/pmie/sqlserver.example.com/pmie.log

추가 리소스

-

/usr/share/ansible/roles/rhel-system-roles.metrics/README.md파일 -

/usr/share/doc/rhel-system-roles/metrics/디렉터리

5장. PCP 설정

PCP(Performance Co-915)는 시스템 수준 성능 측정을 모니터링, 시각화, 저장 및 분석하기 위한 도구, 서비스 및 라이브러리 제품군입니다.

5.1. PCP 개요

Python, Perl, C++ 및 C 인터페이스를 사용하여 성능 지표를 추가할 수 있습니다. 분석 툴은 Python, C++, C 클라이언트 API를 직접 사용할 수 있으며 풍부한 웹 애플리케이션은 JSON 인터페이스를 사용하여 사용 가능한 모든 성능 데이터를 탐색할 수 있습니다.

라이브 결과를 아카이브 데이터와 비교하여 데이터 패턴을 분석할 수 있습니다.

PCP의 기능:

- 경량의 분산 아키텍처는 복잡한 시스템을 분석하는 동안 유용합니다.

- 실시간 데이터를 모니터링하고 관리할 수 있습니다.

- 기록 데이터를 로깅 및 검색할 수 있습니다.

PCP에는 다음과 같은 구성 요소가 있습니다.

-

Performance Metric Collector Daemon(

pmcd)은 설치된 Performance Metric Domain Agents(pmda)에서 성능 데이터를 수집합니다. PMDA 는 시스템에서 개별적으로 로드되거나 언로드될 수 있으며, 동일한 호스트의 PMCD 에 의해 제어됩니다. -

pminfo또는pmstat와 같은 다양한 클라이언트 도구는 동일한 호스트 또는 네트워크를 통해 이 데이터를 검색, 표시, 아카이브 및 처리할 수 있습니다. -

pcp패키지는 명령줄 도구 및 기본 기능을 제공합니다. -

pcp-gui패키지는 그래픽 애플리케이션을 제공합니다.dnf install명령을 실행하여 pcp-gui 패키지를 설치합니다. 자세한 내용은 PCP 차트 애플리케이션을 사용하여 PCP 로그 아카이브 시각화를 참조하십시오.pcp-gui

추가 리소스

-

pcp(1)man page -

/usr/share/doc/pcp-doc/directory - PCP와 함께 배포된 시스템 서비스 및 도구

- Red Hat 고객 포털의 Performance Co-inspector(PCP) 문서, 솔루션, 튜토리얼, 백서

- 기존 툴과 PCP 툴을 나란히 비교 Red Hat Knowledgebase 문서

- PCP 업스트림 문서

5.2. PCP 설치 및 활성화

PCP 사용을 시작하려면 필요한 모든 패키지를 설치하고 PCP 모니터링 서비스를 활성화하십시오.

이 절차에서는 pcp 패키지를 사용하여 PCP를 설치하는 방법을 설명합니다. PCP 설치를 자동화하려면 pcp-zeroconf 패키지를 사용하여 설치합니다. pcp-zeroconf 를 사용하여 PCP를 설치하는 방법에 대한 자세한 내용은 pcp-zeroconf를 사용하여 PCP 설정을 참조하십시오.

절차

pcp패키지를 설치합니다.# dnf install pcp

호스트 시스템에서

pmcd서비스를 활성화하고 시작합니다.# systemctl enable pmcd # systemctl start pmcd

검증 단계

pmcd프로세스가 호스트에서 실행 중인지 확인합니다.# pcp Performance Co-Pilot configuration on workstation: platform: Linux workstation 4.18.0-80.el8.x86_64 #1 SMP Wed Mar 13 12:02:46 UTC 2019 x86_64 hardware: 12 cpus, 2 disks, 1 node, 36023MB RAM timezone: CEST-2 services: pmcd pmcd: Version 4.3.0-1, 8 agents pmda: root pmcd proc xfs linux mmv kvm jbd2

추가 리소스

-

pmcd(1)도움말 페이지 - PCP와 함께 배포된 시스템 서비스 및 도구

5.3. 최소 PCP 설정 배포

PCP 최소 설치는 Red Hat Enterprise Linux에서 성능 통계를 수집합니다. 설정에는 추가 분석을 위해 데이터를 수집하는 데 필요한 프로덕션 시스템에 최소 패키지 수를 추가해야 합니다.

생성된 tar.gz 파일과 다양한 PCP 툴을 사용하여 pmlogger 출력의 아카이브를 분석하고 다른 성능 정보 소스와 비교할 수 있습니다.

사전 요구 사항

- PCP가 설치되어 있습니다. 자세한 내용은 PCP 설치 및 활성화를 참조하십시오.

절차

pmlogger구성을 업데이트합니다.# pmlogconf -r /var/lib/pcp/config/pmlogger/config.default

pmcd및pmlogger서비스를 시작합니다.# systemctl start pmcd.service # systemctl start pmlogger.service

- 성능 데이터를 기록하는 데 필요한 작업을 실행합니다.

pmcd및pmlogger서비스를 중지합니다.# systemctl stop pmcd.service # systemctl stop pmlogger.service

출력을 저장하고 호스트 이름과 현재 날짜와 시간을 기반으로 이름이 지정된

tar.gz파일에 저장합니다.# cd /var/log/pcp/pmlogger/ # tar -czf $(hostname).$(date +%F-%Hh%M).pcp.tar.gz $(hostname)

이 파일을 추출하고 PCP 툴을 사용하여 데이터를 분석합니다.

추가 리소스

-

pmlogconf(1),pmlogger(1)및pmcd(1)도움말 페이지 - PCP와 함께 배포된 시스템 서비스 및 도구

5.4. PCP와 함께 배포된 시스템 서비스 및 도구

PCP(Performance Co- Cryostat)에는 성능을 측정하는 데 사용할 수 있는 다양한 시스템 서비스 및 도구가 포함되어 있습니다. 기본 패키지 pcp 에는 시스템 서비스 및 기본 툴이 포함되어 있습니다. 추가 툴은 pcp-system-tools,pcp-gui 및 pcp-devel 패키지와 함께 제공됩니다.

PCP와 함께 배포되는 시스템 서비스의 역할

pmcd- PMCD(Performance Metric Collector Daemon)입니다.

pmie- 성능 지표 유추 엔진.

pmlogger- 성능 지표 로거입니다.

pmproxy- 실시간 및 기록 성능 지표 프록시, 시계열 쿼리 및 REST API 서비스.

기본 PCP 패키지로 배포되는 툴

pcp- Performance Co-inspector 설치의 현재 상태를 표시합니다.

pcp-vmstat- 5초마다 고급 시스템 성능 개요를 제공합니다. 프로세스, 메모리, 페이징, 블록 IO, 트랩 및 CPU 활동에 대한 정보를 표시합니다.

pmconfig- 구성 매개변수 값을 표시합니다.

pmdiff- 지정된 시간 창에서 하나 또는 두 아카이브의 모든 메트릭의 평균 값을 비교하여 성능 회귀를 검색할 때 관심이 있을 수 있는 변경 사항을 비교합니다.

pmdumplog- Performance Co-inspector 아카이브 파일의 제어, 메타데이터, 인덱스 및 상태 정보를 표시합니다.

pmfind- 네트워크에서 PCP 서비스를 찾습니다.

pmie- 정기적으로 산술, 논리 및 규칙 식 집합을 평가하는 유추 엔진입니다. 지표는 라이브 시스템 또는 Performance Co-inspector 아카이브 파일에서 수집됩니다.

pmieconf-

구성 가능한

pmie변수를 표시하거나 설정합니다. pmiectl-

pmie의 기본이 아닌 인스턴스를 관리합니다. pminfo- 성능 지표에 대한 정보를 표시합니다. 지표는 라이브 시스템 또는 Performance Co-inspector 아카이브 파일에서 수집됩니다.

pmlc-

활성

pmlogger인스턴스를 대화식으로 설정합니다. pmlogcheck- Performance Co-inspector 아카이브 파일에서 잘못된 데이터를 식별합니다.

pmlogconf-

pmlogger구성 파일을 생성하고 수정합니다. pmlogctl-

pmlogger의 기본적이지 않은 인스턴스를 관리합니다. pmloglabel- Performance Co-inspector 아카이브 파일의 레이블을 검증, 수정 또는 복구합니다.

pmlogsummary- Performance Co-inspector 아카이브 파일에 저장된 성능 지표에 대한 통계 정보를 계산합니다.

pmprobe- 성능 지표의 가용성을 결정합니다.

pmsocks- 방화벽을 통해 Performance Co-inspector 호스트에 액세스할 수 있습니다.

pmstat- 정기적으로 시스템 성능에 대한 간략한 요약을 표시합니다.

pmstore- 성능 지표 값을 수정합니다.

pmtrace- 추적 PMDA에 명령줄 인터페이스를 제공합니다.

pmval- 현재 성능 지표 값을 표시합니다.

별도로 설치된 pcp-system-tools 패키지와 함께 배포되는 툴

pcp-atop- CPU, 메모리, 디스크, 네트워크 등 성능 관점에서 가장 중요한 하드웨어 리소스의 시스템 수준 occupation을 보여줍니다.

pcp-atopsar-

다양한 시스템 리소스 사용률에 대해 시스템 수준 활동 보고서를 생성합니다. 이 보고서는

pmlogger또는pcp-atop의-w옵션을 사용하여 이전에 기록된 원시 로그 파일에서 생성됩니다. pcp-dmcache- 장치 IOP, 캐시 및 메타데이터 장치 사용률과 각 캐시 장치에 대한 읽기 및 쓰기 비율 및 비율과 같은 구성된 장치 매퍼 캐시 대상에 대한 정보를 표시합니다.

pcp-dstat-

한 번에 하나의 시스템의 지표를 표시합니다. 여러 시스템의 지표를 표시하려면

--host옵션을 사용합니다. pcp-free- 시스템에서 사용 가능한 메모리 및 사용된 메모리에 대한 보고서

pcp-htop-

에서 실행되는 모든 프로세스를

최상위명령과 유사한 방식으로 명령줄 인수와 함께 표시하지만 마우스를 사용하여 세로로 스크롤하고 수평으로 이동할 수 있습니다. 또한 트리 형식으로 프로세스를 보고 여러 프로세스를 한 번에 선택 및 실행할 수도 있습니다. pcp-ipcs- 호출 프로세스에서 읽기 액세스 권한이 있는 프로세스 간 통신(IPC) 기능에 대한 정보를 표시합니다.

pcp-mpstat- CPU 및 인터럽트 관련 통계를 보고합니다.

pcp-numastat- 커널 메모리 할당기의 NUMA 할당 통계를 표시합니다.

pcp-pidstat- CPU 백분율, 메모리 및 스택 사용량, 스케줄링 및 우선 순위와 같이 시스템에서 실행되는 개별 작업 또는 프로세스에 대한 정보를 표시합니다. 기본적으로 로컬 호스트의 실시간 데이터를 보고합니다.

pcp-shping-

pmdashpingPerformance Metrics Domain Agent(PMDA)에서 내보낸 쉘-핑 서비스 메트릭을 샘플 및 보고합니다. pcp-ss-

pmdasocketsPMDA에서 수집한 소켓 통계를 표시합니다. pcp-tapestat- ExternalIP 장치에 대한 I/O 통계를 보고합니다.

pcp-uptime- 는 시스템이 실행 중인 기간, 현재 로그인한 사용자 수 및 시스템 부하 평균 지난 1, 5, 15분을 표시합니다.

pcp-verify- Performance Co- Cryostat 수집기 설치의 다양한 측면을 검사하고 특정 작동 모드에 대해 올바르게 구성되었는지 보고합니다.

pmiostat-

SCSI 장치(기본적으로) 또는 장치 매퍼 장치에 대한 I/O 통계를 보고합니다(

-xdevice-mapper 옵션 사용). pmrep- 선택한, 쉽게 사용자 지정 가능, 성능 지표 값에 대한 보고서.

별도로 설치된 pcp-gui 패키지로 배포되는 툴

pmchart- Performance Co-inspector 기능을 통해 사용 가능한 성능 지표 값을 작성하고 있습니다.

pmdumptext- 실시간 또는 Performance Co-inspector 아카이브에서 수집한 성능 지표 값을 출력합니다.

별도로 설치된 pcp-devel 패키지와 함께 배포되는 툴

pmclient- PMAPI(Performance Metrics Application Programming Interface)를 사용하여 고급 시스템 성능 지표를 표시합니다.

pmdbg- 사용 가능한 Performance Co-inspector debug 제어 플래그 및 해당 값을 표시합니다.

pmerr- 사용 가능한 Performance Co-inspector 오류 코드 및 해당 오류 메시지를 표시합니다.

5.5. PCP 배포 아키텍처

PCP(Performance Co-Pilot)는 PCP 배포 규모에 따라 여러 배포 아키텍처를 지원하며 고급 설정을 수행할 수 있는 많은 옵션을 제공합니다.

Red Hat에서 설정한 권장 배포에 따라 사용 가능한 확장 배포 설정 변형, 크기 조정 요인 및 구성 옵션은 다음과 같습니다.

localhost각 서비스는 모니터링된 시스템에서 로컬로 실행됩니다. 구성을 변경하지 않고 서비스를 시작하면 기본 배포입니다. 이 경우 개별 노드 이상으로 스케일링할 수 없습니다.

기본적으로 Redis에 대한 배포 설정은 독립 실행형 localhost입니다. 그러나 Redis는 필요에 따라 고가용성 및 확장성이 뛰어난 클러스터형 방식으로 작업을 수행할 수 있습니다. 여기서 데이터는 여러 호스트에서 공유됩니다. 또 다른 실행 가능한 옵션은 클라우드에 Redis 클러스터를 배포하거나 클라우드 벤더의 관리형 Redis 클러스터를 사용하는 것입니다.

Decentralizedlocalhost와 분산 설정의 유일한 차이점은 중앙 집중식 Redis 서비스입니다. 이 모델에서 호스트는 모니터링되는 각 호스트에서

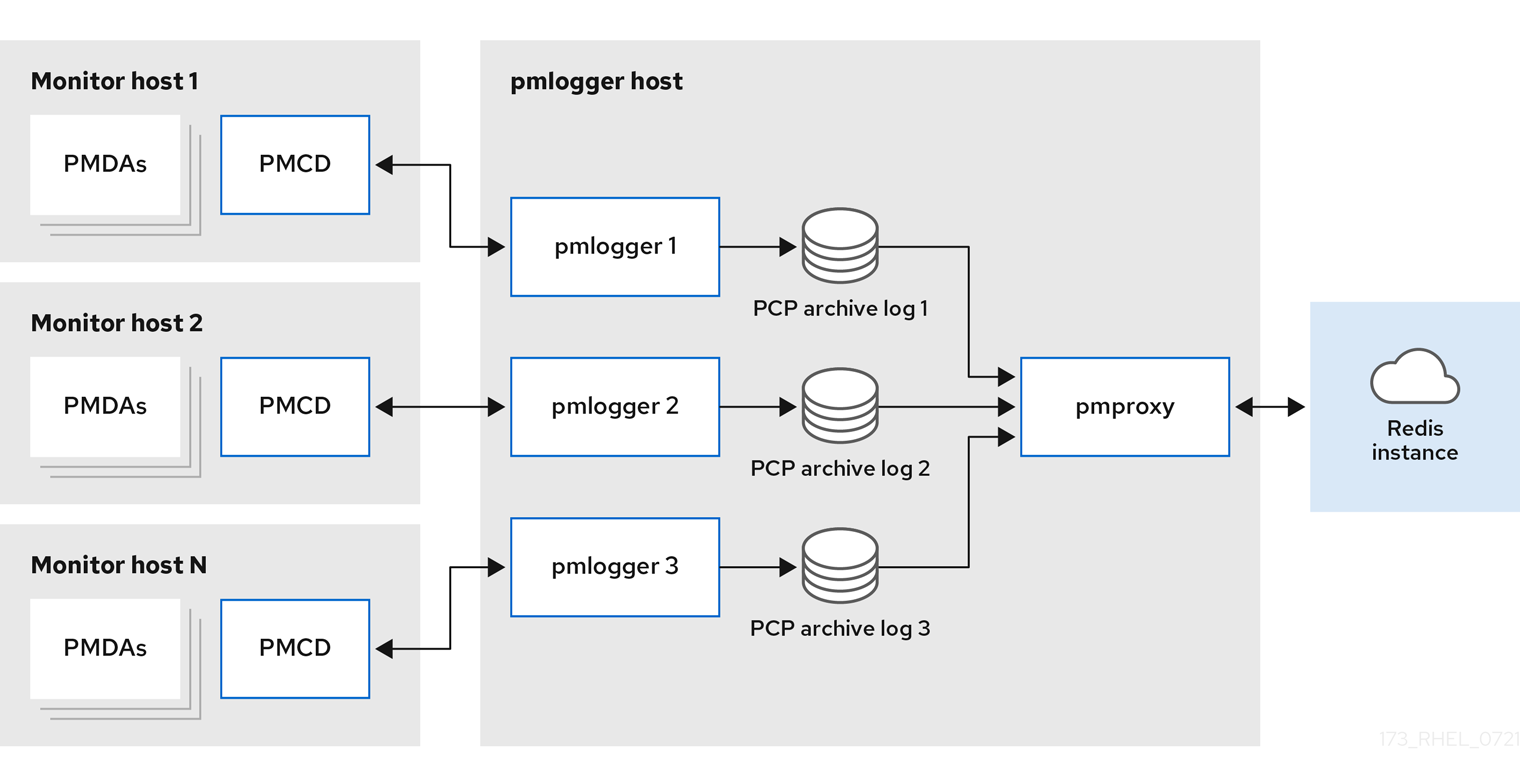

pmlogger서비스를 실행하고 로컬pmcd인스턴스에서 지표를 검색합니다. 그런 다음 로컬pmproxy서비스는 성능 지표를 중앙 Redis 인스턴스로 내보냅니다.그림 5.1. 분산된 로깅

중앙 집중식 로깅 - pmloggerarm모니터링된 호스트의 리소스 사용량이 제한되면 다른 배포 옵션은 중앙 집중식 로깅이라고도 하는

pmloggerarm입니다. 이 설정에서 단일 로거 호스트는 여러pmlogger프로세스를 실행하고 각각 다른 원격pmcd호스트에서 성능 지표를 검색하도록 구성됩니다. 중앙 집중식 로거 호스트는 결과 PCP 아카이브 로그를 검색하고 지표 데이터를 Redis 인스턴스로 로드하는pmproxy서비스를 실행하도록 구성됩니다.그림 5.2. 중앙 집중식 로깅 - pmloggerarm

페더레이션 - 여러 pmloggerarms대규모 배포의 경우 Red Hat은 여러

pmlogger팜을 연합 방식으로 배포하는 것이 좋습니다. 예를 들어 랙 또는 데이터 센터당 하나의pmloggerarm이 있습니다. 각pmloggerarm은 중앙 Redis 인스턴스로 메트릭을 로드합니다.그림 5.3. 페더레이션 - 여러 pmloggerarms

기본적으로 Redis에 대한 배포 설정은 독립 실행형 localhost입니다. 그러나 Redis는 필요에 따라 고가용성 및 확장성이 뛰어난 클러스터형 방식으로 작업을 수행할 수 있습니다. 여기서 데이터는 여러 호스트에서 공유됩니다. 또 다른 실행 가능한 옵션은 클라우드에 Redis 클러스터를 배포하거나 클라우드 벤더의 관리형 Redis 클러스터를 사용하는 것입니다.

추가 리소스

-

PCP(1),pmlogger(1),pmproxy(1)및pmcd(1)도움말 페이지 - 권장되는 배포 아키텍처

5.6. 권장되는 배포 아키텍처

다음 표에서는 모니터링된 호스트 수에 따라 권장되는 배포 아키텍처를 설명합니다.

표 5.1. 권장되는 배포 아키텍처

| 호스트 수 (N) | 1-10 | 10-100 | 100-1000 |

|---|---|---|---|

|

| N | N | N |

|

| 1에서 N으로 | N/10에서 N으로 | N/100에서 N/100으로 |

|

| 1에서 N으로 | 1에서 N으로 | N/100에서 N/100으로 |

| Redis 서버 | 1에서 N으로 | 1에서 N/10으로 | N/100에서 N/10으로 |

| redis cluster | 없음 | 수 있습니다. | 있음 |

| 권장되는 배포 설정 | localhost, 분산화된 또는 중앙 집중식 로깅 | 분산, 중앙 집중식 로깅 또는 Federated | 분산되거나 페어링 |

5.7. 크기 조정 요인

다음은 스케일링에 필요한 크기 조정 요인입니다.

원격 시스템 크기-

CPU, 디스크, 네트워크 인터페이스 및 기타 하드웨어 리소스의 수는 중앙 집중식 로깅 호스트의 각

pmlogger에서 수집한 데이터 양에 영향을 미칩니다. 기록된 메트릭-

기록된 지표의 수와 유형이 중요한 역할을 합니다. 특히

프로세스별 proc.* 메트릭에는 표준설정, 10s 로깅 간격 10MB, proc 메트릭이 없는 11MB - proc 메트릭이 포함된 약 10배 더 많은 디스크 공간이 필요합니다. 또한 각 메트릭의 인스턴스 수(예: CPU 수, 블록 장치 및 네트워크 인터페이스 수)도 필요한 스토리지 용량에 영향을 미칩니다.pcp-zeroconf 로깅 간격-

지표가 기록되는 간격은 스토리지 요구 사항에 영향을 미칩니다. 예상되는 일일 PCP 아카이브 파일 크기는 각

pmlogger인스턴스의pmlogger.log파일에 작성됩니다. 이러한 값은 압축되지 않은 추정치입니다. PCP 아카이브가 매우 잘 압축되므로 약 10:1이 특정 사이트에 대해 실제 장기 디스크 공간 요구 사항을 확인할 수 있습니다. pmlogrewrite-

모든 PCP 업그레이드 후

pmlogrewrite도구가 실행되고 이전 버전의 지표 메타데이터와 새 버전의 PCP가 변경된 경우 이전 아카이브를 다시 작성합니다. 이 프로세스 기간은 저장된 아카이브 수로 선형으로 확장됩니다.

추가 리소스

-

pmlogrewrite(1)및pmlogger(1)도움말 페이지

5.8. PCP 스케일링을 위한 구성 옵션

다음은 확장에 필요한 구성 옵션입니다.

sysctl 및 rlimit 설정-

아카이브 검색이 활성화되면

pmproxy에는 모니터링 또는 로그 세부 정보인 모든pmproxy에 대해 서비스 로그 및pmproxy클라이언트 소켓의 추가 파일 설명자와 함께 4개의 설명자가 필요합니다. 각pmlogger프로세스는 원격pmcd소켓, 아카이브 파일, 서비스 로그 등에 약 20개의 파일 설명자를 사용합니다. 약 200pmlogger프로세스를 실행하는 시스템의 기본 1024 소프트 제한을 초과할 수 있습니다.pcp-5.3.0이상의pmproxy서비스가 하드 제한으로 자동으로 증가합니다. 이전 버전의 PCP에서는 다수의pmlogger프로세스를 배포할 경우 튜닝이 필요하며,pmlogger의 소프트 또는 하드 제한을 늘려 이를 수행할 수 있습니다. 자세한 내용은 systemd에서 실행하는 서비스의 제한(ulimit)을 설정하는 방법을 참조하십시오. 로컬 아카이브-

pmlogger서비스는/var/log/pcp/pmlogger/디렉터리에 로컬 및 원격pmcds의 지표를 저장합니다. 로컬 시스템의 로깅 간격을 제어하려면/etc/pcp/pmlogger/control.d/configfile파일을 업데이트하고 인수에-t X를 추가합니다. 여기서 X 는 로깅 간격(초)입니다. 로깅해야 하는 메트릭을 구성하려면pmlogconf /var/lib/pcp/config/pmlogger/config.clienthostname을 실행합니다. 이 명령은 기본 지표 세트를 사용하여 구성 파일을 배포합니다. 이러한 지표는 선택적으로 추가로 사용자 지정할 수 있습니다. 보존 설정을 지정하려면 이전 PCP 아카이브를 제거하고,/etc/sysconfig/pmlogger_timers파일을 업데이트하고PMLOGGER_DAILY_PARAMS="-E -k X", 여기서 X 는 PCP 아카이브를 유지하기 위한 일 수입니다. Redispmproxy서비스는 로깅된 지표를pmlogger에서 Redis 인스턴스로 보냅니다. 다음은/etc/pcp/pmproxy/pmproxy.conf설정 파일에 보존 설정을 지정하는 두 가지 옵션입니다.-

stream.expire는 오래된 지표를 제거해야 하는 기간, 지정된 시간 내에 업데이트되지 않은 지표를 지정합니다. -

stream.maxlen은 호스트당 하나의 메트릭 값의 최대 메트릭 값을 지정합니다. 이 설정은 보존 간격(예: 20160)에서 14일 동안의 보존 및 60s 로깅 간격(60*60*24*14/60)으로 나눈 보존 시간이어야 합니다.

-

추가 리소스

-

pmproxy(1),pmlogger(1)및sysctl(8)매뉴얼 페이지

5.9. 예: 중앙 집중식 로깅 배포 분석

다음 결과는 기본 pcp-zeroconf 5.3.0 설치로 알려진 중앙 집중식 로깅 설정에서 수집되었으며, 각 원격 호스트는 64 CPU 코어, 376GB RAM 및 1개의 디스크가 있는 서버에서 pmcd 를 실행하는 동일한 컨테이너 인스턴스입니다.

로깅 간격은 10s이며, 원격 노드의 proc 메트릭은 포함되지 않으며 메모리 값은 RSS(Resident Set Size) 값을 나타냅니다.

표 5.2. 10s 로깅 간격에 대한 자세한 사용률 통계

| 호스트 수 | 10 | 50 |

|---|---|---|

| PCP Archives 스토리지 일당 | 91MB | 522 MB |

|

| 160MB | 580MB |

|

| 2MB | 9MB |

|

| 1.4GB | 6.3GB |

| Redis Memory per Day | 2.6 GB | 12GB |

표 5.3. 60s 로깅 간격에 대해 모니터링된 호스트에 따라 사용되는 리소스

| 호스트 수 | 10 | 50 | 100 |

|---|---|---|---|

| PCP Archives 스토리지 일당 | 20 MB | 120MB | 271MB |

|

| 104MB | 524MB | 1049MB |

|

| 0.38MB | 1.75MB | 3.48MB |

|

| 2.67GB | 5.5GB | 9GB |

| Redis Memory per Day | 0.54GB | 2.65GB | 5.3GB |

pmproxy 대기열 Redis는 Redis pipelining 요청을 요청하고 Redis 파이프lining을 사용하여 Redis 쿼리 속도를 높입니다. 이로 인해 메모리 사용량이 증가할 수 있습니다. 이 문제를 해결하려면 높은 메모리 사용량 문제 해결을 참조하십시오.

5.10. 예: 페더레이션 설정 배포 분석

다음 결과는 세 가지 중앙 집중식 로깅 ( pmlogger farm) 설정으로 구성된 여러pmlogger arms로 알려진 페더레이션 설정에서 관찰되었으며, 각 pmlogger farm는 총 300 개의 원격 호스트를 모니터링했습니다.

pmlogger 의 이 설정은 다음에 언급된 구성과 동일합니다.

예: Redis 서버가 클러스터 모드에서 작동 중이라는 점을 제외하고 60s 로깅 간격으로 중앙 집중식 로깅 배포를 분석합니다.

표 5.4. 60s 로깅 간격을 위한 페더레이션 호스트에 따라 사용되는 리소스

| PCP Archives 스토리지 일당 | pmlogger Memory | 네트워크 1일당 (In/Out) | pmproxy 메모리 | Redis Memory per Day |

|---|---|---|---|---|

| 277 MB | 1058MB | 15.6 MB / 12.3 MB | 6-8GB | 5.5GB |

여기서는 모든 값은 호스트당입니다. Redis 클러스터의 노드 간 통신으로 인해 네트워크 대역폭이 더 높습니다.

5.11. 보안 PCP 연결 설정

보안 PCP 프로토콜 교환에 참여하도록 PCP 수집기 및 모니터링 구성 요소를 구성할 수 있습니다.

5.11.1. 보안 PCP 연결

PCP(Performance Co-Pilot) 수집기와 모니터링 구성 요소 간에 보안 연결을 설정할 수 있습니다. PCP 수집기 구성 요소는 다른 소스에서 성능 데이터를 수집하고 추출하는 PCP의 일부입니다. PCP 모니터 구성 요소는 PCP 수집기 구성 요소가 설치된 호스트 또는 아카이브에서 수집된 데이터를 표시하는 PCP의 일부입니다. 이러한 구성 요소 간 보안 연결을 설정하면 인증되지 않은 당사자가 수집 및 모니터링되는 데이터에 액세스하거나 수정하는 것을 방지할 수 있습니다.

성능 지표 수집기 데몬(pmcd)과의 모든 연결은 TCP/IP 기반 PCP 프로토콜을 사용하여 수행됩니다. 프로토콜 프록시 및 PCP REST API는 pmproxy 데몬에서 제공합니다. REST API는 HTTPS를 통해 액세스할 수 있으므로 보안 연결을 보장할 수 있습니다.

pmcd 및 pmproxy 데몬은 단일 포트에서 TLS 및 비 TLS 통신을 동시에 수행할 수 있습니다. pmcd 의 기본 포트는 pmproxy 의 경우 44321 및 44322입니다. 즉, PCP 수집기 시스템의 TLS 또는 비 TLS 통신 중에서 선택할 필요가 없으며 둘 다 동시에 사용할 수 있습니다.

5.11.2. PCP 수집기 구성 요소에 대한 보안 연결 구성

모든 PCP 수집기 시스템에는 보안 PCP 프로토콜 교환에 참여하려면 유효한 인증서가 있어야 합니다.

pmproxy 데몬은 TLS 관점에서 클라이언트와 서버로 작동합니다.

사전 요구 사항

- PCP가 설치되어 있습니다. 자세한 내용은 PCP 설치 및 활성화를 참조하십시오.

개인 클라이언트 키는

/etc/pcp/tls/client.key파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다.개인 키 및 CSR(인증서 서명 요청) 생성 및 CA(인증 기관)에서 인증서를 요청하는 방법에 대한 자세한 내용은 CA 문서를 참조하십시오.

-

TLS 클라이언트 인증서는

/etc/pcp/tls/client.crt파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다. -

CA 인증서는

/etc/pcp/tls/ca.crt파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다. 또한pmproxy데몬의 경우 다음을 수행합니다. -

개인 서버 키는

/etc/pcp/tls/server.key파일에 저장됩니다. 다른 경로를 사용하는 경우 프로세스의 해당 단계를 조정합니다. -

TLS 서버 인증서는

/etc/pcp/tls/server.crt파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다.

절차

CA 발행 인증서를 사용하여 보안 연결을 설정하도록 수집기 시스템에서 PCP TLS 구성 파일을 업데이트합니다.

# cat > /etc/pcp/tls.conf << END tls-ca-cert-file = /etc/pcp/tls/ca.crt tls-key-file = /etc/pcp/tls/server.key tls-cert-file = /etc/pcp/tls/server.crt tls-client-key-file = /etc/pcp/tls/client.key tls-client-cert-file = /etc/pcp/tls/client.crt END

PCP 수집기 인프라를 다시 시작합니다.

# systemctl restart pmcd.service # systemctl restart pmproxy.service

검증

TLS 구성을 확인합니다.

pmcd서비스에서 다음을 수행합니다.# grep 'Info:' /var/log/pcp/pmcd/pmcd.log [Tue Feb 07 11:47:33] pmcd(6558) Info: OpenSSL 3.0.7 setup

pmproxy서비스에서 다음을 수행합니다.# grep 'Info:' /var/log/pcp/pmproxy/pmproxy.log [Tue Feb 07 11:44:13] pmproxy(6014) Info: OpenSSL 3.0.7 setup

5.11.3. PCP 모니터링 구성 요소에 대한 보안 연결 구성

보안 PCP 프로토콜 교환에 참여하도록 PCP 모니터링 구성 요소를 구성합니다.

사전 요구 사항

- PCP가 설치되어 있습니다. 자세한 내용은 PCP 설치 및 활성화를 참조하십시오.

개인 클라이언트 키는

~/.pcp/tls/client.key파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다.개인 키 및 CSR(인증서 서명 요청) 생성 및 CA(인증 기관)에서 인증서를 요청하는 방법에 대한 자세한 내용은 CA 문서를 참조하십시오.

-

TLS 클라이언트 인증서는

~/.pcp/tls/client.crt파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다. -

CA 인증서는

/etc/pcp/tls/ca.crt파일에 저장됩니다. 다른 경로를 사용하는 경우 절차의 해당 단계를 조정합니다.

절차

다음 정보를 사용하여 TLS 구성 파일을 생성합니다.

$ home=

echo ~$ cat > ~/.pcp/tls.conf << END tls-ca-cert-file = /etc/pcp/tls/ca.crt tls-key-file = $home/.pcp/tls/client.key tls-cert-file = $home/.pcp/tls/client.crt END보안 연결을 설정합니다.

$ export PCP_SECURE_SOCKETS=enforce $ export PCP_TLSCONF_PATH=~/.pcp/tls.conf

검증

보안 연결이 구성되었는지 확인합니다.

$ pminfo --fetch --host pcps://localhost kernel.all.load kernel.all.load inst [1 or "1 minute"] value 1.26 inst [5 or "5 minute"] value 1.29 inst [15 or "15 minute"] value 1.28

5.12. 높은 메모리 사용량 문제 해결

다음 시나리오에서는 메모리 사용량이 증가할 수 있습니다.

-

pmproxy프로세스는 새 PCP 아카이브를 처리하는 데 사용 중이며 Redis 요청 및 응답을 처리하는 데 필요한 CPU 사이클은 없습니다. - Redis 노드 또는 클러스터가 과부하되어 제 시간에 들어오는 요청을 처리할 수 없습니다.

pmproxy 서비스 데몬은 Redis 스트림을 사용하며 PCP 튜닝 매개변수인 구성 매개 변수를 지원하며 Redis 메모리 사용량 및 키 보존에 영향을 미칩니다. /etc/pcp/pmproxy/pmproxy.conf 파일에는 pmproxy 및 관련 API에 사용 가능한 설정 옵션이 나열됩니다.

다음 절차에서는 높은 메모리 사용 문제를 해결하는 방법을 설명합니다.

사전 요구 사항

pcp-pmda-redis패키지를 설치합니다.# dnf install pcp-pmda-redis

redis PMDA를 설치합니다.

# cd /var/lib/pcp/pmdas/redis && ./Install

절차

메모리 사용량의 문제를 해결하려면 다음 명령을 실행하고

inflight열을 관찰합니다.$ pmrep :pmproxy backlog inflight reqs/s resp/s wait req err resp err changed throttled byte count count/s count/s s/s count/s count/s count/s count/s 14:59:08 0 0 N/A N/A N/A N/A N/A N/A N/A 14:59:09 0 0 2268.9 2268.9 28 0 0 2.0 4.0 14:59:10 0 0 0.0 0.0 0 0 0 0.0 0.0 14:59:11 0 0 0.0 0.0 0 0 0 0.0 0.0이 열에는 진행 중인 Redis 요청 수가 표시됩니다. 즉, 대기하거나 전송되며 지금까지 응답이 수신되지 않았습니다.

숫자가 높으면 다음 조건 중 하나를 나타냅니다.

-

pmproxy프로세스는 새 PCP 아카이브를 처리하는 데 사용 중이며 Redis 요청 및 응답을 처리하는 데 필요한 CPU 사이클은 없습니다. - Redis 노드 또는 클러스터가 과부하되어 제 시간에 들어오는 요청을 처리할 수 없습니다.

-

메모리 사용량이 많은 문제를 해결하려면 이 팜의

pmlogger프로세스 수를 줄이고 다른 pmloggerarm을 추가합니다. 페더레이션 - 여러 pmloggerarms 설정을 사용합니다.Redis 노드가 장기간에 100% CPU를 사용하는 경우 더 나은 성능을 갖춘 호스트로 이동하거나 클러스터형 Redis 설정을 대신 사용하십시오.

pmproxy.redis.*메트릭을 보려면 다음 명령을 사용합니다.$ pminfo -ftd pmproxy.redis pmproxy.redis.responses.wait [wait time for responses] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: counter Units: microsec value 546028367374 pmproxy.redis.responses.error [number of error responses] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: counter Units: count value 1164 [...] pmproxy.redis.requests.inflight.bytes [bytes allocated for inflight requests] Data Type: 64-bit int InDom: PM_INDOM_NULL 0xffffffff Semantics: discrete Units: byte value 0 pmproxy.redis.requests.inflight.total [inflight requests] Data Type: 64-bit unsigned int InDom: PM_INDOM_NULL 0xffffffff Semantics: discrete Units: count value 0 [...]진행 중인 Redis 요청 수를 보려면

pmproxy.redis.requests.inflight.total지표 및pmproxy.redis.requests.inflight.bytes지표를 참조하여 현재의 모든 inflight Redis 요청에 의해 사용되는 바이트 수를 확인합니다.일반적으로 redis 요청 대기열은 0이지만 대규모 pmloggerarms를 사용하여 빌드할 수 있으므로 확장성은 제한되고