Surveillance et gestion de l'état et des performances du système

Optimisation du débit, de la latence et de la consommation d'énergie du système

Résumé

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Démarrer avec TuneD

En tant qu'administrateur système, vous pouvez utiliser l'application TuneD pour optimiser le profil de performance de votre système pour une variété de cas d'utilisation.

1.1. L'objectif de TuneD

TuneD est un service qui surveille votre système et optimise les performances sous certaines charges de travail. Le cœur de TuneD est profiles, qui adapte votre système à différents cas d'utilisation.

TuneD est distribué avec un certain nombre de profils prédéfinis pour des cas d'utilisation tels que :

- Haut débit

- Faible latence

- Économie d'énergie

Il est possible de modifier les règles définies pour chaque profil et de personnaliser le réglage d'un appareil particulier. Lorsque vous passez à un autre profil ou que vous désactivez TuneD, toutes les modifications apportées aux paramètres du système par le profil précédent reviennent à leur état d'origine.

Vous pouvez également configurer TuneD pour qu'il réagisse aux changements d'utilisation des appareils et ajuste les paramètres afin d'améliorer les performances des appareils actifs et de réduire la consommation d'énergie des appareils inactifs.

1.2. Profils TuneD

L'analyse détaillée d'un système peut prendre beaucoup de temps. TuneD fournit un certain nombre de profils prédéfinis pour des cas d'utilisation typiques. Vous pouvez également créer, modifier et supprimer des profils.

Les profils fournis par TuneD sont répartis dans les catégories suivantes :

- Profils d'économie d'énergie

- Profils d'amélioration des performances

Les profils d'amélioration des performances comprennent des profils qui se concentrent sur les aspects suivants :

- Faible latence pour le stockage et le réseau

- Débit élevé pour le stockage et le réseau

- Performances de la machine virtuelle

- Performances des hôtes de virtualisation

Syntaxe de la configuration du profil

Le fichier tuned.conf peut contenir une section [main] et d'autres sections pour configurer les instances du plug-in. Cependant, toutes les sections sont facultatives.

Les lignes commençant par le signe dièse (#) sont des commentaires.

Ressources supplémentaires

-

tuned.conf(5)page de manuel.

1.3. Le profil TuneD par défaut

Lors de l'installation, le profil le mieux adapté à votre système est sélectionné automatiquement. Actuellement, le profil par défaut est sélectionné en fonction des règles personnalisables suivantes :

| Environnement | Profil par défaut | Objectif |

|---|---|---|

| Nœuds de calcul |

| La meilleure performance en termes de débit |

| Machines virtuelles |

|

La meilleure performance. Si vous n'êtes pas intéressé par les meilleures performances, vous pouvez choisir le profil |

| Autres cas |

| Performances et consommation d'énergie équilibrées |

Ressources supplémentaires

-

tuned.conf(5)page de manuel.

1.4. Profils TuneD fusionnés

À titre expérimental, il est possible de sélectionner plusieurs profils à la fois. TuneD essaiera de les fusionner pendant le chargement.

En cas de conflit, les paramètres du dernier profil spécifié sont prioritaires.

Exemple 1.1. Faible consommation d'énergie dans un invité virtuel

L'exemple suivant optimise le système pour qu'il fonctionne dans une machine virtuelle afin d'obtenir les meilleures performances et le règle simultanément pour qu'il consomme peu d'énergie, la priorité étant la faible consommation d'énergie :

# tuned-adm profile virtual-guest powersave

La fusion est effectuée automatiquement sans vérifier si la combinaison de paramètres qui en résulte a un sens. Par conséquent, la fonction peut régler certains paramètres de manière opposée, ce qui peut être contre-productif : par exemple, régler le disque pour un débit élevé en utilisant le profil throughput-performance et régler simultanément le spindown du disque à la valeur basse par le profil spindown-disk.

Ressources supplémentaires

*tuned-adm man page. * tuned.conf(5) man page.

1.5. Emplacement des profils TuneD

TuneD stocke les profils dans les répertoires suivants :

/usr/lib/tuned/-

Les profils spécifiques à la distribution sont stockés dans le répertoire. Chaque profil a son propre répertoire. Le profil consiste en un fichier de configuration principal appelé

tuned.conf, et éventuellement d'autres fichiers, par exemple des scripts d'aide. /etc/tuned/-

Si vous devez personnaliser un profil, copiez le répertoire du profil dans le répertoire utilisé pour les profils personnalisés. S'il existe deux profils portant le même nom, c'est le profil personnalisé situé dans

/etc/tuned/qui est utilisé.

Ressources supplémentaires

-

tuned.conf(5)page de manuel.

1.6. Profils TuneD distribués avec RHEL

La liste suivante est une liste de profils qui sont installés avec TuneD sur Red Hat Enterprise Linux.

Il peut y avoir des profils plus spécifiques à un produit ou des profils de tierce partie TuneD disponibles. Ces profils sont généralement fournis par des paquets RPM distincts.

balancedLe profil d'économie d'énergie par défaut. Il se veut un compromis entre les performances et la consommation d'énergie. Il utilise l'auto-scaling et l'auto-tuning dans la mesure du possible. Le seul inconvénient est l'augmentation de la latence. Dans la version actuelle de TuneD, il active les plugins CPU, disque, audio et vidéo, et active le gouverneur de CPU

conservative. L'optionradeon_powersaveutilise la valeurdpm-balancedsi elle est prise en charge, sinon elle prend la valeurauto.Il remplace l'attribut

energy_performance_preferencepar le paramètre d'énergienormal. Il modifie également l'attributscaling_governorpolicy enconservativeoupowersaveCPU governor.powersaveUn profil pour des performances maximales en matière d'économie d'énergie. Il peut limiter les performances afin de minimiser la consommation d'énergie réelle. Dans la version actuelle de TuneD, il permet l'autosuspend USB, l'économie d'énergie WiFi et l'économie d'énergie Aggressive Link Power Management (ALPM) pour les adaptateurs hôtes SATA. Il planifie également l'économie d'énergie multicœur pour les systèmes à faible taux de réveil et active le gouverneur

ondemand. Il active l'économie d'énergie audio AC97 ou, selon votre système, l'économie d'énergie HDA-Intel avec un délai de 10 secondes. Si votre système contient une carte graphique Radeon prise en charge avec KMS activé, le profil la configure en économie d'énergie automatique. Sur les ASUS Eee PC, un moteur Super Hybrid dynamique est activé.Il remplace l'attribut

energy_performance_preferencepar le paramètre d'énergiepowersaveoupower. Il modifie également l'attributscaling_governorpolicy enondemandoupowersaveCPU governor.NoteDans certains cas, le profil

balancedest plus efficace que le profilpowersave.Considérons qu'il y a une quantité définie de travail à effectuer, par exemple un fichier vidéo qui doit être transcodé. Votre machine peut consommer moins d'énergie si le transcodage est effectué à pleine puissance, car la tâche est terminée rapidement, la machine commence à tourner au ralenti et elle peut automatiquement passer à des modes d'économie d'énergie très efficaces. En revanche, si vous transcodez le fichier avec une machine bridée, la machine consomme moins d'énergie pendant le transcodage, mais le processus prend plus de temps et l'énergie totale consommée peut être plus élevée.

C'est pourquoi le profil

balancedpeut être une meilleure option.throughput-performanceProfil de serveur optimisé pour un débit élevé. Il désactive les mécanismes d'économie d'énergie et active les paramètres

sysctlqui améliorent le débit des disques et des entrées-sorties réseau. Le gouverneur de CPU est réglé surperformance.Il transforme les attributs

energy_performance_preferenceetscaling_governoren profilperformance.accelerator-performance-

Le profil

accelerator-performancecontient les mêmes réglages que le profilthroughput-performance. En outre, il verrouille le processeur sur des états C faibles afin que la latence soit inférieure à 100us. Cela permet d'améliorer les performances de certains accélérateurs, tels que les GPU. latency-performanceProfil de serveur optimisé pour une faible latence. Il désactive les mécanismes d'économie d'énergie et active les paramètres

sysctlqui améliorent la latence. Le gouverneur de CPU est réglé surperformanceet le CPU est verrouillé sur les états de faible C (par PM QoS).Il transforme les attributs

energy_performance_preferenceetscaling_governoren profilperformance.network-latencyUn profil pour l'optimisation des réseaux à faible latence. Il est basé sur le profil

latency-performance. Il désactive en outre les pages énormes transparentes et l'équilibrage NUMA, et règle plusieurs autres paramètres liés au réseau sursysctl.Il hérite du profil

latency-performancequi transforme les attributsenergy_performance_preferenceetscaling_governoren profilperformance.hpc-compute-

Un profil optimisé pour le calcul à haute performance. Il est basé sur le profil

latency-performance. network-throughputUn profil pour l'optimisation du débit des réseaux. Il est basé sur le profil

throughput-performance. Il augmente en outre les tampons réseau du noyau.Il hérite du profil

latency-performanceouthroughput-performanceet transforme les attributsenergy_performance_preferenceetscaling_governoren profilperformance.virtual-guestUn profil conçu pour les machines virtuelles Red Hat Enterprise Linux 9 et les invités VMWare basé sur le profil

throughput-performancequi, entre autres tâches, diminue l'échange de mémoire virtuelle et augmente les valeurs d'avance de lecture des disques. Il ne désactive pas les barrières de disque.Il hérite du profil

throughput-performanceet remplace les attributsenergy_performance_preferenceetscaling_governorpar le profilperformance.virtual-hostProfil conçu pour les hôtes virtuels sur la base du profil

throughput-performancequi, entre autres tâches, diminue la permutation de la mémoire virtuelle, augmente les valeurs d'avance de lecture des disques et permet une valeur plus agressive de l'écriture des pages sales.Il hérite du profil

throughput-performanceet remplace les attributsenergy_performance_preferenceetscaling_governorpar le profilperformance.oracle-

Un profil optimisé pour les chargements de bases de données Oracle basé sur le profil

throughput-performance. Il désactive en outre les pages énormes transparentes et modifie d'autres paramètres du noyau liés aux performances. Ce profil est fourni par le paquetagetuned-profiles-oracle. desktop-

Profil optimisé pour les ordinateurs de bureau, basé sur le profil

balanced. Il permet en outre des autogroupes de planificateurs pour une meilleure réponse des applications interactives. optimize-serial-consoleUn profil qui réduit l'activité des E/S vers la console série en réduisant la valeur de printk. Cela devrait rendre la console série plus réactive. Ce profil est destiné à être utilisé en superposition à d'autres profils. Par exemple :

# tuned-adm profile throughput-performance optimize-serial-console

mssql-

Un profil fourni pour Microsoft SQL Server. Il est basé sur le profil

throughput-performance. intel-sstProfil optimisé pour les systèmes avec des configurations Intel Speed Select Technology définies par l'utilisateur. Ce profil est destiné à être utilisé en superposition à d'autres profils. Par exemple :

# tuned-adm profile cpu-partitioning intel-sst

1.7. Profil de partitionnement du processeur TuneD

Pour régler Red Hat Enterprise Linux 9 pour les charges de travail sensibles à la latence, Red Hat recommande d'utiliser le profil cpu-partitioning TuneD.

Avant Red Hat Enterprise Linux 9, la documentation Red Hat sur les faibles temps de latence décrivait les nombreuses étapes de bas niveau nécessaires à l'obtention d'un réglage des faibles temps de latence. Dans Red Hat Enterprise Linux 9, vous pouvez effectuer un réglage de faible latence plus efficacement en utilisant le profil cpu-partitioning TuneD. Ce profil est facilement personnalisable en fonction des exigences des applications individuelles à faible latence.

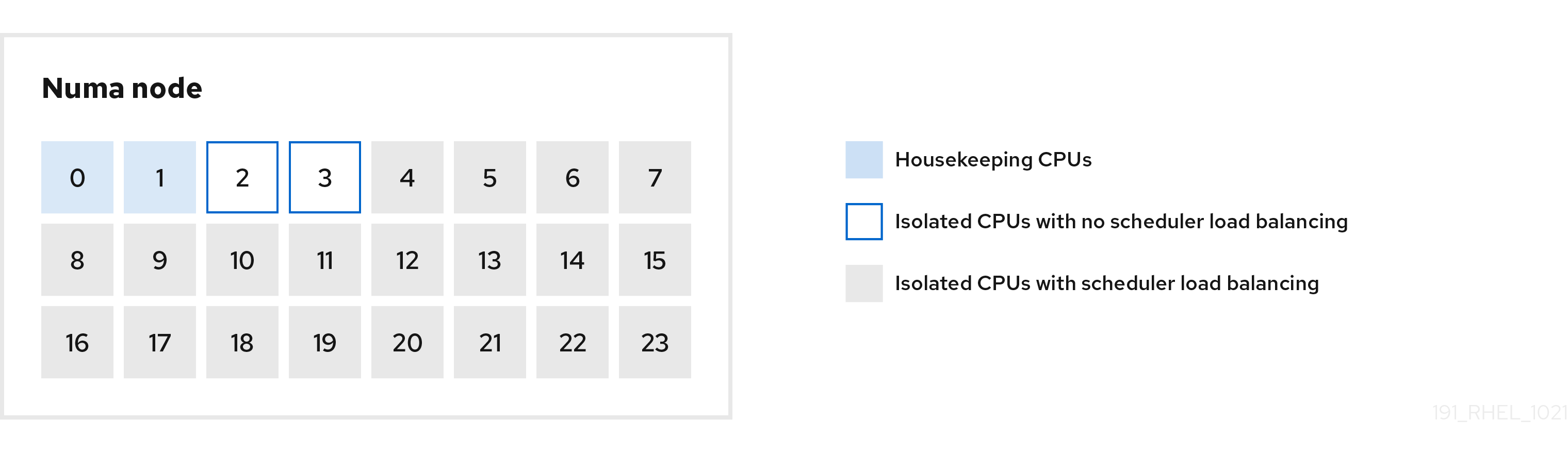

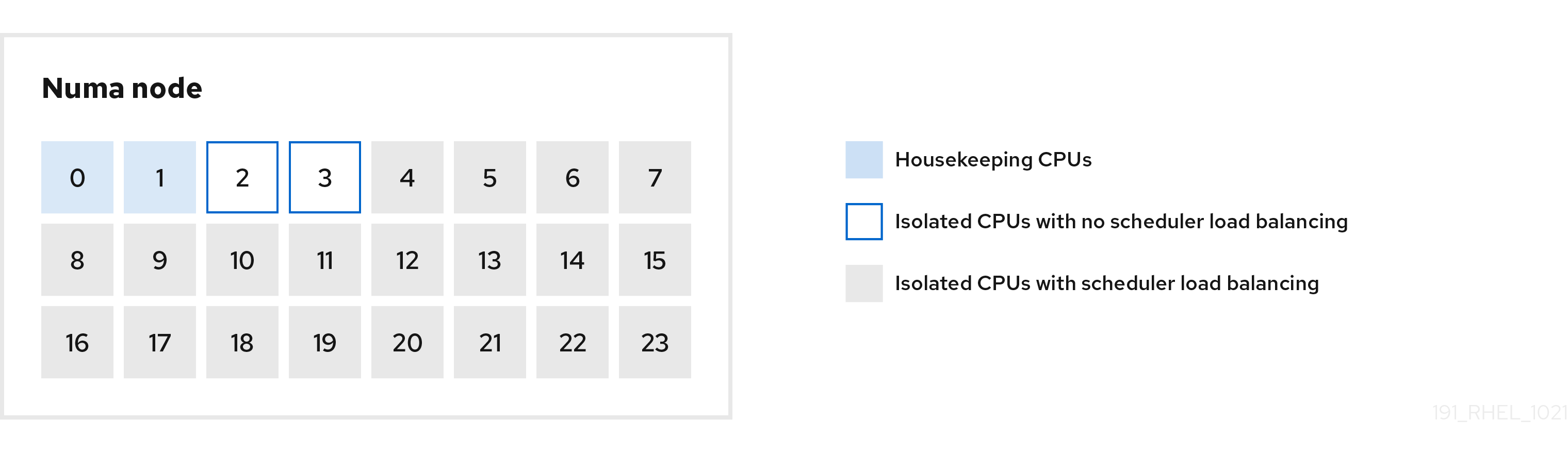

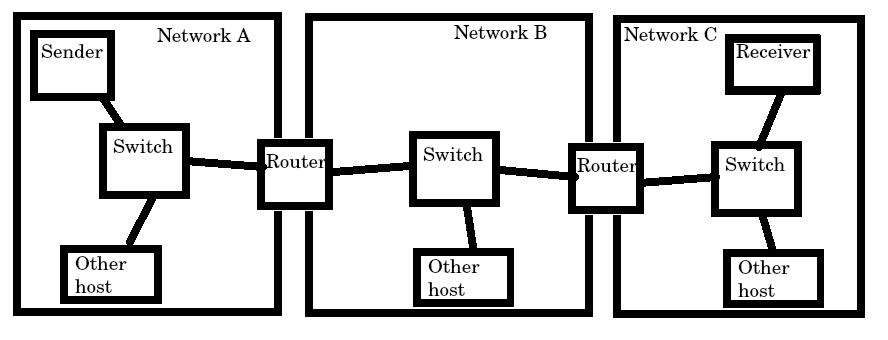

La figure suivante est un exemple d'utilisation du profil cpu-partitioning. Cet exemple utilise la disposition de l'unité centrale et des nœuds.

Figure 1.1. Figure partitionnement du processeur

Vous pouvez configurer le profil de partitionnement du processeur dans le fichier /etc/tuned/cpu-partitioning-variables.conf à l'aide des options de configuration suivantes :

- CPU isolés avec répartition de la charge

Dans la figure de partitionnement des processeurs, les blocs numérotés de 4 à 23 sont les processeurs isolés par défaut. L'équilibrage de la charge des processus de l'ordonnanceur du noyau est activé sur ces CPU. Il est conçu pour les processus à faible latence avec plusieurs threads qui ont besoin de l'équilibrage de la charge du planificateur du noyau.

Vous pouvez configurer le profil de partitionnement des processeurs dans le fichier

/etc/tuned/cpu-partitioning-variables.confà l'aide de l'optionisolated_cores=cpu-list, qui répertorie les processeurs à isoler qui utiliseront l'équilibrage de charge de l'ordonnanceur du noyau.La liste des unités centrales isolées est séparée par des virgules ou vous pouvez spécifier une plage à l'aide d'un tiret, comme

3-5. Cette option est obligatoire. Toute unité centrale absente de cette liste est automatiquement considérée comme une unité centrale de maintenance.- CPU isolés sans répartition de la charge

Dans la figure de partitionnement des CPU, les blocs numérotés 2 et 3 sont les CPU isolés qui ne fournissent pas d'équilibrage supplémentaire de la charge des processus de l'ordonnanceur du noyau.

Vous pouvez configurer le profil de partitionnement des processeurs dans le fichier

/etc/tuned/cpu-partitioning-variables.confà l'aide de l'optionno_balance_cores=cpu-list, qui répertorie les processeurs à isoler qui n'utiliseront pas l'équilibrage de charge de l'ordonnanceur du noyau.La spécification de l'option

no_balance_coresest facultative, mais tous les processeurs de cette liste doivent être un sous-ensemble des processeurs figurant dans la listeisolated_cores.Les threads d'application qui utilisent ces CPU doivent être épinglés individuellement à chaque CPU.

- Unité centrale d'entretien

-

Toute unité centrale qui n'est pas isolée dans le fichier

cpu-partitioning-variables.confest automatiquement considérée comme une unité centrale de maintenance. Sur ces unités centrales, tous les services, démons, processus utilisateur, threads mobiles du noyau, gestionnaires d'interruption et temporisateurs du noyau sont autorisés à s'exécuter.

Ressources supplémentaires

-

tuned-profiles-cpu-partitioning(7)page de manuel

1.8. Utilisation du profil de partitionnement du processeur TuneD pour un réglage à faible latence

Cette procédure décrit comment régler un système pour une faible latence en utilisant le profil cpu-partitioning de TuneD. Elle utilise l'exemple d'une application à faible latence qui peut utiliser cpu-partitioning et la disposition du processeur comme indiqué dans la figure de partitionnement du processeur.

Dans ce cas, l'application utilise :

- Un thread de lecture dédié, qui lit les données du réseau, sera placé sur l'unité centrale 2.

- Un grand nombre de threads qui traitent ces données réseau seront épinglés sur les CPU 4-23.

- Un thread d'écriture dédié qui écrit les données traitées sur le réseau sera placé sur l'unité centrale 3.

Conditions préalables

-

Vous avez installé le profil TuneD

cpu-partitioningen utilisant la commandednf install tuned-profiles-cpu-partitioningen tant que root.

Procédure

Modifiez le fichier

/etc/tuned/cpu-partitioning-variables.confet ajoutez les informations suivantes :# Isolated CPUs with the kernel’s scheduler load balancing: isolated_cores=2-23 # Isolated CPUs without the kernel’s scheduler load balancing: no_balance_cores=2,3

Définir le profil

cpu-partitioningTuneD :# tuned-adm profile cpu-partitioning

Reboot

Après le redémarrage, le système est réglé pour une faible latence, conformément à l'isolation dans la figure de partitionnement des processeurs. L'application peut utiliser taskset pour affecter les threads de lecture et d'écriture aux CPU 2 et 3, et les threads d'application restants aux CPU 4 à 23.

Ressources supplémentaires

-

tuned-profiles-cpu-partitioning(7)page de manuel

1.9. Personnalisation du profil TuneD de partitionnement du processeur

Vous pouvez étendre le profil TuneD pour apporter des modifications supplémentaires à l'accord.

Par exemple, le profil cpu-partitioning configure les unités centrales pour qu'elles utilisent cstate=1. Afin d'utiliser le profil cpu-partitioning mais de changer en plus l'état c du CPU de cstate1 à cstate0, la procédure suivante décrit un nouveau profil TuneD nommé my_profile, qui hérite du profil cpu-partitioning et définit ensuite l'état C-0.

Procédure

Créez le répertoire

/etc/tuned/my_profile:# mkdir /etc/tuned/my_profileCréez un fichier

tuned.confdans ce répertoire et ajoutez-y le contenu suivant :# vi /etc/tuned/my_profile/tuned.conf [main] summary=Customized tuning on top of cpu-partitioning include=cpu-partitioning [cpu] force_latency=cstate.id:0|1Utiliser le nouveau profil :

# tuned-adm profile my_profile

Dans l'exemple partagé, un redémarrage n'est pas nécessaire. Toutefois, si les modifications apportées au profil my_profile nécessitent un redémarrage pour être prises en compte, redémarrez votre machine.

Ressources supplémentaires

-

tuned-profiles-cpu-partitioning(7)page de manuel

1.10. Profils TuneD en temps réel distribués avec RHEL

Les profils temps réel sont destinés aux systèmes utilisant le noyau temps réel. Sans une compilation spéciale du noyau, ils ne configurent pas le système pour qu'il soit en temps réel. Sur RHEL, les profils sont disponibles dans des dépôts supplémentaires.

Les profils en temps réel suivants sont disponibles :

realtimeUtilisation sur des systèmes temps réel nus.

Fourni par le paquetage

tuned-profiles-realtime, qui est disponible dans les dépôts RT ou NFV.realtime-virtual-hostUtilisation dans un hôte de virtualisation configuré pour le temps réel.

Fourni par le paquetage

tuned-profiles-nfv-host, qui est disponible dans le référentiel NFV.realtime-virtual-guestUtilisation dans un invité de virtualisation configuré pour le temps réel.

Fourni par le paquetage

tuned-profiles-nfv-guest, qui est disponible dans le référentiel NFV.

1.11. Accord statique et dynamique dans TuneD

Il est important de comprendre la différence entre les deux catégories de réglage de système que TuneD applique, static et dynamic, pour déterminer laquelle utiliser pour une situation ou un objectif donné.

- Accord statique

-

Il s'agit principalement de l'application de paramètres prédéfinis

sysctletsysfset de l'activation ponctuelle de plusieurs outils de configuration tels queethtool. - Accord dynamique

Surveille la façon dont les différents composants du système sont utilisés tout au long de la durée de fonctionnement de votre système. TuneD ajuste les paramètres du système de façon dynamique sur la base de ces informations de surveillance.

Par exemple, le disque dur est fortement sollicité lors du démarrage et de la connexion, mais il est à peine utilisé par la suite, lorsque l'utilisateur travaille principalement avec des applications telles que des navigateurs web ou des clients de messagerie. De même, l'unité centrale et les périphériques réseau sont utilisés différemment selon les moments. TuneD surveille l'activité de ces composants et réagit aux changements dans leur utilisation.

Par défaut, l'optimisation dynamique est désactivée. Pour l'activer, modifiez le fichier

/etc/tuned/tuned-main.confet remplacez l'optiondynamic_tuningpar1. TuneD analyse alors périodiquement les statistiques du système et les utilise pour mettre à jour les paramètres de réglage de votre système. Pour configurer l'intervalle de temps en secondes entre ces mises à jour, utilisez l'optionupdate_interval.Les algorithmes de réglage dynamique actuellement mis en œuvre tentent d'équilibrer les performances et l'économie d'énergie, et sont donc désactivés dans les profils de performance. L'accord dynamique pour les plug-ins individuels peut être activé ou désactivé dans les profils TuneD.

Exemple 1.2. Accord statique et dynamique sur un poste de travail

Sur un poste de travail de bureau classique, l'interface réseau Ethernet est inactive la plupart du temps. Seuls quelques courriers électroniques entrent et sortent ou quelques pages web peuvent être chargées.

Pour ce type de charge, l'interface réseau n'a pas besoin de tourner à plein régime en permanence, comme c'est le cas par défaut. TuneD dispose d'un plug-in de surveillance et de réglage pour les périphériques réseau qui peut détecter cette faible activité et réduire automatiquement la vitesse de l'interface, ce qui se traduit généralement par une réduction de la consommation d'énergie.

Si l'activité sur l'interface augmente pendant une période prolongée, par exemple parce qu'une image de DVD est téléchargée ou qu'un e-mail contenant une pièce jointe volumineuse est ouvert, TuneD le détecte et règle la vitesse de l'interface au maximum afin d'offrir les meilleures performances lorsque le niveau d'activité est élevé.

Ce principe est également utilisé pour d'autres plug-ins pour l'unité centrale et les disques.

1.12. Mode TuneD sans démon

Vous pouvez exécuter TuneD en mode no-daemon, qui ne nécessite pas de mémoire résidente. Dans ce mode, TuneD applique les paramètres et se termine.

Par défaut, le mode no-daemon est désactivé car de nombreuses fonctionnalités de TuneD sont absentes dans ce mode, notamment :

- Support D-Bus

- Prise en charge de la connexion à chaud

- Prise en charge du retour en arrière pour les paramètres

Pour activer le mode no-daemon, incluez la ligne suivante dans le fichier /etc/tuned/tuned-main.conf:

daemon = 0

1.13. Installation et activation de TuneD

Cette procédure permet d'installer et d'activer l'application TuneD, d'installer les profils TuneD et de prédéfinir un profil TuneD par défaut pour votre système.

Procédure

Installez le paquetage

TuneD:# dnf install tuned

Activez et démarrez le service

TuneD:# systemctl enable --now tuned

En option, installez les profils TuneD pour les systèmes en temps réel :

Pour les profils TuneD pour les systèmes en temps réel, activez le référentiel

rhel-9.# subscription-manager repos --enable=rhel-9-for-x86_64-nfv-beta-rpms

Installez-le.

# dnf install tuned-profiles-realtime tuned-profiles-nfv

Vérifiez qu'un profil TuneD est actif et appliqué :

$ tuned-adm active Current active profile: throughput-performanceNoteLe profil actif présélectionné automatiquement par TuneD diffère selon le type de machine et les paramètres du système.

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

1.14. Liste des profils TuneD disponibles

Cette procédure dresse la liste de tous les profils TuneD actuellement disponibles sur votre système.

Procédure

Pour dresser la liste de tous les profils TuneD disponibles sur votre système, utilisez la touche

$ tuned-adm list Available profiles: - accelerator-performance - Throughput performance based tuning with disabled higher latency STOP states - balanced - General non-specialized TuneD profile - desktop - Optimize for the desktop use-case - latency-performance - Optimize for deterministic performance at the cost of increased power consumption - network-latency - Optimize for deterministic performance at the cost of increased power consumption, focused on low latency network performance - network-throughput - Optimize for streaming network throughput, generally only necessary on older CPUs or 40G+ networks - powersave - Optimize for low power consumption - throughput-performance - Broadly applicable tuning that provides excellent performance across a variety of common server workloads - virtual-guest - Optimize for running inside a virtual guest - virtual-host - Optimize for running KVM guests Current active profile: balanced

Pour n'afficher que le profil actuellement actif, utilisez :

$ tuned-adm active Current active profile: throughput-performance

Ressources supplémentaires

-

tuned-adm(8)page de manuel.

1.15. Définition d'un profil TuneD

Cette procédure permet d'activer un profil TuneD sélectionné sur votre système.

Conditions préalables

-

Le service

TuneDest en cours d'exécution. Voir Installation et activation de TuneD pour plus de détails.

Procédure

En option, vous pouvez laisser TuneD vous recommander le profil le plus adapté à votre système :

# tuned-adm recommend throughput-performanceActiver un profil :

# tuned-adm profile selected-profileVous pouvez également activer une combinaison de plusieurs profils :

# tuned-adm profile selected-profile1 selected-profile2

Exemple 1.3. Une machine virtuelle optimisée pour une faible consommation d'énergie

L'exemple suivant permet d'optimiser le système pour qu'il fonctionne dans une machine virtuelle offrant les meilleures performances et de le régler simultanément pour qu'il consomme peu d'énergie, la priorité étant de consommer peu d'énergie :

# tuned-adm profile virtual-guest powersave

Affichez le profil TuneD actuellement actif sur votre système :

# tuned-adm active Current active profile: selected-profileRedémarrer le système :

# reboot

Verification steps

Vérifiez que le profil TuneD est actif et appliqué :

$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Ressources supplémentaires

-

tuned-adm(8)page de manuel

1.16. Désactivation de TuneD

Cette procédure désactive TuneD et réinitialise tous les paramètres système concernés à leur état d'origine avant que TuneD ne les modifie.

Procédure

Pour désactiver temporairement tous les réglages :

# tuned-adm off

Les réglages sont de nouveau appliqués après le redémarrage du service

TuneD.Il est également possible d'arrêter et de désactiver définitivement le service

TuneD:# systemctl disable --now tuned

Ressources supplémentaires

-

tuned-adm(8)page de manuel

Chapitre 2. Personnalisation des profils TuneD

Vous pouvez créer ou modifier les profils TuneD afin d'optimiser les performances du système en fonction de l'utilisation que vous souhaitez en faire.

Conditions préalables

- Installez et activez TuneD comme décrit dans Installation et activation de TuneD pour plus de détails.

2.1. Profils TuneD

L'analyse détaillée d'un système peut prendre beaucoup de temps. TuneD fournit un certain nombre de profils prédéfinis pour des cas d'utilisation typiques. Vous pouvez également créer, modifier et supprimer des profils.

Les profils fournis par TuneD sont répartis dans les catégories suivantes :

- Profils d'économie d'énergie

- Profils d'amélioration des performances

Les profils d'amélioration des performances comprennent des profils qui se concentrent sur les aspects suivants :

- Faible latence pour le stockage et le réseau

- Débit élevé pour le stockage et le réseau

- Performances de la machine virtuelle

- Performances des hôtes de virtualisation

Syntaxe de la configuration du profil

Le fichier tuned.conf peut contenir une section [main] et d'autres sections pour configurer les instances du plug-in. Cependant, toutes les sections sont facultatives.

Les lignes commençant par le signe dièse (#) sont des commentaires.

Ressources supplémentaires

-

tuned.conf(5)page de manuel.

2.2. Le profil TuneD par défaut

Lors de l'installation, le profil le mieux adapté à votre système est sélectionné automatiquement. Actuellement, le profil par défaut est sélectionné en fonction des règles personnalisables suivantes :

| Environnement | Profil par défaut | Objectif |

|---|---|---|

| Nœuds de calcul |

| La meilleure performance en termes de débit |

| Machines virtuelles |

|

La meilleure performance. Si vous n'êtes pas intéressé par les meilleures performances, vous pouvez choisir le profil |

| Autres cas |

| Performances et consommation d'énergie équilibrées |

Ressources supplémentaires

-

tuned.conf(5)page de manuel.

2.3. Profils TuneD fusionnés

À titre expérimental, il est possible de sélectionner plusieurs profils à la fois. TuneD essaiera de les fusionner pendant le chargement.

En cas de conflit, les paramètres du dernier profil spécifié sont prioritaires.

Exemple 2.1. Faible consommation d'énergie dans un invité virtuel

L'exemple suivant optimise le système pour qu'il fonctionne dans une machine virtuelle afin d'obtenir les meilleures performances et le règle simultanément pour qu'il consomme peu d'énergie, la priorité étant la faible consommation d'énergie :

# tuned-adm profile virtual-guest powersave

La fusion est effectuée automatiquement sans vérifier si la combinaison de paramètres qui en résulte a un sens. Par conséquent, la fonction peut régler certains paramètres de manière opposée, ce qui peut être contre-productif : par exemple, régler le disque pour un débit élevé en utilisant le profil throughput-performance et régler simultanément le spindown du disque à la valeur basse par le profil spindown-disk.

Ressources supplémentaires

*tuned-adm man page. * tuned.conf(5) man page.

2.4. Emplacement des profils TuneD

TuneD stocke les profils dans les répertoires suivants :

/usr/lib/tuned/-

Les profils spécifiques à la distribution sont stockés dans le répertoire. Chaque profil a son propre répertoire. Le profil consiste en un fichier de configuration principal appelé

tuned.conf, et éventuellement d'autres fichiers, par exemple des scripts d'aide. /etc/tuned/-

Si vous devez personnaliser un profil, copiez le répertoire du profil dans le répertoire utilisé pour les profils personnalisés. S'il existe deux profils portant le même nom, c'est le profil personnalisé situé dans

/etc/tuned/qui est utilisé.

Ressources supplémentaires

-

tuned.conf(5)page de manuel.

2.5. Héritage entre les profils TuneD

TuneD les profils peuvent être basés sur d'autres profils et ne modifier que certains aspects de leur profil parent.

La section [main] des profils TuneD reconnaît l'option include:

[main]

include=parentTous les paramètres du profil parent sont chargés dans le profil child. Dans les sections suivantes, le profil child peut remplacer certains paramètres hérités du profil parent ou ajouter de nouveaux paramètres qui ne sont pas présents dans le parent ou ajouter de nouveaux paramètres qui ne sont pas présents dans le profil.

Vous pouvez créer votre propre profil child dans le répertoire /etc/tuned/ sur la base d'un profil préinstallé dans /usr/lib/tuned/ avec seulement quelques paramètres ajustés.

Si le profil parent est mis à jour, par exemple après une mise à niveau de TuneD, les modifications sont répercutées dans le profil child.

Exemple 2.2. Un profil d'économie d'énergie basé sur un équilibre

Voici un exemple de profil personnalisé qui étend le profil balanced et définit la gestion agressive de l'alimentation des liens (ALPM) pour tous les appareils sur l'économie d'énergie maximale.

[main] include=balanced [scsi_host] alpm=min_power

Ressources supplémentaires

-

tuned.conf(5)page de manuel

2.6. Accord statique et dynamique dans TuneD

Il est important de comprendre la différence entre les deux catégories de réglage de système que TuneD applique, static et dynamic, pour déterminer laquelle utiliser pour une situation ou un objectif donné.

- Accord statique

-

Il s'agit principalement de l'application de paramètres prédéfinis

sysctletsysfset de l'activation ponctuelle de plusieurs outils de configuration tels queethtool. - Accord dynamique

Surveille la façon dont les différents composants du système sont utilisés tout au long de la durée de fonctionnement de votre système. TuneD ajuste les paramètres du système de façon dynamique sur la base de ces informations de surveillance.

Par exemple, le disque dur est fortement sollicité lors du démarrage et de la connexion, mais il est à peine utilisé par la suite, lorsque l'utilisateur travaille principalement avec des applications telles que des navigateurs web ou des clients de messagerie. De même, l'unité centrale et les périphériques réseau sont utilisés différemment selon les moments. TuneD surveille l'activité de ces composants et réagit aux changements dans leur utilisation.

Par défaut, l'optimisation dynamique est désactivée. Pour l'activer, modifiez le fichier

/etc/tuned/tuned-main.confet remplacez l'optiondynamic_tuningpar1. TuneD analyse alors périodiquement les statistiques du système et les utilise pour mettre à jour les paramètres de réglage de votre système. Pour configurer l'intervalle de temps en secondes entre ces mises à jour, utilisez l'optionupdate_interval.Les algorithmes de réglage dynamique actuellement mis en œuvre tentent d'équilibrer les performances et l'économie d'énergie, et sont donc désactivés dans les profils de performance. L'accord dynamique pour les plug-ins individuels peut être activé ou désactivé dans les profils TuneD.

Exemple 2.3. Accord statique et dynamique sur un poste de travail

Sur un poste de travail de bureau classique, l'interface réseau Ethernet est inactive la plupart du temps. Seuls quelques courriers électroniques entrent et sortent ou quelques pages web peuvent être chargées.

Pour ce type de charge, l'interface réseau n'a pas besoin de tourner à plein régime en permanence, comme c'est le cas par défaut. TuneD dispose d'un plug-in de surveillance et de réglage pour les périphériques réseau qui peut détecter cette faible activité et réduire automatiquement la vitesse de l'interface, ce qui se traduit généralement par une réduction de la consommation d'énergie.

Si l'activité sur l'interface augmente pendant une période prolongée, par exemple parce qu'une image de DVD est téléchargée ou qu'un e-mail contenant une pièce jointe volumineuse est ouvert, TuneD le détecte et règle la vitesse de l'interface au maximum afin d'offrir les meilleures performances lorsque le niveau d'activité est élevé.

Ce principe est également utilisé pour d'autres plug-ins pour l'unité centrale et les disques.

2.7. Plug-ins TuneD

Les plug-ins sont des modules dans les profils TuneD que TuneD utilise pour surveiller ou optimiser différents dispositifs sur le système.

TuneD utilise deux types de plug-ins :

- Surveillance des plug-ins

Les modules d'extension de surveillance sont utilisés pour obtenir des informations sur un système en cours d'exécution. La sortie des plug-ins de surveillance peut être utilisée par les plug-ins de réglage pour le réglage dynamique.

Les plug-ins de surveillance sont automatiquement instanciés chaque fois que leurs métriques sont nécessaires à l'un des plug-ins d'optimisation activés. Si deux plug-ins de réglage ont besoin des mêmes données, une seule instance du plug-in de surveillance est créée et les données sont partagées.

- Plug-ins d'accordage

- Chaque plug-in de réglage règle un sous-système individuel et prend plusieurs paramètres issus des profils TuneD. Chaque sous-système peut avoir plusieurs périphériques, tels que plusieurs CPU ou cartes réseau, qui sont gérés par des instances individuelles des plug-ins de réglage. Des paramètres spécifiques pour des périphériques individuels sont également pris en charge.

Syntaxe pour les plug-ins dans les profils TuneD

Les sections décrivant les instances de plug-in sont formatées de la manière suivante :

[NAME] type=TYPE devices=DEVICES

- NAME

- est le nom de l'instance du plug-in tel qu'il est utilisé dans les journaux. Il peut s'agir d'une chaîne arbitraire.

- TYPE

- est le type de plug-in d'accord.

- DEVICES

est la liste des dispositifs gérés par cette instance de plug-in.

La ligne

devicespeut contenir une liste, un caractère de remplacement (*) et une négation (!). S'il n'y a pas de lignedevices, tous les dispositifs présents ou connectés ultérieurement sur le système de l'instance de plug-in sont pris en charge par l'instance de plug-in TYPE sont pris en charge par l'instance de plug-in. Cela revient à utiliser l'optiondevices=*.Exemple 2.4. Correspondance entre les dispositifs de blocage et un plug-in

L'exemple suivant correspond à tous les périphériques de bloc commençant par

sd, tels quesdaousdb, et ne désactive pas les barrières sur ces périphériques :[data_disk] type=disk devices=sd* disable_barriers=false

L'exemple suivant fait correspondre tous les blocs à l'exception de

sda1etsda2:[data_disk] type=disk devices=!sda1, !sda2 disable_barriers=false

Si aucune instance d'un plug-in n'est spécifiée, le plug-in n'est pas activé.

Si le plug-in prend en charge d'autres options, celles-ci peuvent également être spécifiées dans la section du plug-in. Si l'option n'est pas spécifiée et qu'elle n'a pas été spécifiée précédemment dans le plug-in inclus, la valeur par défaut est utilisée.

Syntaxe courte du plug-in

Si vous n'avez pas besoin de noms personnalisés pour l'instance du plug-in et qu'il n'y a qu'une seule définition de l'instance dans votre fichier de configuration, TuneD prend en charge la syntaxe courte suivante :

[TYPE] devices=DEVICES

Dans ce cas, il est possible d'omettre la ligne type. L'instance est alors désignée par un nom, identique à celui du type. L'exemple précédent pourrait alors être réécrit en :

Exemple 2.5. Correspondance entre les dispositifs de blocage à l'aide de la syntaxe courte

[disk] devices=sdb* disable_barriers=false

Définitions contradictoires de plug-ins dans un profil

Si la même section est spécifiée plusieurs fois à l'aide de l'option include, les paramètres sont fusionnés. S'ils ne peuvent pas être fusionnés en raison d'un conflit, la dernière définition conflictuelle remplace les paramètres précédents. Si vous ne savez pas ce qui a été défini précédemment, vous pouvez utiliser l'option booléenne replace et lui attribuer la valeur true. Toutes les définitions précédentes portant le même nom sont alors écrasées et la fusion n'a pas lieu.

Vous pouvez également désactiver le plug-in en spécifiant l'option enabled=false. L'effet est le même que si l'instance n'avait jamais été définie. La désactivation du plug-in est utile si vous redéfinissez la définition précédente à partir de l'option include et que vous ne souhaitez pas que le plug-in soit actif dans votre profil personnalisé.

- NOTE

TuneD inclut la possibilité d'exécuter n'importe quelle commande shell dans le cadre de l'activation ou de la désactivation d'un profil d'accord. Cela vous permet d'étendre les profils TuneD avec des fonctionnalités qui n'ont pas encore été intégrées dans TuneD.

Vous pouvez spécifier des commandes shell arbitraires à l'aide du plug-in

script.

Ressources supplémentaires

-

tuned.conf(5)page de manuel

2.8. Plug-ins TuneD disponibles

Surveillance des plug-ins

Actuellement, les plug-ins de surveillance suivants sont mis en œuvre :

disk- Obtient la charge du disque (nombre d'opérations d'E/S) par périphérique et par intervalle de mesure.

net- Obtient la charge du réseau (nombre de paquets transférés) par carte réseau et par intervalle de mesure.

load- Obtient la charge de l'unité centrale par unité centrale et l'intervalle de mesure.

Plug-ins d'accordage

Actuellement, les plug-ins d'accord suivants sont mis en œuvre. Seuls certains de ces plug-ins mettent en œuvre l'accord dynamique. Les options prises en charge par les plug-ins sont également répertoriées :

cpuDéfinit le gouverneur de CPU à la valeur spécifiée par l'option

governoret modifie dynamiquement la latence d'accès direct à la mémoire (DMA) du CPU dans le cadre de la qualité de service de la gestion de l'énergie (PM QoS) en fonction de la charge du CPU.Si la charge du CPU est inférieure à la valeur spécifiée par l'option

load_threshold, la latence est fixée à la valeur spécifiée par l'optionlatency_high, sinon elle est fixée à la valeur spécifiée parlatency_low.Vous pouvez également forcer la latence à une valeur spécifique et l'empêcher de changer dynamiquement. Pour ce faire, réglez l'option

force_latencysur la valeur de latence requise.eeepc_sheDéfinit dynamiquement la vitesse du bus frontal (FSB) en fonction de la charge du processeur.

Cette fonction, que l'on retrouve sur certains netbooks, est également connue sous le nom de Super Hybrid Engine (SHE) d'ASUS.

Si la charge du CPU est inférieure ou égale à la valeur spécifiée par l'option

load_threshold_powersave, le plug-in fixe la vitesse du FSB à la valeur spécifiée par l'optionshe_powersave. Si la charge du CPU est supérieure ou égale à la valeur spécifiée par l'optionload_threshold_normal, il fixe la vitesse du FSB à la valeur spécifiée par l'optionshe_normal.L'accord statique n'est pas pris en charge et le plug-in est désactivé de manière transparente si TuneD ne détecte pas la prise en charge matérielle de cette fonctionnalité.

net-

Configure la fonctionnalité Wake-on-LAN aux valeurs spécifiées par l'option

wake_on_lan. Il utilise la même syntaxe que l'utilitaireethtool. Il modifie aussi dynamiquement la vitesse de l'interface en fonction de son utilisation. sysctlDéfinit divers paramètres

sysctlspécifiés par les options du plug-in.La syntaxe est la suivante

name=valueoù name est identique au nom fourni par l'utilitairesysctl.Utilisez le plug-in

sysctlsi vous devez modifier des paramètres du système qui ne sont pas couverts par d'autres plug-ins disponibles dans TuneD. Si les paramètres sont couverts par certains plug-ins spécifiques, préférez ces plug-ins.usbDéfinit le délai de suspension automatique des périphériques USB à la valeur spécifiée par le paramètre

autosuspend.La valeur

0signifie que la suspension automatique est désactivée.vmActive ou désactive les grandes pages transparentes en fonction de la valeur de l'option

transparent_hugepages.Les valeurs valides de l'option

transparent_hugepagessont les suivantes :- \toujours"

- \Jamais

- "madvise"

audioDéfinit le délai de suspension automatique pour les codecs audio à la valeur spécifiée par l'option

timeout.Actuellement, les codecs

snd_hda_inteletsnd_ac97_codecsont pris en charge. La valeur0signifie que la suspension automatique est désactivée. Vous pouvez également imposer la réinitialisation du contrôleur en définissant l'option booléennereset_controllersurtrue.diskDéfinit l'ascenseur de disque à la valeur spécifiée par l'option

elevator.Il fixe également :

-

APM à la valeur spécifiée par l'option

apm -

Quantum de l'ordonnanceur à la valeur spécifiée par l'option

scheduler_quantum -

Délai d'attente du disque à la valeur spécifiée par l'option

spindown -

La valeur de l'avance de lecture du disque est fixée à la valeur spécifiée par le paramètre

readahead -

L'avance de lecture actuelle du disque à une valeur multipliée par la constante spécifiée par l'option

readahead_multiply

En outre, ce plug-in modifie dynamiquement les paramètres de gestion avancée de l'énergie et de temporisation du variateur en fonction de l'utilisation actuelle du variateur. Le réglage dynamique peut être contrôlé par l'option booléenne

dynamicet est activé par défaut.-

APM à la valeur spécifiée par l'option

scsi_hostAjuste les options pour les hôtes SCSI.

Il définit la gestion agressive de l'alimentation de la liaison (ALPM) à la valeur spécifiée par l'option

alpm.mounts-

Active ou désactive les barrières pour les montages en fonction de la valeur booléenne de l'option

disable_barriers. scriptExécute un script ou un binaire externe lorsque le profil est chargé ou déchargé. Vous pouvez choisir un exécutable arbitraire.

ImportantLe plug-in

scriptest fourni principalement à des fins de compatibilité avec les versions antérieures. Préférez d'autres plug-ins TuneD s'ils couvrent les fonctionnalités requises.TuneD appelle l'exécutable avec l'un des arguments suivants :

-

startlors du chargement du profil -

stoplors du déchargement du profil

Vous devez mettre en œuvre correctement l'action

stopdans votre exécutable et annuler tous les paramètres que vous avez modifiés au cours de l'actionstart. Sinon, l'étape de retour en arrière après avoir modifié votre profil TuneD ne fonctionnera pas.Les scripts Bash peuvent importer la bibliothèque Bash

/usr/lib/tuned/functionset utiliser les fonctions qui y sont définies. N'utilisez ces fonctions que pour des fonctionnalités qui ne sont pas fournies de manière native par TuneD. Si le nom d'une fonction commence par un trait de soulignement, comme_wifi_set_power_level, considérez la fonction comme privée et ne l'utilisez pas dans vos scripts, car elle pourrait changer à l'avenir.Spécifiez le chemin d'accès à l'exécutable à l'aide du paramètre

scriptdans la configuration du plug-in.Exemple 2.6. Exécuter un script Bash à partir d'un profil

Pour exécuter un script Bash nommé

script.shqui se trouve dans le répertoire du profil, utilisez :[script] script=${i:PROFILE_DIR}/script.sh-

sysfsDéfinit divers paramètres

sysfsspécifiés par les options du plug-in.La syntaxe est la suivante

name=value, où name est le chemin d'accèssysfsà utiliser.Utilisez ce plugin si vous devez modifier certains paramètres qui ne sont pas couverts par d'autres plugins. Préférez des plugins spécifiques s'ils couvrent les paramètres requis.

videoDéfinit différents niveaux d'économie d'énergie sur les cartes vidéo. Actuellement, seules les cartes Radeon sont prises en charge.

Le niveau d'économie d'énergie peut être spécifié à l'aide de l'option

radeon_powersave. Les valeurs prises en charge sont les suivantes :-

default -

auto -

low -

mid -

high -

dynpm -

dpm-battery -

dpm-balanced -

dpm-perfomance

Pour plus de détails, voir www.x.org. Notez que ce plug-in est expérimental et que l'option pourrait être modifiée dans les prochaines versions.

-

bootloaderAjoute des options à la ligne de commande du noyau. Ce plug-in ne prend en charge que le chargeur de démarrage GRUB 2.

Un emplacement personnalisé non standard du fichier de configuration GRUB 2 peut être spécifié par l'option

grub2_cfg_file.Les options du noyau sont ajoutées à la configuration actuelle de GRUB et à ses modèles. Le système doit être redémarré pour que les options du noyau prennent effet.

Le passage à un autre profil ou l'arrêt manuel du service

TuneDsupprime les options supplémentaires. Si vous arrêtez ou redémarrez le système, les options du noyau persistent dans le fichiergrub.cfg.Les options du noyau peuvent être spécifiées par la syntaxe suivante :

cmdline=arg1 arg2 ... argN

Exemple 2.7. Modifier la ligne de commande du noyau

Par exemple, pour ajouter l'option de noyau

quietà un profil TuneD, incluez les lignes suivantes dans le fichiertuned.conf:[bootloader] cmdline=quiet

Voici un exemple de profil personnalisé qui ajoute l'option

isolcpus=2à la ligne de commande du noyau :[bootloader] cmdline=isolcpus=2

2.9. Variables dans les profils TuneD

Les variables se développent au moment de l'exécution lorsqu'un profil TuneD est activé.

L'utilisation des variables TuneD réduit la quantité de données à saisir dans les profils TuneD.

Il n'y a pas de variables prédéfinies dans les profils TuneD. Vous pouvez définir vos propres variables en créant la section [variables] dans un profil et en utilisant la syntaxe suivante :

[variables] variable_name=value

Pour développer la valeur d'une variable dans un profil, utilisez la syntaxe suivante :

${variable_name}Exemple 2.8. Isolation des cœurs de l'unité centrale à l'aide de variables

Dans l'exemple suivant, la variable ${isolated_cores} se développe en 1,2; le noyau démarre donc avec l'option isolcpus=1,2:

[variables]

isolated_cores=1,2

[bootloader]

cmdline=isolcpus=${isolated_cores}

Les variables peuvent être spécifiées dans un fichier séparé. Par exemple, vous pouvez ajouter les lignes suivantes à tuned.conf:

[variables]

include=/etc/tuned/my-variables.conf

[bootloader]

cmdline=isolcpus=${isolated_cores}

Si vous ajoutez l'option isolated_cores=1,2 au fichier /etc/tuned/my-variables.conf, le noyau démarre avec l'option isolcpus=1,2.

Ressources supplémentaires

-

tuned.conf(5)page de manuel

2.10. Fonctions intégrées dans les profils TuneD

Les fonctions intégrées se développent en cours d'exécution lorsqu'un profil TuneD est activé.

Vous pouvez :

- Utiliser diverses fonctions intégrées avec des variables TuneD

- Créer des fonctions personnalisées en Python et les ajouter à TuneD sous forme de plug-ins

Pour appeler une fonction, utilisez la syntaxe suivante :

${f :function_name:argument_1:argument_2}

Pour développer le chemin du répertoire où se trouvent le profil et le fichier tuned.conf, utilisez la fonction PROFILE_DIR, qui requiert une syntaxe spéciale :

${i:PROFILE_DIR}Exemple 2.9. Isolation des cœurs de processeur à l'aide de variables et de fonctions intégrées

Dans l'exemple suivant, la variable ${non_isolated_cores} se développe en 0,3-5 et la fonction intégrée cpulist_invert est appelée avec l'argument 0,3-5:

[variables]

non_isolated_cores=0,3-5

[bootloader]

cmdline=isolcpus=${f:cpulist_invert:${non_isolated_cores}}

La fonction cpulist_invert inverse la liste des unités centrales. Pour une machine à 6 CPU, l'inversion est 1,2, et le noyau démarre avec l'option de ligne de commande isolcpus=1,2.

Ressources supplémentaires

-

tuned.conf(5)page de manuel

2.11. Fonctions intégrées disponibles dans les profils TuneD

Les fonctions intégrées suivantes sont disponibles dans tous les profils TuneD:

PROFILE_DIR-

Renvoie le chemin du répertoire où se trouvent le profil et le fichier

tuned.conf. exec- Exécute un processus et renvoie sa sortie.

assertion- Compare deux arguments. S'ils sont do not match, la fonction enregistre le texte du premier argument et interrompt le chargement du profil.

assertion_non_equal- Compare deux arguments. S'ils sont match, la fonction enregistre le texte du premier argument et interrompt le chargement du profil.

kb2s- Convertit les kilo-octets en secteurs de disque.

s2kb- Convertit les secteurs du disque en kilo-octets.

strip- Crée une chaîne de caractères à partir de tous les arguments passés et supprime les espaces blancs en début et en fin de chaîne.

virt_checkVérifie si TuneD s'exécute à l'intérieur d'une machine virtuelle (VM) ou sur du métal nu :

- À l'intérieur d'une VM, la fonction renvoie le premier argument.

- Sur le métal nu, la fonction renvoie le deuxième argument, même en cas d'erreur.

cpulist_invert-

Inverse une liste d'unités centrales pour obtenir son complément. Par exemple, sur un système avec 4 CPU, numérotés de 0 à 3, l'inversion de la liste

0,2,3est1. cpulist2hex- Convertit une liste de CPU en un masque de CPU hexadécimal.

cpulist2hex_invert- Convertit une liste de CPU en un masque de CPU hexadécimal et l'inverse.

hex2cpulist- Convertit un masque de CPU hexadécimal en une liste de CPU.

cpulist_online- Vérifie si les unités centrales de la liste sont en ligne. Renvoie la liste contenant uniquement les unités centrales en ligne.

cpulist_present- Vérifie si les unités centrales de la liste sont présentes. Renvoie la liste contenant uniquement les unités centrales présentes.

cpulist_unpack-

Décompresse une liste de CPU sous la forme de

1-3,4à1,2,3,4. cpulist_pack-

Fournit une liste d'unités centrales sous la forme de

1,2,3,5à1-3,5.

2.12. Création de nouveaux profils TuneD

Cette procédure crée un nouveau profil TuneD avec des règles de performance personnalisées.

Conditions préalables

-

Le service

TuneDest en cours d'exécution. Voir Installation et activation de TuneD pour plus de détails.

Procédure

Dans le répertoire

/etc/tuned/, créez un nouveau répertoire portant le même nom que le profil que vous souhaitez créer :# mkdir /etc/tuned/my-profileDans le nouveau répertoire, créez un fichier nommé

tuned.conf. Ajoutez-y une section[main]et des définitions de plug-ins, en fonction de vos besoins.Par exemple, voir la configuration du profil

balanced:[main] summary=General non-specialized TuneD profile [cpu] governor=conservative energy_perf_bias=normal [audio] timeout=10 [video] radeon_powersave=dpm-balanced, auto [scsi_host] alpm=medium_power

Pour activer le profil, utilisez :

# tuned-adm profile my-profileVérifiez que le profil TuneD est actif et que les paramètres du système sont appliqués :

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Ressources supplémentaires

-

tuned.conf(5)page de manuel

2.13. Modifier les profils TuneD existants

Cette procédure permet de créer un profil enfant modifié sur la base d'un profil TuneD existant.

Conditions préalables

-

Le service

TuneDest en cours d'exécution. Voir Installation et activation de TuneD pour plus de détails.

Procédure

Dans le répertoire

/etc/tuned/, créez un nouveau répertoire portant le même nom que le profil que vous souhaitez créer :# mkdir /etc/tuned/modified-profileDans le nouveau répertoire, créez un fichier nommé

tuned.conf, et définissez la section[main]comme suit :[main] include=parent-profileRemplacer parent-profile par le nom du profil que vous modifiez.

Inclure les modifications de votre profil.

Exemple 2.10. Diminution de la permutation dans le profil débit-performance

Pour utiliser les paramètres du profil

throughput-performanceet modifier la valeur devm.swappinessà 5, au lieu de la valeur par défaut de 10, utilisez :[main] include=throughput-performance [sysctl] vm.swappiness=5

Pour activer le profil, utilisez :

# tuned-adm profile modified-profileVérifiez que le profil TuneD est actif et que les paramètres du système sont appliqués :

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See tuned log file ('/var/log/tuned/tuned.log') for details.

Ressources supplémentaires

-

tuned.conf(5)page de manuel

2.14. Paramétrage du planificateur de disque à l'aide de TuneD

Cette procédure permet de créer et d'activer un profil TuneD qui définit un planificateur de disque donné pour les périphériques de bloc sélectionnés. Le paramètre persiste lors des redémarrages du système.

Dans les commandes et la configuration suivantes, remplacer :

-

device avec le nom du dispositif de blocage, par exemple

sdf -

selected-scheduler avec le planificateur de disque que vous souhaitez définir pour le périphérique, par exemple

bfq

Conditions préalables

-

Le service

TuneDest installé et activé. Pour plus de détails, voir Installation et activation de TuneD.

Procédure

Facultatif : Sélectionnez un profil TuneD existant sur lequel votre profil sera basé. Pour obtenir une liste des profils disponibles, voir les profils TuneD distribués avec RHEL.

Pour savoir quel profil est actuellement actif, utilisez :

$ tuned-adm active

Créez un nouveau répertoire qui contiendra votre profil TuneD:

# mkdir /etc/tuned/my-profileRecherchez l'identifiant unique du système du bloc sélectionné :

$ udevadm info --query=property --name=/dev/device | grep -E '(WWN|SERIAL)' ID_WWN=0x5002538d00000000_ ID_SERIAL=Generic-_SD_MMC_20120501030900000-0:0 ID_SERIAL_SHORT=20120501030900000

NoteLa commande de cet exemple renverra toutes les valeurs identifiées par un World Wide Name (WWN) ou un numéro de série associé au dispositif de bloc spécifié. Bien qu'il soit préférable d'utiliser un WWN, celui-ci n'est pas toujours disponible pour un dispositif donné et toutes les valeurs renvoyées par la commande de l'exemple peuvent être utilisées comme device system unique ID.

Créer le fichier de

/etc/tuned/my-profile/tuned.conffichier de configuration. Dans le fichier, définissez les options suivantes :Facultatif : Inclure un profil existant :

[main] include=existing-profileDéfinir le planificateur de disque sélectionné pour le périphérique qui correspond à l'identifiant WWN :

[disk] devices_udev_regex=IDNAME=device system unique id elevator=selected-scheduler

Ici :

-

Remplacer IDNAME par le nom de l'identifiant utilisé (par exemple,

ID_WWN). Remplacer device system unique id par la valeur de l'identifiant choisi (par exemple,

0x5002538d00000000).Pour faire correspondre plusieurs appareils dans l'option

devices_udev_regex, mettez les identifiants entre parenthèses et séparez-les par des barres verticales :devices_udev_regex=(ID_WWN=0x5002538d00000000)|(ID_WWN=0x1234567800000000)

-

Remplacer IDNAME par le nom de l'identifiant utilisé (par exemple,

Activez votre profil :

# tuned-adm profile my-profile

Verification steps

Vérifiez que le profil TuneD est actif et appliqué :

$ tuned-adm active Current active profile: my-profile$ tuned-adm verify Verification succeeded, current system settings match the preset profile. See TuneD log file ('/var/log/tuned/tuned.log') for details.Lire le contenu du

/sys/block/device/queue/schedulerfichier :# cat /sys/block/device/queue/scheduler [mq-deadline] kyber bfq noneDans le nom du fichier, remplacez device par le nom du bloc, par exemple

sdc.Le planificateur actif est indiqué entre crochets (

[]).

Ressources supplémentaires

Chapitre 3. Révision d'un système à l'aide de l'interface tuna

Utilisez l'outil tuna pour ajuster les paramètres de l'ordonnanceur, la priorité des threads, les gestionnaires d'IRQ et pour isoler les cœurs et les sockets de l'unité centrale. Tuna réduit la complexité des tâches de réglage.

L'outil tuna effectue les opérations suivantes :

- Liste des unités centrales d'un système

- Répertorie les demandes d'interruption (IRQ) en cours sur un système

- Modifie les informations relatives à la politique et à la priorité sur les fils de discussion

- Affiche les politiques et priorités actuelles d'un système

3.1. Installation de l'outil thon

L'outil tuna est conçu pour être utilisé sur un système en fonctionnement. Cela permet aux outils de mesure spécifiques à une application de voir et d'analyser les performances du système immédiatement après que des modifications ont été apportées.

Cette procédure décrit comment installer l'outil tuna.

Procédure

Installer l'outil

tuna:# dnf install tuna

Verification steps

Voir les options CLI disponibles sur

tuna:# tuna -h

Ressources supplémentaires

-

tuna(8)page de manuel

3.2. Visualisation de l'état du système à l'aide de l'outil tuna

Cette procédure décrit comment visualiser l'état du système à l'aide de l'outil d'interface de ligne de commande (CLI) tuna.

Conditions préalables

- L'outil tuna est installé. Pour plus d'informations, voir Installation de l'outil tuna.

Procédure

Pour consulter les politiques et priorités actuelles :

# tuna --show_threads thread pid SCHED_ rtpri affinity cmd 1 OTHER 0 0,1 init 2 FIFO 99 0 migration/0 3 OTHER 0 0 ksoftirqd/0 4 FIFO 99 0 watchdog/0Pour visualiser un fil spécifique correspondant à un PID ou à un nom de commande :

# tuna --threads=pid_or_cmd_list --show_threadsL'argument pid_or_cmd_list est une liste de PID ou de noms de commande séparés par des virgules.

-

Pour régler les processeurs à l'aide de l'interface CLI de

tuna, voir Réglage des processeurs à l'aide de l'outil tuna. -

Pour régler les IRQ à l'aide de l'outil

tuna, voir Réglage des IRQ à l'aide de l'outil tuna. Pour enregistrer la configuration modifiée :

# tuna --save=filename

Cette commande ne sauvegarde que les threads du noyau en cours d'exécution. Les processus qui ne sont pas en cours d'exécution ne sont pas sauvegardés.

Ressources supplémentaires

-

tuna(8)page de manuel

3.3. Optimisation des processeurs à l'aide de l'outil tuna

Les commandes de l'outil tuna peuvent cibler des unités centrales individuelles.

En utilisant l'outil thon, vous pouvez

Isolate CPUs- Toutes les tâches exécutées sur l'unité centrale spécifiée se déplacent vers la prochaine unité centrale disponible. L'isolation d'une unité centrale la rend indisponible en la supprimant du masque d'affinité de tous les threads.

Include CPUs- Permet aux tâches de s'exécuter sur l'unité centrale spécifiée

Restore CPUs- Rétablit la configuration précédente de l'unité centrale spécifiée.

Cette procédure décrit comment régler les CPU à l'aide de l'interface CLI de tuna.

Conditions préalables

- L'outil tuna est installé. Pour plus d'informations, voir Installation de l'outil tuna.

Procédure

Pour spécifier la liste des unités centrales devant être affectées par une commande :

# tuna --cpus=cpu_list [command]

L'argument cpu_list est une liste de numéros de CPU séparés par des virgules. Par exemple,

--cpus=0,2. Les listes d'unités centrales peuvent également être spécifiées dans une plage, par exemple--cpus=”1-3”qui sélectionnerait les unités centrales 1, 2 et 3.Pour ajouter une unité centrale spécifique à l'actuelle cpu_list, par exemple, utilisez

--cpus= 0.Remplacer [command] par, par exemple,

--isolate.Pour isoler une unité centrale :

# tuna --cpus=cpu_list --isolate

Pour inclure une unité centrale :

# tuna --cpus=cpu_list --include

Pour utiliser un système à quatre processeurs ou plus, montrez comment faire en sorte que tous les threads ssh s'exécutent sur les unités centrales 0 et 1, et tous les threads

httpsur les unités centrales 2 et 3:# tuna --cpus=0,1 --threads=ssh\* \ --move --cpus=2,3 --threads=http\* --move

Cette commande permet d'effectuer les opérations suivantes de manière séquentielle :

- Sélectionne les unités centrales 0 et 1.

-

Sélectionne tous les fils qui commencent par

ssh. -

Déplace les threads sélectionnés vers les unités centrales sélectionnées. Tuna définit le masque d'affinité des threads commençant par

sshvers les CPU appropriés. Les CPU peuvent être exprimés numériquement par 0 et 1, en masque hexagonal par 0x3, ou en binaire par 11. - Réinitialise la liste des unités centrales à 2 et 3.

-

Sélectionne tous les fils qui commencent par

http. -

Déplace les threads sélectionnés vers les unités centrales spécifiées. Tuna définit le masque d'affinité des threads commençant par

httpvers les unités centrales spécifiées. Les unités centrales peuvent être exprimées numériquement par 2 et 3, en masque hexagonal par 0xC, ou en binaire par 1100.

Verification steps

Affichez la configuration actuelle et vérifiez que les modifications ont été effectuées comme prévu :

# tuna --threads=gnome-sc\* --show_threads \ --cpus=0 --move --show_threads --cpus=1 \ --move --show_threads --cpus=+0 --move --show_threads thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 1 33997 58 gnome-screensav thread ctxt_switches pid SCHED_ rtpri affinity voluntary nonvoluntary cmd 3861 OTHER 0 0,1 33997 58 gnome-screensav

Cette commande permet d'effectuer les opérations suivantes de manière séquentielle :

-

Sélectionne tous les fils qui commencent par les fils

gnome-sc. - Affiche les threads sélectionnés pour permettre à l'utilisateur de vérifier leur masque d'affinité et leur priorité RT.

- Sélectionne l'unité centrale 0.

-

Déplace les threads

gnome-scvers l'unité centrale spécifiée, l'unité centrale 0. - Affiche le résultat du déplacement.

- Réinitialise la liste des CPU à CPU 1.

-

Déplace les threads

gnome-scvers l'unité centrale spécifiée, l'unité centrale 1. - Affiche le résultat du déplacement.

- Ajoute l'unité centrale 0 à la liste des unités centrales.

-

Déplace les threads

gnome-scvers les unités centrales spécifiées, les unités centrales 0 et 1. - Affiche le résultat du déplacement.

-

Sélectionne tous les fils qui commencent par les fils

Ressources supplémentaires

-

/proc/cpuinfofichier -

tuna(8)page de manuel

3.4. Réglage des IRQ à l'aide de l'outil tuna

Le fichier /proc/interrupts enregistre le nombre d'interruptions par IRQ, le type d'interruption et le nom du périphérique situé à cette IRQ.

Cette procédure décrit comment régler les IRQ à l'aide de l'outil tuna.

Conditions préalables

- L'outil tuna est installé. Pour plus d'informations, voir Installation de l'outil tuna.

Procédure

Pour afficher les IRQ en cours et leur affinité :

# tuna --show_irqs # users affinity 0 timer 0 1 i8042 0 7 parport0 0

Pour spécifier la liste des IRQ à affecter par une commande :

# tuna --irqs=irq_list [command]

L'argument irq_list est une liste de numéros d'IRQ ou de noms d'utilisateurs séparés par des virgules.

Remplacer [command] par, par exemple,

--spread.Pour déplacer une interruption vers une unité centrale spécifiée :

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 0,1,2,3 # tuna --irqs=128 --cpus=3 --move

Remplacez 128 par l'argument irq_list et 3 par l'argument cpu_list.

L'argument cpu_list est une liste de numéros de CPU séparés par des virgules, par exemple,

--cpus=0,2. Pour plus d'informations, voir Tuning CPUs using tuna tool.

Verification steps

Comparer l'état des IRQ sélectionnées avant et après le déplacement d'une interruption vers une unité centrale spécifiée :

# tuna --irqs=128 --show_irqs # users affinity 128 iwlwifi 3

Ressources supplémentaires

-

/procs/interruptsfichier -

tuna(8)page de manuel

Chapitre 4. Surveillance des performances à l'aide des rôles système RHEL

En tant qu'administrateur système, vous pouvez utiliser le rôle système metrics RHEL pour surveiller les performances d'un système.

4.1. Préparation d'un nœud de contrôle et de nœuds gérés à l'utilisation des rôles système RHEL

Avant de pouvoir utiliser des rôles système RHEL individuels pour gérer des services et des paramètres, vous devez préparer le nœud de contrôle et les nœuds gérés.

4.1.1. Préparation d'un nœud de contrôle sur RHEL 9

Avant d'utiliser RHEL System Roles, vous devez configurer un nœud de contrôle. Ce système configure ensuite les hôtes gérés à partir de l'inventaire conformément aux playbooks.

Conditions préalables

- RHEL 8.6 ou une version ultérieure est installée. Pour plus d'informations sur l'installation de RHEL, voir Effectuer une installation standard de RHEL 9.

- Le système est enregistré sur le portail client.

-

Un abonnement

Red Hat Enterprise Linux Serverest attaché au système. -

S'il est disponible dans votre compte Portail Client, un abonnement

Ansible Automation Platformest attaché au système.

Procédure

Installez le paquetage

rhel-system-roles:[root@control-node]# dnf install rhel-system-rolesCette commande installe le paquet

ansible-coreen tant que dépendance.NoteDans RHEL 8.5 et les versions antérieures, les packages Ansible étaient fournis via Ansible Engine au lieu d'Ansible Core, et avec un niveau de support différent. N'utilisez pas Ansible Engine car les packages peuvent ne pas être compatibles avec le contenu d'automatisation Ansible dans RHEL 8.6 et les versions ultérieures. Pour plus d'informations, voir Étendue de la prise en charge du package Ansible Core inclus dans les référentiels AppStream RHEL 9 et RHEL 8.6 et versions ultérieures.

Créez un utilisateur nommé

ansiblepour gérer et exécuter les playbooks :[root@control-node]# useradd ansiblePassez à l'utilisateur nouvellement créé

ansible:[root@control-node]# su - ansibleEffectuez le reste de la procédure en tant qu'utilisateur.

Créez une clé publique et une clé privée SSH :

[ansible@control-node]$ ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/home/ansible/.ssh/id_rsa): <password> ...

Utilisez l'emplacement par défaut proposé pour le fichier clé.

- Facultatif : Pour éviter qu'Ansible ne vous demande le mot de passe de la clé SSH à chaque fois que vous établissez une connexion, configurez un agent SSH.

Créez le fichier

~/.ansible.cfgavec le contenu suivant :[defaults] inventory = /home/ansible/inventory remote_user = ansible [privilege_escalation] become = True become_method = sudo become_user = root become_ask_pass = True

NoteLes paramètres du fichier

~/.ansible.cfgont une priorité plus élevée et remplacent les paramètres du fichier global/etc/ansible/ansible.cfg.Avec ces paramètres, Ansible effectue les actions suivantes :

- Gère les hôtes dans le fichier d'inventaire spécifié.

-

Utilise le compte défini dans le paramètre

remote_userlorsqu'il établit des connexions SSH avec les nœuds gérés. -

Utilise l'utilitaire

sudopour exécuter des tâches sur les nœuds gérés en tant qu'utilisateurroot. - Demande le mot de passe root de l'utilisateur distant à chaque fois que vous appliquez un playbook. Ceci est recommandé pour des raisons de sécurité.

Créez un fichier

~/inventoryau format INI ou YAML qui répertorie les noms d'hôtes gérés. Vous pouvez également définir des groupes d'hôtes dans le fichier d'inventaire. Par exemple, voici un fichier d'inventaire au format INI avec trois hôtes et un groupe d'hôtes nomméUS:managed-node-01.example.com [US] managed-node-02.example.com ansible_host=192.0.2.100 managed-node-03.example.com

Notez que le nœud de contrôle doit être en mesure de résoudre les noms d'hôte. Si le serveur DNS ne peut pas résoudre certains noms d'hôtes, ajoutez le paramètre

ansible_hostà côté de l'entrée de l'hôte pour spécifier son adresse IP.

Prochaines étapes

- Préparez les nœuds gérés. Pour plus d'informations, voir Préparation d'un nœud géré.

Ressources supplémentaires

- Étendue de la prise en charge du package Ansible Core inclus dans les référentiels AppStream RHEL 9 et RHEL 8.6 et versions ultérieures

- Comment enregistrer et abonner un système au portail client de Red Hat à l'aide du gestionnaire d'abonnements ?

-

La page de manuel

ssh-keygen(1) - Se connecter à des machines distantes avec des clés SSH en utilisant ssh-agent

- Paramètres de configuration d'Ansible

- Comment constituer votre inventaire

4.1.2. Préparation d'un nœud géré

Les nœuds gérés sont les systèmes répertoriés dans l'inventaire et qui seront configurés par le nœud de contrôle conformément au cahier de jeu. Il n'est pas nécessaire d'installer Ansible sur les hôtes gérés.

Conditions préalables

- Vous avez préparé le nœud de contrôle. Pour plus d'informations, voir Préparation d'un nœud de contrôle sur RHEL 9.

Vous disposez d'un accès SSH à partir du nœud de contrôle.

ImportantL'accès SSH direct en tant qu'utilisateur

rootprésente un risque pour la sécurité. Pour réduire ce risque, vous créerez un utilisateur local sur ce nœud et configurerez une politiquesudolors de la préparation d'un nœud géré. Ansible sur le nœud de contrôle peut alors utiliser le compte d'utilisateur local pour se connecter au nœud géré et exécuter des playbooks en tant qu'utilisateurs différents, tels queroot.

Procédure

Créez un utilisateur nommé

ansible:[root@managed-node-01]# useradd ansibleLe nœud de contrôle utilise ensuite cet utilisateur pour établir une connexion SSH avec cet hôte.

Définir un mot de passe pour l'utilisateur

ansible:[root@managed-node-01]# passwd ansible Changing password for user ansible. New password: <password> Retype new password: <password> passwd: all authentication tokens updated successfully.

Vous devez saisir ce mot de passe lorsque Ansible utilise

sudopour effectuer des tâches en tant qu'utilisateurroot.Installez la clé publique SSH de l'utilisateur

ansiblesur le nœud géré :Connectez-vous au nœud de contrôle en tant qu'utilisateur

ansibleet copiez la clé publique SSH sur le nœud géré :[ansible@control-node]$ ssh-copy-id managed-node-01.example.com /usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/home/ansible/.ssh/id_rsa.pub" The authenticity of host 'managed-node-01.example.com (192.0.2.100)' can't be established. ECDSA key fingerprint is SHA256:9bZ33GJNODK3zbNhybokN/6Mq7hu3vpBXDrCxe7NAvo.

Lorsque vous y êtes invité, connectez-vous en entrant

yes:Are you sure you want to continue connecting (yes/no/[fingerprint])? yes /usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed /usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keysLorsque vous y êtes invité, saisissez le mot de passe :

ansible@managed-node-01.example.com's password: <password> Number of key(s) added: 1 Now try logging into the machine, with: "ssh '<managed-node-01.example.com>'" and check to make sure that only the key(s) you wanted were added.

Vérifiez la connexion SSH en exécutant à distance une commande sur le nœud de contrôle :

[ansible@control-node]$ ssh <managed-node-01.example.com> whoami ansible

Créer une configuration

sudopour l'utilisateuransible:Créez et modifiez le fichier

/etc/sudoers.d/ansibleà l'aide de la commandevisudo:[root@managed-node-01]# visudo /etc/sudoers.d/ansibleL'avantage d'utiliser

visudoplutôt qu'un éditeur normal est que cet utilitaire fournit des contrôles de base et vérifie les erreurs d'analyse avant d'installer le fichier.Configurez une politique

sudoersdans le fichier/etc/sudoers.d/ansiblequi réponde à vos besoins, par exemple :Pour autoriser l'utilisateur

ansibleà exécuter toutes les commandes en tant qu'utilisateur et groupe sur cet hôte après avoir saisi le mot de passe de l'utilisateuransible, utilisez l'option suivante :ansible ALL=(ALL) ALLPour autoriser l'utilisateur

ansibleà exécuter toutes les commandes en tant qu'utilisateur et groupe sur cet hôte sans saisir le mot de passe de l'utilisateuransible, utilisez la commande suivanteansible ALL=(ALL) NOPASSWD: ALL

Vous pouvez également configurer une politique plus fine qui correspond à vos exigences en matière de sécurité. Pour plus d'informations sur les politiques de

sudoers, voir la page de manuelsudoers(5).

Vérification

Vérifiez que vous pouvez exécuter des commandes à partir du nœud de contrôle sur tous les nœuds gérés :

[ansible@control-node]$ ansible all -m ping BECOME password: <password> managed-node-01.example.com | SUCCESS => { "ansible_facts": { "discovered_interpreter_python": "/usr/bin/python3" }, "changed": false, "ping": "pong" } ...

Le groupe all codé en dur contient dynamiquement tous les hôtes répertoriés dans le fichier d'inventaire.

Vérifiez que l'escalade des privilèges fonctionne correctement en exécutant l'utilitaire