Migration Toolkit for Containers

OpenShift Container Platform 4로 마이그레이션

초록

1장. Migration Toolkit for Containers 정보

MTC(Migration Toolkit for Containers)를 사용하면 네임스페이스 단위로 OpenShift Container Platform 4 클러스터 간에 상태 저장 애플리케이션 워크로드를 마이그레이션할 수 있습니다.

OpenShift Container Platform 3에서 마이그레이션하는 경우 OpenShift Container Platform 3에서 4로 마이그레이션 정보 및 OpenShift Container Platform 3에 레거시 Migration Toolkit for Containers Operator 설치에서 참조하십시오.

상태 마이그레이션을 사용하여 동일한 클러스터 내에서 또는 클러스터 간에 애플리케이션을 마이그레이션할 수 있습니다.

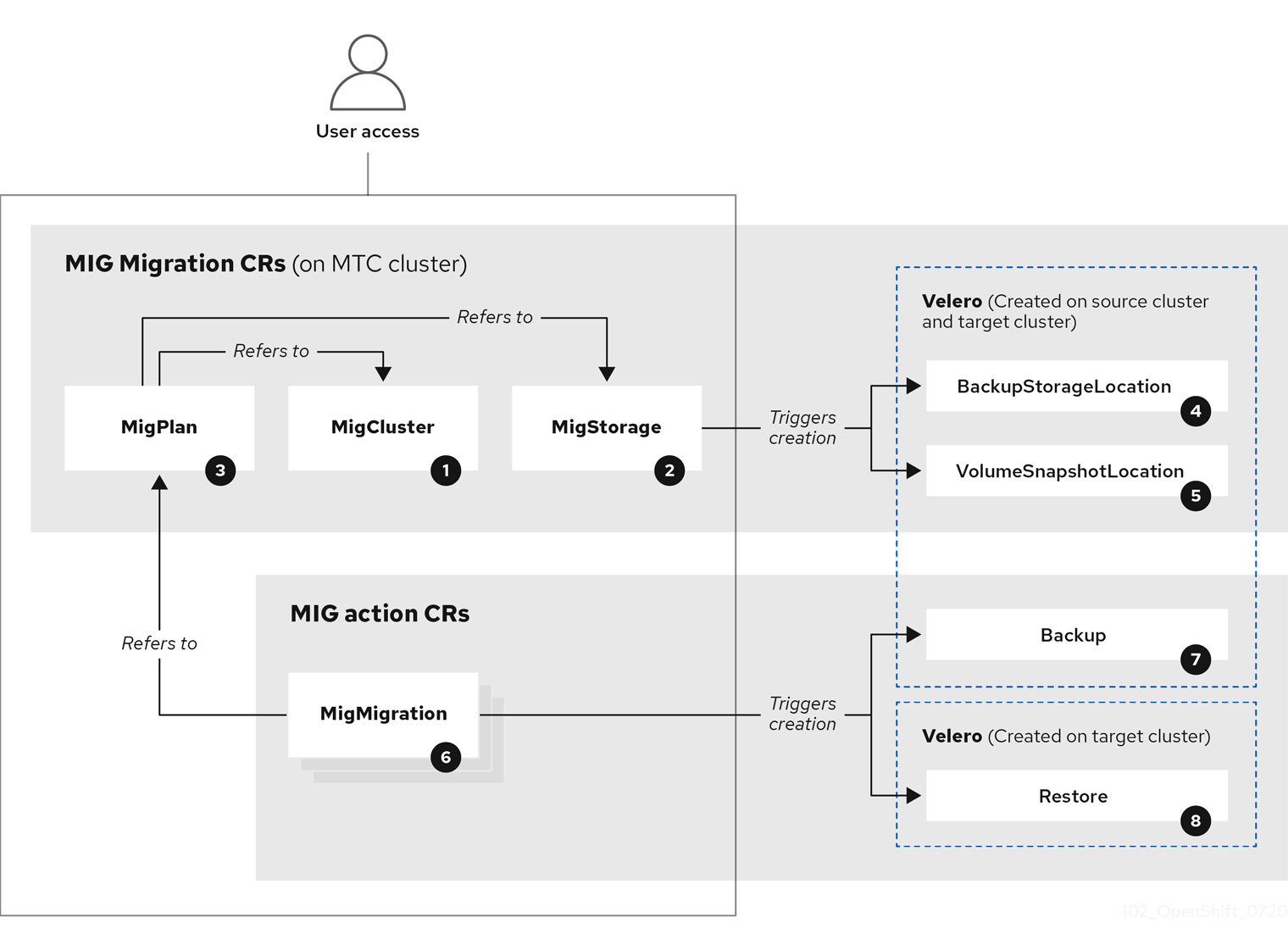

MTC는 마이그레이션을 제어하고 애플리케이션 다운타임을 최소화할 수 있도록 Kubernetes 사용자 지정 리소스를 기반으로 하는 웹 콘솔 및 API를 제공합니다.

MTC 콘솔은 기본적으로 대상 클러스터에 설치되어 있습니다. 원격 클러스터에 콘솔을 설치하도록 Migration Toolkit for Containers Operator를 구성할 수 있습니다.

다음 항목에 대한 자세한 내용은 고급 마이그레이션 옵션을 참조하십시오.

- 마이그레이션 후크 및 MTC API를 사용하여 마이그레이션 자동화.

- 리소스를 제외하고 대규모 마이그레이션을 지원하며 직접 볼륨 마이그레이션을 위해 자동 PV 크기 조정을 활성화하도록 마이그레이션 계획을 구성.

1.1. 용어

표 1.1. MTC 용어

| 용어 | 정의 |

|---|---|

| 소스 클러스터 | 애플리케이션이 마이그레이션되는 클러스터입니다. |

| 대상 클러스터[1] | 애플리케이션이 마이그레이션될 대상 클러스터입니다. |

| 복제 리포지토리 | 간접 마이그레이션 중 또는 직접 볼륨 마이그레이션 또는 직접 이미지 마이그레이션 중에 Kubernetes 오브젝트에 대한 이미지, 볼륨 및 Kubernetes 오브젝트 복사에 사용되는 오브젝트 스토리지입니다. 복제 리포지토리는 모든 클러스터에서 액세스할 수 있어야 합니다. |

| 호스트 클러스터 |

호스트 클러스터에 직접 이미지 마이그레이션을 위해 노출된 레지스트리 경로가 필요하지 않습니다. |

| 원격 클러스터 | 원격 클러스터는 일반적으로 소스 클러스터이지만 필수는 아닙니다.

원격 클러스터에는 원격 클러스터에는 직접 이미지 마이그레이션을 위해 노출된 보안 레지스트리 경로가 필요합니다. |

| 간접 마이그레이션 | 이미지, 볼륨 및 Kubernetes 오브젝트는 소스 클러스터에서 복제 리포지토리로 복사한 다음 복제 리포지토리에서 대상 클러스터로 복사됩니다. |

| 직접 볼륨 마이그레이션 | 영구 볼륨은 소스 클러스터에서 대상 클러스터로 직접 복사됩니다. |

| 직접 이미지 마이그레이션 | 이미지가 소스 클러스터에서 대상 클러스터로 직접 복사됩니다. |

| 마이그레이션 단계 | 애플리케이션을 중지하지 않고 데이터가 대상 클러스터에 복사됩니다. 단계적 마이그레이션을 여러 번 실행하면 컷오버 마이그레이션 기간이 단축됩니다. |

| 컷오버 마이그레이션 | 소스 클러스터에서 애플리케이션이 중지되고 해당 리소스가 대상 클러스터로 마이그레이션됩니다. |

| 상태 마이그레이션 | 애플리케이션 상태는 특정 영구 볼륨 클레임을 대상 클러스터에 복사하여 마이그레이션됩니다. |

| 마이그레이션 롤백 | 마이그레이션 롤백은 완료된 마이그레이션을 롤백합니다. |

1 MTC 웹 콘솔에서 대상 클러스터를 호출합니다.

1.2. MTC 워크플로

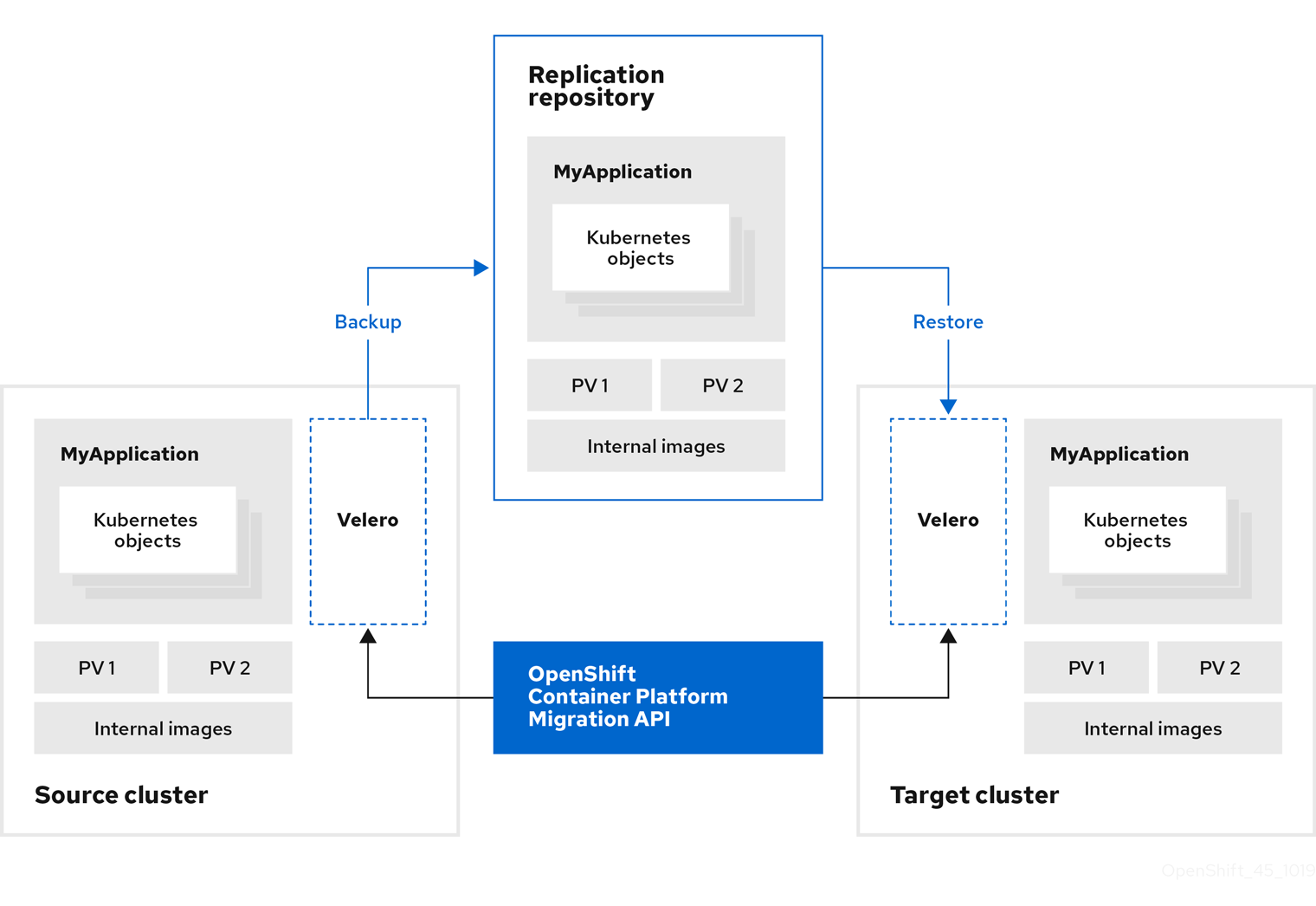

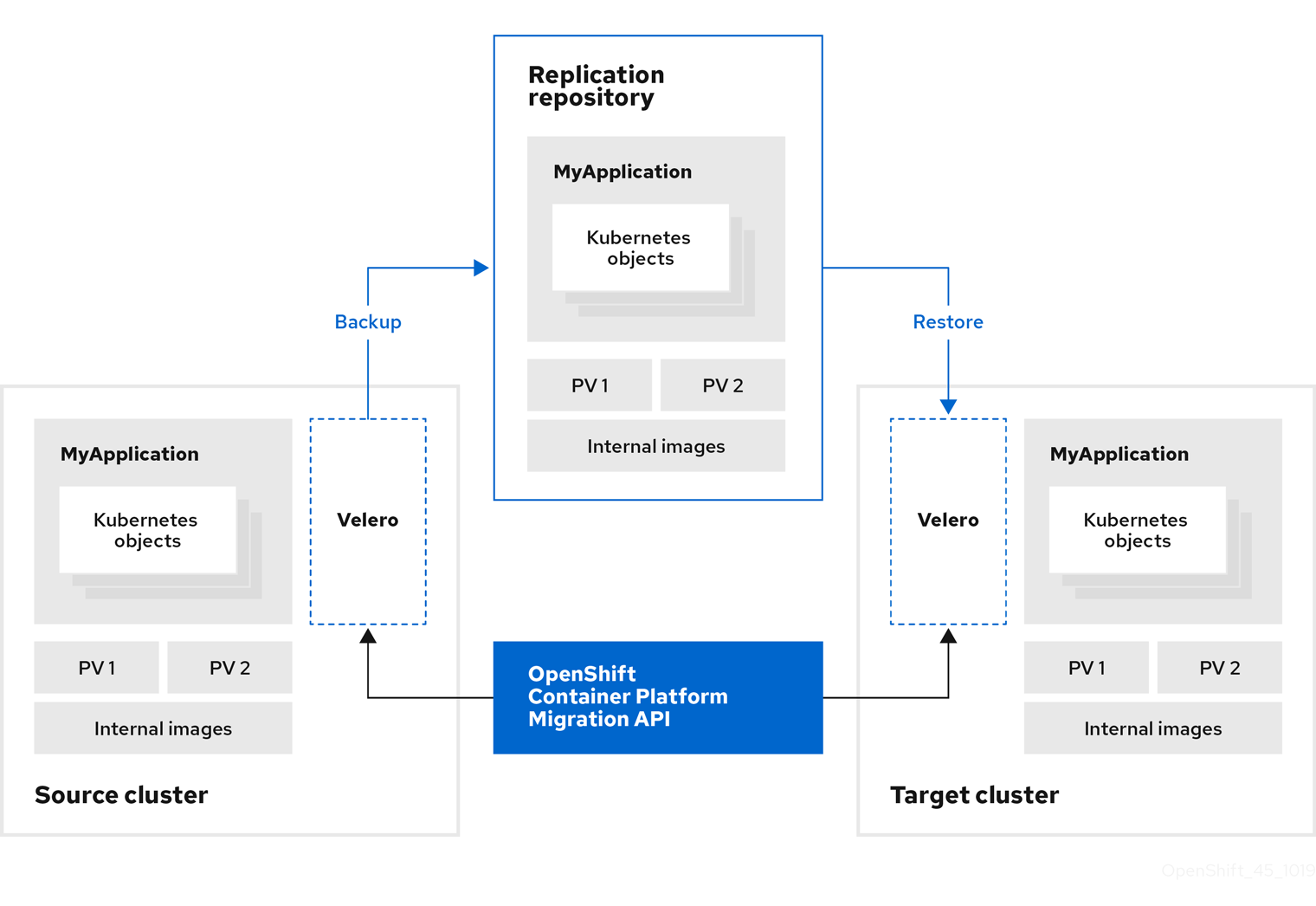

MTC(Migration Toolkit for Containers) 웹 콘솔 또는 Kubernetes API를 사용하여 Kubernetes 리소스, 영구 볼륨 데이터 및 내부 컨테이너 이미지를 OpenShift Container Platform 4.15로 마이그레이션할 수 있습니다.

(MTC)는 다음 리소스를 마이그레이션합니다.

- 마이그레이션 계획에 지정된 네임스페이스입니다.

네임스페이스가 지정된 리소스: MTC가 네임스페이스를 마이그레이션하면 서비스 또는 포드와 같은 해당 네임스페이스와 연결된 모든 오브젝트와 리소스가 마이그레이션됩니다. 또한 네임스페이스에 존재하지만 클러스터 수준에 없는 리소스가 클러스터 수준에 존재하는 리소스에 따라 달라지는 경우 MTC가 두 개의 리소스 모두를 마이그레이션합니다.

예를 들어 SCC(보안 컨텍스트 제약 조건)는 클러스터 수준에 존재하는 리소스이며, 서비스 계정(SA)은 네임스페이스 수준에 존재하는 리소스입니다. MTC가 마이그레이션하는 네임스페이스에 SA가 있는 경우 MTC는 SA에 연결된 모든 SCC를 자동으로 찾고 해당 SCC도 마이그레이션합니다. 마찬가지로 MTC는 네임스페이스의 영구 볼륨 클레임에 연결된 영구 볼륨을 마이그레이션합니다.

참고리소스에 따라 클러스터 범위 리소스를 수동으로 마이그레이션해야 할 수 있습니다.

- CR(사용자 정의 리소스) 및 CRD(사용자 정의 리소스 정의): MTC는 네임스페이스 수준에서 CR 및 CRD를 자동으로 마이그레이션합니다.

MTC 웹 콘솔을 사용하여 애플리케이션을 마이그레이션하는 데는 다음 단계가 포함됩니다.

모든 클러스터에 Migration Toolkit for Containers Operator를 설치합니다.

인터넷 액세스가 제한되거나 없는 제한된 환경에서 Migration Toolkit for Containers Operator를 설치할 수 있습니다. 소스 및 대상 클러스터는 상호 액세스 권한 및 미러 레지스트리에 대한 네트워크 액세스 권한이 있어야 합니다.

MTC가 데이터를 마이그레이션하는 데 사용하는 중간 오브젝트 스토리지인 복제 리포지토리를 구성합니다.

소스 및 대상 클러스터는 마이그레이션 중에 복제 리포지토리에 대한 네트워크 액세스 권한이 있어야 합니다. 프록시 서버를 사용하는 경우 복제 리포지토리와 클러스터 간의 네트워크 트래픽을 허용하도록 해당 서버를 구성해야 합니다.

- MTC 웹 콘솔에 소스 클러스터를 추가합니다.

- MTC 웹 콘솔에 복제 리포지토리를 추가합니다.

다음 데이터 마이그레이션 옵션 중 하나를 사용하여 마이그레이션 계획을 생성합니다.

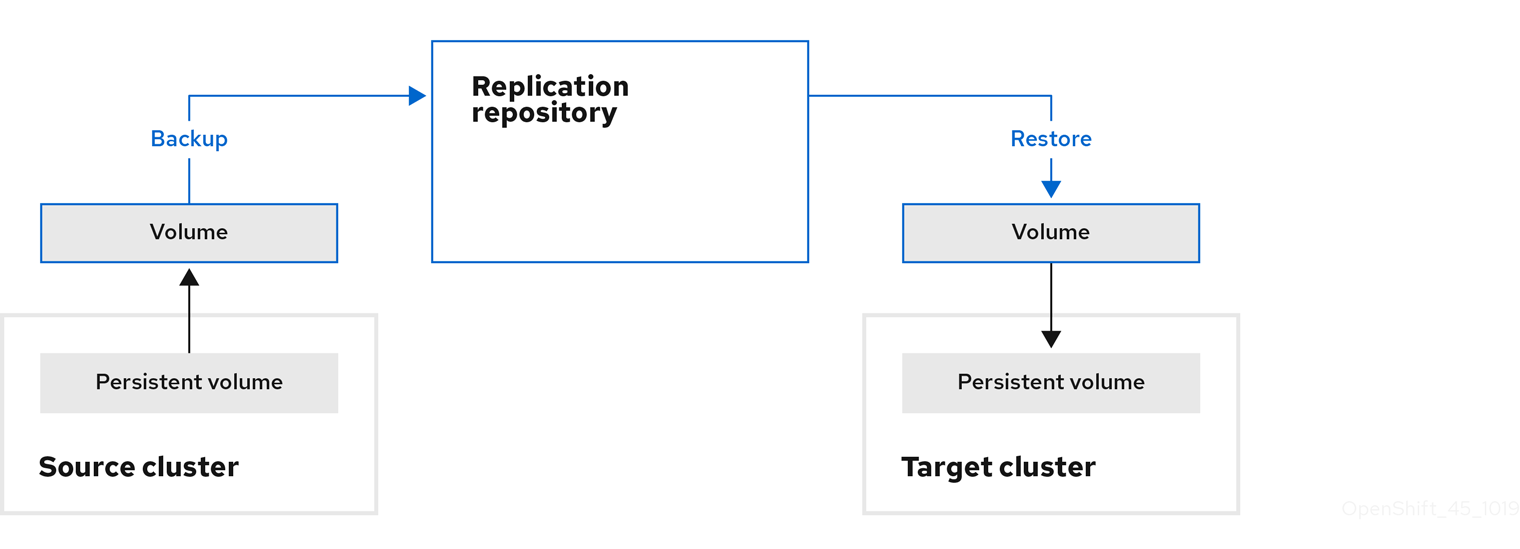

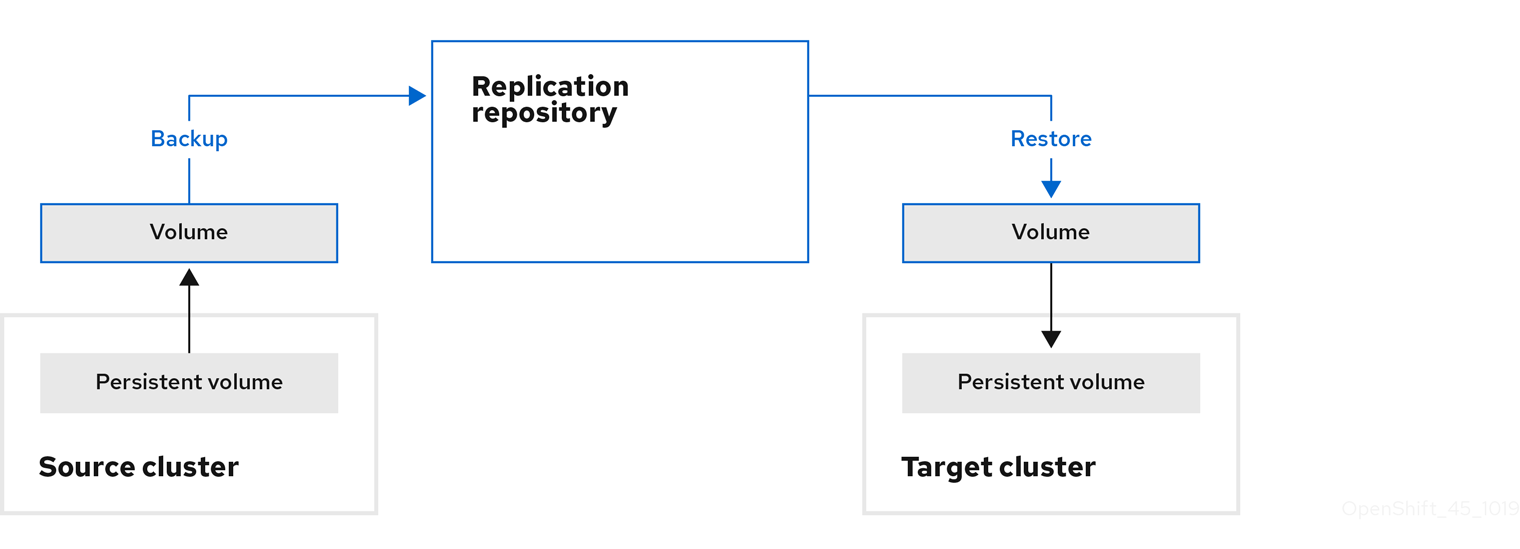

복사: MTC는 소스 클러스터에서 복제 리포지토리로, 복제 리포지토리에서 대상 클러스터로 데이터를 복사합니다.

참고직접 이미지 마이그레이션 또는 직접 볼륨 마이그레이션을 사용하는 경우 소스 클러스터에서 대상 클러스터로 이미지 또는 볼륨이 직접 복사됩니다.

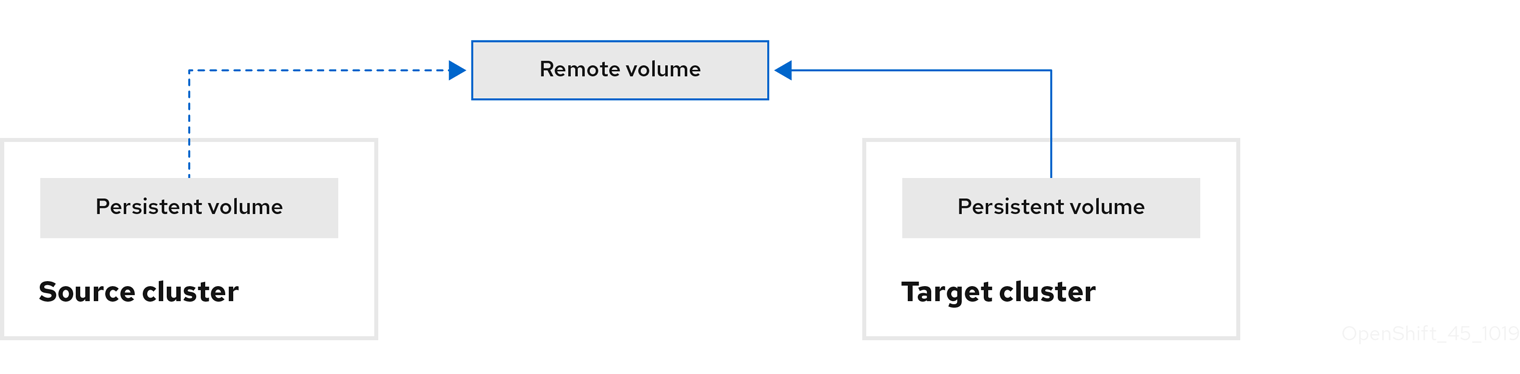

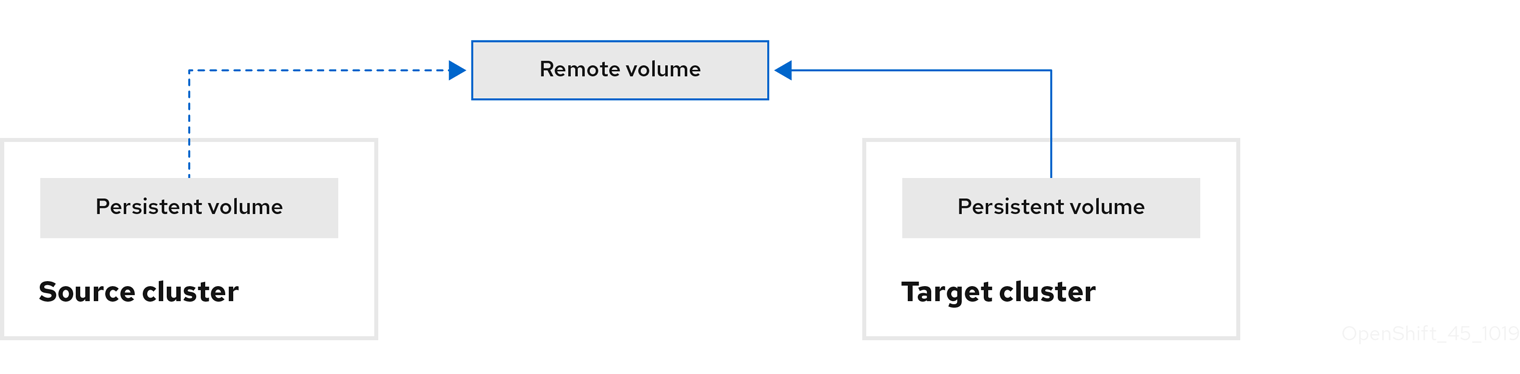

이동: MTC는 소스 클러스터에서 원격 볼륨(예: NFS)을 마운트 해제하고 원격 볼륨을 가리키는 대상 클러스터에 PV 리소스를 만든 다음 대상 클러스터에 원격 볼륨을 마운트합니다. 대상 클러스터에서 실행되는 애플리케이션은 소스 클러스터와 동일한 원격 볼륨을 사용합니다. 소스 및 대상 클러스터가 원격 볼륨에 액세스할 수 있어야 합니다.

참고이 다이어그램에는 복제 리포지토리가 나타나지 않지만 마이그레이션에는 필수입니다.

다음 옵션 중 하나를 사용하여 마이그레이션 계획을 실행합니다.

스테이지 (Stage)는 애플리케이션을 중지하지 않고 데이터를 대상 클러스터에 복사합니다.

스테이지 마이그레이션을 마이그레이션 전에 대부분의 데이터가 대상에 복사되도록 여러 번 실행할 수 있습니다. 하나 이상의 단계적 마이그레이션을 실행하면 컷오버 마이그레이션 기간이 단축됩니다.

컷오버 (Cutover)는 소스 클러스터에서 애플리케이션을 중지하고 리소스를 대상 클러스터로 이동합니다.

선택 사항: 마이그레이션 중에 소스 클러스터에서 트랜잭션 중지 확인란의 선택을 취소할 수 있습니다.

1.3. 데이터 복사 방법 정보

Migration Toolkit for Containers(MTC)는 소스 클러스터에서 대상 클러스터로 데이터를 마이그레이션하기 위한 파일 시스템 및 스냅샷 데이터 복사 방법을 지원합니다. 환경에 적합하고 스토리지 공급자가 지원하는 방법을 선택할 수 있습니다.

1.3.1. 파일 시스템 복사 방법

MTC는 소스 클러스터에서 복제 리포지토리로 데이터 파일을 복사하고 다시 대상 클러스터로 복사합니다.

파일 시스템 복사 방법은 간접 마이그레이션에 Restic을 사용하거나 직접 볼륨 마이그레이션에 Rsync를 사용합니다.

표 1.2. 파일 시스템 복사 방법 요약

| 혜택 | 제한 |

|---|---|

|

|

Restic 및 Rsync PV 마이그레이션은 지원되는 PV가 volumeMode=filesystem 인 것으로 가정합니다. 파일 시스템 마이그레이션에는 volumeMode=Block 을 사용할 수 없습니다.

1.3.2. 스냅샷 복사 방법

MTC는 소스 클러스터 데이터의 스냅샷을 클라우드 공급자의 복제 리포지토리에 복사합니다. 대상 클러스터에서 데이터가 복원됩니다.

스냅샷 복사 방법은 Amazon Web Services, Google Cloud Provider 및 Microsoft Azure와 함께 사용할 수 있습니다.

표 1.3. 스냅샷 복사 방법 요약

| 혜택 | 제한 |

|---|---|

|

|

1.4. 직접 볼륨 마이그레이션 및 직접 이미지 마이그레이션

직접 이미지 마이그레이션(DIM) 및 직접 볼륨 마이그레이션(DVM)을 사용하여 소스 클러스터에서 대상 클러스터로 직접 이미지 및 데이터를 마이그레이션할 수 있습니다.

다른 가용성 영역에 있는 노드에서 DVM을 실행하는 경우 마이그레이션된 Pod가 영구 볼륨 클레임에 액세스할 수 없기 때문에 마이그레이션이 실패할 수 있습니다.

DIM 및 DVM은 소스 클러스터에서 복제 리포지토리로 파일을 백업하고 복제 리포지토리에서 대상 클러스터로 파일을 복원하는 중간 단계를 건너뛰기 때문에 상당한 성능 이점을 지닙니다. Rsync를 사용하여 데이터를 전송합ㅌ니다.

DIM과 DVM에는 다른 사전 요구 사항이 있습니다.

2장. Migration Toolkit for Containers 릴리스 노트

MTC(Migration Toolkit for Containers) 릴리스 노트에서는 새로운 기능 및 개선 사항, 더 이상 사용되지 않는 기능 및 알려진 문제에 대해 설명합니다.

MTC를 사용하면 네임스페이스 단위로 OpenShift Container Platform 클러스터 간에 애플리케이션 워크로드를 마이그레이션할 수 있습니다.

OpenShift Container Platform 3에서 4.15로 마이그레이션하고 OpenShift Container Platform 4 클러스터 간에 마이그레이션할 수 있습니다.

MTC는 마이그레이션을 제어하고 애플리케이션 다운타임을 최소화할 수 있도록 Kubernetes 사용자 지정 리소스를 기반으로 하는 웹 콘솔 및 API를 제공합니다.

MTC 지원 정책에 대한 자세한 내용은 Red Hat OpenShift Container Platform 라이프 사이클 정책의 일부인 OpenShift 애플리케이션 및 클러스터 마이그레이션 솔루션을 참조하십시오.

2.1. Migration Toolkit for Containers 1.8.3 릴리스 노트

2.1.1. 기술 변경 사항

MTC(Migration Toolkit for Containers) 1.8.3에는 다음과 같은 기술적 변경 사항이 있습니다.

OADP 1.3 지원

MTC 1.8.3은 MTC 1.8.z의 종속성으로 OADP(OpenShift API for Data Protection)에 대한 지원을 추가합니다.

2.1.2. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

CVE-2024-24786: Golang protobuf 모듈의 Flaw로 인해 unmarshal 함수가 무한 루프에 들어갑니다.

이전 MTC 릴리스에서는 Golang의 protobuf 모듈에서 취약점이 발견되었습니다. 여기서 unmarshal 함수가 특정 잘못된 입력을 처리하는 동안 무한 루프를 입력했습니다. 결과적으로 공격자는 잘못된 입력을 신중하게 구성하여 함수가 무한 루프에 진입했습니다.

이번 업데이트를 통해 unmarshal 기능이 예상대로 작동합니다.

자세한 내용은 CVE-2024-24786 을 참조하십시오.

CVE-2023-45857: Axios Cross-Site Request Forgery Vulnerability

이전 MTC 릴리스에서는 Axios 1.5.1에서 취약점이 발견되었으며, Axios 1.5.1에서는 공격자가 중요한 정보를 볼 수 있도록 HTTP 헤더 X- 을 포함하여 템플릿에 저장된 기밀 XSRF-TOKEN을 공개했습니다.

XSRF-TOKEN

자세한 내용은 CVE-2023-45857 에서 참조하십시오.

소스 워크로드가 quiesced되지 않으면 Restic 백업이 제대로 작동하지 않습니다.

이전 MTC 릴리스에서는 경로를 사용하여 애플리케이션을 배포할 때 일부 파일이 마이그레이션되지 않았습니다. 소스 워크로드에 대해 quiesce 옵션을 선택하지 않은 경우 Restic 백업이 예상대로 작동하지 않았습니다.

이 문제는 MTC 1.8.3에서 해결되었습니다.

자세한 내용은 BZ#2242064 에서 참조하십시오.

Velero에서 지원되지 않는 값 오류로 인해 Migration Controller 를 설치하지 못했습니다

Velero에서 지원되지 않는 값 오류로 인해 MigrationController 를 설치하지 못했습니다. OADP 1.3.0을 OADP 1.3.1로 업데이트하면 이 문제가 해결됩니다. 자세한 내용은 BZ#2267018 에서 참조하십시오.

이 문제는 MTC 1.8.3에서 해결되었습니다.

해결된 모든 문제의 전체 목록은 Jira의 MTC 1.8.3 해결 문제 목록을 참조하십시오.

2.1.3. 확인된 문제

MTC에는 다음과 같은 알려진 문제가 있습니다.

서비스 계정에 연결된 SCC는 OpenShift Container Platform 4.12에서 마이그레이션할 수 없습니다.

OpenShift Container Platform 버전 4.12의 서비스 계정에 대한 관련 SCC(보안 컨텍스트 제약 조건)는 마이그레이션할 수 없습니다. 이 문제는 향후 MTC 릴리스에서 해결될 예정입니다. (MIG-1454).

알려진 모든 문제의 전체 목록은 Jira의 MTC 1.8.3 알려진 문제 목록을 참조하십시오.

2.2. Migration Toolkit for Containers 1.8.2 릴리스 노트

2.2.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

사용자 정의 CA 복제 리포지토리를 설정한 후 백업 단계가 실패합니다.

이전 릴리스의 MTC(Migration Toolkit for Containers)에서는 복제 리포지토리를 편집하고, 사용자 정의 CA 인증서를 추가하고, 리포지토리를 성공적으로 연결하며, 마이그레이션을 트리거하면 백업 단계에서 오류가 발생했습니다.

CVE-2023-26136: 4.1.3 이전의 hard-cookie 패키지는 Prototype Pollution에 취약합니다.

이전 (MTC) 릴리스에서는 MTC에서 사용되는 hard-cookie 패키지의 4.1.3 이전 버전에서는 프로토타입의 오염에 취약합니다. 이 취약점은 rejectPublicSuffixes 의 값이 false 로 설정되었을 때ieJar가 쿠키를 올바르게 처리하지 않았기 때문에 발생했습니다.

자세한 내용은 (CVE-2023-26136)에서 참조하십시오.

CVE-2022-25883 openshift-migration-ui-container: nodejs-semver: 정규식 서비스 거부

이전 릴리스 (MTC)에서 MTC에서 사용되는 7.5.2 이전의 semver 패키지 버전은 신뢰할 수 없는 사용자 데이터가 범위로 제공된 경우 newRange 함수의 정규식 서비스 거부 (ReDoS)에 취약했습니다.

자세한 내용은 (CVE-2022-25883)에서 참조하십시오.

2.2.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.3. Migration Toolkit for Containers 1.8.1 릴리스 노트

2.3.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

CVE-2023-39325: golang: net/http, x/net/http2: 빠른 스트림 재설정으로 인해 과도한 작업이 발생할 수 있습니다.

MTC(Migration Toolkit for Containers)에서 사용하는 HTTP/2 프로토콜에서 멀티플렉싱된 스트림을 처리하는 데 취약점이 발견되었습니다. 클라이언트는 반복적으로 새로운 멀티플렉싱 스트림을 요청하고 이를 취소하기 위해 RST_STREAM 프레임을 즉시 보낼 수 있습니다. 이렇게 하면 스트림 설정 및 해제 측면에서 서버에 대한 추가 워크로드가 생성되는 반면 연결당 최대 활성 스트림 수에 대한 서버 측 제한을 방지하여 서버 리소스 사용량으로 인해 서비스 거부가 발생합니다. (BZ#2245079)

이 문제를 해결하려면 MTC 1.8.1 이상으로 업데이트하는 것이 좋습니다.

자세한 내용은 (CVE-2023-39325) 및 (CVE-2023-44487)를 참조하십시오.

2.3.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.4. Migration Toolkit for Containers 1.8 릴리스 노트

2.4.1. 해결된 문제

이 릴리스에는 다음과 같은 해결된 문제가 있습니다.

간접 마이그레이션은 백업 단계에 있습니다.

이전 릴리스에서는 InvalidImageName 오류로 인해 간접 마이그레이션이 백업 단계에서 중단되었습니다. (BZ#2233097)

PodVolumeRestore는 마이그레이션이 복원 단계에서 중단되도록 계속 진행 중 상태로 유지됩니다.

이전 릴리스에서는 간접 마이그레이션을 수행할 때 podvolumerestore가 완료될 때까지의 Stage Restore 단계에서 마이그레이션이 중단되었습니다. (BZ#2233868)

마이그레이션된 애플리케이션이 대상 클러스터의 내부 레지스트리에서 이미지를 가져올 수 없음

이전 릴리스에서는 애플리케이션을 대상 클러스터로 마이그레이션할 때 마이그레이션된 애플리케이션이 내부 이미지 레지스트리에서 이미지를 가져오는 데 실패하여 application failure가 발생했습니다. (BZ#2233103)

권한 부여 문제로 인해 Azure에서 마이그레이션 실패

이전 릴리스에서는 Azure 스토리지로 백업할 때 Backup 단계에서 마이그레이션이 실패했습니다. (BZ#2238974)

2.4.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

이전 Restic Pod는 MTC 1.7.x → 1.8.x 업그레이드에서 제거되지 않음

이번 릴리스에서는 MTC Operator를 1.7.x에서 1.8.x로 업그레이드할 때 이전 Restic Pod가 제거되지 않습니다. 따라서 업그레이드 후 Restic 및 node-agent Pod가 네임스페이스에 표시됩니다. (BZ#2236829)

마이그레이션된 빌더 Pod가 이미지 레지스트리로 푸시되지 않음

이번 릴리스에서는 소스에서 대상 클러스터로 BuildConfig 를 포함한 애플리케이션을 마이그레이션할 때 빌더 Pod가 error가 발생하여 이미지를 이미지 레지스트리로 내보내지 못합니다. (BZ#2234781)

[UI] CA 번들 파일 필드가 올바르게 지워지지 않음

이번 릴리스에서는 MigStorage의 MCG NooBaa 버킷에 대한 Require SSL verification 및 CA 번들 파일에 콘텐츠를 추가한 후 예상대로 연결이 실패합니다. 그러나 CA 번들 콘텐츠를 제거하고 Require SSL verification 를 지워 이러한 변경 사항을 되돌릴 때 여전히 연결에 실패합니다. 이 문제는 리포지토리를 삭제하고 다시 추가하여 해결할 수 있습니다. (BZ#2240052)

사용자 정의 CA 복제 리포지토리를 설정한 후 백업 단계가 실패합니다.

(MTC)에서 복제 리포지토리를 편집하고 사용자 정의 CA 인증서를 추가하고 리포지토리를 성공적으로 연결한 후 마이그레이션을 트리거하면 백업 단계에서 오류가 발생합니다.

이 문제는 MTC 1.8.2에서 해결되었습니다.

CVE-2023-26136: 4.1.3 이전의 hard-cookie 패키지는 Prototype Pollution에 취약합니다.

MTC에 사용되는 hard-cookie 패키지의 4.1.3 이전 버전은 프로토타입 문제 해결에 취약합니다. 이 취약점은 rejectPublicSuffixes 의 값이 false 로 설정된 경우 CryostatJar가 쿠키를 올바르게 처리하지 않기 때문에 발생합니다.

이 문제는 MTC 1.8.2에서 해결되었습니다.

자세한 내용은 (CVE-2023-26136)에서 참조하십시오.

CVE-2022-25883 openshift-migration-ui-container: nodejs-semver: 정규식 서비스 거부

이전 릴리스 (MTC)에서 MTC에서 사용되는 7.5.2 이전의 semver 패키지 버전은 신뢰할 수 없는 사용자 데이터가 범위로 제공되는 경우 newRange 함수의 정규식 서비스 거부 (ReDoS)에 취약합니다.

이 문제는 MTC 1.8.2에서 해결되었습니다.

자세한 내용은 (CVE-2022-25883)에서 참조하십시오.

2.4.3. 기술 변경 사항

이 릴리스에는 다음과 같은 기술 변경 사항이 있습니다.

- OpenShift Container Platform 3에서 OpenShift Container Platform 4로 마이그레이션하려면 레거시 MTC(Migration Toolkit for Containers) Operator 및 MTC 1.7.x가 필요합니다.

- MTC 1.7.x에서 MTC 1.8.x로의 마이그레이션은 지원되지 않습니다.

MTC 1.7.x를 사용하여 OpenShift Container Platform 4.9 이하의 소스로 모든 항목을 마이그레이션해야 합니다.

- MTC 1.7.x는 소스 및 대상 모두에서 사용해야 합니다.

MTC 1.8.x는 OpenShift Container Platform 4.10 이상에서 OpenShift Container Platform 4.10 이상으로의 마이그레이션만 지원합니다. 클러스터 버전 4.10 이상과 관련된 마이그레이션의 경우 1.7.x 또는 1.8.x 중 하나를 사용할 수 있습니다. 그러나 소스와 대상 모두에서 동일한 MTC 1.Y.z여야 합니다.

- 소스 MTC 1.7.x에서 대상 MTC 1.8.x로의 마이그레이션은 지원되지 않습니다.

- 소스 MTC 1.8.x에서 대상 MTC 1.7.x로의 마이그레이션은 지원되지 않습니다.

- 소스 MTC 1.7.x에서 대상 MTC 1.7.x로의 마이그레이션이 지원됩니다.

- 소스 MTC 1.8.x에서 대상 MTC 1.8.x로의 마이그레이션이 지원됩니다.

- MTC 1.8.x는 기본적으로 OADP 1.2.x를 설치합니다.

- MTC 1.7.x에서 MTC 1.8.0으로 업그레이드하려면 OADP 채널을 1.2로 수동으로 변경해야 합니다. 이 작업이 완료되지 않으면 Operator 업그레이드가 실패합니다.

2.5. Migration Toolkit for Containers 1.7.15 릴리스 노트

2.5.1. 해결된 문제

이 릴리스에는 다음과 같은 해결된 문제가 있습니다.

CVE-2024-24786: Golang의 protobuf 모듈에서 취약점이 발견되었으며, 여기서 unmarshal 함수가 무한 루프를 입력할 수 있습니다.

protojson.Unmarshal 함수에서 특정 형식의 잘못된 JSON 메시지를 정리하지 못할 때 함수가 무한 루프가 입력될 수 있는 취약점이 발견되었습니다. 이 조건은 Google.protobuf.Any 값이 포함된 메시지 또는 옵션이 JSON 형식의 메시지에 설정된 경우 발생할 수 있습니다.

UnmarshalOptions. DiscardUnknown

이 문제를 해결하려면 MTC 1.7.15로 업그레이드하십시오.

자세한 내용은 (CVE-2024-24786) 에서 참조하십시오.

CVE-2024-28180: jose-go 로 고도의 압축 데이터를 부적절하게 처리

고도로 압축 된 데이터를 부적절하게 처리하여 Jose에서 취약점이 발견되었습니다. 공격자는 Decrypt 또는 DecryptMulti 함수에 의해 압축 해제될 때 많은 양의 메모리와 CPU를 사용하는 압축된 데이터를 포함하는 JWE(JSON Web Encryption) 암호화된 메시지를 보낼 수 있습니다.

이 문제를 해결하려면 MTC 1.7.15로 업그레이드하십시오.

자세한 내용은 (CVE-2024-28180) 에서 참조하십시오.

2.5.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

소스 클러스터의 Rsync Pod가 Error 상태가 되면 직접 볼륨 마이그레이션이 실패합니다.

PVC(영구 볼륨 클레임)를 사용하여 애플리케이션을 마이그레이션할 때 단계 마이그레이션 작업은 경고와 함께 성공하고, 직접 볼륨 마이그레이션(DVM)은 소스 네임스페이스의 rsync Pod가 오류 상태로 전환되어 실패합니다. (BZ#2256141)

충돌 조건이 생성된 후 간단히 지워집니다.

충돌 오류 메시지가 표시되는 새 상태 마이그레이션 계획을 생성할 때 오류 메시지가 표시된 직후에 삭제됩니다. (BZ#2144299)

기본 VSL이 지정되지 않은 클러스터에 구성된 다양한 공급자 유형의 VSL(볼륨 스냅샷 위치)이 여러 개 있는 경우 마이그레이션이 실패합니다.

다른 공급자 유형이 있는 클러스터에 여러 VSL이 있고 기본 VSL로 설정하지 않으면 Velero에서 마이그레이션 작업이 실패하는 검증 오류가 발생합니다. (BZ#2180565)

2.6. Migration Toolkit for Containers 1.7.14 릴리스 노트

2.6.1. 해결된 문제

이 릴리스에는 다음과 같은 해결된 문제가 있습니다.

CVE-2023-39325 CVE-2023-44487: 다양한 취약점

MTC(Migration Toolkit for Containers)에서 사용하는 HTTP/2 프로토콜의 멀티플렉싱 스트림을 처리하는 데 취약점이 발견되었습니다. 클라이언트는 반복적으로 새로운 멀티플렉싱 스트림을 요청한 다음 즉시 해당 요청을 취소하기 위해 RST_STREAM 프레임을 보낼 수 있습니다. 이 활동을 통해 스트림 설정 및 해제 측면에서 서버에 대한 추가 워크로드가 생성되었지만 연결당 최대 활성 스트림 수에 대한 서버 측 제한을 피할 수 있었습니다. 이로 인해 서버 리소스 사용량으로 인해 서비스 거부가 발생했습니다.

이 문제를 해결하려면 MTC 1.7.14로 업그레이드하십시오.

자세한 내용은 (CVE-2023-44487) 및 (CVE-2023-39325) 를 참조하십시오.

CVE-2023-39318 CVE-2023-39319 CVE-2023-39321: 다양한 결함

(CVE-2023-39318): MTC에서 사용하는 Golang에서 취약점이 발견되었습니다.

html/template패키지는 <script> 컨텍스트의 HTML-예:""주석 토큰 또는 hashbang"#!"주석 토큰을 올바르게 처리하지 않았습니다. 이 취약점으로 인해 템플릿 구문 분석기가 <script> 컨텍스트의 내용을 부적절하게 해석하여 작업이 부적절하게 이스케이프될 수 있습니다.(CVE-2023-39319): MTC에서 사용하는 Golang에서 취약점이 발견되었습니다.

html/template패키지는 <script> 컨텍스트의 JavaScript 리터럴 내에"<script","<!-","</script"의 발생을 처리하는 데 적절한 규칙을 적용하지 않았습니다. 이로 인해 템플릿 구문 분석기에서 스크립트 컨텍스트가 조기 종료되도록 잘못 간주하여 작업이 부적절하게 이스케이프될 수 있습니다.(CVE-2023-39321): MTC에서 사용하는 Golang에서 취약점이 발견되었습니다. QUIC 연결에 대한 불완전한 post-handshake 메시지를 처리하면 패닉이 발생할 수 있습니다.

(CVE-2023-3932): MTC에서 사용하는 Golang에서 취약점이 발견되었습니다. QUIC 전송 프로토콜을 사용하는 연결은 post-handshake 메시지를 읽을 때 버퍼링된 데이터 양에 상한을 설정하지 않아 악의적인 QUIC 연결이 바인딩되지 않은 메모리 증가를 초래할 수 있었습니다.

이러한 문제를 해결하려면 MTC 1.7.14로 업그레이드하십시오.

자세한 내용은 (CVE-2023-39318), (CVE-2023-39319) 및 (CVE-2023-39321) 를 참조하십시오.

2.6.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.7. Migration Toolkit for Containers 1.7.13 릴리스 노트

2.7.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.7.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.8. Migration Toolkit for Containers 1.7.12 릴리스 노트

2.8.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.8.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

마이그레이션 세부 정보 페이지에 오류 코드 504가 표시됩니다.

마이그레이션 세부 정보 페이지에서 처음에는 마이그레이션 세부 정보가 문제 없이 표시됩니다. 그러나 경우에 따라 세부 정보가 사라지고 504 오류가 반환됩니다. (BZ#2231106)

MTC 1.7.x를 MTC 1.8로 업그레이드할 때 이전 잔여 Pod가 제거되지 않습니다.

MTC Operator를 1.7.x에서 1.8.x로 업그레이드할 때 이전 잔여 Pod는 제거되지 않습니다. 업그레이드 후 잔여 Pod 및 node-agent Pod가 네임스페이스에 표시됩니다. (BZ#2236829)

2.9. Migration Toolkit for Containers 1.7.11 릴리스 노트

2.9.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.9.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.10. Migration Toolkit for Containers 1.7.10 릴리스 노트

2.10.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

DVM에서 rsync 옵션 조정

이번 릴리스에서는 직접 볼륨 마이그레이션(DVM) 과정의 Rsync에서 절대 심볼릭 링크가 조작되는 것을 방지할 수 있습니다. 권한 있는 모드에서 DVM을 실행하면 PVC(영구 볼륨 클레임) 내부의 절대 심볼릭 링크가 유지됩니다. 권한 있는 모드로 전환하려면 MigrationController CR에서 migration_rsync_privileged 사양을 true 로 설정합니다. (BZ#2204461)

2.10.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.11. Migration Toolkit for Containers 1.7.9 릴리스 노트

2.11.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.11.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

DVM에서 rsync 옵션 조정

이번 릴리스에서는 사용자가 DVM(직접 볼륨 마이그레이션) 중에 rsync에 의해 절대 심볼릭 링크가 조작되지 않도록 할 수 없습니다. (BZ#2204461)

2.12. Migration Toolkit for Containers 1.7.8 릴리스 노트

2.12.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

MTC Operator에서 Velero 이미지를 덮어쓸 수 없습니다

이전 릴리스에서는 MigrationController CR(사용자 정의 리소스)에서 velero_image_fqin 매개변수를 사용하여 velero 이미지를 재정의할 수 없었습니다. (BZ#2143389)

도메인 이름에 6자를 초과하면 UI에서 MigCluster를 추가할 수 없습니다.

이전 릴리스에서는 도메인 이름에 6자를 초과하면 UI에서 MigCluster를 추가할 수 없습니다. UI 코드에는 2~6자 사이의 도메인 이름이 예상되었습니다. (BZ#2152149)

UI가 마이그레이션 페이지를 렌더링하지 못했습니다: Cannot read properties of undefined (reading 'name')

이전 릴리스에서는 UI가 마이그레이션' 페이지를 렌더링 Cannot read properties of undefined (reading 'name') 속성을 반환하지 못했습니다. (BZ#2163485)

Red Hat OpenShift Container Platform 4.6 클러스터에서 DPA 리소스 생성 실패

이전 릴리스에서는 OpenShift Container Platform 4.6 클러스터에 MTC를 배포할 때 로그에 따라 DPA를 생성하지 않아 일부 Pod가 누락되었습니다. OCP 4.6 클러스터의 migration-controller 로그에서 예기치 않은 null 값이 전달되어 오류가 발생했습니다. (BZ#2173742)

2.12.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.13. Migration Toolkit for Containers 1.7.7 릴리스 노트

2.13.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.13.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.14. Migration Toolkit for Containers 1.7.6 릴리스 노트

2.14.1. 새로운 기능

Red Hat OpenShift Container Platform 4.12의 PSA를 사용하여 DVM 지원에 대해 제안된 변경 사항을 구현합니다.

OpenShift Container Platform 4.12에서 PSA(Pod Security Admission)가 적용되면 기본 Pod는 restricted 프로필로 실행됩니다. 이 restricted 프로필은 마이그레이션해야 하는 워크로드가 이 정책을 위반하여 더 이상 작동하지 않음을 의미합니다. 다음 개선 사항에서는 OCP 4.12와 계속 호환되는 데 필요한 변경 사항을 간략하게 설명합니다. (MIG-1240)

2.14.2. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

Red Hat OpenShift Platform 4.12에서 cronjob 오류가 누락되어 스토리지 클래스 변환 계획을 생성할 수 없음

이전 릴리스에서는 영구 볼륨 페이지에서 버전 batch/v1beta1 에서 CronJob을 사용할 수 없는 오류가 발생하며 취소를 클릭하면 migplan이 Not ready 상태로 생성됩니다. (BZ#2143628)

2.14.3. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

충돌 조건이 생성되면 잠시 후에 이 조건이 지워짐

충돌 오류가 발생하는 새 상태 마이그레이션 계획을 생성하면 해당 오류가 표시된 후 해당 오류가 지워집니다. (BZ#2144299)

2.15. Migration Toolkit for Containers 1.7.5 릴리스 노트

2.15.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

소스 클러스터에서 rsync Pod가 오류 상태로 전환되어 직접 볼륨 마이그레이션이 실패

이전 릴리스에서 마이그레이션은 경고와 함께 성공했지만 소스 네임스페이스의 rsync Pod에서 직접 볼륨 마이그레이션에 실패했습니다. (*BZ#2132978)

2.15.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

MTC Operator에서 Velero 이미지를 덮어쓸 수 없음

이전 릴리스에서는 MigrationController CR(사용자 정의 리소스)에서 velero_image_fqin 매개변수를 사용하여 velero 이미지를 재정의할 수 없었습니다. (BZ#2143389)

UI에서 MigHook를 편집할 때 페이지가 다시 로드되지 않을 수 있음

네트워크 연결 문제가 있는 경우 후크를 편집할 때 UI가 다시 로드되지 않을 수 있습니다. 네트워크 연결이 복원되면 캐시가 지워질 때까지 페이지가 다시 로드되지 않습니다. (BZ#2140208)

2.16. Migration Toolkit for Containers 1.7.4 릴리스 노트

2.16.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.16.2. 확인된 문제

대상 클러스터에서 일부 리소스 삭제 누락된 롤백

MTC UI에서 애플리케이션 롤백을 수행할 때 일부 리소스는 대상 클러스터에서 삭제되지 않고 롤백에 상태가 성공적으로 완료된 것으로 표시됩니다. (BZ#2126880)

2.17. Migration Toolkit for Containers 1.7.3 릴리스 노트

2.17.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

대상 네임스페이스에 대한 올바른 DNS 검증

이전 릴리스에서는 대상 네임스페이스가 알파벳이 아닌 문자로 시작된 경우 MigPlan을 검증할 수 없습니다. (BZ#2102231)

UI에서 모든 PVC를 선택 해제하면 시도된 PVC 전송이 발생합니다.

이전 릴리스에서는 전체 마이그레이션을 수행하는 동안 PVC(영구 볼륨 클레임) 선택을 생략하지 않고 PVC 선택을 건너뛰지 않고 마이그레이션을 시도합니다. (BZ#2106073)

대상 네임스페이스에 대한 잘못된 DNS 검증

이전 릴리스에서는 대상 네임스페이스가 알파벳이 아닌 문자로 시작했기 때문에 MigPlan을 검증할 수 없었습니다. (BZ#2102231)

2.17.2. 확인된 문제

이 릴리스에는 알려진 문제가 없습니다.

2.18. Migration Toolkit for Containers 1.7.2 릴리스 노트

2.18.1. 해결된 문제

이 릴리스에는 다음과 같은 주요 해결된 문제가 있습니다.

MTC UI가 로그를 올바르게 표시하지 않음

이전 릴리스에서는 MTC UI가 로그를 올바르게 표시하지 않았습니다. (BZ#2062266)

migplan에서 migstorage 참조 추가 StorageClass 변환 계획

이전 릴리스에서는 StorageClass 변환 계획에 사용되지 않은 경우에도 migstorage 참조가 있었습니다. (BZ#2078459)

다운로드한 로그에서 Velero Pod 로그 누락

이전 릴리스에서는 모든 로그에 대해 압축(.zip) 폴더를 다운로드할 때 velero Pod가 누락되었습니다. (BZ#2076599)

UI 드롭다운에서 Velero Pod 로그 누락

이전 릴리스에서는 마이그레이션이 수행된 후 드롭다운 목록에 제공된 로그에 velero Pod 로그가 포함되지 않았습니다. (BZ#2076593)

Rsync 옵션 로그가 log-reader Pod에 표시되지 않음

이전 릴리스에서는 migrationcontroller에서 유효한 rsync 옵션을 설정하려고 할 때 log-reader에서 유효하지 않은 옵션 또는 rsync 명령에 대한 로그를 표시하지 않았습니다. (BZ#2079252)

Velero/Restic의 기본 CPU 요청은 너무 까다롭고 특정 환경에서는 실패

이전 릴리스에서는 Velero/Restic에 대한 기본 CPU 요청이 너무 부족하여 특정 환경에서 실패했습니다. Velero 및 Restic Pod에 대한 기본 CPU 요청은 500m로 설정됩니다. 이 값은 높았습니다. (BZ#2088022)

2.18.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

UI에서 복제 리포지토리를 다른 스토리지 공급자 유형으로 업데이트하는 것은 지원되지 않음

복제 리포지토리를 다른 유형으로 업데이트하고 리포지토리를 업데이트를 클릭하면 연결이 성공적으로 표시되지만 UI가 올바른 세부 정보로 업데이트되지 않습니다. 편집 버튼을 다시 클릭하면 이전 복제 리포지토리 정보가 계속 표시됩니다.

또한 복제 리포지토리를 다시 업데이트하려고 할 때 이전 복제 세부 정보가 계속 표시됩니다. 새 리포지토리를 선택할 때 이전에 입력한 모든 정보가 표시되고 업데이트 리포지토리는 제출할 변경 사항이 없는 경우와 같이 활성화되지 않습니다. (BZ#2102020)

백업을 찾을 수 없기 때문에 마이그레이션이 실패

초기 백업이 발견되지 않았기 때문에 복원 단계에서 마이그레이션이 실패합니다. (BZ#2104874)

Azure 리소스 그룹을 업데이트할 때 클러스터 업데이트 버튼이 활성화되지 않음

원격 클러스터를 업데이트할 때 Azure 리소스 그룹 확인란을 선택하고 리소스 그룹을 추가하면 클러스터 업데이트 옵션이 활성화되지 않습니다. (BZ#2098594)

migstorage 리소스를 삭제할 때 UI에서 오류 발생

OpenShift Container Platform에서 backupStorage 인증 정보 시크릿을 생성할 때 migstorage 가 UI에서 제거되면 404 오류가 반환되고 기본 보안이 제거되지 않습니다. (BZ#2100828)

UI에서 리소스 수를 0으로 표시하는 MigAnalytic 리소스

백엔드에서 migplan을 생성하면 Miganalytic 리소스에서 리소스 수를 UI에서 0 으로 표시합니다. (BZ#2102139)

이미지 레지스트리에 노출된 경로 호스트에 두 개의 후행 슬래시가 추가되면 레지스트리 검증이 실패

//를 의미하는 두 개의 후행 슬래시를 노출된 레지스트리 경로에 추가하면 MigCluster 리소스가 상태를 connected으로 표시합니다. DIM을 사용하여 백엔드에서 migplan을 생성할 때 계획이 준비되지 unready 상태로 이동합니다. (BZ#2104864)

소스 클러스터를 편집하는 동안 서비스 계정 토큰이 표시되지 않음

추가되었으며 Connected 상태인 소스 클러스터를 편집할 때 UI에서 서비스 계정 토큰이 필드에 표시되지 않습니다. 마법사를 저장하려면 토큰을 다시 가져와서 필드 내에 세부 정보를 제공해야 합니다. (BZ#2097668)

2.19. Migration Toolkit for Containers 1.7.1 릴리스 노트

2.19.1. 해결된 문제

이 릴리스에는 주요 해결된 문제가 없습니다.

2.19.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

대상 네임스페이스에 대한 잘못된 DNS 검증

대상 네임스페이스가 알파벳이 아닌 문자로 시작되므로 MigPlan을 검증할 수 없습니다. (BZ#2102231)

Velero Pod에서 라벨이 누락되어 마이그레이션 컨트롤러의 클라우드 전파 단계가 작동하지 않음

Velero Pod에서 라벨이 누락되어 마이그레이션 컨트롤러의 클라우드 전파 단계는 작동하지 않습니다. 마이그레이션 컨트롤러의 EnsureCloudSecretPropagated 단계는 복제 리포지토리 보안이 양쪽에 전파될 때까지 대기합니다. 이 레이블이 Velero Pod에서 누락되므로 단계가 예상대로 작동하지 않습니다. (BZ#2088026)

특정 환경에서 스케줄링을 실패하는 경우 Velero/Restic의 기본 CPU 요청이 너무 까다로움

특정 환경에서 스케줄링을 실패하는 경우 Velero/Restic의 기본 CPU 요청이 너무 까다롭습니다. Velero 및 Restic Pod에 대한 기본 CPU 요청은 500m로 설정됩니다. 이러한 값은 높습니다. Velero 및 Restic의 podConfig 필드를 사용하여 DPA에서 리소스를 구성할 수 있습니다. 마이그레이션 Operator는 CPU 요청을 100m과 같은 더 낮은 값으로 설정해야 MTC가 자주 작동하는 리소스 제한 환경에서 Velero 및 Restic Pod를 예약할 수 있습니다. (BZ#2088022)

스토리지 클래스 변환 계획을 편집한 후 persistentVolumes 페이지에 경고가 표시됨

스토리지 클래스 변환 계획을 편집한 후 persistentVolumes 페이지에 경고가 표시됩니다. 기존 마이그레이션 계획을 편집할 때 UI에 경고가 표시됩니다. At least one PVC must be selected for Storage Class Conversion. (BZ#2079549)

다운로드한 로그에서 Velero Pod 로그 누락

모든 로그에 대해 압축된(.zip) 폴더를 다운로드할 때 velero Pod가 누락됩니다. (BZ#2076599)

UI 드롭다운에서 Velero Pod 로그 누락

마이그레이션이 완료되면 드롭다운 목록에 제공된 로그에 velero Pod 로그가 포함되지 않습니다. (BZ#2076593)

2.20. Migration Toolkit for Containers 1.7 릴리스 노트

2.20.1. 새로운 기능 및 개선 사항

이 릴리스에는 다음과 같은 새로운 기능 및 개선 사항이 있습니다.

- MTC(Migration Toolkit for Containers) Operator는 이제 OADP(OpenShift API for Data Protection) Operator에 따라 다릅니다. MTC Operator를 설치하면 OLM(Operator Lifecycle Manager)이 동일한 네임스페이스에 OADP Operator를 자동으로 설치합니다.

-

crane tunnel-api명령을 사용하여 두 클러스터 간에 네트워크 터널을 설정하여 방화벽 뒤에 있는 소스 클러스터에서 클라우드 기반 대상 클러스터로 마이그레이션할 수 있습니다. - MTC 웹 콘솔에서 스토리지 클래스 변환: 동일한 클러스터 내에서 마이그레이션을 통해 PV(영구 볼륨)의 스토리지 클래스를 변환할 수 있습니다.

2.20.2. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

-

MigPlan사용자 정의 리소스는 AWS gp2 PVC에 사용 가능한 공간이 없는 경우 경고를 표시하지 않습니다. (BZ#1963927) - 대상 스토리지가 AWS EBS(Elastic File System)에서 동적으로 프로비저닝한 PV인 경우 직접 및 간접 데이터 전송이 작동하지 않습니다. 이는 AWS EFS CSI(Container Storage Interface) 드라이버의 제한 때문입니다. (BZ#2085097)

- IBM Cloud용 블록 스토리지는 동일한 가용 영역에 있어야 합니다. 가상 프라이빗 클라우드의 블록 스토리지에 대한 IBM FAQ를 참조하십시오.

-

MTC 1.7.6은

v1beta1cron 작업을 지원하는 소스 클러스터에서 cron 작업을v1beta1cron 작업을 지원하지 않는 OpenShift Container Platform 4.12 이상 클러스터로 마이그레이션할 수 없습니다. (BZ#2149119)

2.21. Migration Toolkit for Containers 1.6 릴리스 노트

2.21.1. 새로운 기능 및 개선 사항

이 릴리스에는 다음과 같은 새로운 기능 및 개선 사항이 있습니다.

- 상태 마이그레이션: 특정 PVC(영구 볼륨 클레임)를 선택하여 반복 가능한 상태 전용 마이그레이션을 수행할 수 있습니다.

- "신규 Operator 버전 사용 가능" 알림: MTC 웹 콘솔의 클러스터 페이지에 새로운 Migration Toolkit for Containers Operator가 사용 가능한 경우 알림이 표시됩니다.

2.21.2. 더 이상 사용되지 않는 기능

더 이상 사용되지 않는 기능은 다음과 같습니다.

- MTC 버전 1.4는 더 이상 지원되지 않습니다.

2.21.3. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

-

OpenShift Container Platform 3.10에서

MigrationControllerPod를 다시 시작하는 데 시간이 너무 오래 걸립니다. Bugzilla 보고서에는 해결 방법이 포함되어 있습니다. (BZ#1986796) -

StagePod는 IBM Cloud의 클래식 OpenShift Container Platform 소스 클러스터에서 직접 볼륨 마이그레이션 중에 실패합니다. IBM 블록 스토리지 플러그인은 동일한 노드의 여러 Pod에 동일한 볼륨을 마운트하는 것을 허용하지 않습니다. 따라서 Rsync Pod와 애플리케이션 pod에 PVC를 동시에 마운트할 수 없습니다. 이 문제를 해결하려면 마이그레이션 전에 애플리케이션 Pod를 중지합니다. (BZ#1887526) -

MigPlan사용자 정의 리소스는 AWS gp2 PVC에 사용 가능한 공간이 없는 경우 경고를 표시하지 않습니다. (BZ#1963927) - IBM Cloud용 블록 스토리지는 동일한 가용 영역에 있어야 합니다. 가상 프라이빗 클라우드의 블록 스토리지에 대한 IBM FAQ를 참조하십시오.

2.22. Migration Toolkit for Containers 1.5 릴리스 노트

2.22.1. 새로운 기능 및 개선 사항

이 릴리스에는 다음과 같은 새로운 기능 및 개선 사항이 있습니다.

- 웹 콘솔의 마이그레이션 세부 정보 페이지의 마이그레이션 리소스 트리는 마이그레이션 모니터링 및 디버깅을 위한 추가 리소스, Kubernetes 이벤트 및 실시간 상태 정보로 향상되었습니다.

- 웹 콘솔은 수백 개의 마이그레이션 계획을 지원할 수 있습니다.

- 소스 네임스페이스는 마이그레이션 계획의 다른 대상 네임스페이스에 매핑될 수 있습니다. 이전에는 소스 네임스페이스가 동일한 이름의 대상 네임스페이스에 매핑되었습니다.

- 상태 정보가 있는 후크 단계는 마이그레이션 중에 웹 콘솔에 표시됩니다.

- 직접 볼륨 마이그레이션 중에 Rsync 재시도 시도 횟수가 웹 콘솔에 표시됩니다.

- 직접 볼륨 마이그레이션에 대해 영구 볼륨(PV) 크기 조정을 활성화하여 대상 클러스터에 디스크 공간이 부족하지 않도록 할 수 있습니다.

- PV 크기 조정을 트리거하는 임계값을 구성할 수 있습니다. 이전에는 디스크 사용량이 97%를 초과하면 PV 크기 조정이 발생했습니다.

- Velero가 버전 1.6으로 업데이트되어 다양한 수정 사항 및 개선 사항을 제공합니다.

- 캐시된 Kubernetes 클라이언트를 활성화하여 성능을 향상시킬 수 있습니다.

2.22.2. 더 이상 사용되지 않는 기능

더 이상 사용되지 않는 기능은 다음과 같습니다.

- MTC 버전 1.2 및 1.3은 더 이상 지원되지 않습니다.

-

oc convert명령이 더 이상 사용되지 않으므로 사용되지 않는 API를 업데이트하는 절차는 설명서의 문제 해결 섹션에서 제거되었습니다.

2.22.3. 확인된 문제

이 릴리스에는 다음과 같은 알려진 문제가 있습니다.

-

400개 이상의 마이그레이션 계획을 생성하는 경우 Microsoft Azure 스토리지를 사용할 수 없습니다.

MigStorage사용자 지정 리소스에는The request is being throttled as the limit has been reached for operation type메시지가 표시됩니다. (BZ#1977226) - 마이그레이션에 실패하면 마이그레이션 계획에서 quiesced Pod에 대한 사용자 정의 PV(영구 볼륨) 설정이 유지되지 않습니다. 마이그레이션을 수동으로 롤백하고 마이그레이션 계획을 삭제하고 PV 설정으로 새 마이그레이션 계획을 생성해야 합니다. (BZ#1784899)

-

pv_resizing_threshold가 42% 이상인 경우가 아니면 PV 크기 조정은 AWS gp2 스토리지에 대해 예상대로 작동하지 않습니다. (BZ#1973148) 다음 시나리오의 OpenShift Container Platform 3.7 및 3.9 소스 클러스터에서 PV 크기 조정이 작동하지 않습니다.

- MTC를 설치한 후 애플리케이션이 설치되었습니다.

MTC를 설치한 후 애플리케이션 pod가 다른 노드에 다시 예약되었습니다.

OpenShift Container Platform 3.7 및 3.9는 Velero가

ResticPod에 자동으로 PV를 마운트할 수 있도록 하는 Mount Propagation 기능을 지원하지 않습니다.MigAnalyticCR(사용자 정의 리소스)은ResticPod에서 PV 데이터를 수집하지 못하고 리소스를0으로 보고합니다.MigPlanCR에는 다음과 유사한 상태가 표시됩니다.출력 예

status: conditions: - category: Warn lastTransitionTime: 2021-07-15T04:11:44Z message: Failed gathering extended PV usage information for PVs [nginx-logs nginx-html], please see MigAnalytic openshift-migration/ocp-24706-basicvolmig-migplan-1626319591-szwd6 for details reason: FailedRunningDf status: "True" type: ExtendedPVAnalysisFailedPV 크기 조정을 활성화하려면 소스 클러스터에서 Restic 데몬 세트를 수동으로 다시 시작하거나 애플리케이션과 동일한 노드에서

ResticPod를 다시 시작할 수 있습니다. Restic을 다시 시작하지 않으면 PV 크기 조정 없이 직접 볼륨 마이그레이션을 실행할 수 있습니다. (BZ#1982729)

2.22.4. 기술 변경 사항

이 릴리스에는 다음과 같은 기술 변경 사항이 있습니다.

- 기존 Migration Toolkit for Containers Operator 버전 1.5.1은 OpenShift Container Platform 버전 3.7에서 4.5로 수동으로 설치됩니다.

- Migration Toolkit for Containers Operator 버전 1.5.1은 Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 버전 4.6 이상에 설치됩니다.

3장. MTC 설치

OpenShift Container Platform 4에 MTC(Migration Toolkit for Containers)를 설치할 수 있습니다.

OpenShift Container Platform 3에 MTC를 설치하려면 OpenShift Container Platform 3에 레거시 Migration Toolkit for Containers Operator 설치를 참조하십시오.

기본적으로 MTC 웹 콘솔 및 Migration Controller Pod는 대상 클러스터에서 실행됩니다. 원격 클러스터에서 MTC 웹 콘솔 및 Migration Controller Pod를 실행하도록 Migration Controller 사용자 정의 리소스 매니페스트를 구성할 수 있습니다.

MTC를 설치한 후에는 복제 리포지토리로 사용할 오브젝트 스토리지를 구성해야 합니다.

MTC를 설치 제거하려면 MTC 설치 해제 및 리소스 삭제를 참조하십시오.

3.1. 호환성 지침

OpenShift Container Platform 버전과 호환되는 MTC(Migration Toolkit for Containers) Operator를 설치해야 합니다.

정의

- 기존 플랫폼

- OpenShift Container Platform 4.5 및 이전 버전입니다.

- 최신 플랫폼

- OpenShift Container Platform 4.6 이상 버전입니다.

- 기존 Operator

- 레거시 플랫폼을 위해 설계된 MTC Operator입니다.

- 최신 Operator

- 최신 플랫폼을 위해 설계된 MTC Operator입니다.

- 클러스터 제어

- MTC 컨트롤러 및 GUI를 실행하는 클러스터입니다.

- 원격 클러스터

- Velero를 실행하는 마이그레이션의 소스 또는 대상 클러스터입니다. Control Cluster는 Velero API를 통해 원격 클러스터와 통신하여 마이그레이션을 구동합니다.

OpenShift Container Platform 클러스터를 마이그레이션하는 데 호환되는 MTC 버전을 사용해야 합니다. 마이그레이션이 소스 클러스터와 대상 클러스터 모두에 성공하려면 동일한 버전의 MTC를 사용해야 합니다.

MTC 1.7은 OpenShift Container Platform 3.11에서 4.9로의 마이그레이션을 지원합니다.

MTC 1.8은 OpenShift Container Platform 4.10 이상에서만 마이그레이션을 지원합니다.

표 3.1. MTC 호환성: 레거시 또는 최신 플랫폼에서 마이그레이션

| 세부 정보 | OpenShift Container Platform 3.11 | OpenShift Container Platform 4.0에서 4.5로 | OpenShift Container Platform 4.6에서 4.9로 | OpenShift Container Platform 4.10 이상 |

|---|---|---|---|---|

| 안정적인 MTC 버전 | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.8.z |

| 설치 |

레거시 MTC v.1.7.z operator: [critical] 이 클러스터는 제어 클러스터가 될 수 없습니다. |

OLM과 함께 설치, 릴리스 채널 |

OLM과 함께 설치, 릴리스 채널 |

현대 클러스터가 마이그레이션에 관련된 다른 클러스터에 연결하지 못하도록 하는 Edge 사례가 있습니다. 예를 들어 온프레미스의 OpenShift Container Platform 3.11 클러스터에서 클라우드의 최신 OpenShift Container Platform 클러스터로 마이그레이션할 때 최신 클러스터가 OpenShift Container Platform 3.11 클러스터에 연결할 수 없습니다.

MTC v.1.7.z 를 사용하면 네트워크 제한으로 인해 원격 클러스터 중 하나가 컨트롤 클러스터와 통신할 수 없는 경우 crane tunnel-api 명령을 사용합니다.

안정적인 MTC 릴리스에서는 항상 최신 클러스터를 제어 클러스터로 지정해야 하지만 이 특정 경우 레거시 클러스터를 제어 클러스터로 지정하고 워크로드를 원격 클러스터로 푸시할 수 있습니다.

3.2. OpenShift Container Platform 4.2에서 4.5로 레거시 Migration Toolkit for Containers Operator 설치

OpenShift Container Platform 버전 4.2에서 4.5로 레거시 Migration Toolkit for Containers Operator를 수동으로 설치할 수 있습니다.

사전 요구 사항

-

모든 클러스터에서

cluster-admin권한이 있는 사용자로 로그인합니다. -

registry.redhat.io에 대한 액세스 권한이 있어야 합니다. -

podman이 설치되어 있어야 합니다.

프로세스

Red Hat Customer Portal 자격 증명을 사용하여

registry.redhat.io에 로그인합니다.$ podman login registry.redhat.io

다음 명령을 입력하여

operator.yml파일을 다운로드합니다.podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

다음 명령을 입력하여

controller.yml파일을 다운로드합니다.podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

- OpenShift Container Platform 소스 클러스터에 로그인합니다.

클러스터가

registry.redhat.io로 인증할 수 있는지 확인합니다.$ oc run test --image registry.redhat.io/ubi9 --command sleep infinity

Migration Toolkit for Containers Operator 오브젝트 생성:

$ oc create -f operator.yml

출력 예

namespace/openshift-migration created rolebinding.rbac.authorization.k8s.io/system:deployers created serviceaccount/migration-operator created customresourcedefinition.apiextensions.k8s.io/migrationcontrollers.migration.openshift.io created role.rbac.authorization.k8s.io/migration-operator created rolebinding.rbac.authorization.k8s.io/migration-operator created clusterrolebinding.rbac.authorization.k8s.io/migration-operator created deployment.apps/migration-operator created Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-builders" already exists 1 Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-pullers" already exists- 1

Error from server (AlreadyExists)메시지를 무시할 수 있습니다. 이는 Migration Toolkit for Containers Operator가 이후 릴리스에서 제공되는 OpenShift Container Platform 4 이전 버전에 대한 리소스를 생성하기 때문에 발생합니다.

MigrationController오브젝트를 만듭니다.$ oc create -f controller.yml

MTC pod가 실행 중인지 확인합니다.

$ oc get pods -n openshift-migration

3.3. OpenShift Container Platform 4.15에 Migration Toolkit for Containers Operator 설치

Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4.15에 Migration Toolkit for Containers Operator를 설치합니다.

사전 요구 사항

-

모든 클러스터에서

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

- OpenShift Container Platform 웹 콘솔에서 Operator → OperatorHub를 클릭합니다.

- 키워드로 필터링 필드를 사용하여 Migration Toolkit for Containers Operator를 찾습니다.

- Migration Toolkit for Containers Operator를 선택하고 설치를 클릭합니다.

설치를 클릭합니다.

설치된 Operators 페이지에서 Migration Toolkit for Containers Operator는 openshift-migration 프로젝트에 Succeeded 상태로 나타납니다.

- Migration Toolkit for Containers Operator를 클릭합니다.

- 제공된 API 아래에서 마이그레이션 컨트롤러 타일을 찾고 인스턴스 작성을 클릭합니다.

- 생성을 클릭합니다.

- 워크로드 → Pod를 클릭하여 MTC pod가 실행 중인지 확인합니다.

3.4. 프록시 설정

OpenShift Container Platform 4.1 및 이전 버전의 경우 이러한 버전은 클러스터 전체 프록시 오브젝트를 지원하지 않기 때문에 Migration Toolkit for Containers Operator를 설치한 후 MigrationController CR(사용자 정의 리소스) 매니페스트에서 proxy를 구성해야 합니다.

OpenShift Container Platform 4.2 to 4.15의 경우 MTC(Migration Toolkit for Containers)는 클러스터 전체 프록시 설정을 상속합니다. 클러스터 전체 프록시 설정을 재정의하려면 프록시 매개변수를 변경할 수 있습니다.

3.4.1. 직접 볼륨 마이그레이션

MTC 1.4.2에서 직접 볼륨 마이그레이션(DVM)이 도입되었습니다. DVM은 하나의 프록시만 지원합니다. 대상 클러스터가 프록시 뒤에 있는 경우 소스 클러스터는 대상 클러스터의 경로에 액세스할 수 없습니다.

프록시 뒤에서 소스 클러스터에서 DVM을 수행하려면 전송 계층에서 작동하는 TCP 프록시를 구성하고 자체 SSL 인증서로 암호를 해독하고 재암호화하지 않고도 SSL 연결을 투명하게 전달해야 합니다. Stunnel 프록시는 이러한 프록시의 예입니다.

3.4.1.1. DVM용 TCP 프록시 설정

TCP 프록시를 통해 소스와 대상 클러스터 간에 직접 연결하고 프록시를 사용하도록 MigrationController CR에서 stunnel_tcp_proxy 변수를 구성할 수 있습니다.

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] stunnel_tcp_proxy: http://username:password@ip:port

직접 볼륨 마이그레이션(DVM)은 프록시에 대한 기본 인증만 지원합니다. 또한 DVM은 TCP 연결을 투명하게 터널링할 수 있는 프록시 뒤에서만 작동합니다. 중간자 모드에서 HTTP/HTTPS 프록시가 작동하지 않습니다. 기존 클러스터 전체 프록시에서 이 동작을 지원하지 않을 수 있습니다. 결과적으로 DVM의 프록시 설정은 의도적으로 MTC의 일반 프록시 구성과 다르게 유지됩니다.

3.4.1.2. HTTP/HTTPS 프록시 대신 TCP 프록시를 사용하는 이유는 무엇입니까?

OpenShift 경로를 통해 소스와 대상 클러스터 간에 Rsync를 실행하여 DVM을 활성화할 수 있습니다. 트래픽은 TCP 프록시인 Stunnel을 사용하여 암호화됩니다. 소스 클러스터에서 실행되는 Stunnel은 대상 Stunnel을 사용한 TLS 연결을 시작하고 암호화된 채널을 통해 데이터를 전송합니다.

OpenShift의 클러스터 전체 HTTP/HTTPS 프록시는 일반적으로 자체 TLS 세션을 외부 서버와 협상하는 중간자 모드로 구성됩니다. 그러나 이 작업은 Stunnel에서는 작동하지 않습니다. Stunnel은 프록시에서 TLS 세션을 그대로 전환해야 하므로 기본적으로 프록시를 통해 TCP 연결을 그대로 전달하는 투명한 터널로 프록시를 설정해야 합니다. 따라서 TCP 프록시를 사용해야 합니다.

3.4.1.3. 알려진 문제

마이그레이션 실패 오류 Upgrade request required

마이그레이션 컨트롤러는 SPDY 프로토콜을 사용하여 원격 Pod 내에서 명령을 실행합니다. 원격 클러스터가 프록시 또는 SPDY 프로토콜을 지원하지 않는 방화벽 뒤에 있는 경우 마이그레이션 컨트롤러가 원격 명령을 실행하지 못합니다. 오류 메시지 Upgrade request required와 함께 마이그레이션이 실패합니다. 해결방법: SPDY 프로토콜을 지원하는 프록시를 사용합니다.

SPDY 프로토콜 지원 외에도 프록시 또는 방화벽은 Upgrade HTTP 헤더를 API 서버에 전달해야 합니다. 클라이언트는 이 헤더를 사용하여 API 서버와의 websocket 연결을 엽니다. Upgrade 헤더가 프록시 또는 방화벽에 의해 차단된 경우 마이그레이션은 오류 메시지 Upgrade request required와 함께 실패합니다. 해결방법: 프록시가 Upgrade 헤더를 전달하도록 합니다.

3.4.2. 마이그레이션을 위한 네트워크 정책 튜닝

OpenShift는 클러스터에서 사용하는 네트워크 플러그인을 기반으로 NetworkPolicy 또는 EgressFirewall을 사용하여 Pod로 트래픽을 제한할 수 있습니다. 마이그레이션과 관련된 소스 네임스페이스가 이러한 메커니즘을 사용하여 네트워크 트래픽을 포드로 제한하는 경우 제한이 마이그레이션 중에 Rsync pod로의 트래픽을 실수로 중지할 수 있습니다.

소스 및 대상 클러스터에서 둘 다 실행되는 rsync Pod는 OpenShift 경로를 통해 서로 연결되어야 합니다. 기존 NetworkPolicy 또는 EgressNetworkPolicy 오브젝트는 이러한 트래픽 제한에서 Rsync Pod를 자동으로 제외하도록 구성할 수 있습니다.

3.4.2.1. NetworkPolicy 구성

3.4.2.1.1. Rsync Pod의 송신 트래픽

소스 또는 대상 네임스페이스의 NetworkPolicy 구성이 이러한 유형의 트래픽을 차단하는 경우 Rsync Pod의 고유한 레이블을 사용하여 송신 트래픽이 해당 트래픽에서 전달되도록 허용할 수 있습니다. 다음 정책은 네임스페이스의 Rsync Pod에서 모든 송신 트래픽을 허용합니다.

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

egress:

- {}

policyTypes:

- Egress3.4.2.1.2. Rsync pod로의 수신 트래픽

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

ingress:

- {}

policyTypes:

- Ingress3.4.2.2. EgressNetworkPolicy 구성

EgressNetworkPolicy 오브젝트 또는 Egress Firewalls 는 클러스터를 나가는 송신 트래픽을 차단하도록 설계된 OpenShift 구조입니다.

NetworkPolicy 오브젝트와 달리 Egress Firewall은 네임스페이스의 모든 포드에 적용되므로 프로젝트 수준에서 작동합니다. 따라서 Rsync Pod의 고유 레이블은 제한 사항에서 Rsync Pod만 제외하지 않습니다. 그러나 두 클러스터 간에 직접 연결을 설정할 수 있도록 소스 또는 대상 클러스터의 CIDR 범위를 정책의 허용 규칙에 추가할 수 있습니다.

Egress Firewall이 있는 클러스터를 기반으로 다른 클러스터의 CIDR 범위를 추가하여 둘 사이의 송신 트래픽을 허용할 수 있습니다.

apiVersion: network.openshift.io/v1

kind: EgressNetworkPolicy

metadata:

name: test-egress-policy

namespace: <namespace>

spec:

egress:

- to:

cidrSelector: <cidr_of_source_or_target_cluster>

type: Deny3.4.2.3. 데이터 전송을 위한 대체 끝점 선택

기본적으로 DVM은 OpenShift Container Platform 경로를 끝점으로 사용하여 PV 데이터를 대상 클러스터로 전송합니다. 클러스터 토폴로지가 허용하는 경우 다른 유형의 지원되는 끝점을 선택할 수 있습니다.

각 클러스터에 대해 MigrationController CR의 적절한 대상 클러스터에서 rsync_endpoint_type 변수를 설정하여 끝점을 구성할 수 있습니다.

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] rsync_endpoint_type: [NodePort|ClusterIP|Route]

3.4.2.4. Rsync Pod에 대한 추가 그룹 구성

PVC에서 공유 스토리지를 사용하는 경우 Pod에서 액세스를 허용하기 위해 Rsync Pod 정의에 추가 그룹을 추가하여 해당 스토리지에 대한 액세스를 구성할 수 있습니다.

표 3.2. Rsync Pod의 보조 그룹

| Variable | 유형 | Default | 설명 |

|---|---|---|---|

|

| string | 설정되지 않음 | 소스 Rsync Pod에 대한 콤마로 구분된 추가 그룹 목록 |

|

| string | 설정되지 않음 | 대상 Rsync Pod에 대한 콤마로 구분된 추가 그룹 목록 |

사용 예

MigrationController CR을 업데이트하여 이러한 추가 그룹에 대한 값을 설정할 수 있습니다.

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

3.4.3. 프록시 구성

사전 요구 사항

-

모든 클러스터에서

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

MigrationControllerCR 매니페스트를 가져옵니다.$ oc get migrationcontroller <migration_controller> -n openshift-migration

프록시 매개변수를 업데이트합니다.

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: <migration_controller> namespace: openshift-migration ... spec: stunnel_tcp_proxy: http://<username>:<password>@<ip>:<port> 1 noProxy: example.com 2

하위 도메인과 일치하려면 도메인 앞에

.을 입력합니다. 예를 들어,.y.com은x.y.com과 일치하지만y.com은 일치하지 않습니다.*를 사용하여 모든 대상에 대해 프록시를 바이패스합니다.networking.machineNetwork[].cidr필드에 의해 정의된 네트워크에 포함되어 있지 않은 작업자를 설치 구성에서 확장하려면 연결 문제를 방지하기 위해 이 목록에 해당 작업자를 추가해야 합니다.httpProxy또는httpsProxy필드가 설정되지 않은 경우 이 필드는 무시됩니다.-

매니페스트를

migration-controller.yaml로 저장합니다. 업데이트된 매니페스트를 적용합니다.

$ oc replace -f migration-controller.yaml -n openshift-migration

자세한 내용은 클러스터 전체 프록시 구성을 참조하십시오.

3.4.4. Rsync를 루트 또는 루트가 아닌 사용자로 실행

OpenShift Container Platform 환경에는 기본적으로 PodSecurityAdmission 컨트롤러가 활성화되어 있습니다. 이 컨트롤러를 사용하려면 클러스터 관리자가 네임스페이스 레이블을 통해 Pod 보안 표준을 적용해야 합니다. 클러스터의 모든 워크로드는 Privileged,Baseline 또는 Restricted 의 Pod 보안 표준 수준 중 하나를 실행해야 합니다. 모든 클러스터에는 자체 기본 정책 세트가 있습니다.

모든 환경에서 데이터 전송을 성공적으로 수행하기 위해 MTC(Migration Toolkit for Containers) 1.ECDHE에서는 기본적으로 Rsync Pod를 루트가 아닌 사용자로 실행하는 등 Rsync Pod에 변경 사항을 도입했습니다. 이렇게 하면 더 높은 권한이 필요하지 않은 워크로드에도 데이터 전송이 가능합니다. 이러한 변경은 가능한 한 가장 낮은 수준의 권한으로 워크로드를 실행하는 것이 가장 좋기 때문에 이루어졌습니다.

3.4.4.1. 데이터 전송을 위해 루트가 아닌 기본 작업을 수동으로 덮어쓰기

대부분의 경우 Rsync Pod를 루트가 아닌 사용자로 실행해도 소스 측에서 워크로드를 루트 사용자로 실행할 때 데이터 전송이 실패할 수 있습니다. MTC는 데이터 전송을 위해 루트가 아닌 기본 작업을 수동으로 재정의하는 두 가지 방법을 제공합니다.

- 모든 마이그레이션에 대해 대상 클러스터에서 Rsync Pod를 루트로 실행하도록 모든 마이그레이션을 구성합니다.

- 마이그레이션당 대상 클러스터에서 Rsync Pod를 루트로 실행합니다.

두 경우 모두 마이그레이션 전에 더 높은 권한으로 워크로드를 실행하는 네임스페이스의 소스 측에 다음 레이블을 설정해야 합니다(실행,감사, 경고).

Pod Security Admission and setting values for labels에 대한 자세한 내용은 Pod 보안 승인 동기화 제어를 참조하십시오.

3.4.4.2. 모든 마이그레이션에 대해 MigrationController CR을 루트 또는 루트가 아닌 사용자로 구성

기본적으로 Rsync는 루트가 아닌 상태로 실행됩니다.

대상 클러스터에서 Rsync를 루트로 실행하도록 MigrationController CR을 구성할 수 있습니다.

프로세스

다음과 같이

MigrationControllerCR을 구성합니다.apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] migration_rsync_privileged: true

이 구성은 향후 모든 마이그레이션에 적용됩니다.

3.4.4.3. MigMigration CR을 마이그레이션당 루트 또는 루트가 아닌 사용자로 구성

대상 클러스터에서 다음과 같은 루트가 아닌 옵션을 사용하여 Rsync를 루트 또는 루트가 아닌 사용자로 실행하도록 MigMigration CR을 구성할 수 있습니다.

- 특정 사용자 ID(UID)

- 특정 그룹 ID(GID)

프로세스

Rsync를 루트로 실행하려면 다음 예에 따라

MigMigrationCR을 구성합니다.apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsRoot: true

Rsync를 특정 UID(User ID) 또는 특정 그룹 ID(GID)로 실행하려면 다음 예에 따라

MigMigrationCR을 구성합니다.apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsUser: 10010001 runAsGroup: 3

3.5. 복제 리포지토리 구성

복제 리포지토리로 사용할 오브젝트 스토리지를 구성해야 합니다. MTC(Migration Toolkit for Containers)는 소스 클러스터에서 복제 리포지토리로 데이터를 복사한 다음 복제 리포지토리에서 대상 클러스터로 데이터를 복사합니다.

MTC는 소스 클러스터에서 대상 클러스터로 데이터를 마이그레이션하기 위한 파일 시스템 및 스냅샷 데이터 복사 방법을 지원합니다. 환경에 적합하며 스토리지 공급자가 지원하는 방법을 선택합니다.

MTC는 다음과 같은 스토리지 제공자를 지원합니다.

- Multicloud Object Gateway

- Amazon Web Services S3

- Google Cloud Platform

- Microsoft Azure Blob

- 일반 S3 오브젝트 스토리지(예: Minio 또는 Ceph S3)

3.5.1. 사전 요구 사항

- 모든 클러스터에는 복제 리포지토리에 대한 중단없는 네트워크 액세스 권한이 있어야 합니다.

- 내부 호스팅 복제 리포지토리와 함께 프록시 서버를 사용하는 경우 프록시가 복제 리포지토리에 액세스할 수 있는지 확인해야 합니다.

3.5.2. 멀티 클라우드 오브젝트 게이트웨이 인증 정보 검색

MCG를 MTC(Migration Toolkit for Containers)의 복제 리포지토리로 구성하려면 MCG(Multicloud Object Gateway) 인증 정보 및 S3 끝점을 검색해야 합니다. OADP(데이터 보호)용 OpenShift API에 대한 Secret CR(사용자 정의 리소스)을 생성하려면 MCG(Multicloud Object Gateway) 인증 정보를 검색해야 합니다.

MCG는 OpenShift Data Foundation의 구성 요소입니다.

사전 요구 사항

- 적절한 OpenShift Data Foundation 배포 가이드를 사용하여 OpenShift Data Foundation을 배포해야 합니다.

프로세스

NooBaa사용자 정의 리소스에서describe명령을 실행하여 S3 끝점,AWS_ACCESS_KEY_ID및AWS_SECRET_ACCESS_KEY를 가져옵니다.이러한 인증 정보를 사용하여 MCG를 복제 리포지토리로 추가합니다.

3.5.3. Amazon Web Services 구성

AWS(Amazon Web Services) S3 오브젝트 스토리지를 MTC(Migration Toolkit for Containers)의 복제 리포지토리로 구성합니다.

사전 요구 사항

- AWS CLI가 설치되어 있어야 합니다.

- 소스 및 대상 클러스터에서 AWS S3 스토리지 버킷에 액세스할 수 있어야 합니다.

스냅샷 복사 방법을 사용하는 경우:

- EC2 EBS(Elastic Block Storage)에 액세스할 수 있어야 합니다.

- 소스 및 대상 클러스터는 동일한 지역에 있어야 합니다.

- 소스 및 대상 클러스터는 동일한 스토리지 클래스를 보유해야 합니다.

- 스토리지 클래스는 스냅샷과 호환 가능해야 합니다.

프로세스

BUCKET변수를 설정합니다.$ BUCKET=<your_bucket>

REGION변수를 설정합니다.$ REGION=<your_region>

AWS S3 버킷을 생성합니다.

$ aws s3api create-bucket \ --bucket $BUCKET \ --region $REGION \ --create-bucket-configuration LocationConstraint=$REGION 1- 1

us-east-1은LocationConstraint를 지원하지 않습니다. 리전이us-east-1인 경우--create-bucket-configuration LocationConstraint=$REGION을 생략합니다.

IAM 사용자를 생성합니다.

$ aws iam create-user --user-name velero 1- 1

- Velero를 사용하여 여러 S3 버킷이 있는 여러 클러스터를 백업하려면 각 클러스터에 대해 고유한 사용자 이름을 생성합니다.

velero-policy.json파일을 생성합니다.$ cat > velero-policy.json <<EOF { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": [ "ec2:DescribeVolumes", "ec2:DescribeSnapshots", "ec2:CreateTags", "ec2:CreateVolume", "ec2:CreateSnapshot", "ec2:DeleteSnapshot" ], "Resource": "*" }, { "Effect": "Allow", "Action": [ "s3:GetObject", "s3:DeleteObject", "s3:PutObject", "s3:AbortMultipartUpload", "s3:ListMultipartUploadParts" ], "Resource": [ "arn:aws:s3:::${BUCKET}/*" ] }, { "Effect": "Allow", "Action": [ "s3:ListBucket", "s3:GetBucketLocation", "s3:ListBucketMultipartUploads" ], "Resource": [ "arn:aws:s3:::${BUCKET}" ] } ] } EOF정책을 연결하여

velero사용자에게 필요한 최소 권한을 부여합니다.$ aws iam put-user-policy \ --user-name velero \ --policy-name velero \ --policy-document file://velero-policy.json

velero사용자에 대한 액세스 키를 생성합니다.$ aws iam create-access-key --user-name velero

출력 예

{ "AccessKey": { "UserName": "velero", "Status": "Active", "CreateDate": "2017-07-31T22:24:41.576Z", "SecretAccessKey": <AWS_SECRET_ACCESS_KEY>, "AccessKeyId": <AWS_ACCESS_KEY_ID> } }AWS_SECRET_ACCESS_KEY및AWS_ACCESS_KEY_ID를 기록합니다. 인증 정보를 사용하여 AWS를 복제 리포지토리로 추가합니다.

3.5.4. GCP(Google Cloud Platform) 구성

GCP(Google Cloud Platform) 스토리지 버킷을 MTC(Migration Toolkit for Containers)의 복제 리포지토리로 구성합니다.

사전 요구 사항

-

gcloud및gsutilCLI 툴이 설치되어 있어야 합니다. 자세한 내용은 Google 클라우드 설명서를 참조하십시오. - 소스 및 대상 클러스터에서 GCP 스토리지 버킷에 액세스할 수 있어야 합니다.

스냅샷 복사 방법을 사용하는 경우:

- 소스 및 대상 클러스터는 동일한 지역에 있어야 합니다.

- 소스 및 대상 클러스터는 동일한 스토리지 클래스를 보유해야 합니다.

- 스토리지 클래스는 스냅샷과 호환 가능해야 합니다.

프로세스

GCP에 로그인합니다.

$ gcloud auth login

BUCKET변수를 설정합니다.$ BUCKET=<bucket> 1- 1

- 버킷 이름을 지정합니다.

스토리지 버킷을 생성합니다.

$ gsutil mb gs://$BUCKET/

PROJECT_ID변수를 활성 프로젝트로 설정합니다.$ PROJECT_ID=$(gcloud config get-value project)

서비스 계정을 생성합니다.

$ gcloud iam service-accounts create velero \ --display-name "Velero service account"서비스 계정을 나열합니다.

$ gcloud iam service-accounts list

email값과 일치하도록SERVICE_ACCOUNT_EMAIL변수를 설정합니다.$ SERVICE_ACCOUNT_EMAIL=$(gcloud iam service-accounts list \ --filter="displayName:Velero service account" \ --format 'value(email)')정책을 연결하여

velero사용자에게 필요한 최소 권한을 부여합니다.$ ROLE_PERMISSIONS=( compute.disks.get compute.disks.create compute.disks.createSnapshot compute.snapshots.get compute.snapshots.create compute.snapshots.useReadOnly compute.snapshots.delete compute.zones.get storage.objects.create storage.objects.delete storage.objects.get storage.objects.list iam.serviceAccounts.signBlob )velero.server사용자 정의 역할을 생성합니다.$ gcloud iam roles create velero.server \ --project $PROJECT_ID \ --title "Velero Server" \ --permissions "$(IFS=","; echo "${ROLE_PERMISSIONS[*]}")"프로젝트에 IAM 정책 바인딩을 추가합니다.

$ gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT_EMAIL \ --role projects/$PROJECT_ID/roles/velero.serverIAM 서비스 계정을 업데이트합니다.

$ gsutil iam ch serviceAccount:$SERVICE_ACCOUNT_EMAIL:objectAdmin gs://${BUCKET}IAM 서비스 계정 키를 현재 디렉터리의

credentials-velero파일에 저장합니다.$ gcloud iam service-accounts keys create credentials-velero \ --iam-account $SERVICE_ACCOUNT_EMAILcredentials-velero파일을 사용하여 GCP를 복제 리포지토리로 추가합니다.

3.5.5. Microsoft Azure 구성

Microsoft Azure Blob 스토리지 컨테이너를 MTC(Migration Toolkit for Containers)의 복제 리포지토리로 구성합니다.

사전 요구 사항

- Azure CLI가 설치되어 있어야 합니다.

- Azure Blob 스토리지 컨테이너는 소스 및 대상 클러스터에 액세스할 수 있어야 합니다.

스냅샷 복사 방법을 사용하는 경우:

- 소스 및 대상 클러스터는 동일한 지역에 있어야 합니다.

- 소스 및 대상 클러스터는 동일한 스토리지 클래스를 보유해야 합니다.

- 스토리지 클래스는 스냅샷과 호환 가능해야 합니다.

프로세스

Azure에 로그인합니다.

$ az login

AZURE_RESOURCE_GROUP변수를 설정합니다.$ AZURE_RESOURCE_GROUP=Velero_Backups

Azure 리소스 그룹을 생성합니다.

$ az group create -n $AZURE_RESOURCE_GROUP --location CentralUS 1- 1

- 위치를 지정합니다.

AZURE_STORAGE_ACCOUNT_ID변수를 설정합니다.$ AZURE_STORAGE_ACCOUNT_ID="velero$(uuidgen | cut -d '-' -f5 | tr '[A-Z]' '[a-z]')"

Azure 스토리지 계정을 생성합니다.

$ az storage account create \ --name $AZURE_STORAGE_ACCOUNT_ID \ --resource-group $AZURE_RESOURCE_GROUP \ --sku Standard_GRS \ --encryption-services blob \ --https-only true \ --kind BlobStorage \ --access-tier HotBLOB_CONTAINER변수를 설정합니다.$ BLOB_CONTAINER=velero

Azure Blob 스토리지 컨테이너를 생성합니다.

$ az storage container create \ -n $BLOB_CONTAINER \ --public-access off \ --account-name $AZURE_STORAGE_ACCOUNT_ID

velero에 대한 서비스 주체 및 자격 증명을 생성합니다.$ AZURE_SUBSCRIPTION_ID=`az account list --query '[?isDefault].id' -o tsv` \ AZURE_TENANT_ID=`az account list --query '[?isDefault].tenantId' -o tsv` \ AZURE_CLIENT_SECRET=`az ad sp create-for-rbac --name "velero" \ --role "Contributor" --query 'password' -o tsv` \ AZURE_CLIENT_ID=`az ad sp list --display-name "velero" \ --query '[0].appId' -o tsv`

credentials-velero파일에 서비스 주체 자격 증명을 저장합니다.$ cat << EOF > ./credentials-velero AZURE_SUBSCRIPTION_ID=${AZURE_SUBSCRIPTION_ID} AZURE_TENANT_ID=${AZURE_TENANT_ID} AZURE_CLIENT_ID=${AZURE_CLIENT_ID} AZURE_CLIENT_SECRET=${AZURE_CLIENT_SECRET} AZURE_RESOURCE_GROUP=${AZURE_RESOURCE_GROUP} AZURE_CLOUD_NAME=AzurePublicCloud EOFcredentials-velero파일을 사용하여 Azure를 복제 리포지토리로 추가합니다.

3.5.6. 추가 리소스

3.6. MTC 설치 제거 및 리소스 삭제

MTC(Migration Toolkit for Containers)를 설치 제거하고 해당 리소스를 삭제하여 클러스터를 정리할 수 있습니다.

velero CRD를 삭제하면 클러스터에서 Velero가 제거됩니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인해야 합니다.

프로세스

모든 클러스터에서

MigrationControllerCR(사용자 정의 리소스)을 삭제합니다.$ oc delete migrationcontroller <migration_controller>

- Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4에서 Migration Toolkit for Containers Operator를 설치 제거합니다.

다음 명령을 실행하여 모든 클러스터에서 클러스터 범위 리소스를 삭제합니다.

migrationCRD(사용자 정의 리소스 정의):$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')

VeleroCRD:$ oc delete $(oc get crds -o name | grep 'velero')

migration클러스터 역할:$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

migration-operator클러스터 역할:$ oc delete clusterrole migration-operator

Velero클러스터 역할:$ oc delete $(oc get clusterroles -o name | grep 'velero')

migration클러스터 역할 바인딩:$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

migration-operator클러스터 역할 바인딩:$ oc delete clusterrolebindings migration-operator

Velero클러스터 역할 바인딩:$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')

4장. 제한된 네트워크 환경에서 MTC 설치

다음 절차를 수행하여 제한된 네트워크 환경에서 OpenShift Container Platform 4에 MTC(Migration Toolkit for Containers)를 설치할 수 있습니다.

미러링된 Operator 카탈로그 를 생성합니다.

이 프로세스에서는

registry.redhat.io이미지와 미러 레지스트리 이미지 간의 매핑을 포함하는mapping.txt파일을 생성합니다. OpenShift Container Platform 4.2에서 4.5 소스 클러스터에 기존 Migration Toolkit for Containers Operator를 설치하려면mapping.txt파일이 필요합니다.Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4.15 대상 클러스터에 Migration Toolkit for Containers Operator를 설치합니다.

기본적으로 MTC 웹 콘솔 및

Migration ControllerPod는 대상 클러스터에서 실행됩니다. 원격 클러스터에서 MTC 웹 콘솔 및Migration ControllerPod를 실행하도록Migration Controller사용자 정의 리소스 매니페스트를 구성할 수 있습니다.소스 클러스터에 Migration Toolkit for Containers Operator를 설치합니다.

- OpenShift Container Platform 4.6 이상: Operator Lifecycle Manager를 사용하여 Migration Toolkit for Containers Operator를 설치합니다.

- OpenShift Container Platform 4.2 - 4.5: 명령줄 인터페이스에서 기존 컨테이너용 마이그레이션 툴킷을 설치합니다.

- 복제 리포지토리로 사용할 오브젝트 스토리지를 구성합니다.

OpenShift Container Platform 3에 MTC를 설치하려면 OpenShift Container Platform 3에 레거시 Migration Toolkit for Containers Operator 설치를 참조하십시오.

MTC를 설치 제거하려면 MTC 설치 제거 및 리소스 삭제를 참조하십시오.

4.1. 호환성 지침

OpenShift Container Platform 버전과 호환되는 MTC(Migration Toolkit for Containers) Operator를 설치해야 합니다.

정의

- 기존 플랫폼

- OpenShift Container Platform 4.5 및 이전 버전입니다.

- 최신 플랫폼

- OpenShift Container Platform 4.6 이상 버전입니다.

- 기존 Operator

- 레거시 플랫폼을 위해 설계된 MTC Operator입니다.

- 최신 Operator

- 최신 플랫폼을 위해 설계된 MTC Operator입니다.

- 클러스터 제어

- MTC 컨트롤러 및 GUI를 실행하는 클러스터입니다.

- 원격 클러스터

- Velero를 실행하는 마이그레이션의 소스 또는 대상 클러스터입니다. Control Cluster는 Velero API를 통해 원격 클러스터와 통신하여 마이그레이션을 구동합니다.

OpenShift Container Platform 클러스터를 마이그레이션하는 데 호환되는 MTC 버전을 사용해야 합니다. 마이그레이션이 소스 클러스터와 대상 클러스터 모두에 성공하려면 동일한 버전의 MTC를 사용해야 합니다.

MTC 1.7은 OpenShift Container Platform 3.11에서 4.9로의 마이그레이션을 지원합니다.

MTC 1.8은 OpenShift Container Platform 4.10 이상에서만 마이그레이션을 지원합니다.

표 4.1. MTC 호환성: 레거시 또는 최신 플랫폼에서 마이그레이션

| 세부 정보 | OpenShift Container Platform 3.11 | OpenShift Container Platform 4.0에서 4.5로 | OpenShift Container Platform 4.6에서 4.9로 | OpenShift Container Platform 4.10 이상 |

|---|---|---|---|---|

| 안정적인 MTC 버전 | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.7.z | MTC v.1.8.z |

| 설치 |

레거시 MTC v.1.7.z operator: [critical] 이 클러스터는 제어 클러스터가 될 수 없습니다. |

OLM과 함께 설치, 릴리스 채널 |

OLM과 함께 설치, 릴리스 채널 |

현대 클러스터가 마이그레이션에 관련된 다른 클러스터에 연결하지 못하도록 하는 Edge 사례가 있습니다. 예를 들어 온프레미스의 OpenShift Container Platform 3.11 클러스터에서 클라우드의 최신 OpenShift Container Platform 클러스터로 마이그레이션할 때 최신 클러스터가 OpenShift Container Platform 3.11 클러스터에 연결할 수 없습니다.

MTC v.1.7.z 를 사용하면 네트워크 제한으로 인해 원격 클러스터 중 하나가 컨트롤 클러스터와 통신할 수 없는 경우 crane tunnel-api 명령을 사용합니다.

안정적인 MTC 릴리스에서는 항상 최신 클러스터를 제어 클러스터로 지정해야 하지만 이 특정 경우 레거시 클러스터를 제어 클러스터로 지정하고 워크로드를 원격 클러스터로 푸시할 수 있습니다.

4.2. OpenShift Container Platform 4.15에 Migration Toolkit for Containers Operator 설치

Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4.15에 Migration Toolkit for Containers Operator를 설치합니다.

사전 요구 사항

-

모든 클러스터에서

cluster-admin권한이 있는 사용자로 로그인합니다. - 로컬 레지스트리의 미러 이미지에서 Operator 카탈로그를 생성해야 합니다.

프로세스

- OpenShift Container Platform 웹 콘솔에서 Operator → OperatorHub를 클릭합니다.

- 키워드로 필터링 필드를 사용하여 Migration Toolkit for Containers Operator를 찾습니다.

- Migration Toolkit for Containers Operator를 선택하고 설치를 클릭합니다.

설치를 클릭합니다.

설치된 Operators 페이지에서 Migration Toolkit for Containers Operator는 openshift-migration 프로젝트에 Succeeded 상태로 나타납니다.

- Migration Toolkit for Containers Operator를 클릭합니다.

- 제공된 API 아래에서 마이그레이션 컨트롤러 타일을 찾고 인스턴스 작성을 클릭합니다.

- 생성을 클릭합니다.

- 워크로드 → Pod를 클릭하여 MTC pod가 실행 중인지 확인합니다.

4.3. OpenShift Container Platform 4.2에서 4.5로 레거시 Migration Toolkit for Containers Operator 설치

OpenShift Container Platform 버전 4.2에서 4.5로 레거시 Migration Toolkit for Containers Operator를 수동으로 설치할 수 있습니다.

사전 요구 사항

-

모든 클러스터에서

cluster-admin권한이 있는 사용자로 로그인합니다. -

registry.redhat.io에 대한 액세스 권한이 있어야 합니다. -

podman이 설치되어 있어야 합니다. -

registry.redhat.io에서 파일을 다운로드하려면 네트워크 액세스 권한이 있는 Linux 워크스테이션이 있어야 합니다. - Operator 카탈로그의 미러 이미지를 생성해야 합니다.

- OpenShift Container Platform 4.15의 미러링된 Operator 카탈로그에서 Migration Toolkit for Containers Operator를 설치해야 합니다.

프로세스

Red Hat Customer Portal 자격 증명을 사용하여

registry.redhat.io에 로그인합니다.$ podman login registry.redhat.io

다음 명령을 입력하여

operator.yml파일을 다운로드합니다.podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/operator.yml ./

다음 명령을 입력하여

controller.yml파일을 다운로드합니다.podman cp $(podman create registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.7):/controller.yml ./

다음 명령을 실행하여 Operator 이미지 매핑을 가져옵니다.

$ grep openshift-migration-legacy-rhel8-operator ./mapping.txt | grep rhmtc

Operator 카탈로그를 미러링할 때

mapping.txt파일이 생성되었습니다. 출력은registry.redhat.io이미지와 미러 레지스트리 이미지 간의 매핑을 보여줍니다.출력 예

registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a=<registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator

operator.yml파일에서ansible및operator컨테이너의image값과REGISTRY값을 업데이트합니다.containers: - name: ansible image: <registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:<468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a> 1 ... - name: operator image: <registry.apps.example.com>/rhmtc/openshift-migration-legacy-rhel8-operator@sha256:<468a6126f73b1ee12085ca53a312d1f96ef5a2ca03442bcb63724af5e2614e8a> 2 ... env: - name: REGISTRY value: <registry.apps.example.com> 3- OpenShift Container Platform 소스 클러스터에 로그인합니다.

Migration Toolkit for Containers Operator 오브젝트 생성:

$ oc create -f operator.yml

출력 예

namespace/openshift-migration created rolebinding.rbac.authorization.k8s.io/system:deployers created serviceaccount/migration-operator created customresourcedefinition.apiextensions.k8s.io/migrationcontrollers.migration.openshift.io created role.rbac.authorization.k8s.io/migration-operator created rolebinding.rbac.authorization.k8s.io/migration-operator created clusterrolebinding.rbac.authorization.k8s.io/migration-operator created deployment.apps/migration-operator created Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-builders" already exists 1 Error from server (AlreadyExists): error when creating "./operator.yml": rolebindings.rbac.authorization.k8s.io "system:image-pullers" already exists- 1

Error from server (AlreadyExists)메시지를 무시할 수 있습니다. 이는 Migration Toolkit for Containers Operator가 이후 릴리스에서 제공되는 OpenShift Container Platform 4 이전 버전에 대한 리소스를 생성하기 때문에 발생합니다.

MigrationController오브젝트를 만듭니다.$ oc create -f controller.yml

MTC pod가 실행 중인지 확인합니다.

$ oc get pods -n openshift-migration

4.4. 프록시 설정

OpenShift Container Platform 4.1 및 이전 버전의 경우 이러한 버전은 클러스터 전체 프록시 오브젝트를 지원하지 않기 때문에 Migration Toolkit for Containers Operator를 설치한 후 MigrationController CR(사용자 정의 리소스) 매니페스트에서 proxy를 구성해야 합니다.

OpenShift Container Platform 4.2 to 4.15의 경우 MTC(Migration Toolkit for Containers)는 클러스터 전체 프록시 설정을 상속합니다. 클러스터 전체 프록시 설정을 재정의하려면 프록시 매개변수를 변경할 수 있습니다.

4.4.1. 직접 볼륨 마이그레이션

MTC 1.4.2에서 직접 볼륨 마이그레이션(DVM)이 도입되었습니다. DVM은 하나의 프록시만 지원합니다. 대상 클러스터가 프록시 뒤에 있는 경우 소스 클러스터는 대상 클러스터의 경로에 액세스할 수 없습니다.

프록시 뒤에서 소스 클러스터에서 DVM을 수행하려면 전송 계층에서 작동하는 TCP 프록시를 구성하고 자체 SSL 인증서로 암호를 해독하고 재암호화하지 않고도 SSL 연결을 투명하게 전달해야 합니다. Stunnel 프록시는 이러한 프록시의 예입니다.

4.4.1.1. DVM용 TCP 프록시 설정

TCP 프록시를 통해 소스와 대상 클러스터 간에 직접 연결하고 프록시를 사용하도록 MigrationController CR에서 stunnel_tcp_proxy 변수를 구성할 수 있습니다.

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] stunnel_tcp_proxy: http://username:password@ip:port

직접 볼륨 마이그레이션(DVM)은 프록시에 대한 기본 인증만 지원합니다. 또한 DVM은 TCP 연결을 투명하게 터널링할 수 있는 프록시 뒤에서만 작동합니다. 중간자 모드에서 HTTP/HTTPS 프록시가 작동하지 않습니다. 기존 클러스터 전체 프록시에서 이 동작을 지원하지 않을 수 있습니다. 결과적으로 DVM의 프록시 설정은 의도적으로 MTC의 일반 프록시 구성과 다르게 유지됩니다.

4.4.1.2. HTTP/HTTPS 프록시 대신 TCP 프록시를 사용하는 이유는 무엇입니까?

OpenShift 경로를 통해 소스와 대상 클러스터 간에 Rsync를 실행하여 DVM을 활성화할 수 있습니다. 트래픽은 TCP 프록시인 Stunnel을 사용하여 암호화됩니다. 소스 클러스터에서 실행되는 Stunnel은 대상 Stunnel을 사용한 TLS 연결을 시작하고 암호화된 채널을 통해 데이터를 전송합니다.

OpenShift의 클러스터 전체 HTTP/HTTPS 프록시는 일반적으로 자체 TLS 세션을 외부 서버와 협상하는 중간자 모드로 구성됩니다. 그러나 이 작업은 Stunnel에서는 작동하지 않습니다. Stunnel은 프록시에서 TLS 세션을 그대로 전환해야 하므로 기본적으로 프록시를 통해 TCP 연결을 그대로 전달하는 투명한 터널로 프록시를 설정해야 합니다. 따라서 TCP 프록시를 사용해야 합니다.

4.4.1.3. 알려진 문제

마이그레이션 실패 오류 Upgrade request required

마이그레이션 컨트롤러는 SPDY 프로토콜을 사용하여 원격 Pod 내에서 명령을 실행합니다. 원격 클러스터가 프록시 또는 SPDY 프로토콜을 지원하지 않는 방화벽 뒤에 있는 경우 마이그레이션 컨트롤러가 원격 명령을 실행하지 못합니다. 오류 메시지 Upgrade request required와 함께 마이그레이션이 실패합니다. 해결방법: SPDY 프로토콜을 지원하는 프록시를 사용합니다.

SPDY 프로토콜 지원 외에도 프록시 또는 방화벽은 Upgrade HTTP 헤더를 API 서버에 전달해야 합니다. 클라이언트는 이 헤더를 사용하여 API 서버와의 websocket 연결을 엽니다. Upgrade 헤더가 프록시 또는 방화벽에 의해 차단된 경우 마이그레이션은 오류 메시지 Upgrade request required와 함께 실패합니다. 해결방법: 프록시가 Upgrade 헤더를 전달하도록 합니다.

4.4.2. 마이그레이션을 위한 네트워크 정책 튜닝

OpenShift는 클러스터에서 사용하는 네트워크 플러그인을 기반으로 NetworkPolicy 또는 EgressFirewall을 사용하여 Pod로 트래픽을 제한할 수 있습니다. 마이그레이션과 관련된 소스 네임스페이스가 이러한 메커니즘을 사용하여 네트워크 트래픽을 포드로 제한하는 경우 제한이 마이그레이션 중에 Rsync pod로의 트래픽을 실수로 중지할 수 있습니다.

소스 및 대상 클러스터에서 둘 다 실행되는 rsync Pod는 OpenShift 경로를 통해 서로 연결되어야 합니다. 기존 NetworkPolicy 또는 EgressNetworkPolicy 오브젝트는 이러한 트래픽 제한에서 Rsync Pod를 자동으로 제외하도록 구성할 수 있습니다.

4.4.2.1. NetworkPolicy 구성

4.4.2.1.1. Rsync Pod의 송신 트래픽

소스 또는 대상 네임스페이스의 NetworkPolicy 구성이 이러한 유형의 트래픽을 차단하는 경우 Rsync Pod의 고유한 레이블을 사용하여 송신 트래픽이 해당 트래픽에서 전달되도록 허용할 수 있습니다. 다음 정책은 네임스페이스의 Rsync Pod에서 모든 송신 트래픽을 허용합니다.

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

egress:

- {}

policyTypes:

- Egress4.4.2.1.2. Rsync pod로의 수신 트래픽

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-all-egress-from-rsync-pods

spec:

podSelector:

matchLabels:

owner: directvolumemigration

app: directvolumemigration-rsync-transfer

ingress:

- {}

policyTypes:

- Ingress4.4.2.2. EgressNetworkPolicy 구성

EgressNetworkPolicy 오브젝트 또는 Egress Firewalls 는 클러스터를 나가는 송신 트래픽을 차단하도록 설계된 OpenShift 구조입니다.

NetworkPolicy 오브젝트와 달리 Egress Firewall은 네임스페이스의 모든 포드에 적용되므로 프로젝트 수준에서 작동합니다. 따라서 Rsync Pod의 고유 레이블은 제한 사항에서 Rsync Pod만 제외하지 않습니다. 그러나 두 클러스터 간에 직접 연결을 설정할 수 있도록 소스 또는 대상 클러스터의 CIDR 범위를 정책의 허용 규칙에 추가할 수 있습니다.

Egress Firewall이 있는 클러스터를 기반으로 다른 클러스터의 CIDR 범위를 추가하여 둘 사이의 송신 트래픽을 허용할 수 있습니다.

apiVersion: network.openshift.io/v1

kind: EgressNetworkPolicy

metadata:

name: test-egress-policy

namespace: <namespace>

spec:

egress:

- to:

cidrSelector: <cidr_of_source_or_target_cluster>

type: Deny4.4.2.3. 데이터 전송을 위한 대체 끝점 선택

기본적으로 DVM은 OpenShift Container Platform 경로를 끝점으로 사용하여 PV 데이터를 대상 클러스터로 전송합니다. 클러스터 토폴로지가 허용하는 경우 다른 유형의 지원되는 끝점을 선택할 수 있습니다.

각 클러스터에 대해 MigrationController CR의 적절한 대상 클러스터에서 rsync_endpoint_type 변수를 설정하여 끝점을 구성할 수 있습니다.

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] rsync_endpoint_type: [NodePort|ClusterIP|Route]

4.4.2.4. Rsync Pod에 대한 추가 그룹 구성

PVC에서 공유 스토리지를 사용하는 경우 Pod에서 액세스를 허용하기 위해 Rsync Pod 정의에 추가 그룹을 추가하여 해당 스토리지에 대한 액세스를 구성할 수 있습니다.

표 4.2. Rsync Pod의 보조 그룹

| Variable | 유형 | Default | 설명 |

|---|---|---|---|

|

| string | 설정되지 않음 | 소스 Rsync Pod에 대한 콤마로 구분된 추가 그룹 목록 |

|

| string | 설정되지 않음 | 대상 Rsync Pod에 대한 콤마로 구분된 추가 그룹 목록 |

사용 예

MigrationController CR을 업데이트하여 이러한 추가 그룹에 대한 값을 설정할 수 있습니다.

spec: src_supplemental_groups: "1000,2000" target_supplemental_groups: "2000,3000"

4.4.3. 프록시 구성

사전 요구 사항

-

모든 클러스터에서

cluster-admin권한이 있는 사용자로 로그인합니다.

프로세스

MigrationControllerCR 매니페스트를 가져옵니다.$ oc get migrationcontroller <migration_controller> -n openshift-migration

프록시 매개변수를 업데이트합니다.

apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: <migration_controller> namespace: openshift-migration ... spec: stunnel_tcp_proxy: http://<username>:<password>@<ip>:<port> 1 noProxy: example.com 2

하위 도메인과 일치하려면 도메인 앞에

.을 입력합니다. 예를 들어,.y.com은x.y.com과 일치하지만y.com은 일치하지 않습니다.*를 사용하여 모든 대상에 대해 프록시를 바이패스합니다.networking.machineNetwork[].cidr필드에 의해 정의된 네트워크에 포함되어 있지 않은 작업자를 설치 구성에서 확장하려면 연결 문제를 방지하기 위해 이 목록에 해당 작업자를 추가해야 합니다.httpProxy또는httpsProxy필드가 설정되지 않은 경우 이 필드는 무시됩니다.-

매니페스트를

migration-controller.yaml로 저장합니다. 업데이트된 매니페스트를 적용합니다.

$ oc replace -f migration-controller.yaml -n openshift-migration

자세한 내용은 클러스터 전체 프록시 구성을 참조하십시오.

4.5. Rsync를 루트 또는 루트가 아닌 사용자로 실행

이 섹션은 웹 콘솔이 아닌 OpenShift API로 작업하는 경우에만 적용됩니다.

OpenShift 환경에는 기본적으로 PodSecurityAdmission 컨트롤러가 활성화되어 있습니다. 이 컨트롤러를 사용하려면 클러스터 관리자가 네임스페이스 레이블을 통해 Pod 보안 표준을 적용해야 합니다. 클러스터의 모든 워크로드는 Privileged,Baseline 또는 Restricted 의 Pod 보안 표준 수준 중 하나를 실행해야 합니다. 모든 클러스터에는 자체 기본 정책 세트가 있습니다.

모든 환경에서 데이터 전송을 성공적으로 수행하기 위해 MTC(Migration Toolkit for Containers) 1.ECDHE에서는 기본적으로 Rsync Pod를 루트가 아닌 사용자로 실행하는 등 Rsync Pod에 변경 사항을 도입했습니다. 이렇게 하면 더 높은 권한이 필요하지 않은 워크로드에도 데이터 전송이 가능합니다. 이러한 변경은 가능한 한 가장 낮은 수준의 권한으로 워크로드를 실행하는 것이 가장 좋기 때문에 이루어졌습니다.

데이터 전송을 위해 루트가 아닌 기본 작업을 수동으로 덮어쓰기

대부분의 경우 Rsync Pod를 루트가 아닌 사용자로 실행해도 소스 측에서 워크로드를 루트 사용자로 실행할 때 데이터 전송이 실패할 수 있습니다. MTC는 데이터 전송을 위해 루트가 아닌 기본 작업을 수동으로 재정의하는 두 가지 방법을 제공합니다.

- 모든 마이그레이션에 대해 대상 클러스터에서 Rsync Pod를 루트로 실행하도록 모든 마이그레이션을 구성합니다.

- 마이그레이션당 대상 클러스터에서 Rsync Pod를 루트로 실행합니다.

두 경우 모두 마이그레이션하기 전에 권한이 높은 워크로드를 실행하는 네임스페이스의 소스 측에 다음 레이블을 설정해야 합니다. 즉, ,enforce, audit, warn을 적용합니다

Pod Security Admission and setting values for labels에 대한 자세한 내용은 Pod 보안 승인 동기화 제어를 참조하십시오.

4.5.1. 모든 마이그레이션에 대해 MigrationController CR을 루트 또는 루트가 아닌 사용자로 구성

기본적으로 Rsync는 루트가 아닌 상태로 실행됩니다.

대상 클러스터에서 Rsync를 루트로 실행하도록 MigrationController CR을 구성할 수 있습니다.

프로세스

다음과 같이

MigrationControllerCR을 구성합니다.apiVersion: migration.openshift.io/v1alpha1 kind: MigrationController metadata: name: migration-controller namespace: openshift-migration spec: [...] migration_rsync_privileged: true

이 구성은 향후 모든 마이그레이션에 적용됩니다.

4.5.2. MigMigration CR을 마이그레이션당 루트 또는 루트가 아닌 사용자로 구성

대상 클러스터에서 다음과 같은 루트가 아닌 옵션을 사용하여 Rsync를 루트 또는 루트가 아닌 사용자로 실행하도록 MigMigration CR을 구성할 수 있습니다.

- 특정 사용자 ID(UID)

- 특정 그룹 ID(GID)

프로세스

Rsync를 루트로 실행하려면 다음 예에 따라

MigMigrationCR을 구성합니다.apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsRoot: true

Rsync를 특정 UID(User ID) 또는 특정 그룹 ID(GID)로 실행하려면 다음 예에 따라

MigMigrationCR을 구성합니다.apiVersion: migration.openshift.io/v1alpha1 kind: MigMigration metadata: name: migration-controller namespace: openshift-migration spec: [...] runAsUser: 10010001 runAsGroup: 3

4.6. 복제 리포지토리 구성

Multicloud Object Gateway는 제한된 네트워크 환경에 지원되는 유일한 옵션입니다.

MTC는 소스 클러스터에서 대상 클러스터로 데이터를 마이그레이션하기 위한 파일 시스템 및 스냅샷 데이터 복사 방법을 지원합니다. 환경에 적합하고 스토리지 공급자가 지원하는 방법을 선택할 수 있습니다.

4.6.1. 사전 요구 사항

- 모든 클러스터에는 복제 리포지토리에 대한 중단없는 네트워크 액세스 권한이 있어야 합니다.

- 내부 호스팅 복제 리포지토리와 함께 프록시 서버를 사용하는 경우 프록시가 복제 리포지토리에 액세스할 수 있는지 확인해야 합니다.

4.6.2. 멀티 클라우드 오브젝트 게이트웨이 인증 정보 검색

OADP(데이터 보호)용 OpenShift API에 대한 Secret CR(사용자 정의 리소스)을 생성하려면 MCG(Multicloud Object Gateway) 인증 정보를 검색해야 합니다.

MCG는 OpenShift Data Foundation의 구성 요소입니다.

사전 요구 사항

- 적절한 OpenShift Data Foundation 배포 가이드를 사용하여 OpenShift Data Foundation을 배포해야 합니다.

프로세스

-

NooBaa사용자 정의 리소스에서describe명령을 실행하여 S3 끝점,AWS_ACCESS_KEY_ID및AWS_SECRET_ACCESS_KEY를 가져옵니다.

4.6.3. 추가 리소스

- Red Hat OpenShift Data Foundation 설명서의 연결이 끊긴 환경입니다.

- MTC 워크플로

- 데이터 복사 방법 정보

- MTC 웹 콘솔에 복제 리포지토리 추가

4.7. MTC 설치 제거 및 리소스 삭제

MTC(Migration Toolkit for Containers)를 설치 제거하고 해당 리소스를 삭제하여 클러스터를 정리할 수 있습니다.

velero CRD를 삭제하면 클러스터에서 Velero가 제거됩니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인해야 합니다.

프로세스

모든 클러스터에서

MigrationControllerCR(사용자 정의 리소스)을 삭제합니다.$ oc delete migrationcontroller <migration_controller>

- Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4에서 Migration Toolkit for Containers Operator를 설치 제거합니다.

다음 명령을 실행하여 모든 클러스터에서 클러스터 범위 리소스를 삭제합니다.

migrationCRD(사용자 정의 리소스 정의):$ oc delete $(oc get crds -o name | grep 'migration.openshift.io')

VeleroCRD:$ oc delete $(oc get crds -o name | grep 'velero')

migration클러스터 역할:$ oc delete $(oc get clusterroles -o name | grep 'migration.openshift.io')

migration-operator클러스터 역할:$ oc delete clusterrole migration-operator

Velero클러스터 역할:$ oc delete $(oc get clusterroles -o name | grep 'velero')

migration클러스터 역할 바인딩:$ oc delete $(oc get clusterrolebindings -o name | grep 'migration.openshift.io')

migration-operator클러스터 역할 바인딩:$ oc delete clusterrolebindings migration-operator

Velero클러스터 역할 바인딩:$ oc delete $(oc get clusterrolebindings -o name | grep 'velero')

5장. Migration Toolkit for Containers 업그레이드

Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4.15에서 MTC(Migration Toolkit for Containers)를 업그레이드할 수 있습니다.

기존 Migration Toolkit for Containers Operator를 다시 설치하여 OpenShift Container Platform 4.5 및 이전 버전에서 MTC를 업그레이드할 수 있습니다.

MTC 버전 1.3에서 업그레이드하는 경우 MigPlan 사용자 정의 리소스(CR)를 업데이트하려면 추가 절차를 수행해야 합니다.

5.1. OpenShift Container Platform 4.15에서 Migration Toolkit for Containers 업그레이드

Operator Lifecycle Manager를 사용하여 OpenShift Container Platform 4.15에서 MTC(Migration Toolkit for Containers)를 업그레이드할 수 있습니다.

Operator Lifecycle Manager를 사용하여 MTC를 업그레이드할 때 지원되는 마이그레이션 경로를 사용해야 합니다.

마이그레이션 경로

- OpenShift Container Platform 3에서 OpenShift Container Platform 4로 마이그레이션하려면 레거시 MTC Operator 및 MTC 1.7.x가 필요합니다.

- MTC 1.7.x에서 MTC 1.8.x로 마이그레이션하는 것은 지원되지 않습니다.

MTC 1.7.x를 사용하여 OpenShift Container Platform 4.9 이하의 소스로 모든 항목을 마이그레이션해야 합니다.

- MTC 1.7.x는 소스 및 대상 모두에서 사용해야 합니다.

MTC 1.8.x는 OpenShift Container Platform 4.10 이상에서 OpenShift Container Platform 4.10 이상으로의 마이그레이션만 지원합니다. 클러스터 버전 4.10 이상과 관련된 마이그레이션의 경우 1.7.x 또는 1.8.x 중 하나를 사용할 수 있습니다. 그러나 소스 및 대상 모두에서 동일한 MTC 버전이어야 합니다.

- 소스 MTC 1.7.x에서 대상 MTC 1.8.x로의 마이그레이션은 지원되지 않습니다.

- 소스 MTC 1.8.x에서 대상 MTC 1.7.x로의 마이그레이션은 지원되지 않습니다.

- 소스 MTC 1.7.x에서 대상 MTC 1.7.x로의 마이그레이션이 지원됩니다.

- 소스 MTC 1.8.x에서 대상 MTC 1.8.x로의 마이그레이션이 지원됩니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인해야 합니다.

프로세스

OpenShift Container Platform 콘솔에서 Operators > 설치된 Operators로 이동합니다.

보류 중인 업그레이드가 있는 Operator에 업그레이드 사용 가능 상태가 표시됩니다.

- Migration Toolkit for Containers Operator를 클릭합니다.

- 서브스크립션 탭을 클릭합니다. 승인이 필요한 업그레이드는 업그레이드 상태 옆에 표시됩니다. 예를 들어 1 승인 필요가 표시될 수 있습니다.

- 1 승인 필요를 클릭한 다음 설치 계획 프리뷰를 클릭합니다.

- 업그레이드에 사용할 수 있는 리소스를 보고 승인을 클릭합니다.

- Operator → 설치된 Operator 페이지로 이동하여 업그레이드 진행 상황을 모니터링합니다. 완료되면 상태가 성공 및 최신으로 변경됩니다.

- 워크로드 → Pod를 클릭하여 MTC pod가 실행 중인지 확인합니다.

5.2. Migration Toolkit for Containers를 1.8.0으로 업그레이드

Migration Toolkit for Containers를 1.8.0으로 업그레이드하려면 다음 단계를 완료합니다.

프로세스

다음 방법 중 하나를 사용하여 업그레이드할 서브스크립션 이름과 현재 채널을 결정합니다.

다음 명령을 실행하여 서브스크립션 이름과 채널을 확인합니다.

$ oc -n openshift-migration get sub

출력 예

NAME PACKAGE SOURCE CHANNEL mtc-operator mtc-operator mtc-operator-catalog release-v1.7 redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace redhat-oadp-operator mtc-operator-catalog stable-1.0

또는 다음 명령을 실행하여 JSON에서 서브스크립션 이름과 채널을 반환합니다.

$ oc -n openshift-migration get sub -o json | jq -r '.items[] | { name: .metadata.name, package: .spec.name, channel: .spec.channel }'출력 예

{ "name": "mtc-operator", "package": "mtc-operator", "channel": "release-v1.7" } { "name": "redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace", "package": "redhat-oadp-operator", "channel": "stable-1.0" }

각 서브스크립션에 대해 다음 명령을 실행하여 MTC 1.7 채널에서 MTC 1.8 채널로 이동하는 패치입니다.

$ oc -n openshift-migration patch subscription mtc-operator --type merge --patch '{"spec": {"channel": "release-v1.8"}}'출력 예

subscription.operators.coreos.com/mtc-operator patched

5.2.1. OADP 1.0을 1.2 for Containers 1.8.0으로 업그레이드

OADP 1.0을 Migration Toolkit for Containers 1.8.0의 1.2로 업그레이드하려면 다음 단계를 완료하십시오.

프로세스

각 서브스크립션에 대해 다음 명령을 실행하여 OADP 1.0에서 OADP 1.2로 OADP Operator를 패치합니다.

$ oc -n openshift-migration patch subscription redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace --type merge --patch '{"spec": {"channel":"stable-1.2"}}'참고MTC 및 OADP 설치에 사용되는 사용자별 반환된

NAME값을 나타내는 섹션입니다.출력 예

subscription.operators.coreos.com/redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace patched

참고반환된 값은 이 예제에서 사용되는

redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace와 유사합니다.-

installPlanApproval매개변수가Automatic으로 설정된 경우 OLM(Operator Lifecycle Manager)이 업그레이드 프로세스를 시작합니다. -

installPlanApproval매개변수가Manual로 설정된 경우 OLM에서 업그레이드를 시작하기 전에 각installPlan을 승인해야 합니다.

-

검증

다음 명령을 실행하여 OLM에서 OADP 및 MTC 업그레이드를 완료했는지 확인합니다.

$ oc -n openshift-migration get subscriptions.operators.coreos.com mtc-operator -o json | jq '.status | (."state"=="AtLatestKnown")'

값이

true이면 다음 명령을 실행하여 각 서브스크립션에 사용되는 채널을 확인합니다.$ oc -n openshift-migration get sub -o json | jq -r '.items[] | {name: .metadata.name, channel: .spec.channel }'출력 예

{ "name": "mtc-operator", "channel": "release-v1.8" } { "name": "redhat-oadp-operator-stable-1.0-mtc-operator-catalog-openshift-marketplace", "channel": "stable-1.2" }Confirm that the `mtc-operator.v1.8.0` and `oadp-operator.v1.2.x` packages are installed by running the following command:

$ oc -n openshift-migration get csv

출력 예

NAME DISPLAY VERSION REPLACES PHASE mtc-operator.v1.8.0 Migration Toolkit for Containers Operator 1.8.0 mtc-operator.v1.7.13 Succeeded oadp-operator.v1.2.2 OADP Operator 1.2.2 oadp-operator.v1.0.13 Succeeded

5.3. OpenShift Container Platform 버전 4.2에서 4.5로 Migration Toolkit for Containers 업그레이드

레거시 MTC(Migration Toolkit for Containers Operator)를 수동으로 설치하여 OpenShift Container Platform 버전 4.2에서 MTC(Migration Toolkit for Containers)를 업그레이드할 수 있습니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인해야 합니다. -

registry.redhat.io에 대한 액세스 권한이 있어야 합니다. -

podman이 설치되어 있어야 합니다.

프로세스

다음 명령을 입력하여 Red Hat Customer Portal 자격 증명을 사용하여

registry.redhat.io에 로그인합니다.$ podman login registry.redhat.io

다음 명령을 입력하여

operator.yml파일을 다운로드합니다.$ podman cp $(podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.8):/operator.yml ./

다음 명령을 입력하여 Migration Toolkit for Containers Operator를 교체합니다.

$ oc replace --force -f operator.yml

다음 명령을 입력하여

migration-operator배포를0으로 확장하여 배포를 중지합니다.$ oc scale -n openshift-migration --replicas=0 deployment/migration-operator

migration-operator배포를1로 확장하여 배포를 시작하고 다음 명령을 입력하여 변경 사항을 적용합니다.$ oc scale -n openshift-migration --replicas=1 deployment/migration-operator

다음 명령을 입력하여

migration-operator가 업그레이드되었는지 확인합니다.$ oc -o yaml -n openshift-migration get deployment/migration-operator | grep image: | awk -F ":" '{ print $NF }'다음 명령을 입력하여

controller.yml파일을 다운로드합니다.$ podman cp $(podman create \ registry.redhat.io/rhmtc/openshift-migration-legacy-rhel8-operator:v1.8):/controller.yml ./

다음 명령을 입력하여

migration-controller오브젝트를 생성합니다.$ oc create -f controller.yml

다음 명령을 입력하여 MTC Pod가 실행 중인지 확인합니다.

$ oc get pods -n openshift-migration

5.4. MTC 1.3을 1.8로 업그레이드

MTC(Migration Toolkit for Containers) 버전 1.3.x를 1.8로 업그레이드하는 경우 MigrationController Pod가 실행 중인 클러스터에서 MigPlan 사용자 정의 리소스(CR) 매니페스트를 업데이트해야 합니다.

indirectImageMigration 및 indirectVolumeMigration 매개변수는 MTC 1.3에 존재하지 않기 때문에 버전 1.4의 기본값은 false이며 직접 이미지 마이그레이션 및 직접 볼륨 마이그레이션이 활성화됩니다. 직접 마이그레이션 요구 사항이 충족되지 않기 때문에 이러한 매개변수 값이 true로 변경되지 않는 한 마이그레이션 계획에서 Ready 상태에 도달할 수 없습니다.

- OpenShift Container Platform 3에서 OpenShift Container Platform 4로 마이그레이션하려면 레거시 MTC Operator 및 MTC 1.7.x가 필요합니다.

-

MTC 1.7.x를 1.8.x로 업그레이드하려면 1.7.x에서 1.8.x로 업그레이드를 성공적으로 완료하려면 OADP 채널을

stable-1.0에서stable-1.2로 수동으로 업데이트해야 합니다.

사전 요구 사항

-

cluster-admin권한이 있는 사용자로 로그인해야 합니다.

프로세스

-

MigrationControllerPod를 실행하는 클러스터에 로그인합니다. MigPlanCR 매니페스트를 가져옵니다.$ oc get migplan <migplan> -o yaml -n openshift-migration

다음 매개변수 값을 업데이트하고 파일을

migplan.yaml로 저장합니다.... spec: indirectImageMigration: true indirectVolumeMigration: true

MigPlanCR 매니페스트를 교체하여 변경 사항을 적용합니다.$ oc replace -f migplan.yaml -n openshift-migration

업데이트된

MigPlanCR 매니페스트를 가져와 변경 사항을 확인합니다.$ oc get migplan <migplan> -o yaml -n openshift-migration

6장. 마이그레이션 전 체크리스트

MTC(Migration Toolkit for Containers)를 사용하여 애플리케이션 워크로드를 마이그레이션하기 전에 다음 체크리스트를 검토하십시오.

6.1. 클러스터 상태 체크리스트

- 클러스터는 특정 플랫폼 및 설치 방법(예: 베어 메탈 )에 대한 최소 하드웨어 요구 사항을 충족합니다.

- 모든 MTC 사전 요구 사항이 충족됩니다.

- ❏ 모든 노드에는 유효한 OpenShift Container Platform 서브스크립션이 있습니다.

- 노드 상태를 확인했습니다.

- ID 공급자가 작동 중입니다.

- ❏ 마이그레이션 네트워크의 최소 처리량은 10Gbps입니다.

❏ 클러스터에 마이그레이션에 필요한 충분한 리소스가 있습니다.

참고일반 워크로드에서 마이그레이션을 실행하려면 클러스터에 추가 메모리, CPU 및 스토리지가 필요합니다. 실제 리소스 요구 사항은 단일 마이그레이션 계획에서 마이그레이션되는 Kubernetes 리소스 수에 따라 다릅니다. 리소스 요구 사항을 추정하려면 비 프로덕션 환경에서 마이그레이션을 테스트해야 합니다.

-

❏

fio는 클러스터의 etcd 디스크 성능을 확인하는 데 사용되었습니다.

6.2. 소스 클러스터 체크리스트

❏ 다음 명령을 실행하여 종료 중 상태에서 비정상적으로 설정된 PV(영구 볼륨)가 있는지 확인했습니다.

$ oc get pv

❏ 다음 명령을 실행하여 실행 중 또는 완료 이외의 상태인 Pod를 확인했습니다.

$ oc get pods --all-namespaces | egrep -v 'Running | Completed'

❏ 다음 명령을 실행하여 재시작 횟수가 높은 Pod를 확인했습니다.

$ oc get pods --all-namespaces --field-selector=status.phase=Running \ -o json | jq '.items[]|select(any( .status.containerStatuses[]; \ .restartCount > 3))|.metadata.name'

Pod가 실행 중 상태인 경우에도 재시작 횟수가 많으면 기본적인 문제가 될 수 있습니다.

- ❏ 클러스터 인증서는 마이그레이션 프로세스 기간 동안 유효합니다.

❏ 다음 명령을 실행하여 보류 중인 인증서 서명 요청이 있는지 확인했습니다.

$ oc get csr -A | grep pending -i

- 레지스트리는 권장 스토리지 유형을 사용합니다.

- ❏ 레지스트리에 이미지를 읽고 쓸 수 있습니다.

- ❏ etcd 클러스터는 정상입니다.

- 소스 클러스터의 평균 API 서버 응답 시간은 50ms 미만입니다.

6.3. 대상 클러스터 체크리스트

- ❏ 클러스터에 올바른 네트워크 구성과 외부 서비스(예: 데이터베이스, 소스 코드 저장소, 컨테이너 미러 레지스트리, CI/CD 툴)에 액세스할 수 있는 권한이 있습니다.

- ❏ 클러스터에서 제공하는 서비스를 사용하는 외부 애플리케이션과 서비스에는 클러스터에 액세스할 수 있는 올바른 네트워크 구성 및 권한이 있습니다.

- ❏ 내부 컨테이너 이미지에 필요한 종속성을 충족합니다.

- ❏ 대상 클러스터와 복제 리포지토리에 충분한 스토리지 공간이 있습니다.

7장. 네트워크 고려 사항

마이그레이션 후 애플리케이션 네트워크 트래픽을 리디렉션하는 전략을 검토합니다.

7.1. DNS 고려 사항

대상 클러스터의 DNS 도메인은 소스 클러스터의 도메인과 다릅니다. 기본적으로 애플리케이션은 마이그레이션 후 대상 클러스터의 FQDN을 가져옵니다.

마이그레이션된 애플리케이션의 소스 DNS 도메인을 보존하려면 아래에 설명된 두 옵션 중 하나를 선택합니다.

7.1.1. 클라이언트에서 대상 클러스터의 DNS 도메인 격리

소스 클러스터의 DNS 도메인으로 전송된 클라이언트의 요청이 대상 클러스터를 클라이언트에 노출하지 않고 대상 클러스터의 DNS 도메인에 도달할 수 있도록 허용할 수 있습니다.

프로세스

- 클라이언트와 대상 클러스터 간에 애플리케이션 로드 밸런서 또는 역방향 프록시와 같은 기타 네트워크 구성 요소를 배치합니다.

- DNS 서버의 소스 클러스터에서 애플리케이션 FQDN을 업데이트하여 가상 네트워크 구성 요소의 IP 주소를 반환합니다.

- 소스 도메인의 애플리케이션에 대해 수신된 요청을 대상 클러스터 도메인의 로드 밸런서에 보내도록 네트워크 구성 요소를 구성합니다.

-

소스 클러스터의 로드 밸런서의 IP 주소를 가리키는

*.apps.source.example.com도메인에 대한 와일드카드 DNS 레코드를 만듭니다. - 대상 클러스터 앞의 브릿지 네트워크 구성 요소의 IP 주소를 가리키는 각 애플리케이션에 대한 DNS 레코드를 만듭니다. 특정 DNS 레코드는 와일드카드 레코드보다 우선 순위가 높으므로 애플리케이션 FQDN이 확인되면 충돌이 발생하지 않습니다.

- 기존의 네트워크 구성 요소는 모든 보안 TLS 연결을 종료해야 합니다. 연결이 대상 클러스터 로드 밸런서 장치로 전달되면 대상 애플리케이션의 FQDN이 클라이언트에 노출되고 인증서 오류가 발생합니다.

- 애플리케이션은 대상 클러스터 도메인을 클라이언트에 참조하는 링크를 반환해서는 안 됩니다. 그렇지 않으면 애플리케이션 일부가 제대로 로드되거나 작동하지 않을 수 있습니다.

7.1.2. 소스 DNS 도메인을 허용하도록 대상 클러스터 설정

소스 클러스터의 DNS 도메인에서 마이그레이션된 애플리케이션에 대한 요청을 수락하도록 대상 클러스터를 설정할 수 있습니다.

프로세스

비보안 HTTP 액세스 및 보안 HTTPS 액세스 모두에서 다음 단계를 수행합니다.

소스 클러스터에서 애플리케이션의 FQDN으로 주소가 지정된 요청을 수락하도록 구성된 대상 클러스터의 프로젝트에서 경로를 생성합니다.

$ oc expose svc <app1-svc> --hostname <app1.apps.source.example.com> \ -n <app1-namespace>