엣지 컴퓨팅

네트워크 엣지에서 OpenShift Container Platform 클러스터 구성 및 배포

초록

1장. 네트워크 맨 위 엣지의 과제

엣지 컴퓨팅은 지리적으로 대체된 위치에서 많은 사이트를 관리할 때 복잡한 문제를 안고 있습니다. ZTP( GitOps Zero Touch Provisioning)를 사용하여 네트워크의 맨 위에 있는 사이트를 프로비저닝하고 관리합니다.

1.1. 네트워크의 문제를 해결하여 엣지

현재 서비스 제공업체는 네트워크의 에지에 인프라를 배포하려고 합니다. 이는 상당한 과제를 안고 있습니다:

- 여러 에지 사이트의 배포를 병렬로 어떻게 처리합니까?

- 연결이 끊긴 환경에서 사이트를 배포해야 하는 경우 어떻게 됩니까?

- 대규모 클러스터의 라이프사이클을 어떻게 관리합니까?

GitOps ZTP(ZTP) 및 GitOps 는 베어 메탈 장비에 대한 선언적 사이트 정의 및 구성으로 대규모로 원격 에지 사이트를 프로비저닝할 수 있으므로 이러한 문제를 해결합니다. 템플릿 또는 오버레이 구성은 CNF 워크로드에 필요한 OpenShift Container Platform 기능을 설치합니다. 설치 및 업그레이드의 전체 라이프사이클은 GitOps ZTP 파이프라인을 통해 처리됩니다.

GitOps ZTP는 인프라 배포에 GitOps를 사용합니다. GitOps에서는 선언적 YAML 파일 및 Git 리포지토리에 저장된 기타 정의된 패턴을 사용합니다. RHACM(Red Hat Advanced Cluster Management)은 Git 리포지토리를 사용하여 인프라 배포를 지원합니다.

GitOps는 추적성, 역할 기반 액세스 제어(RBAC) 및 각 사이트의 원하는 상태에 대해 단일 정보 소스를 제공합니다. 확장성 문제는 Webhook를 통해 Git 방법론 및 이벤트 중심 작업을 통해 해결됩니다.

GitOps ZTP 파이프라인이 에지 노드에 제공하는 선언적 사이트 정의 및 구성 CR(사용자 정의 리소스)을 생성하여 GitOps ZTP 워크플로를 시작합니다.

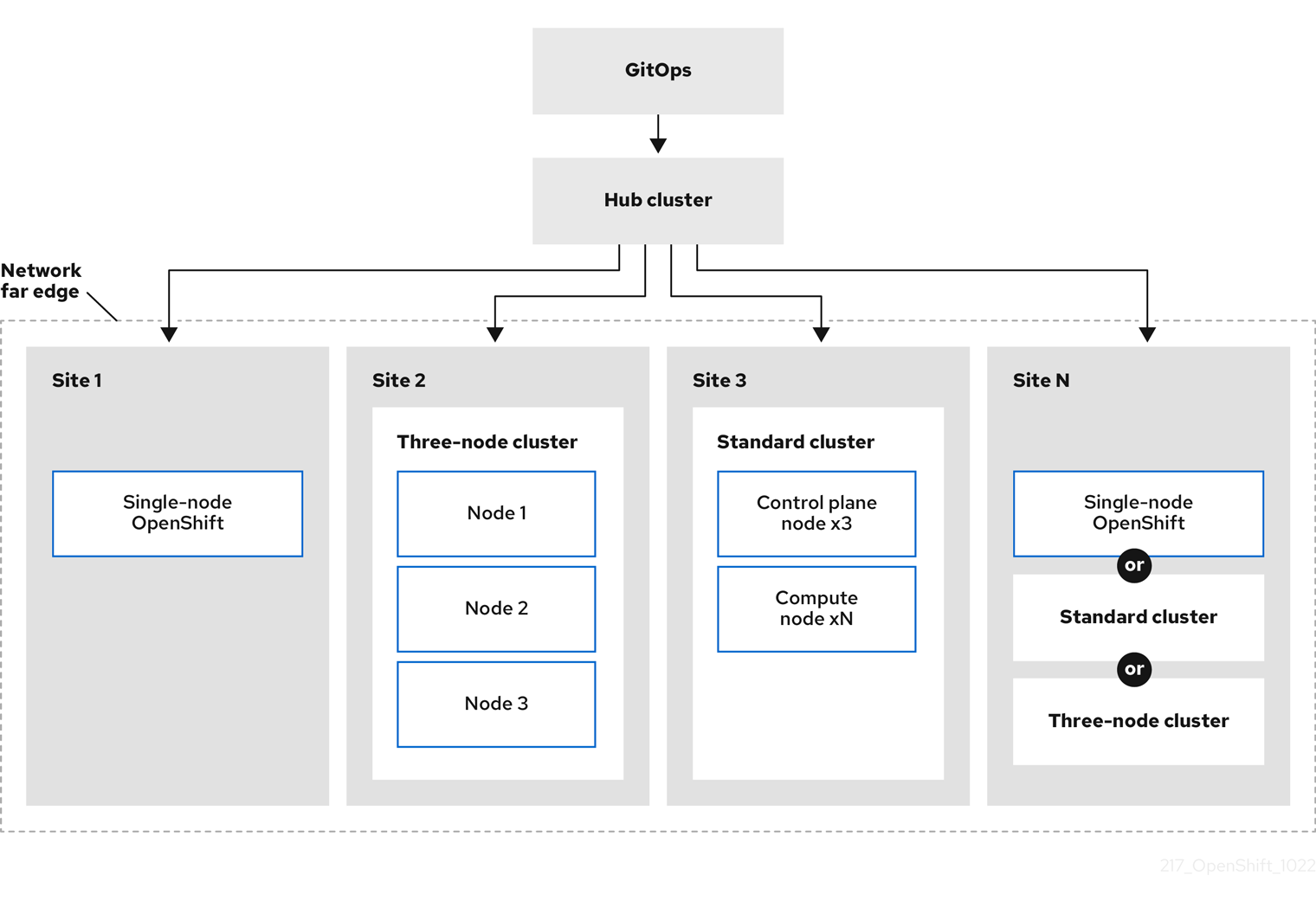

다음 다이어그램은 GitOps ZTP가 far edge 프레임워크 내에서 작동하는 방법을 보여줍니다.

1.2. GitOps ZTP를 사용하여 네트워크 엣지에서 클러스터를 프로비저닝

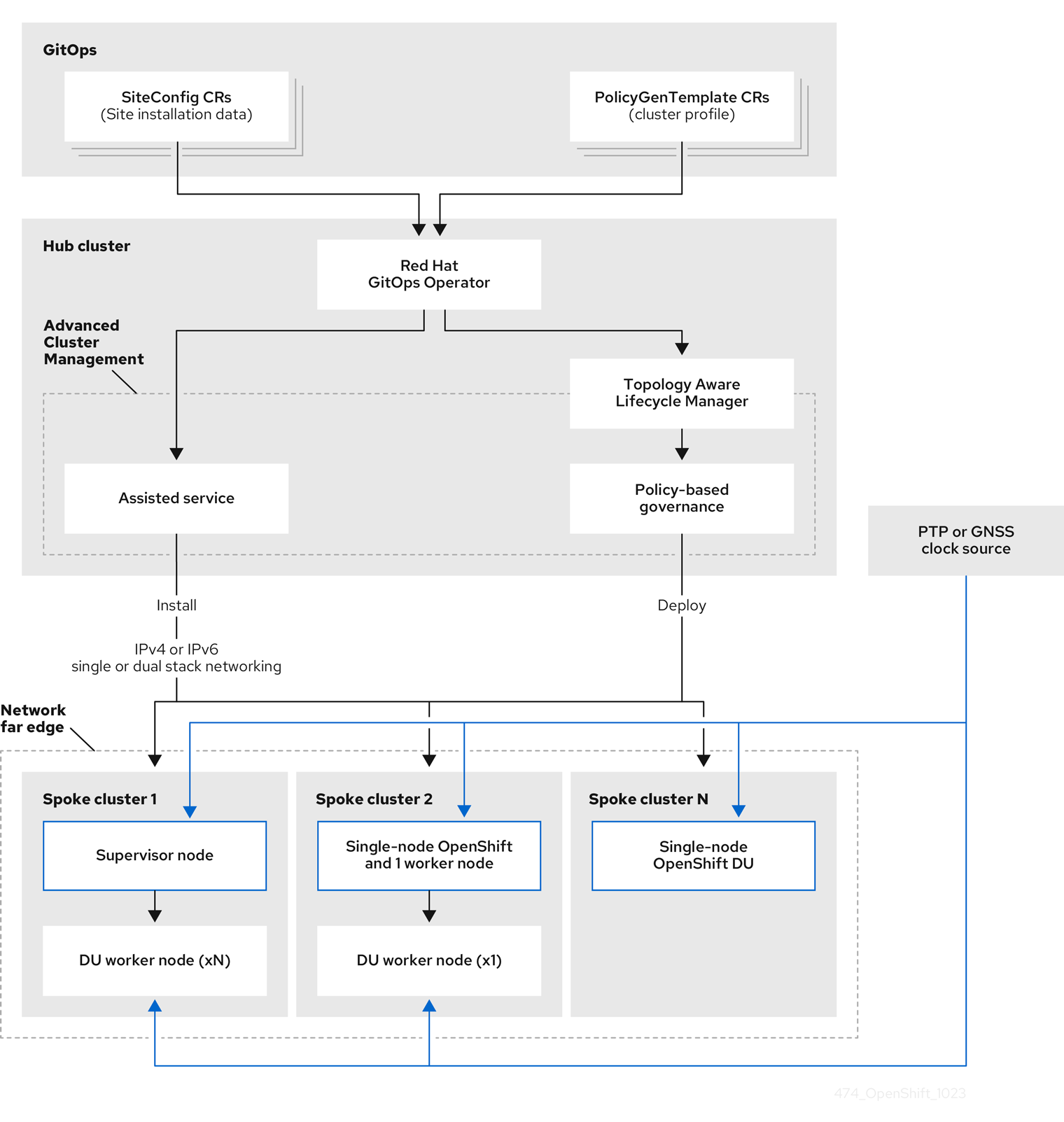

RHACM(Red Hat Advanced Cluster Management)은 단일 허브 클러스터가 많은 spoke 클러스터를 관리하는 hub-and-spoke 아키텍처의 클러스터를 관리합니다. RHACM을 실행하는 Hub 클러스터는 GitOps ZTP(ZTP) 및 RHACM을 설치할 때 배포되는 지원 서비스를 사용하여 관리 클러스터를 프로비저닝하고 배포합니다.

지원 서비스는 단일 노드 클러스터, 3-노드 클러스터 또는 베어 메탈에서 실행되는 표준 클러스터에서 OpenShift Container Platform의 프로비저닝을 처리합니다.

OpenShift Container Platform으로 베어 메탈 호스트를 프로비저닝하고 유지 관리하기 위해 GitOps ZTP를 사용하는 방법에 대한 개괄적인 개요는 다음과 같습니다.

- RHACM을 실행하는 허브 클러스터는 OpenShift Container Platform 릴리스 이미지를 미러링하는 OpenShift 이미지 레지스트리를 관리합니다. RHACM은 OpenShift 이미지 레지스트리를 사용하여 관리 클러스터를 프로비저닝합니다.

- Git 리포지토리에 버전이 지정된 YAML 형식 인벤토리 파일에서 베어 메탈 호스트를 관리합니다.

- 호스트를 관리 클러스터로 프로비저닝할 준비를 하고 RHACM 및 지원 서비스를 사용하여 사이트에 베어 메탈 호스트를 설치합니다.

클러스터 설치 및 배포는 초기 설치 단계와 후속 구성 및 배포 단계가 포함된 2단계 프로세스입니다. 다음 다이어그램에서는 이 워크플로를 보여줍니다.

1.3. SiteConfig 리소스 및 RHACM을 사용하여 관리형 클러스터 설치

GitOps ZTP(ZTP)는 Git 리포지토리에서 site Config CR(사용자 정의 리소스)을 사용하여 OpenShift Container Platform 클러스터를 설치하는 프로세스를 관리합니다. SiteConfig CR에는 설치에 필요한 클러스터별 매개변수가 포함되어 있습니다. 사용자 정의 추가 매니페스트를 포함하여 설치 중에 선택한 구성 CR을 적용하는 옵션이 있습니다.

GitOps ZTP 플러그인은 siteConfig CR을 처리하여 허브 클러스터에서 CR 컬렉션을 생성합니다. 이렇게 하면 RHACM(Red Hat Advanced Cluster Management)에서 지원 서비스가 트리거되어 베어 메탈 호스트에 OpenShift Container Platform을 설치합니다. hub 클러스터에서 이러한 CR에서 설치 상태 및 오류 메시지를 찾을 수 있습니다.

단일 클러스터를 수동으로 프로비저닝하거나 GitOps ZTP를 사용하여 배치에서 프로비저닝할 수 있습니다.

- 단일 클러스터 프로비저닝

-

클러스터의 단일

SiteConfigCR 및 관련 설치 및 구성 CR을 생성하고 Hub 클러스터에 적용하여 클러스터 프로비저닝을 시작합니다. 이는 대규모에 배포하기 전에 CR을 테스트하는 좋은 방법입니다. - 여러 클러스터 프로비저닝

-

Git 리포지토리에서 site

Config 및 관련 CR을 정의하여 최대400개의 배치에 관리형 클러스터를 설치합니다. ArgoCD는 siteConfigCR을 사용하여 사이트를 배포합니다. RHACM 정책 생성기는 매니페스트를 생성하여 Hub 클러스터에 적용합니다. 그러면 클러스터 프로비저닝 프로세스가 시작됩니다.

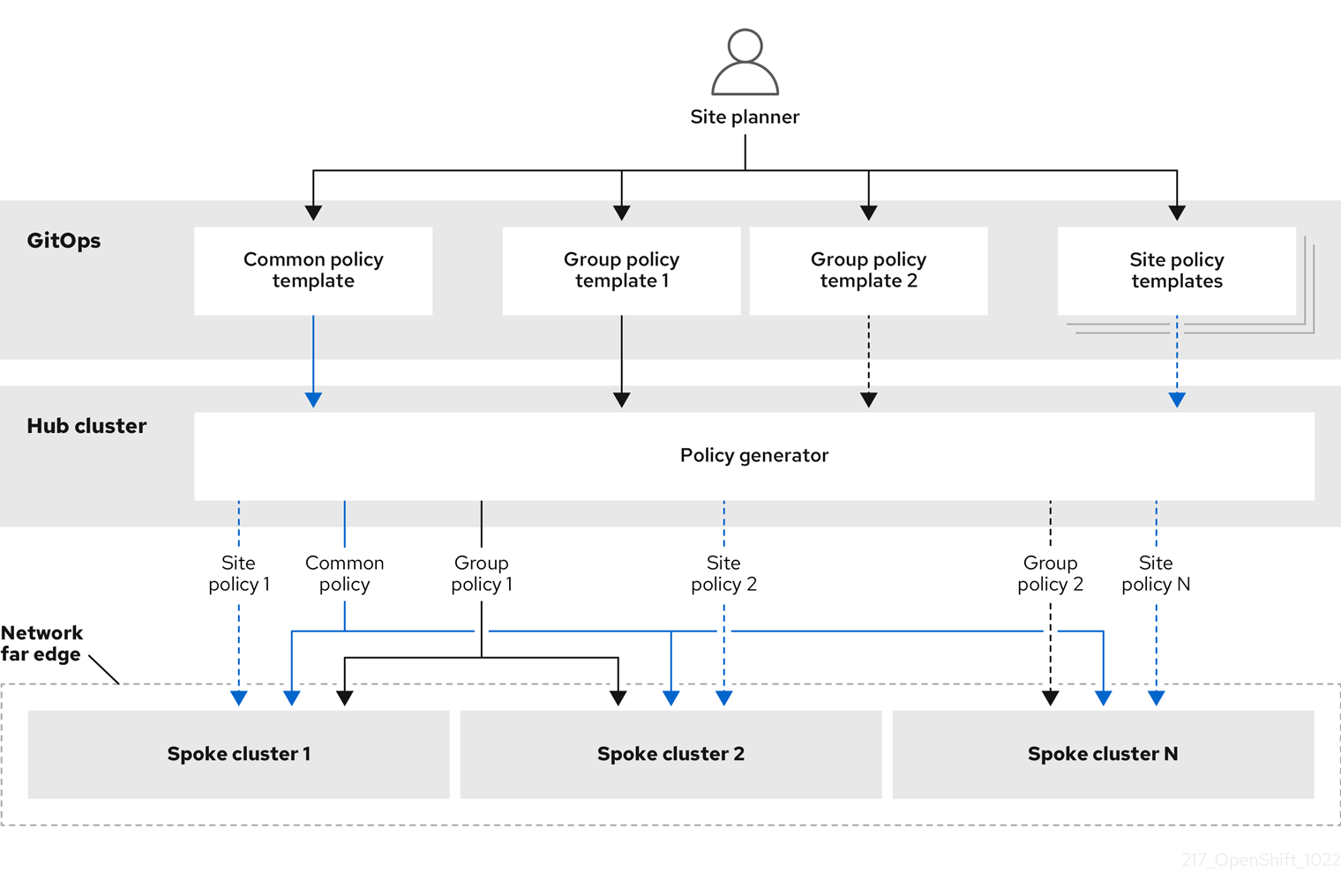

1.4. 정책 및 PolicyGenTemplate 리소스를 사용하여 관리형 클러스터 구성

GitOps ZTP(Red Hat Advanced Cluster Management)는 정책 기반 거버넌스 접근 방식을 사용하여 구성을 적용하여 클러스터를 구성합니다.

정책 생성기 또는 PolicyGen 은 GitOps Operator의 플러그인으로, 간결한 템플릿에서 RHACM 정책을 생성할 수 있습니다. 이 툴은 여러 CR을 단일 정책으로 결합할 수 있으며, 플릿의 다양한 클러스터 하위 집합에 적용되는 여러 정책을 생성할 수 있습니다.

확장성을 유지하고 클러스터 전체에서 구성 관리의 복잡성을 줄이려면 가능한 한 많은 공통성을 갖춘 구성 CR을 사용하십시오.

- 가능한 경우 플릿 전체 공통 정책을 사용하여 구성 CR을 적용합니다.

- 다음 기본 설정은 그룹 정책에서 최대한 많은 나머지 구성을 관리할 클러스터의 논리 그룹을 생성하는 것입니다.

- 구성이 개별 사이트에 고유한 경우 허브 클러스터에서 RHACM 템플릿 작성을 사용하여 사이트별 데이터를 공통 또는 그룹 정책에 삽입합니다. 또는 사이트에 대한 개별 사이트 정책을 적용합니다.

다음 다이어그램은 클러스터 배포 구성 단계에서 정책 생성기가 GitOps 및 RHACM과 상호 작용하는 방법을 보여줍니다.

대규모 클러스터의 경우 해당 클러스터 구성에 높은 수준의 일관성이 있는 것이 일반적입니다.

다음과 같은 권장 정책 구조에서는 구성 CR을 결합하여 몇 가지 목표를 달성할 수 있습니다.

- 일반적인 구성을 한 번 설명하고 플릿에 적용됩니다.

- 유지 관리 및 관리되는 정책의 수를 최소화합니다.

- 클러스터 변형에 대한 일반적인 구성에서 유연성을 지원합니다.

표 1.1. 권장되는 PolicyGenTemplate 정책 범주

| 정책 카테고리 | 설명 |

|---|---|

| 공통 |

공통 카테고리에 존재하는 정책은 플릿의 모든 클러스터에 적용됩니다. 공통 |

| 그룹 |

그룹 카테고리에 존재하는 정책은 플릿의 클러스터 그룹에 적용됩니다. 그룹 |

| 사이트 | 사이트 카테고리에 존재하는 정책은 특정 클러스터 사이트에 적용됩니다. 모든 클러스터는 고유한 정책을 유지 관리할 수 있습니다. |

추가 리소스

-

ztp-site-generate컨테이너 이미지에서 siteConfig및PolicyGenTemplateCR을 추출하는 방법에 대한 자세한 내용은 ZTP Git 리포지토리 준비를 참조하십시오.

2장. ZTP용 허브 클러스터 준비

연결이 끊긴 환경에서 RHACM을 사용하려면 필요한 Operator 이미지가 포함된 OpenShift Container Platform 릴리스 이미지 및 OLM(Operator Lifecycle Manager) 카탈로그를 미러링하는 미러 레지스트리를 생성합니다. OLM은 Operator 및 클러스터의 종속 항목을 관리, 설치 및 업그레이드합니다. 연결이 끊긴 미러 호스트를 사용하여 베어 메탈 호스트를 프로비저닝하는 데 사용되는 RHCOS ISO 및 RootFS 디스크 이미지를 제공할 수도 있습니다.

2.1. Telco RAN DU 4.15 검증 소프트웨어 구성 요소

Red Hat telco RAN DU 4.15 솔루션은 OpenShift Container Platform 관리 클러스터 및 허브 클러스터에 대해 다음과 같은 Red Hat 소프트웨어 제품을 사용하여 검증되었습니다.

표 2.1. Telco RAN DU 관리 클러스터 검증 소프트웨어 구성 요소

| Component | 소프트웨어 버전 |

|---|---|

| 관리형 클러스터 버전 | 4.15 |

| Cluster Logging Operator | 5.8 |

| Local Storage Operator | 4.15 |

| PTP Operator | 4.15 |

| SRIOV Operator | 4.15 |

| Node Tuning Operator | 4.15 |

| Logging Operator | 4.15 |

| SRIOV-FEC Operator | 2.8 |

표 2.2. hub 클러스터 검증 소프트웨어 구성 요소

| Component | 소프트웨어 버전 |

|---|---|

| hub 클러스터 버전 | 4.15 |

| GitOps ZTP 플러그인 | 4.15 |

| Red Hat Advanced Cluster Management(RHACM) | 2.9, 2.10 |

| Red Hat OpenShift GitOps | 1.11 |

| 토폴로지 인식 라이프사이클 관리자(TALM) | 4.15 |

2.2. GitOps ZTP에 대한 권장 허브 클러스터 사양 및 관리 클러스터 제한

GitOps Zero Touch Provisioning (ZTP)을 사용하면 지리적으로 분산된 지역 및 네트워크에서 수천 개의 클러스터를 관리할 수 있습니다. Red Hat Performance 및 Scale 랩은 랩 환경에서 단일 RHACM(Red Hat Advanced Cluster Management) 허브 클러스터에서 DU 프로필이 감소하여 3500개의 가상 단일 노드 OpenShift 클러스터를 성공적으로 생성 및 관리합니다.

실제 상황에서 관리할 수 있는 클러스터 수에 대한 스케일링 제한은 hub 클러스터에 영향을 미치는 다양한 요인에 따라 달라집니다. 예를 들면 다음과 같습니다.

- hub 클러스터 리소스

- 사용 가능한 허브 클러스터 호스트 리소스(CPU, 메모리, 스토리지)는 허브 클러스터가 관리할 수 있는 클러스터 수를 결정하는 데 중요한 요소입니다. 허브 클러스터에 할당될수록 더 많은 관리 클러스터를 수용할 수 있습니다.

- hub 클러스터 스토리지

- 허브 클러스터 호스트 스토리지 IOPS 등급과 허브 클러스터 호스트가 NVMe 스토리지를 사용하는지 여부는 허브 클러스터 성능과 관리할 수 있는 클러스터 수에 영향을 미칠 수 있습니다.

- 네트워크 대역폭 및 대기 시간

- 허브 클러스터와 관리 클러스터 간의 대기 시간이 느리거나 대기 시간이 긴 네트워크 연결은 허브 클러스터가 여러 클러스터를 관리하는 방법에 영향을 미칠 수 있습니다.

- 관리형 클러스터 크기 및 복잡성

- 관리 클러스터의 크기와 복잡성은 허브 클러스터의 용량에도 영향을 미칩니다. 더 많은 노드, 네임스페이스 및 리소스가 있는 대규모 관리 클러스터에는 추가 처리 및 관리 리소스가 필요합니다. 마찬가지로 RAN DU 프로필 또는 다양한 워크로드와 같은 복잡한 구성이 있는 클러스터에는 허브 클러스터의 더 많은 리소스가 필요할 수 있습니다.

- 관리 정책 수

- 해당 정책에 바인딩된 관리 클러스터 수를 통해 확장되는 허브 클러스터에서 관리하는 정책 수는 관리할 수 있는 클러스터 수를 결정하는 중요한 요소입니다.

- 모니터링 및 관리 워크로드

- RHACM은 관리 클러스터를 지속적으로 모니터링하고 관리합니다. 허브 클러스터에서 실행되는 모니터링 및 관리 워크로드의 수와 복잡성은 용량에 영향을 미칠 수 있습니다. 집중적인 모니터링 또는 빈번한 조정 작업에는 추가 리소스가 필요할 수 있으므로 관리 가능한 클러스터 수를 제한할 수 있습니다.

- RHACM 버전 및 구성

- RHACM의 다른 버전에는 다양한 성능 특성과 리소스 요구 사항이 있을 수 있습니다. 또한 동시 조정 수 또는 상태 점검 빈도와 같은 RHACM의 구성 설정은 허브 클러스터의 관리 클러스터 용량에 영향을 미칠 수 있습니다.

다음 대표 구성 및 네트워크 사양을 사용하여 자체 Hub 클러스터 및 네트워크 사양을 개발합니다.

다음 지침은 내부 랩 벤치마크 테스트만 기반으로 하며 완전한 베어 메탈 호스트 사양을 나타내지 않습니다.

표 2.3. 대표 3노드 허브 클러스터 머신 사양

| 요구 사항 | 설명 |

|---|---|

| OpenShift Container Platform | version 4.13 |

| RHACM | 버전 2.7 |

| 토폴로지 인식 라이프사이클 관리자(TALM) | version 4.13 |

| 서버 하드웨어 | 3개의 x Dell PowerEdge R650 랙 서버 |

| NVMe 하드 디스크 |

|

| SSD 하드 디스크 |

|

| 적용되는 DU 프로파일 정책 수 | 5 |

다음 네트워크 사양은 일반적인 실제 RAN 네트워크를 나타내며 테스트 중에 스케일 랩 환경에 적용되었습니다.

표 2.4. 시뮬레이션된 랩 환경 네트워크 사양

| 사양 | 설명 |

|---|---|

| Round-trip Time (RTT) 대기 시간 | 50 MS |

| 패킷 손실 | 0.02% 패킷 손실 |

| 네트워크 대역폭 제한 | 20Mbps |

2.3. 연결이 끊긴 환경에서 GitOps ZTP 설치

연결이 끊긴 환경의 허브 클러스터에서 RHACM(Red Hat Advanced Cluster Management), Red Hat OpenShift GitOps 및 Topology Aware Lifecycle Manager(TALM)를 사용하여 여러 관리 클러스터의 배포를 관리합니다.

사전 요구 사항

-

OpenShift Container Platform CLI(

oc)를 설치했습니다. -

cluster-admin권한이 있는 사용자로 로그인했습니다. 클러스터에서 사용할 연결이 끊긴 미러 레지스트리가 구성되어 있습니다.

참고생성하는 연결이 끊긴 미러 레지스트리에는 허브 클러스터에서 실행 중인 TALM 버전과 일치하는 TALM 백업 및 사전 캐시 이미지가 포함되어야 합니다. spoke 클러스터는 연결이 끊긴 미러 레지스트리에서 이러한 이미지를 확인할 수 있어야 합니다.

프로세스

- hub 클러스터에 RHACM을 설치합니다. 연결이 끊긴 환경에서 RHACM 설치를 참조하십시오.

- hub 클러스터에 GitOps 및 TALM을 설치합니다.

2.4. 연결이 끊긴 미러 호스트에 RHCOS ISO 및 RootFS 이미지 추가

RHACM(Red Hat Advanced Cluster Management)을 사용하여 연결이 끊긴 환경에 클러스터를 설치하기 전에 먼저 사용할 RHCOS(Red Hat Enterprise Linux CoreOS) 이미지를 호스팅해야 합니다. 연결이 끊긴 미러를 사용하여 RHCOS 이미지를 호스팅합니다.

사전 요구 사항

- 네트워크에서 RHCOS 이미지 리소스를 호스팅하도록 HTTP 서버를 배포하고 구성합니다. 사용자 컴퓨터에서 및 사용자가 생성한 시스템에서 HTTP 서버에 액세스할 수 있어야 합니다.

RHCOS 이미지는 OpenShift Container Platform 릴리스에 따라 변경되지 않을 수 있습니다. 설치하는 버전보다 작거나 같은 최신 버전의 이미지를 다운로드해야 합니다. 사용 가능한 경우 OpenShift Container Platform 버전과 일치하는 이미지 버전을 사용합니다. 호스트에 RHCOS를 설치하려면 ISO 및 RootFS 이미지가 필요합니다. 이 설치 유형에서는 RHCOS QCOW2 이미지가 지원되지 않습니다.

프로세스

- 미러 호스트에 로그인합니다.

mirror.openshift.com 에서 RHCOS ISO 및 RootFS 이미지를 가져옵니다. 예를 들면 다음과 같습니다.

필요한 이미지 이름 및 OpenShift Container Platform 버전을 환경 변수로 내보냅니다.

$ export ISO_IMAGE_NAME=<iso_image_name> 1$ export ROOTFS_IMAGE_NAME=<rootfs_image_name> 1$ export OCP_VERSION=<ocp_version> 1필요한 이미지를 다운로드합니다.

$ sudo wget https://mirror.openshift.com/pub/openshift-v4/dependencies/rhcos/4.15/${OCP_VERSION}/${ISO_IMAGE_NAME} -O /var/www/html/${ISO_IMAGE_NAME}$ sudo wget https://mirror.openshift.com/pub/openshift-v4/dependencies/rhcos/4.15/${OCP_VERSION}/${ROOTFS_IMAGE_NAME} -O /var/www/html/${ROOTFS_IMAGE_NAME}

검증 단계

다음과 같이 이미지가 성공적으로 다운로드되고 연결이 끊긴 미러 호스트에서 제공되고 있는지 확인합니다.

$ wget http://$(hostname)/${ISO_IMAGE_NAME}출력 예

Saving to: rhcos-4.15.1-x86_64-live.x86_64.iso rhcos-4.15.1-x86_64-live.x86_64.iso- 11%[====> ] 10.01M 4.71MB/s

추가 리소스

2.5. 지원 서비스 활성화

RHACM(Red Hat Advanced Cluster Management)은 지원 서비스를 사용하여 OpenShift Container Platform 클러스터를 배포합니다. RHACM(Red Hat Advanced Cluster Management)에서 MultiClusterHub Operator를 활성화하면 Helped 서비스가 자동으로 배포됩니다. 그 후에는 모든 네임스페이스를 감시하고 AgentServiceConfig CR(사용자 정의 리소스)을 미러 레지스트리 HTTP 서버에서 호스팅되는 ISO 및 RootFS 이미지에 대한 참조로 업데이트하도록 Provisioning 리소스를 구성해야 합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다. - MultiClusterHub가 활성화된 RHACM이 있어야 합니다.

프로세스

-

프로비저닝리소스를 활성화하여 모든 네임스페이스를 조사하고 연결이 끊긴 환경에 대한 미러를 구성합니다. 자세한 내용은 중앙 인프라 관리 서비스 활성화를 참조하십시오. 다음 명령을 실행하여

AgentServiceConfigCR을 업데이트합니다.$ oc edit AgentServiceConfig

CR의

items.spec.osImages필드에 다음 항목을 추가합니다.- cpuArchitecture: x86_64 openshiftVersion: "4.15" rootFSUrl: https://<host>/<path>/rhcos-live-rootfs.x86_64.img url: https://<mirror-registry>/<path>/rhcos-live.x86_64.iso다음과 같습니다.

- <host>

- 대상 미러 레지스트리 HTTP 서버의 FQDN(정규화된 도메인 이름)입니다.

- <path>

- 대상 미러 레지스트리의 이미지 경로입니다.

편집기를 저장하고 종료하여 변경 사항을 적용합니다.

2.6. 연결이 끊긴 미러 레지스트리를 사용하도록 허브 클러스터 구성

연결이 끊긴 환경에서 연결이 끊긴 미러 레지스트리를 사용하도록 허브 클러스터를 구성할 수 있습니다.

사전 요구 사항

- RHACM(Red Hat Advanced Cluster Management) 2.9가 설치된 연결이 끊긴 허브 클러스터 설치가 있어야 합니다.

-

HTTP 서버의

rootfs및iso이미지를 호스팅했습니다. OpenShift Container Platform 이미지 리포지토리 미러링에 대한 지침은 추가 리소스 섹션을 참조하십시오.

HTTP 서버에 대해 TLS를 활성화하면 루트 인증서가 클라이언트가 신뢰하는 기관에서 서명했는지 확인하고 OpenShift Container Platform 허브와 관리 클러스터와 HTTP 서버 간의 신뢰할 수 있는 인증서 체인을 확인해야 합니다. 신뢰할 수 없는 인증서로 구성된 서버를 사용하면 이미지가 이미지 생성 서비스로 다운로드되지 않습니다. 신뢰할 수 없는 HTTPS 서버 사용은 지원되지 않습니다.

프로세스

미러 레지스트리 구성이 포함된

ConfigMap을 생성합니다.apiVersion: v1 kind: ConfigMap metadata: name: assisted-installer-mirror-config namespace: multicluster-engine 1 labels: app: assisted-service data: ca-bundle.crt: | 2 -----BEGIN CERTIFICATE----- <certificate_contents> -----END CERTIFICATE----- registries.conf: | 3 unqualified-search-registries = ["registry.access.redhat.com", "docker.io"] [[registry]] prefix = "" location = "quay.io/example-repository" 4 mirror-by-digest-only = true [[registry.mirror]] location = "mirror1.registry.corp.com:5000/example-repository" 5

- 1

ConfigMap네임스페이스는multicluster-engine으로 설정해야 합니다.- 2

- 미러 레지스트리를 생성할 때 사용되는 미러 레지스트리의 인증서입니다.

- 3

- 미러 레지스트리의 구성 파일입니다. 미러 레지스트리 구성은 검색 이미지의

/etc/containers/registries.conf파일에 미러 정보를 추가합니다. 미러 정보는 정보가 설치 프로그램에 전달될 때install-config.yaml파일의imageContentSources섹션에 저장됩니다. hub 클러스터에서 실행되는 지원 서비스 Pod는 구성된 미러 레지스트리에서 컨테이너 이미지를 가져옵니다. - 4

- 미러 레지스트리의 URL입니다. 미러 레지스트리를 구성할 때

oc adm release mirror명령을 실행하여imageContentSources섹션의 URL을 사용해야 합니다. 자세한 내용은 OpenShift Container Platform 이미지 저장소 미러링 섹션을 참조하십시오. - 5

registries.conf파일에 정의된 레지스트리는 레지스트리가 아닌 리포지터리로 범위를 지정해야 합니다. 이 예에서quay.io/example-repository및mirror1.registry.corp.com:5000/example-repository리포지토리의 범위는example-repository리포지토리로 지정됩니다.

이 업데이트는 다음과 같이

AgentServiceConfig사용자 정의 리소스에서mirrorRegistryRef를 업데이트합니다.출력 예

apiVersion: agent-install.openshift.io/v1beta1 kind: AgentServiceConfig metadata: name: agent namespace: multicluster-engine 1 spec: databaseStorage: volumeName: <db_pv_name> accessModes: - ReadWriteOnce resources: requests: storage: <db_storage_size> filesystemStorage: volumeName: <fs_pv_name> accessModes: - ReadWriteOnce resources: requests: storage: <fs_storage_size> mirrorRegistryRef: name: assisted-installer-mirror-config 2 osImages: - openshiftVersion: <ocp_version> url: <iso_url> 3

클러스터 설치 중에 유효한 NTP 서버가 필요합니다. 적절한 NTP 서버를 사용할 수 있고 연결이 끊긴 네트워크를 통해 설치된 클러스터에서 연결할 수 있는지 확인합니다.

2.7. 인증되지 않은 레지스트리를 사용하도록 허브 클러스터 구성

인증되지 않은 레지스트리를 사용하도록 허브 클러스터를 구성할 수 있습니다. 인증되지 않은 레지스트리는 이미지에 액세스하고 다운로드하는 데 인증이 필요하지 않습니다.

사전 요구 사항

- hub 클러스터를 설치 및 구성하고 hub 클러스터에 Red Hat Advanced Cluster Management(RHACM)를 설치 및 구성했습니다.

- OpenShift Container Platform CLI(oc)가 설치되어 있습니다.

-

cluster-admin권한이 있는 사용자로 로그인했습니다. - hub 클러스터에서 사용할 인증되지 않은 레지스트리를 구성했습니다.

프로세스

다음 명령을 실행하여

AgentServiceConfigCR(사용자 정의 리소스)을 업데이트합니다.$ oc edit AgentServiceConfig agent

CR에

unauthenticatedRegistries필드를 추가합니다.apiVersion: agent-install.openshift.io/v1beta1 kind: AgentServiceConfig metadata: name: agent spec: unauthenticatedRegistries: - example.registry.com - example.registry2.com ...

인증되지 않은 레지스트리는

AgentServiceConfig리소스의spec.unauthenticatedRegistries에 나열됩니다. 이 목록의 레지스트리에는 spoke 클러스터 설치에 사용되는 풀 시크릿에 항목이 필요하지 않습니다.assisted-service는 설치에 사용되는 모든 이미지 레지스트리에 대한 인증 정보가 포함되어 있는지 확인하여 풀 시크릿을 검증합니다.

미러 레지스트리는 무시 목록에 자동으로 추가되며 spec.unauthenticatedRegistries 아래에 추가할 필요가 없습니다. ConfigMap 에서 PUBLIC_CONTAINER_REGISTRIES 환경 변수를 지정하면 지정된 값이 있는 기본값이 재정의됩니다. PUBLIC_CONTAINER_REGISTRIES 기본값은 quay.io 및 registry.svc.ci.openshift.org 입니다.

검증

다음 명령을 실행하여 hub 클러스터에서 새로 추가된 레지스트리에 액세스할 수 있는지 확인합니다.

hub 클러스터에 대한 디버그 쉘 프롬프트를 엽니다.

$ oc debug node/<node_name>

다음 명령을 실행하여 인증되지 않은 레지스트리에 대한 액세스를 테스트합니다.

sh-4.4# podman login -u kubeadmin -p $(oc whoami -t) <unauthenticated_registry>

다음과 같습니다.

- <unauthenticated_registry>

-

새 레지스트리입니다(예:

unauthenticated-image-registry.openshift-image-registry.svc:5000).

출력 예

Login Succeeded!

2.8. ArgoCD를 사용하여 허브 클러스터 구성

ZTP(ZTP)를 사용하여 각 사이트에 필요한 설치 및 정책 CR(사용자 정의 리소스)을 생성하는 ArgoCD 애플리케이션 세트를 사용하여 허브 클러스터를 구성할 수 있습니다.

RHACM(Red Hat Advanced Cluster Management)은 site Config CR을 사용하여 ArgoCD의 Day 1 관리형 클러스터 설치 CR을 생성합니다. 각 ArgoCD 애플리케이션은 최대 300개의 site Config CR을 관리할 수 있습니다.

사전 요구 사항

- RHACM(Red Hat Advanced Cluster Management) 및 Red Hat OpenShift GitOps가 설치된 OpenShift Container Platform 허브 클러스터가 있어야 합니다.

-

" GitOps ZTP 사이트 구성 리포지토리 준비" 섹션에 설명된 대로 GitOps ZTP 플러그인 컨테이너에서 참조 배포를 추출했습니다. 참조 배포를 추출하면 다음 절차에서 참조되는

out/argocd/deployment디렉터리가 생성됩니다.

프로세스

ArgoCD 파이프라인 구성을 준비합니다.

- 예제 디렉터리와 유사한 디렉터리 구조를 사용하여 Git 리포지토리를 생성합니다. 자세한 내용은 " GitOps ZTP 사이트 구성 리포지토리 준비"를 참조하십시오.

ArgoCD UI를 사용하여 리포지토리에 대한 액세스를 구성합니다. 설정에서 다음을 구성합니다.

-

리포지토리 - 연결 정보를 추가합니다. URL은

.git로 끝나야 합니다(예:https://repo.example.com/repo.git및 인증 정보). - certificates - 필요한 경우 리포지토리의 공용 인증서를 추가합니다.

-

리포지토리 - 연결 정보를 추가합니다. URL은

Git 리포지토리에 따라 2개의 ArgoCD 애플리케이션(

out/argocd/deployment/clusters-app.yaml및out/argocd/deployment/policies-app.yaml)을 수정합니다.-

Git 리포지토리를 가리키도록 URL을 업데이트합니다. URL은

.git로 끝납니다(예:https://repo.example.com/repo.git). -

targetRevision은 모니터링할 Git 리포지토리 분기를 나타냅니다. -

path는 각각SiteConfig및PolicyGenTemplateCR의 경로를 지정합니다.

-

Git 리포지토리를 가리키도록 URL을 업데이트합니다. URL은

GitOps ZTP 플러그인을 설치하려면 이전에

out/argocd/deployment/디렉터리에 추출한 패치 파일을 사용하여 hub 클러스터의 ArgoCD 인스턴스를 패치합니다. 다음 명령을 실행합니다.$ oc patch argocd openshift-gitops \ -n openshift-gitops --type=merge \ --patch-file out/argocd/deployment/argocd-openshift-gitops-patch.json

RHACM 2.7 이상에서는 다중 클러스터 엔진에서 기본적으로

cluster-proxy-addon기능을 활성화합니다. 다음 패치를 적용하여cluster-proxy-addon기능을 비활성화하고 이 애드온을 담당하는 관련 허브 클러스터 및 관리 Pod를 제거합니다. 다음 명령을 실행합니다.$ oc patch multiclusterengines.multicluster.openshift.io multiclusterengine --type=merge --patch-file out/argocd/deployment/disable-cluster-proxy-addon.json

다음 명령을 실행하여 허브 클러스터에 파이프라인 구성을 적용합니다.

$ oc apply -k out/argocd/deployment

2.9. GitOps ZTP 사이트 구성 리포지토리 준비

GitOps ZTP(ZTP) 파이프라인을 사용하려면 사이트 구성 데이터를 호스팅하기 위해 Git 리포지토리를 준비해야 합니다.

사전 요구 사항

- 필요한 설치 및 정책 CR(사용자 정의 리소스)을 생성하도록 Hub 클러스터 GitOps 애플리케이션을 구성했습니다.

- GitOps ZTP를 사용하여 관리 클러스터를 배포했습니다.

프로세스

SiteConfig및PolicyGenTemplateCR에 대한 별도의 경로를 사용하여 디렉터리 구조를 생성합니다.참고site

Config및PolicyGenTemplateCR을 별도의 디렉터리에 보관합니다.SiteConfig및PolicyGenTemplate디렉터리에는 둘 다 해당 디렉터리에 파일을 명시적으로 포함하는kustomization.yaml파일이 포함되어야 합니다.다음 명령을 사용하여

ztp-site-generate컨테이너 이미지에서argocd디렉터리를 내보냅니다.$ podman pull registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.15

$ mkdir -p ./out

$ podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.15 extract /home/ztp --tar | tar x -C ./out

out디렉터리에 다음 하위 디렉터리가 포함되어 있는지 확인합니다.-

out/extra-manifest에는SiteConfig에서 추가 매니페스트configMap을 생성하는 데 사용하는 소스 CR 파일이 포함되어 있습니다. -

Out/source-crs에는PolicyGenTemplate이 RHACM(Red Hat Advanced Cluster Management) 정책을 생성하는 데 사용하는 소스 CR 파일이 포함되어 있습니다. -

out/argocd/deployment에는 이 절차의 다음 단계에서 사용할 허브 클러스터에 적용할 패치 및 YAML 파일이 포함되어 있습니다. -

out/argocd/example에는 권장 구성을 나타내는SiteConfig및PolicyGenTemplate파일의 예가 포함되어 있습니다.

-

-

out/source-crs폴더 및 콘텐츠를PolicyGentemplate디렉터리에 복사합니다. out/extra-manifests 디렉터리에는 RAN DU 클러스터에 대한 참조 매니페스트가 포함되어 있습니다.

out/extra-manifests디렉터리를 siteConfig폴더에 복사합니다. 이 디렉터리에는ztp-site-generate컨테이너의 CR만 포함되어야 합니다. 여기에 사용자 제공 CR을 추가하지 마십시오. 사용자 제공 CR을 사용하려면 해당 콘텐츠에 대한 다른 디렉터리를 생성해야 합니다. 예를 들면 다음과 같습니다.example/ ├── policygentemplates │ ├── kustomization.yaml │ └── source-crs/ └── siteconfig ├── extra-manifests └── kustomization.yaml-

디렉터리 구조와

kustomization.yaml파일을 커밋하고 Git 리포지토리로 내보냅니다. Git으로의 초기 내보내기에는kustomization.yaml파일이 포함되어야 합니다.

out/argocd/example 아래의 디렉터리 구조를 Git 리포지토리의 구조 및 콘텐츠에 대한 참조로 사용할 수 있습니다. 이러한 구조에는 단일 노드, 3-노드 및 표준 클러스터에 대한 SiteConfig 및 PolicyGenTemplate 참조 CR이 포함됩니다. 사용하지 않는 클러스터 유형에 대한 참조를 제거합니다.

모든 클러스터 유형의 경우 다음을 수행해야 합니다.

-

source-crs하위 디렉터리를policygentemplate디렉터리에 추가합니다. -

extra-manifests디렉터리를siteconfig디렉터리에 추가합니다.

다음 예제에서는 단일 노드 클러스터 네트워크에 대한 CR 세트를 설명합니다.

example/

├── policygentemplates

│ ├── common-ranGen.yaml

│ ├── example-sno-site.yaml

│ ├── group-du-sno-ranGen.yaml

│ ├── group-du-sno-validator-ranGen.yaml

│ ├── kustomization.yaml

│ ├── source-crs/

│ └── ns.yaml

└── siteconfig

├── example-sno.yaml

├── extra-manifests/ 1

├── custom-manifests/ 2

├── KlusterletAddonConfigOverride.yaml

└── kustomization.yaml2.9.1. 버전 독립성을 위한 GitOps ZTP 사이트 구성 리포지토리 준비

GitOps ZTP를 사용하여 다른 버전의 OpenShift Container Platform을 실행하는 관리 클러스터의 소스 CR(사용자 정의 리소스)을 관리할 수 있습니다. 즉, hub 클러스터에서 실행되는 OpenShift Container Platform 버전은 관리 클러스터에서 실행되는 버전과 독립적일 수 있습니다.

프로세스

-

SiteConfig및PolicyGenTemplateCR에 대한 별도의 경로를 사용하여 디렉터리 구조를 생성합니다. PolicyGenTemplate디렉터리 내에서 사용할 각 OpenShift Container Platform 버전에 대한 디렉터리를 생성합니다. 각 버전에 다음 리소스를 생성합니다.-

해당 디렉터리에 파일을 명시적으로 포함하는

kustomization.yaml파일 ztp-site-generate컨테이너의 참조 CR 구성 파일을 포함하는source-crs디렉터리사용자 제공 CR을 사용하려면 이를 위해 별도의 디렉터리를 생성해야 합니다.

-

해당 디렉터리에 파일을 명시적으로 포함하는

/siteconfig디렉터리에서 사용할 각 OpenShift Container Platform 버전의 하위 디렉터리를 생성합니다. 각 버전에 대해 컨테이너에서 복사할 참조 CR을 참조하기 위해 하나 이상의 디렉터리를 생성합니다. 디렉터리 이름 지정 또는 참조 디렉터리 수에는 제한이 없습니다. 사용자 정의 매니페스트를 사용하려면 이를 위해 별도의 디렉터리를 생성해야 합니다.다음 예제에서는 다른 OpenShift Container Platform 버전에 대해 사용자 제공 매니페스트 및 CR을 사용하는 구조를 설명합니다.

├── policygentemplates │ ├── kustomization.yaml 1 │ ├── version_4.13 2 │ │ ├── common-ranGen.yaml │ │ ├── group-du-sno-ranGen.yaml │ │ ├── group-du-sno-validator-ranGen.yaml │ │ ├── helix56-v413.yaml │ │ ├── kustomization.yaml 3 │ │ ├── ns.yaml │ │ └── source-crs/ 4 │ │ └── reference-crs/ 5 │ │ └── custom-crs/ 6 │ └── version_4.14 7 │ ├── common-ranGen.yaml │ ├── group-du-sno-ranGen.yaml │ ├── group-du-sno-validator-ranGen.yaml │ ├── helix56-v414.yaml │ ├── kustomization.yaml 8 │ ├── ns.yaml │ └── source-crs/ 9 │ └── reference-crs/ 10 │ └── custom-crs/ 11 └── siteconfig ├── kustomization.yaml ├── version_4.13 │ ├── helix56-v413.yaml │ ├── kustomization.yaml │ ├── extra-manifest/ 12 │ └── custom-manifest/ 13 └── version_4.14 ├── helix57-v414.yaml ├── kustomization.yaml ├── extra-manifest/ 14 └── custom-manifest/ 15

- 1

- 최상위

kustomizationYAML 파일을 생성합니다. - 2 7

- 사용자 지정

/policygentemplates디렉터리 내에 버전별 디렉터리를 생성합니다. - 3 8

- 각 버전에 대한

kustomization.yaml파일을 생성합니다. - 4 9

ztp-site-generate컨테이너의 참조 CR을 포함하도록 각 버전의source-crs디렉터리를 생성합니다.- 5 10

- ZTP 컨테이너에서 추출된 정책 CR에 대한

reference-crs디렉터리를 생성합니다. - 6 11

- 선택 사항: 사용자 제공 CR에 대한 사용자

정의CR 디렉터리를 생성합니다. - 12 14

- 사용자 지정

/siteconfig디렉터리에 디렉터리를 생성하여ztp-site-generate컨테이너의 추가 매니페스트를 포함합니다. - 13 15

- 사용자 제공 매니페스트를 저장할 폴더를 생성합니다.

참고이전 예에서 사용자 지정

/siteconfig디렉터리의 각 버전 하위 디렉터리에는 컨테이너에서 복사한 참조 매니페스트가 포함된 두 개의 하위 디렉터리가 있으며, 다른 하나는 사용자가 제공하는 사용자 정의 매니페스트를 위한 것입니다. 해당 디렉터리에 할당된 이름은 예입니다. 사용자 제공 CR을 사용하는 경우SiteConfigCR의extraManifests.searchPaths아래에 나열된 마지막 디렉터리는 사용자 제공 CR이 포함된 디렉터리여야 합니다.생성한 디렉터리의 검색 경로를 포함하도록

SiteConfigCR을 편집합니다.extraManifests.searchPaths아래에 나열된 첫 번째 디렉터리는 참조 매니페스트가 포함된 디렉터리여야 합니다. 디렉터리가 나열되는 순서를 고려하십시오. 디렉터리에 이름이 같은 파일이 포함된 경우 최종 디렉터리의 파일이 우선합니다.siteConfig CR의 예

extraManifests: searchPaths: - extra-manifest/ 1 - custom-manifest/ 2최상위

kustomization.yaml파일을 편집하여 활성 상태인 OpenShift Container Platform 버전을 제어합니다. 다음은 최상위 수준의kustomization.yaml파일의 예입니다.resources: - version_4.13 1 #- version_4.14 2

3장. GitOps ZTP 업데이트

hub 클러스터, RHACM(Advanced Cluster Management) 및 관리형 OpenShift Container Platform 클러스터와 독립적으로ZTP(ZTP) 인프라를 업데이트할 수 있습니다.

새 버전이 출시되면 Red Hat OpenShift GitOps Operator를 업데이트할 수 있습니다. GitOps ZTP 플러그인을 업데이트할 때 참조 구성에서 업데이트된 파일을 검토하고 변경 사항이 요구 사항을 충족하는지 확인합니다.

3.1. GitOps ZTP 업데이트 프로세스 개요

이전 버전의 GitOps ZTP 인프라를 실행하는 완전히 작동하는 허브 클러스터에 대해 GitOps ZTP(ZTP)를 업데이트할 수 있습니다. 업데이트 프로세스는 관리 클러스터에 미치는 영향을 방지합니다.

권장 콘텐츠 추가를 포함하여 정책 설정을 변경하면 관리 클러스터에 롤아웃하고 조정되어야 하는 업데이트된 정책이 생성됩니다.

높은 수준에서 GitOps ZTP 인프라를 업데이트하기위한 전략은 다음과 같습니다.

-

기존 클러스터에

ztp-done라벨을 지정합니다. - ArgoCD 애플리케이션을 중지합니다.

- 새 GitOps ZTP 툴을 설치합니다.

- Git 리포지토리에서 필요한 콘텐츠 및 선택적 변경 사항을 업데이트합니다.

- 애플리케이션 구성을 업데이트하고 다시 시작합니다.

3.2. 업그레이드 준비

다음 절차에 따라ZTP(ZTP) 업그레이드를 위한 사이트를 준비합니다.

프로세스

- GitOps ZTP와 함께 사용하도록 Red Hat OpenShift GitOps를 구성하는 데 사용되는 사용자 정의 리소스(CR)가 있는 GitOps ZTP 컨테이너의 최신 버전을 가져옵니다.

다음 명령을 사용하여

argocd/deployment디렉터리를 추출합니다.$ mkdir -p ./update

$ podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.15 extract /home/ztp --tar | tar x -C ./update

/update디렉터리에는 다음 하위 디렉터리가 포함되어 있습니다.-

update/extra-manifest:SiteConfigCR에서 추가 매니페스트configMap을 생성하는 데 사용하는 소스 CR 파일이 포함되어 있습니다. -

update/source-crs:PolicyGenTemplateCR에서 RHACM(Red Hat Advanced Cluster Management) 정책을 생성하는 데 사용하는 소스 CR 파일이 포함되어 있습니다. -

update/argocd/deployment: 이 절차의 다음 단계에서 사용할 허브 클러스터에 적용할 패치 및 YAML 파일이 포함되어 있습니다. -

update/argocd/example: 권장 구성을 나타내는 example siteConfig및PolicyGenTemplate파일이 포함되어 있습니다.

-

애플리케이션 이름과 Git 리포지토리의 URL, 분기 및 경로를 반영하도록 cluster-app.yaml 및

policies-app.yaml파일을 업데이트합니다.업그레이드에 더 이상 사용되지 않는 정책이 생성되는 변경 사항이 포함된 경우 업그레이드를 수행하기 전에 더 이상 사용되지 않는 정책을 제거해야 합니다.

플릿 사이트 CR을 관리하는 /update 폴더 및 Git 리포지터리의 구성 및 배포 소스 CR 간 변경 사항을 diffe the changes between the configuration and deployment source CRs in the

/updatefolder and Git repo where you manage your fleet site CRs. 필요한 변경 사항을 적용하고 사이트 리포지토리에 내보냅니다.중요GitOps ZTP를 최신 버전으로 업데이트할 때

update/argocd/deployment디렉터리의 변경 사항을 사이트 리포지토리에 적용해야 합니다. 이전 버전의argocd/deployment/파일을 사용하지 마십시오.

3.3. 기존 클러스터에 레이블 지정

툴 업데이트로 기존 클러스터가 그대로 유지되도록 기존 관리 클러스터에 ztp-done 라벨을 지정합니다.

이 절차는 Topology Aware Lifecycle Manager (TALM)를 사용하여 프로비저닝되지 않은 클러스터를 업데이트하는 경우에만 적용됩니다. TALM으로 프로비저닝하는 클러스터는 자동으로 ztp-done 로 레이블이 지정됩니다.

프로세스

local-cluster!=true와 같이 GitOps ZTP(ZTP)와 함께 배포된 관리 클러스터를 나열하는 라벨 선택기를 찾습니다.$ oc get managedcluster -l 'local-cluster!=true'

결과 목록에 GitOps ZTP와 함께 배포된 모든 관리 클러스터가 포함되어 있는지 확인한 다음 해당 선택기를 사용하여

ztp-done레이블을 추가합니다.$ oc label managedcluster -l 'local-cluster!=true' ztp-done=

3.4. 기존 GitOps ZTP 애플리케이션 중지

기존 애플리케이션을 제거하면 새 버전의 툴을 사용할 수 있을 때까지 Git 리포지토리의 기존 콘텐츠에 대한 변경 사항이 롤아웃되지 않습니다.

배포 디렉터리의 애플리케이션 파일을 사용합니다. 애플리케이션에 사용자 지정 이름을 사용한 경우 먼저 이러한 파일의 이름을 업데이트합니다.

프로세스

클러스터애플리케이션에서 캐스케이딩되지 않은 삭제를 수행하여 생성된 모든 리소스를 제자리에 남겨 둡니다.$ oc delete -f update/argocd/deployment/clusters-app.yaml

정책 애플리케이션에서 계단식 삭제를 수행하여 이전 정책을모두 제거합니다.$ oc patch -f policies-app.yaml -p '{"metadata": {"finalizers": ["resources-finalizer.argocd.argoproj.io"]}}' --type merge$ oc delete -f update/argocd/deployment/policies-app.yaml

3.5. Git 리포지토리에 대한 필수 변경 사항

ztp-site-generate 컨테이너를 이전 버전의 ZTP(ZTP)에서 4.10 이상으로 업그레이드하는 경우 Git 리포지토리의 콘텐츠에 대한 추가 요구 사항이 있습니다. 리포지토리의 기존 콘텐츠는 이러한 변경 사항을 반영하도록 업데이트해야 합니다.

PolicyGenTemplate파일을 변경해야 합니다.모든

PolicyGenTemplate파일은ztp로 접두사가 지정된 네임스페이스에서 생성해야 합니다. 이렇게 하면 GitOps ZTP 애플리케이션이 RHSM(Red Hat Advanced Cluster Management)에서 내부적으로 정책을 관리하는 방식과 충돌하지 않고 GitOps ZTP에서 생성한 정책 CR을 관리할 수 있습니다.kustomization.yaml파일을 리포지토리에 추가합니다.모든

siteConfig및PolicyGenTemplateCR은 해당 디렉터리 트리 아래에kustomization.yaml파일에 포함되어야 합니다. 예를 들면 다음과 같습니다.├── policygentemplates │ ├── site1-ns.yaml │ ├── site1.yaml │ ├── site2-ns.yaml │ ├── site2.yaml │ ├── common-ns.yaml │ ├── common-ranGen.yaml │ ├── group-du-sno-ranGen-ns.yaml │ ├── group-du-sno-ranGen.yaml │ └── kustomization.yaml └── siteconfig ├── site1.yaml ├── site2.yaml └── kustomization.yaml참고생성기섹션에 나열된 파일에는 siteConfig또는PolicyGenTemplateCR만 포함되어야 합니다. 기존 YAML 파일에 다른 CR(예:네임스페이스)이 포함된 경우 이러한 다른 CR을 별도의 파일로 가져와resources섹션에 나열해야 합니다.PolicyGenTemplatekustomization 파일에는resources섹션의generator섹션에 있는 모든PolicyGenTemplateYAML 파일과NamespaceCR이 포함되어야 합니다. 예를 들면 다음과 같습니다.apiVersion: kustomize.config.k8s.io/v1beta1 kind: Kustomization generators: - common-ranGen.yaml - group-du-sno-ranGen.yaml - site1.yaml - site2.yaml resources: - common-ns.yaml - group-du-sno-ranGen-ns.yaml - site1-ns.yaml - site2-ns.yaml

SiteConfigkustomization 파일에는생성기섹션의 모든SiteConfigYAML 파일과 리소스의 다른 CR이 포함되어야 합니다.apiVersion: kustomize.config.k8s.io/v1beta1 kind: Kustomization generators: - site1.yaml - site2.yaml

pre-sync.yaml및post-sync.yaml파일을 제거합니다.OpenShift Container Platform 4.10 이상에서는 더 이상

pre-sync.yaml및post-sync.yaml파일이 필요하지 않습니다.update/deployment/kustomization.yamlCR은 hub 클러스터에서 정책 배포를 관리합니다.참고SiteConfig및PolicyGenTemplate트리 아래에는pre-sync.yaml및post-sync.yaml파일 세트가 있습니다.권장 변경 사항 검토 및 통합

각 릴리스에는 배포된 클러스터에 적용된 구성에 권장되는 추가 변경 사항이 포함될 수 있습니다. 일반적으로 이러한 변경으로 인해 OpenShift 플랫폼, 추가 기능 또는 플랫폼 튜닝에서 CPU 사용이 줄어들게 됩니다.

네트워크의 클러스터 유형에 적용되는

사이트Config및PolicyGenTemplateCR을 확인합니다. 이러한 예제는 GitOps ZTP 컨테이너에서 추출된argocd/example디렉터리에서 확인할 수 있습니다.

3.6. 새 GitOps ZTP 애플리케이션 설치

추출된 argocd/deployment 디렉터리를 사용하여 애플리케이션이 사이트 Git 리포지토리를 가리키는지 확인한 후 배포 디렉터리의 전체 콘텐츠를 적용합니다. 디렉터리의 전체 콘텐츠를 적용하면 애플리케이션에 필요한 모든 리소스가 올바르게 구성됩니다.

프로세스

GitOps ZTP 플러그인을 설치하려면 이전에

out/argocd/deployment/디렉터리에 추출한 패치 파일을 사용하여 hub 클러스터의 ArgoCD 인스턴스를 패치합니다. 다음 명령을 실행합니다.$ oc patch argocd openshift-gitops \ -n openshift-gitops --type=merge \ --patch-file out/argocd/deployment/argocd-openshift-gitops-patch.json

RHACM 2.7 이상에서는 다중 클러스터 엔진에서 기본적으로

cluster-proxy-addon기능을 활성화합니다. 다음 패치를 적용하여cluster-proxy-addon기능을 비활성화하고 이 애드온을 담당하는 관련 허브 클러스터 및 관리 Pod를 제거합니다. 다음 명령을 실행합니다.$ oc patch multiclusterengines.multicluster.openshift.io multiclusterengine --type=merge --patch-file out/argocd/deployment/disable-cluster-proxy-addon.json

다음 명령을 실행하여 허브 클러스터에 파이프라인 구성을 적용합니다.

$ oc apply -k out/argocd/deployment

3.7. GitOps ZTP 구성 변경 사항 롤아웃

권장 변경 사항 구현으로 인해 구성 변경이 업그레이드에 포함된 경우 업그레이드 프로세스에서 hub 클러스터에 정책 CR 세트를 Non-Compliant 상태로 만듭니다. GitOps ZTP(ZTP) 버전 4.10 및 이후 ztp-site-generate 컨테이너를 사용하면 이러한 정책은 정보 모드로 설정되고 사용자가 추가 단계없이 관리 클러스터로 푸시되지 않습니다. 이렇게 하면 변경 사항이 발생하는 시기(예: 유지 관리 기간 중) 및 동시에 업데이트되는 클러스터 수에 따라 클러스터에 잠재적으로 중단될 수 있습니다.

변경 사항을 롤아웃하려면 TALM 설명서에 자세히 설명된 대로 하나 이상의 ClusterGroupUpgrade CR을 생성합니다. CR에는 관리 클러스터로 푸시하려는 비준수 정책 목록과 업데이트에 포함되어야 하는 클러스터 목록 또는 선택기가 포함되어야 합니다.

추가 리소스

- Topology Aware Lifecycle Manager (TALM)에 대한 자세한 내용은 토폴로지 Aware Lifecycle Manager 구성 정보를 참조하십시오.

-

ClusterGroupUpgradeCR을 생성하는 방법에 대한 자세한 내용은 ZTP 용 자동 생성 ClusterGroupUpgrade CR 정보를 참조하십시오.

4장. RHACM 및 siteConfig 리소스를 사용하여 관리형 클러스터 설치

지원 서비스 및 core-reduction 기술이 활성화된 GitOps 플러그인 정책 생성기를 사용하여 RHACM(Red Hat Advanced Cluster Management)을 사용하여 대규모로 OpenShift Container Platform 클러스터를 프로비저닝할 수 있습니다. GitOps ZTP(ZTP) 파이프라인은 클러스터 설치를 수행합니다. GitOps ZTP는 연결이 끊긴 환경에서 사용할 수 있습니다.

4.1. GitOps ZTP 및 토폴로지 인식 라이프사이클 관리자

GitOps ZTP(ZTP)는 Git에 저장된 매니페스트에서 설치 및 구성 CR을 생성합니다. 이러한 아티팩트는 RHACM(Red Hat Advanced Cluster Management), 지원 서비스, 토폴로지 Aware Lifecycle Manager(TALM)에서 CR을 사용하여 관리 클러스터를 설치하고 구성하는 중앙 집중식 허브 클러스터에 적용됩니다. GitOps ZTP 파이프라인의 구성 단계는 TALM을 사용하여 구성 CR의 애플리케이션을 클러스터에 오케스트레이션합니다. GitOps ZTP와 TALM 사이에는 몇 가지 주요 통합 지점이 있습니다.

- 정책 정보

-

기본적으로 GitOps ZTP는

inform이라는 수정 작업을 사용하여 모든 정책을 생성합니다. 이러한 정책을 사용하면 RHACM에서 정책과 관련된 클러스터의 규정 준수 상태를 보고하지만 원하는 구성은 적용되지 않습니다. GitOps ZTP 프로세스 중에 OpenShift를 설치한 후 생성된정보정책을 통해 TALM을 단계화하고 대상 관리 클러스터에 적용합니다. 이렇게 하면 구성이 관리 클러스터에 적용됩니다. 클러스터 라이프사이클의 GitOps ZTP 단계 외부에서는 해당 변경 사항을 영향을 받는 클러스터로 즉시 롤아웃할 위험이 없는 정책을 변경할 수 있습니다. TALM을 사용하여 수정되는 클러스터 세트와 타이밍을 제어할 수 있습니다. - ClusterGroupUpgrade CR 자동 생성

새로 배포된 클러스터의 초기 구성을 자동화하기 위해 TALM은 hub 클러스터에서 모든

ManagedClusterCR의 상태를 모니터링합니다. 새로 생성된ManagedClusterCR을 포함하여ztp-done레이블이 적용되지 않은ManagedClusterCR을 사용하면 TALM에서 다음과 같은 특성을 가진ClusterGroupUpgradeCR을 자동으로 생성합니다.-

ztp-install네임스페이스에서ClusterGroupUpgradeCR이 생성되고 활성화됩니다. -

ClusterGroupUpgradeCR의 이름은ManagedClusterCR과 동일합니다. -

클러스터 선택기에는 해당

ManagedClusterCR과 연결된 클러스터만 포함됩니다. -

관리 정책 세트에는

ClusterGroupUpgrade가 생성될 때 RHACM이 클러스터에 바인딩한 모든 정책이 포함됩니다. - 사전 캐싱은 비활성화되어 있습니다.

- 시간 초과가 4시간(240분)으로 설정됩니다.

활성화된

ClusterGroupUpgrade의 자동 생성을 통해 사용자 개입 없이도 초기 무차별 클러스터 배포를 진행할 수 있습니다. 또한ztp-done레이블이 없는ManagedCluster에 대한ClusterGroupUpgradeCR을 자동으로 생성하면 클러스터에 대한ClusterGroupUpgradeCR을 간단히 삭제하여 실패한 GitOps ZTP 설치를 다시 시작할 수 있습니다.-

- 웨이브

PolicyGenTemplateCR에서 생성된 각 정책에는ztp-deploy-ECDSA 주석이포함됩니다. 이 주석은 해당 정책에 포함된 각 CR에서 동일한 주석을 기반으로 합니다. 웨이브 주석은 자동 생성된ClusterGroupUpgradeCR의 정책을 정렬하는 데 사용됩니다. 웨이브 주석은 자동 생성된ClusterGroupUpgradeCR 이외의 용도로는 사용되지 않습니다.참고동일한 정책의 모든 CR에는

ztp-deploy-Cryostat 주석에 대해 동일한 설정이 있어야 합니다. 각 CR에 대한 이 주석의 기본값은PolicyGenTemplate에서 재정의할 수 있습니다. 소스 CR의 웨이브 주석은 정책파 주석을 결정하고 설정하는 데 사용됩니다. 이 주석은 런타임 시 생성된 정책에 포함된 각 빌드된 CR에서 제거됩니다.TALM은 웨이브 주석에 의해 지정된 순서로 구성 정책을 적용합니다. TALM은 다음 정책으로 이동하기 전에 각 정책이 준수될 때까지 기다립니다. 각 CR의 웨이브 주석이 클러스터에 적용되려면 해당 CR의 사전 요구 사항을 고려해야 합니다. 예를 들어 Operator의 구성과 동시에 Operator를 설치해야 합니다. 마찬가지로 Operator 서브스크립션 이전 또는 동시에 Operator의

CatalogSource를 설치해야 합니다. 각 CR의 기본 웨이브 값은 이러한 사전 요구 사항을 고려합니다.여러 CR과 정책은 동일한 웨이브 번호를 공유할 수 있습니다. 정책을 줄이면 배포가 빨라지고 CPU 사용량을 줄일 수 있습니다. 많은 CR을 비교적 적은 파도로 그룹화하는 것이 좋습니다.

각 소스 CR의 기본 웨이브 값을 확인하려면 ztp-site-generate 컨테이너 이미지에서 추출된 out/source-crs 디렉터리에 대해 다음 명령을 실행합니다.

$ grep -r "ztp-deploy-wave" out/source-crs

- 단계 레이블

ClusterGroupUpgradeCR이 자동으로 생성되고 GitOps ZTP 프로세스의 시작 및 종료 시 라벨을 사용하여ManagedClusterCR에 주석을 달 수 있는 지시문이 포함됩니다.GitOps ZTP 구성 후 설치가 시작되면

ManagedCluster에ztp-running레이블이 적용됩니다. 모든 정책이 클러스터에 수정되어 완전히 준수되면 이러한 지시문으로 인해 TALM에서ztp-running레이블을 제거하고ztp-done레이블을 적용합니다.informDuValidator정책을 사용하는 배포의 경우 클러스터가 애플리케이션 배포를 완전히 준비할 때ztp-done레이블이 적용됩니다. 여기에는 GitOps ZTP가 적용된 구성 CR의 모든 조정 및 결과 영향이 포함됩니다.ztp-done레이블은 TALM의 자동ClusterGroupUpgradeCR 생성에 영향을 미칩니다. 클러스터의 초기 GitOps ZTP 설치 후에는 이 라벨을 조작하지 마십시오.- 연결된 CR

-

자동으로 생성된

ClusterGroupUpgradeCR에는 파생된ManagedCluster로 설정된 owner 참조가 있습니다. 이 참조를 사용하면ManagedClusterCR을 삭제하면 지원되는 리소스와 함께ClusterGroupUpgrade인스턴스가 삭제됩니다.

4.2. GitOps ZTP를 사용하여 관리형 클러스터 배포 개요

RHACM(Red Hat Advanced Cluster Management)은 GitOps ZTP(ZTP)를 사용하여 단일 노드 OpenShift Container Platform 클러스터, 3노드 클러스터 및 표준 클러스터를 배포합니다. Git 리포지토리에서 사이트 구성 데이터를 OpenShift Container Platform CR(사용자 정의 리소스)으로 관리합니다. GitOps ZTP는 선언적 GitOps 접근 방식을 사용하여 한 번 개발하고 모델을 배포하여 관리 클러스터를 배포합니다.

클러스터 배포에는 다음이 포함됩니다.

- 빈 서버에 호스트 운영 체제(RHCOS) 설치

- OpenShift Container Platform 배포

- 클러스터 정책 및 사이트 서브스크립션 생성

- 서버 운영 체제에 필요한 네트워크 구성 만들기

- 프로파일 Operator 배포 및 성능 프로필, PTP 및 SR-IOV와 같은 필요한 소프트웨어 관련 구성 수행

관리 사이트 설치 프로세스 개요

허브 클러스터에 관리 사이트 CR(사용자 정의 리소스)을 적용한 후 다음 작업이 자동으로 수행됩니다.

- 검색 이미지 ISO 파일이 생성되어 대상 호스트에서 부팅됩니다.

- 대상 호스트에서 ISO 파일이 성공적으로 부팅되면 호스트 하드웨어 정보를 RHACM에 보고합니다.

- 모든 호스트가 검색되면 OpenShift Container Platform이 설치됩니다.

-

OpenShift Container Platform 설치가 완료되면 허브가 대상 클러스터에

klusterlet서비스를 설치합니다. - 요청된 애드온 서비스가 대상 클러스터에 설치되어 있습니다.

hub 클러스터에서 관리 클러스터의 Agent CR이 생성되면 Discovery 이미지 ISO 프로세스가 완료됩니다.

대상 베어 메탈 호스트는 vDU 애플리케이션 워크로드에 대해 권장 단일 노드 OpenShift 클러스터 구성에 나열된 네트워킹, 펌웨어 및 하드웨어 요구 사항을 충족해야 합니다.

4.3. 관리형 베어 메탈 호스트 시크릿 생성

관리 베어 메탈 호스트에 필요한 Secret CR(사용자 정의 리소스)을 hub 클러스터에 추가합니다. BMC(Baseboard Management Controller)에 액세스하려면 GitOps ZTP(ZTP) 파이프라인의 시크릿과 지원되는 설치 프로그램 서비스에서 레지스트리에서 클러스터 설치 이미지를 가져오는 시크릿이 필요합니다.

보안은 site Config CR에서 이름으로 참조됩니다. 네임스페이스는 site Config 네임스페이스와 일치해야 합니다.

프로세스

OpenShift 및 모든 추가 기능 클러스터 Operator 설치에 필요한 호스트 BMC(Baseboard Management Controller)에 대한 인증 정보와 풀 시크릿을 포함하는 YAML 시크릿 파일을 생성합니다.

다음 YAML을

example-sno-secret.yaml파일로 저장합니다.apiVersion: v1 kind: Secret metadata: name: example-sno-bmc-secret namespace: example-sno 1 data: 2 password: <base64_password> username: <base64_username> type: Opaque --- apiVersion: v1 kind: Secret metadata: name: pull-secret namespace: example-sno 3 data: .dockerconfigjson: <pull_secret> 4 type: kubernetes.io/dockerconfigjson

-

클러스터를 설치하는 데 사용하는

kustomization.yaml파일에example-sno-secret.yaml에 상대 경로를 추가합니다.

4.4. GitOps ZTP를 사용하여 설치를 위한 Discovery ISO 커널 인수 구성

GitOps ZTP(ZTP) 워크플로는 관리형 베어 메탈 호스트에서 OpenShift Container Platform 설치 프로세스의 일부로 Discovery ISO를 사용합니다. InfraEnv 리소스를 편집하여 Discovery ISO에 대한 커널 인수를 지정할 수 있습니다. 이는 특정 환경 요구 사항이 있는 클러스터 설치에 유용합니다. 예를 들어 클러스터의 정적 네트워킹을 용이하게 하거나 설치 중에 루트 파일 시스템을 다운로드하기 전에 DHCP 주소를 수신하도록 Discovery ISO에 rd.net.timeout.carrier 커널 인수를 구성합니다.

OpenShift Container Platform 4.15에서는 커널 인수만 추가할 수 있습니다. 커널 인수를 교체하거나 삭제할 수 없습니다.

사전 요구 사항

- OpenShift CLI(oc)가 설치되어 있습니다.

- cluster-admin 권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

InfraEnvCR을 생성하고spec.kernelArguments사양을 편집하여 커널 인수를 구성합니다.다음 YAML을

InfraEnv-example.yaml파일에 저장합니다.참고이 예제의

InfraEnvCR은 siteConfigCR의 값에 따라 채워진{{ .Cluster.ClusterName }}과 같은 템플릿 구문을 사용합니다.SiteConfigCR은 배포 중에 이러한 템플릿의 값을 자동으로 채웁니다. 템플릿을 수동으로 편집하지 마십시오.apiVersion: agent-install.openshift.io/v1beta1 kind: InfraEnv metadata: annotations: argocd.argoproj.io/sync-wave: "1" name: "{{ .Cluster.ClusterName }}" namespace: "{{ .Cluster.ClusterName }}" spec: clusterRef: name: "{{ .Cluster.ClusterName }}" namespace: "{{ .Cluster.ClusterName }}" kernelArguments: - operation: append 1 value: audit=0 2 - operation: append value: trace=1 sshAuthorizedKey: "{{ .Site.SshPublicKey }}" proxy: "{{ .Cluster.ProxySettings }}" pullSecretRef: name: "{{ .Site.PullSecretRef.Name }}" ignitionConfigOverride: "{{ .Cluster.IgnitionConfigOverride }}" nmStateConfigLabelSelector: matchLabels: nmstate-label: "{{ .Cluster.ClusterName }}" additionalNTPSources: "{{ .Cluster.AdditionalNTPSources }}"

InfraEnv-example.yamlCR을 siteConfigCR이 있는 Git 리포지토리의 동일한 위치에 커밋하고 변경 사항을 내보냅니다. 다음 예제에서는 샘플 Git 리포지토리 구조를 보여줍니다.~/example-ztp/install └── site-install ├── siteconfig-example.yaml ├── InfraEnv-example.yaml ...SiteConfigCR에서spec.clusters.crTemplates사양을 편집하여 Git 리포지토리의InfraEnv-example.yamlCR을 참조합니다.clusters: crTemplates: InfraEnv: "InfraEnv-example.yaml"SiteConfigCR을 커밋하고 푸시하여 클러스터를 배포할 준비가 되면 빌드 파이프라인은 Git 리포지토리의 사용자 지정InfraEnv-exampleCR을 사용하여 사용자 지정 커널 인수를 포함하여 인프라 환경을 구성합니다.

검증

커널 인수가 적용되었는지 확인하려면 검색 이미지에서 OpenShift Container Platform을 설치할 준비가 되었는지 확인한 후 설치 프로세스가 시작되기 전에 대상 호스트에 SSH를 수행할 수 있습니다. 이때 /proc/cmdline 파일에서 Discovery ISO의 커널 인수를 볼 수 있습니다.

대상 호스트를 사용하여 SSH 세션을 시작합니다.

$ ssh -i /path/to/privatekey core@<host_name>

다음 명령을 사용하여 시스템의 커널 인수를 확인합니다.

$ cat /proc/cmdline

4.5. SiteConfig 및 GitOps ZTP를 사용하여 관리형 클러스터 배포

다음 절차에 따라 SiteConfig CR(사용자 정의 리소스) 및 관련 파일을 생성하고 ZTP( GitOps Zero Touch Provisioning) 클러스터 배포를 시작합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다. - 필요한 설치 및 정책 CR을 생성하도록 허브 클러스터를 구성했습니다.

사용자 지정 사이트 구성 데이터를 관리하는 Git 리포지토리를 생성하셨습니다. 리포지토리는 hub 클러스터에서 액세스할 수 있어야 하며 ArgoCD 애플리케이션의 소스 리포지토리로 구성해야 합니다. 자세한 내용은 " GitOps ZTP 사이트 구성 리포지토리 준비"를 참조하십시오.

참고소스 리포지토리를 생성할 때

ztp-site-generate컨테이너에서 추출한argocd/deployment/argocd-openshift-gitops-patch.jsonpatch-file을 사용하여 ArgoCD 애플리케이션을 패치하는지 확인합니다. " ArgoCD를 사용하여 허브 클러스터 구성"을 참조하십시오.관리 클러스터 프로비저닝을 준비하려면 각 베어 메탈 호스트에 대해 다음이 필요합니다.

- 네트워크 연결

- 네트워크에는 DNS가 필요합니다. 허브 클러스터에서 관리 클러스터 호스트에 연결할 수 있어야 합니다. hub 클러스터와 관리 클러스터 호스트 간에 계층 3 연결이 있는지 확인합니다.

- BMC(Baseboard Management Controller) 세부 정보

-

GitOps ZTP는 BMC 사용자 이름과 암호 세부 정보를 사용하여 클러스터 설치 중에 BMC에 연결합니다. GitOps ZTP 플러그인은 사이트 Git 리포지토리의 site

ConfigCR을 기반으로 Hub 클러스터에서ManagedClusterCR을 관리합니다. 각 호스트에 대해 수동으로 개별BMCSecretCR을 생성합니다.

프로세스

hub 클러스터에 필요한 관리 클러스터 시크릿을 생성합니다. 이러한 리소스는 클러스터 이름과 일치하는 이름이 있는 네임스페이스에 있어야 합니다. 예를 들어

out/argocd/example/siteconfig/example-sno.yaml에서 클러스터 이름과 네임스페이스는example-sno입니다.다음 명령을 실행하여 클러스터 네임스페이스를 내보냅니다.

$ export CLUSTERNS=example-sno

네임스페이스를 생성합니다.

$ oc create namespace $CLUSTERNS

관리 클러스터에 대한 풀 시크릿 및 BMC

SecretCR을 생성합니다. 풀 시크릿에는 OpenShift Container Platform 및 필요한 모든 Operator를 설치하는 데 필요한 모든 인증 정보가 포함되어야 합니다. 자세한 내용은 "관리된 베어 메탈 호스트 시크릿 생성"을 참조하십시오.참고보안은 site

ConfigCR(사용자 정의 리소스)에서 이름으로 참조됩니다. 네임스페이스는 siteConfig 네임스페이스와일치해야 합니다.Git 리포지토리의 로컬 복제본에 클러스터의 site

ConfigCR을 생성합니다.out/argocd/example/siteconfig/폴더에서 CR에 적합한 예제를 선택합니다. 폴더에는 단일 노드, 3-노드 및 표준 클러스터에 대한 예제 파일이 포함되어 있습니다.-

example-sno.yaml -

예:-3node.yaml -

example-standard.yaml

-

예제 파일의 클러스터 및 호스트 세부 정보를 원하는 클러스터 유형과 일치하도록 변경합니다. 예를 들면 다음과 같습니다.

단일 노드 OpenShift SiteConfig CR의 예

# example-node1-bmh-secret & assisted-deployment-pull-secret need to be created under same namespace example-sno --- apiVersion: ran.openshift.io/v1 kind: SiteConfig metadata: name: "example-sno" namespace: "example-sno" spec: baseDomain: "example.com" pullSecretRef: name: "assisted-deployment-pull-secret" clusterImageSetNameRef: "openshift-4.10" sshPublicKey: "ssh-rsa AAAA..." clusters: - clusterName: "example-sno" networkType: "OVNKubernetes" # installConfigOverrides is a generic way of passing install-config # parameters through the siteConfig. The 'capabilities' field configures # the composable openshift feature. In this 'capabilities' setting, we # remove all but the marketplace component from the optional set of # components. # Notes: # - NodeTuning is needed for 4.13 and later, not for 4.12 and earlier installConfigOverrides: "{\"capabilities\":{\"baselineCapabilitySet\": \"None\", \"additionalEnabledCapabilities\": [ \"marketplace\", \"NodeTuning\" ] }}" # It is strongly recommended to include crun manifests as part of the additional install-time manifests for 4.13+. # The crun manifests can be obtained from source-crs/optional-extra-manifest/ and added to the git repo ie.sno-extra-manifest. # extraManifestPath: sno-extra-manifest clusterLabels: # These example cluster labels correspond to the bindingRules in the PolicyGenTemplate examples du-profile: "4.14" # These example cluster labels correspond to the bindingRules in the PolicyGenTemplate examples in ../policygentemplates: # ../policygentemplates/common-ranGen.yaml will apply to all clusters with 'common: true' common: true # ../policygentemplates/group-du-sno-ranGen.yaml will apply to all clusters with 'group-du-sno: ""' group-du-sno: "" # ../policygentemplates/example-sno-site.yaml will apply to all clusters with 'sites: "example-sno"' # Normally this should match or contain the cluster name so it only applies to a single cluster sites: "example-sno" clusterNetwork: - cidr: 1001:1::/48 hostPrefix: 64 machineNetwork: - cidr: 1111:2222:3333:4444::/64 serviceNetwork: - 1001:2::/112 additionalNTPSources: - 1111:2222:3333:4444::2 # Initiates the cluster for workload partitioning. Setting specific reserved/isolated CPUSets is done via PolicyTemplate # please see Workload Partitioning Feature for a complete guide. cpuPartitioningMode: AllNodes # Optionally; This can be used to override the KlusterletAddonConfig that is created for this cluster: #crTemplates: # KlusterletAddonConfig: "KlusterletAddonConfigOverride.yaml" nodes: - hostName: "example-node1.example.com" role: "master" # Optionally; This can be used to configure desired BIOS setting on a host: #biosConfigRef: # filePath: "example-hw.profile" bmcAddress: "idrac-virtualmedia+https://[1111:2222:3333:4444::bbbb:1]/redfish/v1/Systems/System.Embedded.1" bmcCredentialsName: name: "example-node1-bmh-secret" bootMACAddress: "AA:BB:CC:DD:EE:11" # Use UEFISecureBoot to enable secure boot bootMode: "UEFI" rootDeviceHints: wwn: "0x11111000000asd123" # example of diskPartition below is used for image registry (check ImageRegistry.md for more details), but it's not limited to this use case # diskPartition: # - device: /dev/disk/by-id/wwn-0x11111000000asd123 # match rootDeviceHints # partitions: # - mount_point: /var/imageregistry # size: 102500 # start: 344844 nodeNetwork: interfaces: - name: eno1 macAddress: "AA:BB:CC:DD:EE:11" config: interfaces: - name: eno1 type: ethernet state: up ipv4: enabled: false ipv6: enabled: true address: # For SNO sites with static IP addresses, the node-specific, # API and Ingress IPs should all be the same and configured on # the interface - ip: 1111:2222:3333:4444::aaaa:1 prefix-length: 64 dns-resolver: config: search: - example.com server: - 1111:2222:3333:4444::2 routes: config: - destination: ::/0 next-hop-interface: eno1 next-hop-address: 1111:2222:3333:4444::1 table-id: 254참고BMC 주소 지정에 대한 자세한 내용은 "추가 리소스" 섹션을 참조하십시오.

-

외부/argocd/extra-manifest에서기본 extra-manifestMachineConfigCR 세트를 검사할 수 있습니다. 설치 시 클러스터에 자동으로 적용됩니다. 선택 사항: 프로비저닝된 클러스터에서 추가 설치 시간 매니페스트를 프로비저닝하려면 Git 리포지토리에 디렉터리를 생성하고 (예:

sno-extra-manifest/) 사용자 정의 매니페스트 CR을 이 디렉터리에 추가합니다.SiteConfig.yaml이extraManifestPath필드의 이 디렉터리를 참조하는 경우 이 참조 디렉터리의 모든 CR이 기본 추가 매니페스트 세트에 추가됩니다.crun OCI 컨테이너 런타임 활성화최적의 클러스터 성능을 위해서는 단일 노드 OpenShift에서 마스터 및 작업자 노드에 대해 crun, 추가 작업자 노드가 있는 단일 노드 OpenShift, 3-노드 OpenShift 및 표준 클러스터를 활성화합니다.

클러스터를 재부팅하지 않도록

ContainerRuntimeConfigCR에서 0일 추가 설치 시간 매니페스트로 crun을 활성화합니다.enable-crun-master.yaml및enable-crun-worker.yamlCR 파일은ztp-site-generate컨테이너에서 추출할 수 있는out/source-crs/optional-extra-manifest/폴더에 있습니다. 자세한 내용은 " GitOps ZTP 파이프라인의 추가 설치 매니페스트 사용자 지정"을 참조하십시오.

-

out/argocd/example/siteconfig/과 유사하게kustomization.yamlgenerators섹션의 kustomization.yaml 파일에SiteConfigCR을 추가합니다. Git 리포지토리에서

SiteConfigCR 및 관련kustomization.yaml변경 사항을 커밋하고 변경 사항을 내보냅니다.ArgoCD 파이프라인은 변경 사항을 감지하고 관리 클러스터 배포를 시작합니다.

검증

노드가 배포된 후 사용자 정의 역할 및 라벨이 적용되는지 확인합니다.

$ oc describe node example-node.example.com

출력 예

Name: example-node.example.com

Roles: control-plane,example-label,master,worker

Labels: beta.kubernetes.io/arch=amd64

beta.kubernetes.io/os=linux

custom-label/parameter1=true

kubernetes.io/arch=amd64

kubernetes.io/hostname=cnfdf03.telco5gran.eng.rdu2.redhat.com

kubernetes.io/os=linux

node-role.kubernetes.io/control-plane=

node-role.kubernetes.io/example-label= 1

node-role.kubernetes.io/master=

node-role.kubernetes.io/worker=

node.openshift.io/os_id=rhcos

- 1

- 사용자 정의 레이블이 노드에 적용됩니다.

4.5.1. 단일 노드 OpenShift SiteConfig CR 설치 참조

표 4.1. 단일 노드 OpenShift 클러스터에 대한 SiteConfig CR 설치 옵션

| siteConfig CR 필드 | 설명 |

|---|---|

|

|

참고

|

|

|

|

|

|

사이트의 모든 클러스터에 대해 hub 클러스터에서 사용 가능한 이미지 세트를 구성합니다. hub 클러스터에서 지원되는 버전 목록을 보려면 |

|

|

클러스터 설치 전에 선택적 구성 요소를 활성화하거나 비활성화하려면 중요

예제 |

|

|

개별 클러스터를 배포하는 데 사용되는 클러스터 이미지 세트를 지정합니다. 정의된 경우 사이트 수준에서 |

|

|

사용자가 정의한 |

|

|

선택 사항: |

|

|

단일 노드 배포의 경우 단일 호스트를 정의합니다. 3-노드 배포의 경우 세 개의 호스트를 정의합니다. 표준 배포의 경우 역할이 있는 세 개의 호스트( |

|

| 관리 클러스터에서 노드의 사용자 지정 역할을 지정합니다. 추가 역할은 사용자만 OpenShift Container Platform 구성 요소에서 사용하지 않습니다. 사용자 지정 역할을 추가하면 해당 역할의 특정 구성을 참조하는 사용자 지정 머신 구성 풀과 연결할 수 있습니다. 설치 중에 사용자 정의 레이블 또는 역할을 추가하면 배포 프로세스가 더 효과적이며 설치가 완료된 후 추가 재부팅이 필요하지 않습니다. |

|

|

선택 사항: 디스크를 완전히 삭제하지 않고 값의 주석을 |

|

| 호스트에 액세스하는 데 사용하는 BMC 주소입니다. 모든 클러스터 유형에 적용됩니다. GitOps ZTP는 Redfish 또는 IPMI 프로토콜을 사용하여 iPXE 및 가상 미디어 부팅을 지원합니다. iPXE 부팅을 사용하려면 RHACM 2.8 이상을 사용해야 합니다. BMC 주소 지정에 대한 자세한 내용은 "추가 리소스" 섹션을 참조하십시오. |

|

| 호스트에 액세스하는 데 사용하는 BMC 주소입니다. 모든 클러스터 유형에 적용됩니다. GitOps ZTP는 Redfish 또는 IPMI 프로토콜을 사용하여 iPXE 및 가상 미디어 부팅을 지원합니다. iPXE 부팅을 사용하려면 RHACM 2.8 이상을 사용해야 합니다. BMC 주소 지정에 대한 자세한 내용은 "추가 리소스" 섹션을 참조하십시오. 참고 지금까지 엣지 Telco 사용 사례에서는 GitOps ZTP에서 사용할 수 있도록 가상 미디어만 지원됩니다. |

|

|

호스트 BMC 인증 정보를 사용하여 별도로 생성하는 |

|

|

호스트의 부팅 모드를 |

|

|

배포 장치를 지정합니다. 재부팅 시 안정적인 식별자(예 |

|

|

선택 사항: 제공된 예제 |

|

| 선택 사항: 이 필드를 사용하여 영구 스토리지의 파티션을 할당합니다. 디스크 ID와 크기를 특정 하드웨어에 조정합니다. |

|

|

워크로드 파티셔닝을 위해 cluster |

|

| 노드의 네트워크 설정을 구성합니다. |

|

| 호스트의 IPv6 주소를 구성합니다. 고정 IP 주소가 있는 단일 노드 OpenShift 클러스터의 경우 노드별 API 및 Ingress IP가 동일해야 합니다. |

4.6. 관리형 클러스터 설치 진행 상황 모니터링

ArgoCD 파이프라인은 site Config CR을 사용하여 클러스터 구성 CR을 생성하고 Hub 클러스터와 동기화합니다. ArgoCD 대시보드에서 동기화의 진행 상황을 모니터링할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

동기화가 완료되면 설치는 일반적으로 다음과 같이 진행됩니다.

Assisted Service Operator는 클러스터에 OpenShift Container Platform을 설치합니다. 다음 명령을 실행하여 RHACM 대시보드 또는 명령줄에서 클러스터 설치 진행 상황을 모니터링할 수 있습니다.

클러스터 이름을 내보냅니다.

$ export CLUSTER=<clusterName>

관리 클러스터의

AgentClusterInstallCR을 쿼리합니다.$ oc get agentclusterinstall -n $CLUSTER $CLUSTER -o jsonpath='{.status.conditions[?(@.type=="Completed")]}' | jq클러스터의 설치 이벤트를 가져옵니다.

$ curl -sk $(oc get agentclusterinstall -n $CLUSTER $CLUSTER -o jsonpath='{.status.debugInfo.eventsURL}') | jq '.[-2,-1]'

4.7. 설치 CR을 검증하여 GitOps ZTP 문제 해결

ArgoCD 파이프라인은 site Config 및 PolicyGenTemplate CR(사용자 정의 리소스)을 사용하여 클러스터 구성 CR 및 RHACM(Red Hat Advanced Cluster Management) 정책을 생성합니다. 이 프로세스 중에 발생할 수 있는 문제를 해결하려면 다음 단계를 사용하십시오.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

다음 명령을 사용하여 설치 CR이 생성되었는지 확인합니다.

$ oc get AgentClusterInstall -n <cluster_name>

오브젝트가 반환되지 않은 경우 다음 단계를 사용하여

SiteConfig파일에서 설치 CR로 ArgoCD 파이프라인 흐름의 문제를 해결합니다.hub 클러스터의

SiteConfigCR을 사용하여ManagedClusterCR이 생성되었는지 확인합니다.$ oc get managedcluster

ManagedCluster가 없는 경우클러스터애플리케이션이 Git 리포지토리의 파일을 hub 클러스터와 동기화하지 않았는지 확인합니다.$ oc describe -n openshift-gitops application clusters

Status.Conditions필드를 확인하여 관리 클러스터의 오류 로그를 확인합니다. 예를 들어,SiteConfigCR에서extraManifestPath:에 대해 유효하지 않은 값을 설정하면 다음과 같은 오류가 발생합니다.Status: Conditions: Last Transition Time: 2021-11-26T17:21:39Z Message: rpc error: code = Unknown desc = `kustomize build /tmp/https___git.com/ran-sites/siteconfigs/ --enable-alpha-plugins` failed exit status 1: 2021/11/26 17:21:40 Error could not create extra-manifest ranSite1.extra-manifest3 stat extra-manifest3: no such file or directory 2021/11/26 17:21:40 Error: could not build the entire SiteConfig defined by /tmp/kust-plugin-config-913473579: stat extra-manifest3: no such file or directory Error: failure in plugin configured via /tmp/kust-plugin-config-913473579; exit status 1: exit status 1 Type: ComparisonErrorStatus.Sync필드를 확인합니다. 로그 오류가 있는 경우Status.Sync필드에 알 수없는오류가 표시될 수 있습니다.Status: Sync: Compared To: Destination: Namespace: clusters-sub Server: https://kubernetes.default.svc Source: Path: sites-config Repo URL: https://git.com/ran-sites/siteconfigs/.git Target Revision: master Status: Unknown

4.8. Supermicro 서버에서 GitOps ZTP 가상 미디어 부팅 문제 해결

Supermicro X11 서버는 https 프로토콜을 사용하여 이미지를 제공하는 경우 가상 미디어 설치를 지원하지 않습니다. 결과적으로 이 환경의 단일 노드 OpenShift 배포가 대상 노드에서 부팅되지 않습니다. 이 문제를 방지하려면 hub 클러스터에 로그인하고 프로비저닝 리소스에서 TLS(Transport Layer Security)를 비활성화합니다. 이렇게 하면 이미지 주소가 https 스키마를 사용하더라도 TLS로 이미지가 제공되지 않습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

다음 명령을 실행하여

프로비저닝리소스에서 TLS를 비활성화합니다.$ oc patch provisioning provisioning-configuration --type merge -p '{"spec":{"disableVirtualMediaTLS": true}}'- 단일 노드 OpenShift 클러스터를 배포하려면 단계를 계속합니다.

4.9. GitOps ZTP 파이프라인에서 관리되는 클러스터 사이트 제거

GitOps ZTP(ZTP) 파이프라인에서 관리 사이트 및 관련 설치 및 구성 정책 CR을 제거할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

kustomization.yaml파일에서 관련SiteConfig및PolicyGenTemplate파일을 제거하여 사이트 및 관련 CR을 제거합니다.GitOps ZTP 파이프라인을 다시 실행하면 생성된 CR이 제거됩니다.

-

선택 사항: 사이트를 영구적으로 제거하려면 Git 리포지토리에서 site

Config및 사이트별PolicyGenTemplate파일을 제거해야 합니다. -

선택 사항: 예를 들어 사이트를 재배포할 때 사이트를 일시적으로 제거하려면 site

Config 및 사이트별PolicyGenTemplateCR을 Git 리포지토리에 남겨 둘 수 있습니다.

추가 리소스

- 클러스터 제거에 대한 자세한 내용은 관리에서 클러스터 제거를 참조하십시오.

4.10. GitOps ZTP 파이프라인에서 더 이상 사용되지 않는 콘텐츠 제거

PolicyGenTemplate 구성을 변경하면 더 이상 사용되지 않는 정책이 생성되는 경우(예: 정책 이름 변경) 다음 절차를 사용하여 더 이상 사용되지 않는 정책을 제거합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

-

Git 리포지토리에서 영향을 받는

PolicyGenTemplate파일을 제거하고 원격 리포지토리를 커밋하고 내보냅니다. - 변경 사항이 애플리케이션을 통해 동기화되고 영향을 받는 정책이 허브 클러스터에서 제거될 때까지 기다립니다.

업데이트된

PolicyGenTemplate파일을 Git 리포지토리에 다시 추가한 다음 원격 리포지토리를 커밋하고 내보냅니다.참고Git 리포지토리에서 GitOps Zero Touch Provisioning(ZTP) 정책을 제거하면 허브 클러스터에서도 해당 정책을 제거해도 관리 클러스터의 구성에 영향을 미치지 않습니다. 해당 정책에서 관리하는 정책 및 CR은 관리 클러스터에 남아 있습니다.

선택 사항: 대신 더 이상 사용되지 않는 정책을 생성하는

PolicyGenTemplateCR을 변경한 후 hub 클러스터에서 이러한 정책을 수동으로 제거할 수 있습니다. Governance 탭을 사용하거나 다음 명령을 실행하여 RHACM 콘솔에서 정책을 삭제할 수 있습니다.$ oc delete policy -n <namespace> <policy_name>

4.11. GitOps ZTP 파이프라인 종료

ArgoCD 파이프라인 및 생성된 모든 ZTP(ZTP) 아티팩트를 제거할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

- hub 클러스터의 RHACM(Red Hat Advanced Cluster Management)에서 모든 클러스터를 분리합니다.

다음 명령을 사용하여

배포디렉터리에서kustomization.yaml파일을 삭제합니다.$ oc delete -k out/argocd/deployment

- 변경 사항을 커밋하고 사이트 리포지토리로 내보냅니다.

5장. 정책 및 PolicyGenTemplate 리소스를 사용하여 관리형 클러스터 구성

적용된 정책 CR(사용자 정의 리소스)은 사용자가 프로비저닝하는 관리 클러스터를 구성합니다. RHACM(Red Hat Advanced Cluster Management)에서 PolicyGenTemplate CR을 사용하여 적용된 정책 CR을 생성하는 방법을 사용자 지정할 수 있습니다.

5.1. PolicyGenTemplate CRD 정보

PolicyGenTemplate CRD(사용자 정의 리소스 정의)는 PolicyGen 정책 생성기에 클러스터 구성에 포함할 사용자 정의 리소스(CR), CR을 생성된 정책에 결합하는 방법, 해당 CR의 항목을 오버레이 콘텐츠로 업데이트해야 함을 알려줍니다.

다음 예제에서는 ztp-site-generate 참조 컨테이너에서 추출된 PolicyGenTemplate CR(common-du-ranGen.yaml)을 보여줍니다. common-du-ranGen.yaml 파일은 두 개의 RHACM(Red Hat Advanced Cluster Management) 정책을 정의합니다. 경찰은 CR에서 policyName 의 각 고유 값에 대해 하나씩 구성 CR 컬렉션을 관리합니다. common-du-ranGen.yaml 은 bindingRules 섹션에 나열된 레이블을 기반으로 정책을 클러스터에 바인딩하는 단일 배치 바인딩 및 배치 규칙을 생성합니다.

예: PolicyGenTemplate CR - common-du-ranGen.yaml

---

apiVersion: ran.openshift.io/v1

kind: PolicyGenTemplate

metadata:

name: "common"

namespace: "ztp-common"

spec:

bindingRules:

common: "true" 1

sourceFiles: 2

- fileName: SriovSubscription.yaml

policyName: "subscriptions-policy"

- fileName: SriovSubscriptionNS.yaml

policyName: "subscriptions-policy"

- fileName: SriovSubscriptionOperGroup.yaml

policyName: "subscriptions-policy"

- fileName: SriovOperatorStatus.yaml

policyName: "subscriptions-policy"

- fileName: PtpSubscription.yaml

policyName: "subscriptions-policy"

- fileName: PtpSubscriptionNS.yaml

policyName: "subscriptions-policy"

- fileName: PtpSubscriptionOperGroup.yaml

policyName: "subscriptions-policy"

- fileName: PtpOperatorStatus.yaml

policyName: "subscriptions-policy"

- fileName: ClusterLogNS.yaml

policyName: "subscriptions-policy"

- fileName: ClusterLogOperGroup.yaml

policyName: "subscriptions-policy"

- fileName: ClusterLogSubscription.yaml

policyName: "subscriptions-policy"

- fileName: ClusterLogOperatorStatus.yaml

policyName: "subscriptions-policy"

- fileName: StorageNS.yaml

policyName: "subscriptions-policy"

- fileName: StorageOperGroup.yaml

policyName: "subscriptions-policy"

- fileName: StorageSubscription.yaml

policyName: "subscriptions-policy"

- fileName: StorageOperatorStatus.yaml

policyName: "subscriptions-policy"

- fileName: ReduceMonitoringFootprint.yaml

policyName: "config-policy"

- fileName: OperatorHub.yaml 3

policyName: "config-policy"

- fileName: DefaultCatsrc.yaml 4

policyName: "config-policy" 5

metadata:

name: redhat-operators

spec:

displayName: disconnected-redhat-operators

image: registry.example.com:5000/disconnected-redhat-operators/disconnected-redhat-operator-index:v4.9

- fileName: DisconnectedICSP.yaml

policyName: "config-policy"

spec:

repositoryDigestMirrors:

- mirrors:

- registry.example.com:5000

source: registry.redhat.io

- 1

Common: "true"는 이 레이블이 있는 모든 클러스터에 정책을 적용합니다.- 2

sourceFiles아래에 나열된 파일은 설치된 클러스터에 대한 Operator 정책을 생성합니다.- 3

OperatorHub.yaml은 연결이 끊긴 레지스트리에 대한 OperatorHub를 구성합니다.- 4

DefaultCatsrc.yaml은 연결이 끊긴 레지스트리의 카탈로그 소스를 구성합니다.- 5

PolicyName: "config-policy"는 Operator 서브스크립션을 구성합니다.OperatorHubCR은 기본값을 비활성화하고 이 CR은 연결이 끊긴 레지스트리를 가리키는CatalogSourceCR로redhat-operators를 대체합니다.

PolicyGenTemplate CR은 포함된 CR 수를 사용하여 구성할 수 있습니다. hub 클러스터에 다음 예제 CR을 적용하여 단일 CR을 포함하는 정책을 생성합니다.

apiVersion: ran.openshift.io/v1

kind: PolicyGenTemplate

metadata:

name: "group-du-sno"

namespace: "ztp-group"

spec:

bindingRules:

group-du-sno: ""

mcp: "master"

sourceFiles:

- fileName: PtpConfigSlave.yaml

policyName: "config-policy"

metadata:

name: "du-ptp-slave"

spec:

profile:

- name: "slave"

interface: "ens5f0"

ptp4lOpts: "-2 -s --summary_interval -4"

phc2sysOpts: "-a -r -n 24"

소스 파일 PtpConfigSlave.yaml 을 예로 사용하여 파일은 PtpConfig CR을 정의합니다. PtpConfigSlave 예제에 대해 생성된 정책의 이름은 group-du-sno-config-policy 입니다. 생성된 group-du-sno-config-policy 에 정의된 PtpConfig CR의 이름은 du-ptp-slave 입니다. PtpConfigSlave.yaml 에 정의된 사양 은 소스 파일에 정의된 다른 사양 항목과 함께 du-ptp-slave 아래에 배치됩니다.

다음 예제에서는 group-du-sno-config-policy CR을 보여줍니다.

apiVersion: policy.open-cluster-management.io/v1

kind: Policy

metadata:

name: group-du-ptp-config-policy

namespace: groups-sub

annotations:

policy.open-cluster-management.io/categories: CM Configuration Management

policy.open-cluster-management.io/controls: CM-2 Baseline Configuration

policy.open-cluster-management.io/standards: NIST SP 800-53

spec:

remediationAction: inform

disabled: false

policy-templates:

- objectDefinition:

apiVersion: policy.open-cluster-management.io/v1

kind: ConfigurationPolicy

metadata:

name: group-du-ptp-config-policy-config

spec:

remediationAction: inform

severity: low

namespaceselector:

exclude:

- kube-*

include:

- '*'

object-templates:

- complianceType: musthave

objectDefinition:

apiVersion: ptp.openshift.io/v1

kind: PtpConfig

metadata:

name: du-ptp-slave

namespace: openshift-ptp

spec:

recommend:

- match:

- nodeLabel: node-role.kubernetes.io/worker-du

priority: 4

profile: slave

profile:

- interface: ens5f0

name: slave

phc2sysOpts: -a -r -n 24

ptp4lConf: |

[global]

#

# Default Data Set

#

twoStepFlag 1

slaveOnly 0

priority1 128

priority2 128

domainNumber 24

.....5.2. PolicyGenTemplate CR을 사용자 정의할 때 권장 사항

사이트 구성 PolicyGenTemplate CR(사용자 정의 리소스)을 사용자 정의할 때 다음과 같은 모범 사례를 고려하십시오.

-

필요한 만큼의 정책을 사용하십시오. 정책을 더 적게 사용하려면 더 적은 리소스가 필요합니다. 각 추가 정책은 허브 클러스터 및 배포된 관리 클러스터에 대한 오버헤드를 생성합니다. CR은

PolicyGenTemplateCR의policyName필드를 기반으로 정책에 결합됩니다.policyName에 동일한 값이 있는 동일한PolicyGenTemplate의 CR은 단일 정책으로 관리됩니다. -

연결이 끊긴 환경에서는 모든 Operator가 포함된 단일 인덱스로 레지스트리를 구성하여 모든 Operator에 대해 단일 카탈로그 소스를 사용합니다. 관리 클러스터의 각 추가

CatalogSourceCR은 CPU 사용량을 늘립니다. -

MachineConfigCR은 설치 중에 적용되도록SiteConfigCR에서extraManifests로 포함되어야 합니다. 이를 통해 클러스터가 애플리케이션을 배포할 준비가 될 때까지 걸리는 전체 시간을 줄일 수 있습니다. -

PolicyGenTemplates는 원하는 버전을 명시적으로 식별하도록 channel 필드를 재정의해야 합니다. 이렇게 하면 업그레이드 중에 소스 CR의 변경이 생성된 서브스크립션을 업데이트하지 않습니다.

추가 리소스

- RHACM을 사용한 클러스터 스케일링에 대한 권장 사항은 성능 및 확장성을 참조하십시오.

허브 클러스터에서 많은 수의 음성 클러스터를 관리할 때 정책 수를 최소화하여 리소스 소비를 줄입니다.

여러 구성 CR을 단일 또는 제한된 정책으로 그룹화하는 것이 허브 클러스터의 전체 정책 수를 줄이는 한 가지 방법입니다. 사이트 구성을 관리하기 위한 공통, 그룹 및 사이트 계층 구조를 사용하는 경우 사이트별 구성을 단일 정책으로 결합하는 것이 특히 중요합니다.

5.3. RAN 배포를 위한 PolicyGenTemplate CR

PBT( PolicyGenTemplate ) 사용자 정의 리소스(CR)를 사용하여ZTP( GitOps Zero Touch Provisioning) 파이프라인을 사용하여 클러스터에 적용되는 구성을 사용자 지정합니다. PGT CR을 사용하면 클러스터의 구성 CR 세트를 관리하는 하나 이상의 정책을 생성할 수 있습니다. PGT는 관리되는 CR 세트를 식별하고, 정책에 번들로 연결하며, 해당 CR을 래핑하는 정책을 구축하고, 라벨 바인딩 규칙을 사용하여 정책을 클러스터와 연결합니다.

GitOps ZTP 컨테이너에서 얻은 참조 구성은 클러스터가 RAN(Radio Access Network) 분산 단위(DU) 애플리케이션의 엄격한 성능 및 리소스 사용률 제약 조건을 지원할 수 있도록 중요한 기능 및 노드 튜닝 설정 세트를 제공하도록 설계되었습니다. 기준 구성의 변경 사항 또는 누락은 기능 가용성, 성능 및 리소스 사용률에 영향을 미칠 수 있습니다. 참조 PolicyGenTemplate CR을 기준으로 사용하여 특정 사이트 요구 사항에 맞는 구성 파일의 계층 구조를 생성합니다.

RAN DU 클러스터 구성에 정의된 기본 PolicyGenTemplate CR은 GitOps ZTP ztp-site-generate 컨테이너에서 추출할 수 있습니다. 자세한 내용은 " GitOps ZTP 사이트 구성 리포지토리 준비"를 참조하십시오.

PolicyGenTemplate CR은 ./out/argocd/example/policygentemplates 폴더에서 확인할 수 있습니다. 참조 아키텍처에는 공통, 그룹 및 사이트별 구성 CR이 있습니다. 각 PolicyGenTemplate CR은 ./out/source-crs 폴더에 있는 다른 CR을 나타냅니다.

RAN 클러스터 구성과 관련된 PolicyGenTemplate CR은 다음과 같습니다. 단일 노드, 3-노드 컴팩트 및 표준 클러스터 구성의 차이점을 고려하여 PolicyGenTemplate CR 그룹에 변형이 제공됩니다. 마찬가지로 단일 노드 클러스터 및 다중 노드(콤팩트 또는 표준) 클러스터에 대해 사이트별 구성 변형이 제공됩니다. 배포와 관련된 그룹 및 사이트별 구성 변형을 사용합니다.

표 5.1. RAN 배포를 위한 PolicyGenTemplate CR

| PolicyGenTemplate CR | 설명 |

|---|---|

|

| 다중 노드 클러스터에 적용되는 CR 세트를 포함합니다. 이러한 CR은 RAN 설치에 일반적인 SR-IOV 기능을 구성합니다. |

|

| 단일 노드 OpenShift 클러스터에 적용되는 CR 세트를 포함합니다. 이러한 CR은 RAN 설치에 일반적인 SR-IOV 기능을 구성합니다. |

|

| 모든 클러스터에 적용되는 공통 RAN CR 세트를 포함합니다. 이러한 CR은 RAN 및 기본 클러스터 튜닝에 일반적인 클러스터 기능을 제공하는 Operator 세트에 서브스크립션합니다. |

|

| 3-노드 클러스터에 대한 RAN 정책만 포함합니다. |

|

| 단일 노드 클러스터에 대한 RAN 정책만 포함합니다. |

|

| 표준 세 개의 컨트롤 플레인 클러스터에 대한 RAN 정책을 포함합니다. |

|

|

3-노드 클러스터에 필요한 다양한 정책을 생성하는 데 사용되는 |

|

|

표준 클러스터에 필요한 다양한 정책을 생성하는 데 사용되는 |

|

|

단일 노드 OpenShift 클러스터에 필요한 다양한 정책을 생성하는 데 사용되는 |

추가 리소스

5.4. PolicyGenTemplate CR을 사용하여 관리 클러스터 사용자 정의

다음 절차에 따라 ZTP(ZTP) 파이프라인을 사용하여 프로비저닝하는 관리 클러스터에 적용할 수 있는 정책을 사용자 지정할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다. - 필요한 설치 및 정책 CR을 생성하도록 허브 클러스터를 구성했습니다.

- 사용자 지정 사이트 구성 데이터를 관리하는 Git 리포지토리를 생성하셨습니다. 리포지토리는 hub 클러스터에서 액세스할 수 있어야 하며 Argo CD 애플리케이션의 소스 리포지토리로 정의해야 합니다.

프로세스

사이트별 구성 CR에 대한

PolicyGenTemplateCR을 생성합니다.-

out/argocd/example/policygentemplates폴더에서 CR에 대한 적절한 예를 선택합니다(예:example-sno-site.yaml또는example-multinode-site.yaml). 예제 파일의

bindingRules필드를 siteConfigCR에 포함된 사이트별 레이블과 일치하도록 변경합니다. 예제SiteConfig파일에서 사이트별 레이블은sites: example-sno입니다.참고PolicyGenTemplatebindingRules필드에 정의된 라벨이 관련 관리 클러스터 siteConfigCR에 정의된 라벨에 해당하는지 확인합니다.- 예제 파일의 콘텐츠를 원하는 구성과 일치하도록 변경합니다.

-

선택 사항: 전체 클러스터에 적용되는 일반적인 구성 CR에 대한

PolicyGenTemplateCR을 생성합니다.-

out/argocd/example/policygentemplates폴더에서 CR에 대한 적절한 예를 선택합니다(예:common-ranGen.yaml). - 예제 파일의 콘텐츠를 원하는 구성과 일치하도록 변경합니다.

-

선택 사항: 플릿의 특정 클러스터 그룹에 적용되는 모든 그룹 구성 CR에 대해

PolicyGenTemplateCR을 생성합니다.overlaid 사양 파일의 내용이 원하는 최종 상태와 일치하는지 확인합니다. 참조로 out/source-crs 디렉터리에는 PolicyGenTemplate 템플릿에서 포함할 수 있는 source-crs의 전체 목록이 포함되어 있습니다.

참고클러스터의 특정 요구 사항에 따라 클러스터 유형당 단일 그룹 정책이 필요할 수 있습니다. 특히 예제 그룹 정책에는 각각 동일한 하드웨어 구성으로 구성된 클러스터 집합에서만 공유할 수 있는 단일 PerformancePolicy.yaml 파일이 있습니다.

-

out/argocd/example/policygentemplates폴더에서 CR에 대한 적절한 예를 선택합니다(예:group-du-sno-ranGen.yaml). - 예제 파일의 콘텐츠를 원하는 구성과 일치하도록 변경합니다.

-

-

선택 사항: 배포된 클러스터의 GitOps ZTP 설치 및 구성이 완료되면 정책

PolicyGenTemplateCR을 생성합니다. 자세한 내용은 "검토 확인 정보 정책 생성"을 참조하십시오. example

out/argocd/example/policygentemplates/ns.yaml파일과 유사한 YAML 파일에서 모든 정책 네임스페이스를 정의합니다.중요PolicyGenTemplateCR과 동일한 파일에NamespaceCR을 포함하지 마십시오.-

out/argocd/example/policygentemplates/에 표시된 예제와 유사하게kustomization.yamlPolicyGenTemplateCR 및NamespaceCR을 generators 섹션의 kustomization.yaml 파일에 추가합니다. Git 리포지토리에서

PolicyGenTemplateCR,NamespaceCR 및 관련kustomization.yaml파일을 커밋하고 변경 사항을 내보냅니다.ArgoCD 파이프라인은 변경 사항을 감지하고 관리 클러스터 배포를 시작합니다. 변경 사항을

SiteConfigCR 및PolicyGenTemplateCR에 동시에 푸시할 수 있습니다.

5.5. 관리형 클러스터 정책 배포 진행 상황 모니터링

ArgoCD 파이프라인은 Git의 PolicyGenTemplate CR을 사용하여 RHACM 정책을 생성한 다음 hub 클러스터에 동기화합니다. 지원 서비스가 관리형 클러스터에 OpenShift Container Platform을 설치한 후 관리 클러스터 정책 동기화의 진행 상황을 모니터링할 수 있습니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

Topology Aware Lifecycle Manager(TALM)는 클러스터에 바인딩된 구성 정책을 적용합니다.

클러스터 설치가 완료되고 클러스터가

Ready가 되면ran.openshift.io/ztp-deploy-ECDHE 주석에의해 정의된 정렬된 정책 목록과 함께 이 클러스터에 해당하는ClusterGroupUpgradeCR이 TALM에 의해 자동으로 생성됩니다. 클러스터의 정책은ClusterGroupUpgradeCR에 나열된 순서대로 적용됩니다.다음 명령을 사용하여 구성 정책 조정의 고급 진행 상황을 모니터링할 수 있습니다.

$ export CLUSTER=<clusterName>

$ oc get clustergroupupgrades -n ztp-install $CLUSTER -o jsonpath='{.status.conditions[-1:]}' | jq출력 예

{ "lastTransitionTime": "2022-11-09T07:28:09Z", "message": "Remediating non-compliant policies", "reason": "InProgress", "status": "True", "type": "Progressing" }RHACM 대시보드 또는 명령줄을 사용하여 자세한 클러스터 정책 규정 준수 상태를 모니터링할 수 있습니다.

oc를 사용하여 정책 규정 준수를 확인하려면 다음 명령을 실행합니다.$ oc get policies -n $CLUSTER

출력 예

NAME REMEDIATION ACTION COMPLIANCE STATE AGE ztp-common.common-config-policy inform Compliant 3h42m ztp-common.common-subscriptions-policy inform NonCompliant 3h42m ztp-group.group-du-sno-config-policy inform NonCompliant 3h42m ztp-group.group-du-sno-validator-du-policy inform NonCompliant 3h42m ztp-install.example1-common-config-policy-pjz9s enforce Compliant 167m ztp-install.example1-common-subscriptions-policy-zzd9k enforce NonCompliant 164m ztp-site.example1-config-policy inform NonCompliant 3h42m ztp-site.example1-perf-policy inform NonCompliant 3h42m

RHACM 웹 콘솔에서 정책 상태를 확인하려면 다음 작업을 수행합니다.

- Governance → policies 찾기를 클릭합니다.

- 클러스터 정책을 클릭하여 상태를 확인합니다.

모든 클러스터 정책이 준수되면 클러스터의 GitOps ZTP 설치 및 구성이 완료됩니다. ztp-done 레이블이 클러스터에 추가되었습니다.

참조 구성에서 준수되는 최종 정책은 *-du-validator-policy 정책에 정의된 정책입니다. 클러스터 준수 시 이 정책은 모든 클러스터 구성, Operator 설치 및 Operator 구성이 완료되었는지 확인합니다.

5.6. 구성 정책 CR 생성 검증

정책 CR(사용자 정의 리소스)은 해당 리소스가 생성된 PolicyGenTemplate 과 동일한 네임스페이스에 생성됩니다. 동일한 문제 해결 흐름은 다음 명령을 사용하여 표시된 것처럼 ztp-common,ztp-group 또는 ztp-site 기반 여부에 관계없이 PolicyGenTemplate 에서 생성된 모든 정책 CR에 적용됩니다.

$ export NS=<namespace>

$ oc get policy -n $NS

정책 래핑된 CR의 예상 세트가 표시되어야 합니다.

정책 동기화에 실패한 경우 다음 문제 해결 단계를 사용하십시오.

프로세스

정책에 대한 자세한 정보를 표시하려면 다음 명령을 실행합니다.

$ oc describe -n openshift-gitops application policies

Status: Conditions:를 확인하여 오류 로그를 표시합니다. 예를 들어 잘못된sourceFile CryostatfileName:을 설정하면 다음과 같은 오류가 생성됩니다.Status: Conditions: Last Transition Time: 2021-11-26T17:21:39Z Message: rpc error: code = Unknown desc = `kustomize build /tmp/https___git.com/ran-sites/policies/ --enable-alpha-plugins` failed exit status 1: 2021/11/26 17:21:40 Error could not find test.yaml under source-crs/: no such file or directory Error: failure in plugin configured via /tmp/kust-plugin-config-52463179; exit status 1: exit status 1 Type: ComparisonError상태 확인: 동기화:.Status: Conditions:에 로그 오류가 있는 경우Status: Sync:showsUnknownorError:Status: Sync: Compared To: Destination: Namespace: policies-sub Server: https://kubernetes.default.svc Source: Path: policies Repo URL: https://git.com/ran-sites/policies/.git Target Revision: master Status: ErrorRHACM(Red Hat Advanced Cluster Management)에서

ManagedCluster오브젝트에 정책이 적용되는 것을 인식하면 정책 CR 오브젝트가 클러스터 네임스페이스에 적용됩니다. 정책이 클러스터 네임스페이스에 복사되었는지 확인합니다.$ oc get policy -n $CLUSTER

출력 예:

NAME REMEDIATION ACTION COMPLIANCE STATE AGE ztp-common.common-config-policy inform Compliant 13d ztp-common.common-subscriptions-policy inform Compliant 13d ztp-group.group-du-sno-config-policy inform Compliant 13d Ztp-group.group-du-sno-validator-du-policy inform Compliant 13d ztp-site.example-sno-config-policy inform Compliant 13d

RHACM은 적용 가능한 모든 정책을 클러스터 네임스페이스에 복사합니다. 복사된 정책 이름의 형식은 <

policyGenTemplate.Namespace>.<policyGenTemplate.Name>-<policyName>입니다.클러스터 네임스페이스에 복사되지 않은 모든 정책의 배치 규칙을 확인합니다. 해당 정책에 대한

PlacementRule의matchSelector는ManagedCluster오브젝트의 라벨과 일치해야 합니다.$ oc get placementrule -n $NS

다음 명령을 사용하여 누락된 정책, 공통, 그룹 또는 사이트에 적절한

PlacementRule이름을 확인합니다.$ oc get placementrule -n $NS <placementRuleName> -o yaml

- status-decisions에는 클러스터 이름이 포함되어야 합니다.

-

사양에 있는

matchSelector의 키-값 쌍은 관리 클러스터의 라벨과 일치해야 합니다.

다음 명령을 사용하여

ManagedCluster오브젝트에서 라벨을 확인합니다.$ oc get ManagedCluster $CLUSTER -o jsonpath='{.metadata.labels}' | jq다음 명령을 사용하여 호환되는 정책을 확인합니다.

$ oc get policy -n $CLUSTER

네임스페이스

,OperatorGroup및서브스크립션정책이 호환되지만 Operator 구성 정책이 적용되지 않은 경우 Operator가 관리 클러스터에 설치되지 않을 수 있습니다. 이로 인해 CRD가 아직 spoke에 적용되지 않았기 때문에 Operator 구성 정책이 적용되지 않습니다.

5.7. 정책 조정 다시 시작

예를 들어 ClusterGroupUpgrade CR(사용자 정의 리소스)이 시간 초과된 경우 예기치 않은 규정 준수 문제가 발생하면 정책 조정을 다시 시작할 수 있습니다.

프로세스

ClusterGroupUpgradeCR은 관리 클러스터가Ready가 된 후 토폴로지 Aware Lifecycle Manager를 통해ztp-install네임스페이스에 생성됩니다.$ export CLUSTER=<clusterName>

$ oc get clustergroupupgrades -n ztp-install $CLUSTER

예기치 않은 문제가 있고 정책이 구성된 시간 내에 불만이 발생하지 않는 경우(기본값은 4시간)

ClusterGroupUpgradeCR의 상태에UpgradeTimedOut이 표시됩니다.$ oc get clustergroupupgrades -n ztp-install $CLUSTER -o jsonpath='{.status.conditions[?(@.type=="Ready")]}'UpgradeTimedOut상태의ClusterGroupUpgradeCR은 시간마다 정책 조정을 자동으로 다시 시작합니다. 정책을 변경한 경우 기존ClusterGroupUpgradeCR을 삭제하여 즉시 재시도를 시작할 수 있습니다. 이렇게 하면 새ClusterGroupUpgradeCR의 자동 생성이 트리거되고 즉시 정책 조정이 시작됩니다.$ oc delete clustergroupupgrades -n ztp-install $CLUSTER

ClusterGroupUpgrade CR이 UpgradeCompleted 상태로 완료되고 관리 클러스터에 ztp-done 레이블이 적용된 경우 PolicyGenTemplate 을 사용하여 추가 구성을 변경할 수 있습니다. 기존 ClusterGroupUpgrade CR을 삭제하면 TALM에서 새 CR이 생성되지 않습니다.

이 시점에서 GitOps ZTP는 클러스터와의 상호 작용을 완료했으며 추가 상호 작용을 업데이트 및 정책 수정을 위해 생성된 새 ClusterGroupUpgrade CR로 처리해야 합니다.

추가 리소스

-

TALM( Topology Aware Lifecycle Manager)을 사용하여 자체

ClusterGroupUpgradeCR을 구성하는 방법에 대한 자세한 내용은 ClusterGroupUpgrade CR 정보를 참조하십시오.

5.8. 정책을 사용하여 적용된 관리 클러스터 CR 변경

정책을 통해 관리 클러스터에 배포된 CR(사용자 정의 리소스)에서 콘텐츠를 제거할 수 있습니다.

기본적으로 CR에서 생성된 모든 Policy CR에는 Policy GenTemplatecomplianceType 필드가 musthave 로 설정되어 있습니다. 관리 클러스터의 CR에 지정된 콘텐츠가 모두 있으므로 제거된 콘텐츠가 없는 musthave 정책은 계속 호환됩니다. 이 구성을 사용하면 CR에서 콘텐츠를 제거할 때 TALM은 정책에서 콘텐츠를 제거하지만 콘텐츠는 관리 클러스터의 CR에서 제거되지 않습니다.

mustonlyhave 에 complianceType 필드를 사용하면 정책에서 클러스터의 CR이 정책에 지정된 내용과 정확히 일치하도록 합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다. - RHACM을 실행하는 허브 클러스터에서 관리 클러스터를 배포했습니다.

- hub 클러스터에 Topology Aware Lifecycle Manager를 설치했습니다.

프로세스

영향을 받는 CR에서 더 이상 필요하지 않은 콘텐츠를 제거합니다. 이 예에서는

disableDrain: false행이SriovOperatorConfigCR에서 제거되었습니다.CR 예

apiVersion: sriovnetwork.openshift.io/v1 kind: SriovOperatorConfig metadata: name: default namespace: openshift-sriov-network-operator spec: configDaemonNodeSelector: "node-role.kubernetes.io/$mcp": "" disableDrain: true enableInjector: true enableOperatorWebhook: true영향을 받는 정책의

complianceType을group-du-sno-ranGen.yaml파일에서mustonlyhave로 변경합니다.YAML의 예

# ... - fileName: SriovOperatorConfig.yaml policyName: "config-policy" complianceType: mustonlyhave # ...

ClusterGroupUpdatesCR을 생성하고 CR 변경 사항을 받아야 하는 클러스터를 지정합니다.ClusterGroupUpdates CR의 예

apiVersion: ran.openshift.io/v1alpha1 kind: ClusterGroupUpgrade metadata: name: cgu-remove namespace: default spec: managedPolicies: - ztp-group.group-du-sno-config-policy enable: false clusters: - spoke1 - spoke2 remediationStrategy: maxConcurrency: 2 timeout: 240 batchTimeoutAction:다음 명령을 실행하여

ClusterGroupUpgradeCR을 생성합니다.$ oc create -f cgu-remove.yaml

적절한 유지 관리 기간 동안 변경 사항을 적용할 준비가 되면 다음 명령을 실행하여

spec.enable필드의 값을true로 변경합니다.$ oc --namespace=default patch clustergroupupgrade.ran.openshift.io/cgu-remove \ --patch '{"spec":{"enable":true}}' --type=merge

검증

다음 명령을 실행하여 정책의 상태를 확인합니다.

$ oc get <kind> <changed_cr_name>

출력 예

NAMESPACE NAME REMEDIATION ACTION COMPLIANCE STATE AGE default cgu-ztp-group.group-du-sno-config-policy enforce 17m default ztp-group.group-du-sno-config-policy inform NonCompliant 15h

정책의

COMPLIANCE STATE가Compliant인 경우 CR이 업데이트되고 원하지 않는 콘텐츠가 제거됨을 의미합니다.관리 클러스터에서 다음 명령을 실행하여 정책이 대상 클러스터에서 제거되었는지 확인합니다.

$ oc get <kind> <changed_cr_name>

결과가 없는 경우 관리 클러스터에서 CR이 제거됩니다.

5.9. GitOps ZTP 설치에 대해 수행됨 표시

GitOps ZTP(ZTP)는 클러스터의 GitOps ZTP 설치 상태를 확인하는 프로세스를 단순화합니다. GitOps ZTP 상태는 클러스터 설치, 클러스터 구성 및 GitOps ZTP의 세 단계로 이동합니다.

- 클러스터 설치 단계

-

클러스터 설치 단계는 ManagedCluster CR의

ManagedClusterJoined및ManagedClusterAvailableManagedClusterCR에 이러한 조건이 없거나 조건이False로 설정되어 있는 경우 클러스터는 여전히 설치 단계에 있습니다. 설치에 대한 자세한 내용은AgentClusterInstall및ClusterDeploymentCR에서 확인할 수 있습니다. 자세한 내용은 "Troubleshooting GitOps ZTP"를 참조하십시오. - 클러스터 구성 단계

-

클러스터 구성 단계는 클러스터의

ManagedClusterCR을 적용한ztp 실행라벨에 의해 표시됩니다. - GitOps ZTP 완료

GitOps ZTP 완료 단계에서 클러스터 설치 및 구성이 완료됩니다. 이는

ztp-running레이블을 제거하고ztp-done레이블을ManagedClusterCR에 추가하여 표시됩니다.ztp-done레이블은 구성이 적용되었으며 기준 DU 구성이 클러스터 튜닝을 완료했음을 보여줍니다.GitOps ZTP done 상태로의 전환은 RHACM(Red Hat Advanced Cluster Management) 검증 검증 정보 정책의 준수 상태에서 조건부입니다. 이 정책은 완료된 설치에 대한 기존 기준을 캡처하고 관리 클러스터의 GitOps ZTP 프로비저닝이 완료된 경우에만 규정 준수 상태로 이동하는지 확인합니다.

검증기 정보 정책은 클러스터 구성이 완전히 적용되고 Operator가 초기화를 완료하도록 합니다. 정책은 다음을 확인합니다.

-

대상

MachineConfigPool에는 예상되는 항목이 포함되어 있으며 업데이트가 완료되었습니다. 모든 노드를 사용할 수 있으며 성능이 저하되지 않습니다. -

SR-IOV Operator는

syncStatus: Succeeded가 있는 하나 이상의SriovNetworkNodeState에 표시된 대로 초기화를 완료했습니다. - PTP Operator 데몬 세트가 있습니다.

-

대상

6장. ZTP를 사용하여 단일 노드 OpenShift 클러스터 수동 설치

RHACM(Red Hat Advanced Cluster Management) 및 지원 서비스를 사용하여 관리형 단일 노드 OpenShift 클러스터를 배포할 수 있습니다.

여러 개의 관리 클러스터를 생성하는 경우 ZTP를 사용하여 멀리 엣지 사이트 배포에 설명된 site Config 방법을 사용하십시오.

대상 베어 메탈 호스트는 vDU 애플리케이션 워크로드에 대한 권장 클러스터 구성에 나열된 네트워킹, 펌웨어 및 하드웨어 요구 사항을 충족해야 합니다.

6.1. 수동으로 GitOps ZTP 설치 및 구성 CR 생성

ztp-site-generate 컨테이너의 생성기 진입점을 사용하여 SiteConfig 및 PolicyGenTemplate CR을 기반으로 클러스터에 대한 사이트 설치 및 구성 CR(사용자 정의 리소스)을 생성합니다.

사전 요구 사항

-

OpenShift CLI(

oc)가 설치되어 있습니다. -

cluster-admin권한이 있는 사용자로 hub 클러스터에 로그인했습니다.

프로세스

다음 명령을 실행하여 출력 폴더를 생성합니다.

$ mkdir -p ./out

ztp-site-generate컨테이너 이미지에서argocd디렉터리를 내보냅니다.$ podman run --log-driver=none --rm registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.15 extract /home/ztp --tar | tar x -C ./out

./out디렉터리에는out/argocd/example/폴더에PolicyGenTemplate및SiteConfigCR이 있습니다.출력 예

out └── argocd └── example ├── policygentemplates │ ├── common-ranGen.yaml │ ├── example-sno-site.yaml │ ├── group-du-sno-ranGen.yaml │ ├── group-du-sno-validator-ranGen.yaml │ ├── kustomization.yaml │ └── ns.yaml └── siteconfig ├── example-sno.yaml ├── KlusterletAddonConfigOverride.yaml └── kustomization.yaml사이트 설치 CR의 출력 폴더를 생성합니다.

$ mkdir -p ./site-install

설치할 클러스터 유형에 대한

SiteConfigCR 예제를 수정합니다.example-sno.yaml을site-1-sno.yaml에 복사하고 설치할 사이트 및 베어 메탈 호스트의 세부 정보와 일치하도록 CR을 수정합니다. 예를 들면 다음과 같습니다.# example-node1-bmh-secret & assisted-deployment-pull-secret need to be created under same namespace example-sno --- apiVersion: ran.openshift.io/v1 kind: SiteConfig metadata: name: "example-sno" namespace: "example-sno" spec: baseDomain: "example.com" pullSecretRef: name: "assisted-deployment-pull-secret" clusterImageSetNameRef: "openshift-4.10" sshPublicKey: "ssh-rsa AAAA..." clusters: - clusterName: "example-sno" networkType: "OVNKubernetes" # installConfigOverrides is a generic way of passing install-config # parameters through the siteConfig. The 'capabilities' field configures # the composable openshift feature. In this 'capabilities' setting, we # remove all but the marketplace component from the optional set of # components. # Notes: # - NodeTuning is needed for 4.13 and later, not for 4.12 and earlier installConfigOverrides: "{\"capabilities\":{\"baselineCapabilitySet\": \"None\", \"additionalEnabledCapabilities\": [ \"marketplace\", \"NodeTuning\" ] }}" # It is strongly recommended to include crun manifests as part of the additional install-time manifests for 4.13+. # The crun manifests can be obtained from source-crs/optional-extra-manifest/ and added to the git repo ie.sno-extra-manifest. # extraManifestPath: sno-extra-manifest clusterLabels: # These example cluster labels correspond to the bindingRules in the PolicyGenTemplate examples du-profile: "4.14" # These example cluster labels correspond to the bindingRules in the PolicyGenTemplate examples in ../policygentemplates: # ../policygentemplates/common-ranGen.yaml will apply to all clusters with 'common: true' common: true # ../policygentemplates/group-du-sno-ranGen.yaml will apply to all clusters with 'group-du-sno: ""' group-du-sno: "" # ../policygentemplates/example-sno-site.yaml will apply to all clusters with 'sites: "example-sno"' # Normally this should match or contain the cluster name so it only applies to a single cluster sites: "example-sno" clusterNetwork: - cidr: 1001:1::/48 hostPrefix: 64 machineNetwork: - cidr: 1111:2222:3333:4444::/64 serviceNetwork: - 1001:2::/112 additionalNTPSources: - 1111:2222:3333:4444::2 # Initiates the cluster for workload partitioning. Setting specific reserved/isolated CPUSets is done via PolicyTemplate # please see Workload Partitioning Feature for a complete guide. cpuPartitioningMode: AllNodes # Optionally; This can be used to override the KlusterletAddonConfig that is created for this cluster: #crTemplates: # KlusterletAddonConfig: "KlusterletAddonConfigOverride.yaml" nodes: - hostName: "example-node1.example.com" role: "master" # Optionally; This can be used to configure desired BIOS setting on a host: #biosConfigRef: # filePath: "example-hw.profile" bmcAddress: "idrac-virtualmedia+https://[1111:2222:3333:4444::bbbb:1]/redfish/v1/Systems/System.Embedded.1" bmcCredentialsName: name: "example-node1-bmh-secret" bootMACAddress: "AA:BB:CC:DD:EE:11" # Use UEFISecureBoot to enable secure boot bootMode: "UEFI" rootDeviceHints: wwn: "0x11111000000asd123" # example of diskPartition below is used for image registry (check ImageRegistry.md for more details), but it's not limited to this use case # diskPartition: # - device: /dev/disk/by-id/wwn-0x11111000000asd123 # match rootDeviceHints # partitions: # - mount_point: /var/imageregistry # size: 102500 # start: 344844 nodeNetwork: interfaces: - name: eno1 macAddress: "AA:BB:CC:DD:EE:11" config: interfaces: - name: eno1 type: ethernet state: up ipv4: enabled: false ipv6: enabled: true address: # For SNO sites with static IP addresses, the node-specific, # API and Ingress IPs should all be the same and configured on # the interface - ip: 1111:2222:3333:4444::aaaa:1 prefix-length: 64 dns-resolver: config: search: - example.com server: - 1111:2222:3333:4444::2 routes: config: - destination: ::/0 next-hop-interface: eno1 next-hop-address: 1111:2222:3333:4444::1 table-id: 254참고ztp-site-generate컨테이너의out/extra-manifest디렉터리에서 참조 CR 구성 파일을 추출하면extraManifests.searchPaths를 사용하여 해당 파일이 포함된 git 디렉터리의 경로를 포함할 수 있습니다. 그러면 GitOps ZTP 파이프라인에서 클러스터 설치 중에 해당 CR 파일을 적용할 수 있습니다.searchPaths디렉터리를 구성하면 GitOps ZTP 파이프라인에서 사이트를 설치하는 동안ztp-site-generate컨테이너에서 매니페스트를 가져오지 않습니다.다음 명령을 실행하여 수정된

SiteConfigCRsite-1-sno.yaml을 처리하여 0일 설치 CR을 생성합니다.$ podman run -it --rm -v `pwd`/out/argocd/example/siteconfig:/resources:Z -v `pwd`/site-install:/output:Z,U registry.redhat.io/openshift4/ztp-site-generate-rhel8:v4.15 generator install site-1-sno.yaml /output

출력 예

site-install └── site-1-sno ├── site-1_agentclusterinstall_example-sno.yaml ├── site-1-sno_baremetalhost_example-node1.example.com.yaml ├── site-1-sno_clusterdeployment_example-sno.yaml ├── site-1-sno_configmap_example-sno.yaml ├── site-1-sno_infraenv_example-sno.yaml ├── site-1-sno_klusterletaddonconfig_example-sno.yaml ├── site-1-sno_machineconfig_02-master-workload-partitioning.yaml ├── site-1-sno_machineconfig_predefined-extra-manifests-master.yaml ├── site-1-sno_machineconfig_predefined-extra-manifests-worker.yaml ├── site-1-sno_managedcluster_example-sno.yaml ├── site-1-sno_namespace_example-sno.yaml └── site-1-sno_nmstateconfig_example-node1.example.com.yaml선택 사항:

-E옵션으로 참조SiteConfigCR을 처리하여 특정 클러스터 유형에 대한 Day 0MachineConfig설치 CR만 생성합니다. 예를 들어 다음 명령을 실행합니다.MachineConfigCR의 출력 폴더를 생성합니다.$ mkdir -p ./site-machineconfig