Gestion, surveillance et mise à jour du noyau

Guide de gestion du noyau Linux sur Red Hat Enterprise Linux 9

Résumé

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Le noyau Linux

Découvrez le noyau Linux et le paquetage RPM du noyau Linux fourni et maintenu par Red Hat (Red Hat kernel). Maintenir le noyau Red Hat à jour, ce qui garantit que le système d'exploitation dispose de toutes les dernières corrections de bogues, améliorations de performances et correctifs, et qu'il est compatible avec le nouveau matériel.

1.1. Ce qu'est le noyau

Le noyau est une partie centrale du système d'exploitation Linux qui gère les ressources du système et fournit une interface entre le matériel et les applications logicielles. Le noyau Red Hat est un noyau personnalisé basé sur le noyau Linux principal en amont, que les ingénieurs de Red Hat développent et renforcent en mettant l'accent sur la stabilité et la compatibilité avec les technologies et le matériel les plus récents.

Avant que Red Hat ne publie une nouvelle version du noyau, celui-ci doit passer un ensemble de tests d'assurance qualité rigoureux.

Les noyaux Red Hat sont empaquetés au format RPM afin d'être facilement mis à niveau et vérifiés par le dnf gestionnaire de paquets.

Les noyaux qui n'ont pas été compilés par Red Hat sont not pris en charge par Red Hat.

1.2. Paquets RPM

Un paquetage RPM est un fichier contenant d'autres fichiers et leurs métadonnées (informations sur les fichiers nécessaires au système).

Plus précisément, un paquetage RPM se compose de l'archive cpio.

L'archive cpio contient :

- Dossiers

En-tête RPM (métadonnées du paquet)

Le gestionnaire de paquets

rpmutilise ces métadonnées pour déterminer les dépendances, l'endroit où installer les fichiers et d'autres informations.

Types de paquets RPM

Il existe deux types de paquets RPM. Les deux types partagent le format de fichier et l'outillage, mais ont des contenus différents et servent des objectifs différents :

Source RPM (SRPM)

Un SRPM contient le code source et un fichier SPEC, qui décrit comment construire le code source en un RPM binaire. En option, les correctifs du code source sont également inclus.

RPM binaire

Un RPM binaire contient les binaires construits à partir des sources et des correctifs.

1.3. Aperçu des paquets RPM du noyau Linux

Le RPM kernel est un méta-paquet qui ne contient aucun fichier, mais qui s'assure que les sous-paquets suivants sont correctement installés :

-

kernel-core- contient l'image binaire du noyau Linux (vmlinuz). -

kernel-modules-core- contient les modules de base du noyau pour assurer la fonctionnalité de base. Il s'agit des modules essentiels au bon fonctionnement du matériel le plus couramment utilisé. -

kernel-modules- contient les modules restants du noyau qui ne sont pas présents danskernel-core.

Les sous-paquets kernel-core et kernel-modules-core peuvent être utilisés dans des environnements virtualisés et en nuage pour fournir un noyau RHEL 9 avec un temps de démarrage rapide et un faible encombrement sur le disque. Le sous-paquet kernel-modules n'est généralement pas nécessaire pour de tels déploiements.

Les paquets optionnels du noyau sont par exemple

-

kernel-modules-extra- contient des modules de noyau pour du matériel rare et des modules dont le chargement est désactivé par défaut. -

kernel-debug- contient un noyau avec de nombreuses options de débogage activées pour le diagnostic du noyau, au détriment des performances. -

kernel-tools- contient des outils pour manipuler le noyau Linux et de la documentation. -

kernel-devel- contient les en-têtes du noyau et les fichiers makefiles nécessaires à la construction de modules à partir du paquetagekernel. -

kernel-abi-stablelists- contient des informations relatives à l'ABI du noyau RHEL, notamment une liste des symboles du noyau qui sont nécessaires aux modules externes du noyau Linux et un plug-indnfpour faciliter la mise en œuvre. -

kernel-headers- comprend les fichiers d'en-tête C qui spécifient l'interface entre le noyau Linux et les bibliothèques et programmes de l'espace utilisateur. Les fichiers d'en-tête définissent les structures et les constantes nécessaires à la construction de la plupart des programmes standard. kernel-uki-virt- contient l'image unifiée du noyau (UKI) du noyau RHEL. L'UKI combine le noyau Linux,initramfs, et la ligne de commande du noyau en un seul binaire signé qui peut être démarré directement à partir du firmaware UEFI.kernel-uki-virtcontient les modules du noyau nécessaires pour fonctionner dans des environnements virtualisés et en nuage et peut être utilisé à la place du sous-paquetkernel-core.Importantkernel-uki-virtest fourni en tant qu'aperçu technologique dans RHEL 9.2.

Ressources supplémentaires

1.4. Affichage du contenu du paquetage du noyau

Affichez le contenu du paquet du noyau et de ses sous-paquets sans les installer à l'aide de la commande rpm.

Conditions préalables

-

Obtenu les paquets RPM

kernel,kernel-core,kernel-modules,kernel-modules-extrapour l'architecture de votre processeur

Procédure

Liste des modules pour

kernel:$ rpm -qlp <kernel_rpm>(contains no files) …-

Liste des modules pour

kernel-core:

$ rpm -qlp <kernel-core_rpm>

…

/lib/modules/5.14.0-1.el9.x86_64/kernel/fs/udf/udf.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/fs/xfs

/lib/modules/5.14.0-1.el9.x86_64/kernel/fs/xfs/xfs.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/kernel

/lib/modules/5.14.0-1.el9.x86_64/kernel/kernel/trace

/lib/modules/5.14.0-1.el9.x86_64/kernel/kernel/trace/ring_buffer_benchmark.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/lib

/lib/modules/5.14.0-1.el9.x86_64/kernel/lib/cordic.ko.xz

…-

Liste des modules pour

kernel-modules:

$ rpm -qlp <kernel-modules_rpm>

…

/lib/modules/5.14.0-1.el9.x86_64/kernel/drivers/infiniband/hw/mlx4/mlx4_ib.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/drivers/infiniband/hw/mlx5/mlx5_ib.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/drivers/infiniband/hw/qedr/qedr.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/drivers/infiniband/hw/usnic/usnic_verbs.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/kernel/drivers/infiniband/hw/vmw_pvrdma/vmw_pvrdma.ko.xz

…-

Liste des modules pour

kernel-modules-extra:

$ rpm -qlp <kernel-modules-extra_rpm>

…

/lib/modules/5.14.0-1.el9.x86_64/extra/net/sched/sch_cbq.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/extra/net/sched/sch_choke.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/extra/net/sched/sch_drr.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/extra/net/sched/sch_dsmark.ko.xz

/lib/modules/5.14.0-1.el9.x86_64/extra/net/sched/sch_gred.ko.xz

…Ressources supplémentaires

-

La page du manuel

rpm(8) - Paquets RPM

1.5. Mise à jour du noyau

Mettez à jour le noyau en utilisant le gestionnaire de paquets dnf le gestionnaire de paquets.

Procédure

Pour mettre à jour le noyau, entrez la commande suivante :

# dnf update kernelCette commande met à jour le noyau ainsi que toutes les dépendances vers la dernière version disponible.

- Redémarrez votre système pour que les modifications soient prises en compte.

Ressources supplémentaires

- gestionnaire de paquets

-

La page du manuel

dnf(8)

1.6. Installation de versions spécifiques du noyau

Installez de nouveaux noyaux à l'aide du dnf gestionnaire de paquets.

Procédure

Pour installer une version spécifique du noyau, entrez la commande suivante :

# dnf install kernel-{version}

Ressources supplémentaires

Chapitre 2. Gestion des modules du noyau

Découvrez les modules du noyau, comment afficher leurs informations et comment effectuer des tâches administratives de base avec les modules du noyau.

2.1. Introduction aux modules du noyau

Le noyau de Red Hat Enterprise Linux peut être étendu avec des éléments optionnels et supplémentaires de fonctionnalité, appelés modules de noyau, sans avoir à redémarrer le système. Sur Red Hat Enterprise Linux 9, les modules du noyau sont des codes supplémentaires du noyau qui sont intégrés dans des fichiers objets compressés <KERNEL_MODULE_NAME>.ko.xz.

Les fonctionnalités les plus courantes permises par les modules du noyau sont les suivantes :

- Pilote de périphérique qui ajoute la prise en charge d'un nouveau matériel

-

Prise en charge d'un système de fichiers tel que

GFS2ouNFS - Appels système

Sur les systèmes modernes, les modules du noyau sont automatiquement chargés en cas de besoin. Toutefois, dans certains cas, il est nécessaire de charger ou de décharger les modules manuellement.

Comme le noyau lui-même, les modules peuvent prendre des paramètres qui personnalisent leur comportement si nécessaire.

Des outils sont fournis pour vérifier quels modules sont en cours d'exécution, quels modules sont disponibles pour être chargés dans le noyau et quels sont les paramètres acceptés par un module. L'outil fournit également un mécanisme pour charger et décharger les modules du noyau dans le noyau en cours d'exécution.

2.2. Dépendances du module du noyau

Certains modules du noyau dépendent parfois d'un ou de plusieurs autres modules du noyau. Le fichier /lib/modules/<KERNEL_VERSION>/modules.dep contient une liste complète des dépendances des modules du noyau pour la version respective du noyau.

depmod

Le fichier de dépendances est généré par le programme depmod, qui fait partie du paquetage kmod. De nombreux utilitaires fournis par kmod prennent en compte les dépendances des modules lors de l'exécution des opérations, de sorte que le suivi des dépendances de manual est rarement nécessaire.

Le code des modules du noyau est exécuté dans l'espace du noyau en mode non restreint. Pour cette raison, vous devez faire attention aux modules que vous chargez.

weak-modules

En plus de depmod, Red Hat Enterprise Linux fournit le script weak-modules livré également avec le paquetage kmod. weak-modules détermine quels modules sont compatibles kABI avec les noyaux installés. Lors de la vérification de la compatibilité des modules avec le noyau, weak-modules traite les dépendances des symboles des modules de la version supérieure à la version inférieure du noyau pour lequel ils ont été construits. Cela signifie que weak-modules traite chaque module indépendamment de la version du noyau pour lequel il a été construit.

Ressources supplémentaires

-

La page du manuel

modules.dep(5) -

La page du manuel

depmod(8) - Quel est l'objectif du script weak-modules fourni avec Red Hat Enterprise Linux ?

- Qu'est-ce que l'interface binaire d'application du noyau (kABI) ?

2.3. Liste des modules du noyau installés

La commande grubby --info=ALL affiche une liste indexée des noyaux installés sur les installations !BLS et BLS.

Procédure

Lister les noyaux installés à l'aide de la commande suivante :

# grubby --info=ALL | grep titleLa liste de tous les noyaux installés s'affiche comme suit :

title="Red Hat Enterprise Linux (5.14.0-1.el9.x86_64) 9.0 (Plow)" title="Red Hat Enterprise Linux (0-rescue-0d772916a9724907a5d1350bcd39ac92) 9.0 (Plow)"

L'exemple ci-dessus affiche la liste des noyaux installés de grubby-8.40-17, à partir du menu GRUB.

2.4. Liste des modules du noyau actuellement chargés

Affiche les modules du noyau actuellement chargés.

Conditions préalables

-

Le paquet

kmodest installé.

Procédure

Pour obtenir la liste de tous les modules du noyau actuellement chargés, entrez :

$ lsmod Module Size Used by fuse 126976 3 uinput 20480 1 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 xt_conntrack 16384 1 ipt_REJECT 16384 1 nft_counter 16384 16 nf_nat_tftp 16384 0 nf_conntrack_tftp 16384 1 nf_nat_tftp tun 49152 1 bridge 192512 0 stp 16384 1 bridge llc 16384 2 bridge,stp nf_tables_set 32768 5 nft_fib_inet 16384 1 …Dans l'exemple ci-dessus :

- La première colonne fournit l'adresse names des modules actuellement chargés.

- La deuxième colonne indique la quantité de memory par module en kilo-octets.

- La dernière colonne indique le nombre et, éventuellement, les noms des modules qui sont dependent sur un module particulier.

Ressources supplémentaires

-

Le fichier

/usr/share/doc/kmod/README -

La page du manuel

lsmod(8)

2.5. Définition d'un noyau par défaut

Définir un noyau spécifique par défaut à l'aide de l'outil de ligne de commande grubby et de GRUB.

Procédure

Définition du noyau par défaut, à l'aide de l'outil

grubbyEntrez la commande suivante pour définir le noyau par défaut à l'aide de l'outil

grubby:# grubby --set-default $kernel_pathLa commande utilise comme argument un identifiant de machine sans le suffixe

.conf.NoteL'identifiant de la machine se trouve dans le répertoire

/boot/loader/entries/.

Définir le noyau par défaut, en utilisant l'argument

idLister les entrées de démarrage à l'aide de l'argument

id, puis définir un noyau par défaut :# grubby --info ALL | grep id # grubby --set-default /boot/vmlinuz-<version>.<architecture>

NotePour dresser la liste des entrées de démarrage à l'aide de l'argument

title, exécutez la commande# grubby --info=ALL | grep titlecommande.

Définition du noyau par défaut uniquement pour le prochain démarrage

Exécutez la commande suivante pour définir le noyau par défaut uniquement pour le prochain redémarrage à l'aide de la commande

grub2-reboot:# grub2-reboot <index|title|id>AvertissementDéfinissez le noyau par défaut uniquement pour le prochain démarrage avec précaution. L'installation de nouveaux RPM de noyaux, de noyaux auto-construits et l'ajout manuel d'entrées dans le répertoire

/boot/loader/entries/peuvent modifier les valeurs de l'index.

2.6. Affichage d'informations sur les modules du noyau

La commande modinfo permet d'afficher des informations détaillées sur le module du noyau spécifié.

Conditions préalables

-

Le paquet

kmodest installé.

Procédure

Pour afficher des informations sur n'importe quel module du noyau, entrez :

$ modinfo <KERNEL_MODULE_NAME>Par exemple :

$ modinfo virtio_net filename: /lib/modules/5.14.0-1.el9.x86_64/kernel/drivers/net/virtio_net.ko.xz license: GPL description: Virtio network driver rhelversion: 9.0 srcversion: 8809CDDBE7202A1B00B9F1C alias: virtio:d00000001v* depends: net_failover retpoline: Y intree: Y name: virtio_net vermagic: 5.14.0-1.el9.x86_64 SMP mod_unload modversions … parm: napi_weight:int parm: csum:bool parm: gso:bool parm: napi_tx:boolVous pouvez demander des informations sur tous les modules disponibles, qu'ils soient chargés ou non. Les entrées du site

parmindiquent les paramètres que l'utilisateur peut définir pour le module et le type de valeur qu'il attend.NoteLorsque vous saisissez le nom d'un module du noyau, n'ajoutez pas l'extension

.ko.xzà la fin du nom. Les noms des modules du noyau n'ont pas d'extension, mais les fichiers correspondants en ont une.

Ressources supplémentaires

-

La page du manuel

modinfo(8)

2.7. Chargement des modules du noyau au moment de l'exécution du système

La meilleure façon d'étendre les fonctionnalités du noyau Linux est de charger des modules de noyau. Utilisez la commande modprobe pour trouver et charger un module de noyau dans le noyau en cours d'exécution.

Conditions préalables

- Autorisations de la racine

-

Le paquet

kmodest installé. - Le module du noyau concerné n'est pas chargé. Pour s'en assurer, il convient de dresser la liste des modules du noyau chargés.

Procédure

Sélectionnez le module du noyau que vous souhaitez charger.

Les modules sont situés dans le répertoire

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/.Charger le module du noyau concerné :

# modprobe <MODULE_NAME>NoteLorsque vous saisissez le nom d'un module du noyau, n'ajoutez pas l'extension

.ko.xzà la fin du nom. Les noms des modules du noyau n'ont pas d'extension, mais les fichiers correspondants en ont une.En option, vérifier que le module concerné a été chargé :

$ lsmod | grep <MODULE_NAME>Si le module a été correctement chargé, cette commande affiche le module du noyau correspondant. Par exemple :

$ lsmod | grep serio_raw serio_raw 16384 0

Les modifications décrites dans cette procédure will not persist sont effectuées après le redémarrage du système. Pour plus d'informations sur le chargement des modules du noyau à l'adresse persist lors des redémarrages du système, voir Chargement automatique des modules du noyau au démarrage du système.

Ressources supplémentaires

-

La page du manuel

modprobe(8)

2.8. Déchargement des modules du noyau au moment de l'exécution du système

Il arrive parfois que vous deviez décharger certains modules du noyau en cours d'exécution. Utilisez la commande modprobe pour trouver et décharger un module du noyau au moment de l'exécution du système à partir du noyau actuellement chargé.

Conditions préalables

- Autorisations de la racine

-

Le paquet

kmodest installé.

Procédure

Entrez la commande

lsmodet sélectionnez un module du noyau que vous souhaitez décharger.Si un module du noyau a des dépendances, déchargez-les avant de décharger le module du noyau. Pour plus de détails sur l'identification des modules ayant des dépendances, voir Lister les modules du noyau actuellement chargés et Dépendances des modules du noyau.

Décharger le module du noyau concerné :

# modprobe -r <MODULE_NAME>Lorsque vous saisissez le nom d'un module du noyau, n'ajoutez pas l'extension

.ko.xzà la fin du nom. Les noms des modules du noyau n'ont pas d'extension, mais les fichiers correspondants en ont une.AvertissementNe pas décharger les modules du noyau lorsqu'ils sont utilisés par le système en cours d'exécution. Cela peut conduire à un système instable ou non opérationnel.

Optionnellement, vérifier que le module concerné a été déchargé :

$ lsmod | grep <MODULE_NAME>Si le module a été déchargé avec succès, cette commande n'affiche aucun résultat.

Une fois cette procédure terminée, les modules du noyau qui sont définis pour être automatiquement chargés au démarrage, will not stay unloaded après le redémarrage du système. Pour plus d'informations sur la manière d'éviter ce résultat, voir Empêcher le chargement automatique des modules du noyau au moment du démarrage du système.

Ressources supplémentaires

-

modprobe(8)page du manuel

2.9. Déchargement des modules du noyau aux premiers stades du processus de démarrage

Dans certaines situations, il est nécessaire de décharger un module du noyau très tôt dans le processus de démarrage. Par exemple, lorsque le module du noyau contient un code qui rend le système insensible et que l'utilisateur n'est pas en mesure d'atteindre le stade de désactivation permanente du module du noyau. Dans ce cas, il est possible de bloquer temporairement le chargement du module du noyau à l'aide d'un chargeur de démarrage.

Les modifications décrites dans cette procédure will not persist sont appliquées après le prochain redémarrage. Pour plus d'informations sur la manière d'ajouter un module de noyau à une liste de refus afin qu'il ne soit pas automatiquement chargé au cours du processus de démarrage, voir Empêcher le chargement automatique des modules de noyau au moment du démarrage du système.

Conditions préalables

- Vous disposez d'un module de noyau chargeable, dont vous voulez empêcher le chargement pour une raison quelconque.

Procédure

Modifiez l'entrée correspondante du chargeur de démarrage pour décharger le module de noyau souhaité avant que la séquence de démarrage ne se poursuive.

- Utilisez les touches du curseur pour mettre en évidence l'entrée du chargeur de démarrage concerné.

Appuyez sur la touche e pour modifier l'entrée.

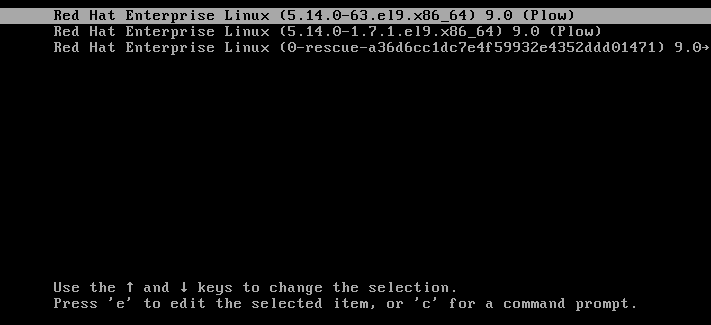

Figure 2.1. Menu de démarrage du noyau

- Utilisez les touches du curseur pour naviguer jusqu'à la ligne qui commence par linux.

Ajouter

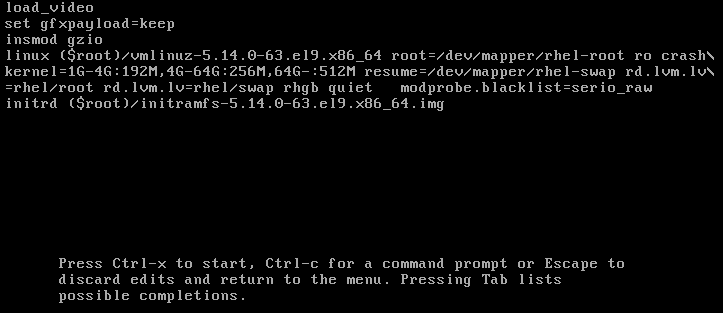

modprobe.blacklist=module_nameà la fin de la ligne.Figure 2.2. Entrée de démarrage du noyau

Le module du noyau

serio_rawillustre un module malveillant qui doit être déchargé au début du processus d'amorçage.- Appuyez sur les touches CTRL x pour démarrer en utilisant la configuration modifiée.

Vérification

Une fois que le système a complètement démarré, vérifiez que le module du noyau concerné n'est pas chargé.

# lsmod | grep serio_raw

Ressources supplémentaires

2.10. Chargement automatique des modules du noyau au démarrage du système

Configurer un module du noyau pour qu'il soit chargé automatiquement pendant le processus de démarrage.

Conditions préalables

- Autorisations de la racine

-

Le paquet

kmodest installé.

Procédure

Sélectionnez un module du noyau que vous souhaitez charger pendant le processus de démarrage.

Les modules sont situés dans le répertoire

/lib/modules/$(uname -r)/kernel/<SUBSYSTEM>/.Créer un fichier de configuration pour le module :

# echo <MODULE_NAME> > /etc/modules-load.d/<MODULE_NAME>.confNoteLorsque vous saisissez le nom d'un module du noyau, n'ajoutez pas l'extension

.ko.xzà la fin du nom. Les noms des modules du noyau n'ont pas d'extension, mais les fichiers correspondants en ont une.En option, après le redémarrage, vérifiez que le module concerné a été chargé :

$ lsmod | grep <MODULE_NAME>L'exemple de commande ci-dessus devrait réussir et afficher le module du noyau concerné.

Les changements décrits dans cette procédure will persist après le redémarrage du système.

Ressources supplémentaires

-

modules-load.d(5)page du manuel

2.11. Empêcher le chargement automatique des modules du noyau au démarrage du système

Ajouter un module du noyau à une liste de refus afin qu'il ne soit pas automatiquement chargé pendant le processus de démarrage.

Conditions préalables

- Autorisations de la racine

-

Le paquet

kmodest installé. - Assurez-vous qu'un module du noyau figurant dans une liste de refus n'est pas vital pour la configuration actuelle de votre système.

Procédure

Sélectionnez un module du noyau que vous souhaitez placer dans une liste de refus :

$ lsmod Module Size Used by fuse 126976 3 xt_CHECKSUM 16384 1 ipt_MASQUERADE 16384 1 uinput 20480 1 xt_conntrack 16384 1 …La commande

lsmodaffiche une liste des modules chargés dans le noyau en cours d'exécution.Vous pouvez également identifier un module du noyau non chargé que vous souhaitez empêcher de se charger.

Tous les modules du noyau sont situés dans le répertoire

/lib/modules/<KERNEL_VERSION>/kernel/<SUBSYSTEM>/.

Créer un fichier de configuration pour une liste de deniers :

# vim /etc/modprobe.d/blacklist.conf # Blacklists <KERNEL_MODULE_1> blacklist <MODULE_NAME_1> install <MODULE_NAME_1> /bin/false # Blacklists <KERNEL_MODULE_2> blacklist <MODULE_NAME_2> install <MODULE_NAME_2> /bin/false # Blacklists <KERNEL_MODULE_n> blacklist <MODULE_NAME_n> install <MODULE_NAME_n> /bin/false …

L'exemple montre le contenu du fichier

blacklist.conf, édité par l'éditeurvim. La ligneblacklistgarantit que le module du noyau concerné ne sera pas automatiquement chargé pendant le processus de démarrage. La commandeblacklist, cependant, n'empêche pas le module d'être chargé en tant que dépendance d'un autre module du noyau qui n'est pas dans une liste de dénylage. Par conséquent, la ligneinstallentraîne l'exécution de la commande/bin/falseau lieu de l'installation d'un module.Les lignes commençant par un signe dièse sont des commentaires destinés à rendre le fichier plus lisible.

NoteLorsque vous saisissez le nom d'un module du noyau, n'ajoutez pas l'extension

.ko.xzà la fin du nom. Les noms des modules du noyau n'ont pas d'extension, mais les fichiers correspondants en ont une.Créez une copie de sauvegarde de l'image ramdisk initiale actuelle avant de la reconstruire :

# cp /boot/initramfs-$(uname -r).img /boot/initramfs-$(uname -r).bak.$(date %m-\r%H%M%S).imgLa commande ci-dessus crée une image de sauvegarde

initramfsau cas où la nouvelle version aurait un problème inattendu.Vous pouvez également créer une copie de sauvegarde d'une autre image initiale de ramdisk qui correspond à la version du noyau pour laquelle vous souhaitez placer des modules de noyau dans une liste de dénombrement :

# cp /boot/initramfs-<SOME_VERSION>.img /boot/initramfs-<SOME_VERSION>.img.bak.$(date %m-\r%H%M%S)

Générer une nouvelle image ramdisk initiale pour refléter les changements :

# dracut -f -vSi vous construisez une image initiale de ramdisk pour une version de noyau différente de celle dans laquelle vous êtes actuellement démarré, indiquez à la fois la cible

initramfset la version du noyau :# dracut -f -v /boot/initramfs-<TARGET_VERSION>.img <CORRESPONDING_TARGET_KERNEL_VERSION>

Redémarrer le système :

$ reboot

Les changements décrits dans cette procédure will take effect and persist après le redémarrage du système. Si vous placez incorrectement un module clé du noyau dans une liste de refus, vous risquez d'avoir un système instable ou non opérationnel.

Ressources supplémentaires

- Comment empêcher le chargement automatique d'un module du noyau ?

-

dracut(8)page du manuel

2.12. Compilation de modules de noyau personnalisés

Vous pouvez créer un module de noyau d'échantillonnage en fonction des différentes configurations matérielles et logicielles.

Conditions préalables

Vous avez installé les paquets

kernel-devel,gccetelfutils-libelf-devel.# dnf install kernel-devel-$(uname -r) gcc elfutils-libelf-devel

- Vous disposez des droits d'accès à la racine.

-

Vous avez créé le répertoire

/root/testmodule/dans lequel vous compilez le module de noyau personnalisé.

Procédure

Créez le fichier

/root/testmodule/test.cavec le contenu suivant.#include <linux/module.h> #include <linux/kernel.h> int init_module(void) { printk("Hello World\n This is a test\n"); return 0; } void cleanup_module(void) { printk("Good Bye World"); } MODULE_LICENSE("GPL");Le fichier

test.cest un fichier source qui fournit les principales fonctionnalités du module du noyau. Le fichier a été créé dans un répertoire/root/testmodule/dédié à des fins d'organisation. Après la compilation du module, le répertoire/root/testmodule/contiendra plusieurs fichiers.Le fichier

test.cinclut les bibliothèques du système :-

Le fichier d'en-tête

linux/kernel.hest nécessaire pour la fonctionprintk()dans le code d'exemple. Le fichier

linux/module.hcontient des déclarations de fonctions et des définitions de macros à partager entre plusieurs fichiers sources écrits en langage de programmation C.Suivez ensuite les fonctions

init_module()etcleanup_module()pour démarrer et terminer la fonction d'enregistrement du noyauprintk(), qui imprime du texte.

-

Le fichier d'en-tête

Créez le fichier

/root/testmodule/Makefileavec le contenu suivant.obj-m := test.o

Le Makefile contient des instructions selon lesquelles le compilateur doit produire un fichier objet spécifiquement nommé

test.o. La directiveobj-mspécifie que le fichiertest.korésultant sera compilé en tant que module de noyau chargeable. Alternativement, la directiveobj-yindiquerait de compilertest.koen tant que module de noyau intégré.Compiler le module du noyau.

# make -C /lib/modules/$(uname -r)/build M=/root/testmodule modules make: Entering directory '/usr/src/kernels/5.14.0-70.17.1.el9_0.x86_64' CC [M] /root/testmodule/test.o MODPOST /root/testmodule/Module.symvers CC [M] /root/testmodule/test.mod.o LD [M] /root/testmodule/test.ko BTF [M] /root/testmodule/test.ko Skipping BTF generation for /root/testmodule/test.ko due to unavailability of vmlinux make: Leaving directory '/usr/src/kernels/5.14.0-70.17.1.el9_0.x86_64'Le compilateur crée un fichier objet (

test.o) pour chaque fichier source (test.c) en tant qu'étape intermédiaire avant de les lier ensemble dans le module final du noyau (test.ko).Après une compilation réussie,

/root/testmodule/contient des fichiers supplémentaires relatifs au module de noyau personnalisé compilé. Le module compilé lui-même est représenté par le fichiertest.ko.

Vérification

Facultatif : vérifiez le contenu du répertoire

/root/testmodule/:# ls -l /root/testmodule/ total 152 -rw-r—r--. 1 root root 16 Jul 26 08:19 Makefile -rw-r—r--. 1 root root 25 Jul 26 08:20 modules.order -rw-r—r--. 1 root root 0 Jul 26 08:20 Module.symvers -rw-r—r--. 1 root root 224 Jul 26 08:18 test.c -rw-r—r--. 1 root root 62176 Jul 26 08:20 test.ko -rw-r—r--. 1 root root 25 Jul 26 08:20 test.mod -rw-r—r--. 1 root root 849 Jul 26 08:20 test.mod.c -rw-r—r--. 1 root root 50936 Jul 26 08:20 test.mod.o -rw-r—r--. 1 root root 12912 Jul 26 08:20 test.oCopiez le module du noyau dans le répertoire

/lib/modules/$(uname -r)/:# cp /root/testmodule/test.ko /lib/modules/$(uname -r)/Mise à jour de la liste des dépendances modulaires :

# depmod -aCharger le module du noyau :

# modprobe -v test insmod /lib/modules/5.14.0-1.el9.x86_64/test.ko

Vérifiez que le module du noyau a été chargé avec succès :

# lsmod | grep test test 16384 0Lire les derniers messages du tampon circulaire du noyau :

# dmesg [74422.545004] Hello World This is a test

Ressources supplémentaires

Chapitre 3. Signer un noyau et des modules pour le démarrage sécurisé

Vous pouvez renforcer la sécurité de votre système en utilisant un noyau et des modules de noyau signés. Sur les systèmes de construction basés sur l'UEFI où Secure Boot est activé, vous pouvez signer vous-même un noyau ou des modules de noyau construits de manière privée. En outre, vous pouvez importer votre clé publique dans un système cible où vous souhaitez déployer votre noyau ou vos modules de noyau.

Si l'option Secure Boot est activée, tous les composants suivants doivent être signés à l'aide d'une clé privée et authentifiés à l'aide de la clé publique correspondante :

- Chargeur de démarrage du système d'exploitation UEFI

- Le noyau Red Hat Enterprise Linux

- Tous les modules du noyau

Si l'un de ces composants n'est pas signé et authentifié, le système ne peut pas terminer le processus de démarrage.

Red Hat Enterprise Linux 9 comprend :

- Chargeurs de démarrage signés

- Noyaux signés

- Modules signés du noyau

De plus, le chargeur de démarrage de première étape signé et le noyau signé incluent des clés publiques Red Hat intégrées. Ces binaires exécutables signés et ces clés intégrées permettent à Red Hat Enterprise Linux 9 de s'installer, de démarrer et de s'exécuter avec les clés de l'autorité de certification Microsoft UEFI Secure Boot qui sont fournies par le microprogramme UEFI sur les systèmes qui prennent en charge UEFI Secure Boot.

- Tous les systèmes basés sur l'UEFI ne prennent pas en charge le démarrage sécurisé.

- Le système de construction, dans lequel vous construisez et signez votre module de noyau, n'a pas besoin d'activer le Secure Boot UEFI ni même d'être un système basé sur l'UEFI.

3.1. Conditions préalables

Pour pouvoir signer les modules du noyau construits en externe, installez les utilitaires des paquets suivants :

# dnf install pesign openssl kernel-devel mokutil keyutilsTableau 3.1. Services publics requis

Utilité Fourni par paquet Utilisé le Objectif efikeygenpesignSystème de construction

Génère des paires de clés X.509 publiques et privées

opensslopensslSystème de construction

Exporte la clé privée non chiffrée

sign-filekernel-develSystème de construction

Fichier exécutable utilisé pour signer un module du noyau avec la clé privée

mokutilmokutilSystème cible

Utilitaire facultatif utilisé pour enregistrer manuellement la clé publique

keyctlkeyutilsSystème cible

Utilitaire facultatif utilisé pour afficher les clés publiques dans le trousseau de clés du système

3.2. Comprendre le démarrage sécurisé de l'UEFI

La technologie Secure Boot de Unified Extensible Firmware Interface (UEFI) permet d'empêcher l'exécution du code de l'espace noyau qui n'a pas été signé par une clé de confiance. Le chargeur de démarrage du système est signé par une clé cryptographique. La base de données des clés publiques, qui est contenue dans le microprogramme, autorise la clé de signature. Vous pouvez ensuite vérifier une signature dans le chargeur de démarrage de l'étape suivante et dans le noyau.

L'UEFI Secure Boot établit une chaîne de confiance entre le microprogramme et les pilotes et modules du noyau signés, comme suit :

-

Une clé privée UEFI signe et une clé publique authentifie le chargeur de démarrage de première étape

shim. Un certificate authority (CA) signe à son tour la clé publique. L'autorité de certification est stockée dans la base de données du microprogramme. -

Le fichier

shimcontient la clé publique de Red Hat Red Hat Secure Boot (CA key 1) pour authentifier le chargeur de démarrage GRUB et le noyau. - Le noyau contient quant à lui des clés publiques pour authentifier les pilotes et les modules.

Secure Boot est le composant de validation du chemin de démarrage de la spécification UEFI. La spécification définit :

- Interface de programmation pour les variables UEFI protégées cryptographiquement dans une mémoire non volatile.

- Stockage des certificats racine X.509 de confiance dans les variables UEFI.

- Validation des applications UEFI telles que les chargeurs de démarrage et les pilotes.

- Procédures de révocation des certificats et des hachages d'applications connus comme mauvais.

L'UEFI Secure Boot permet de détecter les modifications non autorisées, mais ne permet pas d'accéder au site not:

- Empêcher l'installation ou la suppression des chargeurs de démarrage de deuxième niveau.

- Exiger une confirmation explicite de ces modifications par l'utilisateur.

- Arrêter les manipulations du chemin d'amorçage. Les signatures sont vérifiées lors du démarrage, et non lors de l'installation ou de la mise à jour du chargeur de démarrage.

Si le chargeur de démarrage ou le noyau ne sont pas signés par une clé de confiance du système, Secure Boot les empêche de démarrer.

3.3. Prise en charge de l'UEFI Secure Boot

Vous pouvez installer et exécuter Red Hat Enterprise Linux 9 sur des systèmes avec UEFI Secure Boot activé si le noyau et tous les pilotes chargés sont signés avec une clé de confiance. Red Hat fournit des noyaux et des pilotes qui sont signés et authentifiés par les clés Red Hat appropriées.

Si vous souhaitez charger des noyaux ou des pilotes construits en externe, vous devez également les signer.

Restrictions imposées par UEFI Secure Boot

- Le système n'exécute le code en mode noyau que lorsque sa signature a été correctement authentifiée.

- Le chargement du module GRUB est désactivé parce qu'il n'existe pas d'infrastructure pour la signature et la vérification des modules GRUB. Leur chargement constitue l'exécution d'un code non fiable à l'intérieur du périmètre de sécurité défini par Secure Boot.

- Red Hat fournit un binaire GRUB signé qui contient tous les modules pris en charge sur Red Hat Enterprise Linux 9.

Ressources supplémentaires

3.4. Exigences pour l'authentification des modules du noyau avec des clés X.509

Dans Red Hat Enterprise Linux 9, lorsqu'un module du noyau est chargé, le noyau vérifie la signature du module par rapport aux clés publiques X.509 du trousseau de clés du système du noyau (.builtin_trusted_keys) et du trousseau de clés de la plate-forme du noyau (.platform). Le trousseau .platform contient des clés provenant de fournisseurs de plateformes tiers et des clés publiques personnalisées. Les clés du trousseau du système du noyau .blacklist sont exclues de la vérification.

Certaines conditions doivent être remplies pour charger les modules du noyau sur les systèmes dont la fonctionnalité UEFI Secure Boot est activée :

Si l'UEFI Secure Boot est activé ou si le paramètre

module.sig_enforcekernel a été spécifié :-

Vous ne pouvez charger que les modules signés du noyau dont les signatures ont été authentifiées à l'aide des clés du trousseau de clés du système (

.builtin_trusted_keys) et du trousseau de clés de la plate-forme (.platform). -

La clé publique ne doit pas figurer dans le trousseau des clés révoquées du système (

.blacklist).

-

Vous ne pouvez charger que les modules signés du noyau dont les signatures ont été authentifiées à l'aide des clés du trousseau de clés du système (

Si UEFI Secure Boot est désactivé et que le paramètre

module.sig_enforcekernel n'a pas été spécifié :- Vous pouvez charger des modules de noyau non signés et des modules de noyau signés sans clé publique.

Si le système n'est pas basé sur l'UEFI ou si le Secure Boot de l'UEFI est désactivé :

-

Seules les clés intégrées dans le noyau sont chargées sur

.builtin_trusted_keyset.platform. - Vous n'avez pas la possibilité d'augmenter ce jeu de clés sans reconstruire le noyau.

-

Seules les clés intégrées dans le noyau sont chargées sur

Tableau 3.2. Exigences d'authentification du module du noyau pour le chargement

| Module signé | Clé publique trouvée et signature valide | État de l'UEFI Secure Boot | sig_enforce | Chargement du module | Noyau altéré |

|---|---|---|---|---|---|

| Non signé | - | Non activé | Non activé | Réussite | Oui |

| Non activé | Activé | Échecs | - | ||

| Activé | - | Échecs | - | ||

| Signé | Non | Non activé | Non activé | Réussite | Oui |

| Non activé | Activé | Échecs | - | ||

| Activé | - | Échecs | - | ||

| Signé | Oui | Non activé | Non activé | Réussite | Non |

| Non activé | Activé | Réussite | Non | ||

| Activé | - | Réussite | Non |

3.5. Sources des clés publiques

Lors du démarrage, le noyau charge les clés X.509 à partir d'un ensemble de réserves de clés persistantes dans les trousseaux de clés suivants :

-

Le porte-clés du système (

.builtin_trusted_keys) -

Le porte-clés

.platform -

Le système

.blacklistporte-clés

Tableau 3.3. Sources pour les porte-clés système

| Source des clés X.509 | L'utilisateur peut ajouter des clés | État de l'UEFI Secure Boot | Clés chargées au démarrage |

|---|---|---|---|

| Intégrée dans le noyau | Non | - |

|

|

UEFI | Limitée | Non activé | Non |

| Activé |

| ||

|

Intégrée dans le chargeur de démarrage | Non | Non activé | Non |

| Activé |

| ||

| Liste des clés du propriétaire de la machine (MOK) | Oui | Non activé | Non |

| Activé |

|

.builtin_trusted_keys- Un porte-clés construit sur mesure

- Contient des clés publiques de confiance

-

rootdes privilèges sont nécessaires pour visualiser les clés

.platform- Un porte-clés construit sur mesure

- Contient des clés provenant de fournisseurs de plateformes tiers et des clés publiques personnalisées

-

rootdes privilèges sont nécessaires pour visualiser les clés

.blacklist- Un trousseau de clés X.509 révoquées

-

Un module signé par une clé provenant de

.blacklistéchouera à l'authentification même si votre clé publique se trouve dans.builtin_trusted_keys

- UEFI Secure Boot

db - Une base de données de signatures

- Stocke les clés (hachages) des applications UEFI, des pilotes UEFI et des chargeurs de démarrage

- Les clés peuvent être chargées sur la machine

- UEFI Secure Boot

dbx - Une base de données de signatures révoquées

- Empêche le chargement des clés

-

Les clés révoquées de cette base de données sont ajoutées au trousseau de clés

.blacklist

3.6. Générer une paire de clés publique et privée

Pour utiliser un noyau personnalisé ou des modules de noyau personnalisés sur un système compatible avec Secure Boot, vous devez générer une paire de clés X.509 publique et privée. Vous pouvez utiliser la clé privée générée pour signer le noyau ou les modules du noyau. Vous pouvez également valider le noyau ou les modules signés en ajoutant la clé publique correspondante à la clé du propriétaire de la machine (MOK) pour Secure Boot.

Appliquez des mesures de sécurité et des politiques d'accès strictes pour protéger le contenu de votre clé privée. Entre de mauvaises mains, la clé pourrait être utilisée pour compromettre tout système authentifié par la clé publique correspondante.

Procédure

Créez une paire de clés publiques et privées X.509 :

Si vous souhaitez uniquement signer un noyau personnalisé modules:

# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --module \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'

Si vous souhaitez signer un document personnalisé kernel:

# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --kernel \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key'

Lorsque le système RHEL fonctionne en mode FIPS :

# efikeygen --dbdir /etc/pki/pesign \ --self-sign \ --kernel \ --common-name 'CN=Organization signing key' \ --nickname 'Custom Secure Boot key' --token 'pkcs11:token=NSS%20FIPS%20140-2%20Certificate%20DB'

Par défaut, lorsque l'option

--tokenn'est pas spécifiée,pkcs11:token=NSS Certificate DBest utilisé.

Les clés publiques et privées sont maintenant stockées dans le répertoire /etc/pki/pesign/.

C'est une bonne pratique de sécurité de signer le noyau et les modules du noyau pendant la période de validité de sa clé de signature. Cependant, l'utilitaire sign-file ne vous avertit pas et la clé sera utilisable dans Red Hat Enterprise Linux 9 indépendamment des dates de validité.

Ressources supplémentaires

3.7. Exemple de sortie des trousseaux de clés du système

Vous pouvez afficher des informations sur les clés des trousseaux de clés du système à l'aide de l'utilitaire keyctl du paquetage keyutils.

Conditions préalables

- Vous disposez des droits d'accès à la racine.

-

Vous avez installé l'utilitaire

keyctlà partir du paquetagekeyutils.

Exemple 3.1. Sortie de porte-clés

Voici un exemple abrégé de la sortie des trousseaux de clés .builtin_trusted_keys, .platform, et .blacklist d'un système Red Hat Enterprise Linux 9 où l'UEFI Secure Boot est activé.

# keyctl list %:.builtin_trusted_keys 6 keys in keyring: ...asymmetric: Red Hat Enterprise Linux Driver Update Program (key 3): bf57f3e87... ...asymmetric: Red Hat Secure Boot (CA key 1): 4016841644ce3a810408050766e8f8a29... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4309bd82709c8cd54f316ed... ...asymmetric: Microsoft Windows Production PCA 2011: a92902398e16c49778cd90f99e... ...asymmetric: Red Hat Enterprise Linux kernel signing key: 4249689eefc77e95880b... ...asymmetric: Red Hat Enterprise Linux kpatch signing key: 4d38fd864ebe18c5f0b7... # keyctl list %:.platform 4 keys in keyring: ...asymmetric: VMware, Inc.: 4ad8da0472073... ...asymmetric: Red Hat Secure Boot CA 5: cc6fafe72... ...asymmetric: Microsoft Windows Production PCA 2011: a929f298e1... ...asymmetric: Microsoft Corporation UEFI CA 2011: 13adbf4e0bd82... # keyctl list %:.blacklist 4 keys in keyring: ...blacklist: bin:f5ff83a... ...blacklist: bin:0dfdbec... ...blacklist: bin:38f1d22... ...blacklist: bin:51f831f...

Le trousseau .builtin_trusted_keys de l'exemple montre l'ajout de deux clés provenant des clés UEFI Secure Boot db ainsi que de la clé Red Hat Secure Boot (CA key 1), qui est intégrée dans le chargeur de démarrage shim.

Exemple 3.2. Sortie de la console du noyau

L'exemple suivant montre la sortie de la console du noyau. Les messages identifient les clés avec une source liée à l'UEFI Secure Boot. Il s'agit de UEFI Secure Boot db, embedded shim, et MOK list.

# dmesg | egrep 'integrity.*cert'

[1.512966] integrity: Loading X.509 certificate: UEFI:db

[1.513027] integrity: Loaded X.509 cert 'Microsoft Windows Production PCA 2011: a929023...

[1.513028] integrity: Loading X.509 certificate: UEFI:db

[1.513057] integrity: Loaded X.509 cert 'Microsoft Corporation UEFI CA 2011: 13adbf4309...

[1.513298] integrity: Loading X.509 certificate: UEFI:MokListRT (MOKvar table)

[1.513549] integrity: Loaded X.509 cert 'Red Hat Secure Boot CA 5: cc6fa5e72868ba494e93...Ressources supplémentaires

-

keyctl(1),dmesg(1)pages de manuel

3.8. Enregistrement de la clé publique sur le système cible en ajoutant la clé publique à la liste MOK

Vous devez enregistrer votre clé publique sur tous les systèmes où vous souhaitez authentifier et charger votre noyau ou vos modules de noyau. Vous pouvez importer la clé publique sur un système cible de différentes manières afin que le trousseau de clés de la plate-forme (.platform) puisse utiliser la clé publique pour authentifier le noyau ou les modules du noyau.

Lorsque RHEL 9 démarre sur un système basé sur l'UEFI avec Secure Boot activé, le noyau charge sur le trousseau de la plate-forme (.platform) toutes les clés publiques qui se trouvent dans la base de données de clés Secure Boot db. En même temps, le noyau exclut les clés de la base de données dbx des clés révoquées.

Vous pouvez utiliser la fonction de facilité de la clé du propriétaire de la machine (MOK) pour étendre la base de données de clés de l'UEFI Secure Boot. Lorsque RHEL 9 démarre sur un système UEFI avec Secure Boot activé, les clés de la liste MOK sont également ajoutées au trousseau de clés de la plate-forme (.platform) en plus des clés de la base de données de clés. Les clés de la liste MOK sont également stockées de manière persistante et sécurisée de la même manière que les clés de la base de données Secure Boot, mais il s'agit de deux installations distinctes. La fonction MOK est prise en charge par shim, MokManager, GRUB et l'utilitaire mokutil.

Pour faciliter l'authentification de votre module de noyau sur vos systèmes, envisagez de demander à votre fournisseur de système d'incorporer votre clé publique dans la base de données de clés UEFI Secure Boot dans leur image de micrologiciel d'usine.

Conditions préalables

- Vous avez généré une paire de clés publique et privée et vous connaissez les dates de validité de vos clés publiques. Pour plus d'informations, voir Générer une paire de clés publique et privée.

Procédure

Exportez votre clé publique vers le fichier

sb_cert.cer:# certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cer

Importez votre clé publique dans la liste MOK :

# mokutil --import sb_cert.cer- Saisissez un nouveau mot de passe pour cette demande d'inscription au MOK.

Redémarrer la machine.

Le chargeur de démarrage

shimremarque la demande d'enrôlement de la clé MOK en attente et lanceMokManager.efipour vous permettre de terminer l'enrôlement à partir de la console UEFI.Choisissez

Enroll MOK, saisissez le mot de passe que vous avez précédemment associé à cette demande lorsque vous y êtes invité et confirmez l'inscription.Votre clé publique est ajoutée à la liste MOK, qui est persistante.

Une fois qu'une clé figure sur la liste MOK, elle est automatiquement propagée dans le trousseau

.platformlors de ce démarrage et des suivants lorsque l'UEFI Secure Boot est activé.

3.9. Signer un noyau avec la clé privée

Vous pouvez améliorer la sécurité de votre système en chargeant un noyau signé si le mécanisme de démarrage sécurisé de l'UEFI est activé.

Conditions préalables

- Vous avez généré une paire de clés publique et privée et vous connaissez les dates de validité de vos clés publiques. Pour plus d'informations, voir Générer une paire de clés publique et privée.

- Vous avez enregistré votre clé publique sur le système cible. Pour plus de détails, voir Enrôler une clé publique sur le système cible en ajoutant la clé publique à la liste MOK.

- Vous disposez d'une image de noyau au format ELF disponible pour la signature.

Procédure

Sur l'architecture x64 :

Créer une image signée :

# pesign --certificate 'Custom Secure Boot key' \ --in vmlinuz-version \ --sign \ --out vmlinuz-version.signed

Remplacez

versionpar le suffixe de version de votre fichiervmlinuz, etCustom Secure Boot keypar le nom que vous avez choisi précédemment.Facultatif : Vérifier les signatures :

# pesign --show-signature \ --in vmlinuz-version.signed

Remplacer l'image non signée par l'image signée :

# mv vmlinuz-version.signed vmlinuz-version

Sur l'architecture ARM 64 bits :

Décompressez le fichier

vmlinuz:# zcat vmlinuz-version > vmlinux-versionCréer une image signée :

# pesign --certificate 'Custom Secure Boot key' \ --in vmlinux-version \ --sign \ --out vmlinux-version.signed

Facultatif : Vérifier les signatures :

# pesign --show-signature \ --in vmlinux-version.signed

Compresser le fichier

vmlinux:# gzip --to-stdout vmlinux-version.signed > vmlinuz-versionSupprimer le fichier non compressé

vmlinux:# rm vmlinux-version*

3.10. Signer un build GRUB avec la clé privée

Sur un système où le mécanisme de démarrage sécurisé UEFI est activé, vous pouvez signer une version GRUB avec une clé privée personnalisée existante. Vous devez procéder ainsi si vous utilisez une version personnalisée de GRUB ou si vous avez supprimé l'ancre de confiance Microsoft de votre système.

Conditions préalables

- Vous avez généré une paire de clés publique et privée et vous connaissez les dates de validité de vos clés publiques. Pour plus d'informations, voir Générer une paire de clés publique et privée.

- Vous avez enregistré votre clé publique sur le système cible. Pour plus de détails, voir Enrôler une clé publique sur le système cible en ajoutant la clé publique à la liste MOK.

- Vous disposez d'un binaire GRUB EFI à signer.

Procédure

Sur l'architecture x64 :

Créer un binaire EFI GRUB signé :

# pesign --in /boot/efi/EFI/redhat/grubx64.efi \ --out /boot/efi/EFI/redhat/grubx64.efi.signed \ --certificate 'Custom Secure Boot key' \ --sign

Remplacez

Custom Secure Boot keypar le nom que vous avez choisi précédemment.Facultatif : Vérifier les signatures :

# pesign --in /boot/efi/EFI/redhat/grubx64.efi.signed \ --show-signature

Remplacer le binaire non signé par le binaire signé :

# mv /boot/efi/EFI/redhat/grubx64.efi.signed \ /boot/efi/EFI/redhat/grubx64.efi

Sur l'architecture ARM 64 bits :

Créer un binaire EFI GRUB signé :

# pesign --in /boot/efi/EFI/redhat/grubaa64.efi \ --out /boot/efi/EFI/redhat/grubaa64.efi.signed \ --certificate 'Custom Secure Boot key' \ --sign

Remplacez

Custom Secure Boot keypar le nom que vous avez choisi précédemment.Facultatif : Vérifier les signatures :

# pesign --in /boot/efi/EFI/redhat/grubaa64.efi.signed \ --show-signature

Remplacer le binaire non signé par le binaire signé :

# mv /boot/efi/EFI/redhat/grubaa64.efi.signed \ /boot/efi/EFI/redhat/grubaa64.efi

3.11. Signer les modules du noyau avec la clé privée

Vous pouvez renforcer la sécurité de votre système en chargeant des modules de noyau signés si le mécanisme de démarrage sécurisé de l'UEFI est activé.

Votre module noyau signé est également chargeable sur les systèmes où le Secure Boot UEFI est désactivé ou sur un système non UEFI. Par conséquent, vous n'avez pas besoin de fournir une version signée et une version non signée de votre module noyau.

Conditions préalables

- Vous avez généré une paire de clés publique et privée et vous connaissez les dates de validité de vos clés publiques. Pour plus d'informations, voir Générer une paire de clés publique et privée.

- Vous avez enregistré votre clé publique sur le système cible. Pour plus de détails, voir Enrôler une clé publique sur le système cible en ajoutant la clé publique à la liste MOK.

- Vous disposez d'un module de noyau au format d'image ELF disponible pour la signature.

Procédure

Exportez votre clé publique vers le fichier

sb_cert.cer:# certutil -d /etc/pki/pesign \ -n 'Custom Secure Boot key' \ -Lr \ > sb_cert.cer

Extraire la clé de la base de données du SSN sous la forme d'un fichier PKCS #12 :

# pk12util -o sb_cert.p12 \ -n 'Custom Secure Boot key' \ -d /etc/pki/pesign

- Lorsque la commande précédente vous y invite, entrez un nouveau mot de passe qui crypte la clé privée.

Exporter la clé privée non chiffrée :

# openssl pkcs12 \ -in sb_cert.p12 \ -out sb_cert.priv \ -nocerts \ -noenc

ImportantManipulez la clé privée non chiffrée avec précaution.

Signez votre module de noyau. La commande suivante ajoute la signature directement à l'image ELF dans le fichier du module du noyau :

# /usr/src/kernels/$(uname -r)/scripts/sign-file \ sha256 \ sb_cert.priv \ sb_cert.cer \ my_module.ko

Votre module noyau est maintenant prêt à être chargé.

Dans Red Hat Enterprise Linux 9, les dates de validité de la paire de clés sont importantes. La clé n'expire pas, mais le module du noyau doit être signé pendant la période de validité de sa clé de signature. L'utilitaire sign-file ne vous en avertira pas. Par exemple, une clé qui n'est valide qu'en 2021 peut être utilisée pour authentifier un module du noyau signé en 2021 avec cette clé. Cependant, les utilisateurs ne peuvent pas utiliser cette clé pour signer un module de noyau en 2022.

Vérification

Affiche des informations sur la signature du module du noyau :

# modinfo my_module.ko | grep signer signer: Your Name Key

Vérifiez que la signature mentionne votre nom tel qu'il a été saisi lors de la génération.

NoteLa signature annexée n'est pas contenue dans une section de l'image ELF et ne constitue pas une partie formelle de l'image ELF. Par conséquent, des utilitaires tels que

readelfne peuvent pas afficher la signature sur votre module de noyau.Charger le module :

# insmod my_module.koRetirer (décharger) le module :

# rmmod my_module.ko

Ressources supplémentaires

3.12. Chargement des modules signés du noyau

Une fois que votre clé publique est enregistrée dans le trousseau de clés du système (.builtin_trusted_keys) et dans la liste MOK, et après avoir signé le module du noyau concerné avec votre clé privée, vous pouvez charger le module du noyau signé à l'aide de la commande modprobe.

Conditions préalables

- Vous avez généré la paire de clés publique et privée. Pour plus d'informations, voir Générer une paire de clés publique et privée.

- Vous avez enregistré la clé publique dans le trousseau de clés du système. Pour plus de détails, voir Enrôler une clé publique sur le système cible en ajoutant la clé publique à la liste MOK.

- Vous avez signé un module du noyau avec la clé privée. Pour plus de détails, voir Signer des modules du noyau avec la clé privée.

Installez le paquet

kernel-modules-extra, qui crée le répertoire/lib/modules/$(uname -r)/extra/:# dnf -y install kernel-modules-extra

Procédure

Vérifiez que vos clés publiques se trouvent sur le trousseau de clés du système :

# keyctl list %:.platformCopiez le module du noyau dans le répertoire

extra/du noyau que vous voulez :# cp my_module.ko /lib/modules/$(uname -r)/extra/Mise à jour de la liste des dépendances modulaires :

# depmod -aCharger le module du noyau :

# modprobe -v my_moduleEn option, pour charger le module au démarrage, ajoutez-le au fichier

/etc/modules-loaded.d/my_module.confpour charger le module au démarrage :# echo "my_module" > /etc/modules-load.d/my_module.conf

Vérification

Vérifiez que le module a été chargé avec succès :

# lsmod | grep my_module

Ressources supplémentaires

Chapitre 4. Mise à jour de la liste de révocation de l'amorçage sécurisé

Vous pouvez mettre à jour la liste de révocation UEFI Secure Boot de votre système afin que Secure Boot identifie les logiciels présentant des problèmes de sécurité connus et les empêche de compromettre votre processus de démarrage.

4.1. Conditions préalables

- Secure Boot est activé sur votre système.

4.2. Comprendre le démarrage sécurisé de l'UEFI

La technologie Secure Boot de Unified Extensible Firmware Interface (UEFI) permet d'empêcher l'exécution du code de l'espace noyau qui n'a pas été signé par une clé de confiance. Le chargeur de démarrage du système est signé par une clé cryptographique. La base de données des clés publiques, qui est contenue dans le microprogramme, autorise la clé de signature. Vous pouvez ensuite vérifier une signature dans le chargeur de démarrage de l'étape suivante et dans le noyau.

L'UEFI Secure Boot établit une chaîne de confiance entre le microprogramme et les pilotes et modules du noyau signés, comme suit :

-

Une clé privée UEFI signe et une clé publique authentifie le chargeur de démarrage de première étape

shim. Un certificate authority (CA) signe à son tour la clé publique. L'autorité de certification est stockée dans la base de données du microprogramme. -

Le fichier

shimcontient la clé publique de Red Hat Red Hat Secure Boot (CA key 1) pour authentifier le chargeur de démarrage GRUB et le noyau. - Le noyau contient quant à lui des clés publiques pour authentifier les pilotes et les modules.

Secure Boot est le composant de validation du chemin de démarrage de la spécification UEFI. La spécification définit :

- Interface de programmation pour les variables UEFI protégées cryptographiquement dans une mémoire non volatile.

- Stockage des certificats racine X.509 de confiance dans les variables UEFI.

- Validation des applications UEFI telles que les chargeurs de démarrage et les pilotes.

- Procédures de révocation des certificats et des hachages d'applications connus comme mauvais.

L'UEFI Secure Boot permet de détecter les modifications non autorisées, mais ne permet pas d'accéder au site not:

- Empêcher l'installation ou la suppression des chargeurs de démarrage de deuxième niveau.

- Exiger une confirmation explicite de ces modifications par l'utilisateur.

- Arrêter les manipulations du chemin d'amorçage. Les signatures sont vérifiées lors du démarrage, et non lors de l'installation ou de la mise à jour du chargeur de démarrage.

Si le chargeur de démarrage ou le noyau ne sont pas signés par une clé de confiance du système, Secure Boot les empêche de démarrer.

4.3. La liste de révocation de Secure Boot

La Secure Boot Revocation List de l'UEFI, ou Secure Boot Forbidden Signature Database (dbx), est une liste qui identifie les logiciels dont l'exécution n'est plus autorisée par Secure Boot.

Lorsqu'un problème de sécurité ou de stabilité est détecté dans un logiciel interfacé avec Secure Boot, tel que le chargeur de démarrage GRUB, la liste de révocation enregistre sa signature de hachage. Les logiciels dont la signature est reconnue ne peuvent pas être exécutés pendant le démarrage, et le démarrage du système échoue afin d'éviter de compromettre le système.

Par exemple, une certaine version de GRUB peut contenir un problème de sécurité qui permet à un attaquant de contourner le mécanisme de démarrage sécurisé. Lorsque le problème est détecté, la liste de révocation ajoute les signatures de hachage de toutes les versions de GRUB qui contiennent le problème. Par conséquent, seules les versions sécurisées de GRUB peuvent démarrer sur le système.

La liste des révocations nécessite des mises à jour régulières afin de prendre en compte les problèmes nouvellement découverts. Lors de la mise à jour de la liste de révocation, veillez à utiliser une méthode de mise à jour sûre qui n'entraîne pas l'arrêt du démarrage de votre système actuellement installé.

4.4. Application d'une mise à jour en ligne de la liste de révocation

Vous pouvez mettre à jour la liste de révocation de l'amorçage sécurisé de votre système afin que l'amorçage sécurisé empêche les problèmes de sécurité connus. Cette procédure est sûre et garantit que la mise à jour n'empêche pas le démarrage de votre système.

Conditions préalables

- Votre système peut accéder à l'internet pour les mises à jour.

Procédure

Déterminer la version actuelle de la liste de révocation :

# fwupdmgr get-devices

Voir le champ

Current versionsousUEFI dbx.Activer le référentiel de listes de révocation LVFS :

# fwupdmgr enable-remote lvfs

Actualiser les métadonnées du référentiel :

# fwupdmgr refresh

Appliquer la mise à jour de la liste de révocation :

Sur la ligne de commande :

# fwupdmgr update

Dans l'interface graphique :

- Ouvrir l'application Software

- Naviguez jusqu'à l'onglet Updates.

- Trouvez l'entrée Secure Boot dbx Configuration Update.

- Cliquez sur Mettre à jour.

-

À la fin de la mise à jour,

fwupdmgrou Software vous demande de redémarrer le système. Confirmez le redémarrage.

Vérification

Après le redémarrage, vérifiez à nouveau la version actuelle de la liste de révocation :

# fwupdmgr get-devices

4.5. Application d'une mise à jour de la liste de révocation hors ligne

Sur un système sans connexion internet, vous pouvez mettre à jour la Secure Boot Revocation List à partir de RHEL afin que Secure Boot prévienne les problèmes de sécurité connus. Cette procédure est sûre et garantit que la mise à jour n'empêche pas votre système de démarrer.

Procédure

Déterminer la version actuelle de la liste de révocation :

# fwupdmgr get-devices

Voir le champ

Current versionsousUEFI dbx.Liste des mises à jour disponibles auprès de RHEL :

# ls /usr/share/dbxtool/

Sélectionnez le fichier de mise à jour le plus récent pour votre architecture. Les noms de fichiers utilisent le format suivant :

DBXUpdate-date-architecture.cab

Installer le fichier de mise à jour sélectionné :

# fwupdmgr install /usr/share/dbxtool/DBXUpdate-date-architecture.cab

-

À la fin de la mise à jour,

fwupdmgrvous demande de redémarrer le système. Confirmez le redémarrage.

Vérification

Après le redémarrage, vérifiez à nouveau la version actuelle de la liste de révocation :

# fwupdmgr get-devices

Chapitre 5. Configuration des paramètres de la ligne de commande du noyau

Les paramètres de la ligne de commande du noyau vous permettent de modifier le comportement de certains aspects du noyau de Red Hat Enterprise Linux au moment du démarrage. En tant qu'administrateur système, vous avez un contrôle total sur les options qui sont définies au démarrage. Certains comportements du noyau ne peuvent être définis qu'au moment du démarrage, c'est pourquoi la compréhension de la manière d'effectuer ces changements est une compétence clé en matière d'administration.

Changer le comportement du système en modifiant les paramètres de la ligne de commande du noyau peut avoir des effets négatifs sur votre système. Testez toujours les modifications avant de les déployer dans la production. Pour plus d'informations, contactez l'assistance Red Hat.

5.1. Comprendre les paramètres de la ligne de commande du noyau

Les paramètres de la ligne de commande du noyau permettent d'écraser les valeurs par défaut et de définir des paramètres matériels spécifiques. Au moment du démarrage, vous pouvez configurer les fonctions suivantes :

- Le noyau Red Hat Enterprise Linux

- Le disque RAM initial

- Les caractéristiques de l'espace utilisateur

Par défaut, les paramètres de ligne de commande du noyau pour les systèmes utilisant le chargeur d'amorçage GRUB sont définis dans le fichier de configuration de l'entrée d'amorçage pour chaque entrée d'amorçage du noyau.

Vous pouvez manipuler les fichiers de configuration du chargeur de démarrage à l'aide de l'utilitaire grubby. L'utilitaire grubby vous permet d'effectuer les opérations suivantes :

- Modifier l'entrée de démarrage par défaut.

- Ajouter ou supprimer des arguments à une entrée du menu GRUB.

Ressources supplémentaires

-

kernel-command-line(7),bootparam(7)etdracut.cmdline(7)pages de manuel - Comment installer et démarrer des noyaux personnalisés dans Red Hat Enterprise Linux 8

-

La page du manuel

grubby(8)

5.2. Comprendre les entrées de démarrage

Une entrée de démarrage est un ensemble d'options stockées dans un fichier de configuration et liées à une version particulière du noyau. En pratique, vous avez au moins autant d'entrées de démarrage que de noyaux installés sur votre système. Le fichier de configuration de l'entrée de démarrage est situé dans le répertoire /boot/loader/entries/ et peut ressembler à ceci :

d8712ab6d4f14683c5625e87b52b6b6e-5.14.0-1.el9.x86_64.conf

Le nom du fichier ci-dessus se compose d'un identifiant de machine stocké dans le fichier /etc/machine-id et d'une version du noyau.

Le fichier de configuration de l'entrée de démarrage contient des informations sur la version du noyau, l'image initiale du disque dur et les paramètres de la ligne de commande du noyau. L'exemple du contenu d'un fichier de configuration d'entrée de démarrage est présenté ci-dessous :

title Red Hat Enterprise Linux (5.14.0-1.el9.x86_64) 9.0 (Plow) version 5.14.0-1.el9.x86_64 linux /vmlinuz-5.14.0-1.el9.x86_64 initrd /initramfs-5.14.0-1.el9.x86_64.img options root=/dev/mapper/rhel_kvm--02--guest08-root ro crashkernel=1G-4G:192M,4G-64G:256M,64G-:512M resume=/dev/mapper/rhel_kvm--02--guest08-swap rd.lvm.lv=rhel_kvm-02-guest08/root rd.lvm.lv=rhel_kvm-02-guest08/swap console=ttyS0,115200 grub_users $grub_users grub_arg --unrestricted grub_class kernel

5.3. Modification des paramètres de la ligne de commande du noyau pour toutes les entrées de démarrage

Modifier les paramètres de la ligne de commande du noyau pour toutes les entrées de démarrage de votre système.

Lors de l'installation d'une nouvelle version du noyau dans les systèmes RHEL 9, l'outil grubby transmet les arguments de la ligne de commande du noyau de la version précédente.

Toutefois, cela ne s'applique pas à la version 9.0 de RHEL, dans laquelle les noyaux nouvellement installés perdent les options de ligne de commande précédentes. Vous devez exécuter la commande grub2-mkconfig sur le noyau nouvellement installé pour transmettre les paramètres à votre nouveau noyau. Pour plus d'informations sur ce problème connu, voir Chargeur de démarrage.

Conditions préalables

-

Vérifiez que l'utilitaire

grubbyest installé sur votre système. -

Vérifiez que l'utilitaire

ziplest installé sur votre système IBM Z.

Procédure

Pour ajouter un paramètre :

# grubby --update-kernel=ALL --args="<NEW_PARAMETER>"Pour les systèmes qui utilisent le chargeur d'amorçage GRUB et, sur IBM Z, qui utilisent le chargeur d'amorçage zIPL, la commande ajoute un nouveau paramètre de noyau à chaque fichier

/boot/loader/entries/<ENTRY>.conffichier.-

Sur IBM Z, exécutez la commande

ziplsans options pour mettre à jour le menu de démarrage.

-

Sur IBM Z, exécutez la commande

Pour supprimer un paramètre :

# grubby --update-kernel=ALL --remove-args="<PARAMETER_TO_REMOVE>"-

Sur IBM Z, exécutez la commande

ziplsans options pour mettre à jour le menu de démarrage.

-

Sur IBM Z, exécutez la commande

Après chaque mise à jour de votre paquetage de noyau, propagez les options de noyau configurées vers les nouveaux noyaux :

# grub2-mkconfig -o /etc/grub2.cfg

Ressources supplémentaires

- Comprendre les paramètres de la ligne de commande du noyau

-

grubby(8)etzipl(8)pages de manuel - grubby tool

5.4. Modification des paramètres de la ligne de commande du noyau pour une seule entrée de démarrage

Modifier les paramètres de la ligne de commande du noyau pour une seule entrée de démarrage sur votre système.

Conditions préalables

-

Vérifiez que les utilitaires

grubbyetziplsont installés sur votre système.

Procédure

Pour ajouter un paramètre :

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --args="<NEW_PARAMETER>"-

Sur IBM Z, exécutez la commande

ziplsans options pour mettre à jour le menu de démarrage.

-

Sur IBM Z, exécutez la commande

Pour supprimer un paramètre, procédez comme suit :

# grubby --update-kernel=/boot/vmlinuz-$(uname -r) --remove-args="<PARAMETER_TO_REMOVE>"-

Sur IBM Z, exécutez la commande

ziplsans options pour mettre à jour le menu de démarrage.

-

Sur IBM Z, exécutez la commande

-

grubbymodifie et stocke les paramètres de la ligne de commande du noyau d'une entrée de démarrage individuelle du noyau dans le fichier/boot/loader/entries/<ENTRY>.confdans le fichier

Ressources supplémentaires

- Comprendre les paramètres de la ligne de commande du noyau

-

grubby(8)etzipl(8)pages de manuel - grubby tool

5.5. Modification temporaire des paramètres de la ligne de commande du noyau au moment du démarrage

Apporter des modifications temporaires à une entrée de menu du noyau en modifiant les paramètres du noyau uniquement au cours d'un processus de démarrage unique.

Procédure

- Sélectionnez le noyau que vous souhaitez lancer lorsque le menu de démarrage de GRUB 2 s'affiche et appuyez sur la touche e pour modifier les paramètres du noyau.

-

Trouvez la ligne de commande du noyau en déplaçant le curseur vers le bas. La ligne de commande du noyau commence par

linuxsur les systèmes IBM Power Series 64 bits et x86-64 basés sur le BIOS, ou parlinuxefisur les systèmes UEFI. Déplacer le curseur à la fin de la ligne.

NoteAppuyer sur Ctrl+a pour sauter au début de la ligne et Ctrl+e pour passer à la fin de la ligne. Sur certains systèmes, les touches Home et End peuvent également fonctionner.

-

Modifiez les paramètres du noyau en fonction des besoins. Par exemple, pour faire fonctionner le système en mode d'urgence, ajoutez le paramètre emergency à la fin de la ligne

linux:

linux ($root)/vmlinuz-5.14.0-63.el9.x86_64 root=/dev/mapper/rhel-root ro crashkernel=1G-4G:192M,4G-64G:256M,64G-:512M resume=/dev/mapper/rhel-swap rd.lvm.lv=rhel/root rd.lvm.lv=rhel/swap rhgb quiet pass:quotes[_emergency_]

Pour activer les messages du système, supprimez les paramètres rhgb et quiet.

- Appuyer sur Ctrl+x pour démarrer avec le noyau sélectionné et les paramètres de ligne de commande modifiés.

Appuyez sur la touche Esc pour quitter l'édition de la ligne de commande et toutes les modifications effectuées par l'utilisateur seront supprimées.

Cette procédure ne s'applique qu'à un seul démarrage et n'apporte pas de modifications permanentes.

5.6. Configuration des paramètres GRUB pour permettre la connexion à une console série

La console série est utile lorsque vous devez vous connecter à un serveur sans tête ou à un système embarqué et que le réseau est en panne. Ou lorsque vous devez contourner les règles de sécurité et obtenir un accès de connexion sur un autre système.

Vous devez configurer certains paramètres par défaut de GRUB pour utiliser la connexion de console série.

Conditions préalables

- Vous disposez des droits d'accès à la racine.

Procédure

Ajoutez les deux lignes suivantes au fichier

/etc/default/grub:GRUB_TERMINAL="serial" GRUB_SERIAL_COMMAND="serial --speed=9600 --unit=0 --word=8 --parity=no --stop=1"

La première ligne désactive le terminal graphique. La clé

GRUB_TERMINALremplace les valeurs des clésGRUB_TERMINAL_INPUTetGRUB_TERMINAL_OUTPUT.La deuxième ligne ajuste le débit en bauds (

--speed), la parité et d'autres valeurs en fonction de votre environnement et de votre matériel. Notez qu'une vitesse de transmission beaucoup plus élevée, par exemple 115200, est préférable pour des tâches telles que le suivi des fichiers journaux.Mettre à jour le fichier de configuration GRUB.

Sur les machines basées sur le BIOS :

# grub2-mkconfig -o /boot/grub2/grub.cfgSur les machines basées sur l'UEFI :

# grub2-mkconfig -o /boot/grub2/grub.cfg

- Redémarrez le système pour que les modifications soient prises en compte.

Chapitre 6. Configuration des paramètres du noyau au moment de l'exécution

En tant qu'administrateur système, vous pouvez modifier de nombreuses facettes du comportement du noyau de Red Hat Enterprise Linux lors de l'exécution. Configurez les paramètres du noyau au moment de l'exécution en utilisant la commande sysctl et en modifiant les fichiers de configuration dans les répertoires /etc/sysctl.d/ et /proc/sys/.

6.1. Qu'est-ce que les paramètres du noyau ?

Les paramètres du noyau sont des valeurs réglables que vous pouvez ajuster pendant que le système fonctionne. Il n'est pas nécessaire de redémarrer ou de recompiler le noyau pour que les modifications prennent effet.

Il est possible d'adresser les paramètres du noyau par l'intermédiaire de :

-

La commande

sysctl -

Le système de fichiers virtuel monté dans le répertoire

/proc/sys/ -

Les fichiers de configuration dans le répertoire

/etc/sysctl.d/

Les paramètres sont divisés en classes par le sous-système du noyau. Red Hat Enterprise Linux possède les classes de paramètres suivantes :

Tableau 6.1. Tableau des classes sysctl

| Classe accordable | Sous-système |

|---|---|

| abi | Domaines d'exécution et personnalités |

| crypto | Interfaces cryptographiques |

| débogage | Interfaces de débogage du noyau |

| dev | Informations spécifiques à l'appareil |

| fs | Paramètres globaux et spécifiques du système de fichiers |

| noyau | Paramètres globaux du noyau |

| net | Paramètres de réseau |

| sunrpc | Appel de procédure à distance Sun (NFS) |

| utilisateur | Limites de l'espace de nommage de l'utilisateur |

| vm | Optimisation et gestion de la mémoire, des tampons et du cache |

La configuration des paramètres du noyau sur un système de production nécessite une planification minutieuse. Des modifications non planifiées peuvent rendre le noyau instable et nécessiter un redémarrage du système. Vérifiez que vous utilisez des options valides avant de modifier les valeurs du noyau.

Ressources supplémentaires

-

sysctl(8)etsysctl.d(5)pages de manuel

6.2. Configurer temporairement les paramètres du noyau avec sysctl

La commande sysctl permet de définir temporairement les paramètres du noyau au moment de l'exécution. Cette commande est également utile pour lister et filtrer les paramètres.

Conditions préalables

- Autorisations de la racine

Procédure

Liste de tous les paramètres et de leurs valeurs.

# sysctl -aNoteLa commande

# sysctl -aaffiche les paramètres du noyau, qui peuvent être ajustés en cours d'exécution et au démarrage.Pour configurer temporairement un paramètre, entrez :

# sysctl <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE>L'exemple de commande ci-dessus modifie la valeur du paramètre alors que le système est en cours d'exécution. Les modifications prennent effet immédiatement, sans qu'il soit nécessaire de redémarrer le système.

NoteLes modifications reviennent aux valeurs par défaut après le redémarrage du système.

Ressources supplémentaires

6.3. Configuration permanente des paramètres du noyau avec sysctl

Utilisez la commande sysctl pour définir de manière permanente les paramètres du noyau.

Conditions préalables

- Autorisations de la racine

Procédure

Liste de tous les paramètres.

# sysctl -aLa commande affiche tous les paramètres du noyau qui peuvent être configurés au moment de l'exécution.

Configurer un paramètre de manière permanente :

# sysctl -w <TUNABLE_CLASS>.<PARAMETER>=<TARGET_VALUE> >> /etc/sysctl.confL'exemple de commande modifie la valeur ajustable et l'écrit dans le fichier

/etc/sysctl.conf, ce qui remplace les valeurs par défaut des paramètres du noyau. Les modifications prennent effet immédiatement et de manière persistante, sans qu'il soit nécessaire de redémarrer le système.

Pour modifier de manière permanente les paramètres du noyau, vous pouvez également modifier manuellement les fichiers de configuration dans le répertoire /etc/sysctl.d/.

Ressources supplémentaires

-

Les pages du manuel

sysctl(8)etsysctl.conf(5) - Utilisation des fichiers de configuration dans /etc/sysctl.d/ pour ajuster les paramètres du noyau