Configurer et gérer des clusters à haute disponibilité

Utilisation de Red Hat High Availability Add-On pour créer et maintenir des clusters Pacemaker

Résumé

Rendre l'open source plus inclusif

Red Hat s'engage à remplacer les termes problématiques dans son code, sa documentation et ses propriétés Web. Nous commençons par ces quatre termes : master, slave, blacklist et whitelist. En raison de l'ampleur de cette entreprise, ces changements seront mis en œuvre progressivement au cours de plusieurs versions à venir. Pour plus de détails, voir le message de notre directeur technique Chris Wright.

Fournir un retour d'information sur la documentation de Red Hat

Nous apprécions vos commentaires sur notre documentation. Faites-nous savoir comment nous pouvons l'améliorer.

Soumettre des commentaires sur des passages spécifiques

- Consultez la documentation au format Multi-page HTML et assurez-vous que le bouton Feedback apparaît dans le coin supérieur droit après le chargement complet de la page.

- Utilisez votre curseur pour mettre en évidence la partie du texte que vous souhaitez commenter.

- Cliquez sur le bouton Add Feedback qui apparaît près du texte en surbrillance.

- Ajoutez vos commentaires et cliquez sur Submit.

Soumettre des commentaires via Bugzilla (compte requis)

- Connectez-vous au site Web de Bugzilla.

- Sélectionnez la version correcte dans le menu Version.

- Saisissez un titre descriptif dans le champ Summary.

- Saisissez votre suggestion d'amélioration dans le champ Description. Incluez des liens vers les parties pertinentes de la documentation.

- Cliquez sur Submit Bug.

Chapitre 1. Aperçu du module complémentaire de haute disponibilité

Le module complémentaire de haute disponibilité est un système en grappe qui assure la fiabilité, l'évolutivité et la disponibilité des services de production critiques.

Une grappe est constituée de deux ordinateurs ou plus (appelés nodes ou members) qui travaillent ensemble pour effectuer une tâche. Les grappes peuvent être utilisées pour fournir des services ou des ressources hautement disponibles. La redondance de plusieurs machines permet de se prémunir contre de nombreux types de défaillances.

Les grappes à haute disponibilité fournissent des services hautement disponibles en éliminant les points de défaillance uniques et en transférant les services d'un nœud à l'autre au cas où un nœud deviendrait inopérant. En règle générale, les services d'une grappe à haute disponibilité lisent et écrivent des données (au moyen de systèmes de fichiers montés en lecture-écriture). Par conséquent, une grappe à haute disponibilité doit maintenir l'intégrité des données lorsqu'un nœud de la grappe prend le contrôle d'un service d'un autre nœud de la grappe. Les défaillances de nœuds dans une grappe à haute disponibilité ne sont pas visibles pour les clients extérieurs à la grappe. (Les grappes à haute disponibilité sont parfois appelées grappes de basculement.) Le module complémentaire de haute disponibilité fournit une grappe à haute disponibilité par l'intermédiaire de son composant de gestion de services à haute disponibilité, Pacemaker.

1.1. Composants complémentaires de haute disponibilité

Le module complémentaire de haute disponibilité de Red Hat est constitué de plusieurs composants qui fournissent le service de haute disponibilité.

Les principaux composants du module complémentaire de haute disponibilité sont les suivants :

- Infrastructure de grappe - Fournit les fonctions fondamentales permettant aux nœuds de travailler ensemble en tant que grappe : gestion des fichiers de configuration, gestion des membres, gestion des verrous et clôtures.

- Gestion des services à haute disponibilité - assure le basculement des services d'un nœud de la grappe à l'autre en cas de défaillance d'un nœud.

- Outils d'administration des clusters - Outils de configuration et de gestion permettant de mettre en place, de configurer et de gérer le module complémentaire de haute disponibilité. Ces outils sont destinés à être utilisés avec les composants de l'infrastructure du cluster, les composants de gestion de la haute disponibilité et des services, et le stockage.

Vous pouvez compléter le module complémentaire de haute disponibilité avec les composants suivants :

- Red Hat GFS2 (Global File System 2) - Faisant partie du module complémentaire de stockage résilient, il fournit un système de fichiers en cluster à utiliser avec le module complémentaire de haute disponibilité. GFS2 permet à plusieurs nœuds de partager le stockage au niveau des blocs comme si le stockage était connecté localement à chaque nœud du cluster. Le système de fichiers en cluster GFS2 nécessite une infrastructure en cluster.

-

LVM Locking Daemon (

lvmlockd) - Partie intégrante du module complémentaire Resilient Storage, il assure la gestion des volumes de stockage en grappe. La prise en charge delvmlockdnécessite également une infrastructure en grappe. - HAProxy - Logiciel de routage qui assure l'équilibrage de la charge à haute disponibilité et le basculement des services de la couche 4 (TCP) et de la couche 7 (HTTP, HTTPS).

1.2. Concepts du module complémentaire de haute disponibilité

Certains des concepts clés d'un cluster Red Hat High Availability Add-On sont les suivants.

1.2.1. Clôture

Si la communication avec un seul nœud de la grappe échoue, les autres nœuds de la grappe doivent être en mesure de restreindre ou de libérer l'accès aux ressources auxquelles le nœud défaillant peut avoir accès. Il n'est pas possible de le faire en contactant le nœud de la grappe lui-même, car il risque de ne pas être réactif. Au lieu de cela, vous devez fournir une méthode externe, appelée clôture avec un agent de clôture. Un dispositif de clôture est un dispositif externe qui peut être utilisé par la grappe pour restreindre l'accès d'un nœud défaillant aux ressources partagées ou pour redémarrer brutalement le nœud de la grappe.

Sans dispositif de clôture configuré, vous n'avez aucun moyen de savoir que les ressources précédemment utilisées par le nœud de grappe déconnecté ont été libérées, ce qui pourrait empêcher les services de fonctionner sur l'un des autres nœuds de grappe. Inversement, le système peut supposer à tort que le nœud de la grappe a libéré ses ressources, ce qui peut entraîner la corruption et la perte de données. Sans dispositif de clôture configuré, l'intégrité des données ne peut être garantie et la configuration de la grappe ne sera pas prise en charge.

Lorsque la clôture est en cours, aucune autre opération de la grappe n'est autorisée. Le fonctionnement normal de la grappe ne peut pas reprendre avant la fin de la clôture ou avant que le nœud de la grappe ne rejoigne la grappe après avoir été redémarré.

Pour plus d'informations sur la clôture, voir Clôture dans un cluster Red Hat High Availability.

1.2.2. Quorum

Afin de maintenir l'intégrité et la disponibilité de la grappe, les systèmes de grappes utilisent un concept connu sous le nom de quorum pour empêcher la corruption et la perte de données. Une grappe a un quorum lorsque plus de la moitié des nœuds de la grappe sont en ligne. Pour réduire les risques de corruption des données en cas de défaillance, Pacemaker arrête par défaut toutes les ressources si la grappe n'a pas de quorum.

Le quorum est établi à l'aide d'un système de vote. Lorsqu'un nœud de la grappe ne fonctionne pas comme il le devrait ou perd la communication avec le reste de la grappe, la majorité des nœuds en activité peuvent voter pour isoler et, si nécessaire, clôturer le nœud pour qu'il soit réparé.

Par exemple, dans une grappe de 6 nœuds, le quorum est établi lorsqu'au moins 4 nœuds de la grappe fonctionnent. Si la majorité des nœuds se déconnectent ou deviennent indisponibles, la grappe n'a plus de quorum et Pacemaker arrête les services en grappe.

Les fonctions de quorum de Pacemaker permettent d'éviter ce que l'on appelle également split-brain, un phénomène dans lequel la grappe est séparée de la communication, mais où chaque partie continue à travailler comme des grappes séparées, en écrivant potentiellement sur les mêmes données et en provoquant éventuellement des corruptions ou des pertes. Pour plus d'informations sur ce que signifie être dans un état de cerveau divisé, et sur les concepts de quorum en général, voir Exploring Concepts of RHEL High Availability Clusters - Quorum (Explorer les concepts des clusters haute disponibilité RHEL - Quorum).

Un cluster Red Hat Enterprise Linux High Availability Add-On utilise le service votequorum, en conjonction avec la clôture, pour éviter les situations de cerveau divisé. Un nombre de votes est attribué à chaque système de la grappe, et les opérations de la grappe ne sont autorisées que lorsqu'une majorité de votes est présente.

1.2.3. Cluster resources

Un site cluster resource est une instance de programme, de données ou d'application qui doit être gérée par le service de cluster. Ces ressources sont abstraites par agents qui fournit une interface standard pour la gestion de la ressource dans un environnement de cluster.

Pour garantir que les ressources restent saines, vous pouvez ajouter une opération de contrôle à la définition d'une ressource. Si vous ne spécifiez pas d'opération de surveillance pour une ressource, une opération est ajoutée par défaut.

Vous pouvez déterminer le comportement d'une ressource dans un cluster en configurant constraints. Vous pouvez configurer les catégories de contraintes suivantes :

- contraintes d'emplacement - Une contrainte d'emplacement détermine les nœuds sur lesquels une ressource peut s'exécuter.

- contraintes d'ordre - Une contrainte d'ordre détermine l'ordre d'exécution des ressources.

- contraintes de colocalisation - Une contrainte de colocalisation détermine où les ressources seront placées par rapport à d'autres ressources.

L'un des éléments les plus courants d'un cluster est un ensemble de ressources qui doivent être situées ensemble, démarrer de manière séquentielle et s'arrêter dans l'ordre inverse. Pour simplifier cette configuration, Pacemaker prend en charge le concept de groups.

1.3. Aperçu des stimulateurs cardiaques

Pacemaker est un gestionnaire de ressources en grappe. Il assure une disponibilité maximale des services et des ressources de la grappe en utilisant les capacités de messagerie et d'adhésion de l'infrastructure de la grappe pour prévenir les défaillances au niveau des nœuds et des ressources et y remédier.

1.3.1. Composants de l'architecture du stimulateur cardiaque

Un cluster configuré avec Pacemaker comprend des démons de composants distincts qui surveillent l'appartenance au cluster, des scripts qui gèrent les services et des sous-systèmes de gestion des ressources qui surveillent les ressources disparates.

L'architecture de Pacemaker se compose des éléments suivants :

- Base d'informations sur les clusters (CIB)

- Le démon d'information Pacemaker, qui utilise XML en interne pour distribuer et synchroniser la configuration actuelle et les informations d'état du coordinateur désigné (DC) - un nœud assigné par Pacemaker pour stocker et distribuer l'état et les actions de la grappe au moyen de la CIB - à tous les autres nœuds de la grappe.

- Démon de gestion des ressources du cluster (CRMd)

Les actions sur les ressources de la grappe Pacemaker sont acheminées par l'intermédiaire de ce démon. Les ressources gérées par CRMd peuvent être interrogées par les systèmes clients, déplacées, instanciées et modifiées si nécessaire.

Chaque nœud de la grappe comprend également un démon de gestion des ressources locales (LRMd) qui sert d'interface entre CRMd et les ressources. Le LRMd transmet les commandes de CRMd aux agents, comme le démarrage et l'arrêt et la transmission d'informations sur l'état des ressources.

- Tirez dans la tête de l'autre nœud (STONITH)

- STONITH est l'implémentation de la clôture de Pacemaker. Il agit comme une ressource de cluster dans Pacemaker qui traite les demandes de clôture, en arrêtant de force les nœuds et en les retirant du cluster pour garantir l'intégrité des données. STONITH est configuré dans la CIB et peut être surveillé comme une ressource de cluster normale.

- corosync

corosyncest le composant - et le démon du même nom - qui répond aux besoins essentiels en matière d'adhésion et de communication avec les membres pour les grappes à haute disponibilité. Il est nécessaire au fonctionnement du module complémentaire de haute disponibilité.Outre ces fonctions d'adhésion et de messagerie, le site

corosyncoffre également les services suivants :- Gère les règles de quorum et la détermination de celui-ci.

- Fournit des capacités de messagerie pour les applications qui coordonnent ou opèrent à travers plusieurs membres du cluster et qui doivent donc communiquer des informations d'état ou autres entre les instances.

-

Utilise la bibliothèque

kronosnetcomme transport réseau pour fournir des liens redondants multiples et un basculement automatique.

1.3.2. Outils de configuration et de gestion de Pacemaker

Le module complémentaire de haute disponibilité comprend deux outils de configuration pour le déploiement, la surveillance et la gestion des clusters.

pcsL'interface de ligne de commande

pcscontrôle et configure Pacemaker et le démon Heartbeatcorosync. Programme basé sur la ligne de commande,pcspeut effectuer les tâches de gestion de cluster suivantes :- Créer et configurer un cluster Pacemaker/Corosync

- Modifier la configuration de la grappe en cours d'exécution

- Configurer à distance Pacemaker et Corosync, ainsi que démarrer, arrêter et afficher des informations sur l'état de la grappe

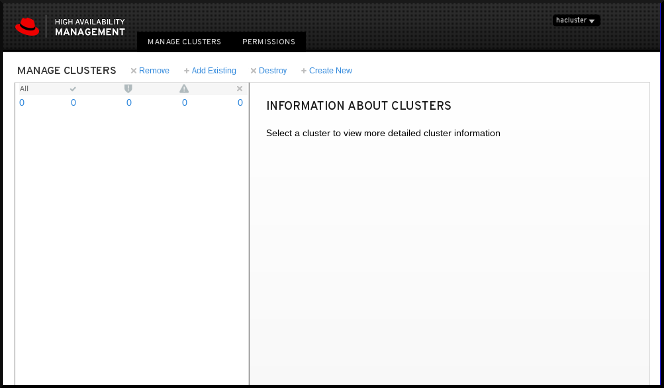

pcsdInterface utilisateur Web- Une interface utilisateur graphique pour créer et configurer les clusters Pacemaker/Corosync.

1.3.3. Les fichiers de configuration du cluster et du pacemaker

Les fichiers de configuration pour le Red Hat High Availability Add-On sont corosync.conf et cib.xml.

Le fichier corosync.conf fournit les paramètres de cluster utilisés par corosync, le gestionnaire de cluster sur lequel Pacemaker est construit. En général, vous ne devez pas éditer directement le fichier corosync.conf, mais plutôt utiliser l'interface pcs ou pcsd.

Le fichier cib.xml est un fichier XML qui représente à la fois la configuration de la grappe et l'état actuel de toutes les ressources de la grappe. Ce fichier est utilisé par la base d'informations sur les clusters (CIB) de Pacemaker. Le contenu de la CIB est automatiquement synchronisé avec l'ensemble de la grappe. Ne modifiez pas directement le fichier cib.xml; utilisez plutôt l'interface pcs ou pcsd.

1.4. Volumes logiques LVM dans un cluster de haute disponibilité Red Hat

Le module complémentaire de haute disponibilité de Red Hat prend en charge les volumes LVM dans deux configurations de cluster distinctes.

Les configurations de cluster que vous pouvez choisir sont les suivantes :

- Volumes LVM à haute disponibilité (HA-LVM) dans les configurations de basculement actif/passif dans lesquelles un seul nœud de la grappe accède au stockage à tout moment.

-

Les volumes LVM qui utilisent le démon

lvmlockdpour gérer les périphériques de stockage dans des configurations actives/actives dans lesquelles plus d'un nœud de la grappe a besoin d'accéder au stockage en même temps. Le démonlvmlockdfait partie du module complémentaire Resilient Storage.

1.4.1. Choisir HA-LVM ou des volumes partagés

L'utilisation de HA-LVM ou de volumes logiques partagés gérés par le démon lvmlockd doit se faire en fonction des besoins des applications ou des services déployés.

-

Si plusieurs nœuds de la grappe ont besoin d'un accès simultané en lecture/écriture aux volumes LVM dans un système actif/actif, vous devez utiliser le démon

lvmlockdet configurer vos volumes en tant que volumes partagés. Le démonlvmlockdfournit un système permettant de coordonner l'activation et les modifications des volumes LVM sur les nœuds d'une grappe simultanément. Le service de verrouillage du démonlvmlockdprotège les métadonnées LVM lorsque les différents nœuds de la grappe interagissent avec les volumes et apportent des modifications à leur configuration. Cette protection dépend de la configuration de tout groupe de volumes qui sera activé simultanément sur plusieurs nœuds de la grappe en tant que volume partagé. -

Si le cluster de haute disponibilité est configuré pour gérer des ressources partagées de manière active/passive, avec un seul membre ayant besoin d'accéder à un volume LVM donné à la fois, vous pouvez utiliser HA-LVM sans le service de verrouillage

lvmlockd.

La plupart des applications fonctionneront mieux dans une configuration active/passive, car elles ne sont pas conçues ou optimisées pour fonctionner simultanément avec d'autres instances. Le choix d'exécuter une application qui n'est pas compatible avec les clusters sur des volumes logiques partagés peut entraîner une dégradation des performances. En effet, dans ces instances, les volumes logiques font l'objet d'une surcharge de communication avec les clusters. Une application compatible avec les grappes doit être en mesure de réaliser des gains de performances supérieurs aux pertes de performances introduites par les systèmes de fichiers en grappes et les volumes logiques compatibles avec les grappes. Certaines applications et charges de travail y parviennent plus facilement que d'autres. Pour choisir entre les deux variantes de LVM, il faut déterminer quelles sont les exigences de la grappe et si l'effort supplémentaire d'optimisation pour une grappe active/active portera ses fruits. La plupart des utilisateurs obtiendront les meilleurs résultats en utilisant HA-LVM.

HA-LVM et les volumes logiques partagés utilisant lvmlockd sont similaires en ce sens qu'ils empêchent la corruption des métadonnées LVM et de ses volumes logiques, ce qui pourrait se produire si plusieurs machines sont autorisées à effectuer des modifications qui se chevauchent. HA-LVM impose la restriction qu'un volume logique ne peut être activé que de manière exclusive, c'est-à-dire sur une seule machine à la fois. Cela signifie que seules les implémentations locales (non groupées) des pilotes de stockage sont utilisées. Le fait d'éviter ainsi les frais généraux liés à la coordination des clusters permet d'améliorer les performances. Un volume partagé utilisant lvmlockd n'impose pas ces restrictions et un utilisateur est libre d'activer un volume logique sur toutes les machines d'une grappe ; cela oblige à utiliser des pilotes de stockage adaptés à la grappe, ce qui permet de mettre en place des systèmes de fichiers et des applications adaptés à la grappe.

1.4.2. Configuration des volumes LVM dans un cluster

Les clusters sont gérés par Pacemaker. Les volumes logiques partagés et HA-LVM ne sont pris en charge qu'avec les clusters Pacemaker et doivent être configurés en tant que ressources de cluster.

Si un groupe de volumes LVM utilisé par un cluster Pacemaker contient un ou plusieurs volumes physiques résidant sur un stockage en bloc distant, tel qu'une cible iSCSI, Red Hat vous recommande de configurer une cible systemd resource-agents-deps et une unité de dépôt systemd pour la cible afin de garantir que le service démarre avant le démarrage de Pacemaker. Pour plus d'informations sur la configuration d'une cible systemd resource-agents-deps, reportez-vous à Configuration de l'ordre de démarrage pour les dépendances de ressources non gérées par Pacemaker.

Pour des exemples de procédures de configuration d'un volume HA-LVM dans le cadre d'un cluster Pacemaker, voir Configuration d'un serveur HTTP Apache actif/passif dans un cluster Red Hat High Availability et Configuration d'un serveur NFS actif/passif dans un cluster Red Hat High Availability.

Ces procédures comprennent les étapes suivantes :

- S'assurer que seule la grappe est capable d'activer le groupe de volumes

- Configuration d'un volume logique LVM

- Configuration du volume LVM en tant que ressource de cluster

-

Pour les procédures de configuration des volumes LVM partagés qui utilisent le démon

lvmlockdpour gérer les périphériques de stockage dans des configurations actives/actives, voir Systèmes de fichiers GFS2 dans un cluster et Configuration d'un serveur Samba actif/actif dans un cluster Red Hat High Availability.

Chapitre 2. Démarrer avec Pacemaker

Pour vous familiariser avec les outils et les processus utilisés pour créer une grappe Pacemaker, vous pouvez exécuter les procédures suivantes. Elles sont destinées aux utilisateurs qui souhaitent voir à quoi ressemble le logiciel de la grappe et comment il est administré, sans avoir besoin de configurer une grappe opérationnelle.

Ces procédures ne créent pas un cluster Red Hat pris en charge, qui nécessite au moins deux nœuds et la configuration d'un dispositif de clôture. Pour obtenir des informations complètes sur les politiques d'assistance, les exigences et les limitations de Red Hat pour les clusters RHEL High Availability, voir Politiques d'assistance pour les clusters RHEL High Availability.

2.1. Apprendre à utiliser un stimulateur cardiaque

En suivant cette procédure, vous apprendrez à utiliser Pacemaker pour configurer une grappe, à afficher l'état de la grappe et à configurer un service de grappe. Cet exemple crée un serveur HTTP Apache en tant que ressource de grappe et montre comment la grappe réagit en cas d'échec de la ressource.

Dans cet exemple :

-

Le nœud est

z1.example.com. - L'adresse IP flottante est 192.168.122.120.

Conditions préalables

- Un seul nœud fonctionnant sous RHEL 9

- Une adresse IP flottante qui réside sur le même réseau que l'une des adresses IP attribuées de manière statique au nœud

-

Le nom du nœud sur lequel vous travaillez se trouve dans votre fichier

/etc/hosts

Procédure

Installez les paquetages logiciels Red Hat High Availability Add-On à partir du canal High Availability, puis démarrez et activez le service

pcsd.# dnf install pcs pacemaker fence-agents-all ... # systemctl start pcsd.service # systemctl enable pcsd.service

Si vous exécutez le démon

firewalld, activez les ports requis par le Red Hat High Availability Add-On.# firewall-cmd --permanent --add-service=high-availability # firewall-cmd --reload

Définissez un mot de passe pour l'utilisateur

haclustersur chaque nœud du cluster et authentifiez l'utilisateurhaclusterpour chaque nœud du cluster sur le nœud à partir duquel vous exécuterez les commandespcs. Cet exemple n'utilise qu'un seul nœud, le nœud à partir duquel vous exécutez les commandes, mais cette étape est incluse ici car il s'agit d'une étape nécessaire dans la configuration d'un cluster multi-nœuds pris en charge par Red Hat High Availability.# passwd hacluster ... # pcs host auth z1.example.com

Créez un cluster nommé

my_clusteravec un membre et vérifiez l'état du cluster. Cette commande crée et démarre la grappe en une seule étape.# pcs cluster setup my_cluster --start z1.example.com ... # pcs cluster status Cluster Status: Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Thu Oct 11 16:11:18 2018 Last change: Thu Oct 11 16:11:00 2018 by hacluster via crmd on z1.example.com 1 node configured 0 resources configured PCSD Status: z1.example.com: Online

Un cluster Red Hat High Availability nécessite que vous configuriez la clôture pour le cluster. Les raisons de cette exigence sont décrites dans Fencing in a Red Hat High Availability Cluster (Clôture dans un cluster Red Hat High Availability). Cependant, pour cette introduction, qui est destinée à montrer uniquement comment utiliser les commandes de base de Pacemaker, désactivez la clôture en définissant l'option de cluster

stonith-enabledsurfalse.AvertissementL'utilisation de

stonith-enabled=falseest totalement inappropriée pour un cluster de production. Elle indique au cluster de simplement prétendre que les nœuds défaillants sont clôturés en toute sécurité.# pcs property set stonith-enabled=falseConfigurez un navigateur web sur votre système et créez une page web pour afficher un simple message texte. Si vous exécutez le démon

firewalld, activez les ports requis parhttpd.NoteN'utilisez pas

systemctl enablepour permettre aux services qui seront gérés par le cluster de démarrer au démarrage du système.# dnf install -y httpd wget ... # firewall-cmd --permanent --add-service=http # firewall-cmd --reload # cat <<-END >/var/www/html/index.html <html> <body>My Test Site - $(hostname)</body> </html> END

Pour que l'agent de ressources Apache puisse obtenir l'état d'Apache, ajoutez la configuration suivante à la configuration existante pour activer l'URL du serveur d'état.

# cat <<-END > /etc/httpd/conf.d/status.conf <Location /server-status> SetHandler server-status Order deny,allow Deny from all Allow from 127.0.0.1 Allow from ::1 </Location> END

Créez les ressources

IPaddr2etapachepour le cluster à gérer. La ressource "IPaddr2" est une adresse IP flottante qui ne doit pas être déjà associée à un nœud physique. Si le périphérique NIC de la ressource "IPaddr2" n'est pas spécifié, l'adresse IP flottante doit résider sur le même réseau que l'adresse IP statiquement assignée utilisée par le nœud.Vous pouvez afficher une liste de tous les types de ressources disponibles à l'aide de la commande

pcs resource list. Vous pouvez utiliser la commandepcs resource describe resourcetypepour afficher les paramètres que vous pouvez définir pour le type de ressource spécifié. Par exemple, la commande suivante affiche les paramètres que vous pouvez définir pour une ressource de typeapache:# pcs resource describe apache ...Dans cet exemple, la ressource adresse IP et la ressource apache sont toutes deux configurées comme faisant partie d'un groupe nommé

apachegroup, ce qui garantit que les ressources sont conservées ensemble pour fonctionner sur le même nœud lorsque vous configurez un cluster multi-nœuds fonctionnel.# pcs resource create ClusterIP ocf:heartbeat:IPaddr2 ip=192.168.122.120 --group apachegroup # pcs resource create WebSite ocf:heartbeat:apache configfile=/etc/httpd/conf/httpd.conf statusurl="http://localhost/server-status" --group apachegroup # pcs status Cluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 1 node configured 2 resources configured Online: [ z1.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com PCSD Status: z1.example.com: Online ...

Après avoir configuré une ressource de cluster, vous pouvez utiliser la commande

pcs resource configpour afficher les options configurées pour cette ressource.# pcs resource config WebSite Resource: WebSite (class=ocf provider=heartbeat type=apache) Attributes: configfile=/etc/httpd/conf/httpd.conf statusurl=http://localhost/server-status Operations: start interval=0s timeout=40s (WebSite-start-interval-0s) stop interval=0s timeout=60s (WebSite-stop-interval-0s) monitor interval=1min (WebSite-monitor-interval-1min)- Dirigez votre navigateur vers le site web que vous avez créé à l'aide de l'adresse IP flottante que vous avez configurée. Celui-ci devrait afficher le message texte que vous avez défini.

Arrêtez le service web Apache et vérifiez l'état de la grappe. L'utilisation de

killall -9simule une panne au niveau de l'application.# killall -9 httpdVérifiez l'état de la grappe. Vous devriez voir que l'arrêt du service web a provoqué un échec, mais que le logiciel du cluster a redémarré le service et que vous devriez toujours pouvoir accéder au site web.

# pcs status Cluster name: my_cluster ... Current DC: z1.example.com (version 1.1.13-10.el7-44eb2dd) - partition with quorum 1 node and 2 resources configured Online: [ z1.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com Failed Resource Actions: * WebSite_monitor_60000 on z1.example.com 'not running' (7): call=13, status=complete, exitreason='none', last-rc-change='Thu Oct 11 23:45:50 2016', queued=0ms, exec=0ms PCSD Status: z1.example.com: OnlineVous pouvez effacer l'état d'échec de la ressource qui a échoué une fois que le service est à nouveau opérationnel et que l'avis d'échec de l'action n'apparaît plus lorsque vous consultez l'état du cluster.

# pcs resource cleanup WebSiteLorsque vous avez terminé d'examiner la grappe et son état, arrêtez les services de grappe sur le nœud. Même si vous n'avez démarré les services que sur un seul nœud pour cette introduction, le paramètre

--allest inclus car il arrêterait les services de cluster sur tous les nœuds d'un cluster multi-nœuds réel.# pcs cluster stop --all

2.2. Apprendre à configurer le basculement

La procédure suivante constitue une introduction à la création d'une grappe Pacemaker exécutant un service qui basculera d'un nœud à l'autre lorsque le nœud sur lequel le service s'exécute devient indisponible. En suivant cette procédure, vous apprendrez à créer un service dans une grappe à deux nœuds et vous pourrez ensuite observer ce qui arrive à ce service lorsqu'il tombe en panne sur le nœud sur lequel il s'exécute.

Cet exemple de procédure configure un cluster Pacemaker à deux nœuds exécutant un serveur HTTP Apache. Vous pouvez ensuite arrêter le service Apache sur un nœud pour voir comment le service reste disponible.

Dans cet exemple :

-

Les nœuds sont

z1.example.cometz2.example.com. - L'adresse IP flottante est 192.168.122.120.

Conditions préalables

- Deux nœuds fonctionnant sous RHEL 9 et pouvant communiquer l'un avec l'autre

- Une adresse IP flottante qui réside sur le même réseau que l'une des adresses IP attribuées de manière statique au nœud

-

Le nom du nœud sur lequel vous travaillez se trouve dans votre fichier

/etc/hosts

Procédure

Sur les deux nœuds, installez les paquetages logiciels Red Hat High Availability Add-On à partir du canal High Availability, puis démarrez et activez le service

pcsd.# dnf install pcs pacemaker fence-agents-all ... # systemctl start pcsd.service # systemctl enable pcsd.service

Si vous exécutez le démon

firewalld, activez sur les deux nœuds les ports requis par le Red Hat High Availability Add-On.# firewall-cmd --permanent --add-service=high-availability # firewall-cmd --reload

Sur les deux nœuds du cluster, définissez un mot de passe pour l'utilisateur

hacluster.# passwd haclusterAuthentifiez l'utilisateur

haclusterpour chaque nœud du cluster sur le nœud à partir duquel vous exécuterez les commandespcs.# pcs host auth z1.example.com z2.example.comCréez un cluster nommé

my_clusteravec les deux nœuds comme membres du cluster. Cette commande crée et démarre la grappe en une seule étape. Vous ne devez l'exécuter qu'à partir d'un seul nœud de la grappe, car les commandes de configuration depcss'appliquent à l'ensemble de la grappe.Sur un nœud de la grappe, exécutez la commande suivante.

# pcs cluster setup my_cluster --start z1.example.com z2.example.comUn cluster Red Hat High Availability nécessite que vous configuriez la clôture pour le cluster. Les raisons de cette exigence sont décrites dans la section Clôture dans un cluster Red Hat High Availability. Pour cette introduction, cependant, afin de montrer uniquement comment le basculement fonctionne dans cette configuration, désactivez la clôture en définissant l'option

stonith-enabledcluster surfalseAvertissementL'utilisation de

stonith-enabled=falseest totalement inappropriée pour un cluster de production. Elle indique au cluster de simplement prétendre que les nœuds défaillants sont clôturés en toute sécurité.# pcs property set stonith-enabled=falseAprès avoir créé une grappe et désactivé la clôture, vérifiez l'état de la grappe.

NoteLorsque vous exécutez la commande

pcs cluster status, il se peut que la sortie diffère légèrement des exemples au fur et à mesure que les composants du système démarrent.# pcs cluster status Cluster Status: Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Thu Oct 11 16:11:18 2018 Last change: Thu Oct 11 16:11:00 2018 by hacluster via crmd on z1.example.com 2 nodes configured 0 resources configured PCSD Status: z1.example.com: Online z2.example.com: OnlineSur les deux nœuds, configurez un navigateur web et créez une page web pour afficher un simple message texte. Si vous exécutez le démon

firewalld, activez les ports requis parhttpd.NoteN'utilisez pas

systemctl enablepour permettre aux services qui seront gérés par le cluster de démarrer au démarrage du système.# dnf install -y httpd wget ... # firewall-cmd --permanent --add-service=http # firewall-cmd --reload # cat <<-END >/var/www/html/index.html <html> <body>My Test Site - $(hostname)</body> </html> END

Pour que l'agent de ressources Apache puisse obtenir l'état d'Apache, sur chaque nœud du cluster, créez l'ajout suivant à la configuration existante pour activer l'URL du serveur d'état.

# cat <<-END > /etc/httpd/conf.d/status.conf <Location /server-status> SetHandler server-status Order deny,allow Deny from all Allow from 127.0.0.1 Allow from ::1 </Location> END

Créez les ressources

IPaddr2etapachepour le cluster à gérer. La ressource "IPaddr2" est une adresse IP flottante qui ne doit pas être déjà associée à un nœud physique. Si le périphérique NIC de la ressource "IPaddr2" n'est pas spécifié, l'adresse IP flottante doit résider sur le même réseau que l'adresse IP statiquement assignée utilisée par le nœud.Vous pouvez afficher une liste de tous les types de ressources disponibles à l'aide de la commande

pcs resource list. Vous pouvez utiliser la commandepcs resource describe resourcetypepour afficher les paramètres que vous pouvez définir pour le type de ressource spécifié. Par exemple, la commande suivante affiche les paramètres que vous pouvez définir pour une ressource de typeapache:# pcs resource describe apache ...Dans cet exemple, la ressource adresse IP et la ressource apache sont toutes deux configurées comme faisant partie d'un groupe nommé

apachegroup, ce qui garantit que les ressources sont conservées ensemble pour fonctionner sur le même nœud.Exécutez les commandes suivantes à partir d'un nœud de la grappe :

# pcs resource create ClusterIP ocf:heartbeat:IPaddr2 ip=192.168.122.120 --group apachegroup # pcs resource create WebSite ocf:heartbeat:apache configfile=/etc/httpd/conf/httpd.conf statusurl="http://localhost/server-status" --group apachegroup # pcs status Cluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 2 nodes configured 2 resources configured Online: [ z1.example.com z2.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com PCSD Status: z1.example.com: Online z2.example.com: Online ...

Notez que dans cet exemple, le service

apachegroupest exécuté sur le nœud z1.example.com.Accédez au site web que vous avez créé, arrêtez le service sur le nœud sur lequel il s'exécute et notez comment le service bascule sur le deuxième nœud.

- Dirigez un navigateur vers le site web que vous avez créé à l'aide de l'adresse IP flottante que vous avez configurée. Celui-ci doit afficher le message textuel que vous avez défini, en indiquant le nom du nœud sur lequel le site web est exécuté.

Arrêtez le service web apache. L'utilisation de

killall -9simule une panne au niveau de l'application.# killall -9 httpdVérifiez l'état de la grappe. Vous devriez constater que l'arrêt du service web a provoqué un échec, mais que le logiciel du cluster a redémarré le service sur le nœud sur lequel il s'exécutait et que vous devriez toujours pouvoir accéder au navigateur web.

# pcs status Cluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 2 nodes configured 2 resources configured Online: [ z1.example.com z2.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z1.example.com WebSite (ocf::heartbeat:apache): Started z1.example.com Failed Resource Actions: * WebSite_monitor_60000 on z1.example.com 'not running' (7): call=31, status=complete, exitreason='none', last-rc-change='Fri Feb 5 21:01:41 2016', queued=0ms, exec=0msEffacez l'état d'échec une fois que le service est à nouveau opérationnel.

# pcs resource cleanup WebSiteMettez le nœud sur lequel le service s'exécute en mode veille. Notez que, puisque nous avons désactivé la clôture, nous ne pouvons pas simuler efficacement une défaillance au niveau du nœud (comme le retrait d'un câble d'alimentation), car la clôture est nécessaire pour que le cluster se rétablisse dans de telles situations.

# pcs node standby z1.example.comVérifiez l'état de la grappe et notez où le service s'exécute maintenant.

# pcs status Cluster name: my_cluster Stack: corosync Current DC: z1.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum Last updated: Fri Oct 12 09:54:33 2018 Last change: Fri Oct 12 09:54:30 2018 by root via cibadmin on z1.example.com 2 nodes configured 2 resources configured Node z1.example.com: standby Online: [ z2.example.com ] Full list of resources: Resource Group: apachegroup ClusterIP (ocf::heartbeat:IPaddr2): Started z2.example.com WebSite (ocf::heartbeat:apache): Started z2.example.com- Accédez au site web. Il ne devrait pas y avoir de perte de service, mais le message d'affichage devrait indiquer le nœud sur lequel le service est maintenant exécuté.

Pour restaurer les services de cluster sur le premier nœud, sortez le nœud du mode veille. Cela ne ramènera pas nécessairement le service sur ce nœud.

# pcs node unstandby z1.example.comPour le nettoyage final, arrêtez les services de cluster sur les deux nœuds.

# pcs cluster stop --all

Chapitre 3. L'interface de ligne de commande pcs

L'interface de ligne de commande pcs contrôle et configure les services de cluster tels que corosync, pacemaker,booth et sbd en facilitant l'accès à leurs fichiers de configuration.

Notez que vous ne devez pas modifier directement le fichier de configuration cib.xml. Dans la plupart des cas, Pacemaker rejettera un fichier cib.xml directement modifié.

3.1. affichage de l'aide pcs

L'option -h de pcs permet d'afficher les paramètres d'une commande pcs et une description de ces paramètres.

La commande suivante affiche les paramètres de la commande pcs resource.

# pcs resource -h3.2. Visualisation de la configuration brute du cluster

Bien que vous ne deviez pas éditer directement le fichier de configuration de la grappe, vous pouvez visualiser la configuration brute de la grappe à l'aide de la commande pcs cluster cib.

Vous pouvez enregistrer la configuration brute du cluster dans un fichier spécifié avec la commande pcs cluster cib filename pour enregistrer la configuration brute du cluster dans un fichier spécifié. Si vous avez déjà configuré un cluster et qu'il y a déjà une CIB active, vous utilisez la commande suivante pour enregistrer le fichier xml brut.

pcs cluster cib filename

Par exemple, la commande suivante enregistre le xml brut de la CIB dans un fichier nommé testfile.

# pcs cluster cib testfile3.3. Enregistrement d'une modification de configuration dans un fichier de travail

Lors de la configuration d'un cluster, vous pouvez enregistrer les modifications de configuration dans un fichier spécifié sans affecter le CIB actif. Cela vous permet de spécifier des mises à jour de configuration sans mettre immédiatement à jour la configuration du cluster en cours d'exécution avec chaque mise à jour individuelle.

Pour plus d'informations sur l'enregistrement de la CIB dans un fichier, reportez-vous à la section Visualisation de la configuration brute du cluster. Une fois que vous avez créé ce fichier, vous pouvez enregistrer les modifications de configuration dans ce fichier plutôt que dans la CIB active en utilisant l'option -f de la commande pcs. Lorsque vous avez terminé les modifications et que vous êtes prêt à mettre à jour le fichier CIB actif, vous pouvez pousser les mises à jour du fichier avec la commande pcs cluster cib-push.

Procédure

La procédure suivante est recommandée pour apporter des modifications au fichier CIB. Cette procédure crée une copie du fichier CIB original sauvegardé et apporte des modifications à cette copie. Lors du transfert de ces modifications dans le fichier CIB actif, cette procédure spécifie l'option diff-against de la commande pcs cluster cib-push afin que seules les modifications entre le fichier d'origine et le fichier mis à jour soient transférées dans le fichier CIB. Cela permet aux utilisateurs d'effectuer en parallèle des modifications qui ne s'écrasent pas les unes les autres et de réduire la charge de travail de Pacemaker, qui n'a pas besoin d'analyser l'intégralité du fichier de configuration.

Sauvegarder la CIB active dans un fichier. Cet exemple enregistre la CIB dans un fichier nommé

original.xml.# pcs cluster cib original.xmlCopiez le fichier enregistré dans le fichier de travail que vous utiliserez pour les mises à jour de la configuration.

# cp original.xml updated.xmlMettez à jour votre configuration si nécessaire. La commande suivante crée une ressource dans le fichier

updated.xmlmais n'ajoute pas cette ressource à la configuration du cluster en cours d'exécution.# pcs -f updated.xml resource create VirtualIP ocf:heartbeat:IPaddr2 ip=192.168.0.120 op monitor interval=30sTransférer le fichier mis à jour vers la CIB active, en précisant que vous ne transférez que les modifications apportées au fichier d'origine.

# pcs cluster cib-push updated.xml diff-against=original.xml

Vous pouvez également afficher tout le contenu actuel d'un fichier CIB à l'aide de la commande suivante.

pcs cluster cib-push filename

Lors du transfert du fichier CIB complet, Pacemaker vérifie la version et ne vous permet pas de transférer un fichier CIB plus ancien que celui qui se trouve déjà dans un cluster. Si vous devez mettre à jour l'ensemble du fichier CIB avec une version plus ancienne que celle qui se trouve actuellement dans le cluster, vous pouvez utiliser l'option --config de la commande pcs cluster cib-push.

pcs cluster cib-push --config filename3.4. Affichage de l'état de la grappe

Plusieurs commandes permettent d'afficher l'état d'un cluster et de ses composants.

Vous pouvez afficher l'état de la grappe et de ses ressources à l'aide de la commande suivante.

# pcs status

Vous pouvez afficher l'état d'un composant particulier de la grappe avec le paramètre commands de la commande pcs status, en spécifiant resources, cluster, nodes ou pcsd.

état des pcs commandsPar exemple, la commande suivante affiche l'état des ressources de la grappe.

# pcs status resourcesLa commande suivante affiche l'état de la grappe, mais pas ses ressources.

# pcs cluster status3.5. Affichage de la configuration complète du cluster

La commande suivante permet d'afficher l'intégralité de la configuration actuelle du cluster.

# pcs config3.6. Modifier le fichier corosync.conf avec la commande pcs

Vous pouvez utiliser la commande pcs pour modifier les paramètres du fichier corosync.conf.

La commande suivante modifie les paramètres du fichier corosync.conf.

pcs cluster config update [transport pass:quotes[transport options]] [compression pass:quotes[compression options]] [crypto pass:quotes[crypto options]] [totem pass:quotes[totem options]] [--corosync_conf pass:quotes[path]]

L'exemple de commande suivant met à jour la valeur de transport knet_pmtud_interval et les valeurs totem token et join.

# pcs cluster config update transport knet_pmtud_interval=35 totem token=10000 join=100Ressources supplémentaires

- Pour plus d'informations sur l'ajout et la suppression de nœuds d'une grappe existante, voir Gestion des nœuds de la grappe.

- Pour plus d'informations sur l'ajout et la modification de liens dans un cluster existant, voir Ajout et modification de liens dans un cluster existant.

- Pour plus d'informations sur la modification des options de quorum et la gestion des paramètres des périphériques de quorum dans une grappe, voir Configuration du quorum de la grappe et Configuration des périphériques de quorum.

3.7. Affichage du fichier corosync.conf avec la commande pcs

La commande suivante affiche le contenu du fichier de configuration du cluster corosync.conf.

# pcs cluster corosync

Vous pouvez imprimer le contenu du fichier corosync.conf dans un format lisible par l'homme à l'aide de la commande pcs cluster config, comme dans l'exemple suivant.

La sortie de cette commande inclut l'UUID du cluster si celui-ci a été créé dans RHEL 9.1 ou une version ultérieure, ou si l'UUID a été ajouté manuellement comme décrit dans la section Identifier les clusters par UUID.

[root@r8-node-01 ~]# pcs cluster config

Cluster Name: HACluster

Cluster UUID: ad4ae07dcafe4066b01f1cc9391f54f5

Transport: knet

Nodes:

r8-node-01:

Link 0 address: r8-node-01

Link 1 address: 192.168.122.121

nodeid: 1

r8-node-02:

Link 0 address: r8-node-02

Link 1 address: 192.168.122.122

nodeid: 2

Links:

Link 1:

linknumber: 1

ping_interval: 1000

ping_timeout: 2000

pong_count: 5

Compression Options:

level: 9

model: zlib

threshold: 150

Crypto Options:

cipher: aes256

hash: sha256

Totem Options:

downcheck: 2000

join: 50

token: 10000

Quorum Device: net

Options:

sync_timeout: 2000

timeout: 3000

Model Options:

algorithm: lms

host: r8-node-03

Heuristics:

exec_ping: ping -c 1 127.0.0.1

Vous pouvez exécuter la commande pcs cluster config show avec l'option --output-format=cmd pour afficher les commandes de configuration pcs qui peuvent être utilisées pour recréer le fichier corosync.conf existant, comme dans l'exemple suivant.

[root@r8-node-01 ~]# pcs cluster config show --output-format=cmd

pcs cluster setup HACluster \

r8-node-01 addr=r8-node-01 addr=192.168.122.121 \

r8-node-02 addr=r8-node-02 addr=192.168.122.122 \

transport \

knet \

link \

linknumber=1 \

ping_interval=1000 \

ping_timeout=2000 \

pong_count=5 \

compression \

level=9 \

model=zlib \

threshold=150 \

crypto \

cipher=aes256 \

hash=sha256 \

totem \

downcheck=2000 \

join=50 \

token=10000Chapitre 4. Création d'un cluster Red Hat à haute disponibilité avec Pacemaker

Créez un cluster Red Hat High Availability à deux nœuds à l'aide de l'interface de ligne de commande pcs en suivant la procédure suivante.

La configuration du cluster dans cet exemple nécessite que votre système comprenne les composants suivants :

-

2 nœuds, qui seront utilisés pour créer le cluster. Dans cet exemple, les nœuds utilisés sont

z1.example.cometz2.example.com. - Commutateurs de réseau pour le réseau privé. Nous recommandons, mais n'exigeons pas, un réseau privé pour la communication entre les nœuds de la grappe et les autres équipements de la grappe, tels que les commutateurs d'alimentation réseau et les commutateurs Fibre Channel.

-

Un dispositif de clôture pour chaque nœud du cluster. Cet exemple utilise deux ports du commutateur d'alimentation APC avec un nom d'hôte

zapc.example.com.

4.1. Installation du logiciel de la grappe

Installez le logiciel de cluster et configurez votre système pour la création de cluster en suivant la procédure suivante.

Procédure

Sur chaque nœud du cluster, activez le référentiel de haute disponibilité correspondant à l'architecture de votre système. Par exemple, pour activer le référentiel de haute disponibilité pour un système x86_64, vous pouvez entrer la commande suivante

subscription-manager:# subscription-manager repos --enable=rhel-9-for-x86_64-highavailability-rpmsSur chaque nœud du cluster, installez les paquetages logiciels Red Hat High Availability Add-On ainsi que tous les agents de clôture disponibles dans le canal High Availability.

# dnf install pcs pacemaker fence-agents-allVous pouvez également installer les paquetages logiciels Red Hat High Availability Add-On ainsi que l'agent de clôture dont vous avez besoin à l'aide de la commande suivante.

# dnf install pcs pacemaker fence-agents-modelLa commande suivante affiche une liste des agents de clôture disponibles.

# rpm -q -a | grep fence fence-agents-rhevm-4.0.2-3.el7.x86_64 fence-agents-ilo-mp-4.0.2-3.el7.x86_64 fence-agents-ipmilan-4.0.2-3.el7.x86_64 ...AvertissementAprès avoir installé les paquetages de Red Hat High Availability Add-On, vous devez vous assurer que vos préférences de mise à jour logicielle sont définies de manière à ce que rien ne soit installé automatiquement. L'installation sur un cluster en cours d'exécution peut provoquer des comportements inattendus. Pour plus d'informations, voir Pratiques recommandées pour l'application de mises à jour logicielles à un cluster RHEL High Availability ou Resilient Storage.

Si vous exécutez le démon

firewalld, exécutez les commandes suivantes pour activer les ports requis par le module complémentaire de haute disponibilité de Red Hat.NoteVous pouvez déterminer si le démon

firewalldest installé sur votre système à l'aide de la commanderpm -q firewalld. S'il est installé, vous pouvez déterminer s'il fonctionne avec la commandefirewall-cmd --state.# firewall-cmd --permanent --add-service=high-availability # firewall-cmd --add-service=high-availability

NoteLa configuration idéale du pare-feu pour les composants de la grappe dépend de l'environnement local, où il peut être nécessaire de prendre en compte des considérations telles que l'existence d'interfaces réseau multiples pour les nœuds ou la présence d'un pare-feu hors hôte. L'exemple présenté ici, qui ouvre les ports généralement requis par un cluster Pacemaker, doit être modifié pour s'adapter aux conditions locales. L'activation des ports pour le module complémentaire de haute disponibilité montre les ports à activer pour le module complémentaire de haute disponibilité de Red Hat et fournit une explication sur l'utilisation de chaque port.

Afin d'utiliser

pcspour configurer le cluster et communiquer entre les nœuds, vous devez définir un mot de passe sur chaque nœud pour l'ID utilisateurhacluster, qui est le compte d'administrationpcs. Il est recommandé que le mot de passe de l'utilisateurhaclustersoit le même sur chaque nœud.# passwd hacluster Changing password for user hacluster. New password: Retype new password: passwd: all authentication tokens updated successfully.Avant de pouvoir configurer la grappe, le démon

pcsddoit être lancé et autorisé à démarrer au démarrage sur chaque nœud. Ce démon travaille avec la commandepcspour gérer la configuration des nœuds de la grappe.Sur chaque nœud du cluster, exécutez les commandes suivantes pour démarrer le service

pcsdet pour activerpcsdau démarrage du système.# systemctl start pcsd.service # systemctl enable pcsd.service

4.2. Installation du paquet pcp-zeroconf (recommandé)

Lorsque vous configurez votre cluster, il est recommandé d'installer le paquetage pcp-zeroconf pour l'outil Performance Co-Pilot (PCP). PCP est l'outil de surveillance des ressources recommandé par Red Hat pour les systèmes RHEL. L'installation du paquetage pcp-zeroconf vous permet d'exécuter PCP et de collecter des données de surveillance des performances dans le cadre d'enquêtes sur les clôtures, les défaillances de ressources et d'autres événements qui perturbent le cluster.

Les déploiements de clusters où PCP est activé auront besoin de suffisamment d'espace pour les données capturées par PCP sur le système de fichiers qui contient /var/log/pcp/. L'utilisation typique de l'espace par PCP varie selon les déploiements, mais 10 Go suffisent généralement lorsque les paramètres par défaut de pcp-zeroconf sont utilisés, et certains environnements peuvent nécessiter moins d'espace. La surveillance de l'utilisation de ce répertoire sur une période de 14 jours d'activité typique peut fournir une estimation plus précise de l'utilisation.

Procédure

Pour installer le paquetage pcp-zeroconf, exécutez la commande suivante.

# dnf install pcp-zeroconf

Ce paquet permet d'activer pmcd et de configurer la capture de données à un intervalle de 10 secondes.

Pour plus d'informations sur l'examen des données PCP, voir Pourquoi un nœud de cluster RHEL High Availability a-t-il redémarré - et comment puis-je éviter que cela ne se reproduise ? sur le portail client de Red Hat.

4.3. Création d'un cluster de haute disponibilité

Créez un cluster Red Hat High Availability Add-On à l'aide de la procédure suivante. Cet exemple de procédure crée un cluster composé des nœuds z1.example.com et z2.example.com.

Procédure

Authentifiez l'utilisateur

pcshaclusterpour chaque nœud du cluster sur le nœud à partir duquel vous exécuterezpcs.La commande suivante authentifie l'utilisateur

haclustersurz1.example.compour les deux nœuds d'un cluster à deux nœuds qui comprendraz1.example.cometz2.example.com.[root@z1 ~]# pcs host auth z1.example.com z2.example.com Username: hacluster Password: z1.example.com: Authorized z2.example.com: Authorized

Exécutez la commande suivante à partir de

z1.example.compour créer la grappe à deux nœudsmy_clusterqui se compose des nœudsz1.example.cometz2.example.com. Les fichiers de configuration de la grappe seront propagés aux deux nœuds de la grappe. Cette commande inclut l'option--start, qui démarre les services de cluster sur les deux nœuds du cluster.[root@z1 ~]# pcs cluster setup my_cluster --start z1.example.com z2.example.comActiver les services de cluster pour qu'ils s'exécutent sur chaque nœud du cluster lorsque le nœud est démarré.

NotePour votre environnement particulier, vous pouvez choisir de laisser les services de la grappe désactivés en sautant cette étape. Cela vous permet de vous assurer qu'en cas de panne d'un nœud, tout problème lié à votre cluster ou à vos ressources est résolu avant que le nœud ne rejoigne le cluster. Si vous laissez les services de cluster désactivés, vous devrez les démarrer manuellement lors du redémarrage d'un nœud en exécutant la commande

pcs cluster startsur ce nœud.[root@z1 ~]# pcs cluster enable --all

Vous pouvez afficher l'état actuel de la grappe à l'aide de la commande pcs cluster status. Comme il peut y avoir un léger délai avant que la grappe soit opérationnelle lorsque vous démarrez les services de la grappe avec l'option --start de la commande pcs cluster setup, vous devez vous assurer que la grappe est opérationnelle avant d'effectuer toute action ultérieure sur la grappe et sa configuration.

[root@z1 ~]# pcs cluster status

Cluster Status:

Stack: corosync

Current DC: z2.example.com (version 2.0.0-10.el8-b67d8d0de9) - partition with quorum

Last updated: Thu Oct 11 16:11:18 2018

Last change: Thu Oct 11 16:11:00 2018 by hacluster via crmd on z2.example.com

2 Nodes configured

0 Resources configured

...4.4. Création d'un cluster de haute disponibilité avec des liens multiples

Vous pouvez utiliser la commande pcs cluster setup pour créer un cluster Red Hat High Availability avec des liens multiples en spécifiant tous les liens pour chaque nœud.

Le format de la commande de base pour créer un cluster à deux nœuds avec deux liens est le suivant.

pcs cluster setup pass:quotes[cluster_name] pass:quotes[node1_name] addr=pass:quotes[node1_link0_address] addr=pass:quotes[node1_link1_address] pass:quotes[node2_name] addr=pass:quotes[node2_link0_address] addr=pass:quotes[node2_link1_address]

Pour la syntaxe complète de cette commande, voir la page de manuel pcs(8).

Lorsque vous créez une grappe avec plusieurs liens, vous devez tenir compte des éléments suivants.

-

L'ordre des

addr=addressest important. La première adresse spécifiée après le nom d'un nœud est pourlink0, la deuxième pourlink1, et ainsi de suite. -

Par défaut, si

link_priorityn'est pas spécifié pour un lien, la priorité du lien est égale au numéro du lien. Les priorités des liens sont alors 0, 1, 2, 3, et ainsi de suite, selon l'ordre spécifié, 0 étant la priorité la plus élevée. -

Le mode de liaison par défaut est

passive, ce qui signifie que la liaison active ayant la priorité de liaison la moins élevée est utilisée. -

Avec les valeurs par défaut de

link_modeetlink_priority, le premier lien spécifié sera utilisé comme lien de plus haute priorité, et si ce lien échoue, le lien suivant spécifié sera utilisé. -

Il est possible de spécifier jusqu'à huit liens en utilisant le protocole de transport

knet, qui est le protocole de transport par défaut. -

Tous les nœuds doivent avoir le même nombre de paramètres

addr=. -

Il est possible d'ajouter, de supprimer et de modifier des liens dans un cluster existant à l'aide des commandes

pcs cluster link add,pcs cluster link remove,pcs cluster link deleteetpcs cluster link update. - Comme pour les clusters à lien unique, ne mélangez pas les adresses IPv4 et IPv6 dans un lien, bien qu'il soit possible d'avoir un lien fonctionnant sous IPv4 et l'autre sous IPv6.

- Comme pour les clusters à lien unique, vous pouvez spécifier des adresses sous forme d'adresses IP ou de noms tant que les noms se résolvent en adresses IPv4 ou IPv6 pour lesquelles les adresses IPv4 et IPv6 ne sont pas mélangées dans un lien.

L'exemple suivant crée un cluster à deux nœuds nommé my_twolink_cluster avec deux nœuds, rh80-node1 et rh80-node2. rh80-node1 possède deux interfaces, l'adresse IP 192.168.122.201 pour link0 et 192.168.123.201 pour link1. rh80-node2 possède deux interfaces, l'adresse IP 192.168.122.202 pour link0 et 192.168.123.202 pour link1.

# pcs cluster setup my_twolink_cluster rh80-node1 addr=192.168.122.201 addr=192.168.123.201 rh80-node2 addr=192.168.122.202 addr=192.168.123.202

Pour définir une priorité de lien à une valeur différente de la valeur par défaut, qui est le numéro de lien, vous pouvez définir la priorité de lien avec l'option link_priority de la commande pcs cluster setup. Chacun des deux exemples de commande suivants crée un cluster à deux nœuds avec deux interfaces où le premier lien, le lien 0, a une priorité de lien de 1 et le second lien, le lien 1, a une priorité de lien de 0. Le lien 1 sera utilisé en premier et le lien 0 servira de lien de basculement. Le mode de liaison n'étant pas spécifié, il est par défaut passif.

Ces deux commandes sont équivalentes. Si vous ne spécifiez pas de numéro de lien après le mot-clé link, l'interface pcs ajoute automatiquement un numéro de lien, en commençant par le plus petit numéro de lien inutilisé.

# pcs cluster setup my_twolink_cluster rh80-node1 addr=192.168.122.201 addr=192.168.123.201 rh80-node2 addr=192.168.122.202 addr=192.168.123.202 transport knet link link_priority=1 link link_priority=0 # pcs cluster setup my_twolink_cluster rh80-node1 addr=192.168.122.201 addr=192.168.123.201 rh80-node2 addr=192.168.122.202 addr=192.168.123.202 transport knet link linknumber=1 link_priority=0 link link_priority=1

Vous pouvez définir le mode de liaison à une valeur différente de la valeur par défaut de passive avec l'option link_mode de la commande pcs cluster setup, comme dans l'exemple suivant.

# pcs cluster setup my_twolink_cluster rh80-node1 addr=192.168.122.201 addr=192.168.123.201 rh80-node2 addr=192.168.122.202 addr=192.168.123.202 transport knet link_mode=activeL'exemple suivant définit à la fois le mode de liaison et la priorité de liaison.

# pcs cluster setup my_twolink_cluster rh80-node1 addr=192.168.122.201 addr=192.168.123.201 rh80-node2 addr=192.168.122.202 addr=192.168.123.202 transport knet link_mode=active link link_priority=1 link link_priority=0Pour plus d'informations sur l'ajout de nœuds à un cluster existant avec des liens multiples, voir Ajouter un nœud à un cluster avec des liens multiples.

Pour plus d'informations sur la modification des liens dans un cluster existant avec plusieurs liens, voir Ajouter et modifier des liens dans un cluster existant.

4.5. Configuration des clôtures

Vous devez configurer un dispositif de clôture pour chaque nœud du cluster. Pour plus d'informations sur les commandes et options de configuration de clôture, reportez-vous à Configuration de la clôture dans un cluster Red Hat High Availability.

Pour des informations générales sur la clôture et son importance dans un cluster Red Hat High Availability, voir Clôture dans un cluster Red Hat High Availability.

Lors de la configuration d'un dispositif de clôture, il convient de vérifier si ce dispositif partage l'alimentation avec d'autres nœuds ou dispositifs de la grappe. Si un nœud et son dispositif de clôture partagent l'alimentation, la grappe risque de ne pas pouvoir clôturer ce nœud en cas de perte d'alimentation du nœud et de son dispositif de clôture. Une telle grappe doit disposer soit d'alimentations redondantes pour les dispositifs de clôture et les nœuds, soit de dispositifs de clôture redondants qui ne partagent pas l'alimentation. D'autres méthodes de clôture, telles que les SBD ou les clôtures de stockage, peuvent également apporter une redondance en cas de perte d'alimentation isolée.

Procédure

Cet exemple utilise l'interrupteur d'alimentation APC dont le nom d'hôte est zapc.example.com pour clôturer les nœuds, ainsi que l'agent de clôture fence_apc_snmp. Étant donné que les deux nœuds seront clôturés par le même agent de clôture, vous pouvez configurer les deux dispositifs de clôture en tant que ressource unique, à l'aide de l'option pcmk_host_map.

Vous créez un dispositif de clôture en le configurant en tant que ressource stonith à l'aide de la commande pcs stonith create. La commande suivante configure une ressource stonith nommée myapc qui utilise l'agent de clôture fence_apc_snmp pour les nœuds z1.example.com et z2.example.com. L'option pcmk_host_map associe z1.example.com au port 1 et z2.example.com au port 2. La valeur de connexion et le mot de passe du dispositif APC sont tous deux apc. Par défaut, ce dispositif utilise un intervalle de surveillance de soixante secondes pour chaque nœud.

Notez que vous pouvez utiliser une adresse IP lorsque vous spécifiez le nom d'hôte des nœuds.

[root@z1 ~]# pcs stonith create myapc fence_apc_snmp ipaddr="zapc.example.com" pcmk_host_map="z1.example.com:1;z2.example.com:2" login="apc" passwd="apc"La commande suivante affiche les paramètres d'un dispositif STONITH existant.

[root@rh7-1 ~]# pcs stonith config myapc

Resource: myapc (class=stonith type=fence_apc_snmp)

Attributes: ipaddr=zapc.example.com pcmk_host_map=z1.example.com:1;z2.example.com:2 login=apc passwd=apc

Operations: monitor interval=60s (myapc-monitor-interval-60s)Après avoir configuré votre dispositif de clôture, vous devez le tester. Pour plus d'informations sur le test d'un dispositif de clôture, voir Test d'un dispositif de clôture.

Ne testez pas votre dispositif de clôture en désactivant l'interface réseau, car cela ne permettra pas de tester correctement la clôture.

Une fois que la clôture est configurée et qu'une grappe a été démarrée, un redémarrage du réseau déclenchera la clôture pour le nœud qui redémarre le réseau, même si le délai n'est pas dépassé. C'est pourquoi il ne faut pas redémarrer le service réseau lorsque le service de cluster est en cours d'exécution, car cela déclencherait un clôturage involontaire sur le nœud.

4.6. Sauvegarde et restauration d'une configuration de cluster

Les commandes suivantes sauvegardent la configuration d'un cluster dans une archive tar et restaurent les fichiers de configuration du cluster sur tous les nœuds à partir de la sauvegarde.

Procédure

Utilisez la commande suivante pour sauvegarder la configuration du cluster dans une archive tar. Si vous ne spécifiez pas de nom de fichier, la sortie standard sera utilisée.

pcs config backup filename

La commande pcs config backup ne sauvegarde que la configuration du cluster telle qu'elle est configurée dans la CIB ; la configuration des démons de ressources n'entre pas dans le champ d'application de cette commande. Par exemple, si vous avez configuré une ressource Apache dans le cluster, les paramètres de la ressource (qui sont dans la CIB) seront sauvegardés, alors que les paramètres du démon Apache (tels qu'ils sont définis dans `/etc/httpd`) et les fichiers qu'il sert ne seront pas sauvegardés. De même, si une ressource de base de données est configurée dans le cluster, la base de données elle-même ne sera pas sauvegardée, mais la configuration de la ressource de base de données (CIB) le sera.

Utilisez la commande suivante pour restaurer les fichiers de configuration du cluster sur tous les nœuds du cluster à partir de la sauvegarde. L'option --local permet de restaurer les fichiers de configuration du cluster uniquement sur le nœud à partir duquel vous exécutez cette commande. Si vous ne spécifiez pas de nom de fichier, l'entrée standard sera utilisée.

pcs config restore [--local] [filename]4.7. Activation des ports pour le module complémentaire de haute disponibilité

La configuration idéale du pare-feu pour les composants de la grappe dépend de l'environnement local, où il peut être nécessaire de prendre en compte des considérations telles que l'existence d'interfaces réseau multiples pour les nœuds ou la présence d'un pare-feu hors hôte.

Si vous exécutez le démon firewalld, exécutez les commandes suivantes pour activer les ports requis par le module complémentaire de haute disponibilité de Red Hat.

# firewall-cmd --permanent --add-service=high-availability # firewall-cmd --add-service=high-availability

Il se peut que vous deviez modifier les ports ouverts en fonction des conditions locales.

Vous pouvez déterminer si le démon firewalld est installé sur votre système à l'aide de la commande rpm -q firewalld. Si le démon firewalld est installé, vous pouvez déterminer s'il est en cours d'exécution à l'aide de la commande firewall-cmd --state.

Le tableau suivant indique les ports à activer pour le module complémentaire de haute disponibilité de Red Hat et fournit une explication de l'utilisation du port.

Tableau 4.1. Ports à activer pour le module complémentaire de haute disponibilité

| Port | Quand cela est nécessaire |

|---|---|

| TCP 2224 |

Port

Il est essentiel d'ouvrir le port 2224 de manière à ce que |

| TCP 3121 | Requis sur tous les nœuds si la grappe comporte des nœuds Pacemaker Remote

Le démon |

| TCP 5403 |

Requis sur l'hôte du périphérique quorum lors de l'utilisation d'un périphérique quorum avec |

| UDP 5404-5412 |

Nécessaire sur les nœuds corosync pour faciliter la communication entre les nœuds. Il est essentiel d'ouvrir les ports 5404-5412 de manière à ce que |

| TCP 21064 |

Nécessaire sur tous les nœuds si le cluster contient des ressources nécessitant un DLM (telles que |

| TCP 9929, UDP 9929 | Doit être ouvert sur tous les nœuds de la grappe et nœuds d'arbitrage pour les connexions à partir de n'importe lequel de ces nœuds lorsque le gestionnaire de tickets de cabine est utilisé pour établir une grappe multisite. |

Chapitre 5. Configuration d'un serveur HTTP Apache actif/passif dans un cluster Red Hat High Availability

Configurez un serveur HTTP Apache actif/passif dans un cluster Red Hat Enterprise Linux High Availability Add-On à deux nœuds à l'aide de la procédure suivante. Dans ce cas d'utilisation, les clients accèdent au serveur HTTP Apache via une adresse IP flottante. Le serveur web s'exécute sur l'un des deux nœuds de la grappe. Si le nœud sur lequel le serveur web s'exécute devient inopérant, le serveur web redémarre sur le deuxième nœud du cluster avec une interruption de service minimale.

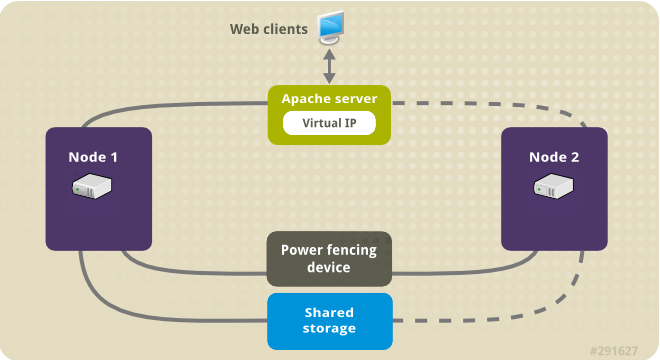

L'illustration suivante montre une vue d'ensemble du cluster dans lequel le cluster est un cluster Red Hat High Availability à deux nœuds qui est configuré avec un commutateur d'alimentation réseau et un stockage partagé. Les nœuds du cluster sont connectés à un réseau public, pour permettre aux clients d'accéder au serveur HTTP Apache par le biais d'une IP virtuelle. Le serveur Apache tourne sur le nœud 1 ou le nœud 2, chacun ayant accès au stockage sur lequel les données Apache sont conservées. Dans cette illustration, le serveur web tourne sur le nœud 1 tandis que le nœud 2 est disponible pour faire tourner le serveur si le nœud 1 devient inopérant.

Figure 5.1. Apache dans un cluster à deux nœuds Red Hat High Availability

Ce cas d'utilisation exige que votre système comprenne les composants suivants :

- Un cluster Red Hat High Availability à deux nœuds avec une clôture d'alimentation configurée pour chaque nœud. Nous recommandons l'utilisation d'un réseau privé, mais nous ne l'exigeons pas. Cette procédure utilise l'exemple de cluster fourni dans Création d'un cluster Red Hat à haute disponibilité avec Pacemaker.

- Une adresse IP virtuelle publique, requise pour Apache.

- Stockage partagé pour les nœuds de la grappe, à l'aide d'iSCSI, de Fibre Channel ou d'un autre périphérique de bloc réseau partagé.

La grappe est configurée avec un groupe de ressources Apache, qui contient les composants de la grappe dont le serveur web a besoin : une ressource LVM, une ressource de système de fichiers, une ressource d'adresse IP et une ressource de serveur web. Ce groupe de ressources peut basculer d'un nœud à l'autre de la grappe, ce qui permet à l'un ou l'autre nœud d'exécuter le serveur web. Avant de créer le groupe de ressources pour cette grappe, vous devez effectuer les procédures suivantes :

-

Configurer un système de fichiers XFS sur le volume logique

my_lv. - Configurer un serveur web.

Après avoir effectué ces étapes, vous créez le groupe de ressources et les ressources qu'il contient.

5.1. Configuration d'un volume LVM avec un système de fichiers XFS dans un cluster Pacemaker

Créez un volume logique LVM sur le stockage partagé entre les nœuds du cluster en suivant la procédure suivante.

Les volumes LVM et les partitions et périphériques correspondants utilisés par les nœuds de cluster doivent être connectés aux nœuds de cluster uniquement.

La procédure suivante permet de créer un volume logique LVM, puis un système de fichiers XFS sur ce volume pour une utilisation dans un cluster Pacemaker. Dans cet exemple, la partition partagée /dev/sdb1 est utilisée pour stocker le volume physique LVM à partir duquel le volume logique LVM sera créé.

Procédure

Sur les deux nœuds de la grappe, procédez comme suit pour définir la valeur de l'identifiant du système LVM sur la valeur de l'identifiant

unamedu système. L'ID système LVM sera utilisé pour s'assurer que seule la grappe est capable d'activer le groupe de volumes.Définissez l'option de configuration

system_id_sourcedans le fichier de configuration/etc/lvm/lvm.confsuruname.# Configuration option global/system_id_source. system_id_source = "uname"

Vérifiez que l'ID du système LVM sur le nœud correspond à l'adresse

unamedu nœud.# lvm systemid system ID: z1.example.com # uname -n z1.example.com

Créez le volume LVM et créez un système de fichiers XFS sur ce volume. Étant donné que la partition

/dev/sdb1est un espace de stockage partagé, cette partie de la procédure ne peut être exécutée que sur un seul nœud.NoteSi votre groupe de volumes LVM contient un ou plusieurs volumes physiques résidant sur un stockage en bloc distant, tel qu'une cible iSCSI, Red Hat vous recommande de vous assurer que le service démarre avant le démarrage de Pacemaker. Pour plus d'informations sur la configuration de l'ordre de démarrage d'un volume physique distant utilisé par un cluster Pacemaker, reportez-vous à Configuration de l'ordre de démarrage pour les dépendances de ressources non gérées par Pacemaker.

Créer un volume physique LVM sur la partition

/dev/sdb1.[root@z1 ~]# pvcreate /dev/sdb1 Physical volume "/dev/sdb1" successfully createdNoteSi votre groupe de volumes LVM contient un ou plusieurs volumes physiques résidant sur un stockage en bloc distant, tel qu'une cible iSCSI, Red Hat vous recommande de vous assurer que le service démarre avant le démarrage de Pacemaker. Pour plus d'informations sur la configuration de l'ordre de démarrage d'un volume physique distant utilisé par un cluster Pacemaker, reportez-vous à Configuration de l'ordre de démarrage pour les dépendances de ressources non gérées par Pacemaker.

Créez le groupe de volumes

my_vgqui se compose du volume physique/dev/sdb1.Spécifiez l'indicateur

--setautoactivation npour vous assurer que les groupes de volumes gérés par Pacemaker dans un cluster ne seront pas automatiquement activés au démarrage. Si vous utilisez un groupe de volumes existant pour le volume LVM que vous créez, vous pouvez réinitialiser cet indicateur avec la commandevgchange --setautoactivation npour le groupe de volumes.[root@z1 ~]# vgcreate --setautoactivation n my_vg /dev/sdb1 Volume group "my_vg" successfully createdVérifiez que le nouveau groupe de volumes possède l'ID système du nœud sur lequel vous travaillez et à partir duquel vous avez créé le groupe de volumes.

[root@z1 ~]# vgs -o+systemid VG #PV #LV #SN Attr VSize VFree System ID my_vg 1 0 0 wz--n- <1.82t <1.82t z1.example.comCréer un volume logique à l'aide du groupe de volumes

my_vg.[root@z1 ~]# lvcreate -L450 -n my_lv my_vg Rounding up size to full physical extent 452.00 MiB Logical volume "my_lv" createdVous pouvez utiliser la commande

lvspour afficher le volume logique.[root@z1 ~]# lvs LV VG Attr LSize Pool Origin Data% Move Log Copy% Convert my_lv my_vg -wi-a---- 452.00m ...Créer un système de fichiers XFS sur le volume logique

my_lv.[root@z1 ~]# mkfs.xfs /dev/my_vg/my_lv meta-data=/dev/my_vg/my_lv isize=512 agcount=4, agsize=28928 blks = sectsz=512 attr=2, projid32bit=1 ...

Ajoutez le périphérique partagé au fichier des périphériques LVM sur le deuxième nœud de la grappe.

[root@z2 ~]# lvmdevices --adddev /dev/sdb1

5.2. Configuration d'un serveur HTTP Apache

Configurez un serveur HTTP Apache en suivant la procédure suivante.

Procédure

Assurez-vous que le serveur Apache HTTP est installé sur chaque nœud de la grappe. L'outil

wgetdoit également être installé sur le cluster pour pouvoir vérifier l'état du serveur HTTP Apache.Sur chaque nœud, exécutez la commande suivante.

# dnf install -y httpd wgetSi vous exécutez le démon

firewalld, sur chaque nœud de la grappe, activez les ports requis par le module complémentaire de haute disponibilité de Red Hat et activez les ports dont vous aurez besoin pour exécuterhttpd. Cet exemple active les portshttpdpour l'accès public, mais les ports spécifiques à activer pourhttpdpeuvent varier pour une utilisation en production.# firewall-cmd --permanent --add-service=http # firewall-cmd --permanent --zone=public --add-service=http # firewall-cmd --reload

Pour que l'agent de ressources Apache puisse obtenir l'état d'Apache, sur chaque nœud du cluster, créez l'ajout suivant à la configuration existante pour activer l'URL du serveur d'état.

# cat <<-END > /etc/httpd/conf.d/status.conf <Location /server-status> SetHandler server-status Require local </Location> END

Créez une page web pour qu'Apache la diffuse.

Sur un nœud du cluster, assurez-vous que le volume logique que vous avez créé dans Configuration d'un volume LVM avec un système de fichiers XFS est activé, montez le système de fichiers que vous avez créé sur ce volume logique, créez le fichier

index.htmlsur ce système de fichiers, puis démontez le système de fichiers.# lvchange -ay my_vg/my_lv # mount /dev/my_vg/my_lv /var/www/ # mkdir /var/www/html # mkdir /var/www/cgi-bin # mkdir /var/www/error # restorecon -R /var/www # cat <<-END >/var/www/html/index.html <html> <body>Hello</body> </html> END # umount /var/www

5.3. Création des ressources et des groupes de ressources

Créez les ressources de votre cluster en suivant la procédure suivante. Pour s'assurer que ces ressources s'exécutent toutes sur le même nœud, elles sont configurées comme faisant partie du groupe de ressources apachegroup. Les ressources à créer sont les suivantes, énumérées dans l'ordre dans lequel elles démarreront.

-

Une ressource

LVM-activatenomméemy_lvmqui utilise le groupe de volumes LVM que vous avez créé dans Configuration d'un volume LVM avec un système de fichiers XFS. -

Une ressource

Filesystemnomméemy_fs, qui utilise le périphérique de système de fichiers/dev/my_vg/my_lvque vous avez créé dans Configuration d'un volume LVM avec un système de fichiers XFS. -

Une ressource

IPaddr2, qui est une adresse IP flottante pour le groupe de ressourcesapachegroup. L'adresse IP ne doit pas être déjà associée à un nœud physique. Si le périphérique NIC de la ressourceIPaddr2n'est pas spécifié, l'adresse IP flottante doit résider sur le même réseau que l'une des adresses IP attribuées de manière statique au nœud, faute de quoi le périphérique NIC qui attribue l'adresse IP flottante ne peut être correctement détecté. -

Une ressource

apachenomméeWebsitequi utilise le fichierindex.htmlet la configuration Apache que vous avez définie dans Configuration d'un serveur HTTP Apache.